管理统计学9一元线性回归

- 格式:ppt

- 大小:515.00 KB

- 文档页数:64

回归方程的显著性检验回归方程的显著性检验的目的是对回归方程拟合优度的检验。

F检验法是英国统计学家Fisher提出的,主要通过比较两组数据的方差S2,以确定他们的精密度是否有显著性差异。

回归方程显著性检验具体方法为:由于y的偏差是由两个因素造成的,一是x变化所引起反应在S回中,二是各种偶然因素干扰所致S残中。

将回归方程离差平方和S回同剩余离差平方和S残加以比较,应用F检验来分析两者之间的差别是否显著。

如果是显著的,两个变量之间存在线性关系;如果不显著,两个变量不存在线性相关关系。

n个观测值之间存在着差异,我们用观测值yi与其平均值的偏差平方和来表示这种差异程度,称其为总离差平方和,记为由于所以式中称为回归平方和,记为S回。

称为残差平方和,记为。

不难证明,最后一项。

因此S总=S回+S残上式表明,y的偏差是由两个因素造成的,一是x变化所引起,二是各种偶然因素干扰所致。

事实上,S回和S残可用下面更简单的关系式来计算。

具体检验可在方差分析表上进行。

这里要注意S回的自由度为1,S残的自由度为n-2,S总的自由度为n-1。

如果x与y有线性关系,则其中,F(1,n-2)表示第一自由度为1,第二自由度为n-2的分布。

在F表中显著性水平用表示,一般取0.10,0.05,0.01,1-表示检验的可靠程度。

在进行检验时,F值应大于F表中的临界值Fα。

若F<0.05(1,n-2),则称x与y 没有明显的线性关系,若F0.05(1,n-2)<F<F0.01(1,n-2),则称x与y有显著的线性关系;若F>F0.01(1,n-2),则称x与y有十分显著的线性关系。

当x与y有显著的线性关系时,在表2-1-2的显著性栏中标以〝*〞;当x与y有十分显著的线性关系时,标以〝**〞。

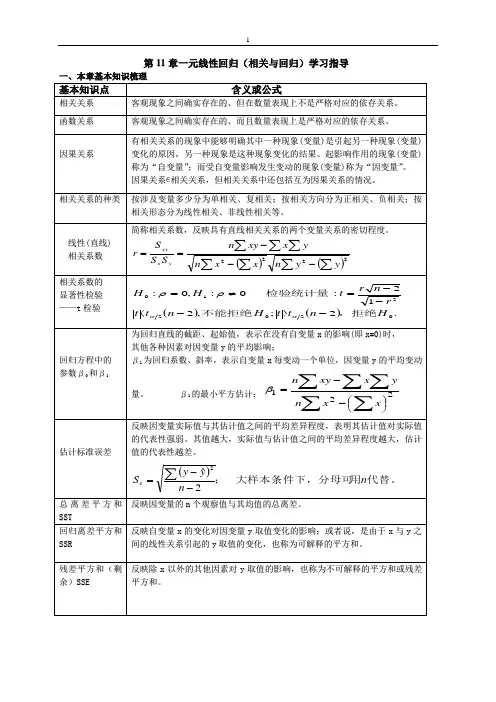

第11章一元线性回归(相关与回归)学习指导一、本章基本知识梳理基本知识点含义或公式相关关系 客观现象之间确实存在的、但在数量表现上不是严格对应的依存关系。

函数关系 客观现象之间确实存在的、而且数量表现上是严格对应的依存关系。

因果关系有相关关系的现象中能够明确其中一种现象(变量)是引起另一种现象(变量)变化的原因,另一种现象是这种现象变化的结果。

起影响作用的现象(变量)称为“自变量”;而受自变量影响发生变动的现象(变量)称为“因变量”。

因果关系∊相关关系,但相关关系中还包括互为因果关系的情况。

相关关系的种类 按涉及变量多少分为单相关、复相关;按相关方向分为正相关、负相关;按相关形态分为线性相关、非线性相关等。

线性(直线) 相关系数 简称相关系数,反映具有直线相关关系的两个变量关系的密切程度。

()()∑∑∑∑∑∑∑---==2222y yn x xn yx xy n SS S r yx xy相关系数的 显著性检验 ——t 检验 ()().2;,212:0:,0:020221Hn t t Hn t t rn r t HH,拒绝不能拒绝检验统计量-〉-〈--=≠=ααρρ回归方程中的 参数β0和β1为回归直线的截距、起始值,表示在没有自变量x 的影响(即x =0)时,其他各种因素对因变量y 的平均影响;β1为回归系数、斜率,表示自变量x 每变动一个单位,因变量y 的平均变动量。

β1的最小平方估计:∑∑∑∑∑⎪⎭⎫ ⎝⎛--=221x x n yx xy nβ估计标准误差反映因变量实际值与其估计值之间的平均差异程度,表明其估计值对实际值的代表性强弱。

其值越大,实际值与估计值之间的平均差异程度越大,估计值的代表性越差。

()代替。

用大样本条件下,分母可;n n yyS e 2ˆ2--=∑总离差平方和S S T反映因变量的n 个观察值与其均值的总离差。

回归离差平方和S S R 反映自变量x 的变化对因变量y 取值变化的影响;或者说,是由于x 与y 之间的线性关系引起的y 取值的变化,也称为可解释的平方和。

统计学一元线性回归分析练习题一、内容提要本章介绍了回归分析的基本思想与基本方法。

首先,本章从总体回归模型与总体回归函数、样本回归模型与样本回归函数这两组概念开始,建立了回归分析的基本思想。

总体回归函数是对总体变量间关系的定量表述,由总体回归模型在若干基本假设下得到,但它只是建立在理论之上,在现实中只能先从总体中抽取一个样本,获得样本回归函数,并用它对总体回归函数做出统计推断。

本章的一个重点是如何获取线性的样本回归函数,主要涉及到普通最小二乘法的学习与掌握。

同时,也介绍了极大似然估计法以及矩估计法。

本章的另一个重点是对样本回归函数能否代表总体回归函数进行统计推断,即进行所谓的统计检验。

统计检验包括两个方面,一是先检验样本回归函数与样本点的“拟合优度”,第二是检验样本回归函数与总体回归函数的“接近”程度。

后者又包括两个层次:第一,检验解释变量对被解释变量是否存在着显著的线性影响关系,通过变量的t检验完成;第二,检验回归函数与总体回归函数的“接近”程度,通过参数估计值的“区间检验”完成。

本章还有三方面的内容不容忽视。

其一,若干基本假设。

样本回归函数参数的估计以及对参数估计量的统计性质的分析以及所进行的统计推断都是建立在这些基本假设之上的。

其二,参数估计量统计性质的分析,包括小样本性质与大样本性质,尤其是无偏性、有效性与一致性构成了对样本估计量优劣的最主要的衡量准则。

Goss-markov定理表明OLS估计量是最佳线性无偏估计量。

其三,运用样本回归函数进行预测,包括被解释变量条件均值与个值的预测,以及预测置信区间的计算及其变化特征。

二、典型例题分析例1、令kids表示一名妇女生育孩子的数目,educ 表示该妇女接受过教育的年数。

生育率对教育年数的简单回归模型为kids??0??1educ??随机扰动项?包含什么样的因素?它们可能与教育水平相关吗?上述简单回归分析能够揭示教育对生育率在其他条件不变下的影响吗?请解释。

计量经济学第二章一元线性回归模型第二章一元线性回归模型第一节一元线性回归模型及其古典假定第二节参数估计第三节最小二乘估计量的统计特性第四节统计显著性检验第五节预测与控制第一节回归模型的一般描述(1)确定性关系或函数关系:变量之间有唯一确定性的函数关系。

其一般表现形式为:一、回归模型的一般形式变量间的关系经济变量之间的关系,大体可分为两类:(2.1)(2)统计关系或相关关系:变量之间为非确定性依赖关系。

其一般表现形式为:(2.2)例如:函数关系:圆面积S =统计依赖关系/统计相关关系:若x和y之间确有因果关系,则称(2.2)为总体回归模型,x(一个或几个)为自变量(或解释变量或外生变量),y为因变量(或被解释变量或内生变量),u为随机项,是没有包含在模型中的自变量和其他一些随机因素对y的总影响。

一般说来,随机项来自以下几个方面:1、变量的省略。

由于人们认识的局限不能穷尽所有的影响因素或由于受时间、费用、数据质量等制约而没有引入模型之中的对被解释变量有一定影响的自变量。

2、统计误差。

数据搜集中由于计量、计算、记录等导致的登记误差;或由样本信息推断总体信息时产生的代表性误差。

3、模型的设定误差。

如在模型构造时,非线性关系用线性模型描述了;复杂关系用简单模型描述了;此非线性关系用彼非线性模型描述了等等。

4、随机误差。

被解释变量还受一些不可控制的众多的、细小的偶然因素的影响。

若相互依赖的变量间没有因果关系,则称其有相关关系。

对变量间统计关系的分析主要是通过相关分析、方差分析或回归分析(regression analysis)来完成的。

他们各有特点、职责和分析范围。

相关分析和方差分析本身虽然可以独立的进行某些方面的数量分析,但在大多数情况下,则是和回归分析结合在一起,进行综合分析,作为回归分析方法的补充。

回归分析(regression analysis)是研究一个变量关于另一个(些)变量的具体依赖关系的计算方法和理论。

一元线性回归教案引言一元线性回归是统计学中非常重要的一种回归分析方法。

它能够通过建立一个线性模型,根据自变量的值来预测因变量的值。

本教案将介绍一元线性回归的基本概念、原理和应用场景,并通过示例演示如何进行一元线性回归分析。

目录1.什么是一元线性回归?2.一元线性回归的原理3.数据的处理与准备4.拟合一元线性回归模型5.模型评估与预测6.应用案例分析7.总结1. 什么是一元线性回归?一元线性回归是指只有一个自变量和一个因变量的线性回归模型。

它的数学表达式为:Y = β0 + β1X + ε,其中Y是因变量,X是自变量,β0和β1是模型的参数,ε是误差项。

一元线性回归的目标是找到最合适的β0和β1,使得模型对观测数据点的拟合程度最优。

2. 一元线性回归的原理一元线性回归的原理基于最小二乘法,即通过最小化观测值与模型预测值之间的差异来确定模型的参数。

最小二乘法可以通过求解正规方程来获得最优的参数估计值。

3. 数据的处理与准备在进行一元线性回归分析之前,需要对数据进行处理和准备。

这包括数据清洗、变量选择和数据可视化等步骤。

本节将介绍常用的数据处理方法,以及如何选择适当的自变量和因变量。

4. 拟合一元线性回归模型拟合一元线性回归模型是通过最小二乘法来确定模型的参数估计值。

本节将介绍如何使用Python中的scikit-learn库来拟合一元线性回归模型,并分析模型的拟合结果。

5. 模型评估与预测在拟合一元线性回归模型之后,需要对模型进行评估和预测。

本节将介绍常用的评估指标,如均方误差(MSE)和决定系数(R-squared),以及如何使用模型进行预测。

6. 应用案例分析本节将通过一个实际的数据集来展示一元线性回归的应用场景。

通过分析数据集中的自变量和因变量之间的关系,我们可以建立一元线性回归模型,并对模型进行评估和预测。

7. 总结本教案从一元线性回归的基本概念和原理开始,通过示例和实践对一元线性回归进行了详细讲解。

§2.4 一元线性回归的模型检验一、经济意义检验。

二、在一元回归模型的统计检验主要包括如下几种检验1、拟合优度检验(R2检验;2、自变量显著性检验(t检验;3、残差标准差检验(SE检验。

•主要检验模型参数的符号、大小和变量之间的相关关系是否与经济理论和实际经验相符合。

一、经济意义检验i•二、统计检验•回归分析是要通过样本所估计的参数来代替总体的真实参数,或者说是用样本回归线代替总体回归线。

•尽管从统计性质上已知,如果有足够多的重复抽样,参数的估计值的期望(均值就等于其总体的参数真值,但在一次抽样中,估计值不一定就等于该真值。

那么,在一次抽样中,参数的估计值与真值的差异有多大,是否显著,这就需要进一步进行统计检验。

1、拟合优度检验拟合优度检验:对样本回归直线与样本观测值之间拟合程度的检验。

度量拟合优度的指标:判定系数(可决系数R2(1、总离差平方和的分解已知由一组样本观测值(X i ,Y i ,通过估计得到如下样本回归直线ii X Y 10ˆˆˆββ+=i i i i i i i y e Y Y Y Y Y Y y ˆˆ(ˆ(+=-+-=-=总离差平方和的分解ii X Y 10ˆˆˆββ+=ˆ(ˆY Y y i i -=i i i i i i i ye Y Y Y Y Y Y y ˆˆ(ˆ(+=-+-=-=Y 的i 个观测值与样本均值的离差由回归直线解释的部分回归直线不能解释的部分离差分解为两部分之和总离差平方和的分解公式:TSS=RSS+ESS,TSS 总离差平方和,ESS 为回归平方和,RSS 为残差平方和.((((((((0ˆˆˆ,0.0ˆˆ(ˆ(ˆˆ(2ˆˆ: 1022222222ˆˆˆˆˆˆ=+===-=-=--+=+=-+-=-+--+-=-+-=-=∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑ii i i i i ii i i i i i i i i i i i i i i i i i i i i i X e e Y e e e Y Y e Y Y e Y Y ESS RSS y e Y Y Y Y TSS Y Y Y YY Y Y YY Y Y Y Y Y Y Y ββ而因为证明TSS=ESS+RSSY的观测值围绕其均值的总离差(total variation可分解为两部分:一部分来自回归线(ESS,另一部分则来自随机部分(RSS。

从统计学看线性回归(1)——⼀元线性回归⽬录1. ⼀元线性回归模型的数学形式2. 回归参数β0 , β1的估计3. 最⼩⼆乘估计的性质 线性性 ⽆偏性 最⼩⽅差性⼀、⼀元线性回归模型的数学形式 ⼀元线性回归是描述两个变量之间相关关系的最简单的回归模型。

⾃变量与因变量间的线性关系的数学结构通常⽤式(1)的形式:y = β0 + β1x + ε (1)其中两个变量y与x之间的关系⽤两部分描述。

⼀部分是由于x的变化引起y线性变化的部分,即β0+ β1x,另⼀部分是由其他⼀切随机因素引起的,记为ε。

该式确切的表达了变量x与y之间密切关系,但密切的程度⼜没有到x唯⼀确定y的这种特殊关系。

式(1)称为变量y对x的⼀元线性回归理论模型。

⼀般称y为被解释变量(因变量),x为解释变量(⾃变量),β0和β1是未知参数,成β0为回归常数,β1为回归系数。

ε表⽰其他随机因素的影响。

⼀般假定ε是不可观测的随机误差,它是⼀个随机变量,通常假定ε满⾜:(2)对式(1)两边求期望,得E(y) = β0 + β1x, (3)称式(3)为回归⽅程。

E(ε) = 0 可以理解为ε对 y 的总体影响期望为 0,也就是说在给定 x 下,由x确定的线性部分β0 + β1x 已经确定,现在只有ε对 y 产⽣影响,在 x = x0,ε = 0即除x以外其他⼀切因素对 y 的影响为0时,设 y = y0,经过多次采样,y 的值在 y0 上下波动(因为采样中ε不恒等于0),若 E(ε) = 0 则说明综合多次采样的结果,ε对 y 的综合影响为0,则可以很好的分析 x 对 y 的影响(因为其他⼀切因素的综合影响为0,但要保证样本量不能太少);若 E(ε) = c ≠ 0,即ε对 y 的综合影响是⼀个不为0的常数,则E(y) = β0 + β1x + E(ε),那么 E(ε) 这个常数可以直接被β0 捕获,从⽽变为公式(3);若 E(ε) = 变量,则说明ε在不同的 x 下对 y 的影响不同,那么说明存在其他变量也对 y 有显著作⽤。

从统计学看线性回归(2)——⼀元线性回归⽅程的显著性检验⽬录1. σ2 的估计2. 回归⽅程的显著性检验 t 检验(回归系数的检验) F 检验(回归⽅程的检验) 相关系数的显著性检验 样本决定系数 三种检验的关系⼀、σ2 的估计 因为假设检验以及构造与回归模型有关的区间估计都需要σ2的估计量,所以先对σ2作估计。

通过残差平⽅和(误差平⽅和)(1)(⽤到和,其中)⼜∵(2)∴(3)其中为响应变量观测值的校正平⽅和。

残差平⽅和有n-2 个⾃由度,因为两个⾃由度与得到的估计值与相关。

(4)(公式(4)在《线性回归分析导论》附录C.3有证明)∴σ2的⽆偏估计量:(5)为残差均⽅,的平⽅根称为回归标准误差,与响应变量y 具有相同的单位。

因为σ2取决于残差平⽅和,所以任何对模型误差假设的违背或对模型形式的误设都可能严重破坏σ2的估计值的实⽤性。

因为由回归模型残差算得,称σ2的估计值是模型依赖的。

⼆、回归⽅程的显著性检验 ⽬的:检验是否真正描述了变量 y 与 x 之间的统计规律性。

假设:正态性假设(⽅便检验计算)1. t 检验 ⽤t 检验来检验回归系数的显著性。

采⽤的假设如下:原假设 H0:β1 = 0 (x 与 y 不存在线性关系)对⽴假设 H1:β1 ≠ 0 回归系数的显著性检验就是要检验⾃变量 x 对因变量 y 的影响程度是否显著。

下⾯我们分析接受和拒绝原假设的意义。

(1)接受 H0:β1 = 0 (x 与 y 不存在线性关系) 此时有两种情况,⼀种是⽆论 x 取值如何, y 都在⼀条⽔平线上下波动,即,如下图1,另⼀种情况为, x 与 y 之间存在关系,但不是线性关系,如图2。

图 1图 2 (2)拒绝 H0:β1 = 0 (x 对解释 y 的⽅差是有⽤的) 拒绝原假设也有两种情况,⼀种是直线模型就是合适的,如图 3,另⼀种情况为存在 x 对 y 的线性影响,也可通过 x 的⾼阶多项式得到更好的结果,如图 4。

一元线性回归公式一元线性回归公式是一种基本的统计学模型,它在统计学和机器学习领域中都有广泛应用,可以用来预测和分析两个变量之间的关系。

一元线性回归的公式可以通俗地表达为:Y = +X,其中Y为因变量,X为自变量,α为截距项,β为斜率。

一元线性回归的本质就是对两个变量之间的线性关系进行拟合,同时计算出两个变量之间的斜率β和截距项α。

两个变量之间的线性关系能够概括为Y = +X,其中X是自变量,Y是因变量,α是压力,β是应力。

由于一元线性回归模型只分析两个变量之间的关系,因此该模型也称为双变量回归模型。

一元线性回归的原理是什么呢?一元线性回归的原理是使用最小二乘法(Least Squares)来找到最佳拟合参数,以使所有样本点和拟合曲线之间的总误差最小。

通过最小二乘法,系统可以根据输入数据自动计算出α和β参数,从而实现回归拟合。

一元线性回归公式是一种重要的统计模型,用于分析两个变量之间的关系。

它能够解决各种数量和定性难题,比如预测消费者行为、分析市场趋势等,以及帮助企业做出数据驱动的决策。

统计学家除了使用一元线性回归公式外,还可以使用多元线性回归来分析多个变量之间的关系,多元线性回归旨在更加准确地预测多元变量之间的关系,从而获得更准确的预测结果。

一元线性回归模型可以很容易地使用统计分析软件或者编程语言实现,它是实现数据驱动的管理层面的有力武器。

此外,一元线性回归模型在机器学习领域中也有着重要的作用,因为它可以用来训练算法,从而帮助计算机更准确地预测结果。

总的来说,一元线性回归公式是一种广泛应用的基础统计学模型,它可以帮助企业进行数据驱动的决策,也可以用于机器学习算法的训练,从而提高算法预测的准确性。

一元线性回归方程回归系数的假设检验方法

一元线性回归方程是一种统计学方法,用于研究两个变量之间的关系。

它可以

用来预测一个变量(被解释变量)的值,另一个变量(解释变量)的值已知。

回归系数是一元线性回归方程的重要参数,它可以用来衡量解释变量对被解释变量的影响程度。

回归系数的假设检验是一种统计学方法,用于检验回归系数是否具有统计学意义。

它的基本思想是,如果回归系数的值不是0,则表明解释变量对被解释变量有

显著的影响,反之则表明解释变量对被解释变量没有显著的影响。

回归系数的假设检验一般采用t检验或F检验。

t检验是检验单个回归系数是

否具有统计学意义的方法,而F检验是检验多个回归系数是否具有统计学意义的方法。

在进行回归系数的假设检验时,首先要确定检验的显著性水平,一般为0.05

或0.01。

然后,根据检验的类型,计算t值或F值,并与检验的显著性水平比较,如果t值或F值大于显著性水平,则拒绝原假设,即认为回归系数具有统计学意义;反之,则接受原假设,即认为回归系数没有统计学意义。

回归系数的假设检验是一种重要的统计学方法,它可以用来检验回归系数是否

具有统计学意义,从而更好地理解解释变量对被解释变量的影响程度。