一元线性回归方程概述

- 格式:ppt

- 大小:1.76 MB

- 文档页数:63

一元线性回归方程

一元线性回归方程:当直线方程Y'=a+bx的a和b确定时,即为一元回归线性方程。

一元线性回归方程反映一个因变量与一个自变量之间的线性关系

一元线性回归方程反映一个因变量与一个自变量之间的线性关系,当直线方程Y'=a+bx的a和b确定时,即为一元回归线性方程。

经过相关分析后,在直角坐标系中将大量数据绘制成散点图,这些点不在一条直线上,但可以从中找到一条合适的直线,使各散点到这条直线的纵向距离之和最小,这条直线就是回归直线,这条直线的方程叫作直线回归方程。

注意:一元线性回归方程与函数的直线方程有区别,一元线性回归方程中的自变量X对应的是因变量Y的一个取值范围。

1. 根据提供的n对数据在直角坐标系中作散点图,从直观上看有无成直线分布的趋势。

即两变量具有直线关系时,才能建立一元线性回归方程。

2. 依据两个变量之间的数据关系构建直线回归方程:Y=a+bx。

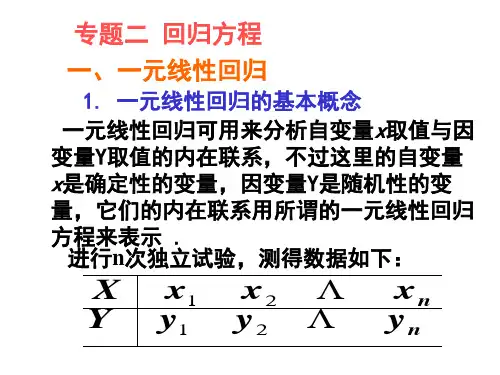

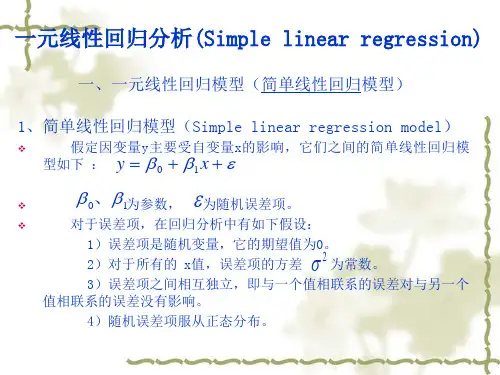

简单线性回归(Simple linear regression)也称为一元线性回归,是分析一个自变量(x)与因变量(y)之间线性关系的方法,它的目的是拟合出一个线性函数或公式来描述x与y之间的关系。

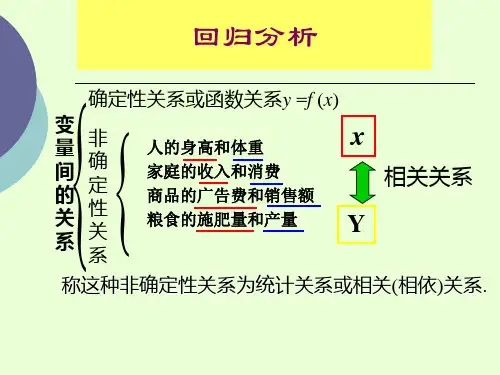

从统计学看线性回归(1)——⼀元线性回归⽬录1. ⼀元线性回归模型的数学形式2. 回归参数β0 , β1的估计3. 最⼩⼆乘估计的性质 线性性 ⽆偏性 最⼩⽅差性⼀、⼀元线性回归模型的数学形式 ⼀元线性回归是描述两个变量之间相关关系的最简单的回归模型。

⾃变量与因变量间的线性关系的数学结构通常⽤式(1)的形式:y = β0 + β1x + ε (1)其中两个变量y与x之间的关系⽤两部分描述。

⼀部分是由于x的变化引起y线性变化的部分,即β0+ β1x,另⼀部分是由其他⼀切随机因素引起的,记为ε。

该式确切的表达了变量x与y之间密切关系,但密切的程度⼜没有到x唯⼀确定y的这种特殊关系。

式(1)称为变量y对x的⼀元线性回归理论模型。

⼀般称y为被解释变量(因变量),x为解释变量(⾃变量),β0和β1是未知参数,成β0为回归常数,β1为回归系数。

ε表⽰其他随机因素的影响。

⼀般假定ε是不可观测的随机误差,它是⼀个随机变量,通常假定ε满⾜:(2)对式(1)两边求期望,得E(y) = β0 + β1x, (3)称式(3)为回归⽅程。

E(ε) = 0 可以理解为ε对 y 的总体影响期望为 0,也就是说在给定 x 下,由x确定的线性部分β0 + β1x 已经确定,现在只有ε对 y 产⽣影响,在 x = x0,ε = 0即除x以外其他⼀切因素对 y 的影响为0时,设 y = y0,经过多次采样,y 的值在 y0 上下波动(因为采样中ε不恒等于0),若 E(ε) = 0 则说明综合多次采样的结果,ε对 y 的综合影响为0,则可以很好的分析 x 对 y 的影响(因为其他⼀切因素的综合影响为0,但要保证样本量不能太少);若 E(ε) = c ≠ 0,即ε对 y 的综合影响是⼀个不为0的常数,则E(y) = β0 + β1x + E(ε),那么 E(ε) 这个常数可以直接被β0 捕获,从⽽变为公式(3);若 E(ε) = 变量,则说明ε在不同的 x 下对 y 的影响不同,那么说明存在其他变量也对 y 有显著作⽤。

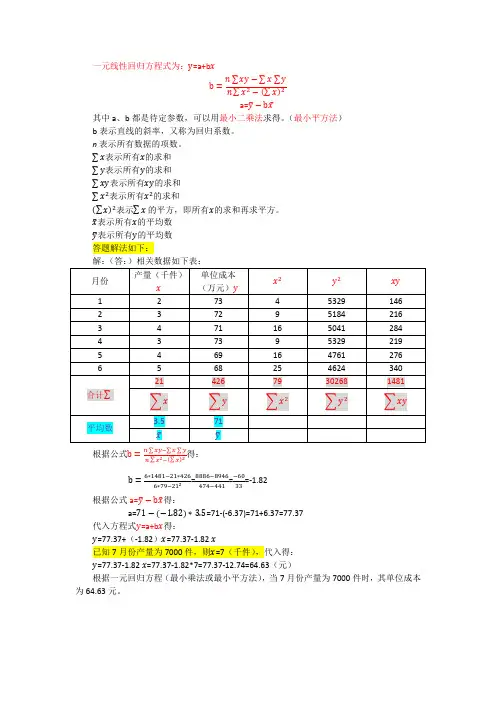

一元线性回归方程式为:y=a+b x

b=n∑xy−∑x∑y n∑x2−(∑x)2

a=y̅−bx̅

其中a、b都是待定参数,可以用最小二乘法求得。

(最小平方法)b表示直线的斜率,又称为回归系数。

n表示所有数据的项数。

∑x表示所有x的求和

∑y表示所有y的求和

∑xy表示所有xy的求和

∑x2表示所有x2的求和

(∑x)2表示∑x的平方,即所有x的求和再求平方。

x̅表示所有x的平均数

y̅表示所有y的平均数

答题解法如下:

解:(答:)相关数据如下表:

根据公式b=n∑xy−∑x∑y

n∑x2−(∑x)2

得:

b=6∗1481−21∗426

6∗79−212=8886−8946

474−441

=−60

33

=-1.82

根据公式a=y̅−bx̅得:

a=71−(−1.82)∗3.5=71-(-6.37)=71+6.37=77.37

代入方程式y=a+b x得:

y=77.37+(-1.82)x=77.37-1.82 x

已知7月份产量为7000件,则x=7(千件),代入得:

y=77.37-1.82 x=77.37-1.82*7=77.37-12.74=64.63(元)

根据一元回归方程(最小乘法或最小平方法),当7月份产量为7000件时,其单位成本为64.63元。

一、一元线性回归(一)基本公式如果预测对象与主要影响因素之间存在线性关系,将预测对象作为因变量y,将主要影响因素作为自变量x,即引起因变量y变化的变量,则它们之间的关系可以用一元回归模型表示为如下形式:y=a+bx+e其中:a和b是揭示x和y之间关系的系数,a为回归常数,b为回归系数e是误差项或称回归余项。

对于每组可以观察到的变量x,y的数值xi,yi,满足下面的关系:yi =a+bxi+ei其中ei是误差项,是用a+bxi去估计因变量yi的值而产生的误差。

在实际预测中,ei是无法预测的,回归预测是借助a+bxi得到预测对象的估计值yi。

为了确定a和b,从而揭示变量y与x之间的关系,公式可以表示为:y=a+bx公式y=a+bx是式y=a+bx+e的拟合曲线。

可以利用普通最小二乘法原理(ols)求出回归系数。

最小二乘法基本原则是对于确定的方程,使观察值对估算值偏差的平方和最小。

由此求得的回归系数为:b=[∑xiyi—x∑yi]/∑xi2—x∑xia=-b式中:xi、yi分别是自变量x和因变量y的观察值,、分别为x和y的平均值.=∑xi/ n ; = ∑yi/ n对于每一个自变量的数值,都有拟合值:yi’=a+bxiyi’与实际观察值的差,便是残差项ei=yi一yi’(二)一元回归流程三)回归检验在利用回归模型进行预测时,需要对回归系数、回归方程进行检验,以判定预测模型的合理性和适用性。

检验方法有方差分析、相关检验、t检验、f检验。

对于一元回归,相关检验与t检验、f检验的效果是等同的,因此,在一般情况下,通过其中一项检验就可以了。

对于多元回归分析,t检验与f检验的作用却有很大的差异。

1.方差分析通过推导,可以得出:∑(yi—y-)2= ∑(yi—yi’)2+∑(yi—y-)2其中:∑(yi—y-)2=tss,称为偏差平方和,反映了n个y值的分散程度,又称总变差。

∑(yi—yi’)2=rss,称为回归平方和,反映了x对y线性影响的大小,又称可解释变差。

一元一次回归方程english 概述说明以及解释1. 引言1.1 概述在统计学和机器学习中,回归分析是一种常见的数据分析方法,用于探索变量之间的关系。

其中,一元一次回归方程是最简单、常用的回归模型之一。

它描述了自变量X对因变量Y的线性影响,并可以通过拟合直线来预测或解释观测数据。

本文将全面介绍一元一次回归方程,包括定义、原理、建立过程以及求解方法。

我们还将通过应用举例分析,展示如何收集和处理数据,并建立与拟合模型。

最后,我们会探讨该模型在实际应用中的局限性,并提出改进方法。

1.2 研究背景回归分析被广泛应用于各个领域,如经济学、社会科学、医学等。

无论是预测市场需求还是研究药物效果,研究人员都需要有效地建立模型,并通过对数据进行分析来获得有价值的信息和结论。

随着技术和计算能力的发展,机器学习和人工智能已成为热门话题。

在这个背景下,了解和掌握一元一次回归方程的基本知识,对于从事相关研究和工作的专业人士至关重要。

1.3 研究目的本文旨在介绍一元一次回归方程的基本概念和原理,并通过实例分析展示其应用方法和解释结果。

具体目标如下:- 提供一元一次回归方程的定义,明确其适用范围和假设条件;- 解释建立过程,包括数据准备、变量选择等步骤;- 探讨常见的求解方法,如最小二乘法;- 通过实际案例,演示数据收集、模型建立与拟合的过程;- 对结果进行解释与评估,引导读者理解模型预测能力与可靠性;- 讨论该模型在实际应用中的局限性,并提出改进方法;- 总结关键要点并展望未来发展方向。

通过深入研究与分析一元一次回归方程,我们希望读者能够全面了解该模型的原理和应用方法,同时认识到其局限性以及可能的改进方向。

这将为读者在日后的研究与实践中提供有益指导。

2. 一元一次回归方程:2.1 定义和原理:一元一次回归方程是统计学中常用的线性回归模型。

它描述了一个自变量(x)和相应的因变量(y)之间的线性关系。

这种关系可以用数学表达式y = a + bx表示,其中a是截距,b是斜率。

EXCEL一元线性回归一、概述在数据分析中,对于成对成组数据的二、一元线性回归基本概念➢一元线性回归方程的建立回归系数ˆˆˆiiy x αβ=+αβˆi yˆi i i e y y=-[]222111ˆ(,)()()nnniii ii i i i Q eyyyx αβαβ=====-=-+∑∑∑(,)Q αβ,αβ,αβ1111222111()()()()ˆ()()n n i i n ni i i i i i xy i i nnxxii ni i ii x y x x y y x y L n L xx x xnβ=======---===--∑∑∑∑∑∑∑ˆˆy xαβ=-根据最小二乘法,可以得到一组正规方程组,对方程组求解,即可得到回归系数, 的计算式:ˆαˆβ三、软件(EXCEL)实现过程本功能需要使用Excel扩展功能,如果Excel尚未安装数据分析,需加载“分析数据库”。

加载成功后,可以在“数据”菜单中看到“数据分析”选项汽车马力(HP)每加仑汽油行驶里程(MPG)4965.455565555.970495346.57046.25545.46259.26253.38043.47341.49240.99240.97340.46639.67339.37838.99238.87838.29042.29240.97440.79540散点图直线拟合分析结果SUMMARY OUTPUT回归统计Multiple R 0.789925583R Square 0.623982426Adjusted R Square0.619282206标准误差6.174780275观测值82方差分析df SS MS F Significance F 回归分析15061.709525061.709523132.75601341.13931E-18残差803050.2329238.12791145总计818111.94244Coefficients标准误差t Stat P-value Lower 95%Upper 95%下限95.0%上限95.0%Intercept 50.07566277 1.5696920531.90158406 2.94532E-4746.951876153.199449446.951876153.19944943X Variable 1-0.1390738520.01207031-11.521979581.13931E-18-0.163094531-0.1150532-0.163094531-0.115053172Y=-0.1391+50.075和前面散点图直线拟合的结果一致“回归”工具为我们提供残差图、线性拟合图:线性拟合图谢谢!请批评指正!。

一元线性回归方程式的相关系数定义涉及的变量的相关信息一元线性回归是一种统计分析方法,用于确定两个变量之间的相关关系。

它假设有一个自变量x 和一个因变量y,并尝试找到一条能够最好地描述这种关系的直线。

相关系数是一种度量两个变量之间相关关系强度的统计量。

它被记为r,取值范围在-1 到1 之间。

如果r 的绝对值接近于1,则表示两个变量之间存在较强的线性关系;如果r 的绝对值接近于0,则表示两个变量之间存在较弱的线性关系;如果r 的绝对值等于0,则表示两个变量之间没有线性关系。

当r 大于0 时,表示两个变量之间存在正相关关系,即x 增大时y 也会增大;当r 小于0 时,表示两个变量之间存在负相关关系,即x 增大时y 会减小。

一元线性回归方程式是一种形式为y = ax + b 的方程,其中a 和b 是常数。

通过计算自变量x 和因变量y 的平均值和标准差,可以使用最小二乘法求出a 和b 的值。

一元线性回归分析可以帮助我们了解两个变量之间的相关关系,并预测因变量y 的值。

但是,这种方法假设存在线性关系,并且假设自变量x 和因变量y 之间没有其他因素的影响。

因此,在使用一元线性回归分析时,应确保自变量x 和因变量y 之间存在线性关系,并尽量减少其他因素的影响。

此外,也应注意相关系数的绝对值只能反映两个变量之间的线性关系强度,并不能反映其他类型的相关关系。