第四章一元线性回归

- 格式:ppt

- 大小:2.52 MB

- 文档页数:105

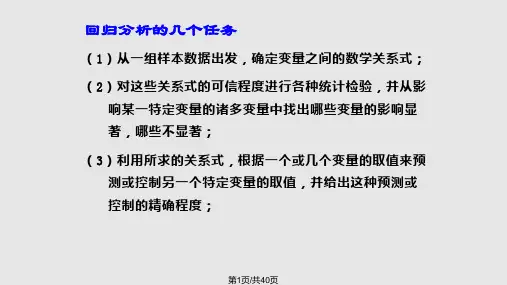

论述一元线性回归的基本步骤

一元线性回归是一种统计学方法,用来描述两个变量之间的线性关系,并建立相应的回归模型。

基本的步骤包括:

(1)确定数据源和变量:从数据源中收集相关的数据,并确定要进行研究的变量:x代表自变量,y代表因变量。

(2)进行各种统计分析:绘制散点图或残差图,用于可视化数据并判断是否存在线性关系;同时,计算出x与y之间的相关系数,试图发现x与y 之间的关联,以确定是否存在线性回归关系。

(3)拟合线性模型:使用常见的最小二乘法方法根据已有数据估计线性模型,即拟合误差平方和最小化的拟合直线,从而得到线性回归模型。

(4)检验线性模型:检验线性模型的有效性是至关重要的一步,可以检验残差图的正态分布假设、小概率假设和模型假设,可以构建R2、F值、AIC和BIC等指标,以进一步确定模型的有效性。

(5)预测新数据:如果经过上述模型检验发现线性模型是有效的,则可以用该模型预测新数据的结果。

总的来说,一元线性回归的基本步骤主要是确定数据源和变量,进行各种统计分析,拟合线性模型,检验模型的有效性,最后利用模型预测新的数据。

12.9 一元线性回归以前我们所研究的函数关系是完全确定的,但在实际问题中,常常会遇到两个变量之间具有密切关系却又不能用一个确定的数学式子表达,这种非确定性的关系称为相关关系。

通过大量的试验和观察,用统计的方法找到试验结果的统计规律,这种方法称为回归分析。

一元回归分析是研究两个变量之间的相关关系的方法。

如果两个变量之间的关系是线性的,这就是一元线性回归问题。

一元线性回归问题主要分以下三个方面:(1)通过对大量试验数据的分析、处理,得到两个变量之间的经验公式即一元线性回归方程。

(2)对经验公式的可信程度进行检验,判断经验公式是否可信。

(3)利用已建立的经验公式,进行预测和控制。

12.9.1 一元线性回归方程 1.散点图与回归直线在一元线性回归分析里,主要是考察随机变量y 与普通变量x 之间的关系。

通过试验,可得到x 、y 的若干对实测数据,将这些数据在坐标系中描绘出来,所得到的图叫做散点图。

例1 在硝酸钠(NaNO 3)的溶解度试验中,测得在不同温度x (℃)下,溶解于100解 将每对观察值(x i ,y i )在直角坐标系中描出,得散点图如图12.11所示。

从图12.11可看出,这些点虽不在一条直线上,但都在一条直线附近。

于是,很自然会想到用一条直线来近似地表示x 与y 之间的关系,这条直线的方程就叫做y 对x 的一元线性回归方程。

设这条直线的方程为yˆ=a+bx 其中a 、b 叫做回归系数(y ˆ表示直线上y 的值与实际值y i 不同)。

图12.11下面是怎样确定a 和b ,使直线总的看来最靠近这几个点。

2.最小二乘法与回归方程在一次试验中,取得n 对数据(x i ,y i ),其中y i 是随机变量y 对应于x i 的观察值。

我们所要求的直线应该是使所有︱y i -yˆ︱之和最小的一条直线,其中i y ˆ=a+bx i 。

由于绝对值在处理上比较麻烦,所以用平方和来代替,即要求a 、b 的值使Q=21)ˆ(i ni iyy-∑=最小。

第四章一元线性回归第一部分学习目的和要求本章主要介绍一元线性回归模型、回归系数的确定和回归方程的有效性检验方法。

回归方程的有效性检验方法包括方差分析法、t检验方法和相关性系数检验方法。

本章还介绍了如何应用线性模型来建立预测和控制。

需要掌握和理解以下问题:1 一元线性回归模型2 最小二乘方法3 一元线性回归的假设条件4 方差分析方法5 t检验方法6 相关系数检验方法7 参数的区间估计8 应用线性回归方程控制与预测9 线性回归方程的经济解释第二部分练习题一、术语解释1 解释变量2 被解释变量3 线性回归模型4 最小二乘法5 方差分析6 参数估计7 控制8 预测二、填空ξ,目的在于使模型更1 在经济计量模型中引入反映()因素影响的随机扰动项t符合()活动。

2 在经济计量模型中引入随机扰动项的理由可以归纳为如下几条:(1)因为人的行为的()、社会环境与自然环境的()决定了经济变量本身的();(2)建立模型时其他被省略的经济因素的影响都归入了()中;(3)在模型估计时,()与归并误差也归入随机扰动项中;(4)由于我们认识的不足,错误的设定了()与()之间的数学形式,例如将非线性的函数形式设定为线性的函数形式,由此产生的误差也包含在随机扰动项中了。

3 ()是因变量离差平方和,它度量因变量的总变动。

就因变量总变动的变异来源看,它由两部分因素所组成。

一个是自变量,另一个是除自变量以外的其他因素。

()是拟合值的离散程度的度量。

它是由自变量的变化引起的因变量的变化,或称自变量对因变量变化的贡献。

()是度量实际值与拟合值之间的差异,它是由自变量以外的其他因素所致,它又叫残差或剩余。

4 回归方程中的回归系数是自变量对因变量的()。

某自变量回归系数β的意义,指的是该自变量变化一个单位引起因变量平均变化( )个单位。

5 模型线性的含义,就变量而言,指的是回归模型中变量的( );就参数而言,指的是回归模型中的参数的( );通常线性回归模型的线性含义是就( )而言的。

一元线性回归分析摘要:一元线性回归分析是一种常用的预测和建模技术,广泛应用于各个领域,如经济学、统计学、金融学等。

本文将详细介绍一元线性回归分析的基本概念、模型建立、参数估计和模型检验等方面内容,并通过一个具体的案例来说明如何应用一元线性回归分析进行数据分析和预测。

1. 引言1.1 背景一元线性回归分析是通过建立一个线性模型,来描述自变量和因变量之间的关系。

通过分析模型的拟合程度和参数估计值,我们可以了解自变量对因变量的影响,并进行预测和决策。

1.2 目的本文的目的是介绍一元线性回归分析的基本原理、建模过程和应用方法,帮助读者了解和应用这一常用的数据分析技术。

2. 一元线性回归模型2.1 模型表达式一元线性回归模型的基本形式为:Y = β0 + β1X + ε其中,Y是因变量,X是自变量,β0和β1是回归系数,ε是误差项。

2.2 模型假设一元线性回归模型的基本假设包括:- 线性关系假设:自变量X与因变量Y之间存在线性关系。

- 独立性假设:每个观测值之间相互独立。

- 正态性假设:误差项ε服从正态分布。

- 同方差性假设:每个自变量取值下的误差项具有相同的方差。

3. 一元线性回归分析步骤3.1 数据收集和整理在进行一元线性回归分析之前,需要收集相关的自变量和因变量数据,并对数据进行整理和清洗,以保证数据的准确性和可用性。

3.2 模型建立通过将数据代入一元线性回归模型的表达式,可以得到回归方程的具体形式。

根据实际需求和数据特点,选择适当的变量和函数形式,建立最优的回归模型。

3.3 参数估计利用最小二乘法或最大似然法等统计方法,估计回归模型中的参数。

通过最小化观测值与回归模型预测值之间的差异,找到最优的参数估计值。

3.4 模型检验通过对回归模型的拟合程度进行检验,评估模型的准确性和可靠性。

常用的检验方法包括:残差分析、显著性检验、回归系数的显著性检验等。

4. 一元线性回归分析实例为了更好地理解一元线性回归分析的应用,我们以房价和房屋面积之间的关系为例进行分析。

4.6 习题练习1 一元线性回归模型函数的几何意义是什么?一元线性回归求解就是拟合直线系数W和b的最佳估计值,使得预测值Y的误差最小。

只要这两个系数确定了,直线方程也就确定了,就可以把要预测的值X代入方程求得对应的Y值。

练习2 解释和分析梯度下降算法的原理。

梯度下降法的基本思想可以类比为一个下山的过程,可以类比为一个下山的过程,假设这样一个场景∶一个人被困在山上,需要从山上下来(找到山的最低点,也就是山谷)。

但此时山上的浓雾很大,导致可视度很低。

因此,下山的路径就无法确定,他必须利用自己周围的信息去找到下山的路径。

这个时候,他就可以利用梯度下降算法来帮助自己下山。

具体来说就是,以他当前所处的位置为基准,寻找这个位置最陡峭的地方,然后朝着山的高度下降最多的地方走,(同理,如果我们的目标是上山,也就是爬到山顶,那么此时应该是朝着最陡峭的方向往上走)。

然后每走一段距离,都反复采用同一个方法,最后就能成功的抵达山谷。

梯度下降示意图原理:在微积分里面,对多元函数的参数求偏导数,把求得的各个参数的偏导数以向量的形式写出来,就是梯度。

比如函数f(x,y), 分别对x,y 求偏导数,求得的梯度向量就是(∂f ∂x ,∂f ∂y)T ,梯度向量的几何意义就是函数变化增加最快的地方。

具体来说,对于函数f(x,y),在点(x0,y0),沿着梯度向量的方向就是(∂f ∂x 0,∂f ∂y 0)T 的方向是f(x,y)增加最快的地方。

或者说,沿着梯度向量的方向,更加容易找到函数的最大值。

反过来说,沿着梯度向量相反的方向,也就是−(∂f ∂x 0,∂f ∂y 0)T 的方向,梯度减少最快,也就是更加容易找到函数的最小值。

练习3 说明逻辑回归的Sigmod 函数原理是什么? Sigmod 函数:x ex -+=11)(SSigmod 函数图像:Sigmod 函数可以将任意实数映射到(0, 1)之间,比较适合做二分类。

逻辑回归的输入是线性回归的输出,将Sigmoid 函数作用于线性回归的输出得到输出结果。

第六讲 一元线性回归在客观世界中, 普遍存在着变量之间的关系.数学的一个重要作用就是从数量上来揭示、表达和分析这些关系。

而变量之间关系, 一般可分为确定的和非确定的两类. 确定性关系可用函数关系表示, 而非确定性关系则不然.例如, 人的身高和体重的关系、人的血压和年龄的关系、某产品的广告投入与销售额间的关系等, 它们之间是有关联的,但是它们之间的关系又不能用普通函数来表示。

我们称这类非确定性关系为相关关系。

具有相关关系的变量虽然不具有确定的函数关系,但是可以借助函数关系来表示它们之间的统计规律,这种近似地表示它们之间的相关关系的函数被称为回归函数。

回归分析是研究两个或两个以上变量相关关系的一种重要的统计方法。

在实际中最简单的情形是由两个变量组成的关系。

考虑用下列模型表示)(x f Y =. 但是,由于两个变量之间不存在确定的函数关系,因此必须把随机波动考虑进去,故引入模型如下ε+=)(x f Y其中Y 是随机变量,x 是普通变量,ε是随机变量(称为随机误差)。

回归分析就是根据已得的试验结果以及以往的经验来建立统计模型,并研究变量间的相关关系,建立起变量之间关系的近似表达式,即经验公式,并由此对相应的变量进行预测和控制等。

本节主要介绍一元线性回归模型估计、检验以及相应的预测和控制等问题。

一、引例为了研究某一化学反应过程中温度x 对产品得率Y 的影响. 测得数据如下:89857874706661545145%/190180170160150140130120110100/i i y C x 温度温度试研究这些数据所蕴藏的规律性.二、一元线性回归模型一般地,当随机变量Y 与普通变量x 之间有线性关系时, 可设εββ++=x Y 10, (1)),,0(~2σεN 其中10,ββ为待定系数。

设),(,),,(),,(2211n n Y x Y x Y x 是取自总体),(Y x 的一组样本,而),(,),,(),,(2211n n y x y x y x 是该样本的观察值,在样本和它的观察值中的n x x x ,,,21 是取定的不完全相同的数值,而样本中的n Y Y Y ,,,21 在试验前为随机变量,在试验或观测后是具体的数值,一次抽样的结果可以取得n 对数据),(,),,(),,(2211n n y x y x y x ,则有i i i x y εββ++=10, n i ,,2,1 = (2)其中n εεε,,,21 相互独立。

一元线性回归分析的原理

一元线性回归分析是一种用于研究变量之间相互关系的统计分析方法。

它旨在

在一组数据中,以一个线性方程的式子去拟合变量之间的关系。

借此,分析一个独立变量(即自变量)和一个取决变量(即因变量)之间的关系,求出最合适的回归系数。

一元线性回归分析可以用来发现和描述变量之间的复杂方程式,用来估计参数,以及构建预测模型。

具体而言,一元线性回归分析指的是自变量和因变量之间有线性关系的回归分析。

也就是说,自变量和因变量均遵从一元线性方程,也就是y=βx+α,其中y

为因变量,x为自变量,β为系数,α为常数。

通过一元线性回归分析可以精确

的定义出变量之间的关系,从而可以得出最佳的回归系数和常数,并估计每个参数。

一元线性回归分析用于研究很多方面,例如决策科学、经济学和政治学等领域。

例如,在政治学研究中,可以使用一元线性回归分析来分析政府的软性政策是否能够促进社会发展,以及社会福利是否会影响民众的投票行为。

在经济学研究中,则可以使用一元线性回归分析来检验价格是否会影响消费水平,或检验工资水平是否会影响经济增长率等。

总结而言,一元线性回归分析是一种有效的研究变量之间关系的统计分析方法,精确地检验独立变量和取决变量之间的关系,从而求得最合适的回归系数和常数,并用该回归方程式构建预测模型,为决策提供参考。

一元线性回归分析的作用方法步骤一元线性回归分析是一种用来探究两个变量之间关系的统计方法。

它基于一个假设,即两个变量之间存在线性关系。

以下是一元线性回归分析的一般步骤:1. 数据收集:首先,需要收集所需的数据。

需要考虑收集的数据是否与研究目的相关,并确保数据的准确性和完整性。

2. 变量定义:定义自变量和因变量。

自变量是用来预测因变量的变量,而因变量是我们想要预测或解释的变量。

3. 数据探索:进行数据探索,包括数据的描述性统计和绘图。

这一步可以帮助我们了解数据的分布、异常值和离群点。

4. 模型选择:选择适当的线性模型。

这可以通过查看散点图、相关性分析和领域知识来完成。

通常,一个线性模型可以用以下方程表示:Y = β0 + β1X + ε,其中Y是因变量,X是自变量,β0和β1是回归系数,ε是误差项。

5. 模型估计:使用最小二乘法来估计回归系数。

最小二乘法的目标是找到最佳拟合直线,使得预测值与实际值之间的残差平方和最小化。

6. 模型评估:评估模型的拟合优度。

常用的指标包括R平方值和调整R平方值。

R平方值介于0和1之间,表示因变量变异性的百分比可以由自变量解释。

调整R平方值是对R平方值的修正,考虑了自变量的数量和样本量。

7. 模型解释:根据回归系数的估计值,解释自变量对因变量的影响。

根据回归系数的正负和大小,可以确定变量之间的关系是正向还是负向,并量化这种关系的强度。

8. 结果验证:验证模型的有效性和稳健性。

这可以通过对新数据集的预测进行测试,或使用交叉验证的方法来完成。

9. 结果解释:对模型结果进行解释,提供有关回归系数的结论,并解释模型对现实世界问题的意义。

总结来说,一元线性回归分析的方法步骤包括数据收集、变量定义、数据探索、模型选择、模型估计、模型评估、模型解释、结果验证和结果解释。

它们相互关联,构成了一元线性回归分析的完整过程。

《应⽤数理统计》吴翊李永乐第四章-回归分析课后作业参考答案第四章回归分析课后作业参考答案4.1 炼铝⼚测得铝的硬度x与抗张强度y的数据如下:i x68 53 70 84 60 72 51 83 70 64i y288 298 349 343 290 354 283 324 340 286(1)求y 对x的回归⽅程(2)检验回归⽅程的显著性(05.0=α) (3)求y在x =65处的预测区间(置信度为0.95) 解:(1) 1、计算结果⼀元线性回归模型εββ++=x y 10只有⼀个解释变量其中:x 为解释变量,y 为被解释变量,10,ββ为待估参数,ε位随机⼲扰项。

()()()()685.222,959.4116,541.35555.76725.19745.109610,5.3151,5.671221212112121211=-==-====-=-==-=--==-=-======∑∑∑∑∑∑∑∑========n Q U L Q L L U y n yyy L y x n y x y y x x L x n xxx L n y n y x n x ee yy e xxxyni ini i yy ni i i n i i i xy ni ini i xx ni i n i i σ使⽤普通最⼩⼆乘法估计参数10,ββ上述参数估计可写为95.193??,80.1?101=-===x y L L xxxy βββ所求得的回归⽅程为:x y80.195.193?+= 实际意义为:当铝的硬度每增加⼀个单位,抗张强度增加1.80个单位。

2、软件运⾏结果根据所给数据画散点图过检验由线性回归分析系数表得回归⽅程为:x y801.1951.193?+=,说明x 每增加⼀个单位,y 相应提⾼1.801。

(2) 1、计算结果①回归⽅程的显著性检验(F 检验):0H 线性回归效果不显著 :1H 线性回归效果显著()91.62/=-=n Q UF e在给定显著性⽔平05.0=α时,()()F F n F <==--32.58,12,195.01α,所以拒绝0H ,认为⽅程的线性回归效果显著②回归系数的显著性检验(t 检验)0:10=βH 0:11≠βH()628.22/?1=-=n Q L t e xx β在给定显著性⽔平05.0=α时,()()t t n t<==--306.282975.021α,所以拒绝0H ,认为回归系数显著,说明铝的硬度对抗张强度有显著的影响。