非线性成分分析作为一个核的特征值问题

- 格式:doc

- 大小:447.00 KB

- 文档页数:20

2009年第6期 科技管理研究Science and Technol ogy Manage ment Research 2009No 16收稿日期:2008-09-25,修回日期:2008-11-05基金项目:黑龙江省社会科学基金项目(05B0142);黑龙江省自然科学基金项目(G200606)文章编号:1000-7695(2009)06-0128-03对主成分分析三点不足的改进徐永智1,2,华惠川2(11吉林大学东北亚研究院,吉林长春 130012;21黑龙江科技学院经济管理学院,黑龙江哈尔滨 150027)摘要:首先通过均值化和对数中心化处理改进主成分分析的特征提取,其次通过比较最优与最劣样本的主成分数值大小,判定特征向量方向,用熵值法对主成分的综合值计算进行改进。

最后,文章用改进后的主成分方法对中国东部各省市区域创新能力进行综合评价。

关键词:主成分分析;均值化;对数中心化;熵值法中图分类号:C93111文献标识码:A1 问题的提出主成分分析在多指标综合评价中被广泛应用。

但在实际应用中,几乎每个步骤都有值得探讨或改进之处。

本文在前人文献的基础上,总结了具体存在三个问题,并在第二部分对这些问题一一做了解决,最后给出一个实例进行具体应用。

其中,本文在第一部分总结出主成分分析在特征提取、特征向量方向确定以及主成分综合值计算中需要改进的地方。

问题一是,通过将指标正态标准化会存在信息丢失问题,从而使得特征提取性下降,并且当指标间线性程度不高时,应用线性主成分方法也会造成特征提取能力下降的问题。

首先,从原始数据的协方差矩阵可以知道,协方差矩阵包含两部分信息。

一是对角线上的信息,它就是各个指标的方差,反映的是各指标的变异。

二是对角线之外的信息,即各指标间的协方差,它反映的是指标间的相互影响,由相关矩阵体现,因为当指标i 与指标j 的方差不变时,协方差就与指标间的线性相关程度成正比。

但传统的正态标准化方法使各指标的方差变成1,即协方差矩阵的对角元素均为1,这样消除了各指标在变异程度上的差异,从中提取的主成分,只包含各指标间相互影响这一部分信息,显然不能准确反映原始数据所包含的全部信息,所以必须改进这种方法。

kpca例题含解答KPCA(Kernel Principal Component Analysis,核主成分分析)是一种非线性降维方法KPCA (Kernel Principal Component Analysis,核主成分分析)是一种非线性降维方法,它通过将原始数据映射到高维空间,然后在高维空间中进行主成分分析来实现降维。

下面是一个关于KPCA的例题及解答:例题:假设我们有一组二维数据点,如下所示:(1,2),(2,3),(3,4),(4,5)我们希望使用KPCA将这些数据点降维到一维空间。

请问如何选择合适的核函数和参数?解答:首先,我们需要选择一个核函数。

常用的核函数有线性核、多项式核、高斯径向基核(RBF)等。

在这个例子中,我们可以选择线性核或RBF核。

接下来,我们需要确定核函数的参数。

对于线性核,参数为0;对于RBF核,参数为σ(标准差)。

我们可以分别尝试这两种核函数和参数组合,然后比较降维后的效果。

例如,我们可以尝试使用线性核和RBF核,参数分别为0和1。

1. 使用线性核:由于线性核实际上就是普通的PCA,所以降维后的数据点仍然是原数据点。

因此,我们可以认为线性核在这个例子中没有起到作用。

2. 使用RBF核:我们将数据点映射到高维空间,然后在高维空间中进行主成分分析。

这里我们选择σ=1作为RBF核的参数。

降维后的数据点可以通过以下公式计算:γ= (x -μ)^T K^+ y其中,x是原始数据点,y是降维后的数据点,μ是数据的均值向量,K^+是K的伪逆矩阵。

计算得到降维后的数据点为:(-1, -1),(-1, 0),(0, 1),(1, 1)可以看到,使用RBF核和σ=1作为参数时,数据点成功地被降维到了一维空间。

因此,我们可以选择RBF核和σ=1作为这个例子中的参数。

主成分分解定理主成分分析(Principal Component Analysis, PCA)是一种常用的无监督学习方法,被广泛应用于数据预处理、降维和数据可视化等领域。

主成分分析的目标是将原始数据投影到一个低维空间中,尽可能地保留原始数据的信息,同时最大化投影后的方差。

主成分分析的核心是主成分分解定理,它是主成分分析方法的理论基础。

主成分分解定理是主成分分析的核心定理之一。

它的关键思想是通过线性变换,将原始数据投影到一个新的坐标系中。

具体来说,假设我们有一个n维的数据集,其中每个样本有d个特征。

那么主成分分解定理的目标是找到一个d维的线性子空间,使得投影后的样本方差最大。

这些d个线性子空间上的基向量称为主成分。

我们假设原始数据集为X,其中每一行表示一个样本,每一列表示一个特征。

为了方便讨论,我们先将原始数据集进行均值中心化操作,即对每个特征减去其均值。

记X'为中心化后的数据集。

根据主成分分解定理的定义,我们可以将上述问题转化为求解一个投影矩阵W,使得投影后的数据集X'W的方差最大。

具体来说,我们需要使得投影后的数据集的协方差矩阵的特征值最大。

这样,我们就可以获得投影矩阵W的最优解。

为了求解投影矩阵W,我们需要先计算协方差矩阵C=X'X'/n,其中n表示样本的个数。

然后,我们可以对协方差矩阵C进行特征值分解,得到特征值λ1,λ2,...,λd,并对应的特征向量u1,u2,...,ud。

这些特征向量对应着投影矩阵W的列向量。

按照特征值从大到小的顺序,我们可以选择前k个特征值和对应的特征向量,构成投影矩阵W。

这样,我们就将原始的d 维数据集投影到一个k维的子空间中。

在投影后的子空间中,每个样本的特征由原始样本在各个特征上的投影表示。

这些投影在子空间中是线性无关的,且能够最大化样本方差。

通过对主成分分解定理的理解,我们可以得出以下结论:1. 主成分分解定理可以将原始数据投影到一个低维子空间中,尽可能地保留数据的信息。

第三部分非线性分析第一章非线性有限元概述1.1非线性行为1、 非线性结构的基本特征是结构刚度随载荷的改变而变化。

如果绘制一个非线 性结构的载荷一位移曲线,则 力与位移的关系是非线性函数。

2、 引起结构非线性的原因:a 几何非线性:大应变,大位移,大旋转 (例如钓鱼竿的变形)b 材料非线性:塑性,超弹性,粘弹性,蠕变c 状态改变非线性:接触,单元死活3、 非线性行为一一分析方法特点A 不能使用叠加原理!B 结构响应与路径有关,也就是说加载的顺序可能是重要的。

C 结构响应与施加的载荷可能不成比例。

1.2非线性分析的应用1、 一些典型的非线性分析的应用包括: 非线性屈曲失稳分析金属成形研究碰撞与冲击分析制造过程分析(装配、部件接触等)材料非线性分析 (塑性材料、聚合物)2、 橡胶底密封:一个包含几何非线性(大应变与大变形),材料非线性(橡胶), 及状态非线性(接触)的例子。

2.1非线性方程组的解法1、求解一个结构的平衡问题通常等于求解结构的总位能的驻值 问题。

结构总位能n : 口 "3弋门心 2、 增量法:就是将荷载分成一系列的荷载增量,即 ANSYS 中的荷载步或荷载子 步。

A 要点:在每一个荷载增量求解完成后,继续进行下一个荷载增量之前, 刚度矩阵以反映结构刚度的变化。

B 增量法的优点:可以追踪结构变形历程,这对于材料或几何非线性(特别是 极限值屈曲分析)十分有用。

C 增量法的缺点:随着荷载步增量的增加而产生积累误差,导致荷载-位移曲 线飘移。

D 对飘移进行平衡修正,可以大大提高增量法的精度。

应用最广的就是在每一 级载荷增量上用Newton-Raphsor 或其变形的迭代法。

3、 迭代法:割线刚度法:收敛性差,因此很少应用切线刚度法Newto n-Ra phsor 迭代法:切向刚度法中 2.2 Newto n-Ra phsor 迭代法 1、 优点:对于一致的切向刚度矩阵有 二次收敛速度。

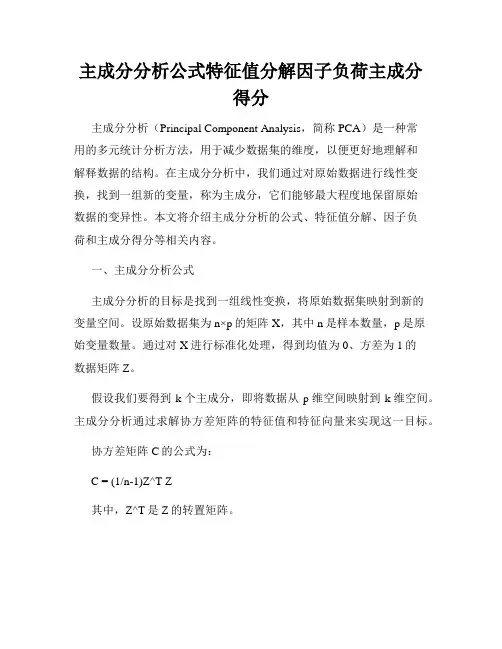

主成分分析公式特征值分解因子负荷主成分得分主成分分析(Principal Component Analysis,简称PCA)是一种常用的多元统计分析方法,用于减少数据集的维度,以便更好地理解和解释数据的结构。

在主成分分析中,我们通过对原始数据进行线性变换,找到一组新的变量,称为主成分,它们能够最大程度地保留原始数据的变异性。

本文将介绍主成分分析的公式、特征值分解、因子负荷和主成分得分等相关内容。

一、主成分分析公式主成分分析的目标是找到一组线性变换,将原始数据集映射到新的变量空间。

设原始数据集为n×p的矩阵X,其中n是样本数量,p是原始变量数量。

通过对X进行标准化处理,得到均值为0、方差为1的数据矩阵Z。

假设我们要得到k个主成分,即将数据从p维空间映射到k维空间。

主成分分析通过求解协方差矩阵的特征值和特征向量来实现这一目标。

协方差矩阵C的公式为:C = (1/n-1)Z^T Z其中,Z^T是Z的转置矩阵。

我们可以对协方差矩阵C进行特征值分解,得到特征值和特征向量。

特征值代表了每个主成分所解释的方差比例,特征向量则表示主成分的方向。

二、特征值分解特征值分解是一种常见的矩阵分解方法,可以将一个矩阵分解为特征值和特征向量的乘积形式。

对于协方差矩阵C,特征值分解的公式为:C = Q∑Q^T其中,Q是特征向量的矩阵,∑是特征值的对角矩阵。

特征向量矩阵Q的列向量对应着主成分的方向,而特征值矩阵∑的对角线元素则代表了各个主成分所解释的方差比例。

三、因子负荷因子负荷可以用来衡量原始变量与主成分之间的关系,它代表了每个原始变量在主成分中的权重或重要程度。

设主成分的特征向量矩阵Q为[q1, q2, ..., qk],原始变量的标准化矩阵Z对应的因子负荷矩阵为A,则A的第j列可以计算为:aj = qj × √λj其中,qj是特征向量矩阵Q的第j列,λj是特征值矩阵∑的第j个对角线元素。

因子负荷矩阵A的元素越大,说明对应的原始变量在主成分中的重要程度越高。

非线性成分分析作为一个核的特征值问题 摘要 我们用于一种新方法描述如何执行主成分分析非线性形式。通过对积分算子核函数的使用。通过一些相关的非线性映射输入空间,我们可以有效计算在高维特征空间的主成分组成部分;比如在16 *16的图像空间中所有可能的5个像素的乘积。这篇论文中我们给出了该方法的推导,连同由非线性与内核的方法形成的讨论,并且展现目前对模式识别的非线性特征提取的第一批实验结果。 1 引入 主成分分析是尽可能提取高维数据集的一种强大的配套技术.它很容易通过求解一个特征值问题或者用迭代算法来估计主成分;现有的文献(看Jolliffe(1986) and Diamataras & Kung (1996))。PCA是将我们所描述的数据的坐标系进行正交变换。用新的坐标值所表示的数据我们称为主成分。通常情况下,少数的主成分组足以说明数据的主要结构。这些少数的数据我们有时候叫做数据的因素及潜在变量。 目前的主成分分析的推广工作,我们相对投射空间的主要成分而言,对输入空间中的变量或特征更感兴趣,因为它与输入变量时非线性相关的。其中包括对输入变量之间采取高层次的相关性得到的实例变量。在图像分析的情况下,这就相当于是对输入数据所张成的空间就行寻找主要成分。 为了这个目的,我们在输入空间中依据核函数来表达特征空间中的点积。对于给出的任何一个算法我们都可以通过点积单独的被表示 出来,也就是说,即使变量本身没有明确的算法,我们也可以通过这个核函数组建不同的非线性函数。(Aizerman,Braverman,和 Rozonoer,1964;Boser,Guyon&Vapnik,1992)。尽管这个方法已被广泛的认知(Burges,1996),它的对机器学习的用途不是很大,除了在支持向量机方面。(Vapnik,1995) 在这篇论文中,我们给出了通过这种方法构造非线性函数的几个例子。第一个例子是主成分分析的非线性形式,我们将会给出方法的细节及实验结果(第2到4节),我们也将主要描绘出具体的算法(第7节)。 在下一节中,我们首先回顾一下标准PCA的算法。为了能把它推广到非线性情况下,我们将用对应的唯一的点积的方法将PCA算法公式化。在第3节中,我们将在特征空间中通过计算点积来讨论核方法。这两节主要是第4节的基础,第4节将提出对于非线性的PCA得核的基本算法。第5节中将讨论基本核PCA算法与其他推广的PCA算法的不同。在第6节中,我们将给出在模式识别的特征值提取中的核基本算法的一些第一次实验结果。然后在第7节将探讨关于核方法在其他领域的应用,将在第8节中对于探讨给出总结。最后,一些技术性的材料,对于论据不构成主要的线索我们将放入附录中。 2 特种空间的PCA 给出一组以M为中心的观测值1,1,...,,,0MNkkkkxkMxRx PCA算法对角化后的协方差矩阵为

11MTjjjCxxM (1) 为了做这个,首先解决特征值问题 vCv (2)

对于0特征值和NvR0且11()MjjjCvxvxM,对于V的值必须依赖于1...Mxx的跨度,因此,(2)就等价于 ()()kkxvxCv 1,...,kM

(3)

本节的其余部分是专门用来直接转换到非线性情况,为了在本论文中提出的方法做基础准备。我们应该现在就描述在空间F上的另一种点集的计算方法,它通过一个可能的非线性映射将输入空间映射到F空间 :,NRF xX (4) F所代表的就是特征空间,维数可能非常的大,很可能是无限的。 这里和下面的大写字母代表空间F中的元素而小写字母表示NR中的元素。 接下来,我们做一个假设,我们将数据中心化,也就是说

1()0Mkkx

然后我们将返回数据点。用空间F的协方差矩阵

11()(),MTjjjCxxM (5)

_______ 1更精确地说,这个协方差矩阵也被定义为TXX

的期望;为了方便,我们应该

通过一个有限的例子用同样的公式计算协方差矩阵来估计下(1)的极大似然率 (如果F是无限维的空间,我们认为通过映射XF到()(())jjxxX 将()(()Tjjxx作为线性算子,我们必须找到0个特征值以及 VF0个特征向量 满足 VCV (6)

和上面的讨论同理,V的解法也依赖于1,...,()()Mxx的跨度。对于我

们,我们得到了两个有用过的结论:第一个我们得到下面的等价不等式 (())(())kkxVxCV1,...,kM (7)

第二,存在系数(1,...,)iiM有

1()MiiiVx (8)

结合(7)式和(8)式,我们得

1111(()())(()(())(()())MMMikiikjjiiijxxxxxxM

1,...,kM (9)

定义一个MM矩阵K ()()ijjjKxx (10)

这就写成 2MKK (11)

其中记为用通过1,...,M作为向量的列。因为K是对称矩阵,它有一组可以长成整个空间的特征向量组成,即 MK (12) 给出方程式(11)的所有的解法。我们记K为半正定的,它就相当于

1,...,1,...,(()())(()())TMMxxxx (13) 它是只对于所有的XF都有 21,...,()(()())0MXFXxxX (14)

因此,K的特征值还都是正的,并且恰恰给出了方程式(11)的M的解法。我们因此只需对角化矩阵K。令12,.,M记为特征值,并且

1,...,M是对应的特征向量的一组集,从而p是第一个非零的特征值2。我们根据需要将,...,pM标准化那么对应的F中的向量也向被标准化,也就说 ()1kkVV ,....,kpM

(15)

依赖于(8)式和(12)式,把,...,pM转化成标准的形式:

,11(()())Mkkijjjijxx ,1MkkijijijK kkK

kk

k

(16)

为了提取主要成分,我们需要计算投影到F中的特征向量kV,(k=p,…,M) 令X为测试点,任意一个F上的图像()x,有 1(())(()())MkkiiiVxxx (17)

我们就称它为相应于的非线性主成分。 总之,下面的步骤就需要计算主要成分:第一,计算用式子(10)定义的矩阵K的点积;3第二步,计算它的特征向量以及在空间F中把它标准化;第三步,通过式子(17)计算讲测试点到特征向量上的投影。 为了简单起见,上文中提出的假设指观察的结果都是集中的。这个在输入空间很容易得到,但是在空间F上却很难得到,因为我们不能明确的计算出空间F的观察值的均值。然而,这有一种方法可以做到这一点,它会导致核基本PCA算法模式方程的轻微改变。(见附录A) 在我们进行下一节之前,我们更需要严密的研究映射的角色,下面的观察是必要的。在矩阵计算中使用的映射可以是任意的非线性映射到可能的高维空间F。例如,在一个输入向量空间中的项目的所有n阶单项式。在那样的情况下,我们需要计算通过映射的输入向量的点积,而且是一个尽可能大的计算消耗。对于这个问题的解决,将在下一节给出描述,事实上这个方法我们只需要唯一计算(10)和(17)式中的映射模式的点积,我们根本不需要明确映射的模式。_______ 2 如果我们需要的映射不能将所有的观测值都映射成0,那么这样的一个p

是永远存在的。 3 根据我们已经知道的结果(也就说Kirby&Sirovich,1990)PCA可以空过计算 点积矩阵,()ijijxx而不是方程式(1),然而,为了清楚和可拓展性的目地,(在目录A中我们可以考虑到在空间F中的数据都是被中心化了)我们给出更加细节的说明

3 在特征值空间计算点积

为了计算这个得点积形式(()())xy,我们用一个核函数来表示它 (,)(()())kxyxy (18)

这样就使我们可以通过计算空间F中的点积的值而不需要找到映射。这个方法用于Boser,Guyou,&Vapnik(1992)在拓展Vapnik&Chervonenkis(1974)“可推广的肖像”的超平面分离器到非线性支持向量机方面的应用。为了这个目的,他们将点积中所有情况都代替成一个预先选择的核函数。通过这种方式,Vapnik&Chervonenkis(1974)将这个有利的结果推广到了肖像识别的非线性情况。Aizerman,Braverman&Rozonoer(1964)叫F空间为“线性化空间”,并且用它依据隐函数分离的办法来根据输入空间的元素表达F中的元素之间的点积。如果空间F是高维的,我们想要为K找到一个封闭的形式来表达,为了更有效的计算。Aizerman et al.(1964)认为K是先天就选择的,不需要直接考虑对应的到F的映射。一个K的特殊选择就对应一个点积,这个点积也对应一个适合的映射。一个特别有用的例子,它是由Poggio(1975.引理2.1)在多项式近似值的背景下对结果进行直接的推广: ()(()()),dddxyCxCy (19)

其中dC向X映射到向量()dCx,将X中的有序对对应所有可能的第n个结果。例如(Vapnik,1995),如果12(,)xxx,那么222121221()(,,,)Cxxxxxxx