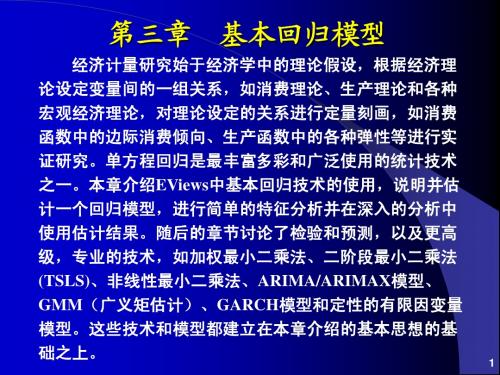

第03章 基本回归模型

- 格式:ppt

- 大小:1.50 MB

- 文档页数:132

第三章 一元线性回归模型一、预备知识(一)相关概念对于一个双变量总体,若由基础理论,变量和变量之间存在因果),(i i x y x y 关系,或的变异可用来解释的变异。

为检验两变量间因果关系是否存在、x y 度量自变量对因变量影响的强弱与显著性以及利用解释变量去预测因变量x y x ,引入一元回归分析这一工具。

y 将给定条件下的均值i x i yi i i x x y E 10)|(ββ+=(3.1)定义为总体回归函数(PopulationRegressionFunction,PRF )。

定义为误差项(errorterm ),记为,即,这样)|(i i i x y E y -i μ)|(i i i i x y E y -=μ,或i i i i x y E y μ+=)|(i i i x y μββ++=10(3.2)(3.2)式称为总体回归模型或者随机总体回归函数。

其中,称为解释变量x (explanatory variable )或自变量(independent variable );称为被解释y 变量(explained variable )或因变量(dependent variable );误差项解释μ了因变量的变动中不能完全被自变量所解释的部分。

误差项的构成包括以下四个部分:(1)未纳入模型变量的影响(2)数据的测量误差(3)基础理论方程具有与回归方程不同的函数形式,比如自变量与因变量之间可能是非线性关系(4)纯随机和不可预料的事件。

在总体回归模型(3.2)中参数是未知的,是不可观察的,统计计10,ββi μ量分析的目标之一就是估计模型的未知参数。

给定一组随机样本,对(3.1)式进行估计,若的估计量分别记n i y x i i ,,2,1),,( =10,),|(ββi i x y E 为,则定义3.3式为样本回归函数^1^0^,,ββi y ()i i x y ^1^0^ββ+=n i ,,2,1 =(3.3)注意,样本回归函数随着样本的不同而不同,也就是说是随机变量,^1^0,ββ它们的随机性是由于的随机性(同一个可能对应不同的)与的变异共i y i x i y x 同引起的。

生物统计学

回归模型

一、函数关系与统计关系

二、回归模型的确定

三、建立回归模型关系的方法步骤三、例题

函数关系如,园的面积计算公式模型关系如统计关系:回归与相关关系一、函数关系与统计关系

)

x (f y =2

R

S π=ε

+=)x (f y ε

βα++=x

y

二、回归模型的确定

f(x)函数多种多样,那么回归模型也是多种多样的。

自变数x为一个或者多个。

依据函数关系,回归模型:直线回归、多元回归、曲线回归、多项式回归、非线性回归,等等。

确定模型的依据

(1)依据因果关系;

(2)依据机理,确定回归关系。

农作物籽粒灌浆期线性增长期。

(3)依据试验设计和散点图形;

(g)水稻单株生物产量与稻谷产量的散点图

三、建立回归模型关系的方法步骤

(1)确定研究内容,明确建立模型的必要性;(2)形成关于模型的认识,预备试验;

(3)设计回归分析(试验设计)

(4)数据分析,建立可用性模型。

说明

回归分析知识体系比较完善、丰富,还请在应用过程中钻研相关知识。

谢谢!。

各种线性回归模型原理线性回归是一种广泛应用于统计学和机器学习领域的方法,用于建立自变量和因变量之间线性关系的模型。

在这里,我将介绍一些常见的线性回归模型及其原理。

1. 简单线性回归模型(Simple Linear Regression)简单线性回归模型是最简单的线性回归模型,用来描述一个自变量和一个因变量之间的线性关系。

模型方程为:Y=α+βX+ε其中,Y是因变量,X是自变量,α是截距,β是斜率,ε是误差。

模型的目标是找到最优的α和β,使得模型的残差平方和最小。

这可以通过最小二乘法来实现,即求解最小化残差平方和的估计值。

2. 多元线性回归模型(Multiple Linear Regression)多元线性回归模型是简单线性回归模型的扩展,用来描述多个自变量和一个因变量之间的线性关系。

模型方程为:Y=α+β1X1+β2X2+...+βnXn+ε其中,Y是因变量,X1,X2,...,Xn是自变量,α是截距,β1,β2,...,βn是自变量的系数,ε是误差。

多元线性回归模型的参数估计同样可以通过最小二乘法来实现,找到使残差平方和最小的系数估计值。

3. 岭回归(Ridge Regression)岭回归是一种用于处理多重共线性问题的线性回归方法。

在多元线性回归中,如果自变量之间存在高度相关性,会导致参数估计不稳定性。

岭回归加入一个正则化项,通过调节正则化参数λ来调整模型的复杂度,从而降低模型的过拟合风险。

模型方程为:Y=α+β1X1+β2X2+...+βnXn+ε+λ∑βi^2其中,λ是正则化参数,∑βi^2是所有参数的平方和。

岭回归通过最小化残差平方和和正则化项之和来估计参数。

当λ=0时,岭回归变为多元线性回归,当λ→∞时,参数估计值将趋近于0。

4. Lasso回归(Lasso Regression)Lasso回归是另一种用于处理多重共线性问题的线性回归方法,与岭回归不同的是,Lasso回归使用L1正则化,可以使得一些参数估计为0,从而实现特征选择。

回归模型的数学表达式回归模型是一种常见的统计分析方法,用于研究变量之间的关系。

它通过建立数学表达式,来预测一个或多个自变量与因变量之间的关系。

回归模型的数学表达式可以写成如下形式:y = β0 + β1x1 + β2x2 + ... + βnxn + ε其中,y表示因变量,x1, x2,..., xn表示自变量,β0, β1, β2, ..., βn 表示回归系数,ε表示误差项。

回归模型的目标是找到最佳的回归系数,使得模型能够最好地拟合数据。

回归模型的数学表达式可以分为线性回归模型和非线性回归模型。

线性回归模型是最简单的回归模型,假设自变量与因变量之间存在线性关系。

非线性回归模型则假设自变量与因变量之间存在非线性关系。

在线性回归模型中,回归系数表示自变量对因变量的影响程度。

例如,β1表示x1每变动一个单位对y的影响,β2表示x2每变动一个单位对y的影响,以此类推。

回归系数的正负号表示自变量与因变量之间的正向或负向关系,而系数的大小表示影响的强度。

在非线性回归模型中,回归系数的解释与线性回归模型类似,但由于存在非线性关系,解释起来相对复杂。

非线性回归模型通常需要依赖于特定的函数形式,如指数函数、对数函数、幂函数等。

回归模型的数学表达式可以通过最小二乘法来求解。

最小二乘法是一种常用的参数估计方法,通过最小化观测值与回归模型预测值之间的误差平方和,来确定最佳的回归系数。

最小二乘法可以通过求解正规方程组或使用迭代算法来实现。

对于回归模型的数学表达式,我们可以根据具体的研究问题和数据特点,选择合适的自变量和函数形式,来构建回归模型。

在建立模型后,我们可以通过拟合优度和显著性检验等指标来评估模型的拟合程度和统计显著性。

回归模型的数学表达式是一种描述自变量与因变量关系的工具,通过建立数学模型,我们可以预测因变量的变化,并了解自变量对因变量的影响。

回归模型的数学表达式可以通过最小二乘法来求解,并根据具体问题选择合适的自变量和函数形式。

回归模型相关重要知识点总结一、线性回归有四个假设:线性:自变量(x)和因变量(y)之间应该存在线性关系,这意味着x值的变化也应该在相同方向上改变y值。

独立性:特征应该相互独立,这意味着最小的多重共线性。

正态性:残差应该是正态分布的。

同方差性:回归线周围数据点的方差对于所有值应该相同。

二、什么是残差,它如何用于评估回归模型残差是指预测值与观测值之间的误差。

它测量数据点与回归线的距离。

它是通过从观察值中减去预测值的计算机。

残差图是评估回归模型的好方法。

它是一个图表,在垂直轴上显示有残差,在x 轴上显示特征。

如果数据点随机散布在没有图案的线上,那么线性回归模型非常适合数据,否则我们应该使用非线性模型。

三、如何区分线性回归模型和非线性回归模型两者都是回归问题的类型。

两者的区别在于他们训练的数据。

线性回归模型假设特征和标签之间存在线性关系,这意味着如果我们获取所有数据点并将它们绘制成线性(直线)线应该适合数据。

非线性回归模型假设变量之间没有线性关系。

非线性(曲线)线应该能够正确地分离和拟合数据。

找出数据是线性还是非线性的三种最佳方法:残差图;散点图;假设数据是线性的,训练一个线性模型并通过准确率进行评估。

四、什么是多重共线性,它如何影响模型性能?当某些特征彼此高度相关时,就会发生多重共线性。

相关性是指表示一个变量如何受到另一个变量变化影响的度量。

如果特征 a 的增加导致特征 b 的增加,那么这两个特征是正相关的。

如果 a 的增加导致特征 b 的减少,那么这两个特征是负相关的。

在训练数据上有两个高度相关的变量会导致多重共线性,因为它的模型无法在数据中找到模式,从而导致模型性能不佳。

所以在训练模型之前首先要尽量消除多重共线性。

五、异常值如何影响线性回归模型的性能?异常值是值与数据点的平均值范围不同的数据点。

换句话说,这些点与数据不同或在第 3 标准之外。

线性回归模型试图找到一条可以减少残差的最佳拟合线。

如果数据包含异常值,则最佳拟合线将向异常值移动一点,从而增加错误率并得出具有非常高MSE 的模型。

回归模型1 回归模型的根本知识 模型简介主要应用在研究某些现象发生的概率p ,比方股票涨还是跌,公司成功或失败的概率,以及讨论概率p 与那些因素有关。

显然作为概率值,一定有10≤≤p ,因此很难用线性模型描述概率p 与自变量的关系,另外如果p 接近两个极端值,此时一般方法难以较好地反映p 的微小变化。

为此在构建p 与自变量关系的模型时,变换一下思路,不直接研究p ,而是研究p 的一个严格单调函数)(p G ,并要求)(p G 在p 接近两端值时对其微小变化很敏感。

于是变换被提出来:〔1〕其中当p 从10→时,)(p Logit 从+∞→∞-,这个变化范围在模型数据处理上带来很大的方便,解决了上述面临的难题。

另外从函数的变形可得如下等价的公式:XT XT T ee p Xppp Logit βββ+=⇒=-=11ln )( 〔2〕模型(2)的根本要求是,因变量〔y 〕是个二元变量,仅取0或1两个值,而因变量取1的概率)|1(X y P =就是模型要研究的对象。

而T k x x x X ),,,,1(21 =,其中i x 表示影响y 的第i 个因素,它可以是定性变量也可以是定量变量,T k ),,,(10ββββ =。

为此模型(2)可以表述成:kx k x k x k x kk eep x x pp βββββββββ+++++++=⇒+++=- 11011011011ln 〔3〕显然p y E =)(,故上述模型说明是k x x x ,,,21 的线性函数。

此时我们称满足上面条件的回归方程为线性回归。

线性回归的主要问题是不能用普通的回归方式来分析模型,一方面离散变量的误差形式服从伯努利分布而非正态分布,即没有正态性假设前提;二是二值变量方差不是常数,有异方差性。

不同于多元线性回归的最小二乘估计法那么(残差平方和最小),变换的非线性特征采用极大似然估计的方法寻求最正确的回归系数。

因此评价模型的拟合度的标准变为似然值而非离差平方和。