预备知识1线性模型

- 格式:docx

- 大小:800.20 KB

- 文档页数:77

在方差分析中,我们初步介绍了线性模型的思想,实际上,线性模型只是方差分析的模型化,其统计检验仍然是依照方差分解原理进行F检验。

线性模型作为一种非常重要的数学模型,通常可以分为方差分析模型、协方差分析模型、线性回归模型、方差分量模型等,根据表现形式又可以分为一般线性模型、广义线性模型、一般线性混合模型、广义线性混合模型。

下面我们就根据分析目的来介绍线性模型一、方差分析模型:使用线性模型进行方差分析的时候涉及一些基本概念:===============================================(1)因素与水平因素也称为因子,在实际分析中,因素就是会对结果产生影响的变量,通常因素都是分类变量,如果用自变量和因变量来解释,那么因素就是自变量,结果就是因变量。

一个因素下面往往具有不同的指标,称为水平,表现在分类变量上就是不同类别或取值范围,例如性别因素有男、女两个水平,有时取值范围是人为划分的。

(2)单元因素各水平之间的组合,表现在列联表中就是某个单元格,有些实验设计如拉丁方设计,单元格为空或无。

(3)元素指用于测量因变量值的最小单位,其实也就是具体的测量值。

根据具体的实验设计,列联表的一个单元格内可以有一个或多个元素,也可能没有元素。

(4)均衡如果一个实验设计中任一因素的各水平在所有单元格中出现的次数相同,且每个单元格内的元素数也相同,那么该实验就是均衡的。

不均衡的实验设计在分析时较为复杂,需要对方差分析模型作特别的设置才行。

(5)协变量有时,我们在分析某些因素的影响时,需要排除某个因素对因变量的影响,这个被排除的因素被称为协变量,(6)交互作用如果一个因素的效应大小在另一个因素的不同水平下表现的明显不同,则说明这两个因素之间存在交互作用。

交互作用是多因素分析时必须要做的,这样分析的结果才会全面。

(7)固定因素和随机因素是因素的两个种类,固定因素是指该因素的所有水平,在本次分析中全部出现,从分析结果就可以获知全部水平的情况。

数学模型可以看做是人们对复杂的现实问题进行简化描述的数学表达式,由于统计学来源于数学,因此在统计分析中,也普遍使用模型来分析问题。

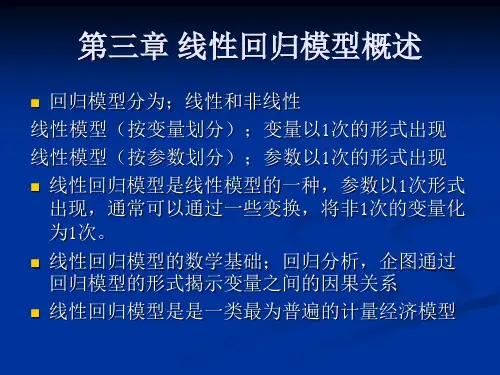

数学中模型的分类非常多,但统计学中最常用的模型是线性模型和非线性模型。

在此,首先明确几个概念1.线性关系线性关系是指自变量和因变量之间成比例的关系,即增量之间有固定的比例,比如X增加了m,那么Y就增加km,这里隐含着两个要点:(1)自变量与因变量是一次函数关系(2)函数图像呈一条过原点的直线,注意是要过原点2.非线性关系与线性关系相对应,非线性关系是指自变量和因变量之间没有固定的比例关系,二者之间不是一次函数关系,函数图像为曲线3.直线关系我们在做散点图考察变量关系时,发现呈直线趋势的话,就称其为具有线性关系,实际上这是不严谨的,因为线性关系特指函数图像为过原点的直线,当图像不过原点时,虽然也为直线,则不能称为线性关系,而应该称为直线关系。

只不过在统计分析中,大部分模型都有常数项,也就是截距,使得函数图不过原点,因此我们才会将二者等同起来。

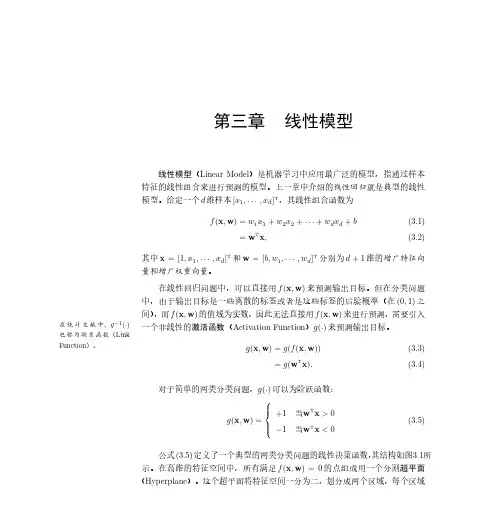

4.线性模型线性模型中的“线性”有两重含义,一个是自变量的线性,即自变量与因变量是一次函数关系,另一个是参数的线性,即因变量与各模型参数是一次函数关系。

其中第二点最为重要,当自变量不满足条件时,我们可以通过变量变换使其满足条件,而参数不满足线性条件时,往往不能通过变量变换解决(也有例外),因此我们将参数为线性的模型称为线性模型5.非线性模型由上可知,因变量与各模型参数是非线性关系的模型为非线性模型。

根据以上概念,我们可以做出如下划分在统计分析中,一般线性模型是应用最广泛同时也是最重要的是一类模型,它通常包括线性回归模型、方差分析模型、协方差分析模型、方差分量模型等,而广义线性模型本质上还是属于非线性模型,但是同时有一些其他非线性模型所不具备的性质,最大的区别是一般非线性模型没有明确的随机误差分布,而广义线性模型的随机误差分布是明确的,如二项分布、Poisson分布、负二项分布等,而当其为正态分布时,广义线性模型和一般线性模型是等价的。

【线性回归】线性回归模型中⼏个参数的解释【线性回归】线性回归模型中⼏个参数的解释R ⽅1. 决定系数/拟合优度类似于⼀元线性回归,构造决定系数。

称为y 关于⾃变量的样本复相关系数。

其中,,有SST=SSR+SSE总离差平⽅和记为SST ,回归平⽅和记为SSR ,残差平⽅和为SSE 。

由公式可见,SSR 是由回归⽅程确定的,即是可以⽤⾃变量x 进⾏解释的波动,⽽SSE 为x 之外的未加控制的因素引起的波动。

这样,总离差平⽅和SST 中能够由⽅程解释的部分为SSR ,不能解释的部分为SSE 。

1. 意义意味着回归⽅程中能被解释的误差占总误差的⽐例。

⼀般来说越⼤,拟合效果越好,⼀般认为超过0.8的模型拟合优度⽐较⾼。

需要注意的是当样本量⼩时,很⼤(例如0.9)也不能肯定⾃变量与因变量之间关系就是线性的。

随着⾃变量的增多,必定会越来越接近于1,但这会导致模型的稳定性变差,即模型⽤来预测训练集之外的数据时,预测波动将会⾮常⼤,这个时候就会对作调整,调整R ⽅可以消除⾃变量增加造成的假象。

F 检验0、预备知识(1)假设检验为了判断与检测X 是否具备对Y 的预测能⼒,⼀般可以通过相关系数、图形等⽅法进⾏衡量,但这只是直观的判断⽅法。

通过对回归参数做假设检验可以为我们提供更严格的数量化分析⽅法。

(2)全模型与简化模型我们称之为全模型(full Model,FM )通过对某些回归系数进⾏假设,使其取指定的值,把这些指定的值带⼊全模型中,得到的模型称为简化模型(reduced model,RM )。

常⽤的简化⽅法将在之后介绍。

1、F 检验检验是线性模型的假设检验中最常⽤的⼀种检验,通过值的⼤⼩可以判断提出的假设是否合理,即是否接受简化模型。

1. 为检验我们的假设是否合理,即评估简化模型相对全模型拟合效果是否⼀样好,需要先建⽴对两个模型拟合效果的评价⽅法。

这⾥我们通过计算模型的残差平⽅和()来衡量模型拟合数据时损失的信息量,也表⽰模型的拟合效果。

线性分类模型(一):线性判别模型分析前言前几篇文章介绍了线性回归算法,线性分类模型分为判别式模型和生成式模型,本文首先简单复习了与算法相关的数学基础知识,然后分析各线性判别式分类算法,如最小平方法,Fisher线性判别法和感知器法,最后总结全文。

目录1、相关的数学知识回顾2、判别式模型和生成性模型3、最小平方法4、Fisher线性判别函数5、感知器算法6、总结相关数学知识回顾1、直线方程和平面方程拓展到分类思想:直线l为分类决策方程,坐标点落在直线l上方时,则分类为C1;坐标点落在直线l下方时,则分类为C2(如下图)。

平面方程类似,在这里不展开。

2、点到直线和点到平面的距离点到直线的距离:点到平面的距离拓展到分类思想:平面方程为决策方程,正确分类的情况下,当点P到决策方程的距离越大,则分类模型越好;错误分类的情况下,点P到决策方程的距离作为损失函数,损失函数最小化过程即是模型参数最优化过程。

3、向量内积的数学意义几何意义:向量A与向量B的内积等于向量A在向量B的投影与向量B的乘积,当向量B是单位向量时,则等于向量A在单位向量方向的投影,单位向量类似于基函数或者可以理解成坐标轴,即向量A在向量B的投影可理解成向量A在向量B方向的坐标,如下图,B'是B 在OA坐标轴方向的投影。

拓展到分类思想:C1与C2属于不同的类,给定一条决策性直线l,当C1与C2在直线L2的投影间距越大,则分类效果越好。

增加不同类间的距离可以作为模型参数优化的方向。

如下图,C1和C2的在直线L2的投影距离|C1'C2'|大于|C1'C2'|,因此决策方程直线L2优于直线L1.4、梯度下降法函数f(x0,x1,...,xn)在梯度方向是函数值变化(增加或减少)最快的方向(本文只给出结论,后续文章会有详细的说明)。

拓展到分类思想:损失函数最小化过程即是模型参数最优化过程,损失函数最小化可通过梯度下降法来实现,当迭代到一定程度,损失函数收敛,则迭代结束,参数w即是要求的最优参数。

线性模型知识点总结一、线性模型概述线性模型是统计学中一类简单而又常用的模型。

在线性模型中,因变量和自变量之间的关系被描述为一个线性方程式。

线性模型被广泛应用于各种领域,如经济学、医学、社会科学等。

线性模型的简单和普适性使得它成为数据分析中的一种重要工具。

线性模型可以用来建立预测模型、对变量之间的关系进行建模和推断、进行变量选择和模型比较等。

在实际应用中,线性模型有多种形式,包括简单线性回归、多元线性回归、广义线性模型、岭回归、逻辑回归等。

这些模型在不同的情况下可以更好地满足数据的特点和要求。

二、线性回归模型1. 简单线性回归简单线性回归是最基本的线性模型之一,它描述了一个因变量和一个自变量之间的线性关系。

简单线性回归模型可以用如下的方程式来表示:Y = β0 + β1X + ε其中,Y是因变量,X是自变量,β0和β1分别是截距项和斜率项,ε是误差项。

简单线性回归模型基于最小二乘法估计参数,从而得到最优拟合直线,使得观测值和拟合值的离差平方和最小。

简单线性回归模型可以用来分析一个自变量对因变量的影响,比如身高和体重的关系、学习时间和考试成绩的关系等。

2. 多元线性回归多元线性回归是在简单线性回归的基础上发展而来的模型,它能够同时描述多个自变量对因变量的影响。

多元线性回归模型可以用如下的方程式来表示:Y = β0 + β1X1 + β2X2 + ... + βpXp + ε其中,X1、X2、...、Xp是p个自变量,β0、β1、β2、...、βp分别是截距项和各自变量的系数,ε是误差项。

多元线性回归模型通过估计各系数的值,可以得到各自变量对因变量的影响情况,以及各自变量之间的相关关系。

3. 岭回归岭回归是一种用来处理多重共线性问题的线性回归方法。

在多元线性回归中,如果自变量之间存在较强的相关性,会导致参数估计不准确,岭回归通过对参数加上一个惩罚项来避免过拟合,从而提高模型的稳定性和泛化能力。

岭回归模型可以用如下的方程式来表示:Y = β0 + β1X1 + β2X2 + ... + βpXp + ε - λ∑(β^2)其中,λ是岭参数,用来平衡参数估计和惩罚项之间的关系。

常用模型知识点总结图一、线性回归模型1.1. 简介线性回归是一种基本的回归分析方法,它用于建立因变量和一个或多个自变量之间的线性关系。

在线性回归模型中,我们假设因变量与自变量之间的关系是线性的,具体表达为:y = β0 + β1x1 + β2x2 + ... + βnxn + ε。

其中,y是因变量,x1, x2, ..., xn是自变量,β0是截距项,β1, β2, ..., βn是各自变量对应的系数,ε是残差项。

1.2. 模型的拟合与评价线性回归模型的拟合通常使用最小二乘法,即最小化残差平方和来估计模型参数。

评价模型通常可以使用R方值、调整R方值、均方差等指标来评估模型的拟合程度和预测能力。

1.3. 模型的应用线性回归模型适用于连续型因变量和定量型自变量之间的关系分析,可以用于价格预测、销售预测、生产量预测等领域。

二、逻辑回归模型2.1. 简介逻辑回归是一种用于解决分类问题的模型,它使用线性回归模型与逻辑函数的组合来进行分类。

逻辑回归模型的表达式可以表示为:p = 1 / (1 + e^(-z)),其中p为事件发生的概率,z为线性函数的和。

2.2. 模型的拟合与评价逻辑回归模型的拟合通常使用极大似然估计,即最大化事件发生的概率来估计模型参数。

评价模型通常可以使用准确率、召回率、精确率、F1值等指标来评估模型的分类能力。

2.3. 模型的应用逻辑回归模型适用于二分类和多分类问题,可以用于垃圾邮件过滤、信用评分、疾病预测等领域。

三、决策树模型3.1. 简介决策树是一种基于树形结构进行决策的模型,它通过特征选择和分裂节点的方式来建立分类或回归模型。

决策树模型的构建过程可以分为特征选取、节点分裂和剪枝三个步骤,其中特征选取通常使用信息增益、基尼系数等指标来选择。

3.2. 模型的拟合与评价决策树模型的拟合通常使用递归划分和修剪的方法来构建树结构,以最小化模型的复杂度和最大化模型的泛化能力。

评价模型通常可以使用准确率、召回率、精确率、F1值等指标来评估模型的分类能力。

线性模型的名词解释线性模型是统计学和机器学习领域中常见的一种模型。

它假设特征和目标变量之间存在线性关系,并通过拟合这种关系来进行预测或解释。

在本文中,我们将对线性模型的各个方面进行解释,包括基本概念、应用领域、优缺点以及相关的扩展方法。

1. 基本概念线性模型的核心概念是线性关系。

在统计学中,线性关系指的是变量之间可以用直线表示的关系。

对于一个简单的线性模型,我们可以用以下表达式表示:y = β0 + β1x1 + β2x2 + ... + βnxn + ε其中,y是目标变量,x1, x2, ..., xn是特征变量,β0, β1, β2, ..., βn是模型的参数,ε是误差项。

该公式中的每一项都表示了一个特征变量与目标变量之间的线性关系,而误差项则表示了模型无法完美拟合数据的部分。

2. 应用领域线性模型在许多领域都有广泛的应用。

在经济学中,线性回归模型被用于解释经济现象的关系,例如GDP与生产要素之间的关系。

在医学研究中,线性模型可以用于分析药物剂量与患者反应之间的关系。

此外,线性模型还可以应用于图像处理、自然语言处理和金融风险分析等领域。

3. 优缺点线性模型具有一些优点和缺点。

首先,线性模型参数的估计和推断相对简单直观,计算效率较高。

此外,线性模型对于特征之间的关联性要求较低,可以处理高维数据。

然而,线性模型的缺点是它对非线性关系的拟合能力较差,无法捕捉到复杂数据中的非线性关系。

此外,线性模型容易受到异常值的影响,对数据分布的假设(例如误差项的正态分布)也要求较高。

4. 相关的扩展方法为了克服线性模型的局限性,研究者们提出了许多扩展方法。

其中一种常见的方法是使用多项式回归模型。

多项式回归模型允许特征变量的指数大于1,从而能够更好地拟合非线性关系。

另一种方法是引入交互项,通过特征之间的相互作用来拟合更复杂的关系。

此外,还有一些非线性模型,如决策树和神经网络,可以用于解决非线性问题。

5. 结论线性模型是一种常见且重要的统计学和机器学习模型。

模型思维线性模型1 什么是线性模型?什么是线性模型?一个量的变化随另外一个,或多个量的变化关系是一种线性关系。

假如你每个月挣的收入是固定的1万元,工作一年,不算奖金的话就是12万,那么你的收入和月份就是一线性关系,如果建立一个收入随月份变化的模型,就是一个线性模型。

前面提到一个量可能只随一个量变化,这种模型就是单一线性模型,比如一个公司里的假期之和工作年限相关,且每多工作一年,假期就增加1天。

但常常一个量和多个量有关,那么建立的线性关系就是多元线性模型。

比如,我们常说的幸福,如果建立一个线性模型,就需要考虑健康,收入,人际关系等多个因素。

在《模型思维》中举了一个例子:数学成绩=21.1+9.2x学习的小时数+0.8x家庭经济状况+6.9x"快班"课程的数量这个模型中,学习成绩就和多个变量相关。

2 线性的价值2.1 量化关系和其它的模型类似,线性模型可以得到直观的量化关系,比如上面的数学成绩模型,如果学习7小时,且参加1个单位的“快班”课程,就可以获得接近90分的成绩。

你要离职?请出示数据中,我分享了自己工作切换的模型,其实那也是一个线性模型,通过这种模型就可以对不同的选择进行价值的量化,从而更好决策。

2.2 相关不是因果针对上面的模型,你可能会有疑问,针对上面的数学成绩模型,如果学习的小时数是100,那学习的成绩岂不是900多了,显然不合理。

当然这个问题,我们可以通过限定模型适用的变量范围来弥补,但是这里透漏了一个更重要的问题,就是线性模型建立的最多是一个相关关系,而不是因果关系,很有可能学习时间长度和参加“快班”这两个因素可能都没用,而是一一种“选择偏差”,那些花更多时间和参加“快班”学生的成绩本来就很好。

2.3 初选参数相关是不是就没用,当然不是,虽然它不能确定那些是关键要因,但是它可以排除其它解释,比如在《模型思维》这本书当中提到,在美国,一个白人家庭平均财富(约11万美元),可能是一个非洲裔家庭平均财富的10倍,各种各样的原因可以用来解释这个现象,比如制度差异,收入差距,储蓄行为差异或者结婚率,通过线性模型,能够初步的筛选发现,婚姻状况和家庭财富没有显著关系,而收入虽然有差距,但是也不足以解释这种财富差异。