16 Flume 日志收集工具

- 格式:pptx

- 大小:377.13 KB

- 文档页数:26

flume基础知识⼀、Flume简介 flume 作为 cloudera 开发的实时⽇志收集系统,受到了业界的认可与⼴泛应⽤。

Flume 初始的发⾏版本⽬前被统称为 Flume OG(original generation),属于 cloudera。

但随着 FLume 功能的扩展,Flume OG 代码⼯程臃肿、核⼼组件设计不合理、核⼼配置不标准等缺点暴露出来,尤其是在 Flume OG 的最后⼀个发⾏版本 0.9.4. 中,⽇ 志传输不稳定的现象尤为严重,为了解决这些问题,2011 年 10 ⽉ 22 号,cloudera 完成了 Flume-728,对 Flume 进⾏了⾥程碑式的改动:重构核⼼组件、核⼼配置以 及代码架构,重构后的版本统称为 Flume NG(next generation);改动的另⼀原因是将 Flume 纳⼊ apache 旗下,cloudera Flume 改名为 Apache Flume。

备注:Flume参考资料⼆、Flume特点flume是⼀个分布式、可靠、和⾼可⽤的海量⽇志采集、聚合和传输的系统。

⽀持在⽇志系统中定制各类数据发送⽅,⽤于收集数据;同时,Flume提供对数据进⾏简单处理, 并写到各种数据接受⽅(⽐如⽂本、HDFS、Hbase等)的能⼒。

flume的数据流由事件(Event)贯穿始终。

事件是Flume的基本数据单位,它携带⽇志数据(字节数组形式)并且携带有头信息,这些Event 由Agent外部的Source⽣成,当 Source捕获事件后会进⾏特定的格式化,然后Source会把事件推⼊(单个或多个)Channel中。

你可以把Channel看作是⼀个缓冲区,它将保存事件直到Sink处理完该事件。

Sink负责持久化⽇志或者把事件推向另⼀个Source。

1)flume的可靠性 当节点出现故障时,⽇志能够被传送到其他节点上⽽不会丢失。

Flume提供了三种级别的可靠性保障,从强到弱依次分别为:end-to-end(收到数据agent⾸先将 event写到磁盘上,当数据传送成功后,再删除;如果数据发送失败,可以重新发送。

flume的安装和使用总结-回复Flume是一个开源的、分布式、可靠和高可用的系统,用于将大量的日志数据从多个服务器收集并将其传输到中心化的数据存储或数据处理平台。

本文将详细介绍Flume的安装和使用过程,以及一些常见的使用方法和场景。

一、Flume的安装1. 准备工作在安装Flume之前,我们需要确保满足以下的准备工作:- JDK的安装:Flume是基于Java开发的,所以我们需要先安装JDK,并配置好环境变量。

- 选择并下载Flume的发布版本:可以从Apache官网上下载合适的Flume发布版本,选择与你服务器的操作系统和架构相匹配的版本。

2. 安装Flume下面是Flume的安装步骤:- 将下载好的Flume发布版本解压到一个合适的目录下,例如:/opt/flume。

- 配置Flume环境变量,在~/.bashrc文件的最后添加以下内容:bashexport FLUME_HOME=/opt/flumeexport PATH=PATH:FLUME_HOME/bin- 使环境变量生效,执行以下命令:bashsource ~/.bashrc- 在Flume的安装目录下创建一个新的目录,用于存放Flume的配置文件:bashmkdir FLUME_HOME/conf- 复制Flume的模板配置文件(位于FLUME_HOME/conf目录下)到新创建的配置目录,并对其进行修改:bashcp FLUME_HOME/conf/flume-conf.properties.template FLUME_HOME/conf/flume-conf.properties- 编辑flume-conf.properties配置文件,并根据自己的需求进行相应的修改。

3. 配置FlumeFlume的配置文件(flume-conf.properties)需要根据实际使用情况进行相应的修改。

下面简要介绍几个常见的配置项:- agent.sources:定义数据源,配置输入数据的来源,例如:日志文件、网络端口等。

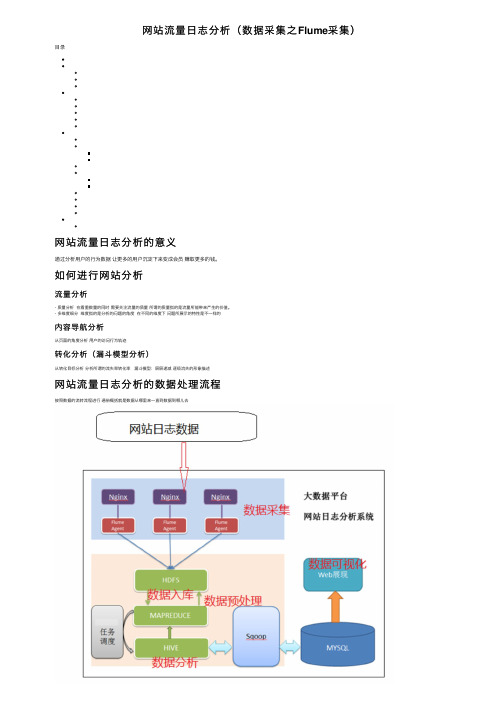

⽹站流量⽇志分析(数据采集之Flume采集)⽬录⽹站流量⽇志分析的意义通过分析⽤户的⾏为数据让更多的⽤户沉淀下来变成会员赚取更多的钱。

如何进⾏⽹站分析流量分析- 质量分析在看重数量的同时需要关注流量的质量所谓的质量指的是流量所能带来产⽣的价值。

- 多维度细分维度指的是分析的问题的⾓度在不同的维度下问题所展⽰的特性是不⼀样的内容导航分析从页⾯的⾓度分析⽤户的访问⾏为轨迹转化分析(漏⽃模型分析)从转化⽬标分析分析所谓的流失率转化率漏⽃模型:层层递减逐级流失的形象描述⽹站流量⽇志分析的数据处理流程按照数据的流转流程进⾏通俗概括就是数据从哪⾥来⼀直到数据到哪⼉去数据采集- 数据从⽆到有的过程:通过技术把客观事件量化成为数据(传感器收集服务器⽇志收集)- 数据搬运过程:把数据从⼀个存储介质传递到另⼀个存储介质中(Apache Flume)数据预处理- ⽬的:保证后续正式处理的数据是格式统⼀、⼲净规则的结构化数据- 技术:任何语⾔软件只要能够接受数据处理数据并且最终输出数据都可以⽤于数据预处理**选择MapReduce**- MR本⾝是java程序,语⾔⽐较熟悉可以⽆缝的调⽤java现有的开源库进⾏数据处理- MR是分布式的程序在预处理中如果数据量⽐较⼤可以分布式并⾏计算处理提⾼效率数据⼊库- 库:⾯向分析的数据仓库,也是就会Apache Hive- ⼊库的本质:经过ETL(抽取、转换、加载)把各个不同的数据源集中加载到数仓的分析主题下⾯。

数据分析- 本质:根据业务需求使⽤hive sql计算统计出各种不同的指标分析是⼀个持续的过程数据可视化尽量的使⽤图形表格的形式把分析的结果规律展⽰给别⼈看也称之为数据报表埋点数据采集数据从⽆到有的采集如何把⽤户的访问⾏为记录下来变成⽹站访问⽇志数据采集⽅式及其优缺点### ⽹站⽇志⽂件⽹站的web服务器⾃带⽇志记录的功能简单便捷的收集⼀些基础的属性信息常见的web服务器(Tomcat nginx apache server(httpd))优点:简单便捷⾃带功能不需要配置就可以使⽤缺点:收集的信息确定不利于维护收集的信息不够完整全⾯### 埋点JavaScript收集- ⽬标:不以影响⽤户的正常浏览体验作为标准数据采集分析锦上添花- 何为埋点```在待采集数据的页⾯上,预先置⼊⼀段JavaScript代码,当⽤户的某种⾏为满⾜JavaScript执⾏条件,触发JavaScript的执⾏,在执⾏的过程中进⾏数据的采集⼯作。

第一章单选题1、下列选项中,最早提出“大数据”这一概念的是()。

• A、贝恩• B、麦肯锡• C、吉拉德• D、杰弗逊参考答案:B答案解析:暂无解析2、下列选项中,哪一项是研究大数据最重要的意义()。

• A、分析• B、统计• C、测试• D、预测参考答案:D答案解析:研究大数据,最重要的意义是预测。

3、Hadoop1.0中,Hadoop内核的主要组成是()。

• A、HDFS和MapReduce• B、HDFS和Yarn• C、Yarn• D、MapReduce和Yarn参考答案:A答案解析:Hadoop1.0中,Hadoop内核的主要是由HDFS和MapReduce两个系统组成。

4、在HDFS中,用于保存数据的节点是()。

• A、namenode• B、datanode• C、secondaryNode• D、yarn参考答案:B答案解析:暂无解析多选题1、下列选项中,属于Google提出的处理大数据的技术手段有()。

• A、MapReduce• B、MySQL• C、BigTable• D、GFS参考答案:A,C,D答案解析:Google提出了三个处理大数据的技术手段,分别是MapReduce、BigTable和G FS。

2、下列选项中,属于Hadoop优势的有()。

• A、扩容能力强• B、可靠性• C、低效率• D、高容错性参考答案:A,B,D答案解析:Hadoop具有扩展能力强、成本低、高效率、可靠性、高容错性的优势。

3、下列选项中,属于Hadoop版本系列的有()。

• A、Hadoop4• B、Hadoop2• C、Hadoop1• D、Hadoop3参考答案:B,C,D答案解析:Hadoop主要分为Hadoop1、Hadoop2、Hadoop3三个系列的多个版本。

判断题1、大数据提供的是一些描述性的信息,而创新还是需要人类自己实现。

• 对• 错参考答案:对答案解析:暂无解析2、JobTracker只负责执行TaskTracker分配的计算任务。

flume的基本功能Flume的基本功能Flume是一个可靠、高可用性的分布式系统,用于收集、聚合和传输大规模数据。

它是Apache软件基金会的开源项目,旨在解决大数据环境下数据流动的问题。

Flume的基本功能包括数据源、数据通道和数据目的地三个方面。

一、数据源Flume支持多种数据源,包括日志文件、消息队列、文件系统等。

它可以监控这些数据源,并将数据采集到Flume Agent中进行处理。

Flume提供了多种数据源的适配器,可以方便地接入不同类型的数据源。

1. 日志文件Flume可以监控指定的日志文件,当文件发生变化时,自动将新的日志数据采集到Agent中。

这对于实时处理日志数据非常有用,可以及时获取系统运行状态、异常情况等信息。

2. 消息队列Flume可以与常见的消息队列系统集成,如Kafka、RabbitMQ等。

它可以从消息队列中消费数据,并将数据发送到Agent中进行处理。

这种方式适用于实时数据流的传输,保证数据的可靠性和高吞吐量。

3. 文件系统Flume可以监控指定的文件目录,当文件发生变化时,自动将新的文件内容采集到Agent中。

这对于处理大规模的文件数据非常有用,可以实现文件数据的实时传输和分析。

二、数据通道Flume使用可靠的数据通道将数据从数据源传输到数据目的地。

数据通道是Flume的核心组件,负责数据的传输和存储。

Flume提供了多种数据通道的实现,如内存通道、文件通道、Kafka通道等。

1. 内存通道内存通道是Flume默认的数据通道,它将数据暂存在Agent的内存中,然后按照指定的规则传输到下一个组件。

内存通道适用于数据量较小、实时性要求较高的场景。

2. 文件通道文件通道将数据暂存在Agent的文件系统中,然后按照指定的规则传输到下一个组件。

文件通道适用于数据量较大、实时性要求一般的场景。

3. Kafka通道Kafka通道是Flume与Kafka消息队列集成的一种数据通道。

flume的使用Flume是一种基于数据流的大数据采集工具,它可以实时地从不同源头中收集大量的数据,并且把这些数据传输到目标系统中进行处理。

这里,我们将学习如何使用Flume来采集数据。

第一步:准备环境在开始使用Flume之前,我们需要准备好一些环境。

首先,需要安装Java和Flume软件。

您可以从官方网站上下载最新版本的Java 和Flume软件。

然后,需要设置Flume的环境变量,在命令行中执行以下命令:export FLUME_HOME=/path/to/flumeexport PATH=$PATH:$FLUME_HOME/bin这将确保您可以在终端中访问Flume。

第二步:创建配置文件接下来,我们需要创建一个Flume配置文件,以便Flume知道从哪个源头收集数据,并将其传输到目标系统中。

配置文件的格式是Properties格式,我们可以使用任何文本编辑器来创建它。

以下是一个简单的配置文件示例:#定义agent名称agent.sources = source-1agent.channels = channel-1agent.sinks = sink-1#定义来源agent.sources.source-1.type = netcatagent.sources.source-1.bind = localhostagent.sources.source-1.port = 44444#定义通道agent.channels.channel-1.type = memoryagent.channels.channel-1.capacity = 1000#定义宿agent.sinks.sink-1.type = logger#绑定source和sink到channelagent.sources.source-1.channels = channel-1agent.sinks.sink-1.channel = channel-1在这个例子中,我们定义了一个名为“source-1”的源头,它是一个网络套接字,绑定在本地主机的44444端口。

flume的作用

flume是一个分布式、可靠、可扩展的系统,用于在大规模数据流中收集、聚合和移动数据。

它的作用包括:

1、数据收集:flume可以从各种来源(例如Web服务器、消息队列、文件系统等)收集数据,并将其发送到指定的目标位置。

2、数据聚合:flume可以将来自不同源的数据进行聚合,以便更好地理解和分析数据。

3、数据转换:flume可以将收集到的数据进行转换和过滤,以便满足特定的需求。

4、数据传输:flume可以将聚合和转换后的数据传输到不同的目标位置,例如HDFS、HBase、Elasticsearch等。

flume的应用非常广泛,以下是一些常见的应用场景:

1、日志收集和聚合:flume可以用于从各种来源(例如Web服务器、应用程序、数据库等)收集日志数据,并将它们聚合到一个地方进行分析。

2、数据备份和恢复:flume可以用于定期备份数据,并将备份数据传输到另一个位置以进行恢复。

3、数据清洗和转换:flume可以用于在收集数据之前对数据进行清洗和转换,以确保数据的一致性和准确性。

4、实时数据处理:flume可以用于实时处理数据,例如通过连接Kafka或Storm流式处理引擎来实现实时数据分析。

5、数据挖掘和机器学习:flume可以用于从大量数据中挖掘有价值的信息,并将这些信息传递给机器学习算法进行分析和预测。

flume可以帮助企业实现数据的采集、处理和传输,从而提高数据的可靠性、可用性和价值。

flume知识点Flume知识点一、概述Flume是一个可靠、可扩展且可管理的分布式日志收集系统,用于将日志数据从多个源头(如Web服务器、数据库、应用程序等)收集到中央存储(如Hadoop、HBase、Kafka等)中。

它是Apache软件基金会的开源项目,广泛应用于大数据领域。

二、架构Flume的架构由三个主要组件组成:Source、Channel和Sink。

1. Source:负责收集数据并将其传递给Channel。

Flume提供了多种类型的Source,如Avro Source、Spooling Directory Source 等,可以根据不同的需求选择合适的Source。

2. Channel:用于存储从Source接收到的事件。

Flume提供了多种类型的Channel,如Memory Channel、File Channel等,可以根据数据量和性能需求选择合适的Channel。

3. Sink:负责将从Channel中获取的事件传递给目标存储。

Flume 提供了多种类型的Sink,如HDFS Sink、HBase Sink等,可以根据数据存储的类型选择合适的Sink。

三、工作流程Flume的工作流程可以分为三个阶段:数据采集、数据传输和数据存储。

1. 数据采集:在数据采集阶段,Flume通过Source组件从不同的数据源中收集数据。

Source可以按照配置文件中的规则来监控数据源,并将收集到的数据传递给Channel。

2. 数据传输:在数据传输阶段,Flume将从Source收集到的数据传输到Channel。

Channel可以存储一定量的数据,以便在高负载情况下进行缓冲。

3. 数据存储:在数据存储阶段,Flume通过Sink组件将数据从Channel传输到目标存储。

Sink可以根据配置文件中的规则将数据存储到不同的存储系统中。

四、高可靠性Flume具有高可靠性的特点,可以确保数据的安全传输和存储。

1.日志收集工具_NCR(SaveLog)工具的使用(应用版本是0111以上的

请使用NCR.APTRA.LogsTool,参考2)

1)运行#Show date format.cmd显示系统日期格式

2)如果是2011/01/01这种运行#Collect - yyyy-mm-dd.cmd即可自动导出日志

3)如果是01/01/2011这种运行#Collect - mm-dd-yyyy.cmd即可自动导出日志

2.日志收集工具 NCR.APTRA.LogsTool使用

只针对V0111及以上版本

在C:\install下执行” NCR.APTRA.LogsTool.exe”的快捷方式(若没有这个快捷方式,可以执行C:\Program Files\NCR\bin\ NCR.APTRA.LogsTool.exe)。

注意,应用的版本为V0111版本以上才有该工具。

1)打开后会有如下程序界面。

2)上图的程序界面关闭即日志收集成功,等待时间视日志大小和设备主机的硬件配置

而定。

时间最多可达30分钟左右。

3)在D盘(C盘或者其他盘)的根目录下找ActivateMVLog文件夹。

ActivateMVLog

目录的子文件夹名称视厂商不同而不同,如NCR的设备在ActivateMVLog\NCR Corporation下即有收集的日志,格式为:ATM编号_YYYYMMDD_HHMMSS.zip。

简述flume的主要作用Flume是一个大数据处理框架,主要用于在分布式环境中高效地收集、聚合和传输大规模数据。

它的主要作用是实现可靠地、高吞吐量地将数据从源头收集到目的地。

Flume的主要作用可以概括为以下几点:1. 数据收集:Flume可以从各种不同的数据源中收集数据,包括日志文件、消息队列、数据库等。

它提供了多种数据源的适配器,可以轻松地配置和管理数据源,实现数据的实时收集。

通过Flume的数据收集功能,用户可以方便地获取分布式环境中的大量数据。

2. 数据聚合:在数据收集的过程中,Flume可以将来自不同数据源的数据进行聚合。

它支持多种不同的聚合策略,如时间窗口、大小窗口等,可以根据用户的需求进行配置。

通过数据聚合功能,用户可以将分散在不同数据源中的数据汇总到一起,方便后续的处理和分析。

3. 数据传输:Flume可以将收集到的数据传输到指定的目的地。

目的地可以是Hadoop集群中的HDFS、HBase等存储系统,也可以是Kafka、Spark等数据处理系统。

Flume提供了多种传输协议和格式,可以灵活地配置和管理数据传输。

通过数据传输功能,用户可以将收集到的数据高效地传输到指定的位置,方便后续的数据处理和分析。

4. 数据可靠性:Flume具有高度的可靠性和容错性。

它可以在数据传输过程中进行数据重试、数据丢弃、数据备份等操作,保证数据的完整性和可靠性。

Flume还支持数据的事务性处理,可以保证数据的一致性和可靠性。

通过数据可靠性功能,用户可以放心地使用Flume进行数据收集和传输,不用担心数据丢失或损坏的问题。

5. 数据扩展性:Flume具有良好的扩展性,可以满足不同规模和需求的数据处理场景。

它采用了分布式架构和可插拔的组件模型,可以方便地进行水平扩展和功能扩展。

Flume的组件之间可以进行灵活的配置和组合,可以根据用户的需求定制和扩展功能。

通过数据扩展性功能,用户可以根据实际情况灵活地调整和扩展Flume的能力。