第10章 聚类分析

- 格式:pdf

- 大小:344.86 KB

- 文档页数:14

聚类分析原理及步骤

一,聚类分析概述

聚类分析是一种常用的数据挖掘方法,它将具有相似特征的样本归为

一类,根据彼此间的相似性(相似度)将样本准确地分组为多个类簇,其中

每个类簇都具有一定的相似性。

聚类分析是半监督学习(semi-supervised learning)的一种,半监督学习的核心思想是使用未标记的数据,即在训

练样本中搜集的数据,以及有限的标记数据,来学习模型。

聚类分析是实际应用中最为常用的数据挖掘算法之一,因为它可以根

据历史或当前的数据状况,帮助组织做出决策,如商业分析,市场分析,

决策支持,客户分类,医学诊断,质量控制等等,都可以使用它。

二,聚类分析原理

聚类分析的本质是用其中一种相似性度量方法将客户的属性连接起来,从而将客户分组,划分出几个客户类型,这样就可以进行客户分类、客户

细分、客户关系管理等,更好地实现客户管理。

聚类分析的原理是建立在相似性和距离等度量概念之上:通过对比一

组数据中不同对象之间的距离或相似性,从而将它们分成不同的类簇,类

簇之间的距离越近,则它们之间的相似性越大;类簇之间的距离越远,则

它们之间的相似性越小。

聚类分析的原理分为两类,一类是基于距离的聚类。

第10章神经网络聚类方法

神经网络聚类方法是一种以神经网络技术为根基,以聚类分析为基础

的分类算法,它可以检测出不同数据之间的相似性,从而将这些数据分类

组织起来。

它的出现主要是为了解决传统聚类方法结果效果不佳的问题。

神经网络聚类方法的基本思想是,将聚类分析问题转化为神经网络模

型的问题,用神经网络解决聚类问题,尤其是使用核函数来表示簇之间的

关系,使用反向传播算法来优化神经网络,得出最优聚类结果。

根据神经网络聚类方法的结构,可以将神经网络聚类方法分为两类:

一种是基于核映射的神经网络聚类,另一种是基于自组织映射的神经网络

聚类。

基于核映射的神经网络聚类的典型代表有核聚类神经网络,它是由一

个输入层、一个隐含层和一个输出层构成的神经网络,它的基本思想是使

用一种核函数来表示簇之间的关系,并用反向传播算法来优化该神经网络,使其能够得出较为精确的聚类结果。

基于自组织映射的神经网络聚类则由一个输入层、一个隐含层和一个

自组织映射(SOM)层构成的神经网络,其基本思想是使用一种自组织映射

函数来表示簇之间的关系,并用反向传播算法来优化该神经网络。

聚类分析(ClusterAnalysis)(一)什么是聚类聚类,将相似的事物聚集在一起,将不相似的事物划分到不同的类别的过程。

是将复杂数据简化为少数类别的一种手段。

(二)聚类的基本思想:•有大量的样本。

•假定研究的样本之间存在程度不同的相似性,可以分为几类;相同类别的样本相似度高,不同类别的样本相似度差。

•用一些数据指标来描述样本的若干属性,构成向量。

•用某种方法度量样本之间或者类别之间的相似性(或称距离),依据距离来进行分类。

•根据分类来研究各类样本的共性,找出规律。

(三)聚类的应用•商业领域-识别顾客购买模式,预测下一次购买行为,淘宝商品推荐等。

•金融领域-股票市场板块分析•安全和军事领域•o破解GPS伪随机干扰码和北斗系统民用版的展频编码密码o识别论坛马甲和僵尸粉o追溯网络谣言的源头•生物领域•o进化树构建o实验对象的分类o大规模组学数据的挖掘o临床诊断标准•机器学习•o人工智能(四)聚类的对象设有m个样本单位,每个样本测的n项指标(变量),原始资料矩阵:image.png指标的选择非常重要:必要性要求:和聚类分析的目的密切相关,并不是越多越好代表性要求:反映要分类变量的特征区分度要求:在不同研究对象类别上的值有明显的差异独立性要求:变量之间不能高度相关(儿童生长身高和体重非常相关)散布性要求:最好在值域范围内分布不太集中(五)数据标准化在各种标准量度值scale差异过大时,或数据不符合正态分布时,可能需要进行数据标准化。

(1)总和标准化。

分别求出各聚类指标所对应的数据的总和,以各指标的数据除以该指标的数据的总和。

image.png这种标准化方法所得到的的新数据满足:image.png(2)标准差标准化,即:image.png这种标准化方法得到的新数据,各指标的平均值为0,标准差为1,即有:image.pngimage.pngPS:比如说大家的身高差异(3)极大值标准差经过这种标准化所得到的新数据,各指标的极大值为1,其余各数值小于1.image.pngPS:课程难易,成绩高低。

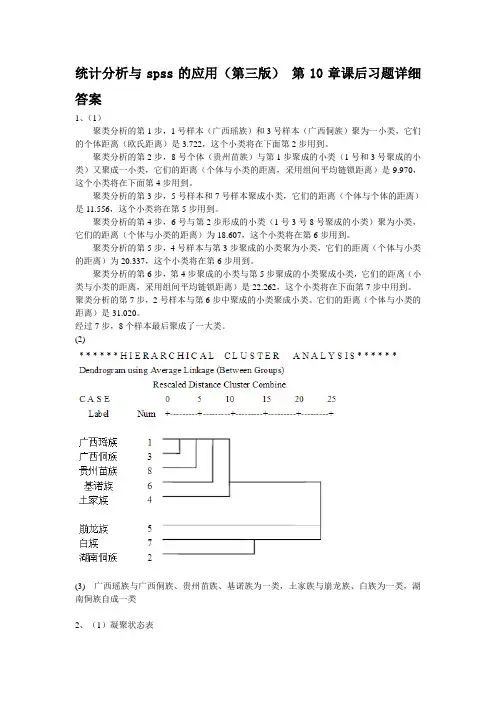

统计分析与spss的应用(第三版)第10章课后习题详细答案1、(1)聚类分析的第1步,1号样本(广西瑶族)和3号样本(广西侗族)聚为一小类,它们的个体距离(欧氏距离)是3.722,这个小类将在下面第2步用到。

聚类分析的第2步,8号个体(贵州苗族)与第1步聚成的小类(1号和3号聚成的小类)又聚成一小类,它们的距离(个体与小类的距离,采用组间平均链锁距离)是9.970,这个小类将在下面第4步用到。

聚类分析的第3步,5号样本和7号样本聚成小类,它们的距离(个体与个体的距离)是11.556,这个小类将在第5步用到。

聚类分析的第4步,6号与第2步形成的小类(1号3号8号聚成的小类)聚为小类,它们的距离(个体与小类的距离)为18.607,这个小类将在第6步用到。

聚类分析的第5步,4号样本与第3步聚成的小类聚为小类,它们的距离(个体与小类的距离)为20.337,这个小类将在第6步用到。

聚类分析的第6步,第4步聚成的小类与第5步聚成的小类聚成小类,它们的距离(小类与小类的距离,采用组间平均链锁距离)是22.262,这个小类将在下面第7步中用到。

聚类分析的第7步,2号样本与第6步中聚成的小类聚成小类。

它们的距离(个体与小类的距离)是31.020。

经过7步,8个样本最后聚成了一大类。

(2)(3) 广西瑶族与广西侗族、贵州苗族、基诺族为一类,土家族与崩龙族、白族为一类,湖南侗族自成一类2、(1)凝聚状态表随着类数目不断减少,类间距离在逐渐增大。

3类后,聚间距离迅速增大,形成极为平坦的碎石路。

所以考虑聚成3类。

(2)北京自成一类,江苏广东上海湖南湖北聚为一类,剩余的聚省为一类。

(3)(4)通过该表可以看出,,对应P值-小于0.005,所以各指数的均值在3类中的差异是显著的。

3、答:聚类分析是以各种距离来度量个体间的“亲疏”程度的。

从各种距离的定义来看,数量级将对距离产生较大的影响,并影响最终的聚类结果。

进行层次聚类分析时,为了避免上述问题,聚类分析之前应首先消除数量级对聚类的影响,对数据进行标准化就是最常用的方法。

聚类分析讲义范文一、聚类分析的基本原理聚类分析的基本原理是通过计算数据点之间的相似性度量,将相似性高的数据点归为一类,从而形成簇(cluster)。

相似性度量方法主要包括欧几里得距离、曼哈顿距离、切比雪夫距离、闵可夫斯基距离等。

欧几里得距离是最常用的相似性度量方法,其计算公式为:d(x, y) = sqrt((x1-y1)^2 + (x2-y2)^2 + ... + (xn-yn)^2)聚类分析的基本步骤包括:1.选择合适的相似性度量方法和聚类算法。

2.初始化聚类中心,将数据点分配到最近的聚类中心。

3.更新聚类中心,重新计算每个聚类中心的位置。

4.重复第2步和第3步,直到聚类中心的位置不再变化为止。

5.输出聚类结果。

二、聚类分析的常用算法1. K-means算法:K-means算法是最常用的聚类算法之一、其核心思想是在每次迭代中,计算每个数据点到所有聚类中心的距离,并将每个数据点分配到距离最近的聚类中心。

然后,重新计算每个聚类中心的位置。

重复执行这两个步骤,直到聚类中心的位置不再变化。

K-means算法的优势是简单快速,但对初始聚类中心的选择较为敏感。

2.层次聚类算法:层次聚类算法通过计算所有数据点之间的相似性,构建一个层次性的聚类结果。

这个结果可以表示为一个树状结构,其中每个节点代表一个聚类。

层次聚类算法的优势是不需要预先指定聚类个数,但计算复杂度较高。

3.密度聚类算法:密度聚类算法将聚类看作是在数据空间中找到高密度区域的过程。

该算法通过计算每个数据点在其邻域内的密度,将高密度区域作为簇的候选。

然后,通过在高密度区域之间构建连接来将簇进行合并。

密度聚类算法的优势在于可以发现任意形状和大小的簇,对于噪声和异常点具有较好的鲁棒性。

三、聚类分析的评估方法四、聚类分析的应用聚类分析在市场调研中可以帮助企业识别相似的顾客群体,从而定制合适的产品和推广策略。

在社交网络分析中,聚类分析可以用来发现具有相似兴趣和行为的用户群体,从而进行精准广告投放。

第 10 章 聚类分析“物以类聚,人以群分”。

对事物进行分类,是人们认识事物的出发点,也是人们认识世界的一种重要方法。

因此,分类学已成为人们认识世界的一门基础科学。

在生物、经济、社会、人口等领域的研究中,存在着大量量化分类研究。

例如:在生物学中,为了研究生物的演变,生物学家需要根据各种生物不同的特征对生物进行分类。

在经济研究中,为了研究不同地区城镇居民生活中的收入和消费情况,往往需要划分不同的类型去研究。

在地质学中,为了研究矿物勘探,需要根据各种矿石的化学和物理性质和所含化学成分把它们归于不同的矿石类。

在人口学研究中,需要构造人口生育分类模式、人口死亡分类状况,以此来研究人口的生育和死亡规律。

但历史上这些分类方法多半是人们主要依靠经验作定性分类,致使许多分类带有主观性和任意性,不能很好地揭示客观事物内在的本质差别与联系;特别是对于多因素、多指标的分类问题,定性分类的准确性不好把握。

为了克服定性分类存在的不足,人们把数学方法引入分类中,形成了数值分类学。

后来随着多元统计分析的发展,从数值分类学中逐渐分离出了聚类分析方法。

随着计算机技术的不断发展,利用数学方法研究分类不仅非常必要而且完全可能,因此近年来,聚类分析的理论和应用得到了迅速的发展。

聚类分析就是分析如何对样品(或变量)进行量化分类的问题。

根据聚类对象的不同,聚类分析分为Q 型聚类和R 型聚类。

Q 型聚类是对样品进行分类处理,R 型聚类是对变量进行分类处理。

根据聚类方法的不同,聚类分析又可以分为系统聚类法、K -均值聚类法、有序样品聚类法、模糊聚类法等。

本书将仅针对系统聚类法和K -均值聚类法进行介绍。

10.1 系统聚类法的理论与方法10.1.1 系统聚类的基本思想系统聚类的基本思想是:距离相近的样品(或变量)先聚成类,距离相远的后聚成类,过程一直进行下去,每个样品(或变量)总能聚到合适的类中。

系统聚类过程是:假设总共有个样品(或变量),第一步将每个样品(或变量)独自聚成一类,共有类;第二步根据所确定的样品(或变量)“距离”公式,把距离较近的两个样品(或变量)聚合为一类,其它的样品(或变量)仍各自聚为一类,这样,形成1n n n −类;第三步1− 个类中“距离”最近的两个类进一步聚成一类,这样,形2n 将n 成−类;……。

以上步骤一直进行下去,最后将所有的样品(或变量)全聚成一类。

为了直观地反映以上的系统聚类过程,可以把整个分类系统画成一张谱系图,所以,系统聚类有时也称为谱系分析。

10.1.2 个体之间距离的度量方法进行聚类分析首先要建立在各个样品(或变量)之间“距离”的精确度量的基础之上。

根据变量类型的不同,“距离”的度量方式也不相同,下面分别叙述:1. 针对连续变量的距离测度欧氏距离(Euclidean distance ): 两个体p 个变量值之差平方和的平方根(,)EUCLID x y =欧氏距离平方(Squared Euclidean distance ):两个体p 个变量值之差的平方和21(,)()p i i i SEUCLID x y x y ==−∑切比雪夫距离(Chebychev ):两个体p 个变量值绝对差的最大值1(,)max i i i pChebychev x y x y ≤≤=− 布洛克距离(Block ):两个体p 个变量值绝对差的总和1(,)p i i i Block x y x y ==−∑明可夫斯基距离(Minkowski ):两个体p 个变量值绝对差k 次幂总和的k 次方根(,)Minkowski x y =其中,k 可以任意指定。

容易看出,欧氏距离、切比雪夫距离和布洛克距离分别是明可夫斯基距离当、和2k =k →∞1k =时候的特例。

自定义距离(Customized ):两个体p 个变量值绝对差r 次幂总和的k 次方根(,)Customized x y =其中,和都可以任意指定。

容易看出,上面给出的所有距离都可以通过赋予和特定的值而得到。

k r k r 夹角余弦(Cosine ):2()(,)p i ix y Cosine x y =∑ 皮尔逊相关系数(Pearson correlation ):()()(,)pi i i ix x y y r x y −−=∑夹角余弦和皮尔逊相关系数其实是描述个体之间相似性的指标,所以,它们的值越大,表明个体之间距离越小。

2. 针对计数变量的距离测度所谓计数变量,是指个体在某个分类变量上的频数。

针对计数变量的距离测度方法主要有卡方距离和Phi 方距离。

卡方距离(Chi-square measure ):利用列联表分析的方法得到一个卡方统计量来衡量两个体之间的差异性(关于列联表分析的详细内容,参见8.1.3节)2(,)x y χ=其中,的第个变量的取值(在第类上的频数),是个体i i ()i E x x i x 是个体x 在第类上的期望频数;i i y 是个体y 的第个变量的取值,是个体 表 10-1给出了某市各企业职工文化程度的数据资料,可以计算甲乙两企业之间的卡方距离如下i ()i E y y 在第i 类上的期望频数。

:根据列联表分析的原理可以知道,卡方统计量越大表明个体的选择对变量的取值有显著影响职工文化程度,这也意味着两个体之间的差异越大。

表 10-1 不同企业的Phi 方距离(Phi-square measure )2(,)Phi x y =其中,为样本容量,其余符号的意义与卡方距离一样。

变量,则个体之间的距离测度将基于一个如表 10-2所示的n 3. 针对二值变量的距离测度如果个体的k 个变量都是二值2+2×的列联表。

该表是根据原始数据转换而来的两个体取值的交叉列联表。

表中,a b c d ++等于变量的总个数,a 为两个体取值都为1的变量个数,b 为个体x 取值为01的变量个数,c 为个体而个体y 取值为x 取值为1而个体y 取值为0的变量个数,d 为两个体取值都是0的变量个数。

显然,a d +的比重描述了两个体之间的相似程度,而b c +的0-2 2×2的列联表 比重反映了两个体之间的差异程度。

表 1个体x 1 0 个体y 1a b 0 c d几乎所有的针对二值变量的距离测度都是基于以上的2×2列联表,这里仅给出几例: 二值欧氏距离(Euclidean distance ):(,)EUCLID x y =二值欧氏距离平方(Squared Euclidean distance ):(,)SEUCLID x y b c =+不对称指数(Size difference ):2(,)()b c SD x y a b c d −=+++ 不相似性测度(Pattern difference ):2(,)()bc PD x y a b c d =+++ 方差(Variance ):(,)4()b c Var x y a b c d +=+++ 10.1.3 类之间距离的度量方法系统聚类法不仅需要度量个体与个体之间的距离,还要度量类与类之间的距离。

类间距离被度量出来之后,距离最小的两个小类将首先被合并成为一类。

由类间距离定义的不同产生了不同的系统聚类法。

SPSS 中提供了如下几种类间距离测度方法:组间平均连接距离(Between-group linkage ):以两类个体两两之间距离的平均数作为类间距离;组内平均连接距离(Within-group linkage ):将两类个体合并为一类后,以合并后类中所有个体之间的平均距离作为类间距离;最近邻距离(Nearest neighbor ):以两类中距离最近的两个个体之间的距离作为类间距离;最远邻距离(Furthest neighbor ):以两类中距离最远的两个个体之间的距离作为类间距离;重心距离(Centroid cluster ):以两类变量均值之间的距离作为类间距离;中位数距离(Median cluster ):以两类变量中位数之间的距离作为类间距离; 离差平方和法(Ward method): 该方法是Ward 提出来的,所以又称为Ward 法。

具体做法是先将n 个样品各自成一类,然后每次减少一类,随着类与类的不断聚合,类内的离差平方和必然不断增大,选择使离差平方和增加最小的两类合并,直到所有的样品归为一类为止。

10.2K-均值聚类法的理论与方法系统聚类法需要计算出不同样品或变量的距离,还要在聚类的每一步都要计算“类间距离”,相应的计算量自然比较大;特别是当样本的容量很大时,需要占据非常大的计算机内存空间,这给应用带来一定的困难。

而K—均值法是一种快速聚类法,采用该方法得到的结果比较简单易懂,对计算机的性能要求不高,因此应用也比较广泛。

K—均值法是麦奎因(MacQueen,1967)提出的,这种算法的基本思想是将每一个样品分配给最近中心(均值)的类中,具体的算法至少包括以下三个步骤:1.将所有的样品分成K个初始类,并计算各初始类的中心坐标;2.通过欧氏距离将所有的样品重新分类,分类的原则是将样品划入离中心最近的类中,然后重新计算中心坐标;3.重复步骤2,直到所有的样品都不能再分配时为止。

K—均值法和系统聚类法一样,都是以距离的远近亲疏为标准进行聚类的,但是两者的不同之处也是明显的:系统聚类对不同的类数产生一系列的聚类结果,而K—均值法只能产生指定类数的聚类结果。

具体类数的确定,离不开实践经验的积累;有时也可以借助系统聚类法以一部分样品为对象进行聚类,其结果作为K—均值法确定类数的参考。

10.3K-均值聚类法的实例根据我国各地区2003年三次产业的产值,利用K均值法对我国31个省、自治区和直辖市进行聚类分析。

10.3.1SPSS操作步骤1. 选择菜单项Analyze→Classify→K-Means Cluster,打开K-Means Cluster Analysis对话框,如图 10-1。

将原始变量x1—x3移入Variables列表框框中,将标志变量Region移入Label Case by列表框框中。

在Method选项栏中选择Iterate classify单选项,使用K-means算法不断计算新的类中心,并替换旧的类中心;若选择Classify only,则根据初始类中心进行聚类,在聚类过程中不改变类中心。

在Number of Cluster后面的输入框中输入想要把样品聚成的类数,这里我们输入3,即将31个地区分为3类。

至于Centers按钮,则用于设置迭代的初始类中心。

如果不手工设置,则系统会自动设置初始类中心,这里我们不作设置。

图 10-1 K-Means Cluster Analysis对话框2. 点击Iterate按钮,打开Iterate子对话框,如图 10-2,对迭代参数进行设置。