3[1].2 经典线性模型的贝叶斯估计

- 格式:pdf

- 大小:110.59 KB

- 文档页数:22

信号的参数估计一般指参数在观测时间内不随时间变化,故是静态估计。

若被估计参量是随机过程或非随机的未知过称,则称为波形估计或状态估计,波形估计或状态估计是动态估计。

3。

2贝叶斯估计贝叶斯估计是基于后验概率分布(posterior distribution)的一类估计方法,其中后验概率分布中采用了先验信息(prior information )。

所谓先验信息,是指已知待估计参数的概率密度函数0()p θ,不管θ是随机变变量或是未知的固定常数。

而后验概率分布具有下面的形式,00()(|)(),1(|)()p c p X p c p X p d θθθθθθ*==⎰.注意两点:1,0()p θ不必满足标准化条件,即0()1p d θθ=⎰,但是0()p θ必须是非负的,并且0102()()p p θθ代表似真比(ratio of plausibility ),若0102()()1p p θθ>,则说明在1θ和2θ两个值之间我们更倾向于1θ为真值;2,()p θ*实际上就是(|)p X θ,是通过试验得到数据X 以后θ的概率密度函数,仅当()1p d θθ=⎰时有明确的含义.下面讨论中,()p θ代表0()p θ,(|)p X θ代表()p θ*。

类似于信号检测中的问题,贝叶斯估计在参数估计中对于不同的估计结果赋予了不同的代价值,然后求解平均代价最小的情况。

估计误差为θθ-,我们只关心估计误差的代价,于是代价函数()()c c θθθ-=,是估计误差的单变量函数。

典型的代价函数有三种:⑴ 平方型()2()c θθθ=-,它强调了大误差的影响 ⑵ 绝对值()c θθθ=-,给出了代价随估计误差成比例增长 ⑶ 均匀型()10c θεθεθε>⎧=⎨⎩-<<这种代价函数给出了估计误差绝对值大于某个值时,代价等于常数,而估计误差绝对值小于某个值时,代价等于零.在贝叶斯估计中,要求估计误差引起的代价的平均值最小。

贝叶斯估计其实这是我之前最想第⼀篇来写的随笔了,今天就先把这⼀部分写⼀写吧。

1.问题 ⼀个医疗诊断问题有两个可选的假设:病⼈有癌症、病⼈⽆癌症可⽤数据来⾃化验结果:阴性和阳性。

有先验知识:在所有⼈⼝中,患病率是0.008,对确实有病的患者的化验准确率为98%,对确实⽆病的患者的化验准确率为97% 。

问题:假定有⼀个新病⼈,化验结果为阳性,是否应将病⼈断定为有癌症? 我们先把问题简单描述⼀下,⽤事件Y表⽰检测为阳性,⽤事件N表⽰检测为阴性,⽤A表⽰患有癌症,⽤B表⽰健康。

那么有:p(A)=0.008p(B)=0.992p(Y|A)=0.98p(N|B)=0.97p(N|A)=0.02p(Y|B)=0.03 然后让我们求p(A|Y) 让我们求已知检测为阳性的情况下,病⼈患有癌症的条件概率,根据条件概率的定义有p(A|Y)=p(A,Y) p(Y) ⽽:p(A,Y)=p(Y|A)p(A) 那么p(Y)怎么求呢? 我们发现A和B是互斥事件,且p(A)+p(B)=1,根据联合概率和边缘概率的关系,有:p(Y,A)+p(Y,B)=p(Y) 再次利⽤联合概率和条件概率:p(Y,A)=p(Y|A)p(A)p(Y,B)=p(Y|B)p(B) 最终得到:p(A|Y)=P(Y|A)p(A)p(Y|A)p(A)+p(Y|B)p(B) 带⼊得p(A|Y)=0.208,这好像和直觉相差甚远,明明对有病患者准确率⾼达98%,为什么检测结果为阳性但是可信度只有21%左右? 我们来看看这种检测⽅法诊断结果为阳性的概率p(Y)=0.0376,发现了什么,该癌症发病率只有0.008,有0.0376的概率的概率是结果为阳性。

假设随机10000个⼈来检查,其中癌症患者的期望为80,但是检测结果为阳性的期望为376。

这表明检测结果为阳性时,假阳性概率很⼤,在0.008的发病率看来,对正常病⼈3%的误差反⽽⼤得多,这也是阳性结果可信度低的最主要原因。

贝叶斯先验概率贝叶斯估计你有没有想过,我们每天做的决定背后,其实有很多不确定性?我们做的选择是根据过去的经验,也我们选择的结果并不完全能预测。

举个例子,假设你早上出门前看了天气预报,说今天有50%的可能下雨。

那么问题来了,你是带伞呢,还是不带呢?如果你经历了好几次天气预报错得离谱,是不是就会开始怀疑这些概率的准确性了?这时候,你可能会觉得,自己的经验比这些预测更靠谱。

嘿,这其实就跟贝叶斯估计有点关系!贝叶斯估计的核心思想就是:把我们的“信念”或者说“先入为主”的看法,结合新的信息,做出更合理的判断。

拿天气预报来说,假如你这几年过得比较顺风顺水,基本上从来没遇到过下雨的预报被错过过,天公作美,你心里可能会觉得今天下雨的可能性更小些。

这时候,你的“先验知识”就开始发挥作用了。

你并不是完全相信50%的下雨几率,而是结合自己以往的经验,觉得这50%的概率其实没那么准确,可能实际下雨的几率还得往低的方向调整。

对,先验概率,这名字听起来有点高深,但其实说白了,就是你在面对不确定的事物时,最初的判断和看法。

举个例子,假设你今天第一次见到一个人,想知道他是不是喜欢看足球。

你完全不了解他,只知道他长得高大,看起来像个运动员。

你的“先验”就是——他可能喜欢足球。

这个先验的看法,源自你对运动员的刻板印象。

可是,如果你后来得知,这个人其实从不碰球,反而热衷于下围棋,那你的想法肯定得做调整。

你会慢慢抛开原本的看法,开始根据实际信息重新评估他的兴趣。

贝叶斯估计的巧妙之处就在于,它鼓励你做这种“更新”。

每当有新的信息进来时,你就该重新调整自己原本的“信念”。

在上面的例子中,一开始你完全凭直觉判断这个人爱足球,结果一查,他竟然喜欢围棋,那你就得调整看法了,把新的信息加进来,改成一个更加准确的估计。

更有意思的是,贝叶斯估计的魅力不仅在于它能够帮助我们调整决策,还在于它不要求我们一开始就知道真相。

嘿,谁能一开始就知道自己做的决定百分之百正确呢?生活就是这样,充满了不确定。

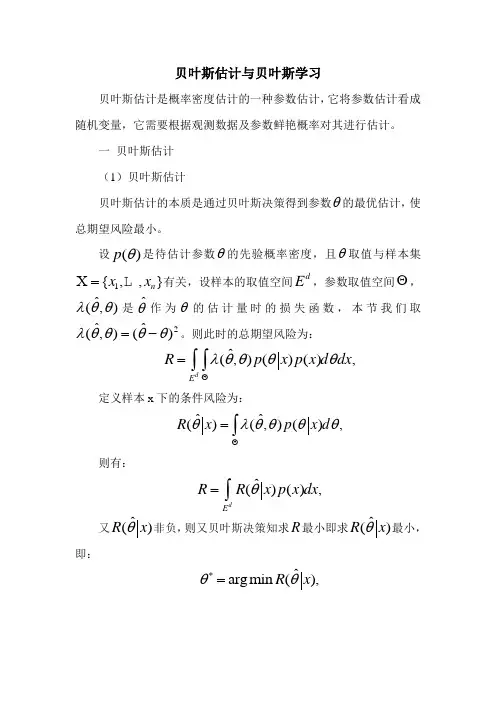

贝叶斯估计与贝叶斯学习贝叶斯估计是概率密度估计的一种参数估计,它将参数估计看成随机变量,它需要根据观测数据及参数鲜艳概率对其进行估计。

一 贝叶斯估计(1)贝叶斯估计贝叶斯估计的本质是通过贝叶斯决策得到参数θ的最优估计,使总期望风险最小。

设()p θ是待估计参数θ的先验概率密度,且θ取值与样本集1{,,}n x x X =L 有关,设样本的取值空间d E ,参数取值空间Θ,ˆ(,)λθθ是ˆθ作为θ的估计量时的损失函数,本节我们取2ˆˆ(,)()λθθθθ=-。

则此时的总期望风险为: ˆ(,)()(),d E R p x p x d dx λθθθθΘ=⎰⎰定义样本x 下的条件风险为:ˆˆ()(,)(),R x p x d θλθθθθΘ=⎰ 则有:ˆ()(),d E R R x p x dx θ=⎰ 又ˆ()R x θ非负,则又贝叶斯决策知求R 最小即求ˆ()R x θ最小,即: ˆargmin (),R x θθ*=可求得最优估计:().p x d θθθθ*Θ=⎰(2)贝叶斯估计步骤总结1. 获得θ的先验分布()p θ;2. 已知x 的密度分布()p x θ得样本集的联合分布:1()();Nn n p p x θθ=X =∏3. 由贝叶斯公式得θ的后验分布:()()();()()p X p p X p X p d θθθθθθΘ=⎰4. 得到θ的最优估计:().p x d θθθθ*Θ=⎰(3)样本概率密度函数()p x X 估计我们是在假设样本概率密度已知下对参数进行估计的,由贝叶斯估计步骤3可以直接得到样本概率密度函数估计:()()().p x X p x p X d θθθΘ=⎰对上式可以理解为:()p x X 在所有可能参数下取值下样本概率密度的加权平均,权值为θ的后验概率。

二 贝叶斯学习贝叶斯学习本质是参数值随着样本增多趋近于真实值的过程。

对于贝叶斯学习由下面过程得到:记样本集为NX ,其中N 代表样本集内样本的个数。

贝叶斯估计最小最大原理1.引言1.1 概述贝叶斯估计和最小最大原理是概率论和统计学中两个重要的概念和方法。

它们在不同的领域和问题中具有广泛的应用,并且相互关联和影响。

贝叶斯估计是统计推断的一种方法,是基于贝叶斯定理的思想发展而来的。

其核心思想是在已知观测数据的情况下,通过计算参数的后验概率分布来进行参数估计。

贝叶斯估计可以将先验知识和观测数据进行有效的结合,提供了一种更加准确和全面的参数估计方法。

最小最大原理是决策论中的一种方法,用于确定最优的决策策略。

最小最大原理的核心思想是在面临不确定性和风险的情况下,通过最小化最大损失来选择最佳策略。

该原理要求在任何可能的情况下,所选择的策略都能使最坏情况下的损失最小化。

本文将围绕贝叶斯估计和最小最大原理展开详细阐述。

首先,我们将介绍贝叶斯估计的基本原理,包括贝叶斯定理和后验概率的计算方法。

然后,我们将介绍最小最大原理的概念和应用,包括最小最大损失和最优策略的确定方法。

最后,我们将着重探讨贝叶斯估计与最小最大原理之间的关系,探讨它们在统计推断和决策制定中的相互作用和互补。

通过对贝叶斯估计和最小最大原理的深入理解和研究,我们可以更好地应对不确定性和风险,并进行更准确和有效的参数估计和决策制定。

本文将为读者提供有关贝叶斯估计和最小最大原理的全面介绍和理解,并为进一步研究和应用这两种方法奠定基础。

在未来的研究中,我们还可以思考和展望贝叶斯估计和最小最大原理的更多潜在应用和改进方向。

1.2文章结构文章结构的目的是为了清晰地呈现文章的逻辑结构和内容框架,帮助读者更好地理解文章的主旨和论证过程。

通过准确的文章结构,读者可以迅速找到所需信息,并更好地理解文章的脉络。

本文将分为引言、正文和结论三个部分。

在引言部分,将对贝叶斯估计最小最大原理的背景和意义进行概述,并介绍文章的结构和目的。

在正文部分,将深入讨论贝叶斯估计的基本原理,以及最小最大原理的概念和应用。

在此基础上,将探讨贝叶斯估计与最小最大原理之间的关系,并展望贝叶斯估计最小最大原理未来的发展方向。

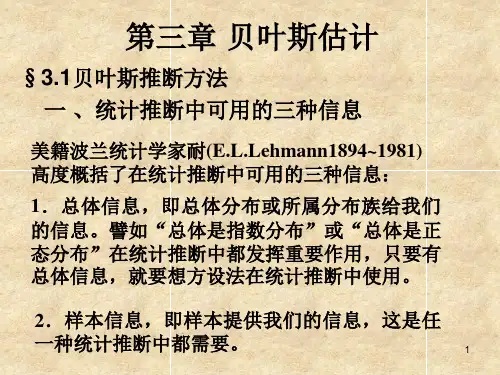

§3.2 经典线性计量经济学模型的贝叶斯估计Bayesian EstimationBayesian Econometrics(教材§3.3)一、贝叶斯定理二、正态线性单方程计量经济学模型的贝叶斯估计0 引子•在《Econometric Analysis》(第3版)中:•Chapter 6 The Classical Multiple Linear Regression Model—Specification and Estimation • 6.9 Bayesian Estimation•在《Econometric Analysis》(第5版)中:•Chapter 16 Estimation Frameworks in Econometrics•16.2 Parametric Estimation•16.2.2 Bayesian Estimation•作为一类估计方法,其原理是重要的。

•在实际应用中,由于先验信息难以获得,该估计方法很难应用。

•贝叶斯统计是由T.R.Bayes于19世纪创立的数理统计的一个重要分支,20世纪50年代,以H.Robbins 为代表提出了在计量经济学模型估计中将经验贝叶斯方法与经典方法相结合,引起了广泛的重视。

•贝叶斯估计对经典计量经济学模型估计方法的扩展在于,它不仅利用样本信息,同时利用非样本信息。

一、贝叶斯定理•后验信息正比于样本信息与先验信息的乘积。

•可以通过样本信息对先验信息的修正来得到更准确的后验信息。

⒉单方程计量经济学模型贝叶斯估计的过程•确定模型的形式,指出待估参数•给出待估参数的先验分布•利用样本信息,修正先验分布•利用待估参数的后验密度函数,进一步推断出待估参数的点估计值,或进行区间估计与假设检验•预测二、正态线性单方程计量经济学模型的贝叶斯估计⒋区间估计•根据B的后验密度函数进行区间估计。

•需要引入最高后验密度区间的概念:区间内每点的后验密度函数值大于区间外任何一点的后验密度函数值,这样的区间称为最高后验密度区间(HPD区间)。

§3.2 经典线性计量经济学模型的

贝叶斯估计

Bayesian Estimation

Bayesian Econometrics

(教材§3.3)

一、贝叶斯定理

二、正态线性单方程计量经济学模型的贝叶斯

估计

0 引子

•在《Econometric Analysis》(第3版)中:•Chapter 6 The Classical Multiple Linear Regression Model—Specification and Estimation • 6.9 Bayesian Estimation

•在《Econometric Analysis》(第5版)中:•Chapter 16 Estimation Frameworks in Econometrics

•16.2 Parametric Estimation

•16.2.2 Bayesian Estimation

•作为一类估计方法,其原理是重要的。

•在实际应用中,由于先验信息难以获得,该估计方法很难应用。

•贝叶斯统计是由T.R.Bayes于19世纪创立的数理统计的一个重要分支,20世纪50年代,以H.Robbins 为代表提出了在计量经济学模型估计中将经验贝叶斯方法与经典方法相结合,引起了广泛的重视。

•贝叶斯估计对经典计量经济学模型估计方法的扩展在于,它不仅利用样本信息,同时利用非样本信息。

一、贝叶斯定理

•后验信息正比于样本信息与先验信息的乘积。

•可以通过样本信息对先验信息的修正来得到更准确的后验信息。

⒉单方程计量经济学模型贝叶斯估计的过程

•确定模型的形式,指出待估参数

•给出待估参数的先验分布

•利用样本信息,修正先验分布

•利用待估参数的后验密度函数,进一步推断出待估参数的点估计值,或进行区间估计与假设检验•预测

二、正态线性单方程计量经济学模

型的贝叶斯估计

⒋区间估计

•根据B的后验密度函数进行区间估计。

•需要引入最高后验密度区间的概念:区间内每点的后验密度函数值大于区间外任何一点的后验密度函数值,这样的区间称为最高后验密度区间(HPD区间)。

•参数的最高后验密度区间在形式上与经典样本信息理论中的置信区间是一致的,但解释并不相同。

⒌假设检验

•可以用最高后验密度区间进行假设检验。

•常用的方法是利用后验优势比检验。

⒍试例

•选取1978-1997年的数据为样本,采用经典模型的估计方法,得到的结果。

T t GDP DE t t t ,,2,110"=++=μββ453ˆ008886.0ˆ18.126ˆ2

10===μσββ。