经典线性回归模型

- 格式:pdf

- 大小:461.63 KB

- 文档页数:17

第二章经典线性回归模型:估计、统计性质与统计检验•经典线性回归模型:假设与OLS估计•OLS估计的小样本性质与统计检验•OLS估计的大样本性质与统计检验§1.1 经典线性回归模型:假设与OLS估计一、经典线性回归模型二、经典线性回归模型的OLS估计E(Y|X)回归分析的基本逻辑:寻找样本回归线,并用样本回归线近似代表总体回归线问题:能否代表?需要通过检验来回答!(1) 对残差平方和SSR(b )= Σe t 2=e ’e =(Y -Xb )’(Y -Xb ) 1阶偏导: ∂SSR/∂b = -2X ’(Y-Xb )2阶偏导: ∂2SSR/∂b ∂b ’= 2X ’X由于X ’X 为正定矩阵(Why?), 从而b =(X ’X )-1(X ’Y )是最小值 由1阶极值条件可以得到所谓正规方程(normal equations ): X ’(Y-Y-XbXb )=X ’e =0 ⇔ Σt X tj e t =0 (j=1,2,…,k )当模型含有值恒为1的常数项时, Σe t =0正规方程是OLS 所特有的,而不论是否有E(εt |X )=02、OLS 估计的数值性质(4)一些有用的等式a. X’e=0b. b −β=(X’X)-1X’ε因为b=(X’X)-1X’Y=(X’X)-1X’(Xβ+ε)=β+(X’X)-1X’ε c. 定义n×n方阵:P P X=X(X’X)-1X’(投影矩阵),M X=I n−P X(消灭矩阵)则P=P X’, M M X=M X’XP X2=P X, M M X2=M XX=X, M X X=O n×(k+1)且PXd. e=M X Y=M XεSSR(b)=e’e=Y’M X Y=ε’M Xε二元回归的示例图赤池信息准则(Akaike information criterion, AIC, 1973) AIC=ln[e’e/n]+2(k+1)/n=goodness of fit + model complexityAIC= -2ln L/n +2(k+1)/n贝叶斯信息准则(Baysian information criterion, BIC)施瓦茨准则(Schwarz criterion,SC, 1978)BIC=ln[e’e/n]+(k+1)ln(n)/nBIC/SC= -2ln L/n+(k+1)ln(n)/n贝叶斯信息准则对多引入多余的解释变量给出了更重的惩罚。

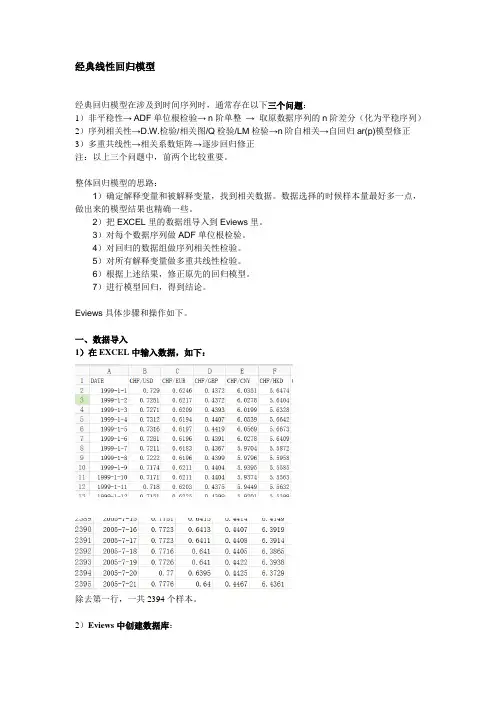

经典线性回归模型经典回归模型在涉及到时间序列时,通常存在以下三个问题:1)非平稳性→ ADF单位根检验→ n阶单整→取原数据序列的n阶差分(化为平稳序列)2)序列相关性→D.W.检验/相关图/Q检验/LM检验→n阶自相关→自回归ar(p)模型修正3)多重共线性→相关系数矩阵→逐步回归修正注:以上三个问题中,前两个比较重要。

整体回归模型的思路:1)确定解释变量和被解释变量,找到相关数据。

数据选择的时候样本量最好多一点,做出来的模型结果也精确一些。

2)把EXCEL里的数据组导入到Eviews里。

3)对每个数据序列做ADF单位根检验。

4)对回归的数据组做序列相关性检验。

5)对所有解释变量做多重共线性检验。

6)根据上述结果,修正原先的回归模型。

7)进行模型回归,得到结论。

Eviews具体步骤和操作如下。

一、数据导入1)在EXCEL中输入数据,如下:除去第一行,一共2394个样本。

2)Eviews中创建数据库:File\new\workfile, 接下来就是这个界面(2394就是根据EXCEL里的样本数据来),OK3)建立子数据序列程序:Data x1再enter键就出来一个序列,空的,把EXCEL里对应的序列复制过来,一个子集就建立好了。

X1是回归方程中的一个解释变量,也可以取原来的名字,比如lnFDI,把方程中所有的解释变量、被解释变量都建立起子序列。

二、ADF单位根检验1)趋势。

打开一个子数据序列,先判断趋势:view\graph,出现一个界面,OK。

得到类似的图,下图就是有趋势的时间序列。

X1.4.2.0-.2-.4-.6-.8100020003000400050002)ADF检验。

直接在图形的界面上进行操作,view\unit root test,出现如下界面。

在第二个方框内根据时序的趋势选择,Intercept指截距,Trend为趋势,有趋势的时序选择第二个,OK,得到结果。

上述结果中,ADF值为-3.657113,t统计值小于5%,即拒绝原假设,故不存在单位根。

线性回归模型的经典假定及检验、修正一、线性回归模型的基本假定1、一元线性回归模型一元线性回归模型是最简单的计量经济学模型,在模型中只有一个解释变量,其一般形式是Y =β0+β1X 1+μ其中,Y 为被解释变量,X 为解释变量,β0与β1为待估参数,μ为随机干扰项。

回归分析的主要目的是要通过样本回归函数(模型)尽可能准确地估计总体回归函数(模型)。

为保证函数估计量具有良好的性质,通常对模型提出若干基本假设。

假设1:回归模型是正确设定的。

模型的正确设定主要包括两个方面的内容:(1)模型选择了正确的变量,即未遗漏重要变量,也不含无关变量;(2)模型选择了正确的函数形式,即当被解释变量与解释变量间呈现某种函数形式时,我们所设定的总体回归方程恰为该函数形式。

假设2:解释变量X 是确定性变量,而不是随机变量,在重复抽样中取固定值。

这里假定解释变量为非随机的,可以简化对参数估计性质的讨论。

假设3:解释变量X 在所抽取的样本中具有变异性,而且随着样本容量的无限增加,解释变量X 的样本方差趋于一个非零的有限常数,即∑(X i −X ̅)2n i=1n→Q,n →∞ 在以因果关系为基础的回归分析中,往往就是通过解释变量X 的变化来解释被解释变量Y 的变化的,因此,解释变量X 要有足够的变异性。

对其样本方差的极限为非零有限常数的假设,旨在排除时间序列数据出现持续上升或下降的变量作为解释变量,因为这类数据不仅使大样本统计推断变得无效,而且往往产生伪回归问题。

假设4:随机误差项μ具有给定X 条件下的零均值、同方差以及无序列相关性,即E(μi|X i)=0Var(μi|X i)=σ2Cov(μi,μj|X i,X j)=0, i≠j随机误差项μ的条件零均值假设意味着μ的期望不依赖于X的变化而变化,且总为常数零。

该假设表明μ与X不存在任何形式的相关性,因此该假设成立时也往往称X为外生性解释变量随机误差项μ的条件同方差假设意味着μ的方差不依赖于X的变化而变化,且总为常数σ2。

计量经济学试题1一 名词解释(每题5分,共10分) 1. 经典线性回归模型 2. 加权最小二乘法(WLS ) 二 填空(每空格1分,共10分)1.经典线性回归模型Y i = B 0 + B 1X i + µi 的最小二乘估计量b 1满足E ( b 1 ) = B 1,这表示估计量b 1具备 性。

2.广义差分法适用于估计存在 问题的经济计量模型。

3.在区间预测中,在其它条件不变的情况下,预测的置信概率越高,预测的精度越 。

4.普通最小二乘法估计回归参数的基本准则是使 达到最小。

5.以X 为解释变量,Y 为被解释变量,将X 、Y 的观测值分别取对数,如果这些对数值描成的散点图近似形成为一条直线,则适宜配合 模型。

6.当杜宾-瓦尔森统计量 d = 4时,ρˆ= ,说明 。

7.对于模型i i i X Y μββ++=10,为了考虑“地区”因素(北方、南方两种状态)引入2个虚拟变量,则会产生 现象。

8. 半对数模型LnY i = B 0 + B 1X i + µI 又称为 模型。

9.经典线性回归模型Y i = B 0 + B 1X i + µi 的最小二乘估计量b 0、b 1的关系可用数学式子表示为 。

三 单项选择题(每个1分,共20分)1.截面数据是指--------------------------------------------------------------( )A .同一时点上不同统计单位相同统计指标组成的数据。

B .同一时点上相同统计单位相同统计指标组成的数据。

C .同一时点上相同统计单位不同统计指标组成的数据。

D .同一时点上不同统计单位不同统计指标组成的数据。

2.参数估计量βˆ具备有效性是指------------------------------------------( ) A .0)ˆ(=βar V B.)ˆ(βarV 为最小 C .0)ˆ(=-ββD.)ˆ(ββ-为最小 3.如果两个经济变量间的关系近似地表现为:当X 发生一个绝对量(X ∆)变动时,Y 以一个固定的相对量(Y Y /∆)变动,则适宜配合的回归模型是------------------------------------------------------------------------------------------- ( )A .i i i X Y μβα++= B.i i i X Y μβα++=ln C .i ii X Y μβα++=1D.i i i X Y μβα++=ln ln 4.在一元线性回归模型中,不可能用到的假设检验是----------( ) A .置信区间检验 B.t 检验 C.F 检验 D.游程检验5.如果戈里瑟检验表明 ,普通最小二乘估计的残差项有显著的如下性质:24.025.1i i X e +=,则用加权最小二乘法估计模型时,权数应选择-------( )A .i X 1 B. 21i X C.24.025.11i X + D.24.025.11i X +6.对于i i i i X X Y μβββ+++=22110,利用30组样本观察值估计后得56.827/)ˆ(2/)ˆ(2=-∑-∑=iiiY Y Y Y F ,而理论分布值F 0.05(2,27)=3.35,,则可以判断( )A . 01=β成立 B. 02=β成立 C. 021==ββ成立 D. 021==ββ不成立7.为描述单位固定成本(Y )依产量(X )变化的相关关系,适宜配合的回归模型是:A .i i i X Y μβα++= B.i i i X Y μβα++=ln C .i ii X Y μβα++=1D.i i i X Y μβα++=ln ln 8.根据一个n=30的样本估计ii i e X Y ++=10ˆˆββ后计算得d=1.4,已知在95%的置信度下,35.1=L d ,49.1=U d ,则认为原模型------------------------( )A .存在正的一阶线性自相关 B.存在负的一阶线性自相关 C .不存在一阶线性自相关 D.无法判断是否存在一阶线性自相关9.对于ii i e X Y ++=10ˆˆββ,判定系数为0.8是指--------------------( ) A .说明X 与Y 之间为正相关 B. 说明X 与Y 之间为负相关 C .Y 变异的80%能由回归直线作出解释 D .有80%的样本点落在回归直线上10. 线性模型i i i i X X Y μβββ+++=22110不满足下列哪一假定,称为异方差现象-------------------------------------------------------------------------------( )A .0)(=j i ov C μμ B.2)(σμ=i ar V (常数) C .0),(=i i ov X C μ D.0),(21=i i ov X X C11.设消费函数i i i X D Y μβαα+++=10,其中虚拟变量⎩⎨⎧=南方北方01D ,如果统计检验表明1α统计显著,则北方的消费函数与南方的消费函数是--( )A .相互平行的 B.相互垂直的 C.相互交叉的 D.相互重叠的12. 在建立虚拟变量模型时,如果一个质的变量有m 种特征或状态,则一般引入几个虚拟变量:----------------------------------------------------------------( )A .m B.m+1 C.m -1 D.前三项均可 13. 在模型i i iX Y μββ++=ln ln ln 10中,1β为---------------------( )A .X 关于Y 的弹性 B.X 变动一个绝对量时Y 变动的相对量 C .Y 关于X 的弹性 D.Y 变动一个绝对量时X 变动的相对量14.对于i i i e X Y ++=10ˆˆββ,以S 表示估计标准误差,iY ˆ表示回归值,则-------------------------------------------------------------------------------------------( )A .S=0时,0)ˆ(=-∑ti Y Y B.S=0时,∑==-ni i i Y Y 120)ˆ( C .S=0时,)ˆ(ii Y Y -∑为最小 D.S=0时,∑=-ni i i Y Y 12)ˆ(为最小 15.经济计量分析工作的基本工作步骤是-----------------------------( )A .设定理论模型→收集样本资料→估计模型参数→检验模型B .设定模型→估计参数→检验模型→应用模型C .理论分析→数据收集→计算模拟→修正模型D .确定模型导向→确定变量及方程式→应用模型16.产量(X ,台)与单位产品成本(Y ,元/台)之间的回归方程为:X Y5.1356ˆ-=,这说明-----------------------------------------------------------( )A .产量每增加一台,单位产品成本平均减少1.5个百分点B .产量每增加一台,单位产品成本减少1.5元C .产量每增加一台,单位产品成本减少1.5个百分点D .产量每增加一台,单位产品成本平均减少1.5元17.下列各回归方程中,哪一个必定是错误的------------------------( )A .8.02.030ˆ=+=XY i i r X Y B. 91.05.175ˆ=+-=XY i i r X Y C .78.01.25ˆ=-=XY ii r X Y D. 96.05.312ˆ-=--=XY ii r X Y18.用一组有28个观测值的样本估计模型i i i X Y μββ++=10后,在0.05的显著性水平下对1β的显著性作t 检验,则1β显著地不等于0的条件是统计量t 大于-------------------------------------------------------------------------------------( )A .t 0.025(28) B. t 0.05(28) C. t 0.025(26) D. t 0.05(26)19.下列哪种形式的序列相关可用DW 统计量来检验(V t 为具有零均值、常数方差,且不存在序列相关的随机变量)---------------------------------( )A .t t t V +=-1ρμμ B.t t t t V +⋅⋅⋅++=--121μρρμμ C. t t V ρμ= D. ⋅⋅⋅++=-12t t t V V ρρμ20.对于原模型t t t X Y μββ++=10,一阶差分模型是指------------( )A .)()()(1)(1t tt t t t t X f X f X X f X f Y μββ++=B .t t t X Y μβ∆+∆=∆1C .t t t X Y μββ∆+∆+=∆10D .)()()1(11101----+-+-=-t t t t t t X X Y Y ρμμρβρβρ四 多项选择题(每个2分,共10分)1.以Y 表示实际值,Yˆ表示回归值,i e 表示残差项,最小二乘直线满足------------------------------------------------------------------------------------------( )A .通用样本均值点(Y X ,) B.ii Y Y ˆ∑=∑ C .0),ˆ(=i i ov e Y C D.0)ˆ(2=-∑i i Y Y E .0)ˆ(=-∑Y Y i2.剩余变差(RSS )是指--------------------------------------------------( )A .随机因素影响所引起的被解释变量的变差B .解释变量变动所引起的被解释变量的变差C .被解释变量的变差中,回归方程不能作出解释的部分D.被解释变量的总变差与解释变量之差E.被解释变量的实际值与回归值的离差平方和3. 对于经典线性回归模型,0LS估计量具备------------------------()A.无偏性 B.线性特性 C.正确性 D.有效性 E.可知性4. 异方差的检验方法有---------------------------------------------------()A.残差的图形检验 B.游程检验 C.White检验D.帕克检验E.方差膨胀因子检验5. 多重共线性的补救有---------------------------------------------------()A.从模型中删掉不重要的解释变量 B.获取额外的数据或者新的样本 C.重新考虑模型 D.利用先验信息 E. 广义差分法五简答计算题(4题,共50分)1.简述F检验的意图及其与t检验的关系。

线性回归分析双变量模型回归分析的含义回归分析是研究一个叫做因变量的变量对另一个或多个叫做解释变量的变量的统计依赖关系。

其用意在于,通过解释变量的已知值或给定值去估计或预测因变量的总体均值。

双变量回归分析:只考虑一个解释变量。

(一元回归分析,简单回归分析)复回归分析:考虑两个以上解释变量。

(多元回归分析)统计关系与确定性关系统计(依赖)关系:非确定性的关系。

在统计依赖关系中,主要处理的是随机变量,也就是有着概率分布的变量。

特别地,因变量的内在随机性是注定存在的。

例如:农作物收成对气温、降雨、阳光以及施肥的依赖关系便是统计性质的。

这些解释变量固然重要,但是并不能使我们准确地预测农作物的收成。

确定性关系:函数关系。

例如物理学中的各种定律。

)/(221r m m k F回归与因果关系❑回归分析研究因变量对于解释变量的统计依赖关系,但并不一定意味着因果关系。

一个统计关系式,不管多强和多么具有启发性,都永远不能确立因果联系。

❑因果关系的确立必须来自于统计关系以外,最终来自于这种或那种理论(先验的或是理论上的)。

回归分析与相关分析(一)❑相关分析:用相关系数测度变量之间的线性关联程度。

例如:测度统计学成绩和高等数学成绩的的相关系数。

假设测得0.90,说明两者存在较强的线性相关。

❑回归分析:感兴趣的是,如何从给定的解释变量去预测因变量的平均取值。

例如:给定一个学生的高数成绩为80分,他的统计学成绩平均来说应该是多少分。

回归分析与相关分析(二)❑在相关分析中,对称地对待任何两个变量,没有因变量和解释变量的区分。

而且,两个变量都被当作随机变量来处理。

❑在回归分析中,因变量和解释变量的处理方法是不对称的。

因变量被当作是统计的,随机的。

而解释变量被当作是(在重复抽样中)取固定的数值,是非随机的。

(把解释变量假定为非随机,主要是为了研究的便利,在高级计量经济学中,一般不需要这个假定。

)双变量回归模型(一元线性回归模型)双变量回归模型(最简单的回归模型)模型特点因变量(Y)仅依赖于唯一的一个解释变量(X)。

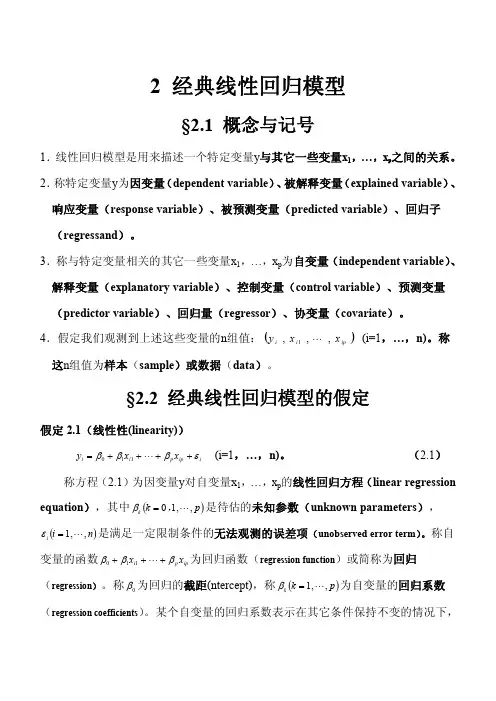

2 经典线性回归模型§2.1 概念与记号1.线性回归模型是用来描述一个特定变量y 与其它一些变量x 1,…,x p 之间的关系。

2. 称特定变量y 为因变量 (dependent variable )、 被解释变量 (explained variable )、 响应变量(response variable )、被预测变量(predicted variable )、回归子 (regressand )。

3.称与特定变量相关的其它一些变量x 1,…,x p 为自变量(independent variable )、 解释变量(explanatory variable )、控制变量(control variable )、预测变量 (predictor variable )、回归量(regressor )、协变量(covariate )。

4.假定我们观测到上述这些变量的n 组值:() ip i i x x y , , , 1 L (i=1,…,n)。

称 这n 组值为样本(sample )或数据(data )。

§2.2 经典线性回归模型的假定假定 2.1(线性性(linearity))iip p i i x x y e b b b + + + + = L 1 1 0 (i=1,…,n)。

(2.1)称方程(2.1)为因变量y 对自变量x 1,…,x p 的线性回归方程(linear regression equation ),其中 ( ) p , k k , , 1 0 L = b 是待估的未知参数(unknown parameters ),( ) n i i , , 1 L = e 是满足一定限制条件的无法观测的误差项(unobserved error term ) 。

称自变量的函数 ip p i x x b b b + + + L 1 1 0 为回归函数(regression function )或简称为回归 (regression )。

称 0 b 为回归的截距(ntercept),称 ( ) p k k , , 1 L = b 为自变量的回归系数 (regression coefficients ) 。

某个自变量的回归系数表示在其它条件保持不变的情况下,这个自变量变化一个单位对因变量的影响程度, 这个影响是在排除其它自变量的影 响后,这个自变量对因变量的偏效应。

下面引入线性回归方程的矩阵表示。

记( ) Tp b b b b , , , 1 0 L = (未知系数向量(unknown coefficient vector )) ( ) T ip i i x x x , , ~ 1 L = , ( ) T ip i i x x x , , , 1 1 L = ,则iTi i x y e b + = (i=1,…,n)。

又记X = ÷ ÷ ÷ øö ç ç ç è æ np p n x x x x M L L L M M 1 1 11 1 1 , Y = ÷ ÷ ÷ ø ö ç ç ç è æ n y y M 1 , ÷ ÷ ÷ø ö ç ç ç è æ = n e e e M 1 ,则 eb + = X Y 假定2.2(严格外生性(strictly exogeneity))( ) ( )np n p i n i x x x x E x x E , , , , , , | ~, , ~| 1 1 11 1 L L L L e e = =0 (i=1,…,n)。

严格外生性的含义 ·误差项的无条件期望为零( ) 0 = i E e(i=1,…,n)。

·正交条件(orthogonality conditions )( ) ( ) ( ) 0 ~ 1 = ÷ ÷ ÷ øö ç ç ç è æ = i jp i j i j x E x E x E e e e M (i=1,…,n ; j=1,…,n )。

·不相关条件(zerocorrelation conditions )( ) 0, cov = jk i x e (对所有i ,j ,k)。

由以上严格外生性的含义可知,如果在时间序列数据中存在的滞后效应 (lagged effect )和反馈效应(feetback effect ) ,那么严格外生性条件就不成立。

因而,在严格外生性假定下推出的性质就不能用于这类时间序列数据。

滞后效应是指 自变量历史值对因变量当前值的影响, 反馈效应是指因变量当前值对自变量未来值 的影响。

假定2.3(无多重共线性(no multicollinearity))n×(p+1)矩阵X的秩为(p+1)的概率为1。

假定2.4(球面误差方差(spherical error variance))( ) nn I x x Var 21 ~, , ~| s e = L ·条件同方差(conditional homoskedasticity )( )0 ~ , , ~| 2 1 2 > =s e ni x x E L (i=1,…,n)。

(误差方差) ·误差项不相关(no correlation between error term )( )0 ~ , , ~| 1 = nj i x x E L e e (对所有i≠j) 在经典线性回归模型的四个假定中,假定2.1和假定2.3是必不可少的,但假定 2.2和假定2.4中的严格外生性、条件同方差和误差项不相关以后可以适当放宽。

§2.3 随机样本的经典线性回归模型若样本( )Ti i x y ~, (i=1,…,n)为IID ,那么假定2.2和假定2.4可简化为 假定2.2: ( ) 0~| = i i x E e (i=1,…,n) 假定2.4: ( ) 0~| 22 > =s e i i x E (i=1,…,n) §2.4 确定性自变量的经典线性回归模型若更进一步假定自变量x 1,…,x p 为确定性的变量,那么假定2.2和假定2.4可 进一步简化为假定2.2: ( ) 0 = i E e(i=1,…,n)假定2.4: ( ) nI Var 2 s e = §2.5 最小二乘估计量及其代数性质虽然我们无法直接观测到误差项, 但对未知系数向量β的一个假想值 (hypotheticalvalue )b ~,容易计算出ipp i i x x y b b b ~~ ~ 1 1 0 - - - - L 称这个量为第i 次观测的残差(residual ),并且称使残差平方和(residual sum of squares )( )( ) å = - - - - = ni ipp i i x x y Q 12 1 1 0 ~ ~ ~ ~b b b b L =( ) ( )b b ~~ X Y X Y T - - 达到最小的假想值:为未知系数向量β的普通最小二乘估计量(ordinary least squares estimators ),简记 为OLS 估计量。

下面介绍OLS 估计量的一些代数性质。

·一阶条件(firstorder conditions )( ) 0= - Xb Y X T (正规方程(normal equations ))·β的OLS 估计量:在假定2.3成立时()÷ øö ç è æ ÷ ø ö ç è æ = = å å = - = -ni i i n i T i i TTy x n x x n Y X X X b 1 11 1 1 1 ·估计量的抽样误差(sampling error ): ( ) eb T T X X X b 1- = - ·第i 次观测的拟合值(fitted value ): bx y Ti i = ˆ ·拟合值向量(vector of fitted value ): ( ) HYY X X X X Xb Y T T º = = -1ˆ ·投影矩阵(projection matrix ): ( ) T T XX X X H º (对称幂等,秩为p+1,HX=X ) ·第i 次观测的OLS 残差(OLS residual ): i i Ti i i yy b x y e ˆ - = - = ( )b b~ min arg ~Q b =·残差向量(vector of OLS residuals ):e=YXb= Y Y ˆ - =(IH)Y≡MY eM = ·零化子(annihilator ):M=I n – H (对称幂等,秩为np1,MX=0)·一阶条件: 0 = e X T,即 01 1= å = ni i i e x n ( ( ) 0 = i i x E e )·OLS 估计的几何意义: e Ye Xb Y + = + = ˆ L(X)·残差平方和(residuals sum of squares )RSS= e e M MY Y e e T T T= = ,(其自由度为np1)·σ 2的OLS 估计量RMSp n RSSs º - - =12 (残差均方,residual mean square )·回归(方程)标准误(standard error of the regression (equation))1- - =p n RSS s (残差标准误,residual standard error)·平方和分解公式当回归方程包含常数项时,可以证明称这个等式为平方和分解公式。

记YeYˆ e e Y YY Y T T T + = ˆ ˆ ( ) ( ) å å å = = = + - = - ni ini ini ie y yy y 121212ˆ( ) Y n I Y y y SST T T ni i ÷ ø öçè æ - = - º å =ii 1 1 2 (称为总平方和,其自由度为n1) (其中, ( ) T 1 , , 1L = i 表示每个元素均为1的n 维向量)( ) RSS SST yy SS ni i reg - = - º å =1 2ˆ (称为回归平方和,其自由度为p ) 则平方和分解公式又可写成:,(n1)=p+(np1)。