最小二乘参数估计的递推算法——

- 格式:pdf

- 大小:354.97 KB

- 文档页数:45

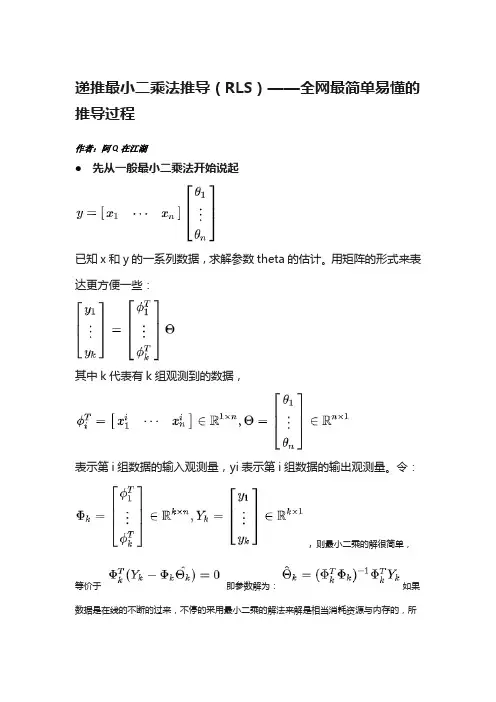

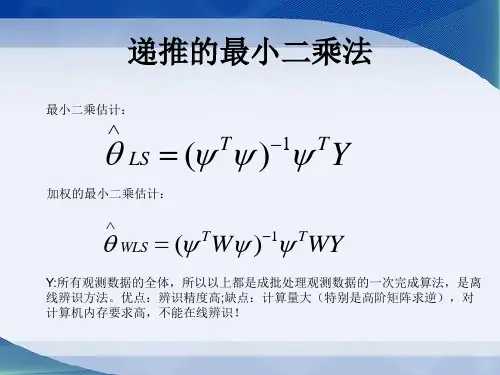

递推最小二乘法推导(RLS)——全网最简单易懂的推导过程作者:阿Q在江湖先从一般最小二乘法开始说起已知x和y的一系列数据,求解参数theta的估计。

用矩阵的形式来表达更方便一些:其中k代表有k组观测到的数据,表示第i组数据的输入观测量,yi表示第i组数据的输出观测量。

令:,则最小二乘的解很简单,等价于即参数解为:如果数据是在线的不断的过来,不停的采用最小二乘的解法来解是相当消耗资源与内存的,所以要有一种递推的形式来保证对的在线更新。

进一步推导出递推最小二乘法(RLS)我们的目的是从一般最小二乘法的解推导出的递推形式。

一定要理解这里的下标k代表的意思,是说在有k组数据情况下的预测,所以k比k-1多了一组数据,所以可以用这多来的一组数据来对原本的估计进行修正,这是一个很直观的理解。

下面是推导过程:先看一般最小二乘法的解下面分别对和这两部分进行推导变换,令得到下面公式(1)下面来变换得到公式(2)下面再来,根据一般最小二乘法的解,我们知道下式成立,得到公式(3)(注:后续公式推导用到)好了,有了上面最主要的三步推导,下面就简单了,将上面推导的结果依次代入公式即可:至此,终于变成的形式了。

通过以上推导,我们来总结一下上面RLS方程:注:以上公式7中,左边其实是根据公式1,右边I为单位矩阵公式(5)和(7)中,有些文献资料是用右边的方程描述,实际上是等效的,只需稍微变换即可。

例如(5)式右边表达式是将公式(1)代入计算的。

为简化描述,我们下面还是只讨论左边表达式为例。

上面第7个公式要计算矩阵的逆,求逆过程还是比较复杂,需要用矩阵引逆定理进一步简化。

矩阵引逆定理:最终RLS的方程解为:好了,至此完毕!以上应该算是最简单的推导过程了,相信都能看得懂了。

后续有时间将增加带遗忘因子的RLS推导步骤,毕竟工程上的实际用途很多用此方法,比如在线辨识电池系统等效电路模型的参数,用于卡尔曼滤波算法估算SOC……。

递推最小二乘法协方差矩阵概述说明以及解释1. 引言1.1 概述在统计学和计量经济学中,递推最小二乘法(Recursive Least Squares,简称RLS)是一种常用的参数估计方法。

它通过不断更新样本数据进行参数的估计,并且可以适用于非静态数据场景。

协方差矩阵是统计分析中重要的概念,它描述了变量之间的线性关系强度和方向,并且在许多领域具有广泛应用。

1.2 文章结构本文首先介绍递推最小二乘法的定义和原理,在此基础上详细解释算法的步骤以及其应用领域。

接着,我们将引入协方差矩阵的概念并介绍其计算方法,同时探讨了它在实际问题中所起到的作用和应用场景。

最后,我们将对递推最小二乘法与协方差矩阵之间的关系进行解释,并通过实例分析来说明它们如何相互影响。

1.3 目的本文旨在全面介绍递推最小二乘法和协方差矩阵,并深入探讨它们之间的联系。

通过对这两个概念及其应用的理解,我们可以更好地理解参数估计方法和变量间关系的描述与分析。

此外,我们还将展望相关领域未来可能的研究方向,以促进学术和实践的进一步发展。

2. 递推最小二乘法2.1 定义和原理:递推最小二乘法是一种用于估计线性模型参数的方法。

它可以通过历史数据的不断更新来逐步拟合模型,以使得估计值与观测值之间的误差达到最小化。

该方法可以被形式化地描述为以下步骤:1. 初始化模型参数的初始值。

2. 从历史数据中选择一个样本,并使用当前参数估计出该样本对应的输出值。

3. 计算该样本的预测误差。

4. 根据预测误差对参数进行调整,使得预测误差尽量减小。

5. 重复步骤2至4,直到所有样本都被处理过一遍,或者满足终止条件。

递推最小二乘法是基于最小二乘原理,即将真实观测值与模型预测值之间的差异平方求和并最小化这个目标函数。

通过迭代地更新参数,递推最小二乘法可以逐渐优化模型,并获得更准确的参数估计。

2.2 算法步骤:具体而言,在每次迭代中,递推最小二乘法按照以下步骤进行操作:1. 根据历史数据选择一个样本,并根据当前的参数估计出预测值。

最小二乘法参数估计量推导最小二乘法,这个名字听上去挺高深的,其实就是一种简单而强大的数学工具,广泛应用于数据分析中。

今天,我们就来聊聊这玩意儿到底是怎么一回事。

1. 什么是最小二乘法最小二乘法其实就是在做“找差距”的工作。

假设你有一堆数据点,比如说你测量了一系列的温度和对应的电力消耗,你的目标是找到一条最能贴合这些数据点的直线。

这条直线就像是你为数据“量体裁衣”的结果。

1.1. 基本思想最小二乘法的核心思想就是:找到一条直线,使得每一个数据点到这条直线的距离(叫做“残差”)的平方和最小。

这个“平方和”就像是把所有的偏差加起来,让它们不再那么“任性”。

1.2. 为什么用“平方”?那为什么要把这些偏差平方呢?因为平方能有效地放大大的误差,这样我们就不容易忽视它们。

就像打麻将,偏差大的牌更容易被看见,才能让我们在游戏中更精准地调整策略。

2. 数学推导好啦,接下来我们就来捋一捋这个过程。

咱们还是从简单的说起:假设你有一组数据点(x₁, y₁)、(x₂, y₂)、……、(xₙ, yₙ),而你要找的是一条直线y = β₀ + β₁x。

这条直线就是我们的“理想之线”。

2.1. 定义目标函数我们的目标就是最小化所有这些点到直线的距离平方和。

用数学的语言来描述,就是要最小化目标函数:[ S(beta_0, beta_1) = sum_{i=1}^n (y_i beta_0 beta_1 x_i)^2 ]。

这里面,(y_i beta_0 beta_1 x_i)就是每一个点到直线的距离,平方了之后就能让误差更加明显。

2.2. 求导数为了找到最小值,我们需要对目标函数进行求导数,然后让导数等于零。

这个过程就像是找到山顶的最低点一样。

我们分别对β₀和β₁求偏导数,然后设定这些偏导数为零,得到两个方程:[ frac{partial S}{partial beta_0} = 0 ]。

[ frac{partial S}{partial beta_1} = 0 ]。

递推最小二乘法推导递推最小二乘法是一种经典的数学方法,用于解决数据拟合问题。

它通过最小化误差平方和的方法,寻找最佳的拟合曲线或平面,从而对数据进行预测和分析。

本文将详细介绍递推最小二乘法的原理和推导过程。

一、引言在现实生活和科学研究中,我们经常需要通过已知的数据来拟合一个函数,以便对未知的数据进行预测或分析。

而最小二乘法就是一种常用的数据拟合方法,它的基本思想是通过最小化误差的平方和,找到最佳的拟合函数。

二、最小二乘法的基本原理最小二乘法的基本原理是通过最小化残差平方和来确定拟合函数的参数。

残差指的是每个数据点的观测值与拟合函数预测值之间的差异。

最小二乘法的目标是找到使得残差平方和最小的参数值,从而得到最佳的拟合曲线或平面。

三、递推最小二乘法的推导过程递推最小二乘法是最小二乘法的一种改进方法,它能够更加高效地进行参数估计。

下面将结合一个简单的一元线性回归问题,来详细介绍递推最小二乘法的推导过程。

假设我们有一组样本数据(x₁, y₁), (x₂, y₂), …, (xₙ, yₙ),需要找到一条直线y = ax + b 来拟合这些数据。

我们可以定义残差eᵢ= yᵢ- (axᵢ + b),其中 eᵢ表示第 i 个数据点的残差。

我们的目标是通过最小化残差平方和来确定直线的参数a 和b。

即最小化损失函数 S = Σ(eᵢ²)。

我们需要计算一些中间变量,包括样本数据的均值xₙ和yₙ,以及样本数据的协方差 sₓy 和方差 sₓ²。

其中,xₙ = (x₁ + x₂ + … + xₙ) / n,yₙ = (y₁ + y₂ + … + yₙ) / n,sₓy = (Σ(xᵢ - xₙ)(yᵢ - yₙ)) / (n - 1),sₓ² = (Σ(xᵢ - xₙ)²) / (n - 1)。

接下来,我们可以通过递推公式来更新参数 a 和 b 的估计值。

首先,我们初始化a₀和 b₀的估计值为0。

几种最小二乘法递推算法的小结最小二乘法是一种常见的参数估计方法,广泛应用于各个领域的数学和统计模型的拟合问题。

在实际应用中,我们常常需要递推地计算最小二乘法的结果,以便能够在实时数据到来的情况下,快速地更新参数估计值。

以下是几种常见的最小二乘法递推算法的小结。

1. 递推最小二乘法(Recursive least squares, RLS)递推最小二乘法是一种在线参数估计方法,可以在每次新数据到来时,快速地更新参数估计值。

RLS算法利用递推的方式,将历史数据和新数据的信息结合起来,从而得到最新的参数估计值。

该算法基于递归迭代过程,迭代公式中的权重矩阵可以由历史数据的协方差矩阵递推得到。

递推最小二乘法具有良好的收敛性和较低的计算复杂度。

2.递推最小二乘法的变种算法(RLS的变种算法)递推最小二乘法的变种算法是对传统的RLS算法进行改进和优化的方法。

其中,经典的改进算法有递归正交最小二乘法(Recursive orthogonal least squares, ROLS)和递推快速QR分解法(Recursive fast QR factorization, RFQR)。

ROLS算法通过引入正交化处理,解决了经典RLS算法中信号相关性较高时,参数估计不稳定的问题。

RFQR算法则通过对历史数据进行快速QR分解的方法,进一步提高了算法的计算速度,并降低了计算复杂度。

3. 渐进最小二乘法(Asymptotic least squares, ALS)渐进最小二乘法是一种常见的在线参数估计算法,用于解决参数估计问题的收敛速度较慢的情况。

ALS算法通过估计参数的渐进协方差矩阵,然后利用资料增益矩阵计算最新的参数估计值。

由于ALS算法不需要存储和计算全部历史数据的相关矩阵,因此可以在实时数据到来的情况下,快速地进行参数估计。

4. 数据辅助递推最小二乘法(Data-augmented recursive least squares, DARLS)数据辅助递推最小二乘法是一种常见的递推最小二乘法的改进算法,适用于当历史数据缺失或者不完整时。

广义最小二乘法和递推最小二乘法

广义最小二乘法和递推最小二乘法是最小二乘法算法的改进版本。

最小二乘法

是一种常见的统计学技术,它有效地估计未知参数集,也可以用于回归分析。

本文旨在详细介绍广义最小二乘法和递推最小二乘法。

首先让我们了解最小二乘法。

最小二乘法(Least Squares)是一种最常用的

方法,其中未知参数的估计量是穷举法的最优估计,这是一种很有效的技术。

最小二乘法的求解过程中,以平方的残差来最小化两个估计量的差异,以求得最优参数。

然而,最小二乘法有时也会出现缺陷,其中一个原因是可能会把噪声干扰包含

在结果中,另一个原因是它依赖被观测值的方差,而方差受因素影响。

因此,有了广义最小二乘法。

广义最小二乘法是在最小二乘法的基础上改进的算法。

在广义最小二乘法中,

我们通过加入惩罚参数来最小化残差,以对噪声进行抑制。

惩罚参数的加入,使得预测变更的安全降低,同时噪声的影响也可以得以抑制。

因此,广义最小二乘法在回归分析中也有广泛的应用。

此外,基于最小二乘法的另一种增强方法是“递推最小二乘法”。

递推最小二

乘法是将最小二乘法算法进行改良,从而改善对噪声的抑制能力。

和广义最小二乘法一样,递推最小二乘法也需要惩罚参数的加入。

递推最小二乘法也通过持续更新未知参数,来达到最小化残差的目的,从而能有效地抑制噪声。

以上就是本文要陈述的关于广义最小二乘法和递推最小二乘法的改进方法以及

它们的比较。

从技术上讲,广义最小二乘法和递推最小二乘法都比最小二乘法更能抑制噪声和拟合回归曲线,因此,它们在回归分析中都有广泛的应用。

递推最小二乘法原理递推最小二乘法(Recursive Least Squares, RLS)是一种经典的自适应滤波算法,广泛应用于信号处理、通信系统、控制系统等领域。

它通过不断地更新参数估计,实现对信号的实时跟踪和预测。

本文将介绍递推最小二乘法的原理及其应用。

首先,我们来了解一下最小二乘法(Least Squares, LS)的基本原理。

最小二乘法是一种常见的参数估计方法,它通过最小化观测数据的残差平方和来确定参数的估计值。

对于线性模型,最小二乘法的估计值可以通过求解正规方程或者利用矩阵运算来得到。

然而,在实际应用中,数据通常是逐步到达的,因此需要一种能够实时更新参数估计的方法,这就是递推最小二乘法。

递推最小二乘法的核心思想是利用递推的方式不断更新参数估计,以适应数据的动态变化。

在每次新的数据到达时,根据当前的参数估计和新的数据,通过一定的计算方法得到更新后的参数估计。

这样,参数估计可以随着时间的推移而不断优化,从而更好地适应信号的变化。

在递推最小二乘法中,通常会引入一个遗忘因子(ForgettingFactor),用于衰减历史数据的影响,使算法更加关注最近的数据。

遗忘因子的选择对于算法的性能有着重要的影响,合理的遗忘因子可以平衡对历史数据和最新数据的重视程度,从而提高参数估计的准确性和稳定性。

除了参数估计,递推最小二乘法还可以用于信号预测和滤波。

通过不断更新参数估计,可以实现对信号的实时跟踪和预测,从而在控制系统和通信系统中发挥重要作用。

在实际应用中,递推最小二乘法通常与自适应滤波器相结合,构成自适应滤波系统,用于抑制噪声、提取信号等。

总之,递推最小二乘法是一种重要的自适应参数估计方法,具有实时性强、适应性好的特点,适用于动态环境下的信号处理和控制。

通过不断更新参数估计,可以实现对信号的准确跟踪和预测,为实际应用提供了有力的支持。

在未来的研究和工程实践中,递推最小二乘法仍将发挥重要作用,为各种领域的应用提供有效的解决方案。

递推最小二乘法公式推导1. 引言嘿,大家好!今天我们来聊聊一个在数据分析和统计学中非常重要的话题:递推最小二乘法。

听起来有点高大上,但别担心,我会用简单易懂的语言来带你们走进这个领域,仿佛在和老朋友聊天。

准备好了吗?让我们一起揭开这个神秘面纱,看看它是怎么运作的。

2. 什么是最小二乘法?2.1 基本概念首先,最小二乘法其实就是一种用来拟合数据的方法。

想象一下,你在一个阳光明媚的日子里和朋友打乒乓球,记录下每一局的得分。

你想知道你和朋友的水平差不多还是天差地别,这时候就需要用到最小二乘法来找出最佳拟合线。

简单说,就是通过一条线,把所有的点“尽量”挤在一起,这样就能直观地看出你们的实力差距啦。

2.2 工作原理这个方法的核心思想就是把所有点到拟合线的距离(也就是误差)平方后求和,然后最小化这个总和。

听起来是不是有点复杂?没关系,换个方式想。

就像你在吃一盘水果沙拉,里面有苹果、香蕉、葡萄,总得找个方法把它们混合得更均匀,不然每次吃到的口感就不一样,简直是“心有不甘”啊!3. 递推最小二乘法的魅力3.1 动态更新说到递推最小二乘法,它就像是一个智能的助手,能够动态更新你的拟合线。

就拿你那打乒乓球的例子来说,随着你打的局数越来越多,你的水平也会有所变化,这时候,递推最小二乘法就能根据新的数据不断调整那条拟合线。

是不是听起来特别聪明?就像你的朋友在旁边不断给你建议:“嘿,这一局你发球不太准,下次可以试试这样……”这样下去,你的水平肯定会越来越高!3.2 应用场景那么,这种方法到底能用在什么地方呢?其实,想想我们的日常生活,处处都有它的身影。

从股票市场的分析到气象预测,从医疗健康的监测到运动员的训练数据,递推最小二乘法的应用可谓是无处不在。

这就像是一个万能的小工具,能帮你解决各种各样的问题,真是“百搭”啊!4. 推导过程4.1 数学基础好了,咱们回到正题,推导递推最小二乘法的公式。

首先,你得有一个基础的数学知识,尤其是线性代数。

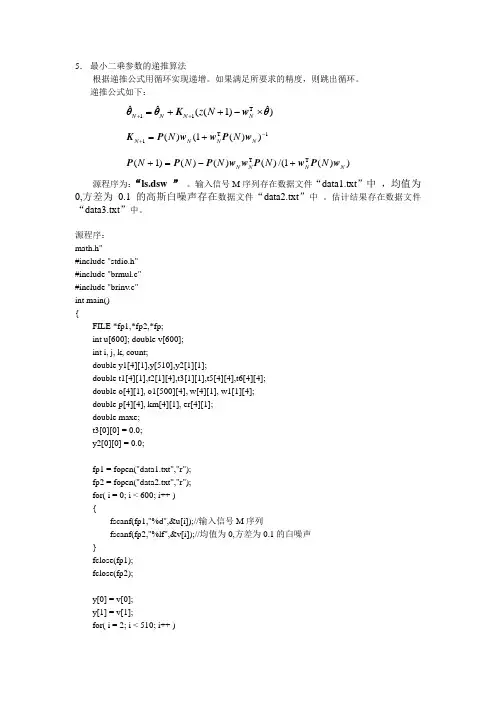

5. 最小二乘参数的递推算法根据递推公式用循环实现递增。

如果满足所要求的精度,则跳出循环。

递推公式如下:)ˆ)1((ˆˆT 11θw K θθ⨯-++=++NN N N N z 1T 1))(1()(-++=N N N N N N w P w w P K))(1/()()()()1(T T N N N N N N N N N w P w P w w P P P +-=+源程序为:“ls.dsw ” 。

输入信号M 序列存在数据文件“data1.txt ”中 ,均值为0,方差为0.1的高斯白噪声存在数据文件“data2.txt ”中 。

估计结果存在数据文件“data3.txt ”中。

源程序:math.h"#include "stdio.h"#include "brmul.c"#include "brinv.c"int main(){FILE *fp1,*fp2,*fp;int u[600]; double v[600];int i, j, k, count;double y1[4][1],y[510],y2[1][1];double t1[4][1],t2[1][4],t3[1][1],t5[4][4],t6[4][4];double o[4][1], o1[500][4], w[4][1], w1[1][4];double p[4][4], km[4][1], er[4][1];double maxe;t3[0][0] = 0.0;y2[0][0] = 0.0;fp1 = fopen("data1.txt","r");fp2 = fopen("data2.txt","r");for( i = 0; i < 600; i++ ){fscanf(fp1,"%d",&u[i]);//输入信号M 序列fscanf(fp2,"%lf",&v[i]);//均值为0,方差为0.1的白噪声}fclose(fp1);fclose(fp2);y[0] = v[0];y[1] = v[1]; for( i = 2; i < 510; i++ )y[i] = 1.5*y[i-1]-0.7*y[i-2]+u[i-1]+0.5*u[i-2]+v[i];y1[0][0] = -1.5;y1[1][0] = 0.7;y1[2][0] = 1.0;y1[3][0] = 0.5;for( i = 0; i < 4; i++ ) o[i][0] = 0;for( i = 0; i < 4; i++ )for( j = 0; j < 4;j++ ){if( i == j ) p[i][j] = 1000000;else p[i][j] = 0;}for( k = 0; k < 500; k++ ){for( i = 0; i < 2; i++ ) w[i][0] = w1[0][i] = -y[1-i+k];for( i = 2; i < 4; i++ ) w[i][0] = w1[0][i] = u[3-i+k];brmul(p,w,4,4,1,t1);brmul(w1,p,1,4,4,t2);brmul(t2,w,1,4,1,t3);for( i = 0; i < 4; i++ ) km[i][0] = t1[i][0]/(1+t3[0][0]);brmul(w1,o,1,4,1,y2);for( i = 0; i < 4; i++ ) o[i][0] = o[i][0] + km[i][0]*(y[k+2] - y2[0][0]);brmul(t1,w1,4,1,4,t5);brmul(t5,p,4,4,4,t6);for( i = 0; i < 4; i++ )for( j = 0; j < 4; j++ ) p[i][j] = p[i][j] - t6[i][j]/(1+t3[0][0]);for ( i = 0; i < 4; i++ ) o1[k][i] = o[i][0];maxe = 0;for( i = 0; i < 4; i++ ){er[i][0] = fabs((o[i][0] - y1[i][0])/y1[i][0]);maxe = max( er[i][0], maxe );}count = k;if( maxe < 0.01 ) break;}fp = fopen("Data3.txt","w");fprintf(fp,"a0\t\ta1\t\tb0\t\tb1\n");for( i = 0; i < count+1; i++ ){fprintf(fp,"%f\t%f\t%f\t%f\n",o1[i][0],o1[i][1],o1[i][2],o1[i][3]);}fclose(fp);return 0; }。

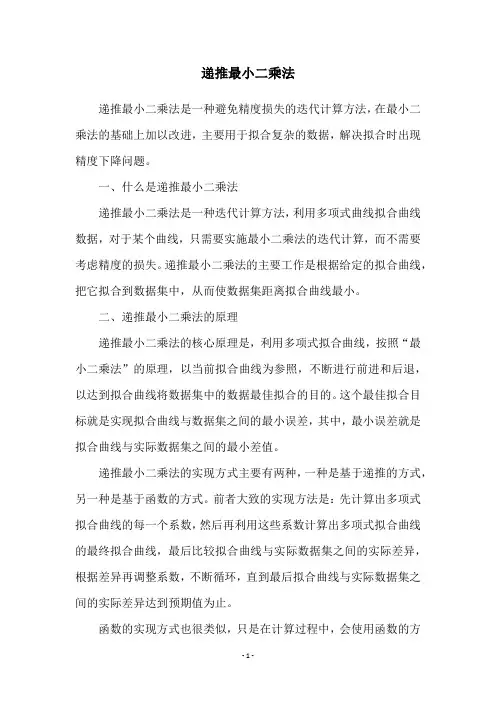

递推最小二乘法递推最小二乘法是一种避免精度损失的迭代计算方法,在最小二乘法的基础上加以改进,主要用于拟合复杂的数据,解决拟合时出现精度下降问题。

一、什么是递推最小二乘法递推最小二乘法是一种迭代计算方法,利用多项式曲线拟合曲线数据,对于某个曲线,只需要实施最小二乘法的迭代计算,而不需要考虑精度的损失。

递推最小二乘法的主要工作是根据给定的拟合曲线,把它拟合到数据集中,从而使数据集距离拟合曲线最小。

二、递推最小二乘法的原理递推最小二乘法的核心原理是,利用多项式拟合曲线,按照“最小二乘法”的原理,以当前拟合曲线为参照,不断进行前进和后退,以达到拟合曲线将数据集中的数据最佳拟合的目的。

这个最佳拟合目标就是实现拟合曲线与数据集之间的最小误差,其中,最小误差就是拟合曲线与实际数据集之间的最小差值。

递推最小二乘法的实现方式主要有两种,一种是基于递推的方式,另一种是基于函数的方式。

前者大致的实现方法是:先计算出多项式拟合曲线的每一个系数,然后再利用这些系数计算出多项式拟合曲线的最终拟合曲线,最后比较拟合曲线与实际数据集之间的实际差异,根据差异再调整系数,不断循环,直到最后拟合曲线与实际数据集之间的实际差异达到预期值为止。

函数的实现方式也很类似,只是在计算过程中,会使用函数的方式,将拟合曲线的系数表示为函数的形式,然后再比较拟合曲线与实际数据集之间的实际差异,根据差异再调整函数系数,最后实现拟合曲线与实际数据集之间的最小差异。

三、应用递推最小二乘法在实际应用中可以用来拟合复杂的数据曲线,以求得更好的拟合效果,解决拟合时出现精度下降问题。

它具有计算量小、运算简单、拟合结果较好的优点,因此在实际应用中得到了广泛的使用,比如在众多植物物种的遗传分析中,用递推最小二乘法来拟合植物的遗传规律,以获得更准确的估计结果;在探测地球大气层时,也可以用最小二乘法来拟合大气层中的湿度数据,以获取更加准确的湿度数据;在搜索引擎中,对查询结果也可以用最小二乘法拟合出来,以获得更准确的查询结果等等。

递推最小二乘法的一般步骤:1. 根据输入输出序列列出最小二乘法估计的观测矩阵ϕ:] )(u ... )1( )( ... )1([)(T b q n k k u n k y k y k ------=ϕ没有给出输出序列的还要先算出输出序列。

本例中, 2)]-u(k 1),-u(k 2),-1),-y(k -[-y(k )(T =k ϕ。

2. 给辨识参数θ和协方差阵P 赋初值。

一般取0θ=0或者极小的数,取σσ,20I P =特别大,本例中取σ=100。

3. 按照下式计算增益矩阵G :)()1()(1)()1()(k k P k k k P k G T ϕϕϕ-+-= 4. 按照下式计算要辨识的参数θ:)]1(ˆ)()()[()1(ˆ)(ˆ--+-=k k k y k G k k T θϕθθ5. 按照下式计算新的协方差阵P :)1()()()1()(---=k P k k G k P k P T ϕ6. 计算辨识参数的相对变化量,看是否满足停机准则。

如满足,则不再递推;如不满足,则从第三步开始进行下一次地推,直至满足要求为止。

停机准则:εϑϑϑ<--)(ˆ)1(ˆ)(ˆmax k k k i i i i 本例中由于递推次数只有三十次,故不需要停机准则。

7. 分离参数:将a 1….a na b 1….b nb 从辨识参数θ中分离出来。

8. 画出被辨识参数θ的各次递推估计值图形。

为了说明噪声对递推最小二乘法结果的影响,程序5-7-2在计算模拟观测值时不加噪声, 辨识结果为a1 =1.6417,a2 = 0.7148,b1 = 0.3900,b2 =0.3499,与真实值a1 =1.642, a2 = 0.715, b1 = 0.3900,b2 =0.35相差无几。

程序5-7-2-1在计算模拟观测值时加入了均值为0,方差为0.1的白噪声序列,由于噪声的影响,此时的结果为变值,但变化范围较小,现任取一组结果作为辨识结果。

一、介绍在数学和工程领域中,最小二乘法是一种常见的参数估计方法,用于寻找一组参数使得观测数据和模型预测值之间的误差最小。

而在matlab中,递推最小二乘法函数是指使用递推方式来实现最小二乘法计算的函数。

本文将介绍matlab中如何编写递推最小二乘法函数,并对其原理和应用进行详细讲解。

二、递推最小二乘法的原理递推最小二乘法是一种迭代方法,通过不断更新参数来逼近最优解。

其原理可以简单描述为以下几个步骤:1. 初始化参数:首先需要初始化参数向量,通常可以使用随机数或者某些先验知识来确定初始参数值。

2. 迭代更新:接下来进入迭代更新阶段,根据当前参数值和观测数据,更新参数向量以降低误差。

3. 判断停止条件:迭代更新的过程中需要设立停止条件,当满足某个条件时停止迭代,可以是达到一定的迭代次数或者参数变化小于某个阈值等。

三、matlab编写递推最小二乘法函数在matlab中,编写递推最小二乘法函数可以通过以下步骤实现:1. 编写初始化函数:首先需要编写一个初始化函数来初始化参数向量,该函数可以接受观测数据和模型的输入,并返回初始参数向量。

2. 编写更新函数:接下来需要编写一个更新函数来进行参数的迭代更新,该函数也可以接受观测数据和当前参数向量的输入,并返回更新后的参数向量。

3. 编写停止条件函数:最后需要编写一个停止条件函数来判断迭代是否应该停止,该函数可以接受当前参数向量和更新前的参数向量的输入,并返回是否停止的逻辑值。

四、matlab递推最小二乘法函数的应用递推最小二乘法函数在matlab中的应用非常广泛,特别是在参数估计、信号处理、系统识别等领域。

通过使用递推最小二乘法函数,可以快速准确地估计出模型参数,从而提高算法的精度和效率。

由于递推最小二乘法具有较好的收敛性和稳定性,因此在实际工程中也得到了广泛的应用。

五、总结通过本文的介绍,读者可以了解到matlab中递推最小二乘法函数的编写和应用。

递推最小二乘法作为一种迭代方法,能够快速准确地估计出模型参数,并在各种工程领域中得到了广泛的应用。

控制理论与控制工程学位课程《系统辨识》考试报告递推阻尼最小二乘法公式详细推导专业:控制理论与控制工程班级:2011双控(研)学生姓名:江南学号:20110201016任课教师:蔡启仲老师2012年06月29 日摘要在参数辨识中,递推最小二乘法是用得最多的一种算法。

但是,最小二乘法存在一些缺点,如随着协方差矩阵的减小,易产生参数爆发现象;参数向量和协方差矩阵的处置选择不当会使得辨识过程在参数收敛之前结束;在存在随机噪声的情况下,参数易产生漂移,出现不稳定等。

为了防止参数爆发现象,Levenberg 提出在参数优化算法中增加一个阻尼项,以增加算法的稳定性。

本文在一般的最小二乘法中增加了阻尼因子,构成了阻尼最小二乘法。

又根据实时控制的要求,详细推到了递推阻尼最小二乘公式,实现在线辨识。

关键字:系统辨识,最小二乘法,递推算法正文1.题目的基本要求已知单入单出系统的差分方程以及噪声,在应用最小二乘法进行辨识的时候,在性能指标中加入阻尼因子,详细推导阻尼最小二乘法的递推公式。

2.输入辨识信号和系统噪声的产生方法和理论依据 2.1系统辩识信号输入选择准则(1)输入信号的功率或副度不宜过大,以免使系统工作在非线性区,但也不应过小,以致信噪比太小,直接影响辩识精度;(2)输入信号对系统的“净扰动”要小,即应使正负向扰动机会几乎均等; (3)工程上要便于实现,成本低。

2.2白噪声及其产生方法 (1) 白噪声过程(2)白噪声是一种均值为0、谱密度为非0常数的平稳随机过程。

(3)白噪声过程定义:如果随机过程()t ω的均值为0,自相关函数为()()2R t t ωσδ= (2.2.1)式中()t δ 为狄拉克(Dirac) 分布函数,即(){(),00,01t t t dt δδ∞∞=≠∞==⎰-且t (2.2.2)则称该随机过程为白燥声过程。

2.3白噪声序列 (1) 定义 如果随机序列{()}w t 均值为0,并且是两两不相关的,对应的自相关函数为()2,0,1,2w l R l l σδ==±± 式中{1,00,0l l l δ=≠=则称这种随机序列{()}w t 为白噪声序列。

最小二乘估计过程推导

最小二乘估计是一种常用的参数估计方法,其基本思想是通过最小化测量值与估计值之间的误差平方和来确定参数值。

具体来说,假设有n组测量数据(x1,y1),(x2,y2),...,(xn,yn),其满足y = f(x,θ)+ε,其中f(x,θ)为参数为θ的函数,ε为误差项,满足ε ~ N(0,σ^2)。

我们的目标是估计θ的值,使得估计的函数f(x,θ)与实际函数y的误差平方和最小。

设误差平方和为S(θ),则有:

S(θ) = Σ(yi - f(xi,θ))^2

我们的目标是通过最小化S(θ)来确定θ的值。

为了达到这个目的,我们需要对S(θ)求导,令导数为0,求得最小化S(θ)的θ值。

对S(θ)求导,得到:

dS(θ)/dθ = Σ2(yi - f(xi,θ))·(-f(xi,θ)/θ) 令导数为0,得到:

Σ(yi - f(xi,θ))·f(xi,θ)/θ = 0

这个方程组称为正规方程组,可以通过矩阵运算求解。

具体地,将f(xi,θ)看作关于θ的函数,构建其雅可比矩阵J,然后将正规方程组写成矩阵形式:

J^T·J·θ = J^T·y

解出θ的值即可得到最小二乘估计。

总之,最小二乘估计是通过最小化误差平方和来确定参数值的方法,其核心在于求解正规方程组,而求解正规方程组可以通过矩阵运

算来完成。