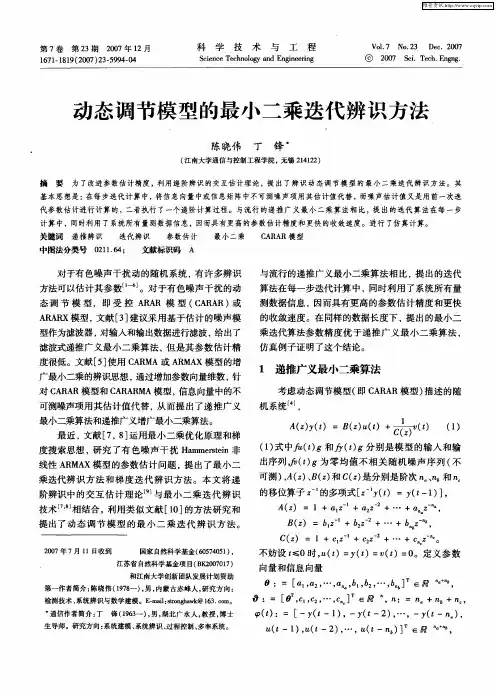

2动态过程数学模型参数估计的最小二乘方法

- 格式:doc

- 大小:851.50 KB

- 文档页数:27

最小二乘法1. 概念定义最小二乘法(Least Squares Method)是一种数学优化方法,用于找到一组参数,使得观测数据与模型预测值之间的平方误差最小。

它通过对误差的平方和进行最小化来估计未知参数的值。

在最小二乘法中,我们假设存在一个线性模型来描述观测数据与未知参数之间的关系。

给定n个观测数据点(xi, yi),其中xi是自变量,yi是因变量,我们可以将线性模型表示为:yi = β0 + β1 * xi + εi其中β0和β1是待估计的未知参数,εi是服从正态分布的随机误差。

我们的目标是找到最佳拟合线,使得所有数据点到该线的距离之和最小。

2. 重要性最小二乘法在统计学和数据分析中具有广泛应用,并且具有以下重要性:2.1 参数估计通过最小二乘法可以估计出线性回归模型中的未知参数。

这些参数对于理解和解释观测数据与自变量之间关系非常重要。

例如,在经济学中,可以使用最小二乘法来估计供需曲线、收入弹性等经济模型中的参数。

2.2 模型拟合最小二乘法可以用于拟合数据,并找到最佳拟合线或曲线。

通过最小化误差平方和,我们可以找到与观测数据最接近的模型。

这对于预测和预测未来数据点非常有用。

2.3 假设检验在统计推断中,最小二乘法还可以用于假设检验。

我们可以利用最小二乘估计的参数进行假设检验,以确定自变量与因变量之间是否存在显著关系。

2.4 模型诊断除了参数估计和模型拟合外,最小二乘法还可以用于诊断模型的适应性和有效性。

通过分析残差(观测值与预测值之间的差异),我们可以检查模型是否满足所假设的条件,并进行必要的修正。

3. 应用最小二乘法广泛应用于各个领域,包括但不限于以下几个方面:3.1 线性回归分析线性回归是最常见的应用之一。

通过将观测数据与线性模型进行拟合,我们可以估计出自变量与因变量之间的关系。

线性回归可以用于预测、关联分析和因果推断等。

3.2 时间序列分析时间序列分析是对随时间变化的数据进行建模和预测的方法。

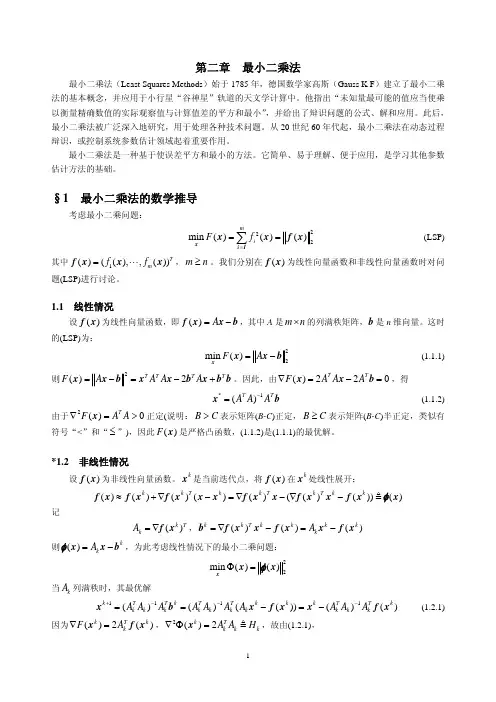

第二章 动态过程数学模型参数估计的最小二乘方法Least Squares§2—1静态线性模型参数的最小二乘估计(多元线性回归)一、什么是最小二乘估计例: y = ax + ε其中:y 、x 可测;ε — 不可测的干扰项;a —未知参数。

通过 N 次实验,得到测量数据 y k 和x k k = 1、2、3 …,确定未知参数 a 称“参数估计”。

使准则 J 为最小 :令:∂ J / ∂ a = 0 , 导出 a = ?称为“最小二乘估计”,即残差平方总和为最小的估计,Gauss 于 1792年提出。

min)(21=-=∑=k N k k ax y J 0)(21=--=∂∂∑=k k N k k x y x a J二、多元线性回归线性模型 y = a 0+ a 1x 1+ + a n x n + ε 式(2 - 1- 1)引入参数向量: θ = [ a 0,a 1, a n ]T (n+1)*1进行 N 次试验,得出N 个方程:y k = ϕk T θ + εk ; k=1、2…、N 式(2 -1- 2)其中:ϕk = [ 1,x 1,x 2, ,x N ] T (n+1) *1方程组可用矩阵表示为y = Φ θ + ε 式(2 -1- 3)其中:y = [ y 1,y 2, 。

,y N ]T (N *1) ε = [ ε1, ε2, 。

,ε N ]T (N *1) N *(n+1) 估计准则:有:⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎣⎡=⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=T N T T nN Nn n x x x x x x ϕϕϕφ....1...........1...121121211121)(θϕT k N k k y J -=∑=[]⎥⎥⎥⎦⎤⎢⎢⎢⎣⎡----=)(..)(*)(...)(1111θϕθϕθϕθϕT N N T T N N T y y y y J= (y — Φ θ)T ( y — Φ θ)(1*N) ( N *1) J = y T y + θT ΦT Φ θ -y T Φ θ - θT ΦT y= y T y + θT ΦT Φ θ - 2 θT ΦT y 式(2 -1- 4)假设:(ΦT Φ)(n+1)(n+1) 满秩,由 利用线性代数的以下两个矩阵对向量求偏导数的公式:A x A x T =∂∂)( 和 Ax xAx x T 2)(=∂∂ 有: y y T T T ΦΦ=∂∂θθ)( 和 θθθθΦΦ=∂ΦΦ∂T T T2)( 所以:y y y y J T T T T T T T ΦΦΦΦΦΦ22)2(-=-+∂∂=∂∂θθθθθθ 解出参数估计向量: θ Ls =(ΦT Φ)-1 ΦT y 式(2 -1- 5) 令:P = (ΦT Φ)-1 则参数估计向量 θ Ls = P ΦT y参数估计向量 θ Ls 被视为以下“正则方程”的解:(ΦT Φ)θ = ΦT y 式(2 -1- 6)注:为了便于区别, 我们用红体字符表示估计量或计算值,而用黑体表示为参数真值或实际测量值。

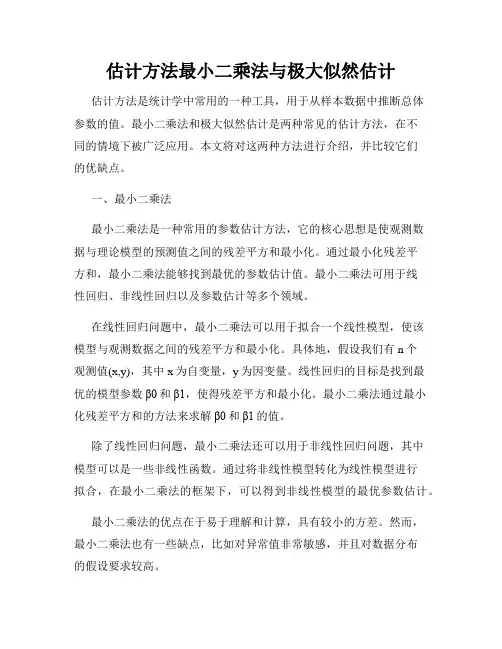

估计方法最小二乘法与极大似然估计估计方法是统计学中常用的一种工具,用于从样本数据中推断总体参数的值。

最小二乘法和极大似然估计是两种常见的估计方法,在不同的情境下被广泛应用。

本文将对这两种方法进行介绍,并比较它们的优缺点。

一、最小二乘法最小二乘法是一种常用的参数估计方法,它的核心思想是使观测数据与理论模型的预测值之间的残差平方和最小化。

通过最小化残差平方和,最小二乘法能够找到最优的参数估计值。

最小二乘法可用于线性回归、非线性回归以及参数估计等多个领域。

在线性回归问题中,最小二乘法可以用于拟合一个线性模型,使该模型与观测数据之间的残差平方和最小化。

具体地,假设我们有n个观测值(x,y),其中x为自变量,y为因变量。

线性回归的目标是找到最优的模型参数β0和β1,使得残差平方和最小化。

最小二乘法通过最小化残差平方和的方法来求解β0和β1的值。

除了线性回归问题,最小二乘法还可以用于非线性回归问题,其中模型可以是一些非线性函数。

通过将非线性模型转化为线性模型进行拟合,在最小二乘法的框架下,可以得到非线性模型的最优参数估计。

最小二乘法的优点在于易于理解和计算,具有较小的方差。

然而,最小二乘法也有一些缺点,比如对异常值非常敏感,并且对数据分布的假设要求较高。

二、极大似然估计极大似然估计是另一种常用的参数估计方法,它的核心思想是选择参数值,使得观测数据出现的概率最大化。

极大似然估计常用于统计模型的参数估计,可以用于概率分布参数的估计,以及对未知分布函数形式的参数估计。

假设我们有一组独立同分布的随机观测值x1, x2, ..., xn,我们希望通过这些观测值来对总体分布的参数进行估计。

极大似然估计的目标是选择最优的参数值,使得观测到这些数据的概率最大化。

以正态分布为例,假设我们观测到了一组随机变量x1, x2, ..., xn,我们希望通过这些观测值来估计正态分布的均值μ和方差σ^2。

使用极大似然估计,我们可以写出似然函数,然后通过最大化似然函数来求解最优的参数估计值。

用最小二乘法估计模型参数最小二乘法是一种参数估计方法,常用于拟合线性回归模型。

该方法通过最小化观测值与模型预测值之间的差异来确定模型的参数。

本文将详细介绍最小二乘法的原理、应用领域以及具体操作步骤,以期为读者提供有关该方法的生动、全面且有实际指导意义的文章。

一、最小二乘法原理最小二乘法最初由法国数学家勒让德于18世纪提出,其核心思想是选择能够最小化观测值与模型预测值之间残差的参数。

残差是观测值与模型预测值之间的差异,这些差异可用来评估模型的拟合程度。

最小二乘法的目标是找到使残差平方和最小化的参数,从而得到最佳拟合效果。

二、最小二乘法的应用领域最小二乘法广泛应用于各个领域,尤其是数理统计学、经济学、工程学和社会科学等领域。

在这些领域,研究人员经常需要通过观测数据来拟合数学模型,并利用最小二乘法来估计模型的参数。

例如,在经济学中,研究人员可以利用最小二乘法来估计市场需求曲线和供应曲线的参数,从而预测市场价格和销售量的变化。

三、最小二乘法的具体操作步骤1. 收集观测数据:首先,需要收集一组相关的观测数据,这些数据是建立数学模型的基础。

2. 选择模型:根据实际问题的需要,选择适当的数学模型来描述观测数据之间的关系。

常见的模型包括线性模型、多项式模型和指数模型等。

3. 确定目标函数:目标函数是最小二乘法的核心,其定义为观测值与模型预测值之间残差的平方和。

通过最小化目标函数,可以找到最佳拟合效果的参数。

4. 求解参数:利用数学方法,对目标函数进行求解,求得最小化目标函数的模型参数。

常用的求解方法包括求导、矩阵运算和数值优化算法等。

5. 模型评估:为了评估拟合效果,需要对模型进行验证。

常用的方法有计算残差平方和、拟合优度和假设检验等。

6. 参数解释和预测:最后,根据所得到的模型参数,解释模型的物理含义,并利用模型进行预测和推断。

通过上述步骤,我们可以利用最小二乘法对观测数据进行拟合,并估计模型的参数。

最小二乘法不仅在理论研究中有重要应用,而且在实际问题的解决中也扮演着重要的角色。

最小二乘估计原理最小二乘估计是一种常用的参数估计方法,它可以用来估计线性回归模型中的参数。

在实际应用中,最小二乘估计被广泛应用于数据拟合、信号处理、统计分析等领域。

本文将介绍最小二乘估计的原理及其应用。

最小二乘估计的原理是基于最小化观测值与模型预测值之间的误差平方和来进行参数估计。

在线性回归模型中,我们通常假设因变量Y与自变量X之间存在线性关系,即Y = β0 + β1X + ε,其中β0和β1是待估参数,ε是误差项。

最小二乘估计的目标是找到最优的β0和β1,使得观测值与模型预测值之间的误差平方和最小。

为了形式化地描述最小二乘估计的原理,我们可以定义损失函数为误差的平方和,即L(β0, β1) = Σ(Yi β0 β1Xi)²。

最小二乘估计的思想就是通过最小化损失函数来求解最优的参数估计值。

为了找到最小化损失函数的参数估计值,我们可以对损失函数分别对β0和β1求偏导数,并令偏导数等于0,从而得到最优的参数估计值。

在实际应用中,最小二乘估计可以通过求解正规方程来得到参数的闭式解,也可以通过梯度下降等迭代方法来进行数值优化。

无论采用何种方法,最小二乘估计都能够有效地估计出线性回归模型的参数,并且具有较好的数学性质和统计性质。

除了在线性回归模型中的应用,最小二乘估计还可以推广到非线性回归模型、广义线性模型等更加复杂的模型中。

在这些情况下,最小二乘估计仍然是一种有效的参数估计方法,并且可以通过一些变形来适应不同的模型结构和假设条件。

总之,最小二乘估计是一种重要的参数估计方法,它具有简单直观的原理和较好的数学性质,适用于各种统计模型的参数估计。

通过最小化观测值与模型预测值之间的误差平方和,最小二乘估计能够有效地估计出模型的参数,并且在实际应用中取得了广泛的成功。

希望本文对最小二乘估计的原理有所帮助,谢谢阅读!。

最小二乘法的基本步骤最小二乘法是一种常见的数据处理方法,主要用于寻找最优解。

在实际应用中,最小二乘法广泛应用于数据拟合、回归分析、参数估计等方面。

本文将介绍最小二乘法的基本步骤及其应用,以帮助读者更好地掌握该方法。

一、最小二乘法的基本原理最小二乘法是利用已知数据的信息,通过求解估计值和实际值之间的差的平方和的最小值,来寻找最优解的方法。

在这个过程中,我们通常需要确定一个或多个参数,使我们得到的拟合结果与实际值的误差最小。

这就是最小二乘法的基本原理。

二、最小二乘法的基本步骤最小二乘法包括以下的基本步骤:1. 确定模型首先,在最小二乘法中,我们需要确定需要拟合的模型的形式。

例如,在线性回归中,我们选择y = kx + b来描述因变量y和自变量x之间的关系,其中k和b就是需要估计的参数。

在确定估计模型后,我们就可以开始对数据进行拟合。

2. 确定误差函数在确定模型后,我们需要确定一个误差函数来衡量估计值与实际值之间的差异。

通常,误差函数可选择为平方误差函数,其计算公式为:E = Σ(yi - f(xi))^2(i=1,2,…,n)其中,yi为实际值,f(xi)为估计值,n为样本数。

3. 求解参数求解参数是最小二乘法的核心步骤。

在这一步中,我们需要通过最小化误差函数来求解参数。

对于线性回归问题,我们可以通过解析解或迭代优化方法求解。

在解析解法中,我们可以直接给出参数的求解公式,例如在二元线性回归中,参数的求解公式为:k = ((nΣxy) - (Σx)(Σy)) / ((nΣx^2) - (Σx)^2)b = (Σy - kΣx) / n其中,x和y分别为自变量和因变量的观测值,Σ表示求和符号,n为样本数。

4. 拟合数据在求解出参数后,我们可以通过估计模型得到拟合的结果,并将其与实际值进行比较。

如果误差较小,我们就可以认为模型的拟合结果是较为准确的。

三、最小二乘法的应用最小二乘法在实际应用中具有广泛的应用。

两阶段最小二乘的操作步骤

两阶段最小二乘(Two-Stage Least Squares,简称2SLS)是一种强大和高效的回

归分析计量方法,它能够最大限度地减少模型误差,帮助研究者更好地探索解释变量之间的关联关系。

2SLS的操作步骤如下:

首先,进行单变量分析,即对有关自变量的字段以多重线性回归的方式进行分析,以确定自变量和任何因变量的新结果变量的关系。

其次,重新估计自变量的样本分布,即基于单变量分析的结果,重新估计自变量的样本是如何组成的,以便更精确地检验它们之间的相互关系。

然后,利用多元回归模型估计因变量,即基于由自变量构成的新样本分布,利用多元回归方法估计解释变量和因变量之间的联系关系。

最后,基于估计模型,使用抽样分布函数进行模型检验,以确定模型的准确性和统计显著性。

从操作步骤上来说,2SLS既是一种回归方法,又是一种数据分析方法。

它充

分利用了单变量分析识别解释变量以及多元回归估计解释变量和因变量的有效关系,从而大大减少模型中的误差,产生非常精确的结果。

同时,还可以避免一些多重共线性的出现以及变量间的错误关联,以达到对有关变量之间代表性关系的最小干扰,从而研究者可以更有效地探究解释变量之间的关联关系。

综上所述,2SLS可以帮助研究人员进行最佳的解释分析,帮助他们更准确、

更牢靠地探测解释变量的影响机理,从而提升研究的质量。

最小二乘法基本原理最小二乘法是一种常见的数学拟合方法,它可以用来求解线性回归、非线性回归等问题。

在实际应用中,最小二乘法被广泛应用于数据拟合、参数估计等领域。

本文将介绍最小二乘法的基本原理,帮助读者更好地理解和应用这一方法。

首先,我们来看看最小二乘法的核心思想。

最小二乘法的目标是找到一条曲线或者一个函数,使得这条曲线或者函数与实际数据的残差平方和最小。

残差即实际观测值与拟合值之间的差距,残差平方和的最小化可以保证拟合效果更好。

在线性回归问题中,我们通常假设模型为y = β0 + β1x + ε,其中β0和β1为待估参数,ε为误差项。

我们的目标是找到最优的参数估计值β0和β1,使得模型的拟合效果最好。

最小二乘法通过最小化残差平方和来实现这一目标。

具体来说,对于给定的数据集{(x1, y1), (x2, y2), ..., (xn, yn)},我们可以通过最小二乘法求解出最优的参数估计值β0和β1。

首先,我们需要构建损失函数,通常选择残差平方和作为损失函数。

然后,通过对损失函数进行求导,可以得到最优参数的闭式解。

最终,我们就可以得到最优的参数估计值,从而得到最佳拟合曲线。

除了线性回归,最小二乘法还可以应用于非线性回归问题。

在非线性回归问题中,我们的模型可能是非线性的,例如y = β0 + β1x + β2x^2 + ε。

此时,我们可以借助最小二乘法来求解最优的参数估计值β0、β1和β2,从而得到最佳拟合曲线。

最小二乘法的优点在于它具有良好的数学性质和稳定的数值计算方法。

通过最小二乘法,我们可以得到最优的参数估计值,从而使得拟合效果更好。

此外,最小二乘法还可以通过统计检验来评估模型的拟合效果,从而帮助我们判断模型的可靠性。

总之,最小二乘法是一种常见且实用的数学拟合方法,它可以用来求解线性回归、非线性回归等问题。

通过最小二乘法,我们可以得到最优的参数估计值,从而使得拟合效果更好。

希望本文能够帮助读者更好地理解和应用最小二乘法,从而在实际问题中取得更好的效果。

最小二乘法的原理最小二乘法是一种常用的参数估计方法,它在统计学和数学建模中有着广泛的应用。

其原理简单清晰,易于理解和实现,因此受到了广泛的关注和应用。

在介绍最小二乘法的原理之前,我们先来了解一下最小二乘法的应用背景。

最小二乘法通常用于拟合一个数学模型与观测数据,其目标是寻找到一个最优的参数组合,使得模型预测值与观测值之间的误差平方和最小。

这种方法在数据分析、回归分析、信号处理、图像处理等领域都有着重要的应用。

最小二乘法的原理可以从几何和代数两个角度来解释。

从几何角度来看,最小二乘法就是寻找一个直线(或者曲线),使得观测数据点到这条直线(曲线)的距离之和最小。

从代数角度来看,最小二乘法是通过最小化残差平方和来确定参数的估计值。

在最小二乘法中,我们通常会遇到一个经典的问题,即拟合直线的问题。

假设我们有一组观测数据点{(x1, y1), (x2, y2), …, (xn, yn)},我们希望找到一条直线y = ax + b,使得观测数据点到直线的距离之和最小。

这时,我们可以利用最小二乘法来求解出直线的参数a和b。

具体而言,我们可以通过最小化残差平方和来确定参数a和b 的估计值。

残差指的是观测数据点到拟合直线的垂直距离,残差平方和就是所有观测数据点到拟合直线的距离的平方之和。

最小二乘法的思想就是找到一组参数a和b,使得残差平方和达到最小值。

最小二乘法的原理可以用数学公式来描述。

对于拟合直线的问题,我们可以定义残差ei为第i个观测数据点到拟合直线的垂直距离,即ei = yi (axi + b),其中(xi, yi)为第i个观测数据点的坐标。

那么残差平方和可以表示为S = Σ(ei^2),i从1到n。

我们的目标就是找到一组参数a和b,使得S达到最小值。

为了求解参数a和b的估计值,我们可以对S分别对a和b求偏导数,并令偏导数等于0,得到参数a和b的估计值。

具体的求解过程可以通过代数方法或者矩阵方法来实现。

通过最小二乘法求解出的参数估计值,就是拟合直线的斜率和截距。

参数最小二乘估计原理最小二乘估计是一种常用的参数估计方法,它基于最小化误差的平方和来确定最优的参数估计值。

在最小二乘估计中,我们从一组观测数据中选择一个数学模型,并通过调整模型的参数来使预测值与观测值的误差最小化。

换句话说,我们希望通过最小二乘估计找到一组参数,使得模型预测的值和观测值之间的差异最小。

具体而言,假设我们有n个观测数据,表示为(x1, y1), (x2,y2), ..., (xn, yn)。

我们选择一个函数形式,例如线性函数y =mx + b,并希望通过调整参数m和b来最小化误差的平方和。

对于每个观测数据点(xi, yi),我们可以计算出预测值yi',即根据当前参数估计值得到的模型的预测值。

然后,我们就可以计算出每个观测数据点的误差ei = yi - yi'。

最小二乘估计的目标是将所有数据点的误差的平方和最小化,即最小化误差的平方和函数:f(m, b) = e1^2 + e2^2 + ... + en^2为了最小化这个函数,我们需要找到使得f(m, b)取得最小值的参数m和b。

一种常见的方法是采用微积分的方法,通过对f(m, b)进行求导,并令导数为0来求解最小值点。

通过求解最小值点的方程,我们可以得到最小二乘估计的参数估计值m和b。

这样,我们就得到了一个最佳拟合的模型,可以用来预测和解释观测数据。

最小二乘估计方法广泛应用于各个领域,例如统计学、经济学、工程学等。

它的优点是计算简单、具有良好的数学性质,并且在许多实际问题中得到了有效的应用。

然而,需要注意的是,最小二乘估计方法对异常值比较敏感,因此在应用时需要注意数据的质量和有效性。

面板数据动态最小二乘法概述说明以及解释1. 引言1.1 概述面板数据是指在一段时间内观察多个单位(如个人、企业或国家等)的数据集合。

在经济学、金融学以及其他社会科学领域,研究面板数据已成为常见的方法之一。

通过对面板数据进行分析,我们能够更全面地了解各个单位间的关系以及随时间的变化趋势。

动态最小二乘法是一种应用于面板数据分析中的重要方法。

它通过引入滞后变量和差分操作,考虑了时间序列和横截面维度上的相关性,从而更准确地估计模型参数,提高了分析结果的可靠性。

1.2 文章结构本文将首先介绍面板数据的概念、特点,以及其在不同领域中的应用。

然后详细阐述动态最小二乘法的基本原理,并与静态最小二乘法进行比较。

接着,将通过实际应用案例来展示动态最小二乘法在面板数据分析中的有效性和优越性。

在第4部分中,我们将解释实施动态最小二乘法所需进行的数据准备和处理步骤,并说明模型设定和参数估计方法的具体过程。

最后,我们将介绍解读结果和进行统计显著性检验的方法。

最后,在结论与展望部分中,将总结归纳面板数据动态最小二乘法的优势和应用情况,并提出未来研究方向和存在问题的建议。

1.3 目的本文旨在全面介绍面板数据与动态最小二乘法,并深入探讨其在面板数据分析中的应用。

通过阅读本文,读者将了解到面板数据概述、动态最小二乘法原理以及实施步骤。

同时,本文也旨在为相关领域的研究者提供参考和指导,帮助他们更好地利用这一方法进行实证研究。

2. 面板数据概述:2.1 面板数据的定义和特点:面板数据,又称为纵向数据或追踪数据,是一种经济学和社会科学中常用的研究方法。

它由多个单位或个体在不同时间点上观察到的多变量数据组成。

面板数据具有两个基本维度:单位维度和时间维度。

在面板数据中,单位可以是人、国家、公司等,在这些单位内部我们会记录多个变量的取值;时间维度表示观察被记录的时间周期,可以是年度、季度、月份等。

与截面数据(横断面)只有一个时期观测值不同,面板数据有两个及以上时期观测值。

最小二乘法的原理及证明最小二乘法是一种常用的数据拟合方法,它的本质是通过寻找最小化残差平方和的参数组合进行数据拟合。

在现实生活中,很多实际问题都可以通过最小二乘法来求解,如线性回归、曲线拟合、方程求解等。

本文将介绍最小二乘法的原理及证明。

一、最小二乘法的原理最小二乘法是一种基于误差最小化的思想进行模型参数求解的方法。

对于含有n个数据点的模型,其最小二乘法的表示形式为:$min[\sum_{i=1}^n(y_i-f(x_i))^2]$其中,$y_i$为第i个数据点的观测值,$f(x_i)$为模型在$x_i$处的预测值。

最小二乘法的目的是寻找一个最优的模型参数集合,使得预测值与观测值之间的误差平方和最小。

以线性回归为例,线性回归模型的基本形式为:$y=\beta_0+\beta_1x+\epsilon$其中,$\beta_0$和$\beta_1$为线性回归的系数,$\epsilon$为误差项。

通过最小二乘法,我们需要求解$\beta_0$和$\beta_1$,使得预测值与真实值之间的残差平方和最小。

在实际应用中,最小二乘法可以通过求解模型参数的偏导数,进而得到参数的估计值。

同时,最小二乘法还可以通过矩阵运算的形式进行求解,这种方法称为矩阵最小二乘法。

二、最小二乘法的证明最小二乘法的原理可以通过数学证明来得到。

在数学推导中,我们需要利用概率论和统计学的相关知识。

1、最小二乘法的基本假设首先,我们需要对最小二乘法做出一些假设。

最小二乘法的假设包括:(1)数据点满足线性关系;(2)误差项满足高斯分布;(3)误差项具有同方差性;(4)误差项之间相互独立。

在这些假设的基础上,我们可以得出以$X$为自变量,$Y$为因变量的线性模型:$Y=\beta_0+\beta_1X+\epsilon$其中,$\beta_0$和$\beta_1$为线性模型的系数,$\epsilon$为误差项。

我们需要利用概率论和统计学的方法,通过参数的似然函数来求解模型的系数。

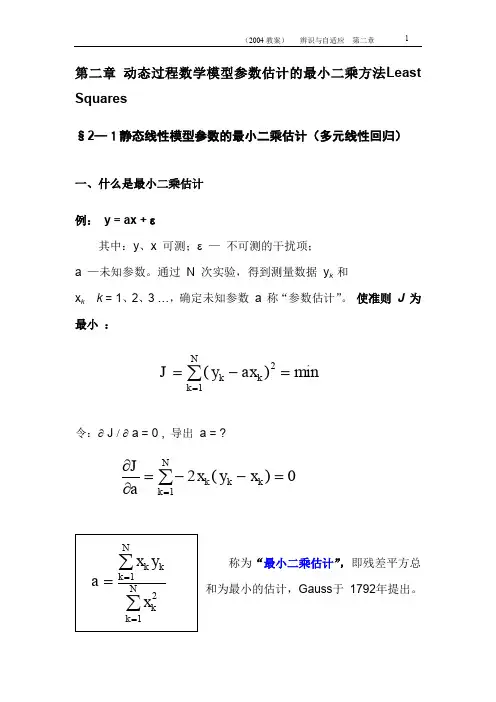

第二章 参数估计的最小二乘方法Least Squares§2—1静态线性模型参数的最小二乘估计(多元线性回归)一、 什么是最小二乘估计系统辨识三要素:模型,数据,准则。

例: y = ax + ε其中:y 、x 可测;ε — 不可测的干扰项;a —未知参数。

通过 N 次实验,得到测量数据 y k 和x k k = 1、2、3 …,确定未知参数 a 称“参数估计”。

使准则 J 为最小 :令:∂ J / ∂ a = 0 , 导出 a = ?称为“最小二乘估计”,即残差平方总和为最小的估计,Gauss 于 1792年提出。

min)(21=-=∑=k N k k ax y J 0)(21=--=∂∂∑=k k N k k ax y x a J二、多元线性回归线性模型 y = a 0+ a 1x 1+ + a n x n + ε 式(2 - 1- 1)引入参数向量: θ = [ a 0,a 1, a n ]T (n+1)*1进行 N 次试验,得出N 个方程:y k = ϕk T θ + εk ; k=1、2…、N 式(2 -1- 2)其中:ϕk = [ 1,x 1,x 2, ,x N ] T (n+1) *1方程组可用矩阵表示为y = Φ θ + ε 式(2 -1- 3)其中:y = [ y 1,y 2, 。

,y N ]T (N *1) ε = [ ε1, ε2, 。

,ε N ]T (N *1) N *(n+1) 估计准则有:= (y — Φ θ)T ( y — Φ θ)(1*N) ( N *1)⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎣⎡=⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=T N T T nN N n n x x x x x x ϕϕϕφ....1...........1...121121211121)(θϕT k N k k y J -=∑=[]⎥⎥⎥⎦⎤⎢⎢⎢⎣⎡----=)(..)(*)(...)(1111θϕθϕθϕθϕT N N T T N N T y y y y JJ = y T y + θT ΦT Φ θ -y T Φ θ - θT ΦT y= y T y + θT ΦT Φ θ - 2 θT ΦT y 式(2 -1- 4)假设:(ΦT Φ)(n+1)(n+1) 满秩,由 利用线性代数的以下两个矩阵对向量求偏导数的公式:A x A x T =∂∂)( 和 Ax xAx x T 2)(=∂∂(必须A 为对称阵) 由ΦΦT 为对称阵 有: y y T T T ΦΦ=∂∂θθ)( 和 θθθθΦΦ=∂ΦΦ∂T T T2)( 所以:y y y y J T T T T T T T ΦΦΦΦΦΦ22)2(-=-+∂∂=∂∂θθθθθθ 令上式等于零,解出参数估计向量:θ Ls =(ΦT Φ)-1 ΦT y 式(2 -1- 5)令:P = (ΦT Φ)-1 则参数估计向量 θ Ls = P ΦT y参数估计向量 θ Ls 被视为以下“正则方程”的解:(ΦT Φ)θ = ΦT y 式(2 -1- 6)注:为了便于区别, 我们用红体字符表示估计量或计算值,而用黑体表示为参数真值或实际测量值。

又 02)22()(22>ΦΦ=Φ-ΦΦ∂∂=∂∂T T T y J θθθθ 所以θ Ls 使J 为最小。

0=∂∂θJ三、关于参数最小二乘估计θLs性质的讨论以上求解参数最小二乘估计θLs时并为对{ εk }的统计特性做任何规定,这是最小二乘估计的优点。

当{ εk }为平稳零均值白噪声时,则θLs有如下良好的估计性质:a) 参数最小二乘估计θLs是y的线性估计θLs= PΦT y 是y 的线性表出;b) 参数最小二乘估计θLs是无偏估计,即E θLs= θ(参数真值)[ 证明]:E θLs= E[ PΦT y ]= PΦT E( y ) = PΦT E ( Φθ + ε ) =PΦTΦθ + E( ε ) = θ + 0 = θc) 最小二乘估计θLs 的估计误差协方差阵是σ2P (n+1)(n+1)即:E [ ( θLs- θ ) (θLs-θ )T ] = σ2P[ 证明]:E [ ( θLs- θ ) (θLs - θ )T ] = E [ PΦT ( y -Φθ) ( y-Φθ)TΦP] = E [ PΦT εεT ΦP ] = PΦT E ( εεT) ΦP =PΦTσ2 I N*NΦP = PΦTΦσ2P=σ2Pd) 若{ εk }为正态分布零均值白噪声时,则θLs是线性无偏最小方差估计(证明从略)。

如若{ εk }是有色噪声,则θLs不具有上述性质,即为有偏估计。

四、最小二乘估计θLs的几何意义和计算问题1. 最小二乘估计的几何意义最小二乘估计的模型输出值为y k= ϕk T θLs k = 1,2,…N输出实际测量值与模型输出值之差叫残差:εk = y k –y k模型输出向量为y = ΦθLs ,而残差向量为:ε= y –y= y–ΦθLsΦT ε= ΦT y –ΦTΦ(ΦTΦ)-1 ΦT y=ΦT y –ΦT y= 0即残差向量ε与由测量数据矩阵Φ的各个向量:Φ1, Φ2 ,…, Φ张成的超平面(估计空间)正交,而最小二乘模型输出向量y 为N实际输出向量y 在估计空间上的正交投影,这就是最小二乘估计的几何意义。

最小二乘估计的几何意义2. 关于最小二乘估计计算中的病态问题估计参数向量θLs一般是求解正则方程:(ΦTΦ)θ = ΦT y 式(2 -1- 6)得出。

可以利用消元法等一系列求解多元线性一次方程组的方法,计算得出,其有解的条件是(ΦTΦ)=P –1 矩阵非奇异(行列式数值大于零)。

但有时在求解式(2 -1- 6)方程组是会出现矩阵接近于奇异(行列式数值接近于零),即所谓“病态”的情况。

由此导致参数估计的结果不稳定,不可信。

出现上述情况的原因可能是由于①被辨识的过程受到的外加激励不够;②采样间隔太密;③A/D转换的位数太短,计算舍入误差累计所致。

为解决最小二乘计算中可能出现的病态问题,提出了不少改进算法,例如:Householder变换法、改进的平方根法和U—D分解算法。

后者是Bierman 1977提出的改善P阵计算性质(对称性、正定性和稳定性)而又不增加计算量的算法。

正定P阵可以分解成一个上三角阵U(其对角线元素都为1)和一个对角阵DP = U D U T由此可解决最小二乘计算中可能出现的病态问题,具体可参阅关于《计算方法》的文献。

总之,我们在使用最小二乘的辨识方法时,应该注意避免出现和克服病态问题。

应用举例在建立生产过程的静态模型时,特别是在机理不清之时常用多元线性回归方法,例如:水泥凝固放热量与水泥成分的关系模型y = a0+ a1x1+ a2x2+ a3x3+ a4x 4 +y 水泥凝固时的放热量(卡/克); x1 ~ x1 水泥的几种成分。

五、非线性最小二乘法(Nonlinear Least Square)以“误差平方总和为最小”的估计准则,估计非线性模型参数的方法。

假设非线性静态系统模型为y = f ( x, θ )+ ε非线性模型 f 的形式是已知的,参数 θ 未知。

经过N 次实验,取得N 组数据(x 1, y 1) (x N , y N )。

准则:需要用优化算法求解,常用的算法有两类——搜索法和迭代法。

前者如单纯型法;后者如梯度法、高斯法、牛顿—拉夫森法、变尺度法等等。

该类方法也还可应用于动态模型和时间连续模型的参数估计。

单纯型法是先给出参数空间的几个猜想点,构成正多面体,计算各点的目标函数值,比较各值后舍去最差的点,按照反射、开拓、收缩等步骤确定新的估计点,直到预定的精度要求后停止搜索。

迭代法是先猜想一个估计的初值,确定一个向量为可接受的方向和步长,进行迭代计算 θk+1 –θ k =μ•v … 。

具体内容可阅有关计算方法的参考书籍。

近年来发展出一系列基于生物进化论的优化新算法,如遗传算法(Genetic Algorithms )(基于改进遗传算法的系统辨识方法. 北方工业大学学报. 第10卷, 第1期,P62-67.)和免疫算法(Immune Algorithms),使得优化算法的性能得到了很大的改善。

∑=-=N k k k x f y J 12)]([θ,§2—2 动态过程参数估计的线性最小二乘法一、模型类:考虑CAR 模型式(2 -2- 1)其中{ y(k) }和{ u(k) }为可测的输出和输入,{ ε(k) }为不可测的随机干扰。

上式还可表示成:A(z -1)y(k)= B(z -1)u(k)+ ε(k) 式(2 -2- 2) 其中:A(z -1) = 1+ a 1z - 1+ a 2z - 2+ 。

+a n z - nB(z -1) = b 1z - 1+ b 2z - 2+ +b n z - n 还可表示为式(2 -2- 3) 其中:当进行了 k = 1-n ,2-n ,..,0,1,2,…,N 共计(N+n )次采样,得到N 个方程:)()(k k y T kεθϕ+=)](),...,1(),(),...,1([],...,,,,....,,[2121n k u k u n k y k y b b b a a a T kn n T k ------==ϕθ∑∑==+-=-+n i n i i i k i k u b i k y a k y 11)()()()(εy(1)= -a 1y(0) -… -a n y(1-n)+b 1u(0)+ … +b n u(1-n)+ ε(1)y(2)= -a 1y(1) -… -a n y(2-n)+b 1u(1)+ … +b n u(2-n)+ ε(2)………………………………………………y(N)=-a 1y(N-1)-…-a n y(N -n)+b 1u(N-1)+…+b n u(N-n)+ε(N)用矩阵表示成y N = ΦN θ + ε N 式(2 -2- 4) 其中:y N = [ y(1), y(2), … , y(N) ]Tε N = [ ε (1), ε (2), … , ε (N) ] T二、 参数最小二乘估计 θ Ls 的导出估计准则为式(2 -2- 5)由 解出: ⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡--------------=)(...)1(.........)2(...)1()1(...)0(,)(..)1(......,)2(..)1(,)1(..)0(n N u N u n u u n u u n N y N y n y y n y y N φ0=∂∂θJ∑=-=N k T k k y J 12])([θϕθ N =(Φ N T Φ N )-1 Φ N T y N 式(2 -2- 6) 上式可视为以下正则方程的解(Φ N T Φ N )θ N = Φ N T y N 式(2 -2- 7)称为最小二乘的“一次完成算法”,是离线算法,有解的条件是(Φ N T Φ N )2n *2n 满秩。