最小二乘法的解释

- 格式:ppt

- 大小:215.50 KB

- 文档页数:15

最小二乘法知识最小二乘法是一种最优化方法,经常用于拟合数据和解决回归问题。

它的目标是通过调整模型参数,使得模型的预测值与观测值之间的差异最小。

最小二乘法的核心思想是最小化误差的平方和。

对于给定的数据集,假设有一个线性模型y = β₀ + β₁x₁ + β₂x₂ + ... +βₙxₙ,其中β₀, β₁, β₂, ... , βₙ 是需要求解的未知参数,x₁, x₂, ... , xₙ 是自变量,y 是因变量。

那么对于每个样本点 (xᵢ, yᵢ),可以计算其预测值ŷᵢ = β₀ + β₁x₁ + β₂x₂ + ... + βₙxₙ,然后计算预测值与实际值之间的差异 eᵢ = yᵢ - ŷᵢ。

最小二乘法的目标是使得误差的平方和最小化,即最小化目标函数 E = ∑(yᵢ - ŷᵢ)²。

对于简单的线性回归问题,即只有一个自变量的情况下,最小二乘法可以通过解析方法求解参数的闭合解。

我们可以通过求偏导数,令目标函数对参数的偏导数等于零,求解出参数的最优解。

然而,对于复杂的非线性回归问题,解析方法通常不可行。

在实际应用中,最小二乘法通常使用迭代方法进行求解。

一种常用的迭代方法是梯度下降法。

梯度下降法通过反复进行参数更新的方式逐步降低目标函数的值,直到收敛到最优解。

具体而言,梯度下降法首先随机初始化参数的值,然后计算目标函数对于每个参数的偏导数,根据偏导数的方向更新参数的值。

迭代更新的过程可以通过下式表示:βₙ = βₙ - α(∂E/∂βₙ)其中,α 是学习率参数,控制每次更新参数的步长。

学习率需要适当选择,过小会导致收敛过慢,过大会导致震荡甚至不收敛。

最小二乘法除了可以用于线性回归问题,还可以用于其他类型的回归问题,比如多项式回归。

在多项式回归中,我们可以通过增加高次项来拟合非线性关系。

同样地,最小二乘法可以通过调整多项式的系数来使得拟合曲线与实际数据更加接近。

除了回归问题,最小二乘法还可以应用于其他领域,比如数据压缩、信号处理和统计建模等。

最小二乘复原方法最小二乘复原方法是一种常见的数据处理技术,广泛应用于信号处理、图像处理、计量经济学等领域。

它的原理是通过最小化误差平方和来估计未知参数,从而得到对原始数据的最优拟合结果。

本文将从最小二乘法的基本原理、应用领域、实施步骤等方面详细介绍最小二乘复原方法。

一、最小二乘法的基本原理最小二乘法的基本原理是通过最小化误差平方和来求解未知参数。

它的核心思想是将观测数据和理论模型进行比较,通过调整模型的参数使得模型与观测数据的差距最小化。

具体而言,对于线性模型,最小二乘法可以表示为以下形式:Y=Xβ+ε其中,Y代表观测数据向量,X代表设计矩阵,β表示待估计的未知参数向量,ε表示误差项,通常假设为满足正态分布的随机变量。

最小二乘法的目标是求解使误差平方和最小的未知参数估计值。

二、最小二乘法的应用领域最小二乘法具有广泛的应用领域,以下列举几个常见的应用场景:1.信号处理:在信号处理领域,最小二乘法常用于信号的滤波、降噪和频谱分析等问题。

通过最小二乘法,可以优化滤波器的参数,提高信号处理的效果。

2.图像处理:在图像处理中,最小二乘法常用于图像重建、去噪和图像恢复等问题。

通过最小二乘法,可以从观测到的图像数据中恢复出原始图像的最佳估计。

3.计量经济学:在计量经济学中,最小二乘法是一种常见的参数估计方法。

通过最小二乘估计,可以从经验数据中得到对经济模型参数的最优估计。

4.地质学与地球物理学:在地质学与地球物理学研究中,最小二乘法常用于地震波形分析、重力异常的计算和地磁场建模等问题。

通过最小二乘法,可以提取出地下结构中的有用信息。

三、最小二乘法的实施步骤最小二乘法的实施步骤可以概括为以下几个部分:1.构建观测模型:首先需要根据实际问题构建观测模型,即确定观测数据向量Y和设计矩阵X。

观测数据可以是实验测量得到的数据,设计矩阵反映了未知参数和观测数据之间的关系。

2.求解未知参数:根据观测模型,构建目标函数,即误差平方和。

用最小二乘法估计模型参数最小二乘法是一种参数估计方法,常用于拟合线性回归模型。

该方法通过最小化观测值与模型预测值之间的差异来确定模型的参数。

本文将详细介绍最小二乘法的原理、应用领域以及具体操作步骤,以期为读者提供有关该方法的生动、全面且有实际指导意义的文章。

一、最小二乘法原理最小二乘法最初由法国数学家勒让德于18世纪提出,其核心思想是选择能够最小化观测值与模型预测值之间残差的参数。

残差是观测值与模型预测值之间的差异,这些差异可用来评估模型的拟合程度。

最小二乘法的目标是找到使残差平方和最小化的参数,从而得到最佳拟合效果。

二、最小二乘法的应用领域最小二乘法广泛应用于各个领域,尤其是数理统计学、经济学、工程学和社会科学等领域。

在这些领域,研究人员经常需要通过观测数据来拟合数学模型,并利用最小二乘法来估计模型的参数。

例如,在经济学中,研究人员可以利用最小二乘法来估计市场需求曲线和供应曲线的参数,从而预测市场价格和销售量的变化。

三、最小二乘法的具体操作步骤1. 收集观测数据:首先,需要收集一组相关的观测数据,这些数据是建立数学模型的基础。

2. 选择模型:根据实际问题的需要,选择适当的数学模型来描述观测数据之间的关系。

常见的模型包括线性模型、多项式模型和指数模型等。

3. 确定目标函数:目标函数是最小二乘法的核心,其定义为观测值与模型预测值之间残差的平方和。

通过最小化目标函数,可以找到最佳拟合效果的参数。

4. 求解参数:利用数学方法,对目标函数进行求解,求得最小化目标函数的模型参数。

常用的求解方法包括求导、矩阵运算和数值优化算法等。

5. 模型评估:为了评估拟合效果,需要对模型进行验证。

常用的方法有计算残差平方和、拟合优度和假设检验等。

6. 参数解释和预测:最后,根据所得到的模型参数,解释模型的物理含义,并利用模型进行预测和推断。

通过上述步骤,我们可以利用最小二乘法对观测数据进行拟合,并估计模型的参数。

最小二乘法不仅在理论研究中有重要应用,而且在实际问题的解决中也扮演着重要的角色。

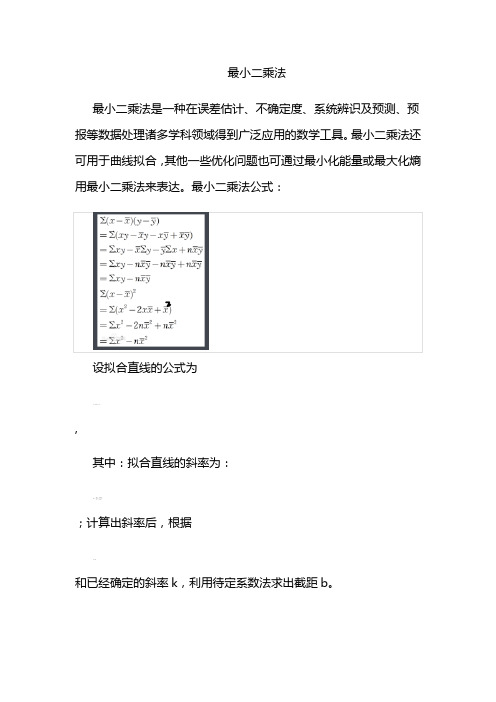

最小二乘法最小二乘法是一种在误差估计、不确定度、系统辨识及预测、预报等数据处理诸多学科领域得到广泛应用的数学工具。

最小二乘法还可用于曲线拟合,其他一些优化问题也可通过最小化能量或最大化熵用最小二乘法来表达。

最小二乘法公式:设拟合直线的公式为,其中:拟合直线的斜率为:;计算出斜率后,根据和已经确定的斜率k,利用待定系数法求出截距b。

在我们研究两个变量(x, y)之间的相互关系时,通常可以得到一系列成对的数据(x1, y1),(x2, y2).. (xm , ym);将这些数据描绘在x -y 直角坐标系中(如图1), 若发现这些点在一条直线附近,可以令这条直线方程如(式1-1)。

Y计= a0 + a1 X (式1-1)其中:a0、a1 是任意实数为建立这直线方程就要确定a0和a1,应用《最小二乘法原理》,将实测值Yi与利用(式1-1)计算值(Y计=a0+a1X)的离差(Yi-Y计)的平方和〔∑(Yi - Y计)²〕最小为“优化判据”。

令: φ= ∑(Yi - Y计)² (式1-2)把(式1-1)代入(式1-2)中得:φ= ∑(Yi - a0 - a1 Xi)2 (式1-3)当∑(Yi-Y计)²最小时,可用函数φ对a0、a1求偏导数,令这两个偏导数等于零。

(式1-4)(式1-5)亦即m a0 + (∑Xi ) a1 = ∑Yi (式1-6)(∑Xi ) a0 + (∑Xi2 ) a1 = ∑(Xi, Yi) (式1-7)得到的两个关于a0、a1为未知数的两个方程组,解这两个方程组得出:a0 = (∑Yi) / m - a1(∑Xi) / m (式1-8)a1 = [∑Xi Yi - (∑Xi ∑Yi)/ m] / [∑Xi2 - (∑Xi)2 / m)] (式1-9) 这时把a0、a1代入(式1-1)中, 此时的(式1-1)就是我们回归的元线性方程即:数学模型。

普通最小二乘法名词解释

普通最小二乘法 (Ordinary Least Squares, OLS) 是一种用于

数据拟合的统计方法。

它的思想是找到一组参数,使得拟合曲线与每个观测点的距离最小。

普通最小二乘法的假设是,拟合曲线是一个正态分布,其中观测点误差都服从正态分布的假设。

在应用普通最小二乘法之前,需要检验数据是否符合正态分布的假设。

普通最小二乘法假设每个观测点的误差是独立的,拟合曲线的误差是准确的。

普通最小二乘法的优点是它可以得到最佳的拟合结果,它的结果准确而可靠。

普通最小二乘法的缺点是它不能应付非正态分布的情况,也不能处理多重共线性的情况,这些都会降低拟合曲线的精确度。

最小二乘法名词解释

最小二乘法:最小二乘法(Least Squares Method)是一种数学优化方法,它可以解决线性回归和最优化问题。

它的主要思想是针对模型参数和模型函数值之间的误差平方和最小化。

也就是说,最小二乘法的目标是找到使得模型参数和模型函数值之间误差的平方和最小的一组参数,从而使得模型更加合理和有效。

最小二乘法一般用于估计因变量与自变量之间的线性关系,最小二乘法也可以用于非线性拟合,在此情况下,非线性拟合可以被转换成线性问题。

- 1 -。

最小二乘法基本原理最小二乘法是一种常用的参数估计方法,它的基本原理是通过最小化观测数据的残差平方和来确定模型的参数。

在实际应用中,最小二乘法被广泛应用于回归分析、曲线拟合、信号处理等领域。

本文将介绍最小二乘法的基本原理,以及其在实际问题中的应用。

首先,我们来看最小二乘法的基本原理。

假设我们有一组观测数据$(x_1, y_1), (x_2, y_2), ..., (x_n, y_n)$,我们希望找到一个模型来描述这些数据。

通常情况下,我们会假设模型具有如下形式:$$y = f(x; \theta) + \varepsilon$$。

其中,$f(x; \theta)$是关于参数$\theta$的函数,$\varepsilon$是误差。

我们的目标是通过调整参数$\theta$的取值,使得模型预测值$f(x; \theta)$与观测值$y$之间的残差平方和最小化。

换句话说,我们希望找到最优的参数$\theta$,使得残差平方和$S(\theta)$达到最小值:$$\min_{\theta} S(\theta) = \sum_{i=1}^{n} (y_i f(x_i; \theta))^2$$。

这就是最小二乘法的基本原理,通过最小化残差平方和来确定模型的参数。

在实际应用中,我们通常会选择一些常见的函数形式作为$f(x; \theta)$,比如线性函数、多项式函数、指数函数等,并利用最小二乘法来估计参数$\theta$的取值。

接下来,我们来看最小二乘法在回归分析中的应用。

回归分析是统计学中的一种重要方法,用于研究自变量和因变量之间的关系。

最小二乘法可以用来拟合回归模型,并估计模型的参数。

例如,考虑简单线性回归模型$y = \beta_0 + \beta_1x + \varepsilon$,我们可以利用最小二乘法来估计参数$\beta_0$和$\beta_1$的取值,从而找到最佳拟合直线。

此外,最小二乘法还可以用于曲线拟合。

线性方程组的最小二乘解在数学中,线性方程组是一个或多个线性方程的集合。

解决线性方程组的问题在科学和工程领域中具有广泛的应用。

然而,在现实世界的许多情况下,由于数据存在误差或方程组不完全满足,我们无法找到一个精确的解。

因此,在这种情况下,我们借助最小二乘法来寻找一个近似解。

最小二乘法是一种通过最小化误差平方和来估计未知参数的统计方法。

它的基本思想是将线性方程组的解转化为一个优化问题,使误差最小化。

这样做的原因是测量误差在实际问题中是不可避免的,而最小二乘法能够有效地减小误差对解的影响。

现在,我们考虑一个具体的线性方程组:\[Ax = b\]其中A是一个m×n的矩阵,x是一个n×1的向量,b是一个m×1的向量。

通常情况下,该方程组无法找到一个完全满足的解。

我们将通过最小二乘法来确定一个最接近的解。

为了得到最小二乘解,我们需要定义一个误差函数,即残差:\[r = Ax - b\]我们的目标是使残差的范数最小化。

这里我们选择残差的欧几里得范数:\[||r||_2 = \sqrt{r^Tr}\]最小二乘解x可以通过求解下面的优化问题得到:\[x_{LS} = \arg\min_x ||Ax - b||_2^2\]为了求解上述优化问题,我们可以使用求导的方法。

令误差函数对x的导数为零,可以得到如下的正规方程:\[A^TAx = A^Tb\]解这个正规方程可以得到最小二乘解x的闭式表达式。

然而,这种方法在矩阵A的条件数较高时可能会导致数值不稳定的结果。

为了解决这个问题,我们可以使用QR分解方法。

QR分解是一种将矩阵分解为正交矩阵Q和上三角矩阵R的方法。

通过QR分解,我们可以将正规方程重新表示为:\[Rx = Q^Tb\]然后,通过反向代入法,可以求解最小二乘解x。

除了使用QR分解法,其他方法,如SVD分解、正交投影等,也可以用于求解线性方程组的最小二乘解。

最后,应该注意的是,最小二乘解不一定是唯一的。

最小二乘法(也称为最小二乘法)是一种数学优化技术。

它通过最小化误差平方和来找到数据的最佳函数匹配。

使用最小二乘法,可以容易地获得未知数据,并且可以最小化这些获得的数据与实际数据之间的误差平方和。

最小二乘法也可以用于曲线拟合。

其他优化问题也可以通过最小二乘法通过最小化能量或最大化熵来表达。

801年,意大利天文学家Giuseppe Piazi发现了第一颗小行星谷神星。

经过40天的跟踪观察,皮亚齐失去了谷神星的位置,因为谷神星移到了太阳后面。

此后,全世界的科学家开始使用Piazi的观测数据来搜索Ceres,但是根据大多数人的计算结果,搜索Ceres并没有结果。

高斯,然后24,也计算了谷神星的轨道。

奥地利天文学家海因里希·阿尔伯斯(Heinrich Albers)根据高斯计算出的轨道重新发现了谷神星。

高斯使用的最小二乘方法发表于1809年的《天体运动理论》一书中。

法国科学家让·德(Jean de)于1806年独立发明了“最小二乘法”,但它尚不为人所知,因为它是全世界所不知道的。

勒让德(Legendre)与高斯(Gauss)有争议,他是谁首先提出了最小二乘法原理。

1829年,高斯证明最小二乘法的优化效果优于其他方法,因此被称为高斯-马尔可夫定理。

最小二乘法由最简单的一维线性模型解释。

什么是线性模型?在监督学习中,如果预测变量是离散的,则称其为分类(例如决策树,支持向量机等),如果预测变量是连续的,则称其为Return。

在收益分析中,如果仅包含一个自变量和一个因变量,并且它们之间的关系可以近似地由一条直线表示,则该收益分析称为一维线性收益分析。

如果收益分析包括两个或多个自变量,并且因变量和自变量之间存在线性关系,则称为多元线性收益分析。

对于二维空间,线性是一条直线;对于三维空间线性度是一个平面,对于多维空间线性度是一个超平面。