最小二乘法原理的几何解释

- 格式:pdf

- 大小:542.55 KB

- 文档页数:7

最小二乘法定义最小二乘法(Least Squares Method,简称LS)是指在数学中一种最常见的数据拟合方法,它是一种统计学意义上的估计方法,用来找出未知变量和已知变量之间的关系,其中模型参数是通过最小化数据集误差的平方和来估计的。

一、定义:最小二乘法(Least Squares Method)是指在数学中最常见的数据拟合方法,它是一种统计学意义上的估计方法,用来确定未知变量与已知变量之间的关系,其中模型参数是通过最小化数据集误差的平方和来估计的。

二、基本原理:最小二乘法的基本原理是利用数据点与一个被称为“模型函数”的预设函数之间的差异,来从中估计出模型函数的参数。

具体来说,这一差异可以以误差的平方和来衡量,最小二乘法就是最小这一平方和的方法。

三、步骤:1. 构造未知变量的模型函数,其中当需要拟合的参数数目大于等于给定数据点的个数时,就会导致一定的形式多项式模型函数有正解;2. 求解模型函数的最小平方误差的最优解,即求解参数的数值;3. 根据最优解找出最小平方误差的值;4. 对模型函数进行评价,判断是否尽可能地满足数据点;5. 若满足,则用找出的模型函数来预报未来的参数变化情况。

四、应用:1. 拟合统计图形:通过最小二乘法,可以得到曲线拟合的参数,绘制出统计图形的曲线,用来剖析统计数据;2. 回归分析:可以用最小二乘法预测变量和另一变量之间的关系,如:股票收益与股价价格之间的关系,从而得到有用的分析结果;3. 模型拟合:最小二乘法可以估计精确数据模型参数,这些模型参数可与实验数据相同;4. 图像分析:最小二乘法可用于分析图像特征,如:平面图像的特征提取与比较,目标图像分类,等;5. 信号处理:最小二乘法的应用也可扩展到信号处理领域,用该方法对信号和噪声之间的关系进行拟合,来消除信号中的噪声。

最小二乘法一、简介最小二乘法,又称最小平方法,是一种数学技术。

它通过最小误差的平方和寻找数据函数的最佳匹配。

最小二乘法是提供“观测组合”的主要工具之一,它依据对某事件的大量观测而获得“最佳”结果或“最可能”表现形式。

如已知两变量为线性关系bx a y +=,对其进行)2(>n n 次观测而获得n 对数据。

若将这n 对数据代入方程求解a ,b 之值则无确定解。

最小二乘法提供了一个求解方法,其基本思想就是寻找“最接近”这n 个观测点的直线。

最小二乘法不仅是19世纪最重要的统计方法,而且还可以称为数理统计学之灵魂。

相关回归分析、方差分析和线性模型理论等数理统计学的几大分支都以最小二乘法为理论基础。

作为其进一步发展或纠正其不足而采取的对策,不少近现代的数理统计学分支也是在最小二乘法基础上衍生出来的。

最小二乘法之于数理统计学,有如微积分之于数学,这并非夸张之辞。

统计学应用的几个分支如相关分析、回归分析、方差分析和线性模型理论等,其关键都在于最小二乘法的应用不少现代的统计学研究是在此法的基础上衍生出来,作为其进一步发展或纠正其不足之处而采取的对策,如回归分析中一系列修正最小二乘法而产生的估计方法等就是最好的例子。

二、创立思想勒让德在先驱者解线性方程组的基础上,以整体的思想方法创立了最小二乘法;高斯由寻找随机误差函数为突破,以独特的概率思想导出了正态分布,详尽地阐述了最小二乘法的理论依据。

最小二乘法(OLSE)的思想就是要使得观测点和估计点的距离平方和达到最小,在各方程的误差之间建立一种平衡,从而防止某一极端误差,对决定参数的估计值取得支配地位,有助于揭示系统的更接近真实的状态。

这里的“二乘”指的是用平方来度量观测点与估计点的远近,“最小”指的是参数的估计值要保证各个观测点与估计点的距离的平方和达到最小。

三、原理设一组数据(,)i i x y (1,2,,)i n = ,现用近似曲线)(x y ϕ=拟合这组数据,“拟合得最好”的标准是所选择的()x ϕ在i x 处的函数值()i x ϕ(1,2,,)i n = 与i y (1,2,,)i n = 相差很小,即偏差(也称残差)()i i x y ϕ-(1,2,,)i n = 都很小.一种方法是使偏差之和()1ni i i x y ϕ=⎡⎤⎣⎦∑-很小来保证每个偏差都很小.但偏差有正有负,在求和的时候可能相互抵消.为了避免这种情况,还可使偏差的绝对值之和()1||ni i i x y ϕ=-∑为最小.但这个式子中有绝对值符号,不便于分析讨论.由于任何实数的平方都是正数或零,因而我们可选择使“偏差平方和21ni i i x y ϕ=-∑[()]最小”的原则来保证每个偏差的绝对值都很小,从而得到最佳拟合曲线y =()x ϕ.这种“偏差平方和最小”的原则称为最小二乘原则,而按最小二乘法原则拟合曲线的方法称为最小二乘法或称最小二乘曲线拟合法.一般而言,所求得的拟合函数可以使不同的函数类,拟合曲线()x ϕ都是由m 个线性无关函数()1x ϕ,()2x ϕ ,…, ()m x ϕ的线性组合而成,即()()()()1122m m x a x a x a x ϕϕϕϕ=+++…)1(-<n m ,其中1a ,2a ,…,m a 为待定系数.线性无关函数()1x ϕ,()2x ϕ ,…()m x ϕ,称为基函数,常用的基函数有: 多项式:1,x , 2x ,…,m x ;三角函数: sin x ,sin 2x ,…,sin mx ;指数函数:x x x m e e e λλλ,,,21 ,x λ2e,…,x λme.最小二乘法又称曲线拟合,所谓“ 拟合” ,即不要求所作的曲线完全通过所有的数据点,只要求所得的近似曲线能反映数据的基本趋势,它的实质是离散情况下的最小平方逼近.四、运用曲线拟合做最小二乘法 1 一元线性拟合已知实测到的一组数据(,)i i x y (1,2,,)i n = ,求作这组数据所成的一元线性关系式.设线性关系式为y a bx =+,求出a 和b 即可.法一:即要满足则)(令,0,0,,12=∂∂=∂∂--=∑=bsa sb a bx a y s ni i i ,则,a b 要满足s a ∂∂=0,sb∂∂=0.即 11()()ni i i n i i ii sy a bx a s y a bx x b==∂⎧--⎪⎪∂⎨∂⎪--⎪∂⎩∑∑=-2=0=-2=0化简得112111n n i i i i nn ni i i i i i i b a x y n n a x b x x y =====⎧⎪⎪⎨⎪⎪⎩∑∑∑∑∑1+=+= 从中解出1112211111n n n i i i ii i i n n i i i i n n i ii i n x y x yb n x x b a y x n n =======⎧⎪⎪⎪⎛⎫ ⎪⎨⎝⎭⎪⎪⎪⎩∑∑∑∑∑∑∑-=-=- (1) 法二:将i x ,i y 代入y a bx =+得矛盾方程组1122n y a bx y a bx y a bx n=+⎧⎪=+⎪⎨⎪⎪=+⎩ (2) 令A =12111n x x x ⎛⎫ ⎪⎪ ⎪ ⎪⎝⎭ ,B =12n y y y ⎛⎫⎪ ⎪ ⎪ ⎪⎝⎭,则(2)式可写成b B A a ⎛=⎫⎪⎝⎭,则对应的正规方程组为TTa b A B A A ⎛=⎫ ⎪⎝⎭,所以a b ⎛⎫ ⎪⎝⎭=1()T TA A AB -,其中A 称为结构矩阵,B 称为数据矩阵,T A A 称为信息矩阵,TA B 称为常数矩阵.2 多元线性拟合设变量y 与n 个变量1x ,2x ,…,n x (1n ≥)内在联系是线性的,即有如下关系式∑=+=nj j j x a a y 10,设j x 的第i 次测量值为ij x ,对应的函数值为i y (1,2,,)i m = ,则偏差平方和为s ='220111()()mm ni i i i ij i i j y y y a a x ===-=--∑∑∑,为了使s 取最小值得正规方程组011001111011202020m n i j ij i j m n i j ij i i j m n i j ij in i j ns y a a x a s y a a x x a s y a a x x a ======⎧∂⎛⎫=---=⎪ ⎪∂⎝⎭⎪⎪∂⎛⎫=---=⎪⎪∂⎨⎝⎭⎪⎪⎪∂⎛⎫=---=⎪ ⎪∂⎝⎭⎩∑∑∑∑∑∑ (3) 即011101111n m mij j i j i i mn m mik ij ik jik i i j i i ma x a y x a x x a x y =======⎧⎛⎫+= ⎪⎪⎝⎭⎪⎨⎛⎫⎪+= ⎪⎪⎝⎭⎩∑∑∑∑∑∑∑1,2,,k n = . (4) 将实验数据(,)i i x y 代入(4)式,即得m a a a ,,,10 .3 指数函数拟合科学实验得到一组数据(,)i i x y (1,2,,)i n = 时,还可以考虑用指数函数为基函数来拟合,此时设拟合函数具有形式bxy ae =(,a b 为待定系数).对上式两端取自然对数可得:ln ln y a bx =+ (9)令Y =ln y ,0ln b a =,则(9)式可转化为一元线性函数形式0Y b bx =+,此时将指数函数拟合转化成了一元线性拟合,利用一元线性拟合中的两种方法均可求出0b 和b ,继而根据0b a e =可求出a ,从而得出因变量y 与自变量x 之间的函数关系式0b bx bx y ae e +==4 对数函数拟合科学实验得到一组数据(,)i i x y (1,2,,)i n = 时,还可以考虑用对数函数为基函数来拟合,此时设拟合函数具有形式ln y a b x =+(0)x >(,a b 为待定系数).0b >时,y 随x 增大而增大,先快后慢;0b <时,y 随x 增大而减小,先快后慢.当以y 和ln x 绘制的散点图呈直线趋势时,可考虑采用对数函数描述y 与x 之间的非线性关系,式中的b 和a 分别为斜率和截距.这时令X =ln x ,就可以利用一元线性拟合的方法来求解.更一般的对数函数还可设为y =()ln a b x k ++,式中k 为一常量.五 举例例1 使电流通过2Ω的电阻,用伏特表测量电阻两端的电压V .测得数据如下表:t I /A1 2 4 6 8 10 t V /V1.83.78.212.015.820.2试用最小二乘法建立I 与V 之间的一元经验公式(有效数字保留到小数点后第3位). 解:可取一次线性关系式V a bI =+作为I 与V 之间的一元经验公式. 将数据代入得矛盾方程组1.82 3.748.2612.0815.81020.2a b a b a b a b a b a b +=⎧⎪+=⎪⎪+=⎨+=⎪⎪+=⎪+=⎩ 令1112141618110A ⎛⎫ ⎪ ⎪ ⎪= ⎪ ⎪ ⎪ ⎪ ⎪⎝⎭, 1.83.78.212.015.820.2B ⎛⎫ ⎪ ⎪ ⎪= ⎪ ⎪ ⎪ ⎪ ⎪⎝⎭,则上述矛盾方程组可写成矩阵形式0a A B b ⎛⎫-= ⎪⎝⎭由此得出其正规方程组0T T a A A A B b ⎛⎫-= ⎪⎝⎭,将数据代入即得63161.7031221442.4a b ⎛⎫⎛⎫⎛⎫-= ⎪⎪ ⎪⎝⎭⎝⎭⎝⎭,解之得0.212.032a b =-⎧⎨=⎩,故所求经验公式为0.2152.V I =-+. 例 2 在在开发一种抗过敏性的新药时,要对不同剂量的药效进行实验.10名患者各服用了该新药的一个特定的剂量.药物消失时立即纪录.观测值列于下表中.x 是剂量,y 是症状消除持续的日数.用7个不同的剂量, 其中3个剂量重复给两名患者.试给出y 与x 之间的一元经验公式(保留3位有效数字).1 2 3 4 5 6 7 8 9 10 ∑ /i x mg334566788959/i y d9 5 12 9 14 16 22 18 24 22 1512i x 9 9 16 25 36 36 49 64 64 81 389i i x y271548458496154144192198 1003解:可设y 与x 之间的经验公式为y a bx =+. 由上表可知,101i i x =∑59=,101i i y =∑151=,101i i i x y =∑1003=,1021i i x =∑389=,2101i i x =⎛⎫ ⎪⎝⎭∑3481= 再由(1)式可求得,1010101112101021110101003591512.7410389348110i i i ii i i i i i i x y x y b x x =====-⨯-⨯===⨯-⎛⎫- ⎪⎝⎭∑∑∑∑∑10101111 2.7415159 1.0710101010i i i i b a y x ===-=⨯-⨯=-∑∑所以y 与x 之间的经验公式为 1.07 2.74y x =-+.最小二乘法能将从实验中得出的一大堆看上去杂乱无章的数据中找出一定的规律,拟合成一条曲线来反映所给数据特点。

最小二乘法基本原理

最小二乘法是一种常用的回归分析方法,用于估计数据中的未知参数。

其基本原理是通过最小化实际观测值与估计值之间的残差平方和,来找到一个最佳拟合曲线或者平面。

在进行最小二乘法拟合时,通常会假设观测误差服从正态分布。

具体而言,最小二乘法寻找到的估计值是使得实际观测值与拟合值之间的差的平方和最小的参数值。

也就是说,最小二乘法通过调整参数的取值,使得拟合曲线与实际观测值之间的误差最小化。

在回归分析中,通常会假设数据服从一个特定的函数形式,例如线性函数、多项式函数等。

根据这个假设,最小二乘法将找到最合适的函数参数,使得这个函数能够最好地拟合数据。

最小二乘法的步骤包括以下几个方面:

1. 根据数据和所假设的函数形式建立回归模型;

2. 计算模型的预测值;

3. 计算实际观测值与预测值之间的残差;

4. 将残差平方和最小化,求解最佳参数值;

5. 利用最佳参数值建立最优拟合曲线。

最小二乘法的优点是简单易用,并且在经济学、统计学和工程学等领域都有广泛应用。

但需要注意的是,最小二乘法所得到的估计值并不一定是真实参数的最优估计,它只是使得残差平方和最小的一组参数估计。

因此,在使用最小二乘法时,需要对模型的合理性进行评估,并考虑其他可能的回归分析方法。

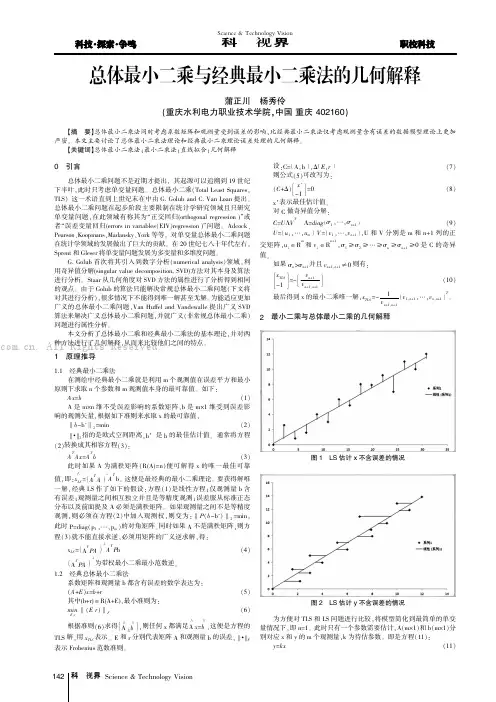

Science &Technology Vision科技视界0引言总体最小二乘问题不是近期才提出,其起源可以追溯到19世纪下半叶,此时只考虑单变量问题。

总体最小二乘(Total Least Squares,TLS)这一术语直到上世纪末在中由G.Golub and C.Van Loan 提出。

总体最小二乘问题在起步阶段主要限制在统计学研究领域且只研究单变量问题,在此领域有称其为“正交回归(orthogonal regression )”或者“误差变量回归(errors in variables(EIV)regression )”问题。

Adcock、Pearson、Koopmans、Madansky、York 等等,对单变量总体最小二乘问题在统计学领域的发展做出了巨大的贡献。

在20世纪七八十年代左右,Sprent 和Gleser 将单变量问题发展为多变量和多维度问题。

G.Golub 首次将其引入到数字分析(numerical analysis)领域,利用奇异值分解(singular value decomposition,SVD)方法对其本身及算法进行分析。

Staar 从几何角度对SVD 方法的属性进行了分析得到相同的观点。

由于Golub 的算法只能解决常规总体最小二乘问题(下文将对其进行分析),很多情况下不能得到唯一解甚至无解。

为能适应更加广义的总体最小二乘问题,Van Huffel and Vandewalle 提出广义SVD 算法来解决广义总体最小二乘问题,并就广义(非常规总体最小二乘)问题进行属性分析。

本文分析了总体最小二乘和经典最小二乘法的基本理论,并对两种方法进行了几何解释,从而来比较他们之间的特点。

1原理推导1.1经典最小二乘法在测绘中经典最小二乘就是利用m 个观测值在误差平方和最小原则下求取n 个参数和m 观测值本身的最可靠值。

如下:Ax=b (1)A 是m×n 维不受误差影响的系数矩阵,b 是m×1维受到误差影响的观测矢量,根据如下准则来求取x 的最可靠值,‖b-b'‖2=min (2)‖•‖2指的是欧式空间距离,b’是b 的最佳估计值。

最小二乘法的基本原理最小二乘法是一种常用的数学方法,用于拟合数据和估计参数。

它的基本原理是通过最小化实际观测值与理论值之间的差异来找到最优的拟合曲线或者参数估计。

在实际应用中,最小二乘法被广泛应用于各种领域,例如经济学、统计学、工程学等。

首先,让我们来看一下最小二乘法的基本概念。

在最小二乘法中,我们通常会有一组观测数据,我们希望找到一个函数或者模型来描述这些数据。

假设我们有一组数据点{(x1, y1), (x2,y2), ..., (xn, yn)},我们希望找到一个函数y = f(x)来拟合这些数据。

最小二乘法的目标就是找到一个函数f(x),使得所有数据点到f(x)的距离之和最小。

为了实现这一目标,我们需要定义一个衡量拟合程度的指标。

通常情况下,我们会使用残差平方和作为衡量指标。

残差指的是每个观测数据点的实际值与拟合值之间的差异,残差平方和则是所有残差的平方之和。

最小二乘法的核心思想就是通过最小化残差平方和来找到最优的拟合函数。

在实际操作中,我们可以通过求解偏导数为0的方程组来得到最小二乘法的解析解,也可以利用数值计算方法来求解。

无论采用哪种方法,最终得到的拟合函数都是使得残差平方和最小的函数。

最小二乘法的优点在于它具有较好的数学性质和稳定性。

它对异常值具有一定的鲁棒性,能够有效地减小异常值对拟合结果的影响。

另外,最小二乘法还可以用于估计参数,例如在线性回归模型中,最小二乘法可以用来估计回归系数。

然而,最小二乘法也存在一些局限性。

首先,它对数据的分布和误差的性质有一定的要求,如果数据不满足最小二乘法的假设条件,拟合结果可能会出现偏差。

其次,最小二乘法在处理大规模数据时,计算量较大,效率较低。

总的来说,最小二乘法是一种简单而有效的数据拟合和参数估计方法。

它的基本原理清晰易懂,应用范围广泛。

在实际应用中,我们需要根据具体问题的特点选择合适的拟合模型和方法,以达到最佳的拟合效果和参数估计结果。

最小二乘法原理

最小二乘法是一种用于拟合实验数据的统计算法,它通过最小化实际观测值与理论曲线之间的残差平方和来确定拟合曲线的最佳参数值。

该方法常应用于曲线拟合、回归分析和数据降维等领域。

最小二乘法的基本原理是基于线性回归模型:假设数据之间存在线性关系,并且实验误差服从正态分布。

为了找到最佳拟合曲线,首先假设拟合曲线的表达式,通常是一个线性方程。

然后利用实际观测值与拟合曲线之间的残差,通过最小化残差平方和来确定最佳的参数估计。

残差即为实际观测值与拟合曲线预测值之间的差异。

最小二乘法的优点在于它能够提供最优的参数估计,并且结果易于解释和理解。

通过将实际观测值与理论曲线进行比较,我们可以评估拟合的好坏程度,并对数据的线性关系进行量化分析。

此外,最小二乘法可以通过引入惩罚项来应对过拟合问题,增加模型的泛化能力。

最小二乘法在实际应用中具有广泛的应用,例如金融学中的资产定价模型、经济学中的需求曲线估计、物理学中的运动学拟合等。

尽管最小二乘法在某些情况下可能存在局限性,但它仍然是一种简单而强大的统计方法,能够提供有关数据关系的重要信息。

最小二乘法的应用及原理解析最小二乘法,英文称为 Least Squares Method,是一种经典的数学优化技术,广泛应用于数据拟合、信号处理、机器学习、统计分析等领域。

本文将从应用角度出发,介绍最小二乘法的基本原理、优缺点以及实际应用中的具体操作流程。

一、最小二乘法的基本原理最小二乘法的基本思路是:已知一组样本数据(x1,y1),(x2,y2),...(xn,yn),要求找到一条曲线(如直线、多项式等),使得该曲线与样本数据的误差平方和最小。

其数学表示式为:$min {\sum_{i=1}^{n}(y_i-\hat{y}_i)^2}$其中,$\hat{y}_i$是曲线在$x_i$处的预测值,代表曲线对样本数据的拟合程度。

显然,当误差平方和最小时,该曲线与样本数据的拟合效果最好,也就是最小二乘法的优化目标。

最小二乘法的求解方法有多种,比较常用的有矩阵求导法、正规方程法、QR分解法等。

这里以正规方程法为例进行介绍。

正规方程法的思路是:将目标函数中的误差平方和展开,取它的一阶导数为零,求得最优解的系数矩阵。

具体过程如下:1.将样本数据表示为矩阵形式,即 $X=[1,x_1,x_2,...,x_n]^T$。

2.构建方程组 $X^TX\beta=X^TY$,其中$\beta=[\beta_0,\beta_1,...,\beta_p]$是待求系数矩阵。

3.求解方程组,得到最优解的系数矩阵 $\beta$。

最小二乘法的优点是:对于线性问题,最小二乘法是一种解析解,可以求得精确解。

同时,最小二乘法易于理解、简单易用,可以快速拟合实际数据,避免过度拟合和欠拟合。

二、最小二乘法的优缺点最小二乘法虽然有很好的拟合效果,但是也存在一些不足之处:1.对异常值敏感。

最小二乘法基于误差平方和的最小化,如果样本中存在离群值或噪声,会对最终结果产生较大影响,导致拟合结果不准确。

2.对线性假设敏感。

最小二乘法只适用于线性问题,如果样本数据的真实规律是非线性的,则拟合效果会大打折扣。

最小二乘法(least sqauremethod)专栏文章汇总文章结构如下:1:最小二乘法的原理与要解决的问题2 :最小二乘法的矩阵法解法3:最小二乘法的几何解释4:最小二乘法的局限性和适用场景5:案例python实现6:参考文献1:最小二乘法的原理与要解决的问题最小二乘法是由勒让德在19世纪发现的,形式如下式:标函数 = \sum(观测值-理论值)^2\\观测值就是我们的多组样本,理论值就是我们的假设拟合函数。

目标函数也就是在机器学习中常说的损失函数,我们的目标是得到使目标函数最小化时候的拟合函数的模型。

举一个最简单的线性回归的简单例子,比如我们有 m 个只有一个特征的样本: (x_i, y_i)(i=1, 2, 3...,m)样本采用一般的 h_{\theta}(x) 为 n 次的多项式拟合,h_{\theta}(x)=\theta_0+\theta_1x+\theta_2x^2+...\theta_nx^n,\theta(\theta_0,\theta_1,\theta_2,...,\theta_n) 为参数最小二乘法就是要找到一组\theta(\theta_0,\theta_1,\theta_2,...,\theta_n) 使得\sum_{i=1}^n(h_{\theta}(x_i)-y_i)^2 (残差平方和) 最小,即,求 min\sum_{i=1}^n(h_{\theta}(x_i)-y_i)^22 :最小二乘法的矩阵法解法最小二乘法的代数法解法就是对 \theta_i 求偏导数,令偏导数为0,再解方程组,得到 \theta_i 。

矩阵法比代数法要简洁,下面主要讲解下矩阵法解法,这里用多元线性回归例子来描:假设函数h_{\theta}(x_1,x_2,...x_n)=\theta_0+\theta_1x_1+...+\t heta_nx_n 的矩阵表达方式为:h_{\theta}(\mathbf{x})=\mathbf{X}\theta\\其中,假设函数 h_{\theta}(\mathbf{x})=\mathbf{X}\theta 为 m\times1 的向量, \theta 为 n\times1 的向量,里面有 n 个代数法的模型参数。

最小二乘法的原理

最小二乘法是一种统计学中常用的参数估计方法,用于拟合数据并找到最适合数据的数学模型。

其原理是通过最小化实际观测值与预测值之间的误差平方和,来确定模型参数的取值。

具体而言,假设有一组数据点,其中每个数据点包括自变量(即输入值)和因变量(即输出值)的配对。

我们要找到一条最佳拟合曲线(或者直线),使得曲线上的预测值尽可能接近实际观测值。

而最小二乘法的目标就是使得残差的平方和最小化。

假设要拟合的模型为一个一次多项式:y = β0 + β1*x,其中β0和β1是待估计的参数,x是自变量,y是因变量。

我们要找到

最优的β0和β1,使得拟合曲线的误差最小。

为了使用最小二乘法,我们首先需要构建一个误差函数。

对于每个数据点,误差函数定义为实际观测值与预测值之间的差,即e = y - (β0 + β1*x)。

我们的目标是最小化所有误差的平方和,即最小化Sum(e^2)。

通过对误差函数求导,并令导数为0,可以得到最小二乘法的

正规方程组。

解这个方程组可以得到最优的参数估计值,即

β0和β1的取值。

最终,通过最小二乘法,我们可以得到一条最佳拟合曲线(或直线),使得曲线的预测值与实际观测值的误差最小。

这条拟

合曲线可以用于预测新的因变量值,或者理解自变量与因变量之间的关系。

最小二乘法的基本原理

最小二乘法(Least Square Method,LSM)是一种数学优化方法,根据一组观测值,找到最能够复合观测值的模型参数。

它是求解最优化问题的重要方法之一,可以用于拟合曲线、拟合非线性函数等。

一、基本原理

(1)最小二乘法依据一组观测值的误差的平方和最小找到参数的最优解,即最小化误差的函数。

(2)为了求解最小量,假设需要估计的参数维度为n,那么应该在总共的m个观测值中找到n个能够最小二乘值的参数。

(3)具体的求解方法为,由所有的数值计算最小和可能性最大的可能性,从而求得最佳拟合参数。

二、优点

(1)最小二乘法最大的优点就是可以准确测量拟合实际数据的结果。

(2)有效利用活跃度原则让处理内容变得简单,操作计算量少。

(3)可以有效地节省计算过程,提高计算效率,使用计算机完成全部计算任务。

(4)具有实用性,可以根据应用的不同情况来自动判断最优的拟合参数,比如用最小二乘法来拟合异常值时,就可以调整参数获得更好的拟合效果,而本没有定义可以解决问题。

三、缺点

(1)对于(多维)曲线拟合问题,最小二乘法计算时特别容易陷入局部最小值,可能得到估计量的质量没有较优的实现;

(2)要求数据具有正态分布特性;

(3)数据中存在外源噪声,则必须使用其它估计方法;

(4)最小二乘法的结果只对数据有效,对机器学习的泛化能力较弱。

高中生都能看懂的最小二乘法原理在简单线性回归等曲线拟合中提到的最多的最小二乘法,那么下面引用《正态分布的前世今生》里的内容稍微简单阐述下。

一、最小二乘法的历史1801年,意大利天文学家朱赛普·皮亚齐发现了第一颗小行星谷神星。

经过40天的跟踪观测后,由于谷神星运行至太阳背后,使得皮亚齐失去了谷神星的位置。

随后全世界的科学家利用皮亚齐的观测数据开始寻找谷神星,但是根据大多数人计算的结果来寻找谷神星都没有结果。

时年24岁的高斯也计算了谷神星的轨道。

奥地利天文学家海因里希·奥尔伯斯根据高斯计算出来的轨道重新发现了谷神星。

高斯使用的最小二乘法的方法发表于1809年他的著作《天体运动论》中。

法国科学家勒让德于1806年独立发明“最小二乘法”,但因不为世人所知而默默无闻。

勒让德曾与高斯为谁最早创立最小二乘法原理发生争执。

1829年,高斯提供了最小二乘法的优化效果强于其他方法的证明,因此被称为高斯-马尔可夫定理。

(来自于wikipedia)二、原理我们口头中经常说:一般来说,平均来说。

如平均来说,不吸烟的健康优于吸烟者,之所以要加“平均”二字,是因为凡事皆有例外,总存在某个特别的人他吸烟但由于经常锻炼所以他的健康状况可能会优于他身边不吸烟的朋友。

而最小二乘法的一个最简单的例子便是算术平均。

最小二乘法(又称最小平方法)是一种数学优化技术。

它通过最小化误差的平方和寻找数据的最佳函数匹配。

利用最小二乘法可以简便地求得未知的数据,并使得这些求得的数据与实际数据之间误差的平方和为最小。

用函数表示为:使误差「所谓误差,当然是观察值与实际真实值的差量」平方和达到最小以寻求估计值的方法,就叫做最小二乘法,用最小二乘法得到的估计,叫做最小二乘估计。

当然,取平方和作为目标函数只是众多可取的方法之一。

最小二乘法的一般形式可表示为:有效的最小二乘法是勒让德在1805 年发表的,基本思想就是认为测量中有误差,所以所有方程的累积误差为我们求解出导致累积误差最小的参数即可:勒让德在论文中对最小二乘法的优良性做了几点说明:•最小二乘使得误差平方和最小,并在各个方程的误差之间建立了一种平衡,从而防止某一个极端误差取得支配地位•计算中只要求偏导后求解线性方程组,计算过程明确便捷•最小二乘可以导出算术平均值作为估计值对于最后一点,从统计学的角度来看是很重要的一个性质。

最小二乘法基本原理最小二乘法是一种常见的数学拟合方法,它可以用来求解线性回归、非线性回归等问题。

在实际应用中,最小二乘法被广泛应用于数据拟合、参数估计等领域。

本文将介绍最小二乘法的基本原理,帮助读者更好地理解和应用这一方法。

首先,我们来看看最小二乘法的核心思想。

最小二乘法的目标是找到一条曲线或者一个函数,使得这条曲线或者函数与实际数据的残差平方和最小。

残差即实际观测值与拟合值之间的差距,残差平方和的最小化可以保证拟合效果更好。

在线性回归问题中,我们通常假设模型为y = β0 + β1x + ε,其中β0和β1为待估参数,ε为误差项。

我们的目标是找到最优的参数估计值β0和β1,使得模型的拟合效果最好。

最小二乘法通过最小化残差平方和来实现这一目标。

具体来说,对于给定的数据集{(x1, y1), (x2, y2), ..., (xn, yn)},我们可以通过最小二乘法求解出最优的参数估计值β0和β1。

首先,我们需要构建损失函数,通常选择残差平方和作为损失函数。

然后,通过对损失函数进行求导,可以得到最优参数的闭式解。

最终,我们就可以得到最优的参数估计值,从而得到最佳拟合曲线。

除了线性回归,最小二乘法还可以应用于非线性回归问题。

在非线性回归问题中,我们的模型可能是非线性的,例如y = β0 + β1x + β2x^2 + ε。

此时,我们可以借助最小二乘法来求解最优的参数估计值β0、β1和β2,从而得到最佳拟合曲线。

最小二乘法的优点在于它具有良好的数学性质和稳定的数值计算方法。

通过最小二乘法,我们可以得到最优的参数估计值,从而使得拟合效果更好。

此外,最小二乘法还可以通过统计检验来评估模型的拟合效果,从而帮助我们判断模型的可靠性。

总之,最小二乘法是一种常见且实用的数学拟合方法,它可以用来求解线性回归、非线性回归等问题。

通过最小二乘法,我们可以得到最优的参数估计值,从而使得拟合效果更好。

希望本文能够帮助读者更好地理解和应用最小二乘法,从而在实际问题中取得更好的效果。

最小二乘法的原理最小二乘法是一种常用的参数估计方法,它在统计学和数学建模中有着广泛的应用。

其原理简单清晰,易于理解和实现,因此受到了广泛的关注和应用。

在介绍最小二乘法的原理之前,我们先来了解一下最小二乘法的应用背景。

最小二乘法通常用于拟合一个数学模型与观测数据,其目标是寻找到一个最优的参数组合,使得模型预测值与观测值之间的误差平方和最小。

这种方法在数据分析、回归分析、信号处理、图像处理等领域都有着重要的应用。

最小二乘法的原理可以从几何和代数两个角度来解释。

从几何角度来看,最小二乘法就是寻找一个直线(或者曲线),使得观测数据点到这条直线(曲线)的距离之和最小。

从代数角度来看,最小二乘法是通过最小化残差平方和来确定参数的估计值。

在最小二乘法中,我们通常会遇到一个经典的问题,即拟合直线的问题。

假设我们有一组观测数据点{(x1, y1), (x2, y2), …, (xn, yn)},我们希望找到一条直线y = ax + b,使得观测数据点到直线的距离之和最小。

这时,我们可以利用最小二乘法来求解出直线的参数a和b。

具体而言,我们可以通过最小化残差平方和来确定参数a和b 的估计值。

残差指的是观测数据点到拟合直线的垂直距离,残差平方和就是所有观测数据点到拟合直线的距离的平方之和。

最小二乘法的思想就是找到一组参数a和b,使得残差平方和达到最小值。

最小二乘法的原理可以用数学公式来描述。

对于拟合直线的问题,我们可以定义残差ei为第i个观测数据点到拟合直线的垂直距离,即ei = yi (axi + b),其中(xi, yi)为第i个观测数据点的坐标。

那么残差平方和可以表示为S = Σ(ei^2),i从1到n。

我们的目标就是找到一组参数a和b,使得S达到最小值。

为了求解参数a和b的估计值,我们可以对S分别对a和b求偏导数,并令偏导数等于0,得到参数a和b的估计值。

具体的求解过程可以通过代数方法或者矩阵方法来实现。

通过最小二乘法求解出的参数估计值,就是拟合直线的斜率和截距。

最小二乘法几何解释最小二乘法是一种常用的数学方法,用于寻找数据点与最佳拟合线之间的最小方差。

这种方法的几何解释非常重要,因为它可以帮助我们更好地理解其原理和应用。

首先,我们来看一下最小二乘法的基本原理。

假设我们有一组离散的数据点,我们希望找到一条直线来拟合这些数据点。

最小二乘法的目标是使得这条直线与每个数据点的误差的平方和最小。

所谓误差,就是每个数据点在垂直方向上到直线的距离。

通过最小化这些误差的平方和,我们可以找到最佳的拟合直线。

接下来,我们来看一下最小二乘法的几何解释。

假设我们有一个坐标系,数据点在该坐标系中呈现一定的分布。

我们要找的拟合直线是通过这个坐标系的,而不是平面上的点。

拟合直线代表了数据点的整体趋势。

最小二乘法的几何解释是,我们要找到一条直线,使得所有数据点在直线上的投影点到原始数据点的垂直距离的平方和最小。

这里的投影点是指数据点在拟合直线上的垂直投影点。

这个几何解释告诉我们,最小二乘法是通过找到投影点和原始数据点之间的垂直距离最小化,来寻找最佳拟合直线。

这个距离的平方和是衡量直线拟合程度的标准,我们希望这个值越小越好。

最小二乘法的几何解释还可以帮助我们理解其应用。

在现实生活中,很多问题都可以转化为拟合直线的问题。

例如,在销售领域,我们可以使用最小二乘法来分析销售数据,找到最佳的趋势线,以预测未来的销售量。

在物理学中,最小二乘法可以用于拟合实验数据,找到物理规律的表达式。

总之,最小二乘法的几何解释非常重要,它帮助我们更好地理解最小二乘法的原理和应用。

通过最小化数据点和拟合直线之间的垂直距离的平方和,我们可以找到最佳的拟合直线,从而得到更准确的预测和分析结果。

无论是在科学研究还是实际应用中,最小二乘法都发挥着重要的作用。

最小二乘法的原理及证明最小二乘法是一种常用的数据拟合方法,它的本质是通过寻找最小化残差平方和的参数组合进行数据拟合。

在现实生活中,很多实际问题都可以通过最小二乘法来求解,如线性回归、曲线拟合、方程求解等。

本文将介绍最小二乘法的原理及证明。

一、最小二乘法的原理最小二乘法是一种基于误差最小化的思想进行模型参数求解的方法。

对于含有n个数据点的模型,其最小二乘法的表示形式为:$min[\sum_{i=1}^n(y_i-f(x_i))^2]$其中,$y_i$为第i个数据点的观测值,$f(x_i)$为模型在$x_i$处的预测值。

最小二乘法的目的是寻找一个最优的模型参数集合,使得预测值与观测值之间的误差平方和最小。

以线性回归为例,线性回归模型的基本形式为:$y=\beta_0+\beta_1x+\epsilon$其中,$\beta_0$和$\beta_1$为线性回归的系数,$\epsilon$为误差项。

通过最小二乘法,我们需要求解$\beta_0$和$\beta_1$,使得预测值与真实值之间的残差平方和最小。

在实际应用中,最小二乘法可以通过求解模型参数的偏导数,进而得到参数的估计值。

同时,最小二乘法还可以通过矩阵运算的形式进行求解,这种方法称为矩阵最小二乘法。

二、最小二乘法的证明最小二乘法的原理可以通过数学证明来得到。

在数学推导中,我们需要利用概率论和统计学的相关知识。

1、最小二乘法的基本假设首先,我们需要对最小二乘法做出一些假设。

最小二乘法的假设包括:(1)数据点满足线性关系;(2)误差项满足高斯分布;(3)误差项具有同方差性;(4)误差项之间相互独立。

在这些假设的基础上,我们可以得出以$X$为自变量,$Y$为因变量的线性模型:$Y=\beta_0+\beta_1X+\epsilon$其中,$\beta_0$和$\beta_1$为线性模型的系数,$\epsilon$为误差项。

我们需要利用概率论和统计学的方法,通过参数的似然函数来求解模型的系数。