基于MPI的并行最大最小蚂蚁系统

- 格式:pdf

- 大小:235.73 KB

- 文档页数:3

MPI并行程序设计MPI并行程序设计引言MPI(Message Passing Interface)是一种常用的并行计算编程模型,用于在分布式计算环境中实现并行程序设计。

MPI提供了在多个进程之间进行通信和同步的机制,使得程序能够充分利用集群或超级计算机的并行性能。

本文将介绍MPI的基本概念和使用方法,并帮助读者了解如何进行MPI并行程序设计。

MPI基本概念MPI的核心思想是将计算任务划分为多个子任务,并将这些子任务分发给不同的进程进行并行计算。

MPI使用消息传递的方式来实现进程之间的通信和同步。

以下是一些MPI的基本概念:进程通信在MPI中,每个并行计算的进程都有一个唯一的标识符,称为进程号(rank)。

进程之间可以使用通信操作进行消息传递,包括发送消息(send)、接收消息(receive)和同步(synchronize)等操作。

点对点通信点对点通信是指在两个进程之间进行消息传递,包括发送方和接收方。

发送方使用`MPI_Send`函数发送消息,接收方使用`MPI_Recv`函数接收消息。

广播通信广播通信是指一个进程向所有其他进程发送消息的操作。

发送方使用`MPI_Bcast`函数广播消息,接收方使用`MPI_Recv`函数接收消息。

归约操作归约操作是指将一组数值合并为一个数值的操作,如求和、求最大值等。

MPI提供了多种归约操作,包括`MPI_Reduce`和`MPI_Allreduce`。

并行计算模式MPI支持多种并行计算模式,包括主从模式、对等模式等。

在主从模式中,一个进程作为主进程,负责分发任务和收集结果;其余进程作为从进程,负责执行分配的子任务。

在对等模式中,所有进程都具有相同的任务和贡献。

MPI程序设计步骤编写MPI并行程序的一般步骤如下:1. 初始化MPI环境:使用`MPI_Init`函数初始化MPI环境,并获取进程数量和进程编号等信息。

2. 分配任务:根据进程编号和任务数量,将总计算任务划分为子任务,并分发给各个进程。

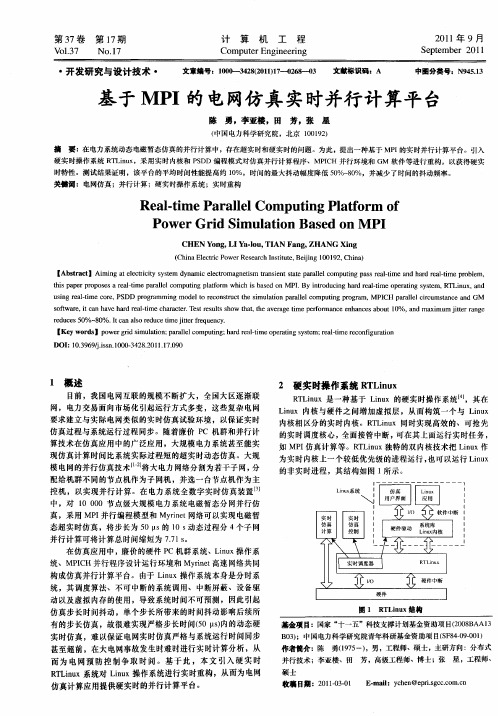

!第"#卷第$期郑州大学学报!理学版"%&’("#)&($ !*#+,年-月./0123451&67389/!):;/<=8/>?/"<2@/*#+,基于C%(的CN1,I I算法并行王!进+!!晏世凯+!!高延雨+!!金理雄*!!胡明星$!!邓!欣+!!陈乔松+!+(重庆邮电大学计算智能重庆市重点实验室!重庆C###E"$*(浙江省通信产业服务有限公司温州市分公司!浙江温州$*"###$$(云南省交通科学研究院!云南昆明E"##++"摘要!基于T J N将T c B=))算法并行化#以解决多标签学习领域中的大规模分类问题#控制计算的时间开销#这也是首次将T J N应用到多标签学习领域/通过与传统的串行T c B=))的对比实验#验证了所提方法的可行性和有效性/另外#允许数据集以特征为单位划分#这使得该方法在处理高维数据时具有更大的优势/关键词!机器学习$多标签学习$并行计算$T c B=))$T J N中图分类号!P J+,+文献标志码!M文章编号!+EA+B E,C+!*#+,"#$B##$CB#"&’(!+#(+$A#"Q R/8I I3/+EA+B E,C+(*#+A*"*)*引言大数据’+(指的是数据规模庞大到无法通过目前的技术)方法和理论#在可以容忍的时间内对其进行获取)管理)处理的数据#其具有数据体量大)数据类型多样)价值密度低等特点/随着大数据时代的到来#传统的串行计算方法已经不能满足数据挖掘工作者的需要#在并行框架下进行大规模数据挖掘已成为一种趋势/目前#机器学习算法常用的并行框架有d:?&&@’*()<@:X[’$(以及T J N!F2I I:42@:I I83483;2X W:=2"’C(/文献’"(分别实现了d:?&&@和<@:X[版本的M@X8&X8算法#实验结果表明<@:X[较d:?&&@在N Q U上时间开销更低#效率更高#文献’E(将<%T和=))分别在<@:X[和T J N Q U@23T J上并行#证明了T J N Q U@23T J比<@:X[具有更高效率/在数据的规模不断增大的同时#数据的表现形式也愈加丰富#而传统的监督学习认为每个样本只有一个标签#不能准确地表述事物的复杂语义/多标签学习’A(认为每个样本可能包含一个或多个标签#具有多个标签的样本能够更好地表现事物语义信息的多样性/多个标签的引入虽然增强了样本的表达能力#却也不可避免地使相应的学习任务变得更加困难/与单标签学习相比#多标签学习中标签集合的数目随标签个数的增加呈指数级增长#导致了其输出空间较大#从而增加了学习的难度/T c B=))!F6’;8B’:Z2’=B32:X2I;32841Z&X"’,(是一种基于=))!=B32:X2I;32841Z&X"和贝叶斯理论的多标签学习算法#算法分别统计待预测样本=近邻中每个标签的信息#并利用最大后验概率准则进行预测/T c B=))也是多标签学习算法中的第一个惰性学习算法’,(#其同时继承惰性学习和贝叶斯方法的优势’A(&决策的边界可以通过调整待预测样本的邻居个数而调整$计算每个类别的先验概率可有效缓解不平衡问题/此外#T c B=))还具有算法简洁)分类准确率高等特点#因而被广泛使用/然而#当数据规模庞大时#T c B=))算法由于自身的时间复杂度较高而不能高效地对其进行处理#本文基于T J N编程模型将T c B=))并行化#以提升T c B=))的效率#节约硬件成本/这也是首次将T J N并行计算框架应用到了多标签学习领域#通过与传统的串行T c B=))的对比实验#验证了本文提出方法的可行性和有效性/值得一提的是#在对数据集的划分时#本文提出的方法不仅可以将数据集以样本为单位划分#也能以特征为单位划分#这使得在处理高维数据的时候#本文的方法具有更大的优势/收稿日期!*#+AB#,B*-基金项目!重庆市基础与前沿研究计划项目!=I;=*#+CR=a R M C###+#=I;=*#+CR=a R M C##**"$重庆教委科学技术研究项目!自然科学类" !S.+C##C$E"/作者简介!王进!+-A-%"#男#重庆人#教授#主要从事机器学习研究#>B F:8’&]:34R83G=H6@;/2?6/=3$通信作者&晏世凯!+--C%"#男#四川泸州人#硕士研究生#主要从事机器学习研究#>B F:8’&I18[:8/a:3GW&^F:8’/=&F/!第$期王!进#等$基于T J N 的T cB =))算法并行+*CN 1,I I 算法设!为特征空间#"是有限个标签的集合5对于任一样本;!;$!"#其标签的集合W )"#3(;为样本;的类别向量#向量中的元素为3(;!*"!*$""#若*$"#则3(;!*"的值为+#否则为#5此外#定义B !;"为样本;在训练集中的=近邻的集合#其中样本之间相似度用欧氏距离度量#则成员统计向量D (;!*"被定义为样本;的=近邻中标签为*的样本的个数/对于测试样本,#X *+表示事件样本,含有标签*$X *#则表示事件样本,不含标签*$A *>!>$.##+#+#=/"表示事件在样本,的=近邻中#恰好有>个样本含有标签*5利用最大化后验概率准则!F :^8F 6F :@&I ;2X 8&X 8#T M J "#测试样本,的标签向量3(,为3(;!*"’:X 4F :^2$.##+/&!X *2A *D (,!*""#*$"5!+"设训练集样本个数为:#特征空间维度为F #标签空间维度为##T c B =))算法训练阶段的时间复杂度为]!:*F o #:="#测试阶段的时间复杂度为]!:F o #="’A (/-*CN 1,I I 的并行-,+*数据集的划分设特征空间!是F 维实数向量空间T F #标签集合"可以映射到一个#维实数向量空间T ##训练集C由:个样本组成#则训练集C 中样本特征的集合可由:行F 列的矩阵#:l F 表示#样本标签的集合可由:行#列的矩阵-:l #表示/对于矩阵##将其以样本和特征为单位近似均匀划分成<l 9个子矩阵/为了阐述的方便#定义每个子矩阵为一个特征数据块#在同一列的特征数据块组成一个特征数据列#在同一行的特征数据块组成一个特征数据行/对于每一个特征数据块#为其分配一个独有的进程#并将该特征数据块和标签矩阵-传入该进程/-,-*先验概率的计算求取先验概率的核心是对训练集标签信息的统计#即对于每个标签统计其正类样本和负类样本的个数/首先将标签信息以样本为单位近似均匀划分为<l 9个子集#每个进程仅需统计其中的一个子集#再通过全归约求和操作#每个进程即可得到整个训练集标签信息的统计结果/最后#对于每个进程#根据统计结果计算先验概率#计算方法与串行的一致/-,3*,近邻的求取由于在数据分割时#不仅将训练集以样本为单位进行了划分#还将训练集以特征为单位进行了划分#使得原始的T cB =))算法中的欧氏距离在并行中不适用#同时为了充分利用矩阵运算的优势提升效率#故将欧氏距离在求取=近邻的情况下等价为C -1,!.#/"’!.7/"!.7/"槡P 8!.7/"!.7/"P 8..P 7*./P ///P 8//P 7*./P #!*"其中&.为当前样本的特征向量$/为目标样本的特征向量/改进后的距离公式允许特征向量.)/同时截断为多个子向量#并分别计算距离后再累加/利用此性质#=近邻的求取步骤如下&首先#将每个特征数据列对应的进程划分为一个独立的通信域#通信域内互相广播传递计算距离所需的特征数据块#进而利用公式!*"求取该特征子集下的样本与样本间的距离/其次#在所有通信域完成距离计算后#对于每个特征数据行对应的所有进程进行归约求和操作#归约求和的结果将以样本为单位近似均匀地分配到特征数据行对应的各个进程/由公式!*"的性质可知#部分特征下的距离在归约求和之后即为在所有特征下完整的距离/最后#由于每个进程中均有部分归约求和的结果#且归约求和的结果为该进程中分配的样本到其他样本的完整距离#故对于每个进程#利用所分配样本的距离信息进行=近邻的求取/-,7*后验概率的求取求取后验概率的核心是近邻标签信息的统计#即对某个样本统计其近邻中含有标签*!*$""的个数以及不含有标签*的个数/由于在=近邻的求取步骤中#每个进程已将分配到的样本子集的=近邻求出#故只需在此基础上对近邻的标签信息做统计#然后将统计结果进行全归约求和操作#每个进程即可得到整体的近"$郑州大学学报!理学版"第"#卷邻标签信息统计结果/最后#对于每个进程#根据总的标签信息统计结果计算出后验概率/3*实验与结果分析3,+*性能指标基于T J N将T c B=))算法并行化并未对其精度产生任何影响#故本实验仅从效率的角度考虑运行时间和加速比两项/运行时间指的是训练模型和分类的总时间#不包括读取数据集的时间/加速比用于度量并行算法运行时间和串行算法运行时间的关系#其公式为P<$$FH<’2J1$k*-#$K<J(J**$*k,-:$#其中&2J1$k*-#$为串行程序运行时间$<J(J**$*k,-:$为并行程序运行时间/加速比P<$$FH<越大#并行的效果越好/3,-*数据集本文选用的数据集来源于T6’:3官网的多标签数据集/实验将从样本数量)特征数量两个维度验证并行算法的性能#故选取的数据集如表+所示/此外#由于在实验中调用了开源库#为了避免开源库对稀疏数据优化减少实际的计算量#从而产生实验误差#故对于稀疏表示的数据集>7Y B c2^和X=9+9*#将其去稀疏化并转化为完整表示的数据集/表+!数据集信息9:;0+!<6F F:X a?2I=X8@;8&3&W;126I2??:;:I2;I个数据集训练集样本数测试集样本数特征维度标签个数)7<B fN O>B Z&]+E+A,-+#A,"-"##,+F2?8:F8’’$#--$+*-+C+*#+#+>7Y B c2^+A C+$+-$""###$--$X=9+9*$###$###CA*$E+#+3,3*实验环境本实验使用的T J N编程环境是由++台服务器搭建的真实物理集群#串行实验的运行环境和单服务器配置相同/服务器的处理器为N3;2’i2&3>"B*E*##使用的操作系统为K23;U<E("#T J N的版本为$(+(C#\K K 版本为C(C(A/3,7*实验内容与结果分析本实验主要目的是验证基于T J N并行化后的T c B=))算法在大规模数据集上的适应能力#以及不同数据划分方式对效率的影响#故实验中不考虑=值对T c B=))算法的影响#实验中默认取值为+#/首先#基于多标签学习开源库T6’:3实现了传统的T c B=))算法#基于Ko o线性代数开源库M X F:?8’’&实现了改进的T c B=))算法#以测试串行的T c B=))算法在不同数据集上的效率以及本文提出的改进算法对算法效率的影响/表*描述了基于T6’:3的串行算法和基于M X F:?8’’&的改进算法在表+所述C个数据集上的运行时间/表-!串行T c B=))实验结果9:;0-!Y2I6’;I&W I2H623;8:’T c B=))I数据集训练时间测试时间总耗时T6’:3M X F:?8’’&T6’:3M X F:?8’’&T6’:3M X F:?8’’&)7<B fN O>B Z&]+*A$-"(CE+*"A+,(*CE,C C$#(C#A+A+"-("C#*++,*"(,E,C*,AA(A,EF2?8:F8’’$$+(E*A$+C(+,"+$A(*C-+$#(,#,CE,(,AE CCC(--$>7Y B c2^A*C"(-$$*E,C(""#,*$(C$**-E(,C-,#E-($E"*-,+($--X=9+9*C"E$("#,A*E(AC#C A$#(,$$A*A(#C$-*-C($C++C"$(A,$!!实验结果表明&+"当数据集的规模上升至十万级)特征维度上百时#串行的T c B=))算法很难在可接受的时间内将数据处理下来/*"改进后的T c B=))算法具有更高的效率#在数据规模较大时有更明显的效果#其原因在于改进后的T c B=))算法编写时使用了Koo线性代数开源库M X F:?8’’&#在=近邻的求取时能够更加充分地利用缓存#而=近邻的求取是T c B=))算法时间开销最大的部分#故提升效果较为明显/此外# E$!第$期王!进#等$基于T J N的T c B=))算法并行Koo语言更偏向于底层#相比.:9:语言效率更高/其次#本实验测试了并行后的T c B=))算法在使用不同的计算资源情况下的性能/表$和表C描述了并行算法在表+所述的C个数据集上的运行时间以及加速比/其中<和9分别为特征数据块的列数和行数# P<$$FH<为并行T c B=))算法相对改进后的串行T c B=))算法的加速比/由于本实验是考察算法在不同计算资源上的性能#为了保持统一#故将数据集均以样本为单位切分/表3!并行后的T c B=))在)7<B fN O>B Z&]和F2?8:F8’’上的结果9:;03!Y2I6’;I&Z;:832?]8;1)7<B fN O>B Z&]:3?F2?8:F8’’?:;:I2;节点数<9)7<B fN O>B Z&]F2?8:F8’’训练时间Q I测试时间Q I总耗时Q I加速比训练时间Q I测试时间Q I总耗时Q I加速比+E++E"E*(-,*$-$("C"-"E("*A CC(,*E+#(-$$"(A#-+E(EC**E(A$-$*+$**-C($*$+--(EE$C-$(-,E,E(A--"(A"-$(+A#,(-*-C-(,$E EC+EC+,+(-+++*,("C#$+#(C"++$,(++C$(+E"+(,#A C(-A*,-(C--+*,++*,+EA(CAA++E(E+C*,C(#-++"#(-*-*(-**+(E"A C("A--A(+,+表7!并行后的T c B=))在>7Y B c2^和X=9+9*上的结果9:;07!Y2I6’;I&Z;:832?]8;1>7Y B c2^:3?X=9+9*?:;:I2;节点数<9>7Y B c2^X=9+9*训练时间Q I测试时间Q I总耗时Q I加速比训练时间Q I测试时间Q I总耗时Q I加速比+E++E+C"(ACA$*(+#$+AA(,"#+E(AE$A+(A,-A+(A,++C$("A#+#(+*"$*+$*,*(*-+,+(A+,+EC(##-+,(+A,EC(-+,EC("*E+*-(CCC++(*$# EC+EC AC(E*A C$(+C#++A(AEA*"($+E,+(*A,,+($C*+E*(E*#,(-$-+*,++*,-$(+CA A+(+CA+EC(*-C+,(+CE+$#("#A+$#(#"-*E#("EE"("A-!!实验结果表明&+"程序的运行时间会随着计算资源的增加而减少#这种减少的程度会随着计算资源的增加逐渐变缓/其原因是#随着节点数的增加#通信需要的时间将逼近甚至超过计算所需时间/*"通过对比表$和表C可知#当数据集特征维度较高时#仅以样本为单位划分数据集对整体效率的提升不大#其原因将在后续实验中进行分析/$"根据M F?:1’定律’-(#最理想的并行结果为加速比等于所用核心个数/而本实验中出现加速比大于所使用核心个数的原因是#在串行代码中#计算样本间的距离采用的是向量的运算#当训练集数据量较大时#随之增长的计算量会造成在=:=12中大量的数据替换#导致=:=12命中率降低#从而运行效率较低/而在并行算法中#为了进一步提升算法的效率#使用了矩阵运算替换部分向量计算#减少了计算量#增加了=:=12命中率#因而能够充分利用缓存进一步提升效率/值得一提的是#如果直接在串行算法中使用矩阵运算替换向量运算可能会导致单机内存不足的问题/以)7<B fN O>B Z&]数据集为例#如果直接使用矩阵运算的方式计算训练集的近邻矩阵#需要占用大约+-"\的内存/C"基于T6’:3的串行T c B=))算法和本文提出的并行T c B=))算法在表+所述C个数据集上的输出结果是一致的#验证了本文对T c B=))算法的改进以及并行化并未影响T c B=))算法的精度/最后#本实验测试了在计算资源相同的情况下#不同数据切分方式对并行T c B=))算法性能的影响/实验结果表明&在计算资源一定的情况下#相比单一的以样本为单位划分数据集#本文提出方法不仅可以将数据集以样本为单位划分#也能以特征为单位划分#这使得在处理高维数据的时候#本文方法具有更大的优势/7*总结本文提出了一种基于T J N编程模型的T c B=))算法并行方法/在保证T c B=))算法精度不受损的情况下#改进了T c B=))算法并提升了算法的效率/实验结果表明#本文提出的方法可以灵活针对数据集的特点改变数据集的切分方式#在大规模数据集上适应性更强/因此#本文的方法是可行且高效的/A$,$郑州大学学报!理学版"第"#卷参考文献!’+(!\Y M d M T B Y U f>O#\U c O<P U)O#O U K P U Y U f K#2;:’/D84?:;:&I=823=283;12@2;:Za;22X:’.(/):;6X2#*##,#C""!A*#-"&,V-/’*(!fd N P>P#K7P P N)\O/d:?&&@&;12?2W838;892468?2’.(/U j X28’’aF2?8:83=4X:923I;2831841]:a3&X;1#*#+*#*+"!++"& +V C/’$(!0M d M Y N MT#K d U fO d7Y eT#O M<P#2;:’/Y2I8’823;?8I;X8Z6;2??:;:I2;I&:W:6’;B;&’2X:3;:ZI;X:=;8&3W&X83B F2F&X a=’6I;2X =&F@6;834’K(Q Q J X&=22?834I&W;12-;17<>)N iK&3W2X23=2&3)2;]&X[2?<a I;2F I O2I843:3?N F@’2F23;:;8&3/<:3.&I2#K M# *#+*&*/’C(!fM c S>YOf#O U)\M Y Y M../T J N&:I;:3?:X?F2I I:42@:I I83483;2X W:=2’.(/<6@2X=&F@6;2X#+--E#+*&"E V E,/’"(!王青#谭良#杨显华/基于<@:X[的M@X8&X8并行算法优化实现’.(/郑州大学学报!理学版"#*#+E#C,!C"&E#V EC/’E(!Y>e><B U Y P N0.c#U)>P U c#M)\7N P M O/D84?:;::3:’a;8=I83;12=’&6?&I@:X[&31:?&&@9I F@8Q&@23F@&3Z2&]6’W ’.(/J X&=2?8:=&F@6;2X I=823=2#*#+"#"$&+*+V+$#/’A(!0d M)\T c#0d U70d/MX2982]&3F6’;8B’:Z2’’2:X3834:’4&X8;1F I’.(/N>>>;X:3I:=;8&3I&3[3&]’2?42:3??:;:2348322X B 834#*#+C#*E!,"&+,+-V+,$A/’,(!0d M)\T c#0d U70d/T c B=))&:’:5a’2:X3834:@@X&:=1;&F6’;8B’:Z2’’2:X3834’.(/J:;;2X3X2=&438;8&3#*##A#C#!A"& *#$,V*#C,/’-(!M T O M d c\T/%:’8?8;a&W;12I834’2@X&=2I I&X:@@X&:=1;&:=1829834’:X42I=:’2=&F@6;834=:@:Z8’8;82I’K(Q Q J X&=22?834I&W <@X834.&83;K&F@6;2X K&3W2X23=2/)2]e&X[&M K T#+-EA&C,$V C,"/%:>:F F5F.U:4.A=AG CN1,I I$:@5EA=C%(fM)\.83+#e M)<18[:8+#\M Ue:3a6+#.N)c8^8&34*#d7T834^834$#O>)\i83+#K d>)g8:&I&34+ !+(D Q.#R9-#R S$3IJ2.(J,.(3.)D.:<H,J,-.#J*T#,$**-R$#+$#D Q.#R9-#R E#-0$(1-,3.)&.1,1J#F M$*$+.::H#-+J,-.#1#D Q.#R9-#R C###E"#D Q-#J$*(D Q-#J D.:1$(0-+$^$#@Q.H D.#1,(H+,-.#D.5#I,F#^$#@Q.H$*"####D Q-#J$$(W H##J#P+-$#+$!$1$J(+Q T#1,-,H,$.)D.::H#-+J,-.#_M(J#1<.(,J,-.##S H#:-#R E"##++#D Q-#J"#;@4>:B4&P12T c B=)):’4&X8;1F]:I@:X:’’2’852?Za T J N!F2I I:42@:I I83483;2X W:=2"/N;:8F2?;&8’B ’6I;X:;2;12=’:I I8W8=:;8&3@X&Z’2F&W’:X42B I=:’2?:;::3?=&3;X&’;12=&F@6;:;8&3&W&92X12:?;8F2/N;]:I :’I&;12W8X I;;8F2;&:@@’aT J N83;&F6’;8B’:Z2’’2:X3834:X2:/M==&X?834;&;X:?8;8&3:’=&3;X:I;2^@2X8B F23;I:Z&6;I2X8:’T c B=))#8;92X8W82?;12W2:I8Z8’8;a:3?2W W2=;89232I I&W;12:’4&X8;1F]18=1]:I@X&98?B 2?/N;]:I]&X;1a F23;8&32?;1:;;12X2]2X2I&F2F2;1&?I]18=1=&6’?F:[2;12@:X;8;8&3&W?:;:I2;?62 ;&W2:;6X2B Z:I2?638;/N;F841;12’@@2&@’2;&42;F&X2;X2F23?&6I:?9:3;:42]123?2:’834]8;11841?8B F23I8&3:’?:;:/L5M J A>E@&F:=1832’2:X3834$F6’;8B’:Z2’’2:X3834$@:X:’’2’=&F@6;834$T c B=))$T J N!责任编辑&王海科"。

最大最小蚁群算法初始化信息素蚁群算法是一种模拟自然界蚂蚁觅食行为的优化算法,其应用广泛,尤其在组合优化问题中表现出色。

其中,最大最小蚁群算法是一种改进的蚁群算法,其初始化信息素的设置对算法的性能有着重要的影响。

一、蚁群算法简介蚁群算法是一种基于蚂蚁觅食行为的优化算法,其核心思想是模拟蚂蚁在寻找食物时的行为。

蚂蚁在寻找食物时,会释放一种化学物质——信息素,其他蚂蚁会根据信息素的浓度来选择路径。

在蚁群算法中,信息素的浓度代表路径的优劣程度,蚂蚁会根据信息素浓度选择路径,从而找到最优解。

二、最大最小蚁群算法最大最小蚁群算法是一种改进的蚁群算法,其核心思想是在蚂蚁的选择过程中,引入最大最小值限制,从而避免算法陷入局部最优解。

在最大最小蚁群算法中,每只蚂蚁会根据信息素浓度和路径长度来选择路径,同时,算法会记录最大和最小信息素浓度,以保证算法的全局搜索能力。

三、初始化信息素的设置初始化信息素的设置对最大最小蚁群算法的性能有着重要的影响。

一般来说,初始化信息素的值应该足够小,以避免算法过早陷入局部最优解。

同时,为了保证算法的全局搜索能力,初始化信息素的值应该足够大,以保证算法能够在搜索空间中进行有效的探索。

在实际应用中,可以采用以下两种方法来设置初始化信息素的值:1. 均匀分布法:将初始化信息素的值均匀分布在一个较小的范围内,例如[0,1]。

这种方法可以保证算法的全局搜索能力,但是需要进行多次试验来确定最佳的初始化信息素范围。

2. 启发式方法:根据问题的特点,设置合适的初始化信息素值。

例如,在TSP问题中,可以将初始化信息素设置为1/n,其中n为城市的数量。

这种方法可以提高算法的收敛速度,但是需要对问题有一定的了解。

四、总结最大最小蚁群算法是一种优秀的优化算法,其初始化信息素的设置对算法的性能有着重要的影响。

在实际应用中,可以采用均匀分布法或启发式方法来设置初始化信息素的值。

通过合理的初始化信息素设置,可以提高算法的全局搜索能力和收敛速度,从而得到更优的解。

MPI在大规模并行计算中的应用一、MPI的介绍MPI(Message Passing Interface)是一种消息传递接口标准,用于在多个计算节点之间进行通信和数据传递。

MPI的出现极大地推动了科学计算和工程计算的大规模并行化和分布式计算。

MPI 有多种实现,如MPICH、OpenMPI和MVAPICH等。

二、MPI的工作原理MPI的工作原理是基于点对点通信,即两个节点之间的通信。

通信方式分为同步和异步两种。

同步通信是指发送方将数据发送到接收端并等待接收端接收,然后才继续执行后续操作。

异步通信则是发送方将数据发送给接收方,而不等待接收端接收,然后就可以继续执行后续操作。

三、MPI在大规模并行计算中广泛应用,如天气预测、生物制药、核物理、空气动力学等领域。

以下是介绍MPI在大规模并行计算中的应用:1. 生物制药生物制药的工艺流程非常复杂,需要处理大量的数据和复杂算法。

MPI可以实现多个生物反应器之间的并行计算,加速反应速率和节省计算时间,同时保证结果的准确性和可靠性。

例如,在DNA分子建模中,MPI可以将一份任务分配给多个计算节点,以提高计算速度。

2. 天气预测天气预测需要处理大量气象数据,包括风速、温度、湿度等。

MPI可以将这些数据分配给计算节点进行处理,以减少计算时间和提高准确性。

例如,在大气模型预测方面,MPI可以将模型分散到多个节点中进行模拟,模拟结果交换并合并成一个预测结果。

3. 核物理在核物理领域,MPI可以实现大规模的数据交换和复杂算法计算。

例如,MPI可以处理以太核物质的模拟和分析,以提高核物理实验的效率和准确性。

4. 空气动力学在航空航天工程中,MPI可以模拟航空器受到的气动力,提高航天飞行器的效率和性能。

例如,在飞机设计方面,MPI可以将模拟数据分配到多个计算节点上进行分析和计算,以提高计算速度和准确性。

四、本文的结论MPI在大规模并行计算中有着广泛的应用,可以提高计算速度和准确性,同时保证数据的可靠性。

并行计算实验报告——密码猜解专业班级学生指导教师一实验题目利用MPI并行猜解密码二实验目的随机输入一个六位数的密码,通过MD5哈希算法首先计算出加密后的密码,然后再次利用MD5哈希算法比对加密数据库,猜解出之前输入的密码。

三实验环境MPI、VS2010(1)MPIMPI是指Message Passing Interface,是一种消息传递函数库的标准规范,由MPI论坛开发。

是一种新的库描述,不是一种语言。

共有上百个函数调用接口,在C语言中可直接对这些函数调用。

MPI 是一种标准或规范的代表,而不是特指某一个对他的具体实现,是一种消息传递编程模型,并成为这种编程模型的代表和事实上的标准。

MPI具有高移植性,MPI已在IBM PC机上,MS Windows上,所有主要的Unix工作站和所有主流的并行机上得到实现。

下面是MPI的主要编程接口:(2)VS2010VS是Microsoft Visual Studio的缩写,是一个基本完整的开发工具集,它包括了整个软件生命周期中所需要的大部分工具,如UML 工具、代码管控工具、集成开发环境(IDE)等等。

我们这里是用VS 中支持C的特性来进行编程。

四实验原理在针对某个问题设计算法时,我们通常都会提到串行算法和并行算法。

串行计算主要是指设计的算法串行执行,即可以理解为只有一个处理器,所有的任务都是一个一个完成的;而并行计算就是在并行计算机或者分布式计算机等高性能计算系统上所做的超级计算,它的物质基础是高性能并行计算机。

这里也要指出的问题是,针对同一个问题,它的并行设计和串行设计的执行时间在很大程度上是有区别的,通常情况下,并行的时间往往少于串行执行时间,也就是说并行的执行效率比较高。

但是,也会出现相反的情况,并行没有达到我们的期望,这种情况可能与数据量、执行环境以及并行的程度都有关系,这个问题我们随着本实验的实际情况做个实际讨论。

五实验内容(1)实验问题描述:密码由6位数字组成,通过用户输入,然后使用MD5加密后保存,(MD5加密一次或多次)。