自组织特征映射神经网络讲解

- 格式:ppt

- 大小:974.00 KB

- 文档页数:20

基于自组织特征映射网络矢量量化图像压缩的研究与实现摘要:在介绍矢量化和自组织特征映射神经网络的基础上,针对基于自组织特征映射神经网络的矢量化算法,在初始码书生成、获胜神经元搜索以及学习速率调整等方面对图像压缩进行研究。

结果表明,采用矢量量化方法进行图像压缩,可以在获得较高压缩比的同时,得到较好的恢复图像质量。

关键词:自组织特征映射;矢量量化;码书;图像压缩1 自组织特征映射网络(SOFM)自组织特征映射网络(SOFM)是自组织网络中的一种,所谓的自组织过程是指学习的结果总是使聚类区内各神经元的权重向量保持向输入向量逼近的趋势,从而使具有相近特性的输入向量聚集在一起。

SOFM能够根据输入信息找出规律及相应联系,并根据这些规律对网络做出相应的调节,使输出结果与之适应。

1.1 SOFM基本思想自组织特征映射(SOFM)最早是由芬兰赫尔辛基大学的Teuvo Kohonen于1981年提出的。

他认为神经元的有序排列可以反映出外界刺激的某些物理特性。

当神经网络接受外界输入模式时, 其会自动分成各个区域,这些区域对输入模式具有不同的响应特点。

各神经元权值具有一定的分布,对于那个获胜神经元g ,在其周围的Ng 区域内,神经元在不同程度上都得到兴奋,而在Ng以外的神经元都被抑制。

获胜神经元不但加强自身, 而且使邻近神经元也得到相应加强, 同时抑制较远的神经元。

这时与竞争层相应节点连接的权值向量就向输入模式的方向修正。

这样,通过不断地调整权值,使每一邻域的所有节点对某种输入具有类似的输出。

因此,SOFM网络的输出状况,不但能判断输入模式所属的类别并使输出节点代表某一模式,还能够得到整个数据区域的大体分布情况。

1.2 SOFM网络模型结构大多数生物的大脑皮层中,神经元的输入信号一部分来自同一区域的反馈信号,另一部分来自感觉组织或其他区域的外部输入信号。

每一神经元接收到的输入信号的加权起特征检测作用,而侧向反馈连接则根据其与神经元距离的不同产生激励或抑制作用。

MATLAB中常见的神经网络模型介绍神经网络是一种模拟生物神经网络工作机制的数学模型。

它由许多人工神经元组成,这些神经元之间存在着连接,通过学习和优化,神经网络能够模拟和处理各种复杂的输入输出关系。

在MATLAB中,有许多常见的神经网络模型可供使用,下面将介绍其中几个。

一、前馈神经网络(Feedforward Neural Network)前馈神经网络是最常见和基本的神经网络模型之一。

它的结构由多层神经元组成,每一层的神经元与下一层的神经元完全连接,信号只能从输入层传输到输出层,不会反向传播。

前馈神经网络适用于分类、回归等问题。

在MATLAB中,创建一个前馈神经网络可以使用“feedforwardnet”函数。

可以设置隐藏层的大小、传递函数类型、训练算法等参数。

通过训练数据,可以使用MATLAB提供的各种优化算法进行网络模型的训练和预测。

二、循环神经网络(Recurrent Neural Network)循环神经网络是一种具有回路结构的神经网络模型。

它的每一个神经元都接受来自上一时刻输出的信号,并将当前的输入和上一时刻的输出作为输入,进行计算。

循环神经网络能够处理具有时序关系的数据,例如序列预测、语言模型等。

在MATLAB中,创建一个循环神经网络可以使用“layrecnet”函数。

可以设置回路层的大小、传递函数类型、训练算法等参数。

通过训练数据,同样可以使用MATLAB提供的优化算法进行网络模型的训练和预测。

三、自组织映射网络(Self-Organizing Map)自组织映射网络是一种无监督学习的神经网络模型。

它通过将输入数据投影到一个低维的节点空间中,并学习节点之间的拓扑结构。

自组织映射网络在数据聚类、特征提取等领域有广泛的应用。

在MATLAB中,创建一个自组织映射网络可以使用“selforgmap”函数。

可以设置节点空间的维度、拓扑结构、距离度量等参数。

通过输入数据,可以使用MATLAB提供的训练算法进行网络模型的训练和预测。

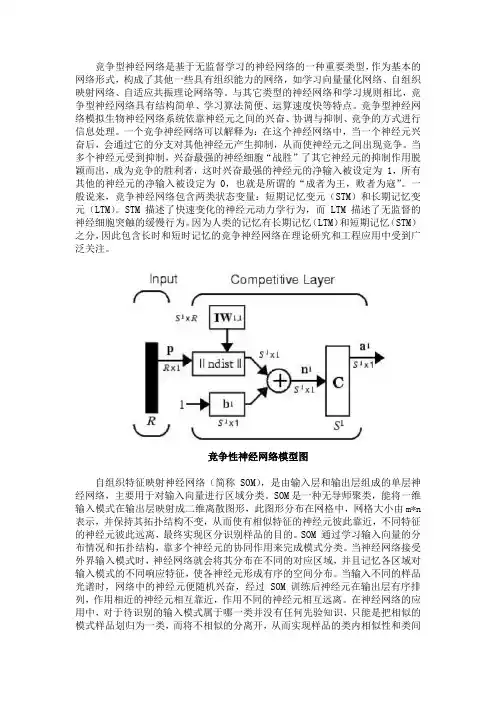

竞争型神经网络是基于无监督学习的神经网络的一种重要类型,作为基本的网络形式,构成了其他一些具有组织能力的网络,如学习向量量化网络、自组织映射网络、自适应共振理论网络等。

与其它类型的神经网络和学习规则相比,竞争型神经网络具有结构简单、学习算法简便、运算速度快等特点。

竞争型神经网络模拟生物神经网络系统依靠神经元之间的兴奋、协调与抑制、竞争的方式进行信息处理。

一个竞争神经网络可以解释为:在这个神经网络中,当一个神经元兴奋后,会通过它的分支对其他神经元产生抑制,从而使神经元之间出现竞争。

当多个神经元受到抑制,兴奋最强的神经细胞“战胜”了其它神经元的抑制作用脱颖而出,成为竞争的胜利者,这时兴奋最强的神经元的净输入被设定为 1,所有其他的神经元的净输入被设定为 0,也就是所谓的“成者为王,败者为寇”。

一般说来,竞争神经网络包含两类状态变量:短期记忆变元(STM)和长期记忆变元(LTM)。

STM 描述了快速变化的神经元动力学行为,而 LTM 描述了无监督的神经细胞突触的缓慢行为。

因为人类的记忆有长期记忆(LTM)和短期记忆(STM)之分,因此包含长时和短时记忆的竞争神经网络在理论研究和工程应用中受到广泛关注。

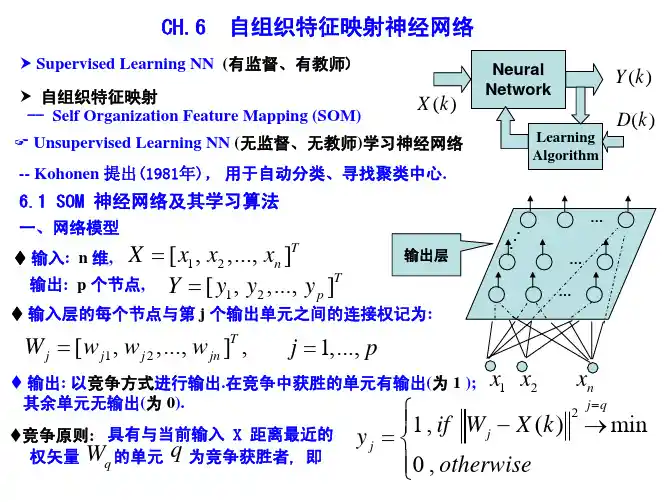

竞争性神经网络模型图自组织特征映射神经网络(简称SOM),是由输入层和输出层组成的单层神经网络,主要用于对输入向量进行区域分类。

SOM是一种无导师聚类,能将一维输入模式在输出层映射成二维离散图形,此图形分布在网格中,网格大小由m*n 表示,并保持其拓扑结构不变,从而使有相似特征的神经元彼此靠近,不同特征的神经元彼此远离,最终实现区分识别样品的目的。

SOM 通过学习输入向量的分布情况和拓扑结构,靠多个神经元的协同作用来完成模式分类。

当神经网络接受外界输入模式时,神经网络就会将其分布在不同的对应区域,并且记忆各区域对输入模式的不同响应特征,使各神经元形成有序的空间分布。

当输入不同的样品光谱时,网络中的神经元便随机兴奋,经过SOM 训练后神经元在输出层有序排列,作用相近的神经元相互靠近,作用不同的神经元相互远离。

SOFM网络的工作原理是:当网络接受外界输入模式时,将会分为不同的区域,各区域对输入模式具有不同的响应特征。

也就是说,特征相近的输入模式靠得比较近,差异大的分得比较远。

在各神经元联接权值的调整过程中,最邻近的神经元相互刺激,而较远的神经元则相互抑制,更远一些的则具有较弱的刺激作用。

输入层所有神经元通过相互竞争和自适应学习,形成空间上的有序结构,从而实现输入矢量到输出矢量空间的特征映射。

SOFM的学习则使网络节点有选择地接受外界刺激模式的不同特性,从而提供了基于检测特性空间活动规律的性能描述。

其实,SOFM的学习过程就是在某个学习准则的指导下,逐步优化网络参数的过程。

该网络分为输入层和竞争层两层。

两层之间实行全互连。

它将任意维输入模式在输出层映射成一维或二维离散图形,并保持其拓扑结构不变。

在竞争层中,让竞争获胜的那个神经元c的兴奋程度最高,并使其周围VBc的区域内的神经元在不同程度上都得到兴奋,VBc是时间的函数,随着时间的增加,NBc的范围不断的减小,通过图可以直观的看出来。

SOFM的算法流程见图从上述算法可以看出,网络训练完毕后,各输出单元对应一个权值。

在分类过程中,每个分类对象必与其中一个权值的距离最近,把与同一输出单元的权值最近的点作为同一类,并由该输出单元输出,即达到了分类的目的。

SOFM分类算法:步骤1:对图像数据作归一化处理,将各点象素值归一化到区间[0,1]内,由此得到图像X=(x 1,x 2,…x n ),其中x i 为图像一点的归一化后的模式.步骤2:初始化网络连接权值W j ,其中1<=j<=M ,M 对应竞争层神经元向量元素的个数。

步骤3:选择获胜单元c,d c =j min ||x i -w j ||.步骤4:进行连接权调整邻域函数一般选用Gaussian 函数:NB(t)=exp{-d j,i (x)2)/2σ2}其中d j,i (x)表示邻域中神经元与获胜神经元间的距离,采用Euclid 距离计算;σ为邻域的有效半径,随离散时间指数衰减σ(t)=σ(0).exp(-t/τ1),t=0,1,2,∀,j=1,2,…m 的初始值,τ1为时间常数,σ(0)是σ(t)的初始值. 步骤5:按照以上步骤,反复训练每一个输入的模式值x i ,直至完成规定的训练次数.经过学习后,再次将x i 输入网络,其输出结果即为分类结果。

神经网络的特点分析神经网络的特点分析(1)神经网络的一般特点作为一种正在兴起的新型技术神经网络有着自己的优势,他的主要特点如下:①由于神经网络模仿人的大脑,采用自适应算法。

使它较之专家系统的固定的推理方式及传统计算机的指令程序方式更能够适应化环境的变化。

总结规律,完成某种运算、推理、识别及控制任务。

因而它具有更高的智能水平,更接近人的大脑。

②较强的容错能力,使神经网络能够和人工视觉系统一样,根据对象的主要特征去识别对象。

③自学习、自组织功能及归纳能力。

以上三个特点是神经网络能够对不确定的、非结构化的信息及图像进行识别处理。

石油勘探中的大量信息就具有这种性质。

因而,人工神经网络是十分适合石油勘探的信息处理的。

(2)自组织神经网络的特点自组织特征映射神经网络作为神经网络的一种,既有神经网络的通用的上面所述的三个主要的特点又有自己的特色。

①自组织神经网络共分两层即输入层和输出层。

②采用竞争学记机制,胜者为王,但是同时近邻也享有特权,可以跟着竞争获胜的神经元一起调整权值,从而使得结果更加光滑,不想前面的那样粗糙。

③这一网络同时考虑拓扑结构的问题,即他不仅仅是对输入数据本身的分析,更考虑到数据的拓扑机构。

权值调整的过程中和最后的结果输出都考虑了这些,使得相似的神经元在相邻的位置,从而实现了与人脑类似的大脑分区响应处理不同类型的信号的功能。

④采用无导师学记机制,不需要教师信号,直接进行分类操作,使得网络的适应性更强,应用更加的广泛,尤其是那些对于现在的人来说结果还是未知的数据的分类。

顽强的生命力使得神经网络的应用范围大大加大。

1.1.3自组织神经网络相对传统方法的优点自组织特征映射神经网络的固有特点决定了神经网络相对传统方法的优点:(1)自组织特性,减少人为的干预,减少人的建模工作,这一点对于数学模型不清楚的物探数据处理尤为重要,减少不精确的甚至存在错误的模型给结果带来的负面影响。

(2)强大的自适应能力大大减少了工作人员的编程工作,使得被解放出来的处理人员有更多的精力去考虑参数的调整对结果的影响。

第6章自组织特征映射本章介绍Kohonen的自组织特征映射(Self-Organizing Feature Mapping,简称SOFM)[Koho1984]。

自组织特征映射是一种竞争学习网络,可以通过神经元之间的竞争实现大脑神经系统中的“近兴奋远抑制”功能,并具有把高维输入映射到低维的能力(拓扑保形特性)。

我们先介绍生物系统中的竞争现象,然后介绍SOFM的网络结构和学习算法,最后通过仿真例子演示SOFM的拓扑保形特性。

6.1 生物系统中的竞争在第4章介绍RBF网的生理学基础时,我们曾提到,某些视觉神经细胞在视网膜上有特定的感受野,并具有近兴奋远抑制(on-center off-surround)功能,因此我们用径向基函数建模这样的近兴奋远抑制神经元。

在本章,我们从神经元之间互相竞争的角度再来看这一现象。

生物神经网络的研究发现,大脑皮层中,神经元是呈2维空间排列的,而且邻近神经元之间通过侧反馈的方式紧密互联。

因此每个神经元既有外部区域的输入信号,也有来自同一区域其它神经元的反馈输入信号。

而邻近神经元之间侧反馈信号的强度体现为这些神经元之间的连接强度,因此而这些连接权值的分布也体现出明显的“近兴奋远抑制”现象。

更具体的说,以某个激活的神经元为圆心,邻近其它神经元根据与该神经元的距离,与之的连接权值呈三个区域的分布:对较邻近的神经元呈强的兴奋性侧反馈;对远邻的神经元呈抑制性侧反馈;对更远的神经元又呈弱的兴奋性侧反馈。

通常情况下,可以不考虑第三区的弱侧反馈。

这里所说的邻近神经元,在大脑皮层中是指以某兴奋神经元为圆心.半径约为50-500µm左右的其它神经元,而远邻神经元是指半径为200µm-2mm左右的神经元。

(a)(b)图6.1 生物神经元中的“近兴奋远抑制”另外,神经元之间连接强度从增强到抑制的过渡是平滑的,因此相邻神经元连接强1度的分布呈“墨西哥帽”式分布,如图6.1(a)所示。

自组织映射(self-organizing feature mapping)自组织神经网络SOM(self-organization mapping net)是基于无监督学习方法的神经网络的一种重要类型。

自组织映射网络理论最早是由芬兰赫尔辛基理工大学Kohen于1981年提出的。

此后,伴随着神经网络在20世纪80年代中后期的迅速发展,自组织映射理论及其应用也有了长足的进步。

它是一种无指导的聚类方法。

它模拟人脑中处于不同区域的神经细胞分工不同的特点,即不同区域具有不同的响应特征,而且这一过程是自动完成的。

自组织映射网络通过寻找最优参考矢量集合来对输入模式集合进行分类。

每个参考矢量为一输出单元对应的连接权向量。

与传统的模式聚类方法相比,它所形成的聚类中心能映射到一个曲面或平面上,而保持拓扑结构不变。

对于未知聚类中心的判别问题可以用自组织映射来实现。

[1]自组织神经网络是神经网络最富有魅力的研究领域之一,它能够通过其输入样本学会检测其规律性和输入样本相互之间的关系,并且根据这些输入样本的信息自适应调整网络,使网络以后的响应与输入样本相适应。

竞争型神经网络的神经元通过输入信息能够识别成组的相似输入向量;自组织映射神经网络通过学习同样能够识别成组的相似输入向量,使那些网络层中彼此靠得很近的神经元对相似的输入向量产生响应。

与竞争型神经网络不同的是,自组织映射神经网络不但能学习输入向量的分布情况,还可以学习输入向量的拓扑结构,其单个神经元对模式分类不起决定性作用,而要靠多个神经元的协同作用才能完成模式分类。

学习向量量化LVQ(learning vector quantization)是一种用于训练竞争层的有监督学习(supervised learning)方法。

竞争层神经网络可以自动学习对输入向量模式的分类,但是竞争层进行的分类只取决于输入向量之间的距离,当两个输入向量非常接近时,竞争层就可能把它们归为一类。