决策树详细易懂,很多例子

- 格式:pptx

- 大小:1.89 MB

- 文档页数:50

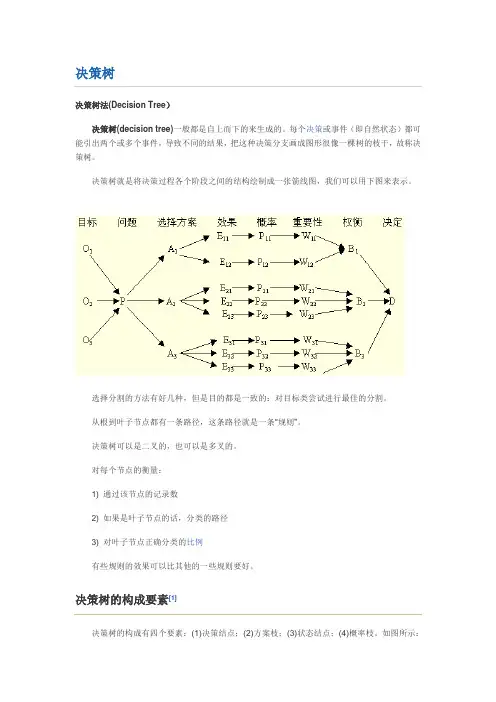

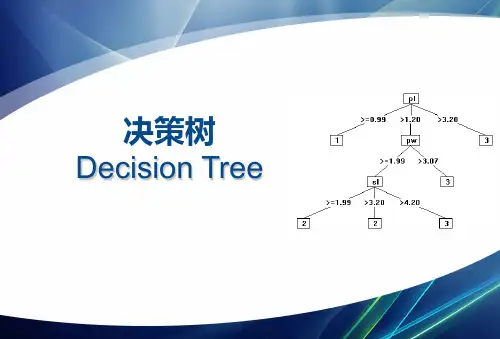

决策树决策树法(Decision Tree)决策树(decision tree)一般都是自上而下的来生成的。

每个决策或事件(即自然状态)都可能引出两个或多个事件,导致不同的结果,把这种决策分支画成图形很像一棵树的枝干,故称决策树。

决策树就是将决策过程各个阶段之间的结构绘制成一张箭线图,我们可以用下图来表示。

选择分割的方法有好几种,但是目的都是一致的:对目标类尝试进行最佳的分割。

从根到叶子节点都有一条路径,这条路径就是一条“规则”。

决策树可以是二叉的,也可以是多叉的。

对每个节点的衡量:1) 通过该节点的记录数2) 如果是叶子节点的话,分类的路径3) 对叶子节点正确分类的比例有些规则的效果可以比其他的一些规则要好。

决策树的构成要素[1]决策树的构成有四个要素:(1)决策结点;(2)方案枝;(3)状态结点;(4)概率枝。

如图所示:总之,决策树一般由方块结点、圆形结点、方案枝、概率枝等组成,方块结点称为决策结点,由结点引出若干条细支,每条细支代表一个方案,称为方案枝;圆形结点称为状态结点,由状态结点引出若干条细支,表示不同的自然状态,称为概率枝。

每条概率枝代表一种自然状态。

在每条细枝上标明客观状态的内容和其出现概率。

在概率枝的最末稍标明该方案在该自然状态下所达到的结果(收益值或损失值)。

这样树形图由左向右,由简到繁展开,组成一个树状网络图。

决策树对于常规统计方法的优缺点优点:1)可以生成可以理解的规则;2)计算量相对来说不是很大;3) 可以处理连续和种类字段;4) 决策树可以清晰的显示哪些字段比较重要。

缺点:1) 对连续性的字段比较难预测;2) 对有时间顺序的数据,需要很多预处理的工作;3) 当类别太多时,错误可能就会增加的比较快;4) 一般的算法分类的时候,只是根据一个字段来分类。

决策树的适用范围[1]科学的决策是现代管理者的一项重要职责。

我们在企业管理实践中,常遇到的情景是:若干个可行性方案制订出来了,分析一下企业内、外部环境,大部分条件是己知的,但还存在一定的不确定因素。

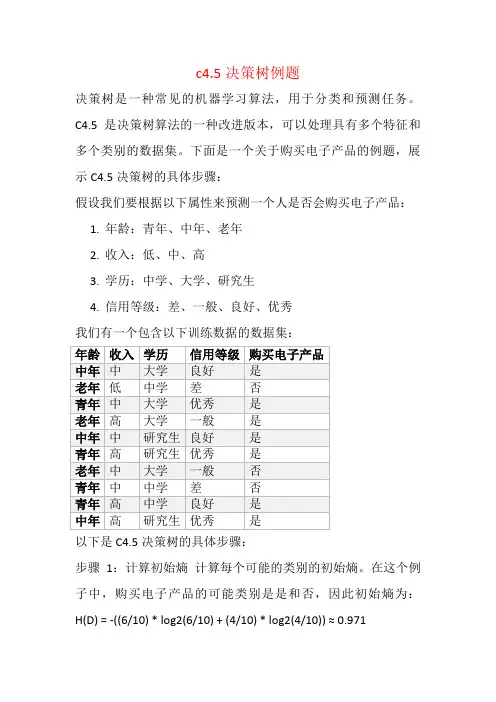

c4.5决策树例题决策树是一种常见的机器学习算法,用于分类和预测任务。

C4.5是决策树算法的一种改进版本,可以处理具有多个特征和多个类别的数据集。

下面是一个关于购买电子产品的例题,展示C4.5决策树的具体步骤:假设我们要根据以下属性来预测一个人是否会购买电子产品:1.年龄:青年、中年、老年2.收入:低、中、高3.学历:中学、大学、研究生4.信用等级:差、一般、良好、优秀我们有一个包含以下训练数据的数据集:以下是C4.5决策树的具体步骤:步骤1:计算初始熵计算每个可能的类别的初始熵。

在这个例子中,购买电子产品的可能类别是是和否,因此初始熵为:H(D) = -((6/10) * log2(6/10) + (4/10) * log2(4/10)) ≈ 0.971步骤2:计算每个属性的信息增益计算每个属性的信息增益(即使用该属性进行划分后的熵的减少量)。

对于每个属性,计算其每个可能值的条件熵,并将其与初始熵进行比较来计算信息增益。

具体步骤如下:a) 对于属性"年龄",计算其各个值的条件熵:•年龄=青年:购买(2是, 2否),条件熵=-((2/4) * log2(2/4) + (2/4) * log2(2/4)) = 1.0•年龄=中年:购买(3是, 1否),条件熵=-((3/4) * log2(3/4) + (1/4) * log2(1/4)) ≈ 0.811•年龄=老年:购买(1是, 1否),条件熵=-((1/2) * log2(1/2) + (1/2) * log2(1/2)) = 1.0然后,计算年龄属性的信息增益:Gain(年龄) = H(D) - ((4/10) *1.0 + (4/10) * 0.811 + (2/10) * 1.0) ≈ 0.124b) 对于属性"收入",计算其各个值的条件熵:•收入=低:购买(1是, 1否),条件熵=-((1/2) * log2(1/2) + (1/2) * log2(1/2)) = 1.0•收入=中:购买(3是, 1否),条件熵=-((3/4) * log2(3/4) + (1/4) * log2(1/4)) ≈ 0.811•收入=高:购买(2是, 2否),条件熵=-((2/4) * log2(2/4) + (2/4) * log2(2/4)) = 1.0然后,计算收入属性的信息增益:Gain(收入) = H(D) - ((2/10) * 1.0 + (4/10) * 0.811 + (4/10) * 1.0) ≈ 0.291c) 对于属性"学历",计算其各个值的条件熵:•学历=中学:购买(1是, 1否),条件熵=-((1/2) * log2(1/2) + (1/2) * log2(1/2)) = 1.0•学历=大学:购买(3是, 2否),条件熵=-((3/5) * log2(3/5) + (2/5) * log2(2/5)) ≈ 0.971•学历=研究生:购买(3是, 1否),条件熵=-((3/4) * log2(3/4) + (1/4) * log2(1/4)) ≈ 0.811然后,计算学历属性的信息增益:Gain(学历) = H(D) - ((2/10) *1.0 + (5/10) * 0.971 + (3/10) * 0.811) ≈ 0.128d) 对于属性"信用等级",计算其各个值的条件熵:•信用等级=差:购买(0是, 1否),条件熵=0•信用等级=一般:购买(1是, 1否),条件熵=-((1/2) * log2(1/2) + (1/2) * log2(1/2)) = 1.0•信用等级=良好:购买(2是, 1否),条件熵=-((2/3) * log2(2/3) + (1/3) * log2(1/3)) ≈ 0.918•信用等级=优秀:购买(3是, 1否),条件熵=-((3/4) * log2(3/4) + (1/4) * log2(1/4)) ≈ 0.811然后,计算信用等级属性的信息增益:Gain(信用等级) = H(D) - ((1/10) * 0 + (2/10) * 1.0 + (3/10) * 0.918 + (4/10) * 0.811) ≈ 0.115步骤3:选择信息增益最大的属性作为当前节点的划分属性根据信息增益,选择信息增益最大的属性作为当前节点的划分属性。

举例说明决策树的预测过程-回复决策树是一种广泛应用于各个领域的机器学习算法,其能够通过一系列的问题和条件判断来预测未知数据的分类或结果。

下面,我将详细解释决策树的预测过程,并通过一个具体的例子来说明。

决策树是一种基于树状结构的模型,其主要分为两个步骤:训练和预测。

训练过程是通过已有的数据集来构建决策树模型,而预测过程则是利用训练好的模型对未知数据进行分类或结果预测。

在训练过程中,决策树通过分析数据集的特征和标签之间的关系来构建树形结构。

下面我们以一个医疗诊断的例子来说明。

假设我们有一个数据集,其中包含了患者的年龄、性别、体温、症状等特征,以及最终的诊断结果(例如感冒、流感等)。

我们的目标是构建一个决策树模型,能够根据患者的特征来预测其最可能的诊断结果。

首先,我们需要选择一个合适的特征作为根节点,以便将数据集分成更小的子集。

常见的选择方法有信息增益、基尼指数等,这些方法可以评估一个特征的重要性。

假设我们选择了年龄作为根节点。

接下来,我们根据年龄的不同取值(例如0-10岁、11-20岁等)将数据集划分成子集。

对于每个子集,我们需要继续选择一个特征作为节点,以便进一步细分数据。

假设我们选择了体温作为第二层的节点。

对于每个年龄段的数据子集,我们可以根据不同的体温范围(例如正常、发烧等)来进行划分。

继续进行下去,我们可以一直选择新的特征作为节点,直到满足某个停止条件(例如子集中的样本数量小于某个阈值,或者所有样本都属于同一类别)为止。

最终得到一个树状结构,即我们的决策树模型。

接下来,我们可以使用训练好的决策树模型来预测未知数据。

预测过程可以通过沿着树的路径从根节点开始进行。

根据每个节点的特征和条件判断,我们可以选择相应的分支继续向下走,直到到达叶节点。

例如,假设我们要对一个年龄为15岁、体温为37.5度的患者进行诊断。

我们可以根据根节点的条件判断,如果患者年龄小于10岁,则进入左侧分支;否则进入右侧分支。

cart决策树例题简单案例决策树是一种常用的机器学习算法,可以用于分类和回归问题。

它通过对特征进行划分来建立一个树状的决策流程,从而对新的样本进行预测或分类。

在本文中,我们将通过一个简单的案例来介绍决策树的基本原理和应用。

假设我们有一个购物车数据集,其中包含了一些特征和对应的标签。

我们的目标是根据这些特征来预测一个购物车是否会购买商品。

首先,我们需要加载数据集并进行数据预处理。

数据预处理的目的是将原始数据转换为适用于决策树算法的格式。

我们可以使用Python的pandas库来完成这些任务。

```pythonimport pandas as pd# 加载数据集data = pd.read_csv('shopping_cart.csv')# 数据预处理# ...```接下来,我们需要选择用于构建决策树的特征。

在这个例子中,我们假设特征包括购买的商品种类、购买的商品数量以及购物车的总价。

根据经验,我们可以选择购买的商品种类和购物车的总价作为特征,因为它们可能与购买行为更相关。

然后,我们将数据集分为训练集和测试集。

训练集用于构建决策树模型,而测试集用于评估模型的性能。

```pythonfrom sklearn.model_selection import train_test_split# 选择特征和标签X = data[['商品种类', '购物车总价']]y = data['购买']# 划分训练集和测试集X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2,random_state=42)```接下来,我们可以使用scikit-learn库中的DecisionTreeClassifier类来构建决策树模型。

```pythonfrom sklearn.tree import DecisionTreeClassifier# 构建决策树模型model = DecisionTreeClassifier()# 在训练集上训练模型model.fit(X_train, y_train)```训练完成后,我们可以使用训练好的模型对测试集进行预测,并评估模型的性能。

决策树分类算法及python代码实现案例决策树分类算法1、概述决策树(decision tree)——是⼀种被⼴泛使⽤的分类算法。

相⽐贝叶斯算法,决策树的优势在于构造过程不需要任何领域知识或参数设置在实际应⽤中,对于探测式的知识发现,决策树更加适⽤。

2、算法思想通俗来说,决策树分类的思想类似于找对象。

现想象⼀个⼥孩的母亲要给这个⼥孩介绍男朋友,于是有了下⾯的对话:⼥⼉:多⼤年纪了?母亲:26。

⼥⼉:长的帅不帅?母亲:挺帅的。

⼥⼉:收⼊⾼不?母亲:不算很⾼,中等情况。

⼥⼉:是公务员不?母亲:是,在税务局上班呢。

⼥⼉:那好,我去见见。

这个⼥孩的决策过程就是典型的分类树决策。

实质:通过年龄、长相、收⼊和是否公务员对将男⼈分为两个类别:见和不见假设这个⼥孩对男⼈的要求是:30岁以下、长相中等以上并且是⾼收⼊者或中等以上收⼊的公务员,那么这个可以⽤下图表⽰⼥孩的决策逻辑上图完整表达了这个⼥孩决定是否见⼀个约会对象的策略,其中:◊绿⾊节点表⽰判断条件◊橙⾊节点表⽰决策结果◊箭头表⽰在⼀个判断条件在不同情况下的决策路径图中红⾊箭头表⽰了上⾯例⼦中⼥孩的决策过程。

这幅图基本可以算是⼀颗决策树,说它“基本可以算”是因为图中的判定条件没有量化,如收⼊⾼中低等等,还不能算是严格意义上的决策树,如果将所有条件量化,则就变成真正的决策树了。

决策树分类算法的关键就是根据“先验数据”构造⼀棵最佳的决策树,⽤以预测未知数据的类别决策树:是⼀个树结构(可以是⼆叉树或⾮⼆叉树)。

其每个⾮叶节点表⽰⼀个特征属性上的测试,每个分⽀代表这个特征属性在某个值域上的输出,⽽每个叶节点存放⼀个类别。

使⽤决策树进⾏决策的过程就是从根节点开始,测试待分类项中相应的特征属性,并按照其值选择输出分⽀,直到到达叶⼦节点,将叶⼦节点存放的类别作为决策结果。

3、决策树构造假如有以下判断苹果好坏的数据样本:样本红⼤好苹果0 1 1 11 1 0 12 0 1 03 0 0 0样本中有2个属性,A0表⽰是否红苹果。

决策树示例数据集1.引言1.1 概述概述:决策树是一种常用的机器学习算法,它通过对数据集进行划分来构建一个树形结构的决策模型。

决策树简单直观,易于理解和解释,并且可以处理各种类型的数据,包括离散型和连续型。

决策树的构建过程是基于对数据集特征的不断划分,每个划分都根据一个特征和一个阈值来进行。

通过不断分割数据集,每一次分割都会使得子数据集纯度提高,即同一子数据集中的数据更加相似。

而不同子数据集之间的差异也会增大,使得最终的决策树能够更好地区分不同类别的数据。

在构建决策树的过程中,有几个重要的概念需要理解。

首先是根节点,也就是最开始的节点,它包含了整个数据集。

然后是内部节点,每个内部节点都代表一个特征,并包含了相应的阈值。

通过比较输入数据的特征值和阈值,可以确定下一步应该进入哪个子节点。

最后是叶节点,它代表了决策树的答案,也就是最终的分类结果。

决策树的构建过程可以通过不同的算法来实现,包括ID3、C4.5和CART等。

这些算法在选择最佳特征和阈值时会使用不同的评估准则,以达到构建最优决策树的目标。

常见的评估准则包括信息增益、增益率和基尼系数等。

决策树在实际应用中有广泛的用途。

例如,在医疗诊断中,决策树可以根据患者的病症和病史来做出诊断决策。

在金融领域,决策树可以根据客户的个人信息和信用记录来评估其信用风险。

此外,决策树还可以用于智能推荐系统、垃圾邮件过滤和文本分类等领域。

综上所述,决策树是一种强大且灵活的机器学习算法,它能够通过对数据集的划分来构建一个可解释性强且有效的决策模型。

在实际应用中,决策树可以帮助我们做出更准确、更快速的决策,提高工作效率并减少错误的发生。

1.2文章结构文章结构部分的内容可以包括以下内容:文章结构部分是对整篇文章的组织和框架进行介绍,主要是对各个章节以及它们之间的逻辑关系进行描述。

通过明确文章的结构,读者可以更好地理解文章的内容和脉络。

在本文中,文章结构部分可以包括以下内容。

决策树做回归的实例1.引言1.1 概述决策树是一种常用的机器学习算法,用于解决回归问题。

它通过构建一个树形结构来对数据进行分类或者预测。

每个内部节点表示一个特征或属性,而每个叶子节点代表一个预测值。

决策树的构建过程是基于对特征空间的划分,以使得在每个子空间内的数据具有相似的特征。

决策树回归算法旨在通过对训练数据进行学习,构建一个能够准确预测连续目标变量的模型。

与分类问题不同,回归问题是在一个连续的预测空间中进行。

决策树回归的基本思想是根据特征属性的取值范围将训练数据划分为不同的子集,并在每个子空间内创建一个预测模型。

然后,对于新的未知数据,根据其特征属性的取值,通过遍历决策树的路径来预测其目标变量的值。

决策树回归的优势在于其简单性和可解释性。

与其他复杂的回归模型相比,决策树能够提供更直观的解释,使得用户能够理解模型的决策过程。

此外,决策树也适用于处理缺失值和离散特征,并对异常值具有较好的鲁棒性。

然而,决策树回归也存在一些局限性。

首先,当决策树过于复杂时,容易产生过拟合问题,导致模型对新数据的泛化能力较差。

其次,决策树对数据中的噪声和异常值相对敏感,可能导致不稳定的预测。

此外,当数据特征过多或者特征之间存在相关性时,决策树的性能可能下降。

在接下来的文章中,我们将详细介绍决策树回归的应用场景、算法原理和具体实例。

通过对决策树回归的深入了解,我们可以更好地理解其优势和局限性,并将其应用于实际问题中。

本文将按照以下结构进行阐述决策树在回归问题上的实例应用。

具体结构如下:1. 引言1.1 概述:介绍文章的主要内容和目的,简要说明决策树回归的基本概念和应用场景。

1.2 文章结构(本章节):阐述文章的整体结构,包括各个章节的内容和安排。

1.3 目的:明确文章撰写的目标,阐述为了什么目的进行该篇文章的写作。

2. 正文2.1 决策树回归介绍:详细介绍决策树回归的原理和基本概念,包括决策树的构建方式、节点的划分准则以及模型的评估方法等内容。