决策树案例及答案

- 格式:doc

- 大小:39.00 KB

- 文档页数:1

决策树算法案例

咱来唠唠决策树算法的一个超有趣案例。

就说判断一个人今天会不会出门逛街这个事儿吧。

首先呢,我们看天气。

如果天气是大暴雨,狂风呼呼吹的那种,那这就是一个节点啦。

在这种天气下,大部分人可能就不想出门逛街了,直接就走向“不出门”这个分支。

但要是天气特别好,阳光明媚的,这又到了下一个判断节点。

接着我们看有没有钱。

要是钱包瘪瘪的,可能就只能走向“不出门”这一支,毕竟逛街可能就意味着花钱呀。

可要是有钱呢,那再看有没有小伙伴一起。

要是没有小伙伴陪着,有些人可能就觉得逛街没啥意思,还是选择“不出门”。

要是有小伙伴一起呢,哈哈,那基本就会走向“出门逛街”这个分支啦。

再比如说判断一个水果是苹果还是橙子。

我们先看形状。

如果形状是圆圆的,这就是一个节点。

然后再看颜色,如果是红色的,那很可能就是苹果这个分支啦。

要是颜色是橙色的呢,那再看看皮是不是光滑的。

如果皮光滑,那很可能就是橙子这个分支;要是皮有点粗糙,那还得再看看有没有果把儿之类的小特征,最后来确定到底是啥水果。

你看,决策树算法就像我们平时做决定一样,一步一步根据不同的条件来做出最后的判断,是不是很容易理解呢?。

案例试题—决策树⼀、2002年案例考试试题——决策树某房地产开发公司对某⼀地块拟定两种开发⽅案。

A⽅案:⼀次性开发多层住宅45000平⽅⽶,需投⼊总成本费⽤9000万元,开发时间18个⽉。

B⽅案:将地块分两期开发,⼀期开发⾼层住宅36000平⽅⽶,需投⼊总成本费⽤8100万元,开发时间15个⽉。

如果⼀期销路好,则⼆期继续开发⾼层住宅36000平⽅⽶,投⼊总费⽤8100万元,如果⼀期销路差,或者暂停开发,或者开发多层住宅22000平⽅⽶,投⼊总费⽤4600万元,开发时间15个⽉。

两⽅案销路好和销路差时的售价和销量情况见下表。

根据经验,多层住宅销路好的概率为0.7,⾼层住宅销路好的概率为0.6,暂停开发每季损失10万元,季利率2%。

问题:1、两⽅案销路好和销路差时季平均销售收⼊各为多少万元(假定销售收⼊在开发时间内均摊)2、⽤决策树做出决策,应采⽤哪个⽅案(计算结果保留两位⼩数)答案:1、A⽅案开发多层住宅:销路好4.5×4800×100%÷6=3600(万元)销路差4.5×4300×80%÷6=2580(万元)B⽅案⼀期开发⾼层住宅:销路好3.6×5500×100%÷5=3960(万元)销路差3.6×5000×70%÷5=2520(万元)B⽅案⼆期开发⾼层住宅:3.6×5500×100%÷5=3960(万元)开发多层住宅:销路好2.2×4800×100%÷5=2112(万元)销路差2.2×4300×80%÷5=1513.6(万元)2、机会点①净现值的期望值:(3600×0.7+2580×0.3)×(P/A,2%,6)-9000=(3600×0.7+2580×0.3)×5.601-9000=9449.69(万元)等额年⾦:9449.69×(A/P,2%,6)=9449.69×1/5.601=1687.14(万元)机会点③净现值的期望值:3960×(P/A,2%,5)×1.0-8100=3960×4.713×1.0-8100=10563.48(万元)等额年⾦:10563.48×(A/P,2%,5)=10563.48×1/4.713=2241.35(万元)机会点④净现值的期望值:-10×(P/A,2%,5)=-10×4.713=-47.13(万元)等额年⾦:-47.13×(A/P,2%,5)=-47.13×1/4.713=-10.00(万元)机会点⑤净现值的期望值:(2112×0.7+1513.6×0.3)×(P/A,2%,5)-4600=(2112×0.7+1513.6×0.3)×4.713-4600=4507.78(万元)等额年⾦:4507.78×(A/P,2%,5)=4507.78×1/4.713=956.46(万元)根据计算结果判断,B⽅案在⼀期开发⾼层住宅销路差的情况下,⼆期应改为开发多层住宅。

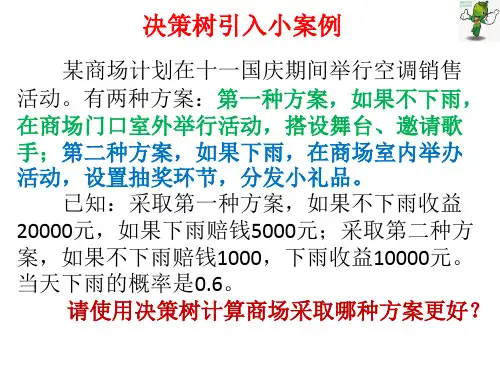

决策树例题经典案例三个方案

为了适应市场的需要,某地准备扩大电视机生产。

市场预测表明:产品销路好的概率为0.7;销路差的概率为0.3。

备选方案有三个:第一个方案是建设大工厂,需要投资600万元,可使用10年;如销路好,每年可赢利200万元;如销路不好,每年会亏损40万元。

第二个方案是建设小工厂,需投资280万元;如销路好,每年可赢利80万元;如销路不好,每年也会赢利60万元。

第三个方案也是先建设小工厂,但是如销路好,3年后扩建,扩建需投资400万元,可使用7年,扩建后每年会赢利190万元。

各点期望:

点②:0.7×200×10+0.3×(-40)×10-600(投资)=680(万元)

点⑤:1.0×190×7-400=930(万元)

点⑥:1.0×80×7=560(万元)

比较决策点4的情况可以看到,由于点⑤(930万元)与点⑥(560万元)相比,点⑤的期望利润值较大,因此应采用扩建的方案,而舍弃不扩建的方案。

把点⑤的930万元移到点4来,可计算出点③的期望利润值。

点③:0.7×80×3+0.7×930+0.3×60×(3+7)-280 = 719(万元)

最后比较决策点1的情况。

由于点③(719万元)与点②(680万元)相比,点③的期望利润值较大,因此取点③而舍点②。

这样,相比之下,建设大工厂的方案不是最优方案,合理的策略应采用前3年建小工厂,如销路好,后7年进行扩建的方案。

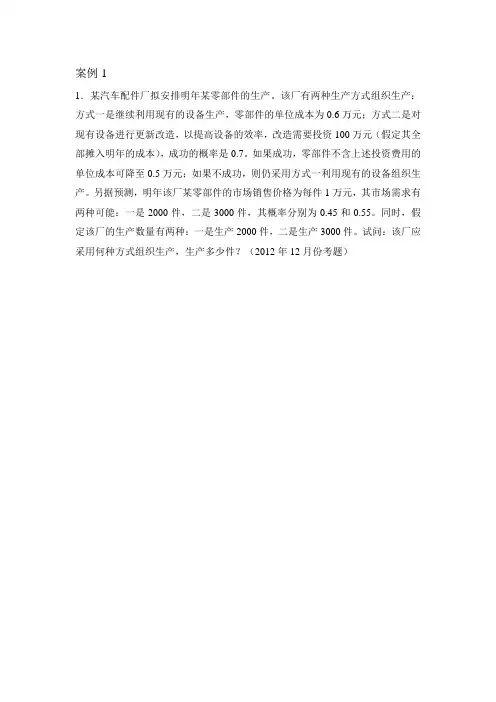

1.某汽车配件厂拟安排明年某零部件的生产。

该厂有两种生产方式组织生产:方式一是继续利用现有的设备生产,零部件的单位成本为0.6万元;方式二是对现有设备进行更新改造,以提高设备的效率,改造需要投资100万元(假定其全部摊入明年的成本),成功的概率是0.7。

如果成功,零部件不含上述投资费用的单位成本可降至0.5万元;如果不成功,则仍采用方式一利用现有的设备组织生产。

另据预测,明年该厂某零部件的市场销售价格为每件1万元,其市场需求有两种可能:一是2000件,二是3000件,其概率分别为0.45和0.55。

同时,假定该厂的生产数量有两种:一是生产2000件,二是生产3000件。

试问:该厂应采用何种方式组织生产,生产多少件?(2012年12月份考题)1、第一步:绘制决策树如下图所示。

决策点4001400 2001200 900900 800 800 1001100 700 700第二步:计算各节点处的期望收益值。

(1)右边第一个节点的期望收益值:=2002000-3000⨯0.6(万元)以此类推可计算其他11个节点的期望收益值。

(2)节点6的期望收益值:2005+12005=750⨯0.4⨯0.5(万元)以此类推可计算其他5个节点的期望收益值。

第三步:剪枝。

根据期望值准则,选出决策点3、4、5的最佳生产批量,并将最佳方案的期望值填在相应的决策点的上方,同时,剪除落选的方案枝。

由此可知:应采取生产方式二组织生产,若成功,生产3000件;若失败,按方式一生产2000件。

案例2:某企业提出如下新产品投资方案:一是投资550万元建大厂;二是投资300万元建小厂,若前两年销路好,后三年考虑扩建,扩建时需追加投资300万元,达到大厂规模,不扩建时仍按原规模生产。

经预测:大厂销路好时每年盈利260万元,销路不好时每年盈利80万元;小厂销路好时每年盈利120万,销路不好时每年盈利50万。

另外,前两年销路好的概率为70%,在前两年销路好的前提下,后三年仍销路好的概率为90%,前两年销路不好的前提下,后三年依然销路不好的概率为80%。

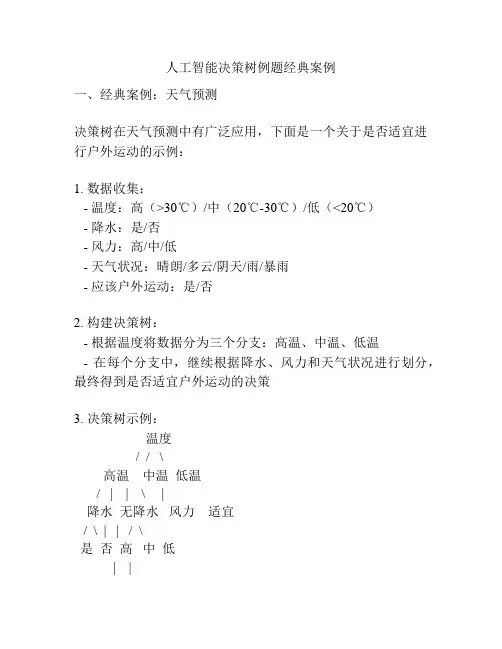

人工智能决策树例题经典案例一、经典案例:天气预测决策树在天气预测中有广泛应用,下面是一个关于是否适宜进行户外运动的示例:1. 数据收集:- 温度:高(>30℃)/中(20℃-30℃)/低(<20℃)- 降水:是/否- 风力:高/中/低- 天气状况:晴朗/多云/阴天/雨/暴雨- 应该户外运动:是/否2. 构建决策树:- 根据温度将数据分为三个分支:高温、中温、低温- 在每个分支中,继续根据降水、风力和天气状况进行划分,最终得到是否适宜户外运动的决策3. 决策树示例:温度/ / \高温中温低温/ | | \ |降水无降水风力适宜/ \ | | / \是否高中低| |不适宜适宜- 如果温度是高温且有降水,则不适宜户外运动- 如果温度是高温且无降水,则根据风力判断,如果风力是高,则不适宜户外运动,如果风力是中或低,则适宜户外运动 - 如果温度是中温,则不论降水和风力如何,都适宜户外运动- 如果温度是低温,则需要考虑风力,如果风力是高,则适宜户外运动,如果风力是中或低,则不适宜户外运动4. 参考内容:决策树的构建和应用:决策树通过对输入特征进行划分,构建了一棵树形结构,用于解决分类或回归问题。

构建决策树主要包括数据预处理、特征选择、划分策略和停止条件等步骤。

特征选择可以使用信息增益、基尼指数等算法,划分策略可以使用二叉划分或多叉划分,停止条件可以是叶子节点纯度达到一定阈值或达到预定的树深度。

决策树的应用包括数据分类、特征选择和预测等任务。

天气预测案例中的决策树:将天气预测问题转化为分类问题,通过构建决策树,可以得到识别是否适宜户外运动的规则。

决策树的决策路径可以用流程图或树状图表示,帮助理解和解释决策过程。

决策树的节点表示特征值,分支表示判断条件,叶子节点表示分类结果。

决策树的生成算法可以基于启发式规则或数学模型,如ID3、C4.5、CART等。

决策树的优缺点:决策树具有可解释性强、易于理解和实现、能处理非线性关系等优点。

大一决策树例题简单案例

嘿,朋友们!今天咱来聊聊大一决策树的简单案例。

就比如选社团这事吧,大一刚入学,那社团多得让人眼花缭乱啊!这就像一棵决策树摆在你面前。

你看哈,喜欢运动的,有篮球社、足球社可以选。

那是不是得想想,自己更喜欢篮球呢,还是足球呢?“哎呀,这可太难选了!”这时候决策树就派上用场啦。

要是觉得自己篮球技术还行,还特别享受那种团队配合的感觉,那篮球社也许就是个不错的选择,这就是决策树其中的一个分支呀。

但又一想,足球也挺有意思的,能在草地上尽情奔跑,那多爽!这又是另一个分支。

这不就跟决策树一样嘛!在每个节点都要做出选择。

像选专业也是同理呀,是选热门的计算机专业呢,还是自己一直感兴趣的文学专业呢?这都是要好好琢磨的呀!“哎呀呀,真让人纠结!”

再比如说交朋友吧,遇到不同性格的人,是不是得考虑跟谁能更合得来?这也是决策树上的一个个选择呀!是和那个活泼开朗的一起玩,还是和那个沉稳内敛的成为朋友呢?这需要我们在大一的时候好好去判断,做出适合自己的决策。

大一就是这样一个充满各种选择和可能的阶段,就像走在一片森林里,要找到属于自己的那条路。

而决策树就是我们的好帮手,帮助我们理清思路,做出明智的选择。

所以呀,大家一定要好好利用决策树这个工具哦,可别小瞧了它!让我们在大一的时候,通过决策树做出那些对我们未来有重要影响的决策,开启一段精彩的大学生活吧!。

python决策树例题经典案例摘要:一、决策树简介- 决策树的定义- 决策树的作用- 决策树在Python 中的实现二、经典案例介绍- 案例一:鸢尾花数据集分类- 案例二:泰坦尼克号乘客生存预测- 案例三:房价预测三、案例实现步骤- 数据准备- 特征选择- 构建决策树模型- 模型评估与优化四、总结与展望- 决策树模型的优缺点- 决策树在实际应用中的限制- 未来发展方向正文:一、决策树简介决策树(Decision Tree)是一种基本的分类和回归方法,可以用于二元和多元分类以及连续和离散的数值预测。

决策树的构建过程就是递归地选择最优的特征并根据该特征对数据进行分裂的过程,直到满足某种条件为止,然后构建出一颗决策树。

在进行分类预测时,对输入数据从根节点开始沿着特定的路径向下走,直到到达某个叶节点,此时该叶节点所对应的类别就是该输入数据的预测类别。

Python 中可以使用scikit-learn 库实现决策树模型,其中包括ID3、C4.5 和CART 等算法。

二、经典案例介绍1.案例一:鸢尾花数据集分类鸢尾花数据集(Iris dataset)是一个常用的数据集,包含了鸢尾花的4 个特征(花萼长度、花萼宽度、花瓣长度、花瓣宽度)和3 个类别(Iris-Setosa,Iris-Versicolour,Iris-Virginica)。

通过决策树模型可以对鸢尾花进行正确分类。

2.案例二:泰坦尼克号乘客生存预测泰坦尼克号数据集(Titanic dataset)包含了泰坦尼克号沉船事件中幸存的乘客信息,包括性别、年龄、兄弟姐妹/配偶数量、父母/子女数量、船票号码等特征。

通过决策树模型,可以预测乘客是否在泰坦尼克号沉船事件中幸存。

3.案例三:房价预测房价预测是一个实际问题,通过收集房屋的特征数据(如面积、卧室数量、卫生间数量、地段等),可以使用决策树模型预测房价。

三、案例实现步骤1.数据准备首先需要收集和整理数据,将数据转换为适用于决策树模型的格式。

决策树例题经典案例python(原创版)目录1.决策树概述2.决策树例题:经典案例3.Python 实现决策树4.总结正文1.决策树概述决策树是一种基本的分类和回归方法,它通过一系列的问题对数据进行划分,从而得到最终的分类结果或回归结果。

决策树可以分为 ID3 决策树、C4.5 决策树和 CART 决策树等,其中 ID3 和 C4.5 属于自上而下、递归划分的方法,而 CART 是自下而上、非递归划分的方法。

2.决策树例题:经典案例以一个经典的决策树例题为例,假设我们有一组房地产数据,包括房屋面积、卧室数量、是否拥有车库等多个特征,目标是预测房屋的售价。

我们可以使用决策树来解决这个问题。

3.Python 实现决策树Python 中,可以使用著名的 scikit-learn 库来实现决策树。

以下是一个简单的示例:```pythonfrom sklearn.datasets import load_irisfrom sklearn.model_selection import train_test_splitfrom sklearn.tree import DecisionTreeClassifierfrom sklearn.metrics import accuracy_score# 加载数据集iris = load_iris()X = iris.datay = iris.target# 划分训练集和测试集X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)# 创建决策树模型clf = DecisionTreeClassifier()# 训练模型clf.fit(X_train, y_train)# 预测y_pred = clf.predict(X_test)# 评估模型print("Accuracy:", accuracy_score(y_test, y_pred))```在这个例子中,我们使用了 scikit-learn 内置的 Iris 数据集,并将数据集划分为训练集和测试集。

决策树例题经典案例决策树是一种常用的机器学习算法,它能够通过构建一棵树来对数据进行分类或者回归预测。

决策树通过对每个样本的特征进行划分,从而逐步构建树结构,最终得到一棵用于分类或者回归的决策树。

下面我们来看一个经典的决策树例题。

假设我们有一个数据集,包含了一些二分类问题的样本,每个样本有两个特征,特征1表示是否有房产(是/否),特征2表示是否有工作(是/否)。

我们的目标是通过这两个特征来预测样本的类别(是/否)。

我们可以根据这个问题构建一个决策树。

首先,我们需要选择一个特征来进行划分。

通常我们选择的划分特征是能够最大程度地将样本分开的特征。

在这个例子中,我们可以选择特征1作为划分特征。

然后,我们将特征1的取值分别为“是”和“否”的样本分成两个子集。

对于特征1取值为“是”的样本,我们可以看到它们的类别都为“是”,所以我们可以将其划分为一个叶子节点,并且将类别设为“是”。

对于特征1取值为“否”的样本,我们需要选择另一个特征来划分。

同样地,我们选择特征2作为划分特征。

对于特征2取值为“是”的样本,我们可以看到它们的类别有一部分为“是”,一部分为“否”,所以我们还需要继续划分。

我们选择特征1作为再次划分的特征。

对于特征2取值为“否”的样本,我们可以看到它们的类别都为“否”,所以我们可以将其划分为一个叶子节点,并且将类别设为“否”。

对于特征2取值为“是”,特征1取值为“否”的样本,我们可以看到它们的类别全部为“否”,所以我们可以将其划分为一个叶子节点,并且将类别设为“否”。

最后,我们得到的决策树如下:特征1是|--- 类别:是特征1否|--- 特征2是| |--- 类别:是||--- 特征2否|--- 类别:否通过这个决策树,我们可以根据样本的特征值来进行预测。

例如,对于一个样本,特征1为“是”,特征2为“否”,按照决策树的规则,我们可以预测该样本的类别为“否”。

决策树是一种直观、易于解释的机器学习算法,它能够根据数据集的特征进行分类或者预测,对于解决一些简单的二分类问题非常有效。

运营管理决策树题引言在运营管理中,经常需要做出决策以确保运营的高效性和效益。

运营管理决策树是一种常见的决策分析工具,可以帮助运营经理在不同情况下做出正确的决策。

本文将通过几个案例,介绍不同的运营管理决策树题目,并给出解决方案。

在这些案例中,我们将会看到决策树如何指导运营决策,进而提高组织的运营效率和效益。

案例一:生产决策背景假设你是一个生产部门的经理,公司生产一种零件,目前有两台生产设备可以选择生产该零件。

设备A每小时可以生产100个零件,但质量相对较低;设备B每小时可以生产80个零件,但质量相对较高。

你需要在两种设备之间做出决策。

决策树•设备A生产成本较低,设备B生产成本较高•如果质量要求较低,选择设备A生产•如果质量要求较高,选择设备B生产结论根据决策树的指导,如果质量要求较低,则应选择设备A生产;如果质量要求较高,则应选择设备B生产。

这样可以最大程度地满足产品质量要求,同时降低生产成本。

案例二:库存管理背景假设你是一个零售店的经理,负责管理库存。

店内有一种商品的销售量存在一定的不确定性,该商品每个月的销售量可能是500个、1000个或1500个。

根据过去的销售数据,你可以预测每个月的销售量,但预测值存在一定的误差。

现在你需要决策每月的库存数量。

决策树•如果预测销售量为500个,则库存为800个•如果预测销售量为1000个,则库存为1200个•如果预测销售量为1500个,则库存为1500个结论根据决策树的指导,根据不同的销售量预测,设置不同的库存数量。

这样可以保证库存能够满足大部分情况下的需求,避免库存过剩或不足的问题。

案例三:供应商选择背景假设你负责采购部门,需要选择一个供应商来提供公司所需的材料。

现在有两个供应商可供选择,供应商A每次交货周期为10天,供应商B每次交货周期为15天。

你需要在两个供应商之间做出选择。

决策树•如果对交货速度要求较高,选择供应商A•如果对交货速度要求不高,选择供应商B结论根据决策树的指导,如果对交货速度有较高的要求,则应选择供应商A;如果对交货速度要求不高,则应选择供应商B。

决策树例题经典案例决策树是一种常见的机器学习算法,它通过对数据集进行划分,构建一颗树形结构来进行决策预测。

在实际应用中,决策树被广泛运用于金融、医疗、营销等领域,帮助人们进行决策分析和预测。

下面我们将通过几个经典案例来深入理解决策树的应用。

案例一,贷款申请。

假设银行需要根据客户的个人信息来决定是否批准其贷款申请。

我们可以利用决策树来构建一个贷款申请的决策模型。

首先,我们需要收集客户的个人信息,比如年龄、收入、信用记录等。

然后,我们将这些信息作为特征,构建决策树模型。

通过对客户信息的分析,决策树可以帮助银行进行贷款申请的预测,提高贷款申请的审批效率。

案例二,疾病诊断。

医疗领域也是决策树的重要应用场景之一。

假设医生需要根据患者的症状来进行疾病诊断,我们可以利用决策树来构建一个疾病诊断的模型。

首先,我们收集患者的症状信息,比如发烧、咳嗽、头痛等。

然后,我们将这些症状作为特征,构建决策树模型。

通过对患者症状的分析,决策树可以帮助医生进行疾病的诊断,提高诊断的准确性。

案例三,产品营销。

在营销领域,决策树也被广泛应用于产品推荐和客户分类。

假设一家电商平台需要根据用户的购物行为来进行产品推荐,我们可以利用决策树来构建一个产品推荐的模型。

首先,我们收集用户的购物记录、浏览记录等信息。

然后,我们将这些信息作为特征,构建决策树模型。

通过对用户行为的分析,决策树可以帮助电商平台进行个性化推荐,提高用户的购物体验。

通过以上经典案例的介绍,我们可以看到决策树在不同领域的应用场景。

无论是贷款申请、疾病诊断还是产品营销,决策树都能够帮助我们进行决策分析和预测,提高工作效率和决策准确性。

因此,掌握决策树算法是非常重要的,它不仅可以帮助我们解决实际问题,还可以提升我们在机器学习领域的竞争力。

希望通过本文的介绍,读者能够对决策树有更深入的理解,为实际问题的解决提供更多的思路和方法。

决策树简单案例

嘿,朋友们!今天来给你们讲个决策树的简单案例,保准让你们大开眼界!

比如说你要决定周末干啥,这就像是站在一棵决策树的根部。

你可能会想,哎呀,是在家宅着看剧呢,还是出去和朋友逛街呢?这就是决策树的两个分支呀!如果选择在家宅着看剧,那可能会很舒服自在,但也许会有点无聊;要是出去和朋友逛街呢,哇,那多有意思啊,可以看到好多新鲜玩意儿,还能和朋友嘻嘻哈哈,可就是有点累人。

再比如,你纠结要不要买一件很贵的衣服。

买吧,虽然穿起来会特别漂亮,让你自信心爆棚,哎呀,走在街上回头率肯定超高!但又想想那价格,真心肉疼啊!不买吧,又觉得有点不甘心,这么好看的衣服错过了多可惜呀!这是不是就像决策树又多了几个分支呀!

就像我有一次,面临着是去参加一个聚会还是自己安静待着的选择。

去聚会呢,说不定能认识很多新朋友,还能玩得很开心,可我又有点社恐,担心融入不进去会尴尬;自己待着呢,确实轻松自在,但又觉得会错失一些有趣的体验。

哎呀,这可真难抉择呀!

决策树就是这么神奇,它能让我们把各种可能的情况和后果都清楚地摆在眼前,就像帮我们打开了一个思维的地图。

所以啊,朋友们,决策树真的太有用啦!它能让我们在面对各种选择时更加理智,更清楚地看到每种选择的利弊。

下次当你犹豫不决的时候,不妨也试着画一棵决策树,说不定就能找到最好的答案呢!总之,决策树就是我们做决策的好帮手,能让我们少走弯路,何乐而不为呢!。

管理学决策树例题经典案例

嘿,朋友们!今天咱来聊聊管理学决策树的例题经典案例。

就说开个餐厅吧,你瞧,这可不是个简单事儿!

比如说,你得考虑选址吧。

是选在繁华的商业街呢,还是在居民区里呢?这就像走在岔路口,得做出选择!要是选了商业街,人流量大,可租金也高得吓人啊,那成本压力不就山大了嘛!但要是在居民区,虽然租金相对低些,可客流量能有那么大吗?哎呀呀,这可真让人头疼呢!

然后呢,菜单怎么设计?是各种菜品都来点,还是主打特色菜呢?这就好比在决策树上又多了几条分支呀。

要是啥都有,备菜成本高,还可能啥都不精;可只搞特色,会不会太局限了呢?

再说说定价,定高了,顾客觉得贵不来了;定低了,自己又觉得亏了。

这不是左右为难嘛!

这不就跟我们人生的选择一样嘛!你看,就像你大学毕业,是去大城市闯荡呢,还是回到家乡安稳过日子呢?每一个选择都可能带来完全不同的结果。

还有招聘员工,找经验丰富的吧,工资要求高;找新手吧,又得花时间精力去培养。

哇,这一个个问题就像决策树上的节点,每个都得慎重考虑呀!

咱回过头看,开餐厅的每一个决定不都影响着餐厅的未来嘛!所以说,管理学决策树真的太重要啦!它能帮我们理清思路,做出更明智的选择。

就好像有了一张地图,告诉我们该往哪走,怎么才能走到成功的彼岸!我觉得,不管是干啥,都得学会用这决策树的思维,毕竟,选择不对,努力白费呀,大家说是不是呢!。

人工智能决策树例题经典案例案例:肿瘤诊断假设医院采集了一批患者的肿瘤数据,现在利用人工智能决策树模型来辅助医生对患者进行肿瘤诊断。

特征(Features):1. 病人年龄(Age):年轻(<30岁)、中年(30-60岁)、老年(>60岁)2. 吸烟史(Smoking history):有、无3. 家族肿瘤史(Family history of tumors):有、无4. 肿瘤大小(Tumor size):小(<1cm)、中(1-3cm)、大(>3cm)5. 肿瘤位置(Tumor location):头部、躯干、四肢6. 是否转移(Metastasis):是、否标签(Label):是否良性(Benign):良性、恶性决策树模型可以通过训练这些数据,生成一颗决策树,使得新的患者输入对应的特征后,可以根据决策树得到一个诊断结果,从而辅助医生进行判断。

例如,一棵生成的决策树可以如下所示:- 如果病人年龄小于30岁,则判断为良性- 如果病人年龄介于30-60岁之间:- 如果有吸烟史,则判断为恶性- 如果没有吸烟史:- 如果有家族肿瘤史,则判断为恶性- 如果没有家族肿瘤史:- 如果肿瘤大小为中或大,则判断为恶性- 如果肿瘤大小为小,且肿瘤位置为头部,则判断为恶性- 如果肿瘤大小为小,且肿瘤位置不在头部,则判断为良性- 如果病人年龄大于60岁,则判断为恶性利用这个决策树模型,当新的患者输入其特征时,比如一个40岁的病人,没有吸烟史,没有家族肿瘤史,肿瘤大小为小,位置在头部,没有转移,根据决策树的判断,该病人的肿瘤很可能是良性的。

通过人工智能决策树模型,可以减轻医生的负担,提供更加准确和快速的诊断结果,帮助医生做出适当的治疗决策。

人工智能决策树例题经典案例

一个经典的人工智能决策树例题是预测某个人是否适合贷款。

假设我们有以下特征信息:

1.年龄:年轻、中年、老年

2.工作:工作,失业,退休

3.收入水平:低,中,高

4.婚姻状况:已婚,未婚,离婚

5.贷款历史:有,无

6.贷款违约:是,否

我们的目标是根据这些特征信息来预测一个人是否适合贷款。

这里的决策树将在不同的特征值上进行分割,并根据分割结果进行判断。

我们可以通过以下步骤构建决策树:

1.选择最佳特征来分割数据集。

在这个案例中,我们可以使用

信息增益或基尼系数来选择最佳的特征。

例如,如果年龄的信息增益最高,则选择年龄作为第一个分割特征。

2.根据选定的特征值将数据集划分为不同的子集。

比如,根据

年龄的不同分为年轻、中年和老年三个子集。

3.对于每个子集,重复步骤1和步骤2,直到满足终止条件。

终止条件可以是子集的纯度已达到一定程度或者没有更多特征可供选择。

4.根据最终的决策树,将一个新的样本输入到决策树中,并根

据决策树的分支进行预测。

比如,如果一个人的年龄是中年,工作是工作,收入水平是中,婚姻状况是已婚,贷款历史是有,那么根据决策树的分支,预测该人适合贷款可能是"是"。

这是一个简化的人工智能决策树例题,实际应用中可能有更多的特征和更复杂的规则。

决策树是一种可解释性强且易于理解的机器学习模型,在许多领域都有广泛的应用。

案例:假设有一工程项目,管理人员要根据天气状况决定开工方案。

如果开工后天气好,可以给国家创收30000元;如果开工后天气差,将给国家带来损失10000元;如果不开工,讲给国家带来损失1000元,。

已知开工后天气好的概率是0.6,开工后天气差的概率是0.4.请用决策树方案进行决策。

【解答】 首先,将题意表格化

方

案

天气好 天气坏 0.6 0.4 开工

30000 ( 期望收益=30000*0.6) -10000 (期望收益= -10000*0.4) 不开工 -1000 ( 期望收益=-1000*0.6) -1000 (期望收益=-1000*0.4)

第二步,绘制决策树

(1)计算期望收益并标注在决策树上

开工方案下,预期收益值=30000*0.6+(-10000)*0.4=14000

不开工方案下,预期损失值=-1000

(2)比较两个方案并减去期望收益较小的方案枝

状 态。