非线性回归预测法——高斯牛顿法(詹学朋)知识分享

- 格式:doc

- 大小:213.50 KB

- 文档页数:9

求解非线性方程的三种新的迭代法非线性方程是指未知数的高次幂或三角函数、指数函数等构成的方程。

非线性方程的求解是数值计算中的一个重要问题,常用的方法有迭代法、试位法、牛顿法等。

下面介绍三种新的迭代法。

1. 牛顿法的改进牛顿法是一种求解非线性方程的常用方法,通过选择合适的初始值,可以得到方程的一个根。

在某些情况下,牛顿法的收敛速度较慢,甚至可能发散。

为了克服这个问题,有人提出了牛顿法的改进方法。

改进的思想是在每一步的迭代中引入一个修正因子,使得每一步的迭代都能够加速收敛。

这个修正因子可以选择为方程导数的逆矩阵,或者通过数值计算方法来估计。

通过引入修正因子,可以使得牛顿法的收敛速度更快,提高求解非线性方程的效率。

2. 弦截法弦截法是一种求解非线性方程的迭代法,它可以看作是牛顿法的一种变形。

在牛顿法中,通过选择切线与x轴的交点作为新的逼近解,而在弦截法中,通过选择切线与两个初始逼近解的连线的交点作为新的逼近解。

弦截法的迭代公式为:Xn+1 = Xn - f(Xn) * (Xn - Xn-1) / (f(Xn) - f(Xn-1))在每一步迭代中,选择两个初始逼近解Xn和Xn-1,代入上述迭代公式即可求得新的逼近解Xn+1。

通过不断迭代,可以逐渐接近方程的根。

3. 牛顿-拉夫逊法牛顿-拉夫逊法是一种变步长的牛顿法,它的主要思想是通过动态调整迭代步长的大小来提高求解非线性方程的效率。

在牛顿-拉夫逊法中,首先根据初始解得到牛顿法的逼近解,然后根据逼近解和方程的误差,动态调整迭代步长。

如果逼近解接近方程的根,将步长增加,以加快收敛速度;如果逼近解偏离方程的根,将步长减小,以避免迭代发散。

λ为步长调整因子,可以根据迭代过程中的收敛情况进行动态调整。

牛顿法的改进、弦截法和牛顿-拉夫逊法是三种求解非线性方程的新的迭代法。

这些方法通过引入修正因子、变化逼近解和动态调整步长等方法,可以提高求解非线性方程的效率和收敛速度。

高斯牛顿法手算例题高斯-牛顿法是一种用于求解非线性方程组的迭代数值方法。

它通过不断迭代来逼近方程组的解。

我将通过一个手算例题来演示高斯-牛顿法的应用。

假设我们要解决以下非线性方程组:f1(x, y) = x^2 + y^2 25 = 0。

f2(x, y) = x y 9 = 0。

我们首先需要计算方程组的雅可比矩阵,即关于变量x和y的偏导数矩阵:J = |2x 2y|。

|y x |。

接下来,我们选择一个初始解向量,例如(x0, y0) = (1, 1)。

然后,我们可以使用以下公式进行迭代:(xn+1, yn+1) = (xn, yn) (J^T J)^(-1) J^T f(xn, yn)。

其中,^T表示矩阵的转置,^(-1)表示矩阵的逆,f(xn, yn)是方程组的函数向量。

现在,让我们开始手算迭代过程:首先,计算f(x0, y0)和J在(x0, y0)处的值:f(x0, y0) = (1^2 + 1^2 25, 11 9) = (-22, -8)。

J = |21 21|。

|1 1 |。

接下来,我们需要计算(J^T J)^(-1) J^T的值。

首先计算J^T J:J^T J = |2 1| |2 2| = |8 4|。

|1 1| |2 2| |4 4|。

然后计算其逆矩阵:(J^T J)^(-1) = (1/(84-44)) |2 -1| = (1/8) |1 -1|。

|-1 2 | |-12 |。

最后,计算(J^T J)^(-1) J^T:(J^T J)^(-1) J^T = (1/8) |1 -1| |2 1| = (1/8) |21|。

|-1 2 | |1 1| |-1 2|。

现在,我们可以将这些值代入迭代公式中:(x1, y1) = (1, 1) (1/8) |2 1| |-22|。

|-1 2 | |-8 |。

(x1, y1) = (1, 1) (1/8) |2 1| |-22| = (1, 1) (1/8)|18|。

高斯—牛顿迭代法高斯-牛顿迭代法是一种重要的数值解方法,它为解决复杂的非线性方程提供了一种有效的途径。

它结合了高斯原理和牛顿法的优势,利用高斯消元方法解出方程的一个精确解,从而有效地解决复杂的非线性方程组。

首先,我们来看看高斯-牛顿迭代法的基本思想。

很显然,这种迭代法是基于高斯原理以及牛顿法的思想。

根据高斯原理,可以得到每一个未知数的一个精确解。

而牛顿法则通过更新未知数的近似值,使得这个近似解更接近真实的解。

在这种思路的指导下,我们引入了高斯-牛顿迭代法,它具有非常高的效率和准确率。

其次,我们来看看高斯-牛顿迭代法的步骤以及具体实现过程。

高斯-牛顿迭代法的步骤主要有四步:首先,通过高斯消元算法求解出精确解;接着,通过求解线性方程组的近似解来更新未知数的初值;第三步,对更新的初值求解线性方程组,同时也计算出该近似解的梯度;最后,运用牛顿法更新未知数的近似值,并重复上述的求解步骤,直到收敛。

另外,在实际使用高斯-牛顿迭代法时,我们还需要考虑一些实际问题,例如对于牛顿迭代中未知数的初值选取,以及求解过程中收敛度控制等等。

不同的初值会影响最终求解过程的收敛速度和收敛精度,而牛顿法的收敛率又受到梯度的影响,因此,在实际应用中,需要考虑如何选择初值以及如何控制收敛度,这些问题都是高斯-牛顿迭代法内容中非常重要的一部分。

最后,我们来看看高斯-牛顿迭代法在实际应用中的一些典型案例。

在压力容器复合结构分析中,需要求解压力容器复合结构的有限元方程组,这其中含有大量非线性方程,而高斯牛顿迭代法可以有效地求解这样的问题;此外,高斯-牛顿迭代法也可以应用于组合优化的求解中,这类优化问题包括多目标优化、非线性约束优化等;另外,高斯牛顿迭代也可以用于求解动力系统中牛顿欧拉方程,如轨道飞行器动力学模型中的牛顿欧拉方程等。

总之,高斯-牛顿迭代法是一种有效的数值解方法,它结合了高斯原理和牛顿法的优势,可以有效地解决复杂的非线性方程组,而且具有收敛性好、效率高、准确率高的特点。

非线性方程组的求解方法及其应用非线性方程组是数学中一类非常重要的问题,其中每个方程都不是线性的。

与线性方程组不同,非线性方程组的求解通常需要借助于数值方法。

本文将讨论一些常见的非线性方程组求解方法,并介绍它们在实际应用中的一些应用。

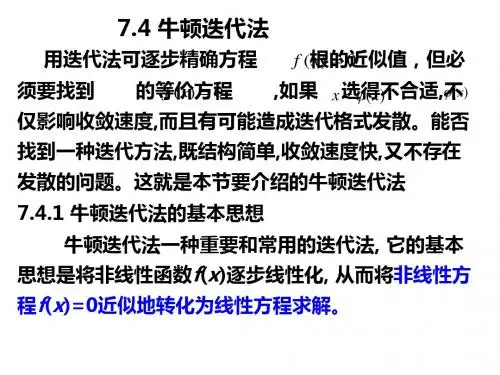

1. 牛顿法牛顿法是一种非常常见的非线性方程组求解方法。

该方法基于牛顿迭代法原理,将非线性方程组转化为一系列的线性问题。

牛顿法的基本思想是:通过不断地使用一阶导数和二阶导数的信息来逼近方程组的解。

具体地说,在每一轮迭代中,求解一个方程组:$$F(x^{k})+J(x^{k})\Delta x^{k} =0$$其中$F(x)$表示非线性方程组,$x^k$表示第$k$轮迭代的解,$J(x^k)$表示$F(x)$在$x^k$处的雅可比矩阵,$\Delta x^k$表示下降方向,满足$\|\Delta x^k\|\rightarrow 0$。

值得注意的是,牛顿法在每轮迭代中都需要求解一次雅可比矩阵,这需要大量的计算资源。

因此,在实际应用中,牛顿法通常只适用于相对较小的方程组。

2. 信赖域方法相比于牛顿法,信赖域方法更具有通用性。

信赖域方法的基本思想是:在每轮迭代中,通过构造二次模型来逼近目标函数,并在一个信赖域内搜索下降方向。

具体地说,我们在每轮迭代中将非线性方程组$F(x)$在$x^k$处转化为二次模型:$$m_k(\Delta x)=F(x^k)+\nabla F(x^k)^\top \Deltax+\frac{1}{2}\Delta x^\top B_k\Delta x$$其中,$\nabla F(x^k)$是$F(x)$在$x^k$处的梯度,$B_k$是二阶导数信息。

在这里我们假设$B_k$为正定矩阵。

显然,我们希望在$m_k(\Delta x)$的取值范围内找到一个适当的$\Delta x$,使得$m_k(\Delta x)$最小。

因此,我们需要设定一个信赖域半径$\Delta_k$,并在$B_k$所定义的椭圆范围内查找最优的$\Delta x$。

非线性回归方法非线性回归是机器学习中的一种重要方法,用于建立输入和输出之间的非线性关系模型。

线性回归假设输入和输出之间存在线性关系,而非线性回归则允许更复杂的模型形式,可以更好地适应现实世界中的复杂数据。

下面将介绍几种常见的非线性回归方法,并说明它们的原理、应用场景和优缺点。

1. 多项式回归多项式回归通过引入高次多项式来拟合数据。

例如,在一元情况下,一阶多项式即为线性回归,二阶多项式即为二次曲线拟合,三阶多项式即为三次曲线拟合,依此类推。

多项式回归在数据不规则变化的情况下能够提供相对灵活的拟合能力,但随着多项式次数的增加,模型的复杂度也会增加,容易出现过拟合问题。

2. 非参数回归非参数回归方法直接从数据中学习模型的形式,并不对模型的形式做出先验假设。

常见的非参数回归方法包括局部加权回归(LWLR)、核回归(Kernel Regression)等。

局部加权回归通过给予离目标点较近的样本更大的权重来进行回归,从而更注重对于特定区域的拟合能力。

核回归使用核函数对每个样本进行加权,相当于在每个样本周围放置一个核函数,并将它们叠加起来作为最终的拟合函数。

非参数回归方法的优点是具有较强的灵活性,可以适应各种不同形状的数据分布,但计算复杂度较高。

3. 支持向量回归(SVR)支持向量回归是一种基于支持向量机的非线性回归方法。

它通过寻找一个超平面,使得样本点离该超平面的距离最小,并且在一定的松弛度下允许一些样本点离超平面的距离在一定范围内。

SVR通过引入核函数,能够有效地处理高维特征空间和非线性关系。

SVR的优点是对异常点的鲁棒性较好,并且可以很好地处理小样本问题,但在处理大规模数据集时计算开销较大。

4. 决策树回归决策树回归使用决策树来进行回归问题的建模。

决策树将输入空间划分为多个子空间,并在每个子空间上拟合一个线性模型。

决策树能够处理离散特征和连续特征,并且对异常点相对较鲁棒。

决策树回归的缺点是容易过拟合,因此需要采取剪枝等策略进行降低模型复杂度。

牛顿法求解非线性方程组的基本流程文档下载说明Download tips: This document is carefully compiled by this editor. I hope that after you download it, it can help you solve practical problems. The document 牛顿法求解非线性方程组的基本流程can be customized and modified after downloading, please adjust and use it according to actual needs, thank you! In addition, this shop provides you with various types of practical materials, such as educational essays, diary appreciation, sentence excerpts, ancient poems, classic articles, topic composition, work summary, word parsing, copy excerpts, other materials and so on, want to know different data formats and writing methods, please pay attention!牛顿法(Newton's method),又称为牛顿拉弗森方法(NewtonRaphson method),是一种用来寻找方程的根的迭代数值方法。

它是一种快速、有效的方法,尤其适用于求解非线性方程组。

牛顿法的基本思想是通过不断逼近函数的根,利用函数的一阶导数和二阶导数信息进行迭代求解。

下面我将详细介绍。

1. 牛顿法的基本原理。

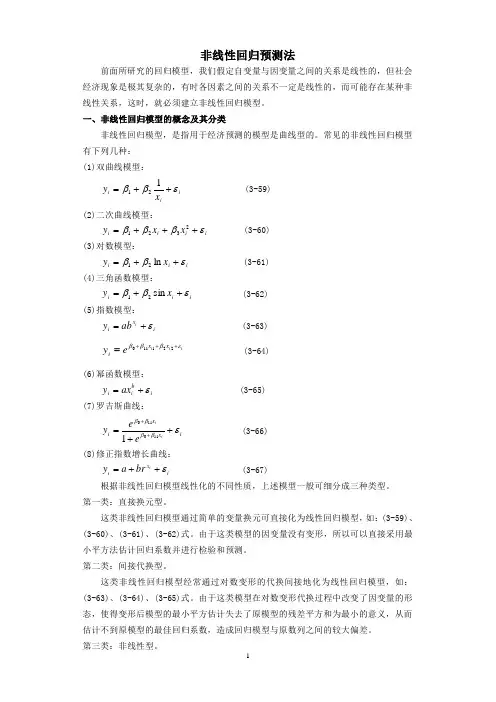

非线性回归预测法前面所研究的回归模型,我们假定自变量与因变量之间的关系是线性的,但社会经济现象是极其复杂的,有时各因素之间的关系不一定是线性的,而可能存在某种非线性关系,这时,就必须建立非线性回归模型。

一、非线性回归模型的概念及其分类非线性回归模型,是指用于经济预测的模型是曲线型的。

常见的非线性回归模型有下列几种: (1)双曲线模型:i ii x y εββ++=121 (3-59) (2)二次曲线模型:i i i i x x y εβββ+++=2321 (3-60)(3)对数模型:i i i x y εββ++=ln 21 (3-61)(4)三角函数模型:i i i x y εββ++=sin 21 (3-62)(5)指数模型:i x i i ab y ε+= (3-63)i i i x x i e y εβββ+++=221110 (3-64)(6)幂函数模型:i b i i ax y ε+= (3-65)(7)罗吉斯曲线:i x x i iie e y εββββ++=++1101101 (3-66)(8)修正指数增长曲线:i x i i br a y ε++= (3-67)根据非线性回归模型线性化的不同性质,上述模型一般可细分成三种类型。

第一类:直接换元型。

这类非线性回归模型通过简单的变量换元可直接化为线性回归模型,如:(3-59)、(3-60)、(3-61)、(3-62)式。

由于这类模型的因变量没有变形,所以可以直接采用最小平方法估计回归系数并进行检验和预测。

第二类:间接代换型。

这类非线性回归模型经常通过对数变形的代换间接地化为线性回归模型,如:(3-63)、(3-64)、(3-65)式。

由于这类模型在对数变形代换过程中改变了因变量的形态,使得变形后模型的最小平方估计失去了原模型的残差平方和为最小的意义,从而估计不到原模型的最佳回归系数,造成回归模型与原数列之间的较大偏差。

第三类:非线性型。

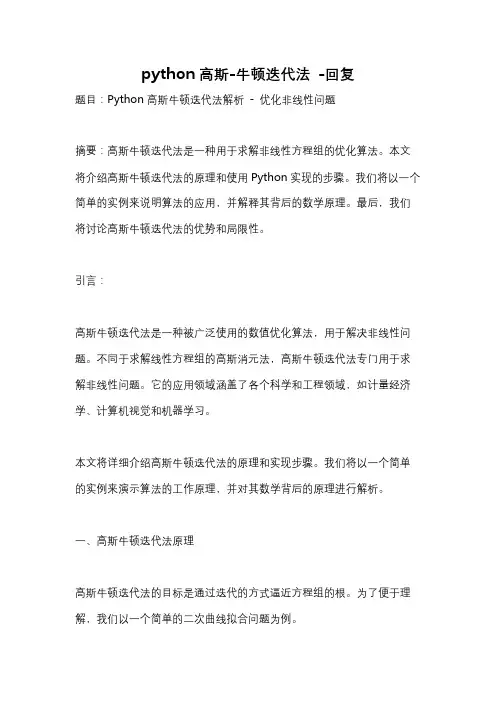

python高斯-牛顿迭代法-回复题目:Python高斯牛顿迭代法解析- 优化非线性问题摘要:高斯牛顿迭代法是一种用于求解非线性方程组的优化算法。

本文将介绍高斯牛顿迭代法的原理和使用Python实现的步骤。

我们将以一个简单的实例来说明算法的应用,并解释其背后的数学原理。

最后,我们将讨论高斯牛顿迭代法的优势和局限性。

引言:高斯牛顿迭代法是一种被广泛使用的数值优化算法,用于解决非线性问题。

不同于求解线性方程组的高斯消元法,高斯牛顿迭代法专门用于求解非线性问题。

它的应用领域涵盖了各个科学和工程领域,如计量经济学、计算机视觉和机器学习。

本文将详细介绍高斯牛顿迭代法的原理和实现步骤。

我们将以一个简单的实例来演示算法的工作原理,并对其数学背后的原理进行解析。

一、高斯牛顿迭代法原理高斯牛顿迭代法的目标是通过迭代的方式逼近方程组的根。

为了便于理解,我们以一个简单的二次曲线拟合问题为例。

假设我们有一组观测数据点(xi,yi),我们希望通过一个二次曲线y = a * x^2 + b * x + c来拟合这些数据。

我们的目标是找到最佳的参数a、b 和c,使得拟合曲线与观测数据点的差异最小。

为了达到这个目标,我们可以定义一个误差函数E(a,b,c)来衡量拟合曲线和观测数据点之间的差异。

常见的误差函数有平方和误差函数,即E(a,b,c) = Σ(yi - (a * xi^2 + b * xi + c))^2。

我们的目标是最小化误差函数,即找到使得E(a,b,c)最小的a、b和c。

高斯牛顿迭代法通过迭代的方式逼近最佳参数。

二、高斯牛顿迭代法步骤1. 初始化参数:初始化a、b和c的初始值。

2. 计算雅可比矩阵:雅可比矩阵是误差函数对参数的偏导数矩阵。

对于二次曲线拟合问题,雅可比矩阵J可以表示为:J = [∂E/∂a, ∂E/∂b, ∂E/∂c]3. 计算梯度向量:梯度向量是误差函数在当前参数值处的梯度,即导数。

梯度向量g可以表示为:g = [∂E/∂a, ∂E/∂b, ∂E/∂c]4. 计算海森矩阵:海森矩阵是误差函数对参数的二阶偏导数矩阵。

非线性回归模型概述非线性回归模型是一种用于建模非线性关系的统计方法。

与线性回归模型不同,非线性回归模型可以更好地适应各种复杂的数据关系。

常见的非线性回归模型1. 多项式回归:多项式回归是一种常见的非线性回归模型,它通过添加多项式项来拟合非线性数据。

多项式回归可以适应曲线、弯曲或波浪形状的数据。

2. 对数回归:对数回归是一种用于建模变量之间对数关系的非线性回归方法。

对数回归常用于分析指数增长或衰减的情况。

3. Sigmoid回归:Sigmoid回归是一种常用的非线性回归模型,适用于二分类问题。

它使用Sigmoid函数将输入数据映射到0和1之间的概率值。

4. 高斯核回归:高斯核回归是一种使用高斯核函数的非线性回归方法。

它可以用于拟合非线性关系,并在一定程度上克服了多项式回归模型的过拟合问题。

模型选择和评估选择合适的非线性回归模型是关键,可以根据数据的特点和问题的要求进行选择。

一般来说,模型应具有良好的拟合能力和泛化能力。

评估非线性回归模型的常见指标包括均方误差(MSE)、平均绝对误差(MAE)和决定系数(R-squared)。

这些指标可以帮助我们评估模型的预测性能和拟合程度。

模型建立步骤1. 导入数据:将需要建模的数据导入到合适的工具或编程环境中。

2. 数据预处理:对数据进行清洗、缺失值处理、特征选择等预处理步骤。

3. 模型选择:根据数据的特点选择合适的非线性回归模型。

4. 模型训练:使用训练集对选定的模型进行训练。

5. 模型评估:使用测试集对模型进行评估,并计算评估指标。

6. 模型优化:根据评估结果进行模型参数调整和优化。

7. 模型应用:使用优化后的模型对新数据进行预测。

总结非线性回归模型是一种强大的建模工具,可以用于解决各种复杂的数据分析问题。

在选择和应用非线性回归模型时,需要根据具体情况进行合理选择,并对模型进行评估和优化,以提高建模的准确性和预测能力。

求解非线性方程组的牛顿法和拟牛顿法解决非线性方程组是数学中的一个经典问题,其应用广泛,例如化学、物理、优化和金融等领域。

牛顿法和拟牛顿法是求解非线性方程组的常见方法之一,本文将详细介绍牛顿法和拟牛顿法的原理、优缺点以及实现步骤。

一、牛顿法牛顿法是一种高效的求解非线性方程组的方法,其基本思路是利用一阶泰勒展开式近似于原方程组,并以此构造一个更新方案,通过一步步迭代找到原方程组的解。

以二元非线性方程组为例,假设有方程组:f1(x1, x2) = 0f2(x1, x2) = 0根据泰勒展开式的一阶近似可得:f(x + Δx) ≈ f(x) + Jx Δx其中,Jx为函数f(x)在点x处的Jacobian矩阵,Δx是待求解的更新量,它满足:f(x + Δx) = 0将近似式带入上述方程组中,可得:Jx Δx = - f(x)由此可以推导出牛顿法的迭代式:x(k+1) = x(k) - [Jx(k)]⁻¹f(x(k))其中,k表示迭代次数,x(k)表示第k次迭代的解,[Jx(k)]⁻¹为Jx(k)的逆矩阵。

牛顿法的优点在于它的收敛速度很快,尤其是在初始值接近解时,收敛更加快速。

但是,牛顿法也有很大的局限性,一是它需要求解Jacobian矩阵,在高维情况下计算复杂度很高,二是它的收敛性依赖于初始值,有时候可能会陷入局部最优。

二、拟牛顿法为了克服牛顿法的局限,拟牛顿法被发明出来。

和牛顿法一样,拟牛顿法同样是基于泰勒展开式的近似思想,但是它避免了Jacobian矩阵的计算,从而提高了算法的计算效率。

拟牛顿法的核心是对于迭代过程中的Jacobian矩阵的近似。

常见的近似方法有Damping BFGS(DBFGS)算法、DFP算法和Broyden-Fletcher-Goldfarb-Shanno(BFGS)算法等。

其中,BFGS算法是拟牛顿法的代表,其迭代步骤如下:1. 初始化矩阵B0 = I2. 对于第k次迭代,求出pk = -Bk-1gk,并更新xk+13. 计算sk = xk+1 - xk,yk = gk+1 - gk4. 更新矩阵Bk+1 = Bk + ΔB,其中ΔB = ρskskT - BkykT - ykBkρ = 1/ (ykT sk)其中ΔB称为BFGS修正子,它近似于Jacobian矩阵的逆。

4.非线性回归4.1 矩估计4.1.1 基本设定经典非线性回归的基准模型设定如下:(4-1)其中,。

在不引起误解的情况下,我们使用来表示样本和参数的函数。

对应的,矩阵表示形式如下:(4-2)在非线性回归的框架下,除了保留线性回归下的外生假定和球形假定,还需要如下可识别假定:假定4-1(可识别假定):对参数空间中的任意有,其中,Z为工具变量,为参数的真值。

由于非线性回归的性质基本是建立在大样本分析的框架上,因此它并不需要假定误差项的正态性。

由定义可知,参数的矩估计对应求解如下样本矩条件:(4-3) 此处工具变量Z是解释变量X的函数,为的满列秩矩阵。

4.1.2 性质1.一致性严格的证明比较复杂,参考Davidson和Mackinnon(2003)的处理,此处只给出估计量一致性的一个直观的说明。

假定存在,其中为于n无关的常数向量。

式(4-3)取概率极限,可有由可识别假定可知有,,所以有,即式(4-3)解得的估计量为真实参数的一致估计。

2.渐近正态性令,,假定有如下结论成立:;;。

其中和为有限正定矩阵,为有限可逆矩阵。

将式(4-3)乘以,则有(4-4)令在处中值展开,上式可转化为:(4-5) 则式(4-5)可转化如下:(4-6)由中心极限定理有。

所以有,(4-7) 3.渐近有效性由和的定义有,易知,当时,的渐近协方差阵可以达到最小,此时渐近协方差阵为。

但是,由于含有未知参数,使用作为Z的矩估计并不可行。

实际计算时,我们必须找到其对应的可行估计量。

4.2 LS估计4.2.1NLS估计量非线性模型的LS估计也称为NLS估计。

同样的,由LS估计的思想可知,NLS估计的最优化目标函数可设定如下:(4-8)上式对求一阶导,可得:令一阶导为0,则我们可以获得如下最优化条件:(4-9)对比式(4-9)与(4-3)可知,此时的NLS估计事实上是矩估计在时的特例,因此关于矩估计的性质分析也可以应用到对NLS估计的分析。

同样的,在渐近可识别的假定下,NLS估计也是一致估计。

非线性回归预测法——高斯牛顿法(詹学朋)非线性回归预测法前面所研究的回归模型,我们假定自变量与因变量之间的关系是线性的,但社会经济现象是极其复杂的,有时各因素之间的关系不一定是线性的,而可能存在某种非线性关系,这时,就必须建立非线性回归模型。

一、非线性回归模型的概念及其分类非线性回归模型,是指用于经济预测的模型是曲线型的。

常见的非线性回归模型有下列几种: (1)双曲线模型:i ii x y εββ++=121 (3-59) (2)二次曲线模型:i i i i x x y εβββ+++=2321 (3-60)(3)对数模型:i i i x y εββ++=ln 21 (3-61)(4)三角函数模型:i i i x y εββ++=sin 21 (3-62)(5)指数模型:i x i i ab y ε+= (3-63)i i i x x i e y εβββ+++=221110 (3-64)(6)幂函数模型:i b i i ax y ε+= (3-65)(7)罗吉斯曲线:i x x i iie e y εββββ++=++1101101 (3-66)(8)修正指数增长曲线:i x i i br a y ε++= (3-67)根据非线性回归模型线性化的不同性质,上述模型一般可细分成三种类型。

第一类:直接换元型。

这类非线性回归模型通过简单的变量换元可直接化为线性回归模型,如:(3-59)、(3-60)、(3-61)、(3-62)式。

由于这类模型的因变量没有变形,所以可以直接采用最小平方法估计回归系数并进行检验和预测。

第二类:间接代换型。

这类非线性回归模型经常通过对数变形的代换间接地化为线性回归模型,如:(3-63)、(3-64)、(3-65)式。

由于这类模型在对数变形代换过程中改变了因变量的形态,使得变形后模型的最小平方估计失去了原模型的残差平方和为最小的意义,从而估计不到原模型的最佳回归系数,造成回归模型与原数列之间的较大偏差。

第三类:非线性型。

这类非线性回归模型属于不可线性化的非线性回归模型,如:(3-66)和(3-67)式。

第一类和第二类非线性回归模型相对于第三类,又称为可线性化的非线性回归模型。

本节重点研究第一类和第二类即可线性化的非线性回归模型。

二、可线性化的非线性回归模型的模型变换及参数估计 1.直接换元法换元过程和参数估计方法,如表3-6所示。

例设某商店1991~2000年的商品流通费用率和商品零售额资料如下表:表3-7 直接换元法计算表根据上述资料,配合适当的回归模型分析商品零售额与流通费用率的关系,若2001年该商店商品零售额将为36.33万元,对2001年的商品流通费用额作出预测。

解:(1)绘制散点图(图略)。

从图中可清楚看到:随着商品零售额的增加,流通费用率有不断下降的趋势,呈双曲线形状。

(2)建立双曲线模型。

i ii x y εββ++=121 令 i i x x 1'=得 i i i x y εββ++='21(3)估计参数。

Eviews4.0 软件,hzz -暴P92表3-7得回归模型为:ii x y 17610.425680.2+=∧2.间接代换法代换过程和参数估计方法如(暴经济预测P96)表3-8所示。

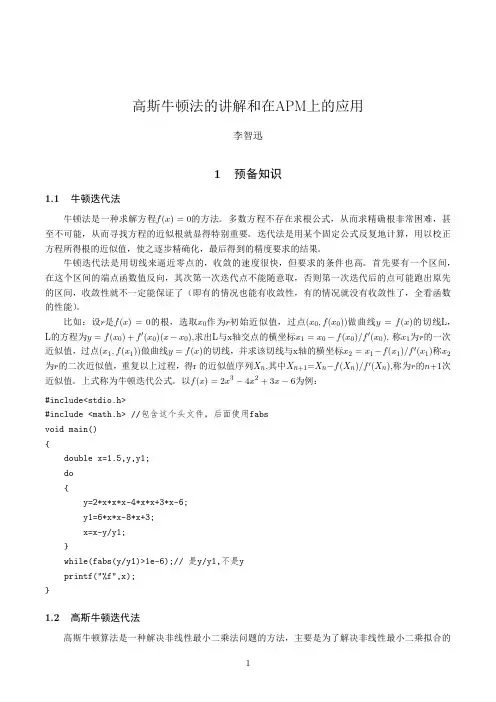

三、高斯—牛顿迭代法高斯—牛顿迭代法的基本思想是使用泰勒级数展开式去近似地代替非线性回归模型,然后通过多次迭代,多次修正回归系数,使回归系数不断逼近非线性回归模型的最佳回归系数,最后使原模型的残差平方和达到最小。

高斯—牛顿法的一般步骤为:(1)初始值的选择。

其方法有三种,一是根据以往的经验选定初始值;二是用分段法求出初始值;三是对于可线性化的非线性回归模型,通过线性变换,然后施行最小平方法求出初始值。

(2)泰勒级数展开式。

设非线性回归模型为:i i i r x f y ε+=),( i=1,2,…,n (3-68)其中r 为待估回归系数,误差项 i ε~N(0, 2σ),设:')0(1)0(1)0(00),,(-=p g g g g Λ,为待估回归系数'110),,(-=p r r r r Λ的初始值,将(3-68)式),(r x f i 在g 0点附近作泰勒展开,并略去非线性回归模型的二阶及二阶以上的偏导数项,得())0(10)0()0(),(),(),(kkgr p k k i i i g rr r x f g x f r x f -⎥⎦⎤⎢⎣⎡∂∂+≈=-=∑ (3-69) 将(3-69)式代入(3-68)式,则()i k kg r p k k i i i g r r r x f g x f y ε+-⎥⎦⎤⎢⎣⎡∂∂+≈=-=∑)0(10)0()0(),(),(移项:()i k kgr p k k i i i g rr r x f g x f y ε+-⎥⎦⎤⎢⎣⎡∂∂≈-=-=∑)0(10)0()0(),(),(令:)0()0()0()0()0()0(),(),(kk k g r k i ik i i i g r r r x f D g x f y y -=⎥⎦⎤⎢⎣⎡∂∂=-==β 则:i k p k ik iD yεβ+≈∑-=)0(1)0()0( i=1,2,…,n 用矩阵形式表示,上式则为:ε+≈)0()0()0(B D Y (3-70)其中:⎪⎪⎪⎪⎭⎫ ⎝⎛=⎪⎪⎪⎪⎭⎫ ⎝⎛=⎪⎪⎪⎭⎫⎝⎛--=-⨯--⨯⨯)0(1)0(0)0(1)0(1)0(0)0(11)0(10)0()0()0(11)0(1),(),(p p npn p p n n nn B D D D D D g x f y g x f y Y ββM ΛM ΛM(3)估计修正因子。

用最小平方法对(3-70)式估计修正因子B (0),则:())0()0(1)0()0()0(''Y D DD b-= (3-71)设g (1)为第一次迭代值,则:)0()0()1(b g g+=(4)精确度的检验。

设残差平方和为:[]21)()0(),(∑=-=ni s i i g x f y SSR ,S 为重复迭代次数,对于给定的允许误差率K ,当k SSRSSR SSR s s s ≤--)()1()(时,则停止迭代;否则,对(3-71)式作下一次迭代。

(5)重复迭代。

重复(3-71)式,当重复迭代S 次时,则有: 修正因子:())()(1)()()(''s s s s s Y D D D b -=第(S+1)次迭代值:)()()1(s s s b g g +=+四、应用举例设12个同类企业的月产量与单位成本的资料如下表:表3-9 间接代换法计算表(注:资料来源《社会经济统计学原理教科书》第435页)试配合适当的回归模型分析月产量与单位产品成本之间的关系。

解:(1)回归模型与初始值的选择。

根据资料散点图的识别,本数据应配合指数模型:i xi ab y =∧对指数模型两边取对数,化指数模型为线性回归模型,然后施行最小平方法求出初始值。

即:b b a a y y bx a y i ii i lg ,lg ,lg lg lg lg '''===+=∧∧∧令:则上述指数模型变为:i ix b a y '''+=∧ i i x y 00831.026109.2'-=∧ 对'',b a 分别求反对数,得182.43,0.981a b ==,带入原模型, 得回归模型:i xi y 981.043.182⨯=∧高斯—牛顿迭代法初始回归模型:(0)(,)182.430.981i xi f x g =⨯残差平方和:(0)(0)2((,))1124.1526i i SSRy f x g =-=∑(2)泰勒级数展开式。

先对指数模型 i xi ab y =∧中的a 和b 分别求偏导数。

0000.981ii a a b b x x i a a b b y b a ==∧==∂==∂11000182.43**0.981i i a a b b x x i a a i i b b y ax b x b--==∧==∂==∂然后用泰勒级数展开指数模型,移项整理得(注:参见(3-69)、(3-70)式):(0)Y(0)D(0)B160-150.5866 0.82545 1535.0316 151-134.2148 0.73571 2189.0282 114-124.3015 0.68137 2534.1796 128-112.9332 0.61905 2878.011085-100.6550 0.55175 3180.7400 a (0)91- 91.4493 = 0.50128 3355.9387 75- 84.6948 0.46246 3453.405276- 76.9488 0.42180 3529.7593 b (0) 66- 68.5829 0.37594 3565.4701 60- 62.3104 0.34156 3556.9658 61- 57.7081 0.31633 3529.5468 60- 52.4302 0.28740 3473.9702(3-72)(3)估计修正因子。

解(3-72)式矩阵,得:a (0)12.09660288=b (0)-0.00180342第一次迭代值:a 1 a 0 a (0)194.5266= + =b 1 b 0 b (0)0.9792第一次迭代回归模型:(1)(,)194.52660.9792i xi f x g =⨯(4)精确度的检验。

残差平方和:(1)(1)2((,))999.4077i i SSR y f x g =-=∑给定误差率K=10-3,则:(1)(0)(1)1124.152610.12482999.4077SSR SSR k SSR -=-=>作下一次迭代。

(5)重复迭代。

将 a 1 代入(3-71)式作第二次迭代。

得估计修正因子:b 1a (1)0.647654043=b (1)-0.000066948第二次迭代值:a 2 a 1 a (1)195.1743= + =b 2 b 1 b (1)0.9791第二次迭代回归模型:(2)(,)195.17430.9791i xi f x g =⨯残差平方和:(2)(2)2((,))999.1241i iSSR yf xg =-=∑ 误差率:(2)(1)(2)999.407710.00028999.1241SSR SSR k SSR -=-=<误差率达到要求,停止迭代。

表3-10计算结果比较从上表可看出:高斯—牛顿迭代法具有收敛快,精确度高的优点,二次迭代就使精确度高达99.97%,相关指数也明显提高。