牛顿法与高斯牛顿法

- 格式:pdf

- 大小:180.50 KB

- 文档页数:14

高斯牛顿法手算例题高斯-牛顿法是一种用于求解非线性方程组的迭代数值方法。

它通过不断迭代来逼近方程组的解。

我将通过一个手算例题来演示高斯-牛顿法的应用。

假设我们要解决以下非线性方程组:f1(x, y) = x^2 + y^2 25 = 0。

f2(x, y) = x y 9 = 0。

我们首先需要计算方程组的雅可比矩阵,即关于变量x和y的偏导数矩阵:J = |2x 2y|。

|y x |。

接下来,我们选择一个初始解向量,例如(x0, y0) = (1, 1)。

然后,我们可以使用以下公式进行迭代:(xn+1, yn+1) = (xn, yn) (J^T J)^(-1) J^T f(xn, yn)。

其中,^T表示矩阵的转置,^(-1)表示矩阵的逆,f(xn, yn)是方程组的函数向量。

现在,让我们开始手算迭代过程:首先,计算f(x0, y0)和J在(x0, y0)处的值:f(x0, y0) = (1^2 + 1^2 25, 11 9) = (-22, -8)。

J = |21 21|。

|1 1 |。

接下来,我们需要计算(J^T J)^(-1) J^T的值。

首先计算J^T J:J^T J = |2 1| |2 2| = |8 4|。

|1 1| |2 2| |4 4|。

然后计算其逆矩阵:(J^T J)^(-1) = (1/(84-44)) |2 -1| = (1/8) |1 -1|。

|-1 2 | |-12 |。

最后,计算(J^T J)^(-1) J^T:(J^T J)^(-1) J^T = (1/8) |1 -1| |2 1| = (1/8) |21|。

|-1 2 | |1 1| |-1 2|。

现在,我们可以将这些值代入迭代公式中:(x1, y1) = (1, 1) (1/8) |2 1| |-22|。

|-1 2 | |-8 |。

(x1, y1) = (1, 1) (1/8) |2 1| |-22| = (1, 1) (1/8)|18|。

高斯牛顿迭代法

高斯-牛顿迭代法,基本思想是使用泰勒级数展开式去近似地代替非线性回归模型,然后通过多次迭代,多次修正回归系数,使回归系数不断逼近非线性回归模型的最佳回归系数,最后使原模型的残差平方和达到最小。

高斯-牛顿法的一般步骤为:

(1)初始值的选择。

其方法有三种,一是根据以往的经验选定初始值;二是用分段法求出初始值;三是对于可线性化的非线性回归模型,通过线性变换,然后施行最小平方法求出初始值。

(2)泰勒级数展开式。

设非线性回归模型为:

i=1,2,…,n(3-68)其中r为待估回归系数,误差项~N(0,)。

python高斯-牛顿迭代法高斯-牛顿迭代法(Gauss-Newton method)是一种用于非线性优化问题的迭代算法。

它基于线性最小二乘法,用于求解非线性函数的最优解。

在本文中,我们将详细介绍高斯-牛顿迭代法的原理和实现,以及一些常见的应用。

1.高斯-牛顿迭代法原理高斯-牛顿迭代法的目标是找到一个最优的参数向量x,使得一个非线性函数集合F(x)的残差平方和最小化。

其中,残差r(x)定义为测量值与模型值之间的差异,即r(x) = y - f(x),其中y是测量值,f(x)是模型值函数。

残差平方和定义为S(x) = sum(r(x)^2),即所有残差的平方和。

为了找到最优的参数向量x,高斯-牛顿迭代法采用以下步骤进行迭代:1.初始化参数向量x的值。

2.计算残差r(x)和残差雅可比矩阵J(x)。

3.求解线性最小二乘问题J(x)^T J(x) dx = -J(x)^T r(x),其中dx是参数的增量。

4.更新参数向量x = x + dx。

5.重复步骤2-4,直到满足停止条件(如参数更新小于某个阈值)。

2.高斯-牛顿迭代法的实现高斯-牛顿迭代法的实现需要计算残差和雅可比矩阵,通过求解线性最小二乘问题来更新参数向量。

以下是一个简单的实现示例:```pythonimport numpy as npdef gauss_newton(x0, y, f, f_prime, max_iterations=100,tol=1e-6):x = x0for i in range(max_iterations):r = y - f(x)J = f_prime(x)dx = np.linalg.lstsq(J, -r, rcond=None)[0]x = x + dxif np.linalg.norm(dx) < tol:breakreturn x```在上述代码中,x0是参数向量的初始值,y是测量值,f是模型值函数,f_prime是模型值函数的导数。

光学牛顿公式和高斯公式

光学公式(公式一):

在光学中,有一条被称为光学公式的基本关系式,其形式类似于牛顿公式。

这个公式

描述了光线经过光学元件(如透镜)时产生的折射现象。

设光线从一个介质(如空气)射入另一个介质(如玻璃),其入射角为θ_1,折射角为θ_2。

则根据光学公式可以得到如下关系:

n_1 × sin(θ_1) = n_2 × sin(θ_2)

n_1和n_2分别是两个介质的折射率,sin(θ_1)和sin(θ_2)分别是入射角和折射角

的正弦值。

高斯公式(公式二):

高斯公式是光学中用于计算薄透镜成像的一种公式,由哥特弗里德·威廉·莱布尼茨

与约翰内斯·凯普勒设计。

设一个物体与薄透镜之间的距离为u,物体到透镜的焦距为f,则像到透镜的距离为v。

根据高斯公式,我们可以得到如下关系:

1/v - 1/u = 1/f

v为像的位置,u为物体的位置。

此公式的表达方式是光学中常用的一种方法,用于定性描述薄透镜成像的情况。

这两个公式在光学研究中具有重要的作用,能够描述光线在传播和成像过程中的行为,为我们解释和预测光学现象提供了基础。

matlab高斯牛顿算法求参数

一、背景

1、matlab高斯牛顿算法是一种解决非线性回归问题的算法,它是一类最优化算法的一种,主要用于迭代求解多个参数之间的关系。

2、matlab高斯牛顿算法的核心思想就是以“最小二乘法”为基础,基于牛顿迭代法,对模型参数不断迭代,最终获取最优参数,从而达到最小化平方误差。

二、实现原理

1、matlab高斯牛顿算法是利用牛顿迭代法求解参数。

牛顿法的迭代过程中,采用“梯度下降法”的概念,逐步减少误差,最终趋近最优解。

2、在迭代过程中,需要求解参数的梯度,此时使用偏导数表来求解。

对于非线性模型,误差即为拟合曲线到样本点距离的平方和,即所谓的二次损失函数,求解参数的梯度,即求此损失函数的偏导数。

3、求解参数的梯度以后,就可以进行参数的迭代更新,根据迭代的结果,可以求出该参数的最优解,即最小二乘法所说的唯一最优参数,此时迭代求解就可以结束。

三、使用步骤

1、首先,使用matlab实现梯度下降法,求出参数的梯度和初值。

2、根据参数的梯度和初值,构建误差函数,求偏导数,以计算梯度方向,然后运用牛顿迭代法,对参数进行更新。

3、使用给定的步长和迭代次数,开始做参数迭代更新,不断的

改变参数的值,寻求最优参数。

4、迭代停止后,获取参数最优值,结束matlab高斯牛顿算法迭代过程。

四、结论

matlab高斯牛顿算法是一种求解非线性回归问题的最优化算法。

其核心思想是根据损失函数的梯度,通过牛顿迭代法,不断更新参数,最终求解出最优参数,从而最小化平方误差。

高斯牛顿迭代法解方程组高斯牛顿迭代法是一种常用的数值计算方法,用于解决非线性方程组。

本文将介绍高斯牛顿迭代法的基本原理、步骤和应用场景。

一、高斯牛顿迭代法的原理高斯牛顿迭代法是利用泰勒展开式对非线性方程组进行近似线性化处理,然后通过迭代逼近的方法求解方程组的解。

其基本思想是通过线性化的近似,将非线性方程组转化为一个线性方程组,然后利用线性方程组的解逐步逼近非线性方程组的解。

二、高斯牛顿迭代法的步骤1. 初始化:给定初值向量x0和迭代误差精度ε。

2. 迭代计算:根据当前的估计解xk,计算出近似的雅可比矩阵Jk 和残差向量rk。

3. 判断终止条件:若rk的范数小于等于设定的误差精度ε,则停止迭代,输出近似解xk;否则,进行下一步迭代。

4. 更新迭代:根据当前的估计解xk和雅可比矩阵Jk,计算更新量Δxk。

5. 更新解向量:更新当前的估计解xk+1 = xk + Δxk。

6. 回到步骤2,继续迭代计算,直到满足终止条件。

三、高斯牛顿迭代法的应用场景高斯牛顿迭代法广泛应用于科学和工程领域的各种问题求解,特别适用于非线性最小二乘问题的求解。

以下是一些常见的应用场景:1. 数据拟合:在实际问题中,常常需要根据一组观测数据拟合出一个数学模型。

高斯牛顿迭代法可以通过最小化观测数据与模型之间的误差,来确定最优的模型参数。

2. 图像处理:高斯牛顿迭代法可以用于图像处理中的图像恢复、图像去噪、图像分割等问题的求解。

例如,在图像恢复中,可以利用高斯牛顿迭代法求解出最佳的恢复图像。

3. 机器学习:高斯牛顿迭代法可以用于机器学习中的参数估计和模型训练。

例如,在逻辑回归中,可以使用高斯牛顿迭代法来求解最优的模型参数。

4. 无线通信:高斯牛顿迭代法在无线通信系统中的信道估计、自适应调制等问题的求解中得到广泛应用。

通过迭代计算信道的状态信息,可以提高通信系统的性能。

高斯牛顿迭代法是一种强大的数值计算方法,可以有效地求解非线性方程组。

一、引言牛顿壳层定理(Newton's Shell Theorem)和高斯定理(Gauss's Theorem)是电磁学中的两个重要定理。

牛顿壳层定理指出,在静电场中,一个带电体的外部电场与该带电体的形状和大小无关,只与带电体的总电荷有关。

高斯定理则表明,闭合曲面的电通量等于闭合曲面所包围的电荷总量除以真空介电常数。

本文将对这两个定理进行证明。

二、牛顿壳层定理的证明假设有一个带电体,其电荷为Q,形状为任意形状。

为了证明牛顿壳层定理,我们将考虑一个半径为r的球壳,其厚度为dr,且与带电体相切。

根据库仑定律,球壳内外的电场强度分别为:E1 = kQ/(4πε0r^2) (球壳内部)E2 = kQ/(4πε0(r+dr)^2) (球壳外部)其中,k为库仑常数,ε0为真空介电常数。

现在,我们计算球壳内外电场的差异:ΔE = E2 - E1 = kQ[1/(4πε0(r+dr)^2) - 1/(4πε0r^2)]将上式化简得:ΔE = kQdr/(4πε0r^2(r+dr)^2)为了证明牛顿壳层定理,我们需要证明球壳内外电场差异ΔE与r无关。

为此,我们考虑以下极限:lim (ΔE/dr) = lim [kQ/(4πε0r^2(r+dr)^2) dr/dr]由于dr是无穷小量,我们可以将其与dr相消,得到:lim (ΔE/dr) = lim [kQ/(4πε0r^2(r+dr)^2)] = kQ/(4πε0r^4)由此可见,ΔE与r无关,因此牛顿壳层定理得证。

三、高斯定理的证明高斯定理的数学表达式为:∮E·dS = Q_enclosed/ε0其中,E为电场强度,dS为闭合曲面上的面积元素,Q_enclosed为闭合曲面所包围的电荷总量。

为了证明高斯定理,我们考虑一个带电体,其电荷为Q,形状为任意形状。

现在,我们构造一个以带电体为中心,半径为r的闭合曲面S。

根据库仑定律,闭合曲面S上的电场强度E可以表示为:E = kQ/(4πε0r^2) r^2/|r|^3 n其中,r为带电体到闭合曲面S上某点的位置矢量,n为闭合曲面S上该点的单位法向量。

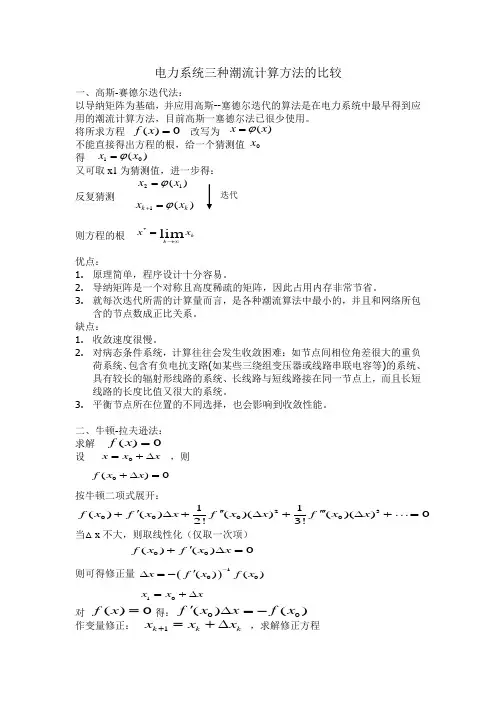

电力系统三种潮流计算方法的比较 一、高斯-赛德尔迭代法:以导纳矩阵为基础,并应用高斯--塞德尔迭代的算法是在电力系统中最早得到应用的潮流计算方法,目前高斯一塞德尔法已很少使用。

将所求方程 改写为 不能直接得出方程的根,给一个猜测值 得 又可取x1为猜测值,进一步得:反复猜测则方程的根优点:1. 原理简单,程序设计十分容易。

2. 导纳矩阵是一个对称且高度稀疏的矩阵,因此占用内存非常节省。

3. 就每次迭代所需的计算量而言,是各种潮流算法中最小的,并且和网络所包含的节点数成正比关系。

缺点:1. 收敛速度很慢。

2. 对病态条件系统,计算往往会发生收敛困难:如节点间相位角差很大的重负荷系统、包含有负电抗支路(如某些三绕组变压器或线路串联电容等)的系统、具有较长的辐射形线路的系统、长线路与短线路接在同一节点上,而且长短线路的长度比值又很大的系统。

3. 平衡节点所在位置的不同选择,也会影响到收敛性能。

二、牛顿-拉夫逊法:求解 设 ,则按牛顿二项式展开:当△x 不大,则取线性化(仅取一次项)则可得修正量对 得: 作变量修正: ,求解修正方程()0f x =()0f x =10()x x ϕ=迭代 0x 21()x x ϕ=1()k k x x ϕ+=()x x ϕ=()0f x =k k x x lim *∞→=0x x x =+∆0()0f x x +∆=23000011()()()()()()02!3!f x f x x f x x f x x ''''''+∆+∆+∆+=00()()0f x f x x '+∆=()100()()x f x f x -'∆=-10x x x =+∆00()()f x x f x '∆=-1k k k x x x +=+∆牛顿法是数学中求解非线性方程式的典型方法,有较好的收敛性。

自从20世纪60年代中期采用了最佳顺序消去法以后,牛顿法在收敛性、内存要求、计算速度方面都超过了其他方法,成为直到目前仍被广泛采用的方法。

---文档均为word文档,下载后可直接编辑使用亦可打印---摘要数值优化是机器学习的重要部分,不断研究和改进已有的优化算法,使其更快更高效,是机器学习领域的一个重要研究方向。

作为数值优化算法中具有代表性的两个二阶算法,LM和BFGS算法各有优缺点,对它们的性能进行分析和比较给二阶数值算法的改进及更广泛的应用提供重要参考。

本论文从LM和BFGS算法的数学基础开始阐述,通过对比两个算法求解多个函数极小值的问题,我们发现LM算法和BFGS算法的差异并不大。

大多数情况下LM算法能够达到更小的误差,但是迭代次数比BFGS算法稍多。

对于等高线为椭圆的函数,LM算法的收敛速度通常比BFGS算法快,但是后期运算的迭代次数比BFGS 算法多;而其他情况下LM算法和BFGS算法的收敛速度差别不大。

由于LM算法在大部分情况下的极值求解效率稍高,我们实现了基于LM算法在前向神经网络中的学习,并用于解决模式分类问题。

实验结果表明基于LM算法的前向神经网络在垃圾邮件分类应用中能取得90%以上的分类正确率。

关键词:数值优化,LM算法,BFGS算法,前向神经网络AbstractNumerical optimization is an important part of machine learning. The analysis study of existing optimization algorithms to make them faster and more efficient is an important research direction in the field of machine learning. As two popular second-order algorithms, the LM and BFGS algorithms have their own advantages and disadvantages. The analysis and comparison of their performance have great significance for the improvement of the second-order numerical algorithms and their wider application in engineering areas.This thesis starts from introducing the mathematical foundation of LM and BFGS algorithms. By comparing the performance of the two algorithms for finding the minima of different functions, we find that the LM and BFGS algorithms have similar performance for numerical optimization problems. In most cases of our experiments, the LM algorithm can achieve smaller error, but the number of iterations is slightly higher than that of the BFGS algorithm. For the functions with elliptical contours, the convergence speed of the LM algorithm is usually faster than that of the BFGS algorithm, but the iterations of later computation are much more than those of the BFGS algorithm. while in other cases,their convergence speed is almost the same. Because of the higher efficiency of the LM algorithm in most cases, the LM algorithm is employed to train feedforward neural networks which are applied to deal with some pattern classification problem. The experimental results show that the feedforward neural network trained by the LM algorithm can reach more than 90% classification accuracy in the applications of classify spam and none spam email.Keywords:Numerical optimization,LM algorithm,BFGS algorithm,Feedforward neural networks第一章绪论1.1研究背景优化算法是用来求解问题的最优解或近似最优解的[15]。

高斯牛顿和牛顿法

高斯-牛顿法和牛顿法都是优化算法中常用的方法,它们都被用来寻找函数的最小值。

牛顿法是一种基于一阶导数信息的迭代算法,通过不断利用函数的局部信息逼近函数的极值。

其基本思想是在当前点处,利用一阶导数信息构造一个局部的二次模型,并求出该二次模型的极小值点,将其作为下一步的搜索点。

这个过程可以被表示为以下迭代公式:

x_{k+1} = x_k - \frac{f'(x_k)}{f''(x_k)}

其中,x_k表示第k次迭代时的搜索点,f(x)表示要求解的目标函数,f'(x)和f''(x)分别表示目标函数的一阶和二阶导数。

高斯-牛顿法是牛顿法的一种变形,用于求解最小二乘问题。

在最小二乘问题中,我们需要找到使得残差平方和最小的参数向量。

高斯-牛顿法通过在每次迭代中使用雅可比矩阵(残差对参数的一阶导数矩阵)来逼近目标函数,其迭代公式为:

x_{k+1} = x_k - [J(x_k)^T J(x_k)]^{-1} J(x_k)^T f(x_k)

其中,J(x_k)是函数f(x)在x_k处的雅可比矩阵,f(x_k)是x_k处的残差向量。

总之,高斯-牛顿法和牛顿法都是常用的优化算法,用于寻找函数的最小值,但它们的应用范围略有不同。

牛顿法可以处理一般的无约束问题,而高斯-牛顿法则更适合求解最小二乘问题。

高斯–牛顿算法和 lm 方法

高斯-牛顿算法和lm方法是数值计算中用于求解非线性最小二

乘问题的两种经典算法。

非线性最小二乘问题是指寻找一个向量x,使得一个非线性函数f(x)的平方和最小。

高斯-牛顿算法是一种迭代算法,它利用牛顿法的思想,通过多次迭

代来逼近最优解。

其基本思路是在当前点处,利用函数的一阶和二阶导数信息构造一个二次模型,然后将该模型最小化来求解下一个点,直到满足停机准则。

lm方法是一种综合了高斯-牛顿算法和Levenberg-Marquardt方法的算法,其主要思路是在高斯-牛顿算法的基础上增加一个正则化项,

以保证算法的收敛性和稳定性。

具体而言,lm方法在迭代过程中动

态地调整正则化项的大小,当模型误差较小时,正则化项接近于零,lm算法就退化为高斯-牛顿算法;当模型误差较大时,正则化项增大,以保证算法的收敛性和稳定性。

相对于高斯-牛顿算法而言,lm方法具有更好的收敛性和稳定性,因为它可以避免高斯-牛顿算法中可能出现的矩阵奇异性和发散等问题。

此外,lm方法还可以根据数据的特点和模型的复杂度来动态地调整

正则化项的大小,以保证算法在不同情况下都能够取得良好的效果。

总之,高斯-牛顿算法和lm方法是求解非线性最小二乘问题中常用的两种方法,它们都具有迭代求解、效率高等优点,但lm方法相对于高斯-牛顿算法而言更加稳定和收敛快速,因此在实际应用中更受欢迎。

lm高斯牛顿法的改进

lm高斯牛顿法是一种常用的非线性最小二乘优化方法,但在实际应用中存在一些问题,如容易陷入局部最优解、对初值敏感等。

因此,为了提高训练效果和泛化性能,需要对该方法进行改进。

现有的改进方法有:引入正则化项、加入牛顿校正、采用逆Hessian矩阵的估计等,这些方法可以有效地提高算法的鲁棒性和收敛速度。

另外,通过结合其他优化方法如共轭梯度法和拟牛顿法,还可以进一步提高算法的效果。

因此,在使用lm高斯牛顿法时,需要根据具体情况选择合适的改进方法,以达到更好的优化效果。

- 1 -。

pcl库的收敛函数

PCL库的收敛函数是指在点云配准算法中,计算两个点云之间的变换矩阵时所使用的优化算法。

这种算法主要是利用了梯度下降法来优化误差函数,使得两个点云之间的误差最小化。

PCL库的收敛函数主要包括以下几种类型:

1. GradientDescent:梯度下降法是一种常用的优化算法,它利用误差函数的梯度信息来调整参数,使得误差函数的值逐渐变小,从而达到最优解。

2. NormalDistributionsTransform:NDT算法是一种基于高斯分布模型的点云配准算法,它通过计算点云的高斯分布函数来估计点云之间的变换矩阵。

3. GaussNewton:高斯牛顿法是一种非线性优化算法,它利用误差函数的二阶导数信息来求解最优解,可以更快地收敛。

4. LevenbergMarquardt:LM算法是一种广泛应用于非线性优化问题的算法,它综合了梯度下降法和高斯牛顿法的优点,既可以保证全局收敛,又具有快速的局部收敛性能。

PCL库的收敛函数在点云配准算法中发挥着重要的作用,能够提高点云配准的精度和效率,对于点云处理和机器视觉应用具有重要的意义。

- 1 -。