RBF神经网络设计

- 格式:pptx

- 大小:683.87 KB

- 文档页数:24

摘要当今人类社会已经进入了大数据时代,数据大多呈现出维数高、规模大、结构复杂等特性。

在大数据的研究当中,许多数据如媒体数据、遥感数据、生物医学数据、社交网络数据、金融数据等都是高维数据,尤其是在人类生产生活中,含高维数据的无解析模型或一次候选解的评价计算成本十分巨大的昂贵多目标问题,对其仿真求解势必面临维数灾难。

因此,寻找合适的降维方法处理高维数据已是迫切需求。

神经网络是模拟人脑的结构和功能而建立起来的分布式信息处理系统,面对高维多目标优化等非线性问题,与其他降维方法相比,神经网络具有巨大的优势,这得益于神经网络具有高度非线性、结构复杂、自学习、自适应等特点。

RBF神经网络是一种新颖有效的前馈式神经网络,它具有很强的非线性映射能力,能以任意精度全局逼近一个非线性函数,而且学习速度快。

利用RBF神经网络实现对高维数据的降维预处理,不仅有充分的理论依据,而且更具优越性。

本文在对RBF神经网络算法进行优化研究的基础上,研究了基于数据驱动的特征选择RBF 神经网络降维方法,并将其应用在高维多目标优化决策空间降维预处理及Pareto 优劣性预测中。

为了提高RBF神经网络的学习效率,本文首先对RBF神经网络进行改进研究。

通过自适应调节RBF神经网络的学习率和动量因子,加快了RBF神经网络的收敛速度;同时,利用遗传算法对RBF神经网络的三个参数初始值进行优化设计,提出了一种遗传自适应RBF神经网络算法。

将改进算法分别应用于故障诊断和UCI数据集的分类实验上,验证了改进RBF神经网络算法的有效性和优越性。

针对无解析模型的高维多目标优化问题,提出了一种最大信息系数与最大相关最小冗余相结合的特征选择方法,利用遗传自适应RBF神经网络算法在高维特征空间中选取出了一个低维的特征子集,从而实现对高维特征空间的降维。

通过在UCI数据集上的分类实验,证明了该降维算法在保证较好分类精度的前提下,大大减少了计算成本。

为了降低高维多目标优化的维数灾难,将本文提出的基于最大冗余最小相关的遗传自适应RBF神经网络特征选择算法用于多目标优化中的决策空间降维预处理,进行Pareto优劣性预测并将其嵌入MOEAs算法。

基于RBF神经网络整定的PID控制器设计及仿真摘要目前,因为PID控制具有简单的控制结构,可通过调节比例积分和微分取得基本满意的控制性能,在实际应用中又较易于整定,所以广泛应用于过程控制和运动控制中,尤其在可建立精确模型的确定性控制系统中应用比较多。

然而随着现代工业过程的日益复杂,对控制要求的逐步增高(如稳定性、准确性、快速性等),经典控制理论面临着严重的挑战。

对工业控制领域中非线性系统,采用传统PID 控制不能获得满意的控制效果。

采用基于梯度下降算法优化RBF神经网络,它将神经网络和PID控制技术融为一体,既具有常规PID控制器结构简单、物理意义明确的优点,同时又具有神经网络自学习、自适应的功能。

因此,本文通过对RBF神经网络的结构和计算方法的学习,设计一个基于RBF神经网络整定的PID控制器,构建其模型,进而编写M语言程序。

运用MATLAB软件对所设计的RBF神经网络整定的PID控制算法进行仿真研究。

然后再进一步通过仿真实验数据,研究本控制系统的稳定性,鲁棒性,抗干扰能力等。

关键词:PID;RBF神经网络;参数整定SETTING OF THE PID CONTROLLER BASED ON RBF NEURAL NETWORK DESIGN AND SIMULATIONAbstractAt present, because the PID control has a simple control structure, through adjusting the proportional integral and differential gain basic satisfactory control performance, and is relatively easy to setting in practical application, so widely used in process control and motion control, especially in the accurate model can be built more deterministic control system application. With the increasingly complex of the modern industrial process, however, increased step by step to control requirements (e.g., stability, accuracy and quickness, etc.), classical control theory is faced with severe challenges. Non-linear systems in industrial control field, using the traditional PID control can not obtain satisfactory control effect. Optimized RBF neural network based on gradient descent algorithm, it will be integrated neural network and PID control technology, with a conventional PID controller has simple structure, physical meaning is clear advantages, at the same time with neural network self-learning, adaptive function. Therefore, this article through to the RBF neural network structure and the calculation method of learning, to design a setting of the PID controller based on RBF neural network, constructs its model, and then write M language program. Using the MATLAB software to design the RBF neural network settingof PID control algorithm simulation research. Data and then further through simulation experiment, the control system stability, robustness, anti-interference ability, etc.Keywords: PID; RBF neural network; Parameter setting目录摘要 (Ⅰ)Abstract (Ⅱ)1 绪论 (1)1.1 课题研究背景及意义 (1)1.2神经网络的发展历史 (2)1.3本课题研究的主要内容 (5)2 神经网络 (6)2.1神经网络的基本概念和特点 (6)2.2人工神经网络构成的基本原理 (6)2.3神经网络的结构 (7)2.3.1前馈网络 (7)2.3.2 反馈网络 (7)2.4神经网络的学习方式 (8)2.4.1监督学习(有教师学习) (8)2.4.2非监督学习(无教师学习) (8)2.4.3再励学习(强化学习) (9)2.5 RBF神经网络 (9)2.5.1 RBF神经网络的发展简史 (9)2.5.2 RBF的数学模型 (9)2.5.3被控对象Jacobian信息的辨识算法 (10)2.5.4 RBF神经网络的学习算法 (11)2.6 本章小结 (13)3 PID控制器 (13)3.1 PID控制器简介 (13)3.2 经典PID控制原理 (13)3.3 现有PID控制器参数整定方法 (15)3.4 PID控制的局限 (15)3.5本章小结 (16)4 基于RBF神经网络整定的PID控制器设计 (17)4.1 RBF神经网络的PID整定原理 (17)4.2 神经网络PID控制器的设计 (17)4.3 本章小结 (18)5 仿真分析 (19)5.1 系统的稳定性分析 (19)5.2 系统抗干扰能力分析 (20)5.3 系统鲁棒性分析 (22)5.4 本章小结 (23)结论 (24)参考文献 (25)致谢 (26)附录仿真程序 (27)1 绪论1.1 课题研究背景及意义PID控制器(按比例、积分和微分进行控制的调节器)是最早发展起来的应用经典控制理论的控制策略之一,是工业过程控制中应用最广泛,历史最悠久,生命力最强的控制方式,在目前的工业生产中,90%以上的控制器为PID控制器。

1998年3月重庆大学学报 (自然科学版)V ol.21,№.2第21卷第2期J o urnal o f Ch ongqing U niv er sity(N atura l Science Editio n)M ar.1998基于遗传算法的RBF神经网络设计黄席樾 刘菡萏 石为人(重庆大学自动化系,重庆,400044;第一作者54岁,男,教授) 摘 要 采用了遗传算法自动构造RBF网络,把网络结构的形式作为一个子集选择问题来解决,并提出了新的遗传操作算子来改进遗传算法,加快了收敛速度,提高了算法的实用性。

文中介绍了遗传算法的结构与优化原理,并给出了RBF网络结构的生成方法,用仿真结果证明了本算法的可行性。

关键词 系统辩识/遗传算法;RBF网络;网络结构 中国图书资料分类法分类号 TP273.220 引 言非线性系统的控制是人们面临的一大难题。

神经网络以其逼近非线性函数的能力而被广泛用于解决非线性系统的控制问题。

对于连续系统,由于径向基函数(Radial basis Func-tion,简称RBF)神经网络的可调参数与网络的输出呈线性关系而用作非线性系统的模型,用于非线性连续系统的自动控制系统中。

然而,如何设计RBF神经网络结构,至今没有系统的规则可循。

目前训练RBF网络的方法大致分为两类:1)学习隐层的中心向量和宽度;2)学习隐层到输出层的连接权重。

在这些学习算法中,网络结构或隐层结点数目是基于先验知识预定的[1]。

但是,RBF网络结构是关于隐层结点数、中心向量和连接权的最小化问题。

由于隐层结点数是不连续和不可微的,而传统优化方法需要对象函数的导数信息,当对象函数是多模态时,存在很多局部极小,传统优化方法很可能陷入这些局部极小。

而且,当考虑网络结构和参数时,搜索空间实际上是无限的,对传统优化方法来说在计算上是不可能实现的。

由于这些原因,许多传统优化方法,例如随机法、梯度下降法、仿真退火法等,应用于完成搜索时都存在着很多问题。

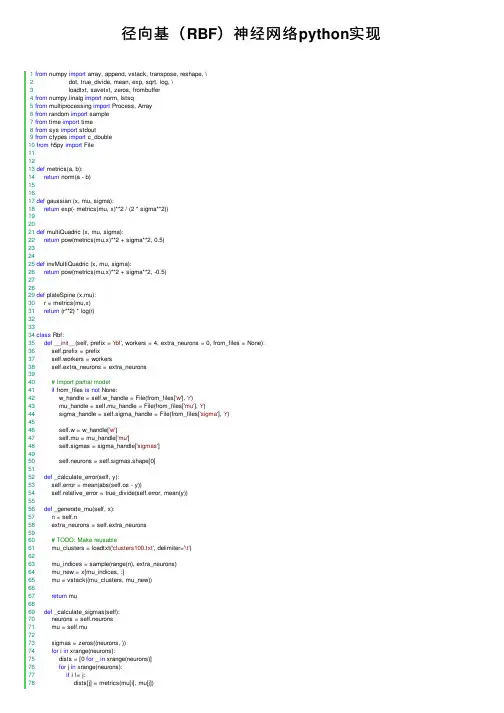

Python实现的径向基(RBF)神经⽹络⽰例本⽂实例讲述了Python实现的径向基(RBF)神经⽹络。

分享给⼤家供⼤家参考,具体如下:from numpy import array, append, vstack, transpose, reshape, \dot, true_divide, mean, exp, sqrt, log, \loadtxt, savetxt, zeros, frombufferfrom numpy.linalg import norm, lstsqfrom multiprocessing import Process, Arrayfrom random import samplefrom time import timefrom sys import stdoutfrom ctypes import c_doublefrom h5py import Filedef metrics(a, b):return norm(a - b)def gaussian (x, mu, sigma):return exp(- metrics(mu, x)**2 / (2 * sigma**2))def multiQuadric (x, mu, sigma):return pow(metrics(mu,x)**2 + sigma**2, 0.5)def invMultiQuadric (x, mu, sigma):return pow(metrics(mu,x)**2 + sigma**2, -0.5)def plateSpine (x,mu):r = metrics(mu,x)return (r**2) * log(r)class Rbf:def __init__(self, prefix = 'rbf', workers = 4, extra_neurons = 0, from_files = None):self.prefix = prefixself.workers = workersself.extra_neurons = extra_neurons# Import partial modelif from_files is not None:w_handle = self.w_handle = File(from_files['w'], 'r')mu_handle = self.mu_handle = File(from_files['mu'], 'r')sigma_handle = self.sigma_handle = File(from_files['sigma'], 'r')self.w = w_handle['w']self.mu = mu_handle['mu']self.sigmas = sigma_handle['sigmas']self.neurons = self.sigmas.shape[0]def _calculate_error(self, y):self.error = mean(abs(self.os - y))self.relative_error = true_divide(self.error, mean(y))def _generate_mu(self, x):n = self.nextra_neurons = self.extra_neurons# TODO: Make reusablemu_clusters = loadtxt('clusters100.txt', delimiter='\t')mu_indices = sample(range(n), extra_neurons)mu_new = x[mu_indices, :]mu = vstack((mu_clusters, mu_new))return mudef _calculate_sigmas(self):neurons = self.neuronsmu = self.musigmas = zeros((neurons, ))for i in xrange(neurons):dists = [0 for _ in xrange(neurons)]for j in xrange(neurons):if i != j:dists[j] = metrics(mu[i], mu[j])sigmas[i] = mean(dists)* 2# max(dists) / sqrt(neurons * 2))return sigmasdef _calculate_phi(self, x):C = self.workersneurons = self.neuronsmu = self.musigmas = self.sigmasphi = self.phi = Nonen = self.ndef heavy_lifting(c, phi):s = jobs[c][1] - jobs[c][0]for k, i in enumerate(xrange(jobs[c][0], jobs[c][1])):for j in xrange(neurons):# phi[i, j] = metrics(x[i,:], mu[j])**3)# phi[i, j] = plateSpine(x[i,:], mu[j]))# phi[i, j] = invMultiQuadric(x[i,:], mu[j], sigmas[j]))phi[i, j] = multiQuadric(x[i,:], mu[j], sigmas[j])# phi[i, j] = gaussian(x[i,:], mu[j], sigmas[j]))if k % 1000 == 0:percent = true_divide(k, s)*100print(c, ': {:2.2f}%'.format(percent))print(c, ': Done')# distributing the work between 4 workersshared_array = Array(c_double, n * neurons)phi = frombuffer(shared_array.get_obj())phi = phi.reshape((n, neurons))jobs = []workers = []p = n / Cm = n % Cfor c in range(C):jobs.append((c*p, (c+1)*p + (m if c == C-1 else 0)))worker = Process(target = heavy_lifting, args = (c, phi))workers.append(worker)worker.start()for worker in workers:worker.join()return phidef _do_algebra(self, y):phi = self.phiw = lstsq(phi, y)[0]os = dot(w, transpose(phi))return w, os# Saving to HDF5os_h5 = os_handle.create_dataset('os', data = os)def train(self, x, y):self.n = x.shape[0]## Initialize HDF5 cachesprefix = self.prefixpostfix = str(self.n) + '-' + str(self.extra_neurons) + '.hdf5'name_template = prefix + '-{}-' + postfixphi_handle = self.phi_handle = File(name_template.format('phi'), 'w')os_handle = self.w_handle = File(name_template.format('os'), 'w')w_handle = self.w_handle = File(name_template.format('w'), 'w')mu_handle = self.mu_handle = File(name_template.format('mu'), 'w')sigma_handle = self.sigma_handle = File(name_template.format('sigma'), 'w') ## Mu generationmu = self.mu = self._generate_mu(x)self.neurons = mu.shape[0]print('({} neurons)'.format(self.neurons))# Save to HDF5mu_h5 = mu_handle.create_dataset('mu', data = mu)## Sigma calculationprint('Calculating Sigma...')sigmas = self.sigmas = self._calculate_sigmas()# Save to HDF5sigmas_h5 = sigma_handle.create_dataset('sigmas', data = sigmas)print('Done')## Phi calculationprint('Calculating Phi...')phi = self.phi = self._calculate_phi(x)print('Done')# Saving to HDF5print('Serializing...')phi_h5 = phi_handle.create_dataset('phi', data = phi)del phiself.phi = phi_h5print('Done')## Algebraprint('Doing final algebra...')w, os = self.w, _ = self._do_algebra(y)# Saving to HDF5w_h5 = w_handle.create_dataset('w', data = w)os_h5 = os_handle.create_dataset('os', data = os)## Calculate errorself._calculate_error(y)print('Done')def predict(self, test_data):mu = self.mu = self.mu.valuesigmas = self.sigmas = self.sigmas.valuew = self.w = self.w.valueprint('Calculating phi for test data...')phi = self._calculate_phi(test_data)os = dot(w, transpose(phi))savetxt('iok3834.txt', os, delimiter='\n')return os@propertydef summary(self):return '\n'.join( \['-----------------','Training set size: {}'.format(self.n),'Hidden layer size: {}'.format(self.neurons),'-----------------','Absolute error : {:02.2f}'.format(self.error),'Relative error : {:02.2f}%'.format(self.relative_error * 100)])def predict(test_data):mu = File('rbf-mu-212243-2400.hdf5', 'r')['mu'].valuesigmas = File('rbf-sigma-212243-2400.hdf5', 'r')['sigmas'].valuew = File('rbf-w-212243-2400.hdf5', 'r')['w'].valuen = test_data.shape[0]neur = mu.shape[0]mu = transpose(mu)mu.reshape((n, neur))phi = zeros((n, neur))for i in range(n):for j in range(neur):phi[i, j] = multiQuadric(test_data[i,:], mu[j], sigmas[j])os = dot(w, transpose(phi))savetxt('iok3834.txt', os, delimiter='\n')return os更多关于Python相关内容感兴趣的读者可查看本站专题:《》、《》、《》、《》及《》希望本⽂所述对⼤家Python程序设计有所帮助。

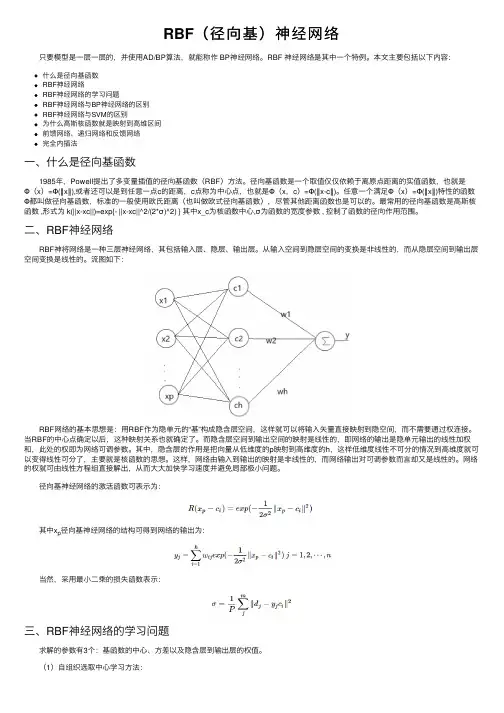

RBF(径向基)神经⽹络 只要模型是⼀层⼀层的,并使⽤AD/BP算法,就能称作 BP神经⽹络。

RBF 神经⽹络是其中⼀个特例。

本⽂主要包括以下内容:什么是径向基函数RBF神经⽹络RBF神经⽹络的学习问题RBF神经⽹络与BP神经⽹络的区别RBF神经⽹络与SVM的区别为什么⾼斯核函数就是映射到⾼维区间前馈⽹络、递归⽹络和反馈⽹络完全内插法⼀、什么是径向基函数 1985年,Powell提出了多变量插值的径向基函数(RBF)⽅法。

径向基函数是⼀个取值仅仅依赖于离原点距离的实值函数,也就是Φ(x)=Φ(‖x‖),或者还可以是到任意⼀点c的距离,c点称为中⼼点,也就是Φ(x,c)=Φ(‖x-c‖)。

任意⼀个满⾜Φ(x)=Φ(‖x‖)特性的函数Φ都叫做径向基函数,标准的⼀般使⽤欧⽒距离(也叫做欧式径向基函数),尽管其他距离函数也是可以的。

最常⽤的径向基函数是⾼斯核函数 ,形式为 k(||x-xc||)=exp{- ||x-xc||^2/(2*σ)^2) } 其中x_c为核函数中⼼,σ为函数的宽度参数 , 控制了函数的径向作⽤范围。

⼆、RBF神经⽹络 RBF神将⽹络是⼀种三层神经⽹络,其包括输⼊层、隐层、输出层。

从输⼊空间到隐层空间的变换是⾮线性的,⽽从隐层空间到输出层空间变换是线性的。

流图如下: RBF⽹络的基本思想是:⽤RBF作为隐单元的“基”构成隐含层空间,这样就可以将输⼊⽮量直接映射到隐空间,⽽不需要通过权连接。

当RBF的中⼼点确定以后,这种映射关系也就确定了。

⽽隐含层空间到输出空间的映射是线性的,即⽹络的输出是隐单元输出的线性加权和,此处的权即为⽹络可调参数。

其中,隐含层的作⽤是把向量从低维度的p映射到⾼维度的h,这样低维度线性不可分的情况到⾼维度就可以变得线性可分了,主要就是核函数的思想。

这样,⽹络由输⼊到输出的映射是⾮线性的,⽽⽹络输出对可调参数⽽⾔却⼜是线性的。

⽹络的权就可由线性⽅程组直接解出,从⽽⼤⼤加快学习速度并避免局部极⼩问题。

径向基(RBF)神经⽹络python实现 1from numpy import array, append, vstack, transpose, reshape, \2 dot, true_divide, mean, exp, sqrt, log, \3 loadtxt, savetxt, zeros, frombuffer4from numpy.linalg import norm, lstsq5from multiprocessing import Process, Array6from random import sample7from time import time8from sys import stdout9from ctypes import c_double10from h5py import File111213def metrics(a, b):14return norm(a - b)151617def gaussian (x, mu, sigma):18return exp(- metrics(mu, x)**2 / (2 * sigma**2))192021def multiQuadric (x, mu, sigma):22return pow(metrics(mu,x)**2 + sigma**2, 0.5)232425def invMultiQuadric (x, mu, sigma):26return pow(metrics(mu,x)**2 + sigma**2, -0.5)272829def plateSpine (x,mu):30 r = metrics(mu,x)31return (r**2) * log(r)323334class Rbf:35def__init__(self, prefix = 'rbf', workers = 4, extra_neurons = 0, from_files = None):36 self.prefix = prefix37 self.workers = workers38 self.extra_neurons = extra_neurons3940# Import partial model41if from_files is not None:42 w_handle = self.w_handle = File(from_files['w'], 'r')43 mu_handle = self.mu_handle = File(from_files['mu'], 'r')44 sigma_handle = self.sigma_handle = File(from_files['sigma'], 'r')4546 self.w = w_handle['w']47 self.mu = mu_handle['mu']48 self.sigmas = sigma_handle['sigmas']4950 self.neurons = self.sigmas.shape[0]5152def _calculate_error(self, y):53 self.error = mean(abs(self.os - y))54 self.relative_error = true_divide(self.error, mean(y))5556def _generate_mu(self, x):57 n = self.n58 extra_neurons = self.extra_neurons5960# TODO: Make reusable61 mu_clusters = loadtxt('clusters100.txt', delimiter='\t')6263 mu_indices = sample(range(n), extra_neurons)64 mu_new = x[mu_indices, :]65 mu = vstack((mu_clusters, mu_new))6667return mu6869def _calculate_sigmas(self):70 neurons = self.neurons71 mu = self.mu7273 sigmas = zeros((neurons, ))74for i in xrange(neurons):75 dists = [0 for _ in xrange(neurons)]76for j in xrange(neurons):77if i != j:78 dists[j] = metrics(mu[i], mu[j])79 sigmas[i] = mean(dists)* 280# max(dists) / sqrt(neurons * 2))81return sigmas8283def _calculate_phi(self, x):84 C = self.workers85 neurons = self.neurons86 mu = self.mu87 sigmas = self.sigmas88 phi = self.phi = None89 n = self.n909192def heavy_lifting(c, phi):93 s = jobs[c][1] - jobs[c][0]94for k, i in enumerate(xrange(jobs[c][0], jobs[c][1])):95for j in xrange(neurons):96# phi[i, j] = metrics(x[i,:], mu[j])**3)97# phi[i, j] = plateSpine(x[i,:], mu[j]))98# phi[i, j] = invMultiQuadric(x[i,:], mu[j], sigmas[j]))99 phi[i, j] = multiQuadric(x[i,:], mu[j], sigmas[j])100# phi[i, j] = gaussian(x[i,:], mu[j], sigmas[j]))101if k % 1000 == 0:102 percent = true_divide(k, s)*100103print(c, ': {:2.2f}%'.format(percent))104print(c, ': Done')105106# distributing the work between 4 workers107 shared_array = Array(c_double, n * neurons)108 phi = frombuffer(shared_array.get_obj())109 phi = phi.reshape((n, neurons))110111 jobs = []112 workers = []113114 p = n / C115 m = n % C116for c in range(C):117 jobs.append((c*p, (c+1)*p + (m if c == C-1 else 0)))118 worker = Process(target = heavy_lifting, args = (c, phi))119 workers.append(worker)120 worker.start()121122for worker in workers:123 worker.join()124125return phi126127def _do_algebra(self, y):128 phi = self.phi129130 w = lstsq(phi, y)[0]131 os = dot(w, transpose(phi))132return w, os133# Saving to HDF5134 os_h5 = os_handle.create_dataset('os', data = os)135136def train(self, x, y):137 self.n = x.shape[0]138139## Initialize HDF5 caches140 prefix = self.prefix141 postfix = str(self.n) + '-' + str(self.extra_neurons) + '.hdf5'142 name_template = prefix + '-{}-' + postfix143 phi_handle = self.phi_handle = File(name_template.format('phi'), 'w')144 os_handle = self.w_handle = File(name_template.format('os'), 'w')145 w_handle = self.w_handle = File(name_template.format('w'), 'w')146 mu_handle = self.mu_handle = File(name_template.format('mu'), 'w')147 sigma_handle = self.sigma_handle = File(name_template.format('sigma'), 'w') 148149## Mu generation150 mu = self.mu = self._generate_mu(x)151 self.neurons = mu.shape[0]152print('({} neurons)'.format(self.neurons))153# Save to HDF5154 mu_h5 = mu_handle.create_dataset('mu', data = mu)155156## Sigma calculation157print('Calculating Sigma...')158 sigmas = self.sigmas = self._calculate_sigmas()159# Save to HDF5160 sigmas_h5 = sigma_handle.create_dataset('sigmas', data = sigmas)161print('Done')162163## Phi calculation164print('Calculating Phi...')165 phi = self.phi = self._calculate_phi(x)166print('Done')167# Saving to HDF5168print('Serializing...')169 phi_h5 = phi_handle.create_dataset('phi', data = phi)170del phi171 self.phi = phi_h5172print('Done')173174## Algebra175print('Doing final algebra...')176 w, os = self.w, _ = self._do_algebra(y)177# Saving to HDF5178 w_h5 = w_handle.create_dataset('w', data = w)179 os_h5 = os_handle.create_dataset('os', data = os)180181## Calculate error182 self._calculate_error(y)183print('Done')184185def predict(self, test_data):186 mu = self.mu = self.mu.value187 sigmas = self.sigmas = self.sigmas.value188 w = self.w = self.w.value189190print('Calculating phi for test data...')191 phi = self._calculate_phi(test_data)192 os = dot(w, transpose(phi))193 savetxt('iok3834.txt', os, delimiter='\n')194return os195196 @property197def summary(self):198return'\n'.join( \199 ['-----------------',200'Training set size: {}'.format(self.n),201'Hidden layer size: {}'.format(self.neurons),202'-----------------',203'Absolute error : {:02.2f}'.format(self.error),204'Relative error : {:02.2f}%'.format(self.relative_error * 100)]) 205206207def predict(test_data):208 mu = File('rbf-mu-212243-2400.hdf5', 'r')['mu'].value209 sigmas = File('rbf-sigma-212243-2400.hdf5', 'r')['sigmas'].value 210 w = File('rbf-w-212243-2400.hdf5', 'r')['w'].value211212 n = test_data.shape[0]213 neur = mu.shape[0]214215 mu = transpose(mu)216 mu.reshape((n, neur))217218 phi = zeros((n, neur))219for i in range(n):220for j in range(neur):221 phi[i, j] = multiQuadric(test_data[i,:], mu[j], sigmas[j])222223 os = dot(w, transpose(phi))224 savetxt('iok3834.txt', os, delimiter='\n')225return os。

径向基神经网络的介绍及其案例实现径向基(RBF)神经网络是一种常用的人工神经网络模型,它以径向基函数作为激活函数来进行模式分类和回归任务。

该网络在模式识别、函数逼近、数据挖掘等领域都具有良好的性能,并且具有较好的泛化能力。

引言:径向基(RBF)神经网络最早是由Broomhead和Lowe于1988年引入的,它是一种前馈式神经网络。

RBF神经网络的主要思想是以输入向量与一组高斯函数的基函数作为输入层,然后再通过隐藏层进行特征映射,最后通过输出层进行模式分类或回归。

1.RBF神经网络的结构:RBF神经网络包括输入层、隐藏层和输出层三层。

输入层负责接收输入向量,隐藏层负责特征映射,输出层负责输出结果。

输入层:输入层接收具有所要分类或回归的特征的数据,通常使用欧几里德距离计算输入层的神经元与输入向量之间的距离。

隐藏层:隐藏层是RBF神经网络的核心部分,它通过一组径向基函数来进行特征映射。

隐藏层的神经元数量通常和训练样本数量相同,每个神经元负责响应一个数据样本。

输出层:输出层根据隐藏层的输出结果进行模式分类或回归预测,并输出网络的最终结果。

2.RBF神经网络的训练:RBF神经网络的训练主要包括两个步骤:聚类和权值调整。

聚类:首先通过K-means等聚类算法将训练样本划分为若干个类别,每个类别对应一个隐藏层神经元。

这样可以将输入空间划分为若干个区域,每个区域中只有一个样本。

权值调整:通过最小化残差误差或最小化目标函数来优化隐藏层和输出层的权值。

常用的优化算法有最小二乘法、梯度下降法等。

3.RBF神经网络的案例实现:案例1:手写数字识别案例2:股票市场预测RBF神经网络也可以应用于股票市场的预测。

该案例中,RBF神经网络接收一组与股票相关的指标作为输入,通过隐藏层的特征映射将指标转化为更有意义的特征表示,最后通过输出层进行未来股价的回归预测。

该系统的训练样本为历史股票数据以及与之对应的未来股价。

结论:径向基(RBF)神经网络是一种应用广泛且效果良好的人工神经网络模型。

神经网络控制RBF神经网络是一种模拟人脑处理信息的计算模型,可以通过学习数据来预测和控制各种系统。

在控制领域,神经网络已经被广泛应用,很多控制问题可以通过神经网络来实现优化控制。

而基于类RBF(径向基函数)神经网络的控制方法也得到广泛的研究和应用,该方法是一种自适应控制方法,可以处理非线性系统,具有一定的理论和实际应用价值。

1. RBF神经网络控制方法RBF神经网络是一种前馈神经网络,由输入层、隐层和输出层组成。

其中,输入层接受外界输入,隐层包含一组RBF神经元,其作用是将输入空间划分为若干子空间,并将每个子空间映射到一个神经元上。

输出层是线性层,负责将隐层输出进行线性组合,输出控制信号。

在控制系统中,RBF神经元用于计算控制信号,从而实现控制目标。

RBF神经网络的训练包括两个阶段:聚类和权重调整。

聚类过程将输入空间划分成若干个类别,并计算出每个类别的中心和半径。

聚类算法的目标是使得同一类别内的样本距离聚类中心最小,不同类别之间距离最大。

常用的聚类算法包括k-means算法和LVQ算法。

权重调整过程将隐层神经元的权重调整到最优状态,以便将隐层输出映射到目标输出。

在实际控制中,RBF神经网络控制方法应用较为广泛,可以替代PID控制器等传统控制方法,具有良好的鲁棒性、自适应能力和较好的控制性能。

2. 基于RBF神经网络的控制方法RBF神经网络控制方法广泛应用于各种领域的控制任务,特别是在非线性系统控制中具有重要的应用价值。

基于RBF神经网络的控制方法主要包括以下两种:(1)虚拟控制策略:将系统建模为线性结构和非线性结构两部分,其中线性结构可以采用传统的控制方法进行控制,而非线性结构则采用基于RBF神经网络的控制方法进行控制。

虚拟控制策略的优点是可以将传统控制和RBF神经网络控制各自的优势融合起来,减小系统的复杂度和计算量。

(2)基于反馈线性化的控制策略:利用反馈线性化的方法将非线性系统变为一个可控的线性系统,从而可以采用传统线性控制方法进行控制。

RBF 神经网络概述1 RBF 神经网络的基本原理2 RBF 神经网络的网络结构3 RBF 神经网络的优点1 RBF 神经网络的基本原理人工神经网络以其独特的信息处理能力在许多领域得到了成功的应用。

它不仅具有强大的非线性映射能力,而且具有自适应、自学习和容错性等,能够从大量的历史数据中进行聚类和学习,进而找到某些行为变化的规律。

径向基函数(RBF)神经网络是一种新颖有效的前馈式神经网络,它具有最佳逼近和全局最优的性能,同时训练方法快速易行,不存在局部最优问题,这些优点使得RBF 网络在非线性时间序列预测中得到了广泛的应用。

1985年,Powell 提出了多变量插值的径向基函数(Radial-Basis Function, RBF)方法。

1988年,Broomhead 和Lowe 首先将RBF 应用于神经网络设计,构成了径向基函数神经网络,即RBF 神经网络。

用径向基函数(RBF)作为隐单元的“基”构成隐含层空间,对输入矢量进行一次变换,将低维的模式输入数据变换到高维空间内,通过对隐单元输出的加权求和得到输出,这就是RBF 网络的基本思想。

2 RBF 神经网络的网络结构RBF 网络是一种三层前向网络:第一层为输入层,由信号源节点组成。

第二层为隐含层,隐单元的变换函数是一种局部分布的非负非线性函数,他对中心点径向对称且衰减。

隐含层的单元数由所描述问题的需要确定。

第三层为输出层,网络的输出是隐单元输出的线性加权。

RBF 网络的输入空间到隐含层空间的变换是非线性的,而从隐含层空间到输出层空间的变换是线性。

不失一般性,假定输出层只有一个隐单元,令网络的训练样本对为{,}(1,2,...,)n n X d n N =,其中12[,,...,],(1,2,...,)T n n n nM X x x x n N ==为训练样本的输入,(1,2,...,)n d n N =为训练样本的期望输出,对应的实际输出为(1,2,...,)n Y n N =;基函数(,)i X t ϕ为第i 个隐单元的输出12[,,...,,...,](1,2,...,)i i i im iM t t t t t i I ==为基函数的中心; (1,2,...,)i w i I =为第i 个隐单元与输出单元之间的权值。

机器学习第四章神经网络报告一、神经网络概述1.简介人工神经网络是模仿脑细胞结构和功能、脑神经结构以及思维处理问题等脑功能的信息处系统,它从模仿人脑智能的角度出发,探寻新的信息表示、存储和处理方式,这种神经网络依靠系统的复杂程度,通过调整内部大量节点之间相互连接的关系,从而达到处理信息的目的,它采用了与传统人工智能和信息处理技术完全不同的机理,克服了传统的基于逻辑符号的人工智能在处理直觉、非结有针对性化信息方面的缺陷,具有自适应、自组织和实时学习的特点,它通过预先提供的一批相互对应的输入和输出数据,分析掌握两者之间潜在的规律,最终根据这些规律,用新的输入数据来推算输出结果。

人工神经网络(ANN)学习对于训练数据中的错误健壮性很好,且已被成功地应用到很多领域,例如视觉场景分析、语音识别、机器人控制以及医学图像处理等。

人工神经网络2.人工神经网络的特点及功能2.1人工神经网络具有以下几个突出的优点:(1)能充分逼近复杂的非线性关系。

只有当神经元对所有输入信号的综合处理结果超过某一个限值后才能输出一个信号。

(2)所有定量或定性的信息都等势分布贮存于网络内的各神经元,每个神经元及其连线只能表示一部分信息,因此当有节点断裂时也不影响总体运行效果,具有很强的鲁棒性和容错能力。

(3)采用并行分布处理方法,使得快速进行大量运算成为可能。

(4)可学习和自适应不知道或不确定的系统。

2.2人工神经网络的特点和优越性,使其具有以下三个显著的功能:(1)具有自学习功能:这种功能在图像识别和处理以及未来预测方面表现得尤为明显。

自学习功能在未来预测方面也意义重大,随着人工神经网络的发展,未来它将在更多的领域,比如经济预测、市场预测、效益预测等等,发挥更好的作用。

(2)具有联想存储功能:人的大脑能够对一些相关的知识进行归类划分,进而具有联想的功能,当我们遇到一个人或者一件事情的时候,跟此人或者此事相关的一些信息会浮现在你的脑海,而人工神经网络则通过它的反馈网络,实现一些相关事物的联想。