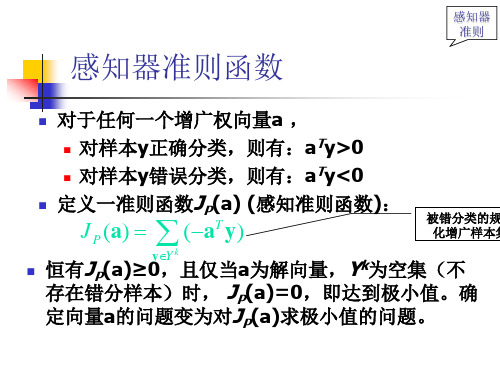

感知器准则函数

- 格式:ppt

- 大小:128.50 KB

- 文档页数:7

感知器准则函数范文

感知器是一种基于线性分离原理的二分类机器学习算法,传统的感知器算法主要依赖于一个重要的函数,准则函数(criterion function),用于确定感知器模型的权重并进行分类决策。

在本文中,我将详细介绍感知器准则函数的定义和作用,以及几种常见的准则函数类型。

1.均方误差函数(MSE):

$$E(w) = \frac{1}{N}\sum_{i=1}^{N}(y_i - \hat{y_i})^2$$

2. 绝对误差函数(absolute error):

$$E(w) = \frac{1}{N}\sum_{i=1}^{N},y_i - \hat{y_i},$$

对于具体的准则函数类型,根据准则函数的特点和应用场景,可以分为以下几种常见类型:

3. 对数似然函数(log-likelihood):对数似然函数在分类问题中起着重要作用,它基于概率模型,度量感知器对于样本分类的置信度。

对数似然函数通常结合了激活函数和损失函数的定义,利用最大似然估计的思想来选择最优的参数。

准则函数的选择应根据具体问题的特点和需求进行合理选择。

对于连续预测变量的问题,均方误差函数和绝对误差函数常常是合适的选择;对于二分类或多分类问题,可以使用对数似然函数或零一损失函数来度量模型的性能。

综上所述,准则函数在感知器学习算法中起着重要作用,它对模型的训练和分类能力具有直接影响,准则函数的选择应根据具体问题的特点来

确定。

在实际应用中,我们可以根据数据集的特点和算法的要求选择合适的准则函数,以获得更好的模型性能。

武汉理工大学理学院统计学系课程实验报告米用上面(5)中①②③的步骤,利用 MATLAB®程即可以实现感知器算法。

这里以一组二维的数据点为例。

随机生成 15个横纵坐标均在(0,1)之间的 点,与15个横纵坐标都在(2, 3)之间的点,共30个数据点,显然这两类点 是线性可分的,故可以采用感知器算法进行分类。

MATLAB^码如下: %感知器实 验 结 果及 分 析plot(x,y,'k'); %做出分界的直线xlabel('X');ylabel('Y');title('两类样本点');legend(第一类','第二类','分界直线'); 其中几次运算的结果如下:alpha =4.0000 -1.3939 -2.5368即直线的方程为:4 - 1.3939X - 2.5368y = 0迭代的次数为:8两类样本点alpha =4.0000 -1.4657 -1.4105即直线的方程为:4.0000 -1.4657X T.4105y = 0迭代的次数为:8从得到的结果来,对于线性可分的情形,感知器算法分类的效果还是比较好的,可以较为明显地把两类样本分开,而且迭代的次数为8,说明算法的收敛速度还是比较快的。

但是值得注意的是,感知器仅仅可以用于线性可分的样本的分类,对于线性不可分的情形,它是无能为力的。

所以在实际应用中,直接使用感知器算法的场合并不多,但是,它是很多复杂的算法的基础,比如支持向量机、人工神经网络等,所以从这这一点上来说,理解并掌握感知器算法还是十分有必要且重要的。

基于模式识别的个人认识班级自动化1002班姓名刘永福学号 1009101016摘要:本文主要介绍了模式识别的基本理论概念及算法,通过对模式识别的几种算法的概括、分析,推出算法的要求及步骤,实现样本的基本分类要求。

主要包括模式识别及模式识别系统的基本概念以及应用领域、线性判别函数的介绍及相关算法的推理证明、非线性判别函数的介绍及相关算法的推理证明。

一.模式识别及模式识别系统(1)模式识别的基本概念模式识别是以计算机为工具、各种传感器为信息来源,数据计算与处理为方法,对各种现象、事物、状态等进行准确地分析、判断识别与归类,包括人类在内的生物体的一项基本智能。

对于模式和模式识别有“广义”和“狭义”两种解释:广义地说,存在于时间和空间中可观察的事物,如果可以区别它们是否相同或相似,都可以称之为模式。

此时,模式识别是生物体(包括人)的基本活动,与感觉、记忆、学习、思维等心理过程紧密联系,是透视人类心理活动的重要窗口之一。

从这个角度讲,模式识别是研究生物体如何感知对象的学科,属于认识科学的范畴,是生理学家、心理学家、生物学家和神经生理学家的研究内容,常被称做认知模式识别。

具体来说,它是指人们把接收到的有关客观事物或人的刺激信息与他在大脑里已有的知识结构中有关单元的信息进行比较和匹配,从而辨认和确定该刺激信息意义的过程。

正是通过认知模式识别,我们才能认识世界,才能辨别出各个物体之间的差别,才能更好地学习和生活。

狭义地说,模式是为了能让计算机执行和完成分类识别任务,通过对具体的个别事物进行观测所得到的具有时间和空间分布的信息。

把模式所属的类别或同一类中模式的总体称为模式类(或简称为类)。

计算机模式识别就是指根据待识别对象的特征或属性,利用以计算机为中心的机器系统,运用一定的分析算法确定对象的类别的学科,是数学家、信息学专家和计算机专家的研究内容。

因此,模式识别的研究主要集中在认知模式识别和计算机模式识别这两个方面。

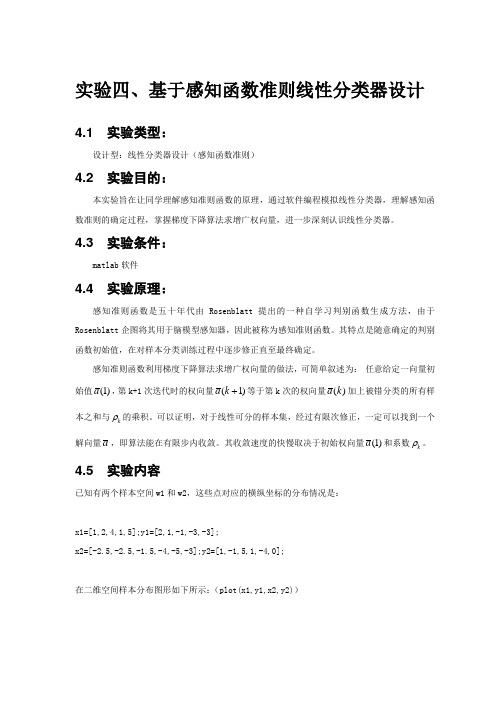

实验四、基于感知函数准则线性分类器设计4.1 实验类型:设计型:线性分类器设计(感知函数准则)4.2 实验目的:本实验旨在让同学理解感知准则函数的原理,通过软件编程模拟线性分类器,理解感知函数准则的确定过程,掌握梯度下降算法求增广权向量,进一步深刻认识线性分类器。

4.3 实验条件:matlab 软件4.4 实验原理:感知准则函数是五十年代由Rosenblatt 提出的一种自学习判别函数生成方法,由于Rosenblatt 企图将其用于脑模型感知器,因此被称为感知准则函数。

其特点是随意确定的判别函数初始值,在对样本分类训练过程中逐步修正直至最终确定。

感知准则函数利用梯度下降算法求增广权向量的做法,可简单叙述为: 任意给定一向量初始值)1(a ,第k+1次迭代时的权向量)1(+k a 等于第k 次的权向量)(k a 加上被错分类的所有样本之和与k ρ的乘积。

可以证明,对于线性可分的样本集,经过有限次修正,一定可以找到一个解向量a ,即算法能在有限步内收敛。

其收敛速度的快慢取决于初始权向量)1(a 和系数k ρ。

4.5 实验内容已知有两个样本空间w1和w2,这些点对应的横纵坐标的分布情况是:x1=[1,2,4,1,5];y1=[2,1,-1,-3,-3];x2=[-2.5,-2.5,-1.5,-4,-5,-3];y2=[1,-1,5,1,-4,0];在二维空间样本分布图形如下所示:(plot(x1,y1,x2,y2))2 -6-4-20246-6-4-22464.6 实验任务:1、 用matlab 完成感知准则函数确定程序的设计。

2、 请确定sample=[(0,-3),(1,3),(-1,5),(-1,1),(0.5,6),(-3,-1),(2,-1),(0,1),(1,1),(-0.5,-0.5),( 0.5,-0.5)];属于哪个样本空间,根据数据画出分类的结果。

3、 请分析一下k ρ和)1(a 对于感知函数准则确定的影响,并确定当k ρ=1/2/3时,相应的k 的值,以及)1(a 不同时,k 值得变化情况。

感知器准则例题感知器准则是一种在模式识别和机器学习中常用的准则,它主要用于二分类问题。

下面是一个简单的感知器准则的例子:假设我们有一个简单的二分类问题,其中特征为 (x),类别为(y)。

对于这个分类问题,我们定义一个线性分类器 (f(x) = w \cdot x + b),其中 (w) 是权重向量,(b) 是偏置项。

现在,我们有一个训练数据集 (D = {(x_1, y_1), (x_2, y_2), \ldots, (x_n, y_n)}),其中 (y_i = \pm 1) 表示类别。

我们的目标是找到一个分类器 (f(x)),使得对于训练数据集中的所有样本,(f(x)) 的输出与 (y) 的值一致。

感知器准则的基本思想是:如果存在一个分类器 (f(x)) 能够将训练数据集中的所有样本正确分类,那么这个分类器就是一个好的分类器。

为了找到这样的分类器,我们可以使用感知器算法。

该算法的基本步骤如下:1.初始化权重向量 (w) 和偏置项 (b) 为随机值。

2.对于每个样本 ((x_i, y_i)) 在训练数据集 (D) 中,计算(f(x_i)) 的值。

3.如果 (y_i f(x_i) > 0)(即类别和预测值一致),则不更新权重向量和偏置项。

4.如果 (y_i f(x_i) \leq 0)(即类别和预测值不一致),则根据规则更新权重向量和偏置项。

5.重复步骤 2-4,直到训练数据集中的所有样本都被正确分类,或者达到预设的迭代次数。

感知器准则的优点是简单、易于实现和收敛速度快。

然而,它也有一些限制,例如对非线性问题可能无法找到全局最优解,并且对噪声和异常值敏感。

为了解决这些问题,研究者们提出了许多改进算法,如支持向量机、神经网络等。

《模式识别》试题库一、基本概念题1.1 模式识别的三大核心问题是: 、 、 。

1.2、模式分布为团状时,选用 聚类算法较好。

1.3 欧式距离具有 。

马式距离具有 。

(1)平移不变性 (2)旋转不变性 (3)尺度缩放不变性 (4)不受量纲影响的特性1.4 描述模式相似的测度有: 。

(1)距离测度 (2)模糊测度 (3)相似测度 (4)匹配测度1.5 利用两类方法处理多类问题的技术途径有:(1) ;(2) ;(3) 。

其中最常用的是第 个技术途径。

1.6 判别函数的正负和数值大小在分类中的意义是: , 。

1.7 感知器算法 。

(1)只适用于线性可分的情况;(2)线性可分、不可分都适用。

1.8 积累位势函数法的判别界面一般为 。

(1)线性界面;(2)非线性界面。

1.9 基于距离的类别可分性判据有: 。

(1)1[]w B Tr S S - (2) BWS S (3) B W B S S S +1.10 作为统计判别问题的模式分类,在( )情况下,可使用聂曼-皮尔逊判决准则。

1.11 确定性模式非线形分类的势函数法中,位势函数K(x,x k )与积累位势函数K(x)的关系为( )。

1.12 用作确定性模式非线形分类的势函数法,通常,两个n 维向量x 和x k 的函数K(x,x k )若同时满足下列三个条件,都可作为势函数。

①( );②( );③ K(x,x k )是光滑函数,且是x 和x k 之间距离的单调下降函数。

1.13 散度J ij 越大,说明w i 类模式与w j 类模式的分布( )。

当w i 类模式与w j 类模式的分布相同时,J ij =( )。

1.14 若用Parzen 窗法估计模式的类概率密度函数,窗口尺寸h1过小可能产生的问题是( ),h1过大可能产生的问题是( )。

1.15 信息熵可以作为一种可分性判据的原因是: 。

1.16作为统计判别问题的模式分类,在( )条件下,最小损失判决规则与最小错误判决规则是等价的。

感知机定理的条件和结论感知机定理的条件和结论1. 引言感知机是一种二分类的线性分类模型,它的提出对机器学习领域产生了重要影响。

感知机定理是感知机理论的核心,它规定了感知机在什么条件下能够解决线性可分问题。

在本文中,我们将探讨感知机定理的条件和结论,帮助读者更全面、深入地理解感知机模型的原理和应用。

2. 感知机模型感知机模型是一种简单且常用的机器学习模型,它的目标是通过一个线性函数来划分不同类别的样本。

感知机模型可以表示为:f(x) = sign(w·x + b)其中,x是输入样本的特征向量,w和b是感知机模型的参数,w是权重向量,b是偏置项,sign是符号函数,当参数w·x + b大于0时,输出为1,否则输出为-1。

3. 感知机定理的条件感知机定理规定了感知机在什么条件下能够解决线性可分问题。

感知机定理的条件如下:a) 线性可分的数据集:该条件要求样本能够被一个超平面完美地分开,即存在一个参数向量w和偏置项b,能够使得所有正例样本满足w·x + b > 0,所有负例样本满足w·x + b < 0。

b) 学习率的选择:感知机算法中的学习率η需要大于0,且不能过大,否则可能导致模型无法收敛。

合适的学习率可以保证感知机算法在有限的步数内收敛到最优解。

4. 感知机定理的结论根据感知机定理,如果满足上述条件,感知机算法将能够找到一个参数向量w和偏置项b,可以将训练集中的样本完美地分开。

感知机算法的迭代过程如下:a) 初始化参数w和b为0或者一个较小的随机数。

b) 随机选择一个被错误分类的样本x,即w·x + b > 0且y = -1,或者w·x + b < 0且y = 1。

c) 更新参数w和b:w = w + ηyx,b = b + ηy,其中η是学习率,y是样本的真实标签。

d) 重复步骤b和c,直到所有的样本都被正确分类或者达到了指定的迭代次数。

【中⽂分词】结构化感知器SP结构化感知器(Structured Perceptron, SP)是由Collins [1]在EMNLP'02上提出来的,⽤于解决序列标注的问题。

中⽂分词⼯具、所采⽤的分词模型便是基于此。

1. 结构化感知器模型全局化地以最⼤熵准则建模概率P(Y|X);其中,X为输⼊序列x_1^n,Y为标注序列y_1^n。

不同于CRF建模概率函数,SP则是以最⼤熵准则建模score函数:S(Y,X) = \sum_s \alpha_s \Phi_s(Y,X)其中,\Phi_s(Y,X)为本地特征函数\phi_s(h_i,y_i)的全局化表⽰:\Phi_s(Y,X) = \sum_i \phi_s(h_i,y_i)那么,SP解决序列标注问题,可视作为:给定X序列,求解score函数最⼤值对应的Y序列:\mathop{\arg \max}_Y S(Y,X)为了避免模型过拟合,保留每⼀次更新的权重,然后对其求平均。

具体流程如下所⽰:因此,结构化感知器也被称为平均感知器(Average Perceptron)。

解码在将SP应⽤于中⽂分词时,除了事先定义的特征模板外,还⽤⽤到⼀个状态转移特征(y_{t-1}, y_t)。

记在时刻t的状态为y的路径y_1^{t}所对应的score函数最⼤值为\delta_t(y) = \max S(y_1^{t-1},X,y_t=y)则有,在时刻t+1\delta_{t+1}(y) = \max_{y'} \ \{ \delta_t(y') + w_{y',y} + F(y_{t+1}=y,X) \}其中,w_{y',y}为转移特征(y',y)所对应的权值,F(y_{t+1}=y,X)为y_{t+1}=y所对应的特征模板的特征值的加权之和。

2. 开源实现张开旭的(THULAC的雏形)给出了SP中⽂分词的简单实现。

⾸先,来看看定义的特征模板:def gen_features(self, x): # 枚举得到每个字的特征向量for i in range(len(x)):left2 = x[i - 2] if i - 2 >= 0 else '#'left1 = x[i - 1] if i - 1 >= 0 else '#'mid = x[i]right1 = x[i + 1] if i + 1 < len(x) else '#'right2 = x[i + 2] if i + 2 < len(x) else '#'features = ['1' + mid, '2' + left1, '3' + right1,'4' + left2 + left1, '5' + left1 + mid, '6' + mid + right1, '7' + right1 + right2]yield features共定义了7个特征:x_iy_ix_{i-1}y_ix_{i+1}y_ix_{i-2}x_{i-1}y_ix_{i-1}x_{i}y_ix_{i}x_{i+1}y_ix_{i+1}x_{i+2}y_i将状态B、M、E、S分别对应于数字0、1、2、3:def load_example(words): # 词数组,得到x,yy = []for word in words:if len(word) == 1:y.append(3)else:y.extend([0] + [1] * (len(word) - 2) + [2])return ''.join(words), y训练语料则采取的更新权重:for i in range(args.iteration):print('第 %i 次迭代' % (i + 1), end=' '), sys.stdout.flush()evaluator = Evaluator()for l in open(args.train, 'r', 'utf-8'):x, y = load_example(l.split())z = cws.decode(x)evaluator(dump_example(x, y), dump_example(x, z))cws.weights._step += 1if z != y:cws.update(x, y, 1)cws.update(x, z, -1)evaluator.report()cws.weights.update_all()cws.weights.average()Viterbi算法⽤于解码,与HMM相类似:def decode(self, x): # 类似隐马模型的动态规划解码算法# 类似隐马模型中的转移概率transitions = [[self.weights.get_value(str(i) + ':' + str(j), 0) for j in range(4)]for i in range(4)]# 类似隐马模型中的发射概率emissions = [[sum(self.weights.get_value(str(tag) + feature, 0) for feature in features)for tag in range(4)] for features in self.gen_features(x)]# 类似隐马模型中的前向概率alphas = [[[e, None] for e in emissions[0]]]for i in range(len(x) - 1):alphas.append([max([alphas[i][j][0] + transitions[j][k] + emissions[i + 1][k], j]for j in range(4))for k in range(4)])# 根据alphas中的“指针”得到最优序列alpha = max([alphas[-1][j], j] for j in range(4))i = len(x)tags = []while i:tags.append(alpha[1])i -= 1alpha = alphas[i][alpha[1]]return list(reversed(tags))3. 参考资料[1] Collins, Michael. "Discriminative training methods for hidden markov models: Theory and experiments with perceptron algorithms." Proceedings of the ACL-02 conference on Empirical methods in natural language processing-Volume 10. Association for Computational Linguistics, 2002.[2] Zhang, Yue, and Stephen Clark. "Chinese segmentation with a word-based perceptron algorithm." Annual Meeting-Association for Computational Linguistics. Vol. 45. No. 1. 2007.[3] Kai Zhao and Liang Huang, .[4] Michael Collins, .Processing math: 0%。