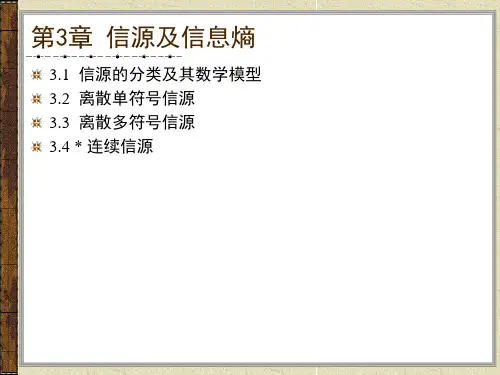

第三章连续信源的信息熵

- 格式:ppt

- 大小:1.32 MB

- 文档页数:60

信源熵的名词解释信源熵(Source Entropy)是信息论中一个重要的概念,用于衡量信息源的不确定性和信息的平均编码长度。

在信息论中,信息可以被看作是从一个信源中获取的,而信源熵用来描述这个信源的不确定性大小。

信源熵的计算方法是根据信源可能产生的符号的概率分布来进行的。

具体来说,如果一个信源有n个可能取值(符号)S1,S2,...,Sn,并且每个符号出现的概率分别为P1,P2,...,Pn,那么信源的熵H(S)可以通过下面的公式计算得出:H(S) = -P1log(P1) - P2log(P2) - ... - Pnlog(Pn)其中,log是以2为底的对数,P1,P2,...,Pn是概率分布。

信源熵的含义是,对于一个不确定性较大的信源,需要更长的编码长度来表示每一个符号,所以熵值越大,说明信息的平均编码长度越长。

相反,当一个信源的不确定性较小,即各个符号出现的概率分布较平均时,信息的平均编码长度较短,熵值较小。

以一个简单的例子来说明信源熵的概念。

假设有一个只有两个符号的信源,分别记为S1和S2,它们出现的概率分别为P1和P2。

如果这两个符号的概率分布相等(即P1 = P2 = 0.5),那么信源的熵就是最大的,因为这两个符号的不确定性相同,需要同样长度的编码来表示它们。

而如果其中一个符号的概率接近于1,另一个符号的概率接近于0,那么信源的熵就是最小的,因为其中一个符号的信息是确定的,只需要很短的编码来表示它。

这个例子可以帮助我们理解信源熵与不确定性之间的关系。

除了信源熵,信息论中还有一个重要的概念是条件熵(Conditional Entropy)。

条件熵是在已知一定的背景条件下,信源的不确定性大小,即在给定前提条件下的平均编码长度。

条件熵可以通过信源和条件之间的联合概率分布来计算,其公式为:H(S|T) = -ΣΣP(s, t)log(P(s|t))其中,P(s, t)表示符号s和条件t联合发生的概率。

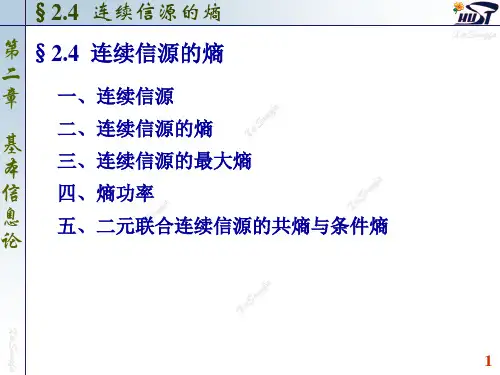

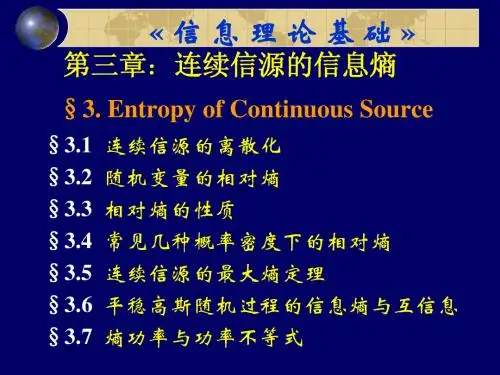

2.6连续信源的熵所谓连续信源就是指其输出在时间上和取值上都是连续的信源。

见图2.6.1。

各采样值的概率可用其概率分布密度函数来确定。

图2.6.2表示一个连续信源输出的幅度和其概率分布密度的关系。

设各种采样值之间无相关性,信源熵可写成:])(log[)(dx x p dx x p i ii ∑[例2.6.1]一连续信源,其输出信号的概率分布密度如图2.6.3所示,试计算其熵。

连续信源的熵不再具有非负性,这与离散信源显然不同。

同样可以定义两个连续变量的联合熵:⎰⎰-=dxdy xy lbp xy p XY H )()()(以及定义两个连续变量的条件熵;⎰⎰-=dxdy y x lbp xy p Y X H )/()()/( ⎰⎰-=dxdy x y lbp xy p X Y H )/()()/(连续信源的共熵、条件熵、单独熵之间也存在如下关系:)()()(Y H X H XY H +≤2.6.1三种特定连续信源的最大熵与离散信源不同,求连续信源的最大熵需要附加条件,常见的有三种。

1.输出幅度范围受限(或瞬时功率受限)的信源2.输出平均功率受限的信源 3.输出幅度平均值受限的信源 (1)限峰值功率的最大熵定理若代表信源的N 维随机变量的取值被限制在一定的范围之内,则在有限的定义域内,均匀分布的连续信源具有最大熵。

设N 维随机变量∏=∈Ni iib a X 1),( iia b>其均匀分布的概率密度函数为⎪⎪⎩⎪⎪⎨⎧-∉-∈-=∏∏∏===Ni i i Ni i i Ni i i a b x a b x a b x p 111)(0)()(1)(除均匀分布以外的其他任意概率密度函数记为)(x q ,并用[]X x p H c),(和[]X x q H c),(分别表示均匀分布和任意非均匀分布连续信源的熵。

在1)()(11112121==⎰⎰⎰⎰N b a b a N b a b a dx dx dxx q dx dx dxx p N NN N的条件下有[]⎰⎰-=1112)(log)(),(b a Nb ac dx dx x q x q X x q H NN⎰⎰⎰⎰⎰⎰+-=⎥⎦⎤⎢⎣⎡∙=111111121212)()(log)()(log)()()()(1log )(b a Nb a b a N b a b a Nb a dx dx x q x p x q dx dx x p x q dx dx x p x p x q x q NNNNN N令0,)()(≥=z x q x p z显然运用著名不等式1ln -≤z z 0>z 则]),([11)(log1)()()()(1log)(]),([1211121111X x p H a bdx dx x q x p x q dx dx a bx q X x q H c Ni i ib a Nb a b a N Ni i ib ac N N NN=-+-=⎥⎦⎤⎢⎣⎡-+--≤∏⎰⎰⎰∏⎰==则证明了,在定义域有限的条件下,以均匀分布的熵为最大。

信源熵的计算公式

信源熵是计算信息量的重要指标,它可以通过计算可能出现的各种信源的熵而得出。

信源熵的计算公式如下:H(x)=-Σ p(x)log2 p(x),其中p(x)表示每个信息元素x出现的概率。

由于信源熵在计算信息量中独具重要意义,所以它成为各类信息处理实践中的重要工具,例如,它可用于高级编码技术中,优化信号传输的带宽;也可以应用于量化理论中,用来减少信号失真;此外,还可以与信号处理相关联,减少计算量,提高系统效能等。

总而言之,信源熵是计算信息量的重要指标之一,它能够有效帮助我们更好地提取信息,用更少的计算量实现更大的效果,可谓是信息处理领域中的一颗明珠。

根据Charles H. Bennett对Maxwell's Demon的解释,对信息的销毁是一个不可逆过程所以销毁信息是符合热力学第二定律的。

而产生信息,则是为系统引入负(热力学)熵的过程。

所以信息熵的符号与热力学熵应该是相反的。

一般而言,当一种信息出现概率更高的时候,表明它被传播得更广泛,或者说,被引用的程度更高。

我们可以认为,从信息传播的角度来看,信息熵可以表示信息的价值。

这样我们就有一个衡量信息价值高低的标准,可以做出关于知识流通问题的更多推论。

信源的平均不定度。

在信息论中信源输出是随机量,因而其不定度可以用概率分布来度量。

记H(X)=H(P1,P2,…,Pn)=P(xi)logP(xi),这里P(xi),i=1,2,…,n为信源取第i个符号的概率。

P(xi)=1,H(X)称为信源的信息熵。

熵的概念来源于热力学。

在热力学中熵的定义是系统可能状态数的对数值,称为热熵。

它是用来表达分子状态杂乱程度的一个物理量。

热力学指出,对任何已知孤立的物理系统的演化,热熵只能增加,不能减少。

然而这里的信息熵则相反,它只能减少,不能增加。

所以热熵和信息熵互为负量。

且已证明,任何系统要获得信息必须要增加热熵来补偿,即两者在数量上是有联系的。

可以从数学上加以证明,只要H(X)满足下列三个条件:①连续性:H(P,1-P)是P的连续函数(0≤P≤1);②对称性:H(P1,…,Pn)与P1,…,Pn的排列次序无关;③可加性:若Pn=Q1+Q2>0,且Q1,Q2≥0,则有H(P1,…,Pn-1,Q1,Q2)=H(P1,…,Pn-1)+PnH;则一定有下列唯一表达形式:H(P1,…,Pn)=-CP(xi)logP(xi)其中C为正整数,一般取C=1,它是信息熵的最基本表达式。

信息熵的单位与公式中对数的底有关。

最常用的是以2为底,单位为比特(bit);在理论推导中常采用以e为底,单位为奈特(Nat);还可以采用其他的底和单位,并可进行互换。

信源熵的原理及应用信源熵是信息理论中的重要概念,用于描述一个随机变量包含的信息量的度量。

在信息理论中,熵被定义为信源中每个符号所携带的平均信息量的期望值。

熵的原理可以通过以下步骤来理解:1. 假设一个离散概率信源,它产生n个符号{s1, s2, ..., sn}。

每个符号都有对应的概率{p1, p2, ..., pn}。

2. 每个符号si携带的信息量可以用-log(pi)来度量,其中pi是符号si出现的概率。

3. 信源熵H可以定义为每个符号携带信息量的期望值,即H = -Σ(pi * log(pi)),其中Σ表示对所有符号求和。

熵的应用广泛,下面是几个常见的应用:1.数据压缩:信源熵的性质使之成为数据压缩技术的基础。

压缩算法通过移除冗余信息来减少数据的存储和传输成本。

压缩算法的思路就是将频率较高的符号用较短的编码表示,将频率较低的符号用较长的编码表示,以减小整体的编码长度。

2.信息编码:熵可以衡量信息的不确定性。

在通信系统中,编码器使用熵的概念来将消息转换成可传输的信号。

常用的编码方案包括霍夫曼编码、香农-费诺编码和算术编码等。

3.最优传输速率:信源熵对于最优传输速率具有重要意义。

在理想的通信信道中,传输速率应该等于信源熵,以达到最高的传输效率。

当传输速率高于信源熵时,会出现信息丢失或传输错误。

4.信息隐藏:信源熵的概念也可以应用于信息隐藏领域。

信息隐藏是指将附加信息嵌入到覆盖载体中,使得这些信息对于一般观察者不可察觉。

利用信源熵的概念,可以构建一些隐蔽的嵌入方案,将秘密信息嵌入到原始图像或音频中。

总之,信源熵在信息理论中起着重要的作用,它是衡量信息量的基本度量方式,并且对数据压缩、通信编码、传输速率等方面具有广泛的应用。

通过对信源熵的研究,我们可以更好地理解信息的特性和效率,并且能够应用于真实世界中的各种通信系统和数据处理任务中。

信源熵公式

信源熵是信息论中的一个重要概念,它是用来度量消息的丰富性和

复杂性的一种度量方法。

它的概念源于 Shannon 在 1948 年出版的文章Information Theory。

一、信源熵是什么

信源熵(即 Shannon 熵)是指数据量的复杂性程度的度量,即信息量

在消息中不确定性的度量。

它可以帮助我们测量消息中内容丰富程度,以及消息是否具有冗余性。

通俗来说,信源熵是一种度量消息中有多

少信息和无规律性的度量方法。

二、信源熵的计算公式

信源熵的计算公式是: H(p) = -∑p(i)logp(i) 。

其中,H(p)是具有信息量

p的信息源的熵,p(i)是每一种信息量的概率。

它很好地反映了消息的复杂性,但它不能用来衡量消息的可靠性,因

此不能按照 Shannon 熵来评估消息的独特性。

三、信源熵的应用

信源熵有很多应用,最重要的是在信号处理、声音分析、密码学、数

据库设计和模式分析等领域有广泛的应用。

例如在压缩文件时,可以

使用信源熵来确定哪些数据需要进行压缩处理,从而减小数据的量。

另外,信源熵也可以用来度量信号的复杂性,比如机器学习算法中的模型复杂度因子,可以使用信源熵来衡量模型的复杂度。

四、总结

信源熵是由 Shannon 在 1948 年提出的一种度量方法,它可以度量消息的复杂性和冗余性,可以帮助我们评估消息的信息量。

它被广泛应用于信号处理、声音分析、密码学、数据库设计和模式分析等领域,可以用来度量信号的复杂性,以及机器学习算法中的模型复杂度因子。

连续随机变量信息熵摘要:1.连续随机变量的概念与特点2.信息熵的概念与计算方法3.连续随机变量与信息熵的关系4.应用场景及实例5.提高信息熵的方法及其作用6.总结正文:一、连续随机变量的概念与特点连续随机变量是指取值范围为连续闭区间内的随机变量。

其在实际应用中具有广泛的意义,例如,温度、长度、时间等都可以看作是连续随机变量。

连续随机变量的特点是取值范围广泛,概率密度函数呈连续分布。

二、信息熵的概念与计算方法信息熵是信息论中用于度量信息量的物理量,其定义为随机变量取值的不确定性。

信息熵的计算方法通常有多种,如香农熵、相对熵等。

其中,香农熵是最为常见的,其计算公式为:H(X) = -Σ(P(x) * log2(P(x))),其中X为随机变量,P(x)为随机变量取值x的概率。

三、连续随机变量与信息熵的关系连续随机变量的信息熵反映了其在各个取值范围内的不确定性。

信息熵越大,表示连续随机变量的不确定性越大,即所包含的信息量越丰富。

反之,信息熵越小,表示连续随机变量的不确定性较小,所包含的信息量较少。

四、应用场景及实例在实际应用中,信息熵被广泛应用于通信、数据压缩、机器学习等领域。

例如,在数据压缩中,通过计算信息熵,可以有效地去除冗余信息,实现数据的压缩。

在机器学习中,信息熵可以用于度量特征的选择,选择信息熵较大的特征可以提高分类或回归的准确性。

五、提高信息熵的方法及其作用提高信息熵的方法主要包括增加数据多样性、增加数据量等。

这些方法可以使得数据集更具代表性,提高模型的泛化能力。

同时,提高信息熵还可以增强数据的安全性,降低数据泄露的风险。

六、总结连续随机变量在实际应用中具有重要意义,其信息熵可以用来度量不确定性及包含的信息量。

通过计算和优化信息熵,可以提高数据压缩、特征选择、模型泛化能力等方面的效果。