2015秋.信息论.第2章离散信源与信息熵

- 格式:pps

- 大小:2.55 MB

- 文档页数:98

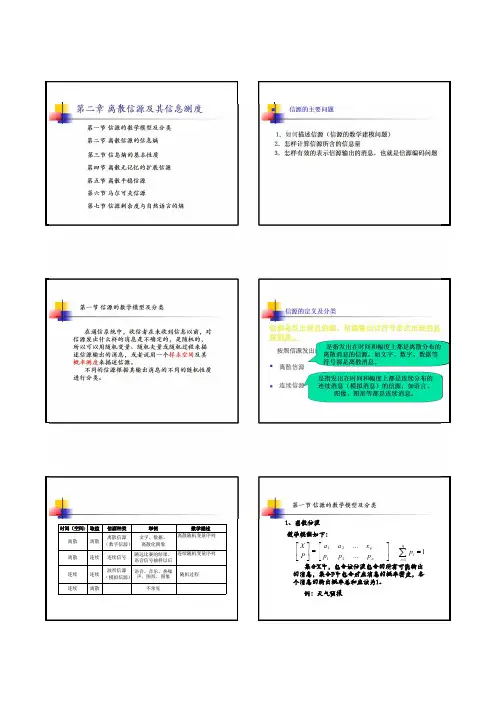

第2章离散信源与信息熵信号 信号+干扰 消息干扰消息 信源 编码器 信道 译码器 信宿 噪声源通信系统模型信息2.1 信源的分类和描述信源是信息的发源地,可以是人、生物、机器或其他事物。

信源的输出是包含信息的消息。

消息的形式可以是离散的或连续的。

信源输出为连续信号形式(如语音),可用连续随机变量描述。

连续信源←→模拟通信系统信源输出是离散的消息符号(如书信),可用离散随机变量描述。

离散信源←→数字通信系统离散信源…X i…X j…离散无记忆信源:输出符号Xi Xj之间相互无影响;离散有记忆信源:输出符号Xi Xj之间彼此依存。

3离散信源无记忆有记忆发出单个符号发出符号序列马尔可夫信源非马尔可夫信源y j将一粒棋子随意地放在棋盘中的某列;棋子放置的位置是一个随机事件;可看做一个发出单个符号的离散信源。

x i1212,,...,(),(),...,()m m x x x X P p x p x p x ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦就数学意义来讲,信源就是一个概率场,可用概率空间来描述信源。

由离散随机变量X 表示棋子位置:10()1,()1m i ii p x p x =≤≤=∑i x 其中,代表随机事件的某一结果。

2.2离散信源的信息熵信息的可度量性是信息论建立的基础;香农的信息论用事件发生概率的对数来描述事件的不确定性,得到消息的信息量,建立熵的概念。

2.2.1自信息量–定义2.1 任意随机事件x i 的自信息量定义为:i i i 1(x )log log (x )(x )I P P ==-小概率事件所包含的不确定性大,自信息量大。

大概率事件所包含的不确定性小,自信息量小。

概率为1的确定性事件,自信息量为零。

i i i 1(x )log log (x )(x )I P P ==-信息量的单位与公式中的对数取底有关。

以2为底,单位比特(bit );以e 为底,单位奈特(nat );()22log log ,log log ln log c a c b b x e x a==⋅–例:棋盘共8列,甲随手一放,将一枚棋子放在了第3列。

3321()log log 1/83()I x bit P x ==-=–例:袋内红、白球各50个,随意从袋中摸出一球。

21()log log 1/21()I bit P ==-=红红21()log log 1/21()I bit P ==-=白白–例:袋内红球1个、白球7个,随意从袋中摸出一球。

21()log log 1/83()I bit P ==-=红红21()log log 7/8019()I bit P ==-≈白.白定义2. 2 X 中出现事件x i 与Y 中出现事件y j 的联合自信息量定义为(,)log (,)i j i j I x y p x y =-log(()(/))log ()log (/)j i j j i j p y p x y p y p x y =-=--log ()log (/)i j i p x p y x =--定义2.3 X 中事件x i 在Y 中事件y j 已出现的情况下再出现时所能提供的信息量定义为条件自信息量(/)log (/)i j i j I x y p x y =-(,)()(/)i j j i j I x y I y I x y =+()(/)i j i I x I y x =+(/)(),(/)()j i j i j i p y x p y p x y p x ==(,)()()i j i j I x y I x I y =+当互相独立时,i j x yx i y jx iy j将一粒棋子随意地放在8*8的正方形棋盘的某方格内;涉及两个随机事件。

{}1112881/64,1/64,...,1/64,,...,x y x y x y XY P ⎡⎤=⎢⎥⎣⎦联合自信息量为2(,)log (,)1log 664i j i j I x y p x y bit =-=-=x i 相对y j 的条件自信息量为2(|)log (|)(,)1/64log log 3()1/8i j i j i j j I x y p x y p x y bit p y =-=-=-=已知棋子所在方格的行,棋子所在列的位置?11110(),(),()1()1,()1,()1i j i j m n n mij i j i j j i p x p y p x y p x p y p x y ====≤≤===∑∑∑∑其中,1111,...,,...,(),...,(),...,()i j m n i j m n x y x y x y XY P p x y p x y p x y ⎧⎫⎡⎤=⎨⎬⎢⎥⎣⎦⎩⎭1212,,...,(),(),...,()m m x x x X P p x p x p x ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦1212,,...,(),(),...,()n n y y y Y P p y p y p y ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦一般地11(/)1,(/)1m n i jj i i j p x y p y x ====∑∑0(/),(/)1,j i i j p y x p x y ≤≤11(,)(),(,)()m i j ji n i j ij p x y p y p x y p x ====∑∑y j (,)()(/)()(/)i j i j i j i j p x y p x p y x p y p x y ==1(,)(/),(,)(,)(/)(,)i j i j m i ji i j j i n i jp x y p x y p x y p x y p y x p x y ===∑∑思考题•有12块银元,其中有一块是假的。

真假银元从外观看完全相同,但假银元的重量与真银元略有不同。

–求证,用一架天平称3次即可找出假银元,并知道假银元是轻是重。

2.2.2平均自信息量一个离散随机变量X ,以不同的取值概率有N 个可能取值,11,...,,...,()(),...,(),...,()i n i n x x x X P x p x p x p x ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦i i i 1(x )log log p(x )p(x )I ==-是一个随机变量,不能用来作为整个信源的信息测度。

定义2.4 随机变量I(x i )的数学期望定义为平均自信息量,又称作离散信源X 的信息熵,简称熵。

•熵函数的自变量是X,表示信源整体。

集X 的平均自信息量表示集X 中事件出现的平均不确定性。

即集X 中每出现一个事件平均给出的信息量。

•熵这个名词是香农从物理学中的统计热力学借用过来的,在物理学中热熵是表示分子混乱程度的一个物理量。

1()[()]()log ()ni i i i H X E I x p x p x ===-∑例:袋内100个球,其中80个红的,20个白的,若随机摸取一个,猜测其颜色,求平均摸取一次所能获得的自信息量。

12()0.80.2x x X P x ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦概率空间11(x )log (x )log0.8I P =-=-22(x )log (x )log0.2I P =-=-随机模取n 次后总共所获得的信息量为1122()(x )()(x )np x I np x I +平均模取1次所获得的信息量为[][]11221()()(x )()(x )()log ()()log ()H X np x I np x I np x p x p x p x =+=-+熵从平均意义上表征信源的总体特征——平均不确定性.随机摸取n 次红球出现次数为np(x1),白球出现次数为np(x2)理解BIT二进制信源,如果0和1两个符号出现的概率都是0.5,这个信源平均每输出一个符号,我们就得到1bit 信息。

熵的单位与公式中的对数取底有关。

H(X)以2为底,通信中最常用,单位比特(bit );H e (X)以e 为底,理论推导中较方便,单位奈特(nat );()(0)log (0)(1)log (1)0.5log0.50.5log0.51()H X p p p p bit =--=--=定义2.5 联合熵1111(,)(,)(,)(,)log (,)nmi j i j i j n mi j i j i j H X Y p x y I x y p x y p x y ======-∑∑∑∑j i y x 联合离散符号集合XY 上的每个元素对的联合自信息量的数学期望。

定义2.6 条件熵•在已知随机变量Y 的条件下,随机变量X 的熵称为集X 对集Y 的条件熵。

是联合集XY 上条件自信息量的数学期望。

是已知一随机变量,对另一个随机变量的不确定性的量度当X 表示信源的输出,Y 表示信宿的输入时,条件熵H(X/Y)可表示信宿在收到Y 后,信源X 仍然存在的不确定度,即信道的损失。

11(,(/)[(/)]log (/))i j n mi j i j i j p H X Y E I x y p x x y y ====-∑∑求条件熵为什么要用联合概率加权?11(/)[(/)](,)log (/)n mi j i j i j i j H X Y E I x y p x y p x y ====-∑∑1(/)()(/)mj j j H X Y p y H X y ==∑1(/)(/)(/)nj i j i j i H X y p x y I x y ==∑11()(/)(/)mnj i j i j j i p y p x y I x y ===∑∑11(,)(/)m ni j i j j i p x y I x y ===∑∑}1,0{∈(/)(,)log (/)ijijijH X Y p x y p x y =-∑∑(,)(/)()i j i j j p x y p x y p y =例:已知X ,Yp(0,0)=p(1,1)=1/8,p(0,1)=p(1,0)=3/8,计算条件熵H(X/Y)。

,XY 的联合概率为:解:根据条件熵公式(,)i j ip x y =∑11333311(/)log log log log 0.406H X Y bit =----=()0001011311()(,)(,),()8822p y p x y p x y p y =+=+==0000100(,)1/813(/),(/)()1/244p x y p x y p x y p y ====110113(/),(/)44p x y p x y ==(,)()(/)()(/)H X Y H X H Y X H Y H X Y =+=+命题2.1 联合熵等于信息熵加上条件熵。