第二章 信源与信息熵

- 格式:ppt

- 大小:448.50 KB

- 文档页数:26

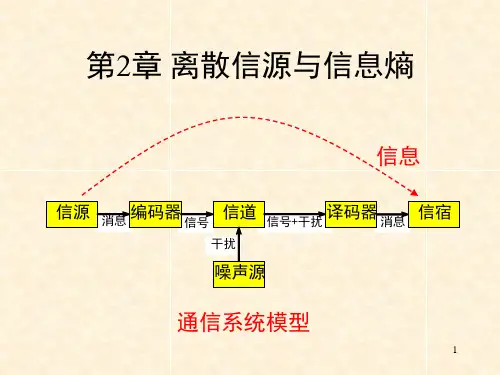

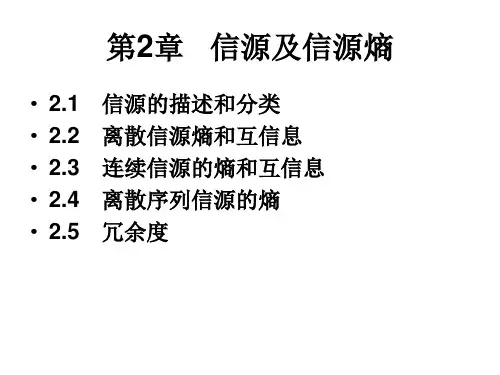

第2章离散信源与信息熵信号 信号+干扰 消息干扰消息 信源 编码器 信道 译码器 信宿 噪声源通信系统模型信息2.1 信源的分类和描述信源是信息的发源地,可以是人、生物、机器或其他事物。

信源的输出是包含信息的消息。

消息的形式可以是离散的或连续的。

信源输出为连续信号形式(如语音),可用连续随机变量描述。

连续信源←→模拟通信系统信源输出是离散的消息符号(如书信),可用离散随机变量描述。

离散信源←→数字通信系统离散信源…X i…X j…离散无记忆信源:输出符号Xi Xj之间相互无影响;离散有记忆信源:输出符号Xi Xj之间彼此依存。

3离散信源无记忆有记忆发出单个符号发出符号序列马尔可夫信源非马尔可夫信源y j将一粒棋子随意地放在棋盘中的某列;棋子放置的位置是一个随机事件;可看做一个发出单个符号的离散信源。

x i1212,,...,(),(),...,()m m x x x X P p x p x p x ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦就数学意义来讲,信源就是一个概率场,可用概率空间来描述信源。

由离散随机变量X 表示棋子位置:10()1,()1m i ii p x p x =≤≤=∑i x 其中,代表随机事件的某一结果。

2.2离散信源的信息熵信息的可度量性是信息论建立的基础;香农的信息论用事件发生概率的对数来描述事件的不确定性,得到消息的信息量,建立熵的概念。

2.2.1自信息量–定义2.1 任意随机事件x i 的自信息量定义为:i i i 1(x )log log (x )(x )I P P ==-小概率事件所包含的不确定性大,自信息量大。

大概率事件所包含的不确定性小,自信息量小。

概率为1的确定性事件,自信息量为零。

i i i 1(x )log log (x )(x )I P P ==-信息量的单位与公式中的对数取底有关。

以2为底,单位比特(bit );以e 为底,单位奈特(nat );()22log log ,log log ln log c a c b b x e x a==⋅–例:棋盘共8列,甲随手一放,将一枚棋子放在了第3列。

第二章 信源与信息熵(第二讲)(2课时)主要内容:(1)信源的描述(2)信源的分类 重点:信源的分类,马尔可夫信源。

难点:信源的描述,马尔可夫信源。

作业:2.1, 2.2, 2.3说明:本堂课推导内容较多,枯燥平淡,不易激发学生兴趣,要注意多讨论用途。

另外,注意,解题方法。

多加一些内容丰富知识和理解。

2.1 信源的描述与分类在通信系统中收信者在未收到消息以前对信源发出什么消息是不确定的,是随机的,所以可用随机变量、随机序列或随机过程来描述信源输出的消息,或者说用一个样本空间及其概率测度——概率空间来描述信源。

信源:产生随机变量、随机序列和随机过程的源。

信源的基本特性:具有随机不确定性。

信源的分类离散信源:文字、数据、电报——随机序列 连续信源:话音、图像——随机过程离散信源:输出在时间和幅度上都是离散分布的消息。

消息数是有限的或可数的,且每次只输出其中一个消息,即两两不相容。

发出单个符号的无记忆信源离散无记忆信源: 发出符号序列的无记忆信源离散信源离散有记忆信源: 发出符号序列的有记忆信源发出符号序列的马尔可夫信源 概率论基础:无条件概率,条件概率和联合概率的性质和关系: 非负性0()()(/)(/)()1i j j i i j i j p x p y p y x p x y p x y ≤≤,,,, 完备性111111()1,()1,(/)1,(/)1,()1n m nijiji j i mm nji i j j j i p x p y p x y p yx p x y ===========∑∑∑∑∑∑11()(),()()n mijjijii j p x y p y p x y p x ====∑∑联合概率()()(/)()(/)()()()(/)()(/)()i j i j i j i j i j i j j i j i j i p x y p x p y x p y p x y X Y p x y p x p y p y x p y p x y p x =====当与相互独立时,,贝叶斯公式11()()(/)(/)()()i j i j i j j i nmijiji j p x y p x y p x y p y x p x y p x y ====∑∑,2.1.1 无记忆信源:例如扔骰子,每次试验结果必然是1~6点中的某一个面朝上。