第4讲拟合与回归分析

- 格式:ppt

- 大小:2.38 MB

- 文档页数:85

回归方程拟合度回归方程拟合度是衡量回归模型拟合数据程度的指标。

它可以帮助我们判断回归模型对观测数据的拟合程度,从而评估模型的可靠性和预测能力。

常见的回归方程拟合度指标有决定系数R-square、调整决定系数Adjusted R-square、标准误差Standard Error和F统计量。

决定系数R-square是一种常见的回归方程拟合度指标,它表示有多少百分比的因变量的变异可以由自变量的线性组合来解释。

R-square的取值范围在0到1之间,越接近1表示模型对数据的拟合越好。

然而,R-square有一个局限性,它只考虑了自变量的线性效应,对于非线性关系可能不太适用。

调整决定系数Adjusted R-square是对决定系数R-square的修正,考虑了自变量的个数和样本量的影响。

当自变量的个数增加,调整决定系数会减小,避免了过度拟合。

因此,调整决定系数可以更准确地评估模型的预测能力。

标准误差Standard Error是用来估计模型预测的误差大小的指标。

它是实际观测值与回归方程预测值之间的标准差。

标准误差越小,表示回归模型的拟合程度越好。

F统计量是用来判断回归方程是否有统计显著性的指标。

F统计量的计算涉及回归方程的残差平方和和回归方程的解释平方和的比值。

如果F统计量大于某个临界值,就可以认为回归方程具有统计显著性,即自变量对因变量的解释是显著的。

除了以上常见的回归方程拟合度指标,还可以使用预测误差和残差分析来评估模型的拟合程度。

预测误差是实际观测值与模型预测值之间的差异,可以用来评估模型的预测精度。

残差是实际观测值与模型拟合值之间的差异,可以帮助检验模型的合理性和正确性。

在实际应用中,选择合适的拟合度指标要根据具体的研究目的和数据特点进行。

不同的拟合度指标有不同的优势和局限性,需要综合考虑。

此外,还可以使用交叉验证等方法来进一步评估模型的性能。

总之,回归方程拟合度是评估回归模型拟合数据程度的重要指标,可以帮助我们判断模型的可靠性和预测能力。

如何用EXCEL做数据线性拟合和回归分析使用Excel进行数据线性拟合和回归分析的过程如下:一、数据准备:1. 打开Excel,并将数据输入到一个工作簿中的其中一列或行中。

2.确保数据已经按照自变量(X)和因变量(Y)的顺序排列。

二、线性拟合:1. 在Excel中选择一个空白单元格,键入“=LINEST(Y数据范围,X数据范围,TRUE,TRUE)”。

-Y数据范围是因变量的数据范围。

-X数据范围是自变量的数据范围。

-最后两个参数设置为TRUE表示计算截距和斜率。

2. 按下“Ctrl +Shift + Enter”键以在该单元格中输入数组公式。

3. Excel将返回一列值,其中包括线性回归方程的系数和其他有关回归模型的统计信息。

-第一个值为截距项。

-第二个值为斜率项。

三、回归分析:1. 在Excel中选择一个空白单元格,键入“=LINEST(Y数据范围,X数据范围,TRUE,TRUE)”。

2. 按下“Ctrl + Shift + Enter”键以在该单元格中输入数组公式。

3. Excel将返回一列值,其中包括线性回归方程的系数和其他有关回归模型的统计信息。

-第一个值为截距项。

-第二个值为斜率项。

-第三个值为相关系数(R^2)。

-第四个值为标准误差。

四、数据可视化:1.选中自变量(X)和因变量(Y)的数据范围。

2.点击“插入”选项卡中的“散点图”图表类型。

3.选择一个散点图类型并插入到工作表中。

4.可以添加趋势线和方程式以可视化线性拟合结果。

-右键单击散点图上的一个数据点,选择“添加趋势线”。

-在弹出的对话框中选择线性趋势线类型。

-勾选“显示方程式”和“显示R^2值”选项以显示线性回归方程和相关系数。

五、解读结果:1.截距项表示在自变量为0时,因变量的预测值。

2.斜率项表示因变量随着自变量变化而变化的速率。

3.相关系数(R^2)表示自变量对因变量的解释力,范围从0到1,越接近1表示拟合的越好。

4.标准误差表示拟合线与实际数据之间的平均误差。

回归分析方法

回归分析是统计学中一种重要的数据分析方法,它用于研究自

变量和因变量之间的关系。

回归分析方法可以帮助我们预测和解释

变量之间的关系,从而更好地理解数据的特征和趋势。

在本文中,

我们将介绍回归分析的基本概念、常见的回归模型以及如何进行回

归分析。

首先,回归分析的基本概念包括自变量和因变量。

自变量是研

究者可以控制或观察到的变量,而因变量是研究者希望预测或解释

的变量。

回归分析旨在通过自变量的变化来预测或解释因变量的变化,从而揭示它们之间的关系。

常见的回归模型包括线性回归、多元线性回归、逻辑回归等。

线性回归是最简单的回归模型之一,它假设自变量和因变量之间的

关系是线性的。

多元线性回归则允许多个自变量对因变量产生影响,逻辑回归则用于因变量是二元变量的情况,例如成功与失败、生存

与死亡等。

进行回归分析时,我们需要收集数据、建立模型、进行拟合和

检验模型的拟合优度。

在收集数据时,我们需要确保数据的质量和

完整性,避免因为数据缺失或异常值而影响分析结果。

建立模型时,我们需要选择合适的自变量和因变量,并根据实际情况选择合适的

回归模型。

进行拟合和检验模型的拟合优度时,我们需要根据实际

情况选择合适的统计指标和方法,例如残差分析、R方值等。

总之,回归分析方法是一种重要的数据分析方法,它可以帮助

我们预测和解释变量之间的关系。

通过本文的介绍,相信读者对回

归分析有了更深入的了解,希望能够在实际工作中灵活运用回归分

析方法,为决策提供更可靠的依据。

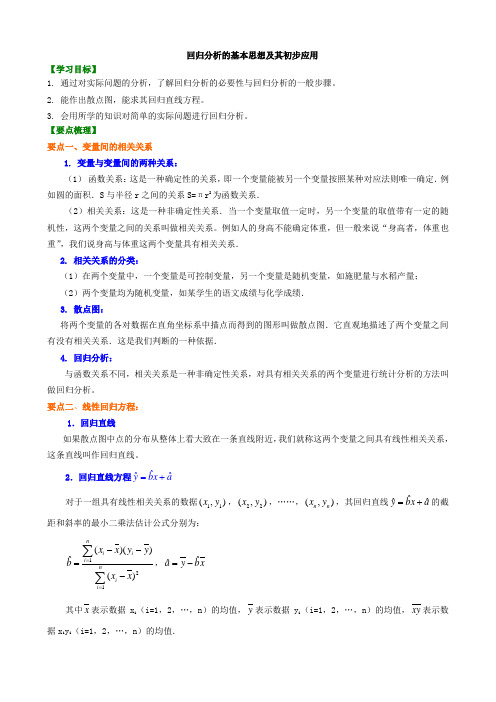

回归分析的基本思想及其初步应用【学习目标】1. 通过对实际问题的分析,了解回归分析的必要性与回归分析的一般步骤。

2. 能作出散点图,能求其回归直线方程。

3. 会用所学的知识对简单的实际问题进行回归分析。

【要点梳理】要点一、变量间的相关关系1. 变量与变量间的两种关系:(1) 函数关系:这是一种确定性的关系,即一个变量能被另一个变量按照某种对应法则唯一确定.例如圆的面积.S 与半径r 之间的关系S=πr 2为函数关系.(2)相关关系:这是一种非确定性关系.当一个变量取值一定时,另一个变量的取值带有一定的随机性,这两个变量之间的关系叫做相关关系。

例如人的身高不能确定体重,但一般来说“身高者,体重也重”,我们说身高与体重这两个变量具有相关关系. 2. 相关关系的分类:(1)在两个变量中,一个变量是可控制变量,另一个变量是随机变量,如施肥量与水稻产量; (2)两个变量均为随机变量,如某学生的语文成绩与化学成绩. 3. 散点图:将两个变量的各对数据在直角坐标系中描点而得到的图形叫做散点图.它直观地描述了两个变量之间有没有相关关系.这是我们判断的一种依据.4. 回归分析:与函数关系不同,相关关系是一种非确定性关系,对具有相关关系的两个变量进行统计分析的方法叫做回归分析。

要点二、线性回归方程:1.回归直线如果散点图中点的分布从整体上看大致在一条直线附近,我们就称这两个变量之间具有线性相关关系,这条直线叫作回归直线。

2.回归直线方程ˆˆˆybx a =+ 对于一组具有线性相关关系的数据11(,)x y ,22(,)x y ,……,(,)n n x y ,其回归直线ˆˆˆybx a =+的截距和斜率的最小二乘法估计公式分别为:121()()ˆ()niii nii x x y y bx x ==--=-∑∑,ˆˆay bx =- 其中x 表示数据x i (i=1,2,…,n )的均值,y 表示数据y i (i=1,2,…,n )的均值,xy 表示数据x i y i (i=1,2,…,n )的均值.a 、b 的意义是:以a 为基数,x 每增加一个单位,y 相应地平均变化b 个单位.要点诠释:①回归系数121()()ˆ()niii nii x x y y bx x ==--=-∑∑,也可以表示为1221ˆni ii nii x y nx ybxnx==-=-∑∑,这样更便于实际计算。

回归分析回归分析(Regression Analysis )是研究因变量y 和自变量x 之间数量变化规律,并通过一定的数学表达式来描述这种关系,进而确定一个或几个自变量的变化对因变量的影响程度。

简约地讲,可以理解为用一种确定的函数关系去近似代替比较复杂的相关关系,这个函数称为回归函数,在实际问题中称为经验公式。

回归分析所研究的主要问题就是如何利用变量X ,Y 的观察值(样本),对回归函数进行统计推断,包括对它进行估计及检验与它有关的假设等。

在SPSS 中的“Analyze ”菜单下的“Regression ”项是专门用于回归分析的过程组。

单击该项,将打开“Regression ”的右拉式菜单,菜单包含如下几项:1.Linear 线性回归。

2.Curve Estimation 曲线估计。

3.Binary Logistic 二元逻辑分析。

4.Multinomial Logistic 多元逻辑分析。

5.Ordinal 序数分析。

6.Probit 概率分析。

7.Nonlinear 非线性估计。

8.Weight Estimation 加权估计。

9.2-Stage Least Squares 两段最小二乘法。

本课程将介绍其中的“Linear ”、“Curve Estimation ”和“Nonlinear ”项过程的应用。

一元回归分析在数学关系式中只描述了一个变量与另一个变量之间的数量变化关系,则称其为一元回归分析。

其回归模型为i i i bx a y ε++=,y 称为因变量,x 称为自变量,ε称为随机误差,a ,b 称为待估计的回归参数,下标i 表示第i 个观测值。

若给出a 和b 的估计量分别为b aˆ,ˆ则经验回归方程:ii x b a y ˆˆˆ+=,一般把i i i y y e ˆ-=称为残差, 残差i e 可视为扰动ε的“估计量”。

例:湖北省汉阳县历年越冬代二化螟发蛾盛期与当年三月上旬平均气温的数据如表1-1,分析三月上旬平均温度与越冬代二化螟发蛾盛期的关系。

回归分析方法

回归分析是一种统计学方法,用于研究自变量与因变量之间的关系。

在实际应用中,回归分析可以帮助我们预测未来的趋势,分析变量之间的影响关系,以及找出影响因变量的主要因素。

本文将介绍回归分析的基本概念、常见方法和实际应用。

首先,回归分析可以分为简单线性回归和多元线性回归两种基本类型。

简单线性回归是指只有一个自变量和一个因变量的情况,而多元线性回归则是指有多个自变量和一个因变量的情况。

在进行回归分析时,我们需要先确定自变量和因变量的关系类型,然后选择合适的回归模型进行拟合和预测。

常见的回归模型包括最小二乘法、岭回归、Lasso回归等。

最小二乘法是一种常用的拟合方法,通过最小化残差平方和来找到最佳拟合直线或曲线。

岭回归和Lasso回归则是在最小二乘法的基础上引入了正则化项,用于解决多重共线性和过拟合的问题。

选择合适的回归模型可以提高模型的预测准确性和稳定性。

在实际应用中,回归分析可以用于市场营销预测、金融风险评估、医学疾病预测等领域。

例如,我们可以利用回归分析来预测产

品销量与广告投放的关系,评估股票收益率与市场指数的关系,或

者分析疾病发病率与环境因素的关系。

通过回归分析,我们可以更

好地理解变量之间的关系,为决策提供可靠的依据。

总之,回归分析是一种强大的统计工具,可以帮助我们理解变

量之间的关系,预测未来的趋势,并进行决策支持。

在实际应用中,我们需要选择合适的回归模型,进行数据拟合和预测分析,以解决

实际问题。

希望本文对回归分析方法有所帮助,谢谢阅读!。

回归分析是一种统计学方法,用于探索和解释变量之间的关系。

它可以帮助研究者理解变量如何相互影响,从而预测未来的趋势或结果。

在进行回归分析之前,需要先了解一些基本概念和步骤。

第一步:收集数据进行回归分析的第一步是收集相关数据。

这些数据可以是实验数据,调查结果,或者是已有的历史数据。

确保数据的准确性和完整性对于回归分析的结果至关重要。

第二步:确定变量在回归分析中,通常会有两种变量:自变量和因变量。

自变量是用来预测因变量的变量,而因变量则是被预测的变量。

在选择自变量时,需要考虑其与因变量的相关性,避免选择无关的变量。

第三步:建立模型建立回归模型是回归分析的核心步骤。

最常见的回归模型是线性回归模型,它假设自变量与因变量之间存在线性关系。

除了线性回归模型外,还有多项式回归模型、对数回归模型等。

选择合适的模型需要根据实际情况和数据特点进行判断。

第四步:拟合模型一旦确定了回归模型,就需要利用数据对模型进行拟合。

拟合模型的过程是通过最小化残差,来确定模型的参数估计值。

残差是观测值与模型预测值之间的差异,拟合模型的目标是使残差尽可能小。

第五步:评估模型评估模型的好坏是回归分析中的关键步骤。

常用的评估方法包括R方值、残差分析、假设检验等。

R方值是用来衡量模型对观测数据的拟合程度,值越接近于1表示模型拟合得越好。

残差分析可以帮助检验模型的假设是否成立,假设检验则可以用来检验模型的显著性。

第六步:预测结果一旦建立了合适的回归模型,并对模型进行了评估,就可以利用模型进行预测。

预测结果可以帮助研究者了解自变量对因变量的影响程度,从而进行合理的决策。

需要注意的是,回归分析只能用来观察变量之间的相关关系,并不能说明因果关系。

在进行回归分析时,需要注意变量选择、模型建立、模型评估等步骤,以确保分析结果的准确性和可靠性。

总之,回归分析是一种强大的工具,可以帮助研究者理解变量之间的关系,并进行预测和决策。

通过深入了解回归分析的基本步骤和方法,可以更好地应用这一方法来解决实际问题。