基于sift的特征匹配算法

- 格式:pptx

- 大小:9.19 MB

- 文档页数:11

图像特征点提取及匹配算法研究论文1.SIFT算法:SIFT(Scale-Invariant Feature Transform)算法是一种经典的图像特征点提取算法。

该算法首先使用高斯滤波器对图像进行多尺度的平滑处理,然后使用差分算子来检测图像中的关键点,最后计算关键点的主方向和描述符。

SIFT算法具有尺度不变性和旋转不变性,对于图像中存在较大尺度和角度变化的情况下仍能提取出稳定的特征点。

2.SURF算法:SURF(Speeded Up Robust Features)算法是一种快速的特征点提取算法,它在SIFT算法的基础上进行了优化。

SURF算法使用Haar小波响应来检测图像中的特征点,并使用积分图像来加速计算过程。

此外,SURF算法还使用了一种基于方向直方图的特征描述方法,能够提取出具有旋转不变性和尺度不变性的特征点。

3.ORB算法:ORB(Oriented FAST and Rotated BRIEF)算法是一种快速的特征点提取和匹配算法。

该算法结合了FAST角点检测算法和BRIEF描述符算法,并对其进行了改进。

ORB算法利用灰度值的转折点来检测图像中的角点,并使用二进制字符串来描述关键点,以提高特征点的匹配速度。

ORB算法具有较快的计算速度和较高的匹配精度,适用于实时应用。

4.BRISK算法:BRISK(Binary Robust Invariant Scalable Keypoints)算法是一种基于二进制描述符的特征点提取和匹配算法。

该算法首先使用田字形格点采样方法检测关键点,然后使用直方图来描述关键点的方向和纹理特征。

最后,BRISK算法使用二进制字符串来表示关键点的描述符,并使用汉明距离来进行特征点的匹配。

BRISK算法具有较快的计算速度和较高的鲁棒性,适用于大规模图像匹配任务。

总结起来,图像特征点提取及匹配算法是计算机视觉领域中的重要研究方向。

本文介绍了一些常用的特征点提取及匹配算法,并对其进行了讨论。

SIFT特征匹配技术讲义1导言:SIFT特征匹配算法是目前国内外特征点匹配研究领域的热点与难点,其匹配能力较强,可以处理两幅图像之间发生平移、旋转、仿射变换情况下的匹配问题,甚至在某种程度上对任意角度拍摄的图像也具备较为稳定的特征匹配能力。

该算法目前外文资料较多,但中文方面的介绍较少。

为此我撰写了这篇文档,以帮助国内的研究学者尽快入门,以最快的速度去体验SIFT算法的魅力!作者:山东大学信息科学与工程学院赵辉bugzhao@ / 5.1 宽基线特征匹配概述宽基线条件下点特征匹配的首要任务就是提取稳定的特征,并进行描述。

这里稳定一词的含义指的是希望该特征能对旋转、尺度缩放、仿射变换、视角变化、光照变化等图像变化因素保持一定的不变性,而对物体运动、遮挡、噪声等因素也保持较好的可匹配性,从而可以实现差异较大的两幅图像之间特征的匹配。

对图像变化保持稳定的特征描述符称为不变量,比如对图像的旋转保持稳定的不变量称为旋转不变量(Rotation Invariant),对尺度缩放保持稳定的不变量则称为尺度不变量(Scale Invariant)。

特征描述符(Featrue Descriptors)指的是检测图像的局部特征(比如边缘、角点、轮廓等),然后根据匹配目标的需要进行特征的组合、变换,以形成易于匹配、稳定性好的特征向量,从而把图像匹配问题转化为特征的匹配问题,进而将特征的匹配问题转化为特征空间特征向量的聚类问题[51]。

宽基线条件下的点特征匹配一般包括下面四个步骤[30]:1.)特征点检测。

这些特征点一般是灰度变化的局部极值点,含有显著的结构性信息,甚至这些点也可以没有实际的直观视觉意义,但却在某种角度、某个尺度上含有丰富的易于匹配的信息。

2.)特征点描述,即建立特征向量。

这是各匹配算法主要的不同所在。

特征空间的选择决定了图像的哪些特性参与匹配,哪些特性将被忽略。

特征点的特征描述符应是不变量,以确保最低限度的受摄像机的运动或光照变化等因素的影响。

sift特征计算SIFT(Scale-Invariant Feature Transform)是一种用于计算图像中关键点的特征点描述符的算法。

它最早由David Lowe在1999年提出,被广泛应用于计算机视觉和图像处理领域。

SIFT算法的主要目标是能够提取图像中具有尺度、旋转和光照不变性的关键点。

它通过以下步骤来计算SIFT特征:1. 尺度空间极值检测(Scale-space Extrema Detection):-首先,使用高斯滤波器对原始图像进行多次平滑处理,得到不同尺度空间的图像金字塔。

-然后,在每个尺度空间中,通过比较像素值与其周围像素值来检测图像的极值点。

-这些极值点被认为是图像中可能的关键点。

2. 关键点定位(Key Point Localization):-对于每个检测到的极值点,通过计算尺度空间的高斯差分图像来确定其精确位置。

-使用泰勒级数展开来拟合极值点周围像素的曲线,找到更精确的关键点位置。

-根据曲线的响应值和临近像素点的梯度幅值,筛选掉低对比度和边缘响应的关键点。

3. 方向分配(Orientation Assignment):-对于每个关键点,计算其周围像素点的梯度幅值和方向。

-将周围像素点的梯度方向分布转换为直方图,并找到主导方向。

-在主导方向和周围方向上进行插值,获得关键点的特征方向。

4. 关键点描述(Descriptor Representation):-在关键点周围的邻域内,根据关键点的尺度和方向构建一个相对于尺度和旋转不变的描述子。

-将关键点周围的图像区域划分为若干个子区域,并计算每个子区域内像素的梯度方向和幅值。

-将梯度方向转换为16个方向的直方图,得到长度为128的特征向量。

-对特征向量进行归一化,去除光照变化的影响。

5. 特征匹配(Feature Matching):-使用特征点的描述子来计算两幅图像中的特征点之间的距离。

-对于每个特征点,选择与其特征向量距离最近的特征点作为匹配点。

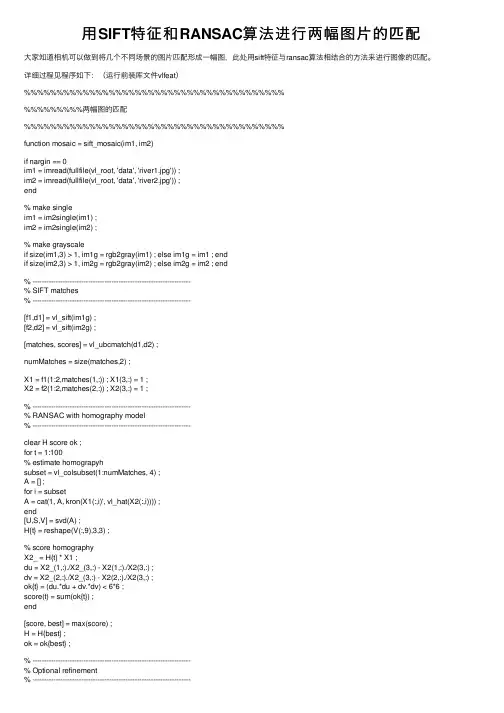

⽤SIFT特征和RANSAC算法进⾏两幅图⽚的匹配⼤家知道相机可以做到将⼏个不同场景的图⽚匹配形成⼀幅图,此处⽤sift特征与ransac算法相结合的⽅法来进⾏图像的匹配。

详细过程见程序如下:(运⾏前装库⽂件vlfeat)%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%两幅图的匹配%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%function mosaic = sift_mosaic(im1, im2)if nargin == 0im1 = imread(fullfile(vl_root, 'data', 'river1.jpg')) ;im2 = imread(fullfile(vl_root, 'data', 'river2.jpg')) ;end% make singleim1 = im2single(im1) ;im2 = im2single(im2) ;% make grayscaleif size(im1,3) > 1, im1g = rgb2gray(im1) ; else im1g = im1 ; endif size(im2,3) > 1, im2g = rgb2gray(im2) ; else im2g = im2 ; end% --------------------------------------------------------------------% SIFT matches% --------------------------------------------------------------------[f1,d1] = vl_sift(im1g) ;[f2,d2] = vl_sift(im2g) ;[matches, scores] = vl_ubcmatch(d1,d2) ;numMatches = size(matches,2) ;X1 = f1(1:2,matches(1,:)) ; X1(3,:) = 1 ;X2 = f2(1:2,matches(2,:)) ; X2(3,:) = 1 ;% --------------------------------------------------------------------% RANSAC with homography model% --------------------------------------------------------------------clear H score ok ;for t = 1:100% estimate homograpyhsubset = vl_colsubset(1:numMatches, 4) ;A = [] ;for i = subsetA = cat(1, A, kron(X1(:,i)', vl_hat(X2(:,i)))) ;end[U,S,V] = svd(A) ;H{t} = reshape(V(:,9),3,3) ;% score homographyX2_ = H{t} * X1 ;du = X2_(1,:)./X2_(3,:) - X2(1,:)./X2(3,:) ;dv = X2_(2,:)./X2_(3,:) - X2(2,:)./X2(3,:) ;ok{t} = (du.*du + dv.*dv) < 6*6 ;score(t) = sum(ok{t}) ;end[score, best] = max(score) ;H = H{best} ;ok = ok{best} ;% --------------------------------------------------------------------% Optional refinement% --------------------------------------------------------------------function err = residual(H)u = H(1) * X1(1,ok) + H(4) * X1(2,ok) + H(7) ;v = H(2) * X1(1,ok) + H(5) * X1(2,ok) + H(8) ;d = H(3) * X1(1,ok) + H(6) * X1(2,ok) + 1 ;du = X2(1,ok) - u ./ d ;dv = X2(2,ok) - v ./ d ;err = sum(du.*du + dv.*dv) ;endif exist('fminsearch') == 2H = H / H(3,3) ;opts = optimset('Display', 'none', 'TolFun', 1e-8, 'TolX', 1e-8) ; H(1:8) = fminsearch(@residual, H(1:8)', opts) ;elsewarning('Refinement disabled as fminsearch was not found.') ; end% --------------------------------------------------------------------% Show matches% --------------------------------------------------------------------dh1 = max(size(im2,1)-size(im1,1),0) ;dh2 = max(size(im1,1)-size(im2,1),0) ;figure(1) ; clf ;subplot(2,1,1) ;imagesc([padarray(im1,dh1,'post') padarray(im2,dh2,'post')]) ; o = size(im1,2) ;line([f1(1,matches(1,:));f2(1,matches(2,:))+o], ...[f1(2,matches(1,:));f2(2,matches(2,:))]) ;title(sprintf('%d tentative matches', numMatches)) ;axis image off ;subplot(2,1,2) ;imagesc([padarray(im1,dh1,'post') padarray(im2,dh2,'post')]) ; o = size(im1,2) ;line([f1(1,matches(1,ok));f2(1,matches(2,ok))+o], ...[f1(2,matches(1,ok));f2(2,matches(2,ok))]) ;title(sprintf('%d (%.2f%%) inliner matches out of %d', ...sum(ok), ...100*sum(ok)/numMatches, ...numMatches)) ;axis image off ;drawnow ;% --------------------------------------------------------------------% Mosaic% --------------------------------------------------------------------box2 = [1 size(im2,2) size(im2,2) 1 ;1 1 size(im2,1) size(im2,1) ;1 1 1 1 ] ;box2_ = inv(H) * box2 ;box2_(1,:) = box2_(1,:) ./ box2_(3,:) ;box2_(2,:) = box2_(2,:) ./ box2_(3,:) ;ur = min([1 box2_(1,:)]):max([size(im1,2) box2_(1,:)]) ;vr = min([1 box2_(2,:)]):max([size(im1,1) box2_(2,:)]) ;[u,v] = meshgrid(ur,vr) ;im1_ = vl_imwbackward(im2double(im1),u,v) ;z_ = H(3,1) * u + H(3,2) * v + H(3,3) ;u_ = (H(1,1) * u + H(1,2) * v + H(1,3)) ./ z_ ;v_ = (H(2,1) * u + H(2,2) * v + H(2,3)) ./ z_ ;im2_ = vl_imwbackward(im2double(im2),u_,v_) ;mass = ~isnan(im1_) + ~isnan(im2_) ;im1_(isnan(im1_)) = 0 ;im2_(isnan(im2_)) = 0 ;mosaic = (im1_ + im2_) ./ mass ; figure(2) ; clf ;imagesc(mosaic) ; axis image off ; title('Mosaic') ;if nargout == 0, clear mosaic ; end end。

基于SIFT特征点的图像匹配算法作者:高峰, 魏少华, 王学通来源:《现代电子技术》2010年第18期摘要:SIFT特征点是图像的一种尺度不变局部特征点。

首先给出了尺度空间的生成方法;接下来给出了SIFT特征点的提取步骤和精确定位方法,基于特征点邻域像素的梯度和方向生成了关键点的描述向量;最后根据特征向量给出了匹配方法,提取了SIFT特征点,并将其应用于图像匹配。

实验结果说明,使用SIFT特征点可以有效实现图像匹配。

关键词:SIFT算法; 图像匹配; 尺度空间; 高斯核中图分类号:TN919-34;TP391.4 文献标识码:A文章编号:1004-373X(2010)18-0101-03Image Matching Algorithm Based on SIFT Feature PointGAO Feng1, WEI Shao-hua1, WANG Xue-tong2(1. North Institute of Information Engineering, Xi’an Technological University, Xi’an 710025, China;2. School of Computer Science and Engineering, Xi’an University of Technology, Xi’an 710048, China)Abstract: SIFT feature point is a kind of feature which is invariant to scale. Method for generation scale space of image is presented, then steps for picking up sift key point are provided. Vectors for describing key point are generated based on the gradient magnitude and orientation of pixels neighboring to the key point. Matching algorithm is presented based on vectors. The experiment shows that it is efficient for image matching.Keywords: SIFT algorithm; image matching; scale space; Gaussian kernel0 引言图像匹配技术是图像处理和计算机视觉领域的一项重要技术。

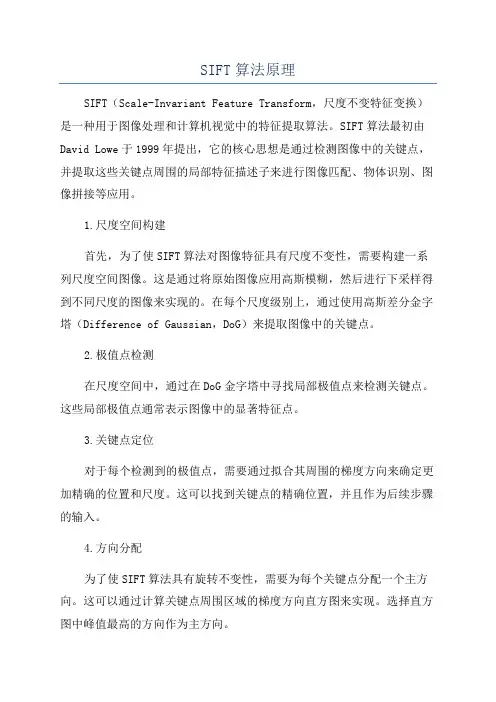

SIFT算法原理SIFT(Scale-Invariant Feature Transform,尺度不变特征变换)是一种用于图像处理和计算机视觉中的特征提取算法。

SIFT算法最初由David Lowe于1999年提出,它的核心思想是通过检测图像中的关键点,并提取这些关键点周围的局部特征描述子来进行图像匹配、物体识别、图像拼接等应用。

1.尺度空间构建首先,为了使SIFT算法对图像特征具有尺度不变性,需要构建一系列尺度空间图像。

这是通过将原始图像应用高斯模糊,然后进行下采样得到不同尺度的图像来实现的。

在每个尺度级别上,通过使用高斯差分金字塔(Difference of Gaussian,DoG)来提取图像中的关键点。

2.极值点检测在尺度空间中,通过在DoG金字塔中寻找局部极值点来检测关键点。

这些局部极值点通常表示图像中的显著特征点。

3.关键点定位对于每个检测到的极值点,需要通过拟合其周围的梯度方向来确定更加精确的位置和尺度。

这可以找到关键点的精确位置,并且作为后续步骤的输入。

4.方向分配为了使SIFT算法具有旋转不变性,需要为每个关键点分配一个主方向。

这可以通过计算关键点周围区域的梯度方向直方图来实现。

选择直方图中峰值最高的方向作为主方向。

5.特征描述在关键点的周围区域内,通过计算局部区域的梯度幅值和方向来构建特征描述子。

这些特征描述子对尺度、旋转和光照等变化都具有较强的鲁棒性,可以用来进行匹配和识别。

总的来说,SIFT算法通过构建尺度空间,检测局部极值点,定位关键点,分配主方向以及构建特征描述子等步骤,提取出图像中的稳定且具有鲁棒性的特征点。

这些特征点可以用于图像匹配、物体识别、图像拼接等计算机视觉任务,并且对尺度、旋转以及光照等变化具有一定的不变性。

SIFT算法在实际应用中具有广泛的应用价值,并成为计算机视觉领域中最经典的特征提取算法之一1.尺度空间构建2.关键点检测3.关键点定位对于检测到的关键点,SIFT算法通过拟合其周围的梯度方向来定位关键点的精确位置和尺度。

SIFT特征提取与匹配原理的深入解析一、引言在图像处理和计算机视觉领域,尺度不变特征变换(Scale-Invariant Feature Transform,SIFT)是一种被广泛应用的算法。

SIFT特征提取与匹配原理是图像处理中的重要一环,对于图像识别、图像配准、3D建模、物体跟踪等应用具有重要意义。

本文将深入解析SIFT特征提取与匹配原理,包括其基本概念、算法流程、优缺点以及应用场景。

二、SIFT特征提取原理1. 尺度空间极值检测SIFT算法首先通过构建尺度空间,在不同尺度下搜索所有可能的特征点。

这个过程是通过高斯差分(Difference of Gaussians,DoG)来实现的,它可以有效地检测出图像中的局部极值点,这些点具有尺度不变性,即无论图像被放大或缩小,这些点都能被检测到。

2. 特征点定位在检测到局部极值点后,SIFT算法会进行精确的定位。

这个过程包括去除低对比度的点和边缘点,因为这些点不稳定且对噪声敏感。

通过拟合三维二次函数来精确确定特征点的位置和尺度。

3. 方向分配为了使描述符具有旋转不变性,SIFT算法会为每个特征点分配一个主方向。

这是通过计算特征点周围像素的梯度方向和大小来实现的。

主方向是通过直方图统计梯度方向并找到最大的峰值来确定的。

4. 描述符生成最后,SIFT算法会生成一个描述符,用于描述特征点周围的图像信息。

描述符是通过将特征点周围的区域划分为4x4的子区域,并计算每个子区域的梯度方向和大小直方图来生成的。

描述符是一个128维的向量,具有对尺度、旋转和光照变化的不变性。

三、SIFT特征匹配原理在生成了SIFT描述符后,就可以进行特征匹配了。

这个过程是通过计算两个描述符之间的欧氏距离来实现的。

距离越小,表示两个特征点越相似。

为了提高效率,通常会使用K-D树等数据结构来加速匹配过程。

此外,还可以使用RANSAC等算法来消除误匹配,提高匹配的准确性。

四、优缺点分析SIFT算法的优点主要体现在以下几个方面:1. 尺度、旋转和光照不变性:SIFT描述符具有对尺度、旋转和光照变化的不变性,这使得它在各种场景下都能取得较好的效果。

特征点匹配算法概要特征点匹配是计算机视觉领域中的一项重要任务,其主要是为了在不同图像或视频帧中找到相互对应的特征点。

特征点是指在图像中明显可识别的局部区域,可以通过其在不同图像中的描述符来进行匹配。

在很多计算机视觉应用中,如图像拼接、目标跟踪、三维重建等,特征点匹配是必不可少的。

1.经典算法1.1尺度不变特征变换(SIFT)SIFT算法是一种基于局部特征的描述符,其通过尺度空间上的高斯差分函数检测图像中的关键点,并计算其旋转不变的特征向量。

SIFT算法具有尺度不变性和旋转不变性,可以在不同尺度和旋转角度下匹配特征点。

SIFT算法的主要流程包括尺度空间极值检测、关键点定位、方向分配和特征描述四个步骤。

1.2 加速稳健特征(Accelerated-robust features, SURF)SURF算法是对SIFT算法的改进,其通过积分图像和快速哈希技术实现了更快速的特征点检测和匹配。

SURF算法具有较好的尺度不变性和旋转不变性,并且可以在多尺度下进行特征点匹配。

1.3匹配追踪算法(OPTICALFLOW)匹配追踪是一类基于像素变化的特征点匹配算法,其通过计算图像中像素的运动向量来进行匹配。

典型的匹配追踪算法包括Lucas-Kanade光流算法和Horn-Schunck光流算法。

2.深度学习算法2.1 卷积神经网络(Convolutional Neural Network, CNN)卷积神经网络是一种深度学习算法,其通过卷积层、池化层和全连接层等结构来提取图像的特征。

在特征点匹配中,可以使用卷积神经网络来学习特征点的表示并进行匹配。

相比于传统算法,卷积神经网络可以自动学习图像的特征表示,具有更强的泛化能力。

2.2 微调网络(Fine-tuned network)微调网络是在预训练好的卷积神经网络模型上进行微调,以适应特定任务的需求。

在特征点匹配中,可以使用微调网络对图像进行特征提取,并使用其中一种距离度量方法(如欧氏距离、余弦相似度等)进行特征点的匹配。

SIFT算法原理SIFT算法详细介绍SIFT(Scale-Invariant Feature Transform)算法是一种用于图像特征提取和匹配的算法,被广泛应用于计算机视觉领域。

SIFT算法的核心思想是在不同尺度空间中检测和描述图像的局部特征,通过这些特征可实现图像的匹配、识别和定位。

1.尺度空间极值点检测:首先,SIFT算法通过高斯平滑滤波器构建高斯金字塔,每一层都是由上一层进行降采样得到的。

在不同尺度空间的图像上,通过比较每个像素点与其相邻像素点的灰度值,找出尺度空间极值点,作为关键点候选。

2.关键点定位:通过对尺度空间的极值点进行精确定位,以获取更加准确的关键点。

在关键点候选集合中,利用尺度空间的极值点与梯度方向直方图等局部特征进行过滤,剔除低对比度和边缘响应的关键点。

3.方向分配:为了使SIFT算法具有旋转不变性,需要为每个关键点分配主方向。

采用梯度直方图对关键点周围的图像区域进行统计,找到梯度方向直方图的峰值,作为该关键点的主方向。

4.关键点描述:在每个关键点周围的图像区域内,构建128维的特征向量,用于描述该关键点的局部特征。

通过计算每个像素点周围的梯度幅值和方向,并将其转换为特征向量的模式,构成关键点的描述符。

5.特征匹配:对于待匹配的图像,通过计算两个图像的特征向量之间的欧氏距离,进行特征匹配。

采用距离比值方法,选取最匹配和次匹配之间的距离比值小于预先设定的阈值的特征点,进行最终匹配。

6.特征筛选:通过应用RANSAC(随机抽样一致性)算法,对匹配结果进行筛选,剔除外点,保留内点,从而得到更准确的匹配结果。

SIFT算法的应用非常广泛,常用于目标识别、图像拼接、图像检索、三维重建和运动估计等领域。

在目标识别中,通过提取图像的SIFT特征,并与模板图像进行匹配,可以实现目标的识别和定位。

在图像拼接中,通过寻找多幅图像之间的共同特征点,并根据特征点的位置关系进行配准,可以实现图像的自动拼接。