人工智能导论实验指导书

- 格式:doc

- 大小:200.50 KB

- 文档页数:21

OCR实验手册4.3任务二:文字识别(OCR)4.3.1任务目标通过采用深度学习技进行对验证码进行图像识别,通过采用程序进行验证码生成进行数据集准备、采用opencv进行验证码分割、利用深度学习框架Keras进行模型搭建与训练、最后读取模型进行验证码识别,使读者能够:(1)体验一个完整的深度学习算法对验证码进行图像识别应用开发。

(2)掌握图像数据生成、处理、读取等操作。

(3)掌握使用深度学习框架进行模型搭建,训练与预测方法。

4.3.2任务实现本项目的主要流程:灰度→二值化→去干扰线及噪点→切割成单个字符→标注→识别学习并得到模型→使用模型识别。

对获得的原始验证码,处理流程总共分为以下几步:(1)对图片进行灰度处理,如图4-32。

图4-32 灰度处理(2)根据自己设置的阈值,对图片进行二值化处理。

图4-33 二值化处理(3)降噪处理,去除干扰的像素点及像素块。

图4-34 降噪处理(4)对图片进行切割,获得单个字符,并进行人工标注。

图4-35 图片分割(5)使用卷积神经网络进行模型训练,得到模型。

(6)使用训练得到的模型进行验证码识别。

步骤一:批量生成验证码在使用深度学习框架搭建验证码识别模型时,需要大量的验证码图片。

在这里,使用captcha模块生成验证码图片,验证码图片名称为验证码上显示的字符串。

验证码支持10个数字加26+26个大小写英文字母,一共62种字符类型。

通过运行程序在当前目录文件夹pic生成验证码。

运行代码:1gen_captcha.py,将使用代码生成随机验证码图像,运行程序后,在pic 文件夹中输出100张图像,如图4-36所示图4-36 验证码数据集步骤二:使用opencv看到验证码生成验证可以通过电脑的默认图片查看器查看,也可以用程序进行显示,这里采用opencv模板对图像进行读取与显示,同时还有打印图片的信息,例如图像宽高等。

代码路径:2show_img.pyimport cv2file_name = "./test_img/test_img_1.png"#读取图像img = cv2.imread(file_name)#图片大小信息print(img.shape)#显示验证码图片和验证码标题cv2.imshow("win", img)#窗口结束时间,如果为0,一直显示cv2.waitKey(0)运行效果如图4-37所示:图4-37 验证码显示步骤三:图像二值化处理由于验证码图像是四个字符,因此需要对这4个字符进行图像处理,完成分割,得到分别4个独立的字符,字符识别是对每个字符分别进行。

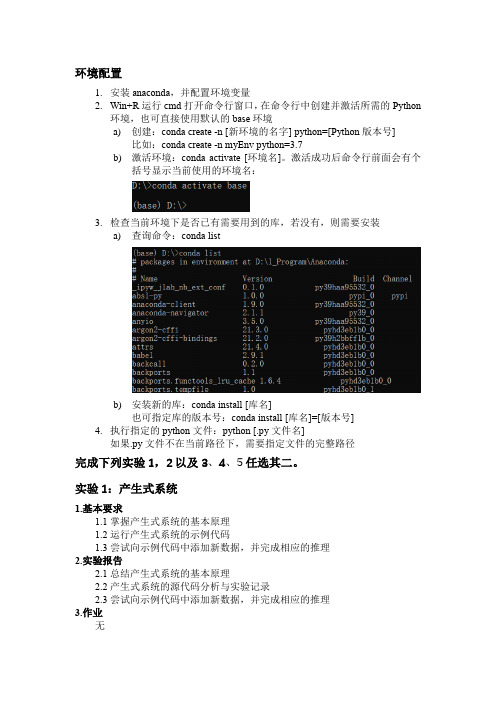

环境配置1.安装anaconda,并配置环境变量2.Win+R运行cmd打开命令行窗口,在命令行中创建并激活所需的Python环境,也可直接使用默认的base环境a)创建:conda create -n [新环境的名字] python=[Python版本号]比如:conda create -n myEnv python=3.7b)激活环境:conda activate [环境名]。

激活成功后命令行前面会有个括号显示当前使用的环境名:3.检查当前环境下是否已有需要用到的库,若没有,则需要安装a)查询命令:conda listb)安装新的库:conda install [库名]也可指定库的版本号:conda install [库名]=[版本号]4.执行指定的python文件:python [.py文件名]如果.py文件不在当前路径下,需要指定文件的完整路径完成下列实验1,2以及3、4、5任选其二。

实验1:产生式系统1.基本要求1.1掌握产生式系统的基本原理1.2运行产生式系统的示例代码1.3尝试向示例代码中添加新数据,并完成相应的推理2.实验报告2.1总结产生式系统的基本原理2.2产生式系统的源代码分析与实验记录2.3尝试向示例代码中添加新数据,并完成相应的推理3.作业无实验2:AStar求解八数码问题1.基本要求1.1掌握AStar算法的基本原理1.2编写并运行AStar算法求解八数码问题的示例代码。

给定矩阵初始状态,允许将0与相邻的4个数字之一交换,直到矩阵转变为目标状态。

输出每一步交换后的矩阵例12.实验报告2.1 总结AStar算法的基本原理2.2 如何描述八数码问题中两个状态间的距离?2.2 如何根据状态距离将八数码问题转换为AStar寻路问题?3.作业提交编写的AStar求解八数码问题代码实验3:AStar求解迷宫寻路问题1.基本要求1.1掌握AStar算法的基本原理1.2编写并运行AStar算法求解迷宫寻路问题的示例代码。

人工智能导论实验报告

一、实验要求

实验要求是使用Python实现一个简单的人工智能(AI)程序,包括

使用数据挖掘,机器学习,自然语言处理,语音识别,计算机视觉等技术,通过提供用户输入的信息,实现基于信息的自动响应和推理。

二、实验步骤

1. 数据采集:编写爬虫程序或者使用预先定义的数据集(如movielens)从互联网收集数据;

2. 数据预处理:使用numpy对数据进行标准化处理,以便机器学习

程序能够有效地解析数据;

3. 模型构建:使用scikit-learn或者tensorflow等工具,构建机

器学习模型,从已经采集到的数据中学习规律;

4.模型训练:使用构建完成的模型,开始训练,通过反复调整参数,

使得模型在训练集上的效果达到最优;

5.模型评估:使用构建完成的模型,对测试集进行预测,并与实际结

果进行比较,从而评估模型的效果;

6. 部署:使用flask或者django等web框架,将模型部署为网络应用,从而实现模型的实时响应;

三、实验结果

实验结果表明,使用数据挖掘,机器学习,自然语言处理,语音识别,计算机视觉等技术,可以得到很高的模型预测精度,模型的准确性可以明

显提高。

《人工智能导论》实验河南理工大学《人工智能》实验指导实验内容实验一状态空间搜索实验实验二 A*算法实验实验三子句消解实验实验四化为子句集的九步法实验实验五梵塔问题实验实验六 BP网络实验温馨提示:上述实验可以采用任何自己熟悉的语言来实现《人工智能导论》实验河南理工大学实验一状态空间搜索实验——八数码问题(必修,2学时)一、实验目的及内容实验目的:理解和掌握状态空间搜索的策略实验内容要求:在一个3X3的九宫中有1—8,这八个数及一个空格,随机的摆放在其中的格子里,现要求实现这个问题:将该九宫格调整为某种有序的形式,调整的原则为每次只能将空格(上、下、左、右)相邻的一个数字平移到空格中,试编程实现这一问题的求解二、实验原理及基本技术路线图(方框原理图或程序流程图)实验原理:算法分析:实验流程图:三、所用仪器、材料(设备名称、型号、规格等或使用软件)硬件:软件:四、实验方法、步骤(或:程序代码或操作过程)1.实验步骤2.实验源程序五、实验过程原始记录( 测试数据、图表、计算等)六、实验结果、分析和结论1《人工智能导论》实验河南理工大学实验二 A*算法实验(2学时)一、实验目的:熟悉和掌握启发式搜索的定义、估价函数和算法过程,并利用A*算法求解N数码难题,理解求解流程和搜索顺序。

二、实验原理:A*算法是一种有序搜索算法,其特点在于对估价函数的定义上。

对于一般的有序搜索,总是选择f值最小的节点作为扩展节点。

因此,f是根据需要找到一条最小代价路径的观点来估算节点的,所以,可考虑每个节点n的估价函数值为两个分量:从起始节点到节点n的代价以及从节点n到达目标节点的代价。

三、实验条件:1 N数码难题演示程序。

2 IE6.0以上,可以上Internet。

三、实验内容:1 分别以8数码和15数码为例实际求解A*算法。

2 画出A*算法求解框图。

3 分析估价函数对搜索算法的影响。

4 分析A*算法的特点。

四、实验步骤:1 开始演示。

山西财经大学信息管理学院王保忠编《人工智能实验指导书》适用专业:计算机科学与技术信息管理与系统信息科学与计算一、学时与学分总学时:48;总学分:4;实验学时:16;实验学分:1二、实验课的任务、性质与目的本实验课程是计算机专业、信息管理与系统学生的一门专业课程,通过实验软件环境提供的大量演示性、验证性和开发设计性实验,帮助学生更好地熟悉和掌握人工智能的基本原理和方法;通过实验提高学生编写实验报告、总结实验结果的能力;使学生对人工智能的相关理论有更深刻的认识。

三、基本原理本实验涉及人工智能的经典理论和方法,以及计算智能的部分分支和实现方法,主要包括以下内容:1. 产生式系统实验2. 搜索策略实验3. 神经网络实验4. 自动规划实验四、实验方式与基本要求本实验目的是使学生进一步加深对人工智能的基本原理和方法的认识,通过实践了解人工智能的实现手段。

实验方式:1. 实验共16学时;2. 由指导教师讲解实验的基本要求,提示算法的基本思想;3. 实验一人一组,独立完成实验的演示、验证和开发设计;4. 学生在完成预习报告后才能进入实验室进行实验。

五、实验项目的设置与内容提要《人工智能实验指导书》实验名称实验目的内容简介1 产生式系统实验熟悉和掌握产生式系统的运行机制,掌握基于规则推理的基本方法主要包括产生式系统的正、反向推理、基于逻辑的搜索等10余个相关演示性、验证性和开发性设计实验。

2 搜索策略实验熟悉和掌握启发式搜索的定义、估价函数和算法过程,并利用A*算法求解N数码难题,理解求解流程和搜索顺序。

主要包括盲目式、启发式搜索类的10余个相关演示性、验证性和开发性设计实验。

3 神经网络实验理解反向传播网络的结构和原理,掌握反向传播算法对神经元的训练过程,了解反向传播公式。

通过构建BP网络实例,熟悉前馈网络的原理及结构。

主要包括以BP网为代表的ANN的验证性实验及设计性实验。

并包括用BP网解决一些非线性问题的典型设计实验(如异或问题、布尔代数及非线性函数模拟等)4 自动规划实验理解自动规划的基本原理,掌握为活动实体(人、组织、机器)设计合理的行为、按时间顺序的活动序列等基本技术。

《人工智能导论》实验指导实验一Prolog平台使用实验二状态空间搜索:传教士与野人问题求解实验三启发式搜索算法:斑马属谁问题求解实验四小型专家系统设计与实现实验报告的基本内容和书写格式——————————————————————————————————一、实验目的二、实验内容三、实验步骤四、实验结果1. 系统名称〈所做系统的名称〉2. 系统概述(包括所做系统的背景和主要功能等。

)3.系统运行演示过程(1) 输入的初始事实或数据:(2) 系统运行时产生的推理树(网):(3) 输出的结果:——————————————————————————————————《人工智能导论》实验一Prolog平台使用实验目的:熟悉Prolog(包括SWI-Prolog平台、Turbo-Prolog平台),包括编辑器、编译器及其执行模式;熟悉Prolog语法、数据结构和推理机制;熟悉SWI-Prolog平台与Visual C++结合开发应用程序。

实验环境(硬/软件要求):硬件:计算机一台软件:SWI-Prolog、Turbo Prolog、SWI-Prolog-Editor、Visual C++、Eclipse实验内容:1.Prolog平台界面和基本操作;2.熟悉Prolog语法和数据结构;3.熟悉Eclipse PDT插件安装、使用;4.编写简单Prolog程序并测试(输入动物叫声、输出该动物名称);5.熟悉Prolog平台与Visual C++结合开发应用程序;实验主要步骤:1.打开SWI-Prolog平台,熟悉SWIPrologEditor,熟悉操作界面;2.实现Prolog基本语句;3.编写简单Prolog程序并测试(输入动物叫声、输出该动物名称);示例程序(Turbo Prolog)逻辑电路模拟程序。

该程序以逻辑运算“与”、“或”、“非”的定义为基本事实,然后在此基础上定义了“异或”运算。

那么,利用这些运算就可以对“与”、“或”、“非”和“异或”等逻辑电路进行模拟。

人工智能导论实验报告人工智能导论实验报告一、实验目的本实验旨在通过实际操作,加深对人工智能导论中基本概念和算法的理解,培养我们的实践能力和解决问题的能力。

二、实验原理在人工智能导论中,我们学习了机器学习、深度学习、自然语言处理等重要概念和算法。

本实验将通过应用这些算法,实现对特定数据集的分类、预测和生成等任务。

三、实验步骤1.数据准备:选择合适的数据集,进行预处理和特征工程。

在本实验中,我们选择了经典的MNIST手写数字数据集。

2.模型训练:根据所选择的算法和数据集,构建并训练模型。

本实验中,我们采用了深度学习中的卷积神经网络(CNN)算法进行图像分类。

3.模型评估:使用测试集对模型进行评估,计算准确率、精度等指标。

4.模型优化:根据评估结果,对模型进行优化调整,提高性能。

5.应用扩展:将优化后的模型应用于实际场景中,实现分类、预测等功能。

四、实验结果与分析1.实验结果经过训练和优化,我们在MNIST数据集上达到了95%的准确率,取得了较好的分类效果。

2.结果分析通过对比不同模型结构和参数的实验结果,我们发现以下几点对模型性能影响较大:(1)数据预处理:合适的预处理方法能够提高模型的分类性能。

例如,对手写数字图像进行灰度化和归一化处理后,模型的分类准确率得到了显著提升。

(2)模型结构:在本实验中,我们采用了卷积神经网络(CNN)算法。

通过调整CNN的层数、卷积核大小和池化参数等,可以显著影响模型的分类性能。

(3)优化算法:选择合适的优化算法能够提高模型的训练效果。

我们采用了梯度下降法进行优化,并比较了不同的学习率和优化策略对模型性能的影响。

(4)特征工程:虽然MNIST数据集较为简单,但适当的特征工程仍然可以提高模型的性能。

例如,我们尝试了不同的图像尺寸和归一化方法,发现它们对模型的分类性能具有一定影响。

五、结论与展望通过本次实验,我们深入了解了人工智能导论中的基本概念和算法,并成功应用到了MNIST手写数字分类任务中。

人工智能技术实验指导书实验背景本实验指导书旨在帮助学生深入了解人工智能技术的基础原理及应用方法。

通过本实验,学生将能掌握人工智能技术的基本概念、算法和编程技能,为未来在人工智能领域的研究和研究打下坚实基础。

实验目的本实验旨在培养学生的人工智能算法设计和编程能力,提高学生对人工智能技术的理解和应用能力。

实验内容实验一:人工智能算法基础- 研究人工智能算法的基本概念和分类;- 掌握常见的人工智能算法原理和实现方法;- 利用Python编程语言实现简单的人工智能算法。

实验二:机器研究算法实践- 掌握机器研究算法的基本原理和应用方法;- 研究使用机器研究库进行数据预处理和算法训练;- 利用已有数据集,实现一个简单的机器研究算法模型。

实验三:深度研究算法应用- 理解深度研究算法的基本原理和结构;- 研究使用深度研究框架进行神经网络模型的设计和训练;- 实现一个简单的深度研究算法应用案例。

实验要求- 学生应具备基本的编程能力,熟悉Python编程语言;- 学生应具备基本的数学和统计知识,对概率和线性代数有一定了解;- 学生应具备良好的逻辑思维能力和问题解决能力。

实验评估- 实验报告:学生需按要求书写并提交实验报告,内容包括实验目的、方法、实验结果和分析等;- 实验成绩:根据实验报告和实验结果,对学生的实验成果进行综合评估。

实验资源- 教材:提供相关的教材和参考书籍,供学生参考和研究;- 软件工具:提供相应的编程环境和开发工具,供学生进行实验操作和编程实现。

实验安排- 实验时间:本实验预计需要3周的时间完成;- 实验地点:学生可以自行选择合适的实验地点进行实验。

注意事项- 学生在进行实验时,应遵守实验室规定和安全操作流程;- 学生在编写实验报告时,应保证报告内容真实可信。

参考资料- 《人工智能导论》- 《机器研究实战》- 《深度学习》。

贵州大学计算机科学与技术学院计算机科学与技术科系本科生《人工智能》实验指导书/实验教学大纲王以松2012年目录实验一人工智能冲浪 (3)实验二SAT求解描述性问题 (4)实验三Prolog基本编程环境 (6)实验四ASP描述性问题求解 (10)参考资料: (12)实验一人工智能冲浪1、实验目的了解人工智能的定义/讨论,研究内容,研究进展以及相关的重要人物和有影响的事件。

2、实验原理通过网络搜索引擎,例如google,baidu,yahoo等,以关键词在网络上搜索相关内容。

3、实验内容搜索如下内容:1)人工智能的定义与讨论,特别是wiki百科在这方面的讨论.2)人工智能研究方向/领域,以及本领域中有重大影响力的论文1-2篇,例如在citeseer上的被引用次数最多.3)Turing奖获得者中,人工智能领域的专家,例如McCarthy, Pearl, Newell, Simon, Feigenbaum等,他们的获奖理由/在人工智能方面的突出贡献.4)IBM Deep Blue, Watson;Checker;Big Dog(Boston Dynamics)4、实验描述及要求选择其中一个实验内容,整理形成一个AI的主题介绍。

5、实验步骤无要求.6、参考程序无.实验二SAT求解描述性问题1、实验目的通过学习并使用一个SAT求解器,例如MiniSat,了解Satisfiability描述性问题求解方法。

了解SAT求解器的研发现状。

2、实验原理把给定的问题表达成逻辑公式CNF形式,使得其模型对应问题的解。

经过翻译后,输入给SAT求解器,并将其输出结果解释后输出,从而读出问题的一个解。

3、实验内容1)选用一个SAT求解器,例如MiniSat等。

2)搜索公开的SAT的benchmark/测试用例,就图着色等问题生成CNF公式,或随机生成CNF公式。

3)调用SAT求解器,例如MiniSat,计算其模型。

4)输出对应问题的解。

目录实验一 PROLOG语言编程练习 (2)实验二图搜索问题求解 (4)实验三小型专家系统(原型)设计 (7)实验一 PROLOG语言编程练习一、实验目的加深学生对逻辑程序运行机理的理解,使学生掌握PROLOG语言的特点、熟悉其编程环境,同时为后面的人工智能程序设计做好准备。

1、熟悉PROLOG语言编程环境的使用;2、了解PROLOG语言中常量、变量的表示方法;3、了解利用PROLOG进行事实库、规则库的编写方法;二、实验环境计算机,Turbo PROLOG教学软件。

三、预习要求实验前应阅读实验指导书,了解实验目的、预习PROLOG语言的相关知识。

四、实验内容1、学习使用Turbo PROLOG,包括进入PROLOG主程序、编辑源程序、修改环境目录、退出等基本操作。

2、在Turbo prolog集成环境下调试运行简单的Turbo PROLOG程序,如描述亲属关系的PROLOG程序或其他小型演绎数据库程序等。

五、实验方法和步骤1、启动Windows XP操作环境。

2、打开文件目录,执行prolog应用程序,启动Turbo prolog,并按空格键(SPACE)进入集成开发环境。

3、选择Setup项,打开下拉菜单,选择Directories项,进行工作目录修改,按Esc键退出,选择Save Configuration项,保存修改。

4、选择Files项,打开下拉菜单,选择New file项,进入源程序输入和编辑,或选择Load项,选择要打开的示例程序,再选择Edit项,可以进行编辑源程序。

5、编辑之后,可以选择Run项,执行程序,可以在Dialog窗口进行询问,即外部目标的执行,查看程序运行结果,分析程序之功能。

6、仿前例,可以选择其他程序并运行,分析程序功能。

7、退出,选择Quit项,可以退出Turbo Prolog程序,返回到Windows XP环境。

六、示例程序逻辑电路模拟程序。

该程序以逻辑运算“与”、“或”、“非”的定义为基本事实,然后在此基础上定义了“异或”运算。

实验一 感知器的MATLAB 仿真感知器(Pereceptron)是一种特殊的神经网络模型,是由美国心理学家F.Rosenblatt 于1958年提出的,一层为输入层,另一层具有计算单元,感知器特别适合于简单的模式分类问题,也可用于基于模式分类的学习控制和多模态控制中。

一、感知器神经元模型感知器神经元通过对权值的训练,可以使感知器神经元的输出能代表对输入模式进行的分类,图1.1为感知器神经元模型。

图1.1 感知器神经元模型感知器神经元的每一个输入都对应于一个合适的权值,所有的输入与其对应权值的加权和作为阀值函数的输入。

由于阀值函数的引入,从而使得感知器可以将输入向量分为两个区域,通常阀函数采用双极阶跃函数,如:⎩⎨⎧<≥=0,00,1)(x x x f (1.1) 而感知器神经元模型的实际输出为⎪⎭⎫⎝⎛-=∑-=R i i i b x w f o 1 (1.2)其中b 为阀值二、感知器的网络结构图1.2所描述的是一个简单的感知器网络结构,输入层有R 个输入,Q 个输出,通过权值w ij 与s 个感知器神经元连接组成的感知器神经网络。

根据网络结构,可以写出感知器处理单元对其输入的加权和操作,即:∑==Rj j ij i p w n 1(1.3)而其输出a i 为a i =f (n i +b i ) (1.4)由式2.1易知⎩⎨⎧<+≥+=0001i i i i i b n b n a (1.5) 则当输入n i +b i 大于等于0,即有n i ≥-b i 时,感知器的输出为1;否则输出为0。

上面所述的单层感知器神经网络是不可能解决线性不可分的输入向量分类问题,也不能推广到一般的前向网络中去。

为解决这一问题,我们可以设计多层感知器神经网络以实现任意形状的划分。

图1.3描述了一个双层感知器神经网络。

其工作方式与单层感知器网络一样,只不过是增加了一层而已,具体的内容这里不做讨论。

三、感知器神经网络的学习规则感知器的学习规则主要是通过调整网络层的权值和阀值以便能够地网络的输入向量进行正确的分类。

P 1S ×1图1.2 感知器神经网络结构P 1 图1.3 感知器神经网络结构如图1.2所示的输入向量P、输出和量a和目标向量为t的感知器神经网络,感知器的学习规则是根据以下输出矢量a可能出现的几种情况未进行参与调整的:1)如果第i个神经元的输出是正确的,即有a i=t1,则与第i个神经元联接的权值和阀值保持不变。

2)如果第i个神经元的输出是不正确,应该有两种情况。

i)实际输出为0,而理想输出为1,即有a i=0,而t i=1,则所有的输入j 对权值和阀值进行调整,修正值Δw1j=p j,Δb j=1。

ii)实际输出为1,而期望输出为0,即有a i=1,而t i=0,则对所有的输入j进行权值和阀值调整,Δw1j=-p j,Δb i=-1。

基于感知器误差e=t-a,感知器学习规则可望写为:Δw1j=e i·p j可以证明当前输入样本来自线性可分的模式时,上述学习算法在有限步同收敛,这时所得的权值能对所有样本正确分类,这一结论被称为感知器收敛定理。

四、感知器神经网络的训练要使前向神经网络模型实现某种功能,必须对它进行训练,让它逐步学会要做的事情,并把所学到的知识记忆在网络的权值中。

感知器神经网络的训练是采用由一组样本组成的集合来进行。

在训练期间,将这些样本重复输入,通过调整权值使感知器的输出达到所要求的理想输出。

感知器的训练主要是反复对感知器神经网络进行仿真和学习,最终得到最优的网络阀值和权值。

我们可以用以下方法训练网络:1)确定我们所解决的问题的输入向量P、目标向量t,并确定各向量的维数,以及网络结构大小、神经元数目。

假定我们采用图2.2的网络结构。

2)初始化:权值向量w和阀值向量b分别赋予[-1,+1]之间的随机值,并且给出训练的最大次数。

3)根据输入向量P、最新权值向量w和阀值向量b,计算网络输出向量a。

4)检查感知器输出向量与目标向量是否一致,或者是否达到了最大的训练次数,如果是则结束训练,否则转入(5)。

5)根据感知器学习规则调查权向量,并返回3)。

五、重要的感知器神经网络函数的使用方法对于感知器的初始化、训练、仿真,在MA TLABP神经网络工具箱中分别提供了init( ), trainp( )和sim( )函数。

1.初始化函数init( )感知器初始化函数init( )可得到R个输入,S个神经元数的感知器层的权值和阀值,其调用格式为:[w,b]=init(R,S)另外,也可以利用输入向量P和目标向量t来初始化。

[w,b]=init(p,t)在介绍trainp( )函数前,让我们先介绍一下训练的控制参数tp。

tp=[disp_freq max_epoch]其中disp_freq指定两次显示间训练次数,缺省值为1;map_epoch指定训练的最大次数,缺省值为100。

2. 训练函数trainp( )调用训练函数trainp( )函数后又得到新的权值矩阵,阀值向量以及误差te。

trainp( )函数所需要的输入变量为:输入向量P、目标向量t以及网络的初始权值和阀值,训练的控制参数tp。

调用格式为:[w,b,te]=trainp(w,b,p,t,tp)由于函数trainp( )并不能保证感知器网络所得到的网络权值和阀值达到要求。

因此,在训练完后,要用下列验证语句验证一下。

a=sim(p, w, b);if all(a= =t),disp( ′It works!′),end假如网络不能成功运行,就可以继续运用trainp( )函数对网络进行训练。

经足够的训练后,网络仍达不到要求,那么就应当认真分析一下,感知器网络是否适合于这个问题。

3.仿真函数sim( )sim( )函数主要用于计算网络输出。

它的调用比较简单。

a=sim(p,w,b)六、感知器神经网络应用举例为了便于消化与理解感知器神经网络的四个问题,下面将给出一个具体的问题进行分析,问题的描述如下:两种蠓虫Af 和Apf 已由生物学家W.L.Grogan 与w. w. Wirth(1981)根据它们触角长度和翼长中以区分。

见表1.1中9Af 蠓和6只Apf 蠓的数据。

根据给出的触角长度和翼长可识别出一只标本是Af 还是Apf 。

1.给定一只Af 或者Apf 族的蒙,你如何正确地区分它属于哪一族? 2.将你的方法用于触角长和翼中分别为(1.24,1.80)、(1.28,1.84)、(1.40,2.04)的三个标本表1.1输入向量为:p=[1.24 1.36 1.38 1.378 1.38 1.40 1.48 1.54 1.56 1.14 1.18 1.20 1.26 1.28 1.30;1.72 1.74 1.64 1.82 1.90 1.70 1.70 1.82 2.08 1.78 1.96 1.86 2.00 2.00 1.96 ]目标向量为:图形显示,目标值1对应的用“+”、目标值0对应的用“o ”来表示:plotpv(p ,t)为解决该问题,利用函数newp 构造输入量在[0,2.5]之间的感知器神经网络模型:net=newp([0 2.5;0 2.5],1) 初始化网络:net=init(net)利用函数adapt调整网络的权值和阀值,直到误差为0时训练结束:[net, y, e]=adapt(net, p, t)训练结束后可得如图1.5的分类方式,可见感知器网络将样本正确地分成两类:图1.5 网络训练结果感知器网络训练结束后,可以利用函数sim进行仿真,解决实际的分类问题:p1=[1.24;1.80]a1=sim(net,p1)p2=[1.28;1.84]a2=sim(net,p2)p3=[1.40;2.04]a3=sim(net,p3)网络仿真结果为:a1=0 a2=0 a3=0实验二线性神经网络的MATLAB实现线性神经网络是最简单的一种神经元网络,由一个或多个线性神经元构成。

1959年,美国工程师B.widrow和M.Hoft提出自适应线性元件(Adaptive linear element,简称Adaline)是线性神经网络的最早典型代表。

它是感知器的变化形式,尤其在修正权矢量的方法上进行了改进,不仅提高了训练收敛速度,而且提高了训练精度。

线性神经网络与感知器神经网络的主要不同之处在于其每个神经元的传递函数为线性函数,它允许输出任意值,而不是象感知器中只能输出0或1。

此外,线性神经网络一般采用Widrow-Hoff (简称W-H)学习规则或者最小场方差(Least mean Square,简称LMS)规则来调整网络的权值和阀值。

线性神经网络的主要用途是线性逼近一个函数表达式,具有联想功能。

另外,它还适用于信号处理滤波、预测、模式识别和控制等方面。

一、线性神经元模型线性神经元可以训练学习一个与之对应的输入/输出函数关系,或线性逼近任意一个非线性函数,但它不能产生任何非线性的计算特性。

图2.1描述了一个具有R个输入的由纯线性函数组成的线性神经元。

图2.1 线性神经元模型由于线性神经网络中神经元的传递函数为线性函数,其输入与输出之间是简单的比例关系:a=g(w*p,b)其中函数g(x)为线性函数。

二、线性神经网络结构如图2.2描述了一个由S 个神经元相并联形成一层网络,这种网络也称为Madaline 网络。

W -H 学习规则只能训练单层的线性神经网络,但这并不是什么严重问题。

因为对线性神经网络而言,完全可以设计出一个性能完全相当的单层线性神经网络。

三、线性神经学习网络的学习规则前面我们提到过,线性神经网络采用W -H 学习规则。

W -H 学习规则是Widrow 是Hoft 提出的用来求得权值和阀值的修正值的学习规则。

首先要定义一个线性网络的输出误差函数:E(w,b)=21(t ―a)2=21(t ―w*p)2 2.1 由式2.1可看出,线性网络具有抛物线型误差函数所形成的误差表面。

所以只有一个误差最小值。

通过W -H 学习规则来计算权值和偏差的变化,并使网络的误差平方和最小化,总能够训练一个网络的误差趋于最小值。

这可通过沿着相对于误差平方和最速下降方向连续调整网络的权值和阀值来实现。

根据梯度下降法,权矢量的修正值正比于当前位置上E (w,b )的梯度,对于第i 输出节点为:j i i ijij p a t w Ew )(-=∂∂-=∆ηη2.2 或表示为:P1 S ×1图2.2 线性神经元网络j i ij p w ηδ=∆ 2.3 i i b ηδ=∆ 2.4这里δi 定义为第i 个输出节点的误差:δi =t i ―a i 2.5式2.3称为W -H 学习规则。