spss回归分析相关分析

- 格式:pptx

- 大小:918.26 KB

- 文档页数:55

如何使用统计软件SPSS进行回归分析如何使用统计软件SPSS进行回归分析引言:回归分析是一种广泛应用于统计学和数据分析领域的方法,用于研究变量之间的关系和预测未来的趋势。

SPSS作为一款功能强大的统计软件,在进行回归分析方面提供了很多便捷的工具和功能。

本文将介绍如何使用SPSS进行回归分析,包括数据准备、模型建立和结果解释等方面的内容。

一、数据准备在进行回归分析前,首先需要准备好需要分析的数据。

将数据保存为SPSS支持的格式(.sav),然后打开SPSS软件。

1. 导入数据:在SPSS软件中选择“文件”-“导入”-“数据”命令,找到数据文件并选择打开。

此时数据文件将被导入到SPSS的数据编辑器中。

2. 数据清洗:在进行回归分析之前,需要对数据进行清洗,包括处理缺失值、异常值和离群值等。

可以使用SPSS中的“转换”-“计算变量”功能来对数据进行处理。

3. 变量选择:根据回归分析的目的,选择合适的自变量和因变量。

可以使用SPSS的“变量视图”或“数据视图”来查看和选择变量。

二、模型建立在进行回归分析时,需要建立合适的模型来描述变量之间的关系。

1. 确定回归模型类型:根据研究目的和数据类型,选择适合的回归模型,如线性回归、多项式回归、对数回归等。

2. 自变量的选择:根据自变量与因变量的相关性和理论基础,选择合适的自变量。

可以使用SPSS的“逐步回归”功能来进行自动选择变量。

3. 建立回归模型:在SPSS软件中选择“回归”-“线性”命令,然后将因变量和自变量添加到相应的框中。

点击“确定”即可建立回归模型。

三、结果解释在进行回归分析后,需要对结果进行解释和验证。

1. 检验模型拟合度:可以使用SPSS的“模型拟合度”命令来检验模型的拟合度,包括R方值、调整R方值和显著性水平等指标。

2. 检验回归系数:回归系数表示自变量对因变量的影响程度。

通过检验回归系数的显著性,可以判断自变量是否对因变量有统计上显著的影响。

数据统计分析软件SPSS的应用(五)——相关分析与回归分析数据统计分析软件SPSS的应用(五)——相关分析与回归分析数据统计分析软件SPSS是目前应用广泛且非常强大的数据分析工具之一。

在前几篇文章中,我们介绍了SPSS的基本操作和一些常用的统计方法。

本篇文章将继续介绍SPSS中的相关分析与回归分析,这些方法是数据分析中非常重要且常用的。

一、相关分析相关分析是一种用于确定变量之间关系的统计方法。

SPSS提供了多种相关分析方法,如皮尔逊相关、斯皮尔曼相关等。

在进行相关分析之前,我们首先需要收集相应的数据,并确保数据符合正态分布的假设。

下面以皮尔逊相关为例,介绍SPSS 中的相关分析的步骤。

1. 打开SPSS软件并导入数据。

可以通过菜单栏中的“File”选项来导入数据文件,或者使用快捷键“Ctrl + O”。

2. 准备相关分析的变量。

选择菜单栏中的“Analyze”选项,然后选择“Correlate”子菜单中的“Bivariate”。

在弹出的对话框中,选择要进行相关分析的变量,并将它们添加到相应的框中。

3. 进行相关分析。

点击“OK”按钮后,SPSS会自动计算所选变量之间的相关系数,并将结果输出到分析结果窗口。

4. 解读相关分析结果。

SPSS会给出相关系数的值以及显著性水平。

相关系数的取值范围为-1到1,其中-1表示完全负相关,1表示完全正相关,0表示没有相关关系。

显著性水平一般取0.05,如果相关系数的显著性水平低于设定的显著性水平,则可以认为两个变量之间存在相关关系。

二、回归分析回归分析是一种用于探索因果关系的统计方法,广泛应用于预测和解释变量之间的关系。

SPSS提供了多种回归分析方法,如简单线性回归、多元线性回归等。

下面以简单线性回归为例,介绍SPSS中的回归分析的步骤。

1. 打开SPSS软件并导入数据。

同样可以通过菜单栏中的“File”选项来导入数据文件,或者使用快捷键“Ctrl + O”。

2. 准备回归分析的变量。

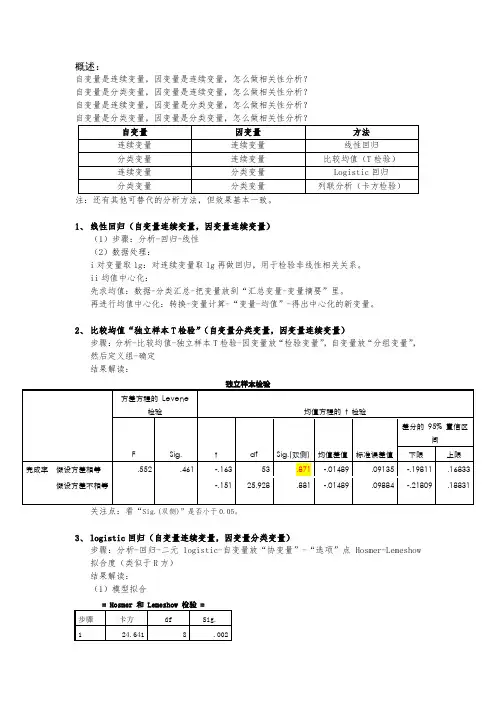

概述:自变量是连续变量,因变量是连续变量,怎么做相关性分析?自变量是分类变量,因变量是连续变量,怎么做相关性分析?自变量是连续变量,因变量是分类变量,怎么做相关性分析?注:还有其他可替代的分析方法,但效果基本一致。

1、线性回归(自变量连续变量,因变量连续变量)(1)步骤:分析-回归-线性(2)数据处理:i对变量取lg:对连续变量取lg再做回归,用于检验非线性相关关系。

ii均值中心化:先求均值:数据-分类汇总-把变量放到“汇总变量-变量摘要”里。

再进行均值中心化:转换-变量计算-“变量-均值”-得出中心化的新变量。

2、比较均值“独立样本T检验”(自变量分类变量,因变量连续变量)步骤:分析-比较均值-独立样本T检验-因变量放“检验变量”,自变量放“分组变量”,然后定义组-确定结果解读:关注点:看“Sig.(双侧)”是否小于0.05。

3、logistic回归(自变量连续变量,因变量分类变量)步骤:分析-回归-二元logistic-自变量放“协变量”-“选项”点Hosmer-Lemeshow 拟合度(类似于R方)结果解读:(1)模型拟合= Hosmer 和 Lemeshow 检验 =步骤卡方df Sig.1 24.641 8 .002关注点:卡方越小,Sig.越高,说明模型拟合度越高。

关注点:看变量的显著性水平是否小于0.05。

4、列联表分析(自变量分类变量,因变量分类变量)步骤:分析-描述统计-交叉表-自变量放“列”,因变量放“行”-“统计量”点“卡方”-“单元格”点“百分比-行”结果解读:卡方检验值df 渐进 Sig. (双侧)精确 Sig.(双侧)精确 Sig.(单侧)Pearson 卡方 3.245a 1 .072连续校正b 2.900 1 .089似然比 3.313 1 .069Fisher 的精确检验.077 .043 有效案例中的 N 1084a. 0 单元格(.0%) 的期望计数少于 5。

spss二元logistic回归分析结果解读二元logistic回归分析是一种重要的统计学方法,可以用来对事件发生与否、违约与否等二元变量进行分析,以及把其他自变量与二元变量之间的关系分析出来。

本文将从回归分析的背景、过程、模型分析和结果解释几个方面来论述SPSS二元logistic回归分析结果解读。

一、回归分析的背景二元logistic回归分析是对事件发生状况,如违约情况,是否能够通过自变量的影响而产生波动的状况,比如客户的反应、经济形势以及其他因素。

二元logistic回归分析用于分析违约行为是否与客户的特征有关,以及查看违约行为的发生率随着潜在因素的变化而如何变化。

二、二元logistic回归分析的过程二元logistic回归分析的过程是以自变量对变量(或响应变量)变化来提出研究假设,然后使用这种假设来拟合回归模型,从而评估自变量对变量的影响,并预测其变化。

在SPSS软件中,二元logistic回归分析的过程包括:(1)确定自变量;(2)建立模型;(3)检验模型;(4)分析单个自变量;(5)结果解释。

三、模型分析通过二元logistic回归可以计算回归系数,用于分析自变量对事件发生与否的影响,也可以通过回归系数求出奇异值,来度量回归系数的统计显著性,也即模型拟合度。

SPSS二元logistic回归分析结果输出有两个主要部分,一部分是转换的参数分析,一部分是基础的参数分析。

其中,转换的参数分析中,可以看到回归系数、Odds Ratio以及它们的差异显著性,也可以构建Odds Ratio曲线,来查看自变量的整体影响;基础的参数分析中,可以看到Deviance、Cox & Snell R2以及Nagelkerke R2,来检验模型的拟合度。

结果解释在SPSS二元logistic回归分析结果解释中,可以从回归系数和Odds ratio、Deviance、Cox & Snell R2以及Nagelkerke R2几个方面来解释模型的结果。

相关分析和回归分析SPSS实现SPSS(统计包统计分析软件)是一种广泛使用的数据分析工具,在相关分析和回归分析方面具有强大的功能。

本文将介绍如何使用SPSS进行相关分析和回归分析。

相关分析(Correlation Analysis)用于探索两个或多个变量之间的关系。

在SPSS中,可以通过如下步骤进行相关分析:1.打开SPSS软件并导入数据集。

2.选择“分析”菜单,然后选择“相关”子菜单。

3.在“相关”对话框中,选择将要分析的变量,然后单击“箭头”将其添加到“变量”框中。

4.选择相关系数的计算方法(如皮尔逊相关系数、斯皮尔曼等级相关系数)。

5.单击“确定”按钮,SPSS将计算相关系数并将结果显示在输出窗口中。

回归分析(Regression Analysis)用于建立一个预测模型,来预测因变量在自变量影响下的变化。

在SPSS中,可以通过如下步骤进行回归分析:1.打开SPSS软件并导入数据集。

2.选择“分析”菜单,然后选择“回归”子菜单。

3.在“回归”对话框中,选择要分析的因变量和自变量,然后单击“箭头”将其添加到“因变量”和“自变量”框中。

4.选择回归模型的方法(如线性回归、多项式回归等)。

5.单击“统计”按钮,选择要计算的统计量(如参数估计、拟合优度等)。

6.单击“确定”按钮,SPSS将计算回归模型并将结果显示在输出窗口中。

在分析结果中,相关分析会显示相关系数的数值和统计显著性水平,以评估变量之间的关系强度和统计显著性。

回归分析会显示回归系数的数值和显著性水平,以评估自变量对因变量的影响。

值得注意的是,相关分析和回归分析在使用前需要考虑数据的要求和前提条件。

例如,相关分析要求变量间的关系是线性的,回归分析要求自变量与因变量之间存在一定的关联关系。

总结起来,SPSS提供了强大的功能和工具,便于进行相关分析和回归分析。

通过上述步骤,用户可以轻松地完成数据分析和结果呈现。

然而,分析结果的解释和应用需要结合具体的研究背景和目的进行综合考虑。

SPSS的线性回归分析分析SPSS是一款广泛用于统计分析的软件,其中包括了许多功能强大的工具。

其中之一就是线性回归分析,它是一种常用的统计方法,用于研究一个或多个自变量对一个因变量的影响程度和方向。

线性回归分析是一种用于解释因变量与自变量之间关系的统计技术。

它主要基于最小二乘法来评估自变量与因变量之间的关系,并估计出最合适的回归系数。

在SPSS中,线性回归分析可以通过几个简单的步骤来完成。

首先,需要加载数据集。

可以选择已有的数据集,也可以导入新的数据。

在SPSS的数据视图中,可以看到所有变量的列表。

接下来,选择“回归”选项。

在“分析”菜单下,选择“回归”子菜单中的“线性”。

在弹出的对话框中,将因变量拖放到“因变量”框中。

然后,将自变量拖放到“独立变量”框中。

可以选择一个或多个自变量。

在“统计”选项中,可以选择输出哪些统计结果。

常见的选项包括回归系数、R方、调整R方、标准误差等。

在“图形”选项中,可以选择是否绘制残差图、分布图等。

点击“确定”后,SPSS将生成线性回归分析的结果。

线性回归结果包括多个重要指标,其中最重要的是回归系数和R方。

回归系数用于衡量自变量对因变量的影响程度和方向,其值表示每个自变量单位变化对因变量的估计影响量。

R方则反映了自变量对因变量变异的解释程度,其值介于0和1之间,越接近1表示自变量对因变量的解释程度越高。

除了回归系数和R方外,还有其他一些统计指标可以用于判断模型质量。

例如,标准误差可以用来衡量回归方程的精确度。

调整R方可以解决R方对自变量数量的偏向问题。

此外,SPSS还提供了多种工具来检验回归方程的显著性。

例如,可以通过F检验来判断整个回归方程是否显著。

此外,还可以使用t检验来判断每个自变量的回归系数是否显著。

在进行线性回归分析时,还需要注意一些统计前提条件。

例如,线性回归要求因变量与自变量之间的关系是线性的。

此外,还需要注意是否存在多重共线性,即自变量之间存在高度相关性。

spss多元线性回归分析结果解读SPSS多元线性回归分析结果解读1. 引言多元线性回归分析是一种常用的统计分析方法,用于研究多个自变量对因变量的影响程度及相关性。

SPSS是一个强大的统计分析软件,可以进行多元线性回归分析并提供详细的结果解读。

本文将通过解读SPSS多元线性回归分析结果,帮助读者理解分析结果并做出合理的判断。

2. 数据收集与变量说明在进行多元线性回归分析之前,首先需要收集所需的数据,并明确变量的含义。

例如,假设我们正在研究学生的考试成绩与他们的学习时间、家庭背景、社会经济地位等因素之间的关系。

收集到的数据包括每个学生的考试成绩作为因变量,以及学习时间、家庭背景、社会经济地位等作为自变量。

变量说明应当明确每个变量的测量方式和含义。

3. 描述性统计分析在进行多元线性回归分析之前,我们可以首先对数据进行描述性统计分析,以了解各个变量的分布情况。

SPSS提供了丰富的描述性统计方法,如均值、标准差、最小值、最大值等。

通过描述性统计分析,我们可以获得每个变量的分布情况,如平均值、方差等。

4. 相关性分析多元线性回归的前提是自变量和因变量之间存在一定的相关性。

因此,在进行回归分析之前,通常需要进行相关性分析来验证自变量和因变量之间的关系。

SPSS提供了相关性分析的功能,我们可以得到每对变量之间的相关系数以及其显著性水平。

5. 多元线性回归模型完成了描述性统计分析和相关性分析后,我们可以构建多元线性回归模型。

SPSS提供了简单易用的界面,我们只需要选择因变量和自变量,然后点击进行回归分析。

在SPSS中,我们可以选择不同的回归方法,如逐步回归、前向回归、后向回归等。

6. 回归结果解读在进行多元线性回归分析后,SPSS将提供详细的回归结果。

我们可以看到每个自变量的系数、标准误差、t值、显著性水平等指标。

系数表示自变量与因变量之间的关系程度,标准误差表示估计系数的不确定性,t值表示系数的显著性,显著性水平则表示系数是否显著。

用SPSS做回归分析回归分析是一种统计方法,用于研究两个或多个变量之间的关系,并预测一个或多个因变量如何随着一个或多个自变量的变化而变化。

SPSS(统计软件包的统计产品与服务)是一种流行的统计分析软件,广泛应用于研究、教育和业务领域。

要进行回归分析,首先需要确定研究中的因变量和自变量。

因变量是被研究者感兴趣的目标变量,而自变量是可能影响因变量的变量。

例如,在研究投资回报率时,投资回报率可能是因变量,而投资额、行业类型和利率可能是自变量。

在SPSS中进行回归分析的步骤如下:1.打开SPSS软件,并导入数据:首先打开SPSS软件,然后点击“打开文件”按钮导入数据文件。

确保数据文件包含因变量和自变量的值。

2.选择回归分析方法:在SPSS中,有多种类型的回归分析可供选择。

最常见的是简单线性回归和多元回归。

简单线性回归适用于只有一个自变量的情况,而多元回归适用于有多个自变量的情况。

3.设置因变量和自变量:SPSS中的回归分析工具要求用户指定因变量和自变量。

选择适当的变量,并将其移动到正确的框中。

4.运行回归分析:点击“运行”按钮开始进行回归分析。

SPSS将计算适当的统计结果,包括回归方程、相关系数、误差项等。

这些结果可以帮助解释自变量如何影响因变量。

5.解释结果:在完成回归分析后,需要解释得到的统计结果。

回归方程表示因变量与自变量之间的关系。

相关系数表示自变量和因变量之间的相关性。

误差项表示回归方程无法解释的变异。

6.进行模型诊断:完成回归分析后,还应进行模型诊断。

模型诊断包括检查模型的假设、残差的正态性、残差的方差齐性等。

SPSS提供了多种图形和统计工具,可用于评估回归模型的质量。

回归分析是一种强大的统计分析方法,可用于解释变量之间的关系,并预测因变量的值。

SPSS作为一种广泛使用的统计软件,可用于执行回归分析,并提供了丰富的功能和工具,可帮助研究者更好地理解和解释数据。

通过了解回归分析的步骤和SPSS的基本操作,可以更好地利用这种方法来分析数据。

SPSS回归分析报告1. 引言本报告旨在使用SPSS软件进行回归分析,并对分析结果进行解释和总结。

回归分析是一种用于探索自变量与因变量之间关系的统计方法。

通过对相关变量的分析,我们可以了解自变量对因变量的影响程度和方向。

2. 数据描述我们使用的数据集包含了X和Y两个变量的观测值。

X代表自变量,Y代表因变量。

数据集总共包含了N个观测值。

3. 数据处理在进行回归分析之前,我们需要对数据进行处理,包括数据清洗和变量转换。

数据清洗的目的是去除异常值和缺失值,确保数据的质量和完整性。

变量转换可以根据需要对变量进行归一化、对数化等操作,以满足回归分析的前提条件。

4. 模型建立我们选择了线性回归模型来研究自变量X对因变量Y的影响。

线性回归模型的表达式如下:Y = β0 + β1*X + ε其中,Y代表因变量,X代表自变量,β0和β1是回归系数,ε是误差项。

我们希望通过对数据进行回归分析,得到最佳的回归系数估计值。

5. 回归结果经过回归分析,我们得到了以下结果:回归方程:Y = a + b*X回归系数a的估计值为x,回归系数b的估计值为y。

回归方程可以用来预测因变量Y在给定自变量X的情况下的取值。

6. 模型评估为了评估我们建立的回归模型的拟合程度,我们使用了一些统计指标。

其中,R方(R^2)是衡量模型拟合优度的指标,它的取值范围在0到1之间,越接近1说明模型的拟合度越好。

我们得到的R方为r。

另外,我们还计算了回归系数的显著性检验。

显著性检验可以帮助我们判断回归系数是否具有统计学意义。

我们得到的显著性水平为p。

通过对这些统计指标的分析,我们可以评估回归模型的有效性和可靠性。

7. 结论通过SPSS软件进行回归分析,我们得到了自变量X对因变量Y的影响程度和方向。

根据我们的回归方程和回归系数,我们可以预测因变量Y在给定自变量X 的情况下的取值。

然而,需要注意的是,回归分析只能显示自变量和因变量之间的关系,并不能确定因果关系。