概率论与数理统计(随机变量的相互独立性)

- 格式:ppt

- 大小:422.00 KB

- 文档页数:18

随机变量独立性判断随机变量的独立性和相关性随机变量的独立性和相关性是概率论和数理统计中的重要概念。

在实际问题中,我们经常需要判断随机变量之间是否相互独立或者相关。

本文将介绍如何判断随机变量的独立性和相关性。

一、什么是随机变量的独立性和相关性随机变量的独立性和相关性描述了随机变量之间的关系。

独立性:若两个随机变量X和Y的联合分布等于各自的边缘分布之积,即P(X=x, Y=y) = P(X=x)P(Y=y),则称X和Y独立。

相关性:若两个随机变量X和Y之间存在某种依赖关系,即它们的联合分布和边缘分布不相等,称X和Y相关。

二、判断随机变量的独立性和相关性的方法1. 统计方法利用样本数据进行统计分析,可以判断随机变量的独立性和相关性。

对于两个随机变量X和Y,如果它们的样本相关系数接近于0,可以认为X和Y近似独立;如果样本相关系数接近于1或-1,可以认为X和Y相关。

2. 图形方法通过绘制散点图可以直观地观察随机变量的相关性。

对于两个随机变量X和Y,如果它们的散点图呈现出线性关系,则可以认为X和Y相关;如果散点图呈现出无规律的分布,则可以认为X和Y近似独立。

3. 利用协方差和相关系数判断协方差和相关系数是判断随机变量相关性的重要指标。

协方差衡量了两个随机变量之间的线性相关性,若协方差为0,则可以认为两个随机变量不相关。

相关系数除了衡量两个随机变量的线性相关性,还可以衡量非线性相关性,相关系数的范围在-1至1之间,绝对值越接近1表示相关性越强,绝对值越接近0表示独立性越强。

三、应用举例1. 抛硬币问题假设一次抛硬币,X表示正面次数,Y表示反面次数。

在这个例子中,X和Y的取值只能是0或1,它们的联合分布如下:P(X=0, Y=0) = 1/2P(X=1, Y=0) = 1/2P(X=0, Y=1) = 1/2P(X=1, Y=1) = 1/2可以看出,X和Y的联合分布等于各自的边缘分布之积,即P(X=x, Y=y) = P(X=x)P(Y=y),因此X和Y是独立的。

随机变量的独立性和相关性随机变量是概率论和数理统计中的重要概念,用于描述随机事件和随机现象的数值特征。

研究随机变量之间的关系对于深入理解概率和统计学的基本原理至关重要。

在这篇文章中,我们将探讨随机变量的独立性和相关性。

一、独立性独立性是指两个或多个随机变量之间的关系,即一个随机变量的取值对另一个随机变量的取值没有任何影响。

如果两个随机变量X和Y 是独立的,那么它们满足以下条件:P(X=x, Y=y) = P(X=x) * P(Y=y)其中P(X=x, Y=y)表示X等于x,Y等于y的概率,P(X=x)和P(Y=y)分别表示X等于x的概率和Y等于y的概率。

换句话说,当两个随机变量独立时,它们的联合概率等于各自的边缘概率的乘积。

独立性的意义在于可以简化概率计算。

如果X和Y是独立的,那么我们可以通过独立事件的性质计算它们的联合概率。

此外,独立性还可以应用于贝叶斯定理、条件概率和协方差等相关概念的推导与计算。

二、相关性相关性是指两个随机变量之间存在某种程度的关联或依赖关系。

如果两个随机变量X和Y相关,那么它们的取值是彼此依赖的,即当X的取值发生变化时,Y的取值也会随之变化。

在统计学中,相关性通过协方差和相关系数来度量。

协方差描述了两个随机变量之间的总体关系,定义为:cov(X,Y) = E[(X - E(X))(Y - E(Y))]其中cov(X,Y)表示X和Y的协方差,E(X)和E(Y)分别表示X和Y的期望(均值)。

协方差的数值可以为负、零或正,分别表示负相关、无相关或正相关。

相关系数是协方差的标准化形式,用于度量两个随机变量之间的线性相关程度。

相关系数的取值范围在-1和1之间,越接近-1或1表示相关性越强,越接近0表示相关性越弱或不存在。

三、独立性与相关性的区别独立性和相关性是两个不同的概念。

独立性是指两个或多个随机变量之间的独立关系,即一个变量的取值对另一个变量的取值没有影响。

相关性是指两个随机变量之间存在某种关联或依赖关系,即一个变量的取值会随着另一个变量的取值而变化。

概率论与数理统计的独立性与条件概率研究概率论与数理统计是数学中的重要分支,它们的研究对象是随机事件和随机变量,通过对事件和变量的概率分布进行研究,可以揭示出事件和变量之间的规律。

在概率论与数理统计的研究中,独立性和条件概率是两个重要的概念。

首先,我们来探讨概率论与数理统计中的独立性。

独立性是指两个或多个事件之间的发生与否不相互影响。

在概率论中,如果事件A和事件B是独立的,那么它们的联合概率等于各自概率的乘积。

换句话说,P(A∩B) = P(A) * P(B)。

这个公式可以用来计算两个独立事件同时发生的概率。

独立性在实际生活中有很多应用。

例如,假设有一批产品,每个产品的质量是否合格是一个独立事件。

如果每个产品合格的概率是0.9,那么同时有两个产品合格的概率就是0.9 * 0.9 = 0.81。

这个概率可以帮助我们评估产品质量的可靠性。

然而,并不是所有的事件都是独立的。

有些事件之间存在一定的关联关系,这就引出了条件概率的概念。

条件概率是指在已知某一事件发生的条件下,另一事件发生的概率。

在概率论与数理统计中,条件概率可以用来计算事件之间的依赖关系。

条件概率的计算方法是通过已知条件来确定事件发生的概率。

假设事件A和事件B之间存在依赖关系,那么在已知事件B发生的条件下,事件A发生的概率可以表示为P(A|B)。

根据概率的定义,P(A|B) = P(A∩B) / P(B)。

这个公式可以用来计算在已知事件B发生的情况下,事件A同时发生的概率。

条件概率在实际中也有广泛的应用。

例如,在医学诊断中,医生需要根据病人的症状和检查结果来判断病人是否患有某种疾病。

这时,医生会根据已知的症状和检查结果计算疾病的概率,以帮助做出正确的诊断。

除了独立性和条件概率,概率论与数理统计还包括其他重要的概念和方法,如随机变量、概率分布、期望值等等。

这些概念和方法在现代科学和工程领域中有广泛的应用。

例如,在金融领域中,概率论与数理统计可以用来对股票价格的波动进行建模和预测,以帮助投资者做出决策。

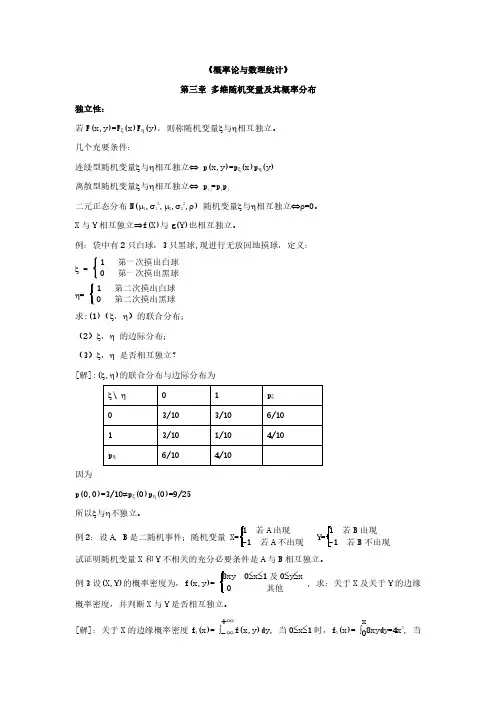

随机变量的独立性与相关性随机变量的独立性与相关性是概率论和数理统计中重要的概念。

独立性是指两个或多个随机变量的取值之间没有相互影响的关系,而相关性则描述了随机变量之间的线性关系程度。

本文将分别介绍随机变量的独立性和相关性的定义、性质以及其在实际问题中的应用。

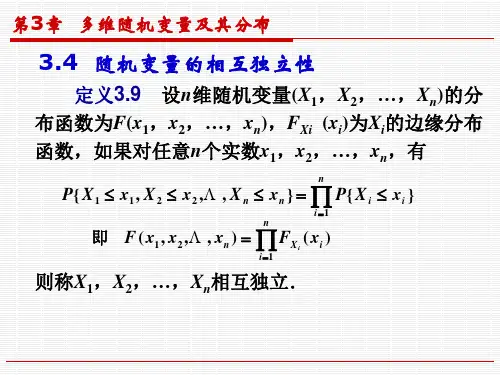

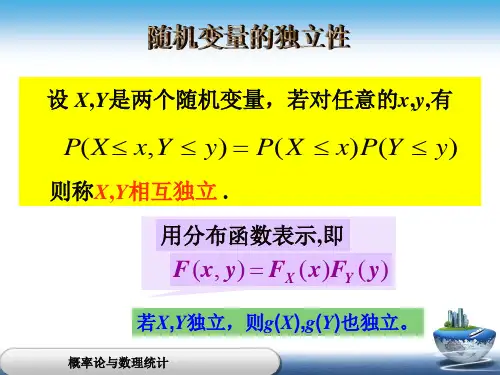

一、随机变量的独立性在概率论中,独立性是指两个或多个随机变量在任意条件下都是互相独立的。

具体而言,对于随机变量X和Y,如果对于任意的实数a 和b,满足以下等式:P(X ≤ a, Y ≤ b) = P(X ≤ a) · P(Y ≤ b),则称X和Y是独立的。

其中,P(X ≤ a, Y ≤ b)表示事件{X ≤ a}和{Y ≤ b}同时发生的概率。

独立性是一种极为重要的性质,它使得概率计算更加简化。

在实际问题中,我们可以利用独立性假设来简化分析,提高计算的效率。

例如,在投掷硬币的实验中,每一次投掷的结果都是独立的,因此可以通过简单的概率计算来确定投掷n次后获得正面朝上的次数。

二、随机变量的相关性相关性是指随机变量之间的线性关系程度。

对于两个随机变量X和Y,其相关性可以通过协方差或相关系数来衡量。

1. 协方差随机变量X和Y的协方差定义为:Cov(X, Y) = E[(X - E(X))(Y - E(Y))],其中,E(X)和E(Y)分别表示X和Y的期望值。

协方差可以看作是X与Y共同变动的程度。

如果Cov(X, Y) = 0,则称X和Y是不相关的。

如果Cov(X, Y) > 0,则X和Y是正相关的;如果Cov(X, Y) < 0,则X和Y是负相关的。

2. 相关系数相关系数是协方差的归一化形式,可以消除量纲的影响。

随机变量X和Y的相关系数定义为:ρ(X, Y) = Cov(X, Y) / (σ(X)σ(Y)),其中,σ(X)和σ(Y)分别表示X和Y的标准差。

相关系数的取值范围在-1到1之间,且满足如下性质:若ρ(X, Y) = 0,则X和Y不相关;若ρ(X, Y) > 0,则X和Y正相关;若ρ(X, Y) < 0,则X和Y负相关。

随机变量的独立性与相关性随机变量是概率论中的重要概念,它描述了不确定性事件的数值特征。

在概率论和数理统计等领域中,我们常常需要研究随机变量之间是否存在独立性或相关性。

本文将探讨随机变量的独立性和相关性的概念、性质以及在实际问题中的应用。

一、独立性的概念与性质在概率论中,独立性是指两个或多个随机变量的取值之间相互独立的性质。

具体来说,对于两个随机变量X和Y,若它们的联合分布等于它们的边缘分布的乘积,则称X和Y是独立的。

即,若对于任意的x和y,有P(X=x,Y=y)=P(X=x)P(Y=y),则称X和Y是独立的。

独立性有以下性质:1. 若X和Y是独立的,则其数学期望的乘积等于数学期望的乘积的条件期望,即E(XY)=E(X)E(Y);2. 若X和Y是独立的,则其方差的和等于方差的和,即Var(X+Y)=Var(X)+Var(Y);3. 若X和Y是独立的,则其协方差等于零,即Cov(X,Y)=0。

二、相关性的概念与性质相关性是指两个随机变量之间的线性关系程度的度量。

具体来说,对于随机变量X和Y,它们的相关性可以通过协方差来衡量。

协方差Cov(X,Y)反映了X和Y的变动方向是否一致,其具体定义为Cov(X,Y)=E[(X-E(X))(Y-E(Y))]。

相关性有以下性质:1. 相关性的取值范围为[-1, 1],当相关性为1时,表示X和Y之间存在完全正相关关系,当相关性为-1时,表示X和Y之间存在完全负相关关系,当相关性为0时,表示X和Y之间不存在线性关系;2. 相关性不具有传递性,即若X与Y相关,Y与Z相关,不能得出X与Z相关的结论;3. 对于函数变换,相关性具有保持不变的性质,即如果X和Y相关,则g(X)和h(Y)也相关,其中g和h为任意函数。

三、独立性与相关性的区别与联系独立性和相关性都是描述随机变量之间关系的概念,但两者有本质的区别。

独立性是一种较强的关系,表示两个随机变量之间的完全独立,不受彼此影响。

概率论与数理统计 一 、名词解释1、样本空间:随机试验E 的所有可能结果组成的集合,称为E 的样本空间。

2、随机事件:试验E 的样本空间S 的子集,称为E 的随机事件。

3、必然事件:在每次试验中总是发生的事件。

4、不可能事件:在每次试验中都不会发生的事件。

5、概率加法定理:P(A ∪B)=P(A)+P(B)-P(AB)6、概率乘法定理:P(AB)=P(A)P(B │A)7、随机事件的相互独立性:若P(AB)=P(A)P(B)则事件A,B 是相互独立的。

8、实际推断原理:概率很小的事件在一次试验中几乎是不会发生的。

9、条件概率:设A ,B 是两个事件,且P(A)>0,称P(B │A)=()()A P AB P 为在事件A 发生的条件下事件B 发生的条件概率。

10、全概率公式: P(A)=())/(1B B i A P ni i P ∑=11、贝叶斯公式: P(Bi │A)= ()()∑=⎪⎭⎫⎝⎛⎪⎭⎫⎝⎛n i j A P j P i A P i P B B B B 112、随机变量:设E 是随机试验,它的样本空间是S=﹛e ﹜。

如果对于每一个e ∈S,有一个实数X(e)与之对应,就得到一个定义的S 上的单值实值函数X=X(e),称为随机变量。

13、分布函数:设X 是一个随机变量,χ是任意实数,函数F(χ)=P(X ≤χ)称为X 的分布函数。

14、随机变量的相互独立性:设(χ,у)是二维随机变量 ,如果对于任意实数χ,у,有F(χ,у)=F x (χ)〃F y (у)或 f (χ,у)= f x (χ)〃f y (у)成立。

则称为X 与Y 相互独立。

15、方差:E ﹛〔X-E(χ)〕2〕16、数学期望: E(χ)=()dxx xf ⎰∞-+∞(或)=i p i i x ∑+∞=117、简单随机样本:设X是具有分布函数F 的随机变量,若χ1 , χ2 … , χn 是具有同一分布函数F 的相互独立的随机变量,则称χ1 , χ2 … , χn 为从总体X 得到的容量为n 的简单随机样本。