随机变量相互独立的定义

- 格式:ppt

- 大小:509.00 KB

- 文档页数:27

随机变量的独立性及联合分布的定义及计算方法随机变量是统计学中一个重要的概念,指的是随机试验中可能取到的数值。

对于多个随机变量之间的关系,独立性和联合分布是常用的概念和方法。

本文将依次介绍随机变量独立性的定义和判定方法、随机变量的联合分布的定义和常见计算方法。

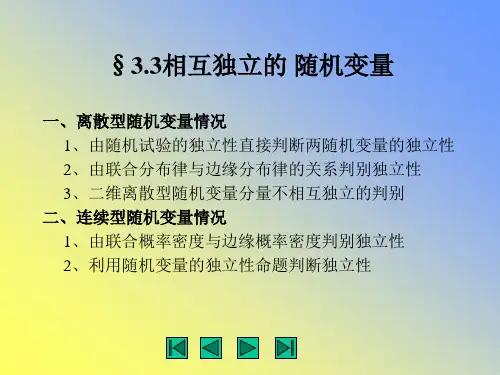

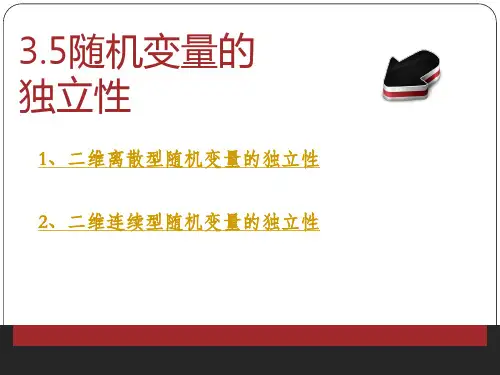

一、随机变量的独立性随机变量的独立性是指在给定条件下,多个随机变量之间不存在相关性,即一个随机变量的取值不会对其他随机变量的取值产生影响。

常用的判定方法包括:1. 互不影响如果两个随机变量之间互不影响,则这两个变量是独立的。

例如,投掷两个骰子,其中一个骰子的点数不会影响另一个骰子的点数,因此两个骰子的点数是独立的随机变量。

2. 相互独立如果多个随机变量之间的任意两个变量都是独立的,则这些随机变量是相互独立的。

例如,投掷三个骰子,每个骰子的点数都是独立的随机变量,因此三个骰子的点数是相互独立的随机变量。

3. 独立性定义下的概率乘法公式对于两个独立的随机变量X和Y,它们同时取到某个值的概率等于它们各自取到这个值的概率的乘积。

即P(X=x,Y=y)=P(X=x)P(Y=y)。

该公式也适用于多个独立的随机变量。

二、随机变量的联合分布多个随机变量的联合分布是指这些随机变量取值组合所对应的概率分布函数。

常用的计算方法包括:1. 联合分布函数对于两个随机变量X和Y,它们的联合分布函数定义为F(x,y)=P(X<=x,Y<=y)。

该函数可以用来计算任意两个随机变量的联合分布。

对于多个随机变量,联合分布函数的定义相应地拓展。

2. 联合概率密度函数对于连续型随机变量,它们的联合概率密度函数可以通过对应的联合分布函数求导得到。

即f(x,y)=∂^2 F(x,y)/∂x∂y。

该函数可以用来计算任意两个连续型随机变量的联合分布。

对于多个连续型随机变量,联合概率密度函数的定义相应地拓展。

3. 边缘分布和条件分布对于联合分布中的任意一个随机变量,我们都可以将它的概率分布函数单独计算出来,称为边缘分布。

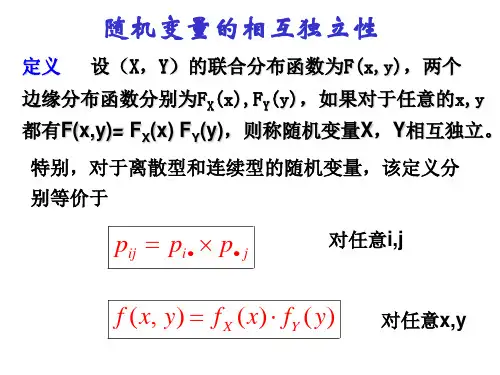

证明随机变量相互独立要证明随机变量相互独立,可以通过验证它们的联合分布函数和边缘分布函数,或者联合概率密度和边缘概率密度之间的关系来进行判断。

以下是证明随机变量X和Y相互独立的一般步骤:1. 定义独立性:如果两个随机变量X和Y满足对于所有可能的事件A和B,它们的联合概率等于各自概率的乘积,即P(A∩B) = P(A)P(B),那么称X和Y是相互独立的。

2. 使用分布函数:对于连续型随机变量,如果X和Y相互独立,则它们的联合分布函数F(x, y)等于边缘分布函数的乘积,即F(x, y) = F_X(x) * F_Y(y)。

类似地,对于离散型随机变量,它们的联合概率质量函数等于边缘概率质量函数的乘积。

3. 使用概率密度函数:对于具有概率密度函数的随机变量,如果X和Y相互独立,则它们的联合概率密度函数f(x, y)等于边缘概率密度函数的乘积,即f(x, y) = f_X(x) * f_Y(y)。

4. 检验条件独立性:随机变量X和Y相互独立还意味着给定任何其他随机变量Z的条件下,X和Y仍然是独立的。

这可以用条件概率来表示,即P(X|Z)和P(Y|Z)的乘积应该等于P(X, Y|Z)。

5. 数学期望的性质:如果X和Y相互独立,那么它们的乘积的期望值等于各自期望值的乘积,即E(XY) = E(X)E(Y)。

这是独立性的一个结果,但不能用来作为独立性的判定标准,因为不线性相关并不意味着独立。

6. 实证检验:在实际应用中,可以通过收集数据并计算这些概率或期望值来检验随机变量是否独立。

如果实证数据与独立性的定义相符合,则可以认为它们是独立的。

7. 理论推导:在某些情况下,可以通过理论推导来证明独立性。

例如,如果已知随机变量是由某些独立的实验或过程生成的,那么这些随机变量可能是独立的。

8. 测度论方法:在更高级的数学框架下,如测度论,可以使用σ-代数和概率测度的概念来定义和证明独立性。

这通常涉及到对事件集合的操作和概率的公理化定义。

xy相互独立的条件(随机变量之间)相互独立:两个随机变量 x 和 y ,如果它们的概率分布可以表示成两个因子的乘积形式,并且一个因子只包含 x 另一个因子只包含 y ,我们就称这两个随机变量是相互独立的。

设 A A A, B B B 是两事件,如果满足等式 P ( A B ) = P ( A ) P ( B ) P(AB) = P(A)P(B) P(AB)=P(A)P(B)则称事件A A A,B B B 相互独立。

(随机变量之间)条件独立: 如果关于 x 和 y 的条件概率分布对于 z 的每一个值都可以写成乘积的形式,那么这两个随机变量 x 和 y 在给定随机变量 z 时是条件独立的.设 A , B , C A,B,C A,B,C 是三事件,如果满足等式P ( A B ∣ C ) = P ( A ∣ C ) P ( B ∣ C ) P(AB|C) =P(A|C)P(B|C) P(AB∣C)=P(A∣C)P(B∣C)则称事件 A A A, B B B 满足 C C C 条件下的相互独立。

协方差在某种意义上给出了两个变量线性相关性的强度以及这些变量的尺度: C o v ( X , Y ) = E { [ X − E ( X ) ] [ Y − E ( Y ) ] } Cov(X, Y) = E\{[X-E(X)][Y-E(Y)]\} Cov(X,Y)=E{[X−E(X)][Y−E(Y)]}相关系数将每个变量的贡献归一化,为了只衡量变量的相关性而不受各个变量尺度大小的影响。

ρ X , Y = C o v ( X , Y ) D ( X ) D ( Y )\rho_{X,Y}=\frac{Cov(X,Y)}{\sqrt{D(X)}\sqrt{D(Y)}}ρX,Y=D(X)D(Y)Cov(X,Y)若相关系数ρ x y = 0 ρ_{xy} = 0 ρxy=0,则称随机变量X 与 Y 不相关。

相关性描述的是线性相关关系。