回归分析概要(多元线性回归模型)

- 格式:doc

- 大小:157.00 KB

- 文档页数:5

第四章 多元线性回归模型在一元线性回归模型中,解释变量只有一个。

但在实际问题中,影响因变量的变量可能不止一个,比如根据经济学理论,人们对某种商品的需求不仅受该商品市场价格的影响,而且受其它商品价格以及人们可支配收入水平的制约;影响劳动力劳动供给意愿(用劳动参与率度量)的因素不仅包括经济形势(用失业率度量),而且包括劳动实际工资;根据凯恩斯的流动性偏好理论,影响人们货币需求的因素不仅包括人们的收入水平,而且包括利率水平等。

当解释变量的个数由一个扩展到两个或两个以上时,一元线性回归模型就扩展为多元线性回归模型。

本章在理论分析中以二元线性回归模型为例进行。

一、预备知识(一)相关概念对于一个三变量总体,若由基础理论,变量21,x x 和变量y 之间存在因果关系,或21,x x 的变异可用来解释y 的变异。

为检验变量21,x x 和变量y 之间因果关系是否存在、度量变量21,x x 对变量y 影响的强弱与显著性、以及利用解释变量21,x x 去预测因变量y ,引入多元回归分析这一工具。

将给定i i x x 21,条件下i y 的均值i i i i i x x x x y E 2211021),|(βββ++= (4.1) 定义为总体回归函数(Population Regression Function,PRF )。

定义),|(21i i i i x x y E y -为误差项(error term ),记为i μ,即),|(21i i i i i x x y E y -=μ,这样i i i i i x x y E y μ+=),|(21,或i i i i x x y μβββ+++=22110 (4.2)(4.2)式称为总体回归模型或者随机总体回归函数。

其中,21,x x 称为解释变量(explanatory variable )或自变量(independent variable );y 称为被解释变量(explained variable )或因变量(dependent variable );误差项μ解释了因变量的变动中不能完全被自变量所解释的部分。

多元线性回归模型的估计与解释多元线性回归是一种广泛应用于统计学和机器学习领域的预测模型。

与简单线性回归模型相比,多元线性回归模型允许我们将多个自变量引入到模型中,以更准确地解释因变量的变化。

一、多元线性回归模型的基本原理多元线性回归模型的基本原理是建立一个包含多个自变量的线性方程,通过对样本数据进行参数估计,求解出各个自变量的系数,从而得到一个可以预测因变量的模型。

其数学表达形式为:Y = β0 + β1X1 + β2X2 + ... + βnXn + ε其中,Y为因变量,X1、X2、...、Xn为自变量,β0、β1、β2、...、βn为模型的系数,ε为误差项。

二、多元线性回归模型的估计方法1. 最小二乘法估计最小二乘法是最常用的多元线性回归模型估计方法。

它通过使残差平方和最小化来确定模型的系数。

残差即观测值与预测值之间的差异,最小二乘法通过找到使残差平方和最小的系数组合来拟合数据。

2. 矩阵求解方法多元线性回归模型也可以通过矩阵求解方法进行参数估计。

将自变量和因变量分别构成矩阵,利用矩阵运算,可以直接求解出模型的系数。

三、多元线性回归模型的解释多元线性回归模型可以通过系数估计来解释自变量与因变量之间的关系。

系数的符号表示了自变量对因变量的影响方向,而系数的大小则表示了自变量对因变量的影响程度。

此外,多元线性回归模型还可以通过假设检验来验证模型的显著性。

假设检验包括对模型整体的显著性检验和对各个自变量的显著性检验。

对于整体的显著性检验,一般采用F检验或R方检验。

F检验通过比较回归平方和和残差平方和的比值来判断模型是否显著。

对于各个自变量的显著性检验,一般采用t检验,通过检验系数的置信区间与预先设定的显著性水平进行比较,来判断自变量的系数是否显著不为零。

通过解释模型的系数和做假设检验,我们可以对多元线性回归模型进行全面的解释和评估。

四、多元线性回归模型的应用多元线性回归模型在实际应用中具有广泛的应用价值。

第二章多元线性回归§2.1 基本概述一、回归的任务多元线性回归(MLR)(multiple linear regression)是分析一个随机变量与多个变量之间线性关系的统计方法。

回归(Regression)起源于19世纪生物学家F·高尔顿进行的遗传学研究。

其核心是“普通最小平方法”(Ordinary Least Squares)OLS。

多元回归将所研究的变量分为:确定自变量和因变量的关系是回归分析的主要任务:(1)根据实测数据求解某一模型的各个参数;(2)评价回归模型是否较好地拟合实例数据;(3)利用模型进行预测。

需要注意的是:(1) 因变量必须是间距测度等级以上的变量(有时也包含定性变量。

见《应用回归分析》)(也称为连续变量)。

自变量可以是任意等级的变量。

(2)既使模型正确通过检验,也不能确定X、Y之间的因果关系,而只能确认存在着统计关系。

[例] 不同地区的人均食品支出与人均收入的关系(图2–1);汽车重量与每加仑燃料行驶英里值的关系;(图2–2)。

图2–1图2–2二、一元线性回归的回顾1. 模型i i i x Y εββ++=10 (2.1)当获得n 组样本观测值(x 1 , y 1),(x 2 , y 2),…(x n ,y n )的数据时,如果符合2.1式,则有n i X Y iii,,2,11=++=εββ (2.2)2.1式称为理论回归模型;2.2式称为样本回归模型。

有时不加以区分地将两者称为一元线性回归模型。

通过n 组观测值,用OLS 法对10,ββ进行估计,得10ˆ,ˆββ,则称为Y 关于X 的一元线性方程。

其中: 1β 回归系数,说明X 与Y 之间的变化关系。

2.普通最小二乘法估计的统计性质(OLSE Estimation ) (1)残差:ii iY Y e ˆ-=,用来说明拟合效果,可以看作误差项εi 的估计值。

⎪⎩⎪⎨⎧==∑∑00ii i e x e 因为 )(ˆˆX X Y Y-+=β,所以 0)(ˆ)()ˆ(=---=-=∑∑∑∑X X Y Y Y Y e β 但∑=ni i e 1||很麻烦,经常用∑2i e 来说明。

(完整版)多元线性回归模型原理研究在线性关系相关性条件下,两个或者两个以上自变量对一个因变量,为多元线性回归分析,表现这一数量关系的数学公式,称为多元线性回归模型。

多元线性回归模型是一元线性回归模型的扩展,其基本原理与一元线性回归模型类似,只是在计算上为复杂需借助计算机来完成。

计算公式如下:设随机y 与一般变量12,,k x x x L 的线性回归模型为:01122k k y x x x ββββε=++++其中01,,k βββL 是1k +个未知参数,0β称为回归常数,1,k ββL 称为回归系数;y 称为被解释变量;12,,k x x x L 是k 个可以精确可控制的一般变量,称为解释变量。

当1p =时,上式即为一元线性回归模型,2k ≥时,上式就叫做多元形多元回归模型。

ε是随机误差,与一元线性回归一样,通常假设2()0var()E εεσ?=?=?同样,多元线性总体回归方程为01122k k y x x x ββββ=++++L 系数1β表示在其他自变量不变的情况下,自变量1x 变动到一个单位时引起的因变量y 的平均单位。

其他回归系数的含义相似,从集合意义上来说,多元回归是多维空间上的一个平面。

多元线性样本回归方程为:01122k ky x x x ββββ=++++L多元线性回归方程中回归系数的估计同样可以采用最小二乘法。

由残差平方和:()0SSE y y∑=-= 根据微积分中求极小值得原理,可知残差平方和SSE 存在极小值。

欲使SSE 达到最小,SSE 对01,,k βββL 的偏导数必须为零。

将SSE 对01,,k βββL 求偏导数,并令其等于零,加以整理后可得到1k +各方程式:?2()0i SSE y yβ?=--=?∑ 0?2()0i SSE y y x β?=--=?∑通过求解这一方程组便可分别得到01,,k βββL 的估计值0?β,1?β,···?kβ回归系数的估计值,当自变量个数较多时,计算十分复杂,必须依靠计算机独立完成。

多元线性回归分析多元线性回归分析是一种常用的统计方法,用于研究多个自变量与因变量之间的关系。

它可以帮助我们理解多个因素对于一个目标变量的影响程度,同时也可以用于预测和解释因变量的变化。

本文将介绍多元线性回归的原理、应用和解读结果的方法。

在多元线性回归分析中,我们假设因变量与自变量之间存在线性关系。

具体而言,我们假设因变量是自变量的线性组合,加上一个误差项。

通过最小二乘法可以求得最佳拟合直线,从而获得自变量对因变量的影响。

多元线性回归分析的第一步是建立模型。

我们需要选择一个合适的因变量和若干个自变量,从而构建一个多元线性回归模型。

在选择自变量时,我们可以通过领域知识、经验和统计方法来确定。

同时,我们还需要确保自变量之间没有高度相关性,以避免多重共线性问题。

建立好模型之后,我们需要对数据进行拟合,从而确定回归系数。

回归系数代表了自变量对因变量的影响大小和方向。

通过最小二乘法可以求得使残差平方和最小的回归系数。

拟合好模型之后,我们还需要进行模型检验,以评估模型拟合的好坏。

模型检验包括对回归方程的显著性检验和对模型的拟合程度进行评估。

回归方程的显著性检验可以通过F检验来完成,判断回归方程是否显著。

而对模型的拟合程度进行评估可以通过判断决定系数R-squared的大小来完成。

解读多元线性回归结果时,首先需要看回归方程的显著性检验结果。

如果回归方程显著,说明至少一个自变量对因变量的影响是显著的。

接下来,可以观察回归系数的符号和大小,从中判断自变量对因变量的影响方向和相对大小。

此外,还可以通过计算标准化回归系数来比较不同自变量对因变量的相对重要性。

标准化回归系数表示自变量单位变化对因变量的单位变化的影响程度,可用于比较不同变量的重要性。

另外,决定系数R-squared可以用来评估模型对观测数据的拟合程度。

R-squared的取值范围在0到1之间,越接近1说明模型对数据的拟合越好。

但需要注意的是,R-squared并不能反映因果关系和预测能力。

多元线性回归模型在市场的经济活动中,经常会遇到某一市场现象的发展和变化取决于几个影响因素的情况,也就是一个因变量和几个自变量有依存关系的情况。

而且有时几个影响因素主次难以区分,或者有的因素虽属次要,但也不能略去其作用。

例如,某一商品的销售量既与人口的增长变化有关,也与商品价格变化有关。

这时采用一元回归分析预测法进行预测是难以奏效的,需要采用多元回归分析预测法。

多元回归分析预测法是指通过对两个或两个以上的自变量与一个因变量的相关分析,建立预测模型进行预测的方法。

当自变量与因变量之间存在线性关系时,称为多元线性回归分析。

多元回归分析可以达到以下目的。

(1)了解因变量和自变量之间的关系是否存在,以及这种关系的强度。

也就是以自变量所解释的因变量的变异部分是否显著,且因变量变异中有多大部分可以由自变量来解释。

(2)估计回归方程,求在自变量已知的情况下因变量的理论值或预测值,以达到预测目的。

(3)评价特定自变量对因变量的贡献,也就是在控制其他自变量不变的情况下,该处变量的变化所导致的因变量变化情况。

(4)比较各处变量在拟合的回归方程中相对作用大小,寻找最重要的和比较重要的自变量。

假定被解释变量Y与多个解释变量x1,x2,…,x k之间具有线性关系,是解释变量的多元线性函数,称为多元线性回归模型,即:式中,Y为被解释变量;x j(j=1,2,…,k)为k个解释变量,β(j j=1,2,…,k)为k个未知参数,β0是常数项,β1,β2,…,βk是回归系数,β1是x2,x3,…,x k固定时,x1每增加一个单位对Y的效应,即x1对Y的偏回归系数,同理,β2是x2对Y的偏回归系数;μ为随机误差项。

被解释变量Y的期望值与解释变量x1,x2,…,x k的线性方程为:式(4.19)称为多元总体线性回归方程,简称总体回归方程。

对于n组观测值,其方程组形式为:多元线性回归模型包含多个解释变量,多个解释变量同时对被解释变量发生作用,若要考察其中一个解释变量对被解释变量的影响就必须假设其他解释变量保持不变来进行分析。

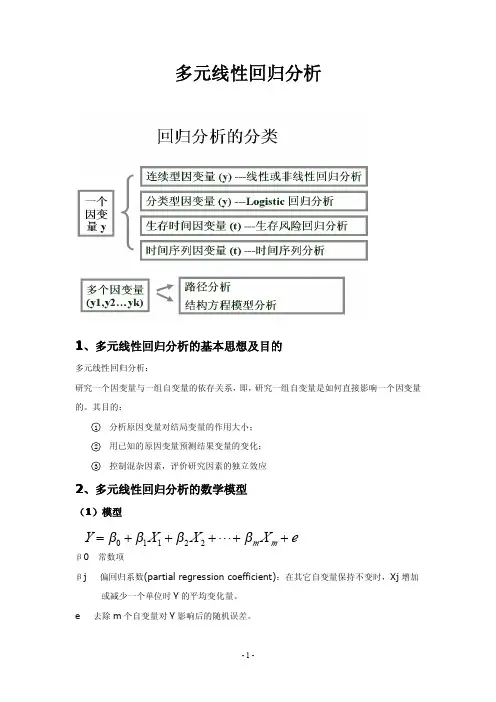

回归分析的模型SPSS概要回归分析是一种统计分析方法,用于研究因变量与一个或多个自变量之间的关系。

它可以用来预测因变量的值,解释因变量的变化,以及确定与因变量最相关的自变量。

SPSS(统计分析软件)是一款经典的统计分析软件,具有强大的数据处理和分析功能,能够进行多种回归分析。

在进行回归分析之前,需要明确确定因变量和自变量,以及数据的类型(连续型或分类型)。

常用的回归分析方法有简单线性回归、多元线性回归、逻辑回归等。

简单线性回归模型是最基本的回归模型,用于研究因变量与一个自变量之间的关系。

该模型假设因变量与自变量之间存在线性关系,可以通过一条直线来表示。

模型的方程可以写为:Y=β0+β1X+ε,其中Y为因变量,X为自变量,β0和β1为模型的参数,ε为误差项。

多元线性回归模型是用于研究因变量与多个自变量之间的关系。

该模型假设因变量与自变量之间存在线性关系,可以通过多个自变量的线性组合来表示。

模型的方程可以写为:Y=β0+β1X1+β2X2+...+βnXn+ε,其中Y为因变量,X1、X2、..、Xn为自变量,β0、β1、β2、..、βn为模型的参数,ε为误差项。

逻辑回归模型是用于研究因变量为二分类变量(如成功与失败、存在与不存在等)与一个或多个自变量之间的关系。

该模型假设因变量服从二项分布,并且通过logistic函数来建模。

模型的方程可以写为:log(p/(1-p)) = β0 + β1X1 + β2X2 + ... + βnXn,其中p为因变量为1的概率,X1、X2、..、Xn为自变量,β0、β1、β2、..、βn为模型的参数。

SPSS可以通过数据的输入和处理来进行回归分析。

首先,将数据导入SPSS软件中,然后选择适当的回归分析模型和方法,设置因变量和自变量,以及其他相关参数。

接下来,进行模型的拟合和参数的估计,得到回归方程和相应的统计结果。

最后,进行模型的诊断和解释,评估模型的拟合度和预测效果。

第二章 回归分析概要

第五节 多元线性回归分析

一 模型的建立与假定条件

在一元线性回归模型中,我们只讨论了包含一个解释变量的一元线性回归模型,也就是假定被解释变量只受一个因素的影响。

但是在现实生活中,一个被解释变量往往受到多个因素的影响。

例如,商品的消费需求,不但受商品本身的价格影响,还受到消费者的偏好、收入水平、替代品价格、互补品价格、对商品价格的预测以及消费者的数量等诸多因素的影响。

在分析这些问题的时候,仅利用一元线性回归模型已经不能够反映各变量间的真实关系,因此,需要借助多元线性回归模型来进行量化分析。

1. 多元线性回归模型的基本概念

如果一个被解释变量(因变量)t y 有k 个解释变量(自变量)tj x ,k j ,...,3,2,1=, 同时,t y 不仅是tk x 的线性函数,而且是参数0β和k i i ,...3,2,1=,β(通常未知)的线性函数,随即误差项为t u ,那么多元线性回归模型可以表示为:

,...22110t tk k t t t u x x x y +++++=ββββ ),..,2,1(n t =

这里tk k t t t x x x y E ββββ++++=...)(22110为总体多元线性回归方程,简称总体回归方程。

其中,k 表示解释变量个数,0β称为截距项,k βββ...21是总体回归系数。

k i i ,...3,2,1=,β表示在其他自变量保持不变的情况下,自变量tj X 变动一个单位所引起的因变量Y 平均变动的数量,因而也称之为偏回归系数。

当给定一个样本n t x x x y tk t t t ,...2,1),,...,,(21=时,上述模型可以表示为:

⎪⎪⎪⎭

⎪⎪⎪

⎬⎫⎪⎪⎪⎩⎪⎪⎪⎨⎧+++++=+++++=+++++=+++++=t tk k t t t k k k k k k u x x x y u x x x y u x x x y u x x x y ββββββββββββββββ (22110333223110322222211021112211101)

此时,t y 与tj x 已知,i β与t u 未知。

其相应的矩阵表达式为:

)1(321)1(210)

(1333122211111)1(321............1......1......1......1...⨯⨯⨯⨯⎪⎪⎪⎭⎪⎪⎪⎬⎫⎪⎪⎪⎩⎪⎪⎪⎨⎧+⎪⎪⎪⎭⎪⎪⎪⎬⎫⎪⎪⎪⎩⎪⎪⎪⎨⎧⎪⎪⎪⎭⎪⎪⎪⎬⎫⎪⎪⎪⎩

⎪⎪⎪⎨⎧=⎪⎪⎪⎭⎪⎪⎪⎬⎫⎪⎪⎪⎩⎪⎪⎪⎨⎧T T k k k T Tk Tj T k j k j k j T T u u u u x x x x x x x x x x x x y y y y ββββ

可以简化为: u X Y +=β--总体回归模型的简化形式。

2. 假定条件

与一元线性回归模型的基本假定相似,为保证得到最优估计量,多元线性回归模型应满足以下假定条件:

假定1 随机误差项t u 满足均值为零,其方差2

σ相同且为有限值。

假定2 随机误差项之间相互独立,无自相关。

假定3 解释变量tj x ,k j ,...,3,2,1=之间线性无关,即解释变量的样本观测值矩阵式满秩矩阵,否则称解释变量之间存在多重共线性(与课本假定7合并)。

假定4 解释变量tj x ,k j ,...,3,2,1=是确定性变量,与误差项彼此之间相互独立。

假定5 解释变量是非随机变量,且当Q X X T T →'

∞→-1

时,,Q 是一个有限值的非奇异矩阵。

假定6 随机误差项服从正态分布。

假定7 回归模型是正确设计的。

二、最小二乘法

根据最小二乘法的原则,总体回归模型可以推导为样本回归模型,即: u X Y ˆˆ+=β

其中,)ˆ...ˆˆ(ˆ10k

ββββ=是β的估计值列向量,)ˆ(ˆβX Y u -=称为残差列向量。

因为,βˆˆX Y u

-=,所以,u ˆ也是Y 的线性组合。

关于多元线性回归模型中样本容量的问题:

(1)最小样本容量

在多元线性回归模型中,样本容量必须不少于模型中解释变量的数目(包括常数项),这就是最小样本容量,即:1+≥k n 。

(2)满足基本要求的样本容量

一般经验认为,当30≥n 或者至少)1(3+≥k n 时,才能说满足模型估计的基本要求。

三、多元可决系数与调整后的多元可决系数

类似于一元线性回归模型的情形,我们对估计的回归方程关于样本观测值的拟合优度进行检验,而检验的统计量是可决系数。

因是多元回归,样本可决系数2R 就称为多元可决系数。

对于多元线性回归模型的情形,一元线性回归模型的总离差平方和的分解公式依然成立,即:

TSS= ESS +RSS

其中,TSS 的自由度为n-1,n 表示样本容量,

ESS 的自由度为k ,k 表示自变量的个数,

RSS 的自由度为n-k-1。

TSS

RSS TSS ESS R -==12 我们在模型应用中发现,如果在模型中增加一个解释变量,2R 往往会增大。

这是因为残差平方和往往随着解释变量个数的增加而减少,至少不会增加。

这就给人一个错觉:要使模型拟合得好,只要增加解释变量就可以了。

但是,现实情况往往是,由增加解释变量个数引起的2R 的增大与拟合好坏无关,因此,在多元线性回归模型之间比较拟合优度,2R 就不是一个合适的指标,必须加以调整。

在样本容量一定的情况下,增加解释变量必定使得自由度减少,所以调整的思路是将残差平方和与总离差平方和分别处以各自的自由度,以剔除变量个数对拟合优度的影响。

定义调整的多元可决系数 如下:

)1(1

11)1/()1/(122R k n n n TSS k n RSS R -----=----= 当模型中增加一个自变量,如果RSS/(n-k-1)变小,因而使2R 增大,便可认为这个自变

量对因变量有显著影响,应该放入模型中,否则,应予抛弃。

在样本容量一定的情况下,2

R 具有如下性质:

(1) 若;,122R R k ≤≥则

(2) 2R 可能出现负值。

如1.0,2,102===R k T 时,157.02-=R 。

显然,负的拟合优度没有任何意义,在此情况下,取02

=R 在实际中,2R 或2R 越大,模型拟合得就越好,但拟合优度不是评价模型优劣的唯一标准。

因此,我们不能仅根据2R 或2R 的大小来选择模型。

补充知识:赤池信息准则和施瓦茨信息准则

为了比较所含解释变量个数不同的多元线性回归模型的拟合优度,常用的标准还有赤池信息准则(Akaike Information Criterion ,AIC )和施瓦茨信息准则(Schwarz Criterion ,SC ),其定义分别为:

)()()1(2)(,,n In n

k n e e In SC n k n e e In AIC +=++= 这两个准则均要求仅当所增加的解释变量能够减少AIC 值或SC 值时才能在原模型中增加该解释变量。

显然,与调整的可决系数相仿,如果增加的解释变量没有解释能力,则对残

差平方和e ,e 的减小没有多大帮助,但增加了待估参数的个数,这时可能到时AIC 或SC 的

值增加。

四、统计检验

1. F 检验

为了从总体上检验模型中被解释变量与解释变量之间的线性关系是否显著成立,检验的原假设为:0...:210====k H βββ(k 表示方程中回归系数的个数,也可以称为自变量的个数)若成立,则模型中被解释变量与解释变量之间不存在显著的线性关系。

备择解释为:j H β:1不全为零。

若原假设成立,则检验统计量:

)

1/(/--=k n RSS k ESS F )1,(--k n k F 这是自由度为1,--k n k 的F 分布,对于预先给定的显著水平a ,可以从F 分布表中查出相应的自由度。

设检验水平为a ,则检验规则是:

若)1,(--≤k n k F F a ,接受原假设;

若)1,(--〉k n k F F a ,则接受备选假设。

F 与2

R 的关系: k k n R R F 1122--•-=, kF

k n n R +----=1112 由公式,可以看出,F 与2R 成正比,2

R 越大,F 值也越大。

即总体的F 检验越显著(F 值越大),2R 的值也越大,回归方程拟合得就越好,所以,F 检验可以看作是对拟合优度的

检验。

2.回归系数的显著性检验—t 检验

对于多元线性回归模型,总体回归方程线性关系的显著性,并不意味着每个解释变量对被解释变量的影响都是显著的。

因此,有必要通过检验把那些对被解释变量影响不显著的解释变量从模型中剔除,只保留对被解释变量影响显著的解释变量,以建立更为简单合理的多元线性回归模型。

如果一个解释变量tj x 对被解释变量的影响不显著,则对应于该解释变量的回归系数j β的值等于0。

因此,我们只要检验一个解释变量tj x 的回归系数j β的值是否为0就可以了。

检验原假设:k j H j ,...,2,1,0:0==β;

备择假设:0:1≠j H β 判别标准,若接受原假设),1(2--≤k n t t a ;若接受备择假设),1(2

--〉k n t t a 。