第九章 回归分析(一元线性回归)(1)汇总

- 格式:ppt

- 大小:3.42 MB

- 文档页数:99

回归分析法概念及原理一(一元线性回归)2009-12-14 14:27最近,在学一门统计学,有点意思。

问题一点一点出现,又一点一点被慢慢解决,慢慢消化~~做为初学者,搞不清的地方还真多。

今天刚好又看了有关相关分析和回归分析的学习资料,感觉不错,闲来与大家分享分享。

一、一元回归分析法,是在考虑预测对象发展变化本质基础上,分析因变量随一个自变量变化而变化的关联形态,借助回归分析建立它们因果关系的回归方程式,描述它们之间的平均变化数量关系,据此进行预测或控制。

1、基本原理假设预测目标因变量为Y,影响它变化的一个自变量为X,因变量随自变量的增(减)方向的变化。

一元线性回归分析就是要依据一定数量的观察样本(Xi,Yi)i=1,2…,n,找出回归直线方程Y=a+bX (1)对应于每一个Xi,根据回归直线方程可以计算出一个因变量估计值Yi。

回归方程估计值Yi 与实际观察值Yj之间的误差记作e-i=Yi-Yi。

显然,n个误差的总和越小,说明回归拟合的直线越能反映两变量间的平均变化线性关系。

据此,回归分析要使拟合所得直线的平均平方离差达到最小,简称最小二乘法将求出的a和b代入式(1)就得到回归直线Y-i =a+bXI 。

那么,只要给定Xi-值,就可以用作因变量Y i的预测值。

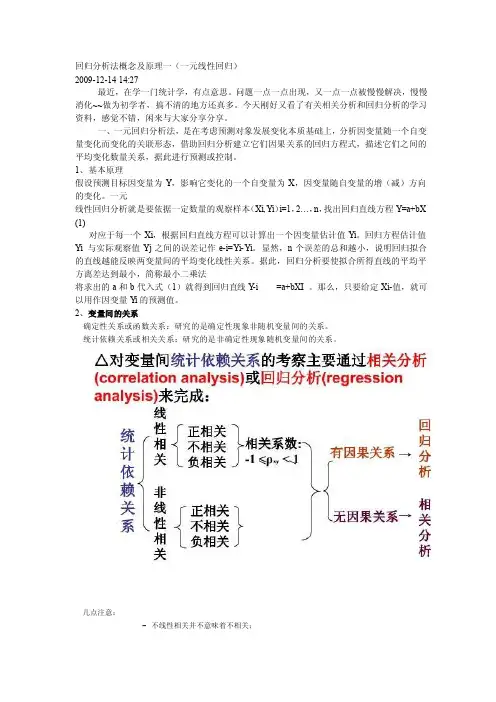

2、变量间的关系确定性关系或函数关系:研究的是确定性现象非随机变量间的关系。

统计依赖关系或相关关系:研究的是非确定性现象随机变量间的关系。

几点注意:–不线性相关并不意味着不相关;–有相关关系并不意味着一定有因果关系;–相关分析对称地对待任何(两个)变量,两个变量都被看作是随机的;回归分析对变量的处理方法存在不对称性,即区分因变量(被解释变量)和自变量(解释变量):前者是随机变量,后者不是。

总体回归函数:•给定解释变量X的某个确定值X i,与之统计相关的被解释变量Y的总体均值(期望值)可以表示为:上式说明了被解释变量Y平均地说随解释变量X变化的规律,一般称为总体回归函数或总体回归方程(population regression function,PRF);对应的曲线称为总体回归曲线(population regression curve),它可以是线性的或非线性的。

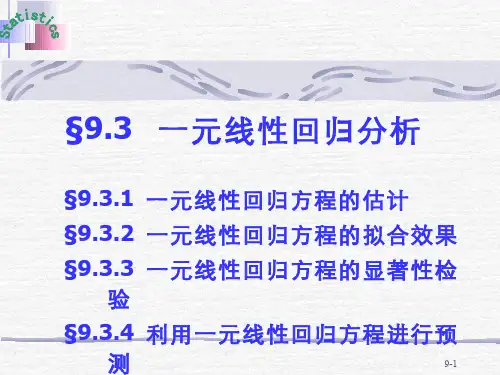

一元线性回归分析摘要:一元线性回归分析是一种常用的预测和建模技术,广泛应用于各个领域,如经济学、统计学、金融学等。

本文将详细介绍一元线性回归分析的基本概念、模型建立、参数估计和模型检验等方面内容,并通过一个具体的案例来说明如何应用一元线性回归分析进行数据分析和预测。

1. 引言1.1 背景一元线性回归分析是通过建立一个线性模型,来描述自变量和因变量之间的关系。

通过分析模型的拟合程度和参数估计值,我们可以了解自变量对因变量的影响,并进行预测和决策。

1.2 目的本文的目的是介绍一元线性回归分析的基本原理、建模过程和应用方法,帮助读者了解和应用这一常用的数据分析技术。

2. 一元线性回归模型2.1 模型表达式一元线性回归模型的基本形式为:Y = β0 + β1X + ε其中,Y是因变量,X是自变量,β0和β1是回归系数,ε是误差项。

2.2 模型假设一元线性回归模型的基本假设包括:- 线性关系假设:自变量X与因变量Y之间存在线性关系。

- 独立性假设:每个观测值之间相互独立。

- 正态性假设:误差项ε服从正态分布。

- 同方差性假设:每个自变量取值下的误差项具有相同的方差。

3. 一元线性回归分析步骤3.1 数据收集和整理在进行一元线性回归分析之前,需要收集相关的自变量和因变量数据,并对数据进行整理和清洗,以保证数据的准确性和可用性。

3.2 模型建立通过将数据代入一元线性回归模型的表达式,可以得到回归方程的具体形式。

根据实际需求和数据特点,选择适当的变量和函数形式,建立最优的回归模型。

3.3 参数估计利用最小二乘法或最大似然法等统计方法,估计回归模型中的参数。

通过最小化观测值与回归模型预测值之间的差异,找到最优的参数估计值。

3.4 模型检验通过对回归模型的拟合程度进行检验,评估模型的准确性和可靠性。

常用的检验方法包括:残差分析、显著性检验、回归系数的显著性检验等。

4. 一元线性回归分析实例为了更好地理解一元线性回归分析的应用,我们以房价和房屋面积之间的关系为例进行分析。