卡方检验模型验证方法

- 格式:doc

- 大小:50.00 KB

- 文档页数:2

特征选择:⽅差选择法、卡⽅检验、互信息法、递归特征消除、L1范数、树模型转载:特征选择主要从两个⽅⾯⼊⼿:特征是否发散:特征发散说明特征的⽅差⼤,能够根据取值的差异化度量⽬标信息.特征与⽬标相关性:优先选取与⽬标⾼度相关性的.对于特征选择,有时候我们需要考虑分类变量和连续变量的不同.1.过滤法:按照发散性或者相关性对各个特征进⾏评分,设定阈值或者待选择阈值的个数选择特征⽅差选择法:建议作为数值特征的筛选⽅法计算各个特征的⽅差,然后根据阈值,选择⽅差⼤于阈值的特征from sklearn.feature_selection import VarianceThresholdfrom sklearn.datasets import load_irisimport pandas as pdX,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))#建议作为数值特征的筛选⽅法,对于分类特征可以考虑每个类别的占⽐问题ts = 0.5vt = VarianceThreshold(threshold=ts)vt.fit(X_df)#查看各个特征的⽅差dict_variance = {}for i,j in zip(X_df.columns.values,vt.variances_):dict_variance[i] = j#获取保留了的特征的特征名ls = list()for i,j in dict_variance.items():if j >= ts:ls.append(i)X_new = pd.DataFrame(vt.fit_transform(X_df),columns=ls)卡⽅检验:建议作为分类问题的分类变量的筛选⽅法经典的卡⽅检验是检验定性⾃变量对定性因变量的相关性。

假设⾃变量有N种取值,因变量有M种取值,考虑⾃变量等于i且因变量等于j的样本频数的观察值与期望的差距,构建统计量:from sklearn.feature_selection import VarianceThreshold,SelectKBest,chi2from sklearn.datasets import load_irisimport pandas as pdX,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))(chi2,pval) = chi2(X_df,y)dict_feature = {}for i,j in zip(X_df.columns.values,chi2):dict_feature[i]=j#对字典按照values排序ls = sorted(dict_feature.items(),key=lambda item:item[1],reverse=True)#特征选取数量k =2ls_new_feature=[]for i in range(k):ls_new_feature.append(ls[i][0])X_new = X_df[ls_new_feature]互信息法:建议作为分类问题的分类变量的筛选⽅法经典的互信息也是评价定性⾃变量对定性因变量的相关性的,为了处理定量数据,最⼤信息系数法被提出,互信息计算公式如下:from sklearn.feature_selection import VarianceThreshold,SelectKBest,chi2from sklearn.datasets import load_irisimport pandas as pdfrom sklearn.feature_selection import mutual_info_classif#⽤于度量特征和离散⽬标的互信息X,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))feature_cat = ["A","D"]discrete_features = []feature = X_df.columns.values.tolist()for k in feature_cat:if k in feature:discrete_features.append(feature.index(k))mu = mutual_info_classif(X_df,y,discrete_features=discrete_features,n_neighbors=3, copy=True, random_state=None)dict_feature = {}for i,j in zip(X_df.columns.values,mu):dict_feature[i]=j#对字典按照values排序ls = sorted(dict_feature.items(),key=lambda item:item[1],reverse=True)#特征选取数量k =2ls_new_feature=[]for i in range(k):ls_new_feature.append(ls[i][0])X_new = X_df[ls_new_feature]from sklearn.feature_selection import VarianceThreshold,SelectKBest,chi2from sklearn.datasets import load_irisimport pandas as pdfrom sklearn.feature_selection import mutual_info_classif,mutual_info_regression#⽤于度量特征和连续⽬标的互信息X,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))feature_cat = ["A","D"]discrete_features = []feature = X_df.columns.values.tolist()for k in feature_cat:if k in feature:discrete_features.append(feature.index(k))mu = mutual_info_regression(X_df,y,discrete_features=discrete_features,n_neighbors=3, copy=True, random_state=None)dict_feature = {}for i,j in zip(X_df.columns.values,mu):dict_feature[i]=j#对字典按照values排序ls = sorted(dict_feature.items(),key=lambda item:item[1],reverse=True)#特征选取数量k =2ls_new_feature=[]for i in range(k):ls_new_feature.append(ls[i][0])X_new = X_df[ls_new_feature]2.包装法递归特征消除法:⽤⼀个基模型来进⾏多轮训练,每轮训练后,消除若⼲权值系数的特征,再基于新的特征集进⾏下⼀轮训练from sklearn.datasets import load_irisimport pandas as pdfrom sklearn.feature_selection import RFE,RFECVfrom sklearn.ensemble import RandomForestClassifierX,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))refCV = RFECV(estimator=RandomForestClassifier(),step=0.5,cv =5,scoring=None,n_jobs=-1)refCV.fit(X_df,y)#保留特征的数量refCV.n_features_#保留特征的False、True标记refCV.support_feature_new = X_df.columns.values[refCV.support_]#交叉验证分数refCV.grid_scores_3.嵌⼊的⽅法基于L1范数:使⽤带惩罚项的基模型,除了筛选出特征外,同时也进⾏了降维from sklearn.datasets import load_irisimport pandas as pdfrom sklearn.feature_selection import SelectFromModelfrom sklearn.linear_model import LogisticRegressionX,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))sf = SelectFromModel(estimator=LogisticRegression(penalty="l1", C=0.1),threshold=None,prefit=False,norm_order=1)sf.fit(X_df,y)X_new = X_df[X_df.columns.values[sf.get_support()]]基于树模型的特征选择法:树模型中GBDT也可⽤来作为基模型进⾏特征选择,使⽤feature_selection库的SelectFromModel类结合GBDT模型from sklearn.datasets import load_irisimport pandas as pdfrom sklearn.feature_selection import SelectFromModelfrom sklearn.ensemble import GradientBoostingClassifierX,y = load_iris(return_X_y=True)X_df = pd.DataFrame(X,columns=list("ABCD"))sf = SelectFromModel(estimator=GradientBoostingClassifier(),threshold=None,prefit=False,norm_order=1)sf.fit(X_df,y)X_new = X_df[X_df.columns.values[sf.get_support()]]。

卡方检验和精确概率法-概述说明以及解释1.引言1.1 概述卡方检验和精确概率法是统计学中常用的两种假设检验方法。

它们都是用于检验数据之间的相关性或者关联度,以判断某种因素与某种结果之间是否存在显著的统计关系。

卡方检验是一种非参数的假设检验方法,主要用于分析分类数据的关联性。

它通过统计观察值与期望值之间的差异,来决定变量之间是否存在显著性关系。

卡方检验可以处理多个分类变量之间的相关性问题,并且不受数据分布的限制。

在实际应用中,卡方检验经常用于医学研究、社会科学调研等领域,帮助研究者发现变量之间的关联性,从而进一步分析和解读数据。

精确概率法,又称为精确检验法,是一种基于排列组合原理的计算方法。

它主要用于处理小样本或者数据限制条件较多的情况下的假设检验问题。

与卡方检验不同的是,精确概率法通过枚举出所有可能的组合情况,计算出达到当前观察值或更极端情况下的事件发生概率,从而得出假设检验的结果。

精确概率法的主要优势在于其统计推断的准确性和稳定性,适用于小样本和稀有事件的研究。

本文将会介绍卡方检验和精确概率法的原理和应用,并比较它们的优缺点。

在结论部分,将会对两种方法进行对比分析,进一步探讨它们适用的场景和应用前景。

通过本文的阐述,读者将对卡方检验和精确概率法有更加全面的了解,并能够根据具体问题的特点选择适合的检验方法。

1.2文章结构1.2 文章结构本文将分为三个主要部分,分别是引言、正文和结论。

在引言部分,将对卡方检验和精确概率法的背景和概述进行介绍。

首先会对这两种方法进行简要的概述,包括其原理和应用领域。

接下来会明确本文的结构和目的,为读者提供整体上的概括。

在正文部分,将详细探讨卡方检验和精确概率法。

首先,在2.1节将详细介绍卡方检验的原理和应用。

会对卡方检验的基本原理进行解释,包括假设检验的流程和计算统计量的方法。

同时,会介绍卡方检验的应用领域,包括医学、社会科学和市场调研等。

接着,会对卡方检验的优缺点进行分析和讨论,以便读者全面了解其适用范围和局限性。

卡方检验的结果解读1.引言1.1 概述卡方检验是一种常用的统计方法,用于判断两个分类变量之间是否存在相关性或者一致性。

它是基于统计推断的方法,通过比较实际观察值与理论期望值之间的差异来进行判断。

在实际应用中,卡方检验被广泛用于比较两个或多个分类变量的分布情况,包括但不限于医学研究、社会调查以及市场分析等领域。

它能够帮助我们判断两个或多个分类变量是否独立,从而揭示变量之间的关联关系。

本文旨在对卡方检验的结果进行解读和分析。

首先,我们将介绍卡方检验的基本原理,包括计算卡方值和自由度的方法。

其次,我们将探讨卡方检验在实际应用中的一些典型场景,比如用于比较不同人群中某一特征的分布情况,或者用于评估某一策略对用户行为变化的影响等。

在解读卡方检验结果时,我们需要关注卡方值和P值。

卡方值反映了观察值与理论期望值之间的差异程度,而P值则是用来判断这种差异是否具有统计学意义的指标。

通常来说,如果P值小于预先设定的显著性水平(通常为0.05),则可以拒绝原假设,即认为变量之间存在相关性或一致性。

然而,卡方检验也有其局限性。

例如,样本量过小可能导致研究结论不准确,而样本量过大则可能会使得小的差异也变得显著。

此外,卡方检验只能判断变量是否相关,而不能确定其具体的关系强度和方向性。

综上所述,卡方检验是一种重要的统计方法,可以帮助我们判断变量之间的关系。

对于卡方检验结果的解读,我们需要综合考虑卡方值和P值,并且意识到其存在的局限性。

在实际应用中,我们可以根据具体问题选择合适的卡方检验方法,并合理解读其结果,以便得出准确的结论。

1.2文章结构文章结构部分应该对整篇长文的大致结构进行介绍,并说明各个部分内容的关联性和重要性。

具体内容如下:1.2 文章结构本文主要围绕卡方检验的结果进行解读展开。

全文分为引言、正文和结论三个部分。

在引言部分,我们将对卡方检验进行概述,介绍其基本原理,并明确文章的目的。

同时,我们也会提及本文的结构,让读者对文章整体有个初步的认识。

统计学方法卡方检验

卡方检验是一种统计学方法,主要用于分类变量分析,包括两个率或两个构成比的比较、多个率或多个构成比的比较以及分类资料的相关分析等。

具体步骤如下:

首先,观察实际观测值和理论推断值的偏离程度,此处的理论值可以是预期的发生频率或概率。

实际观测值与理论推断值之间的偏离程度决定了卡方值的大小。

如果卡方值越大,说明实际观测值与理论值之间的差异越大;反之,则差异越小。

如果两个值完全相等,卡方值就是0,这表明理论值完全符合实际观测值。

此外,在没有其他限定条件或说明时,卡方检验通常指的是皮尔森卡方检验。

在进行卡方检验时,研究人员通常会将观察量的值划分成若干互斥的分类,并尝试用一套理论(或零假设)去解释观察量的值落入不同分类的概率分布模型。

卡方检验的目的就在于衡量这个假设对观察结果所反映的程度。

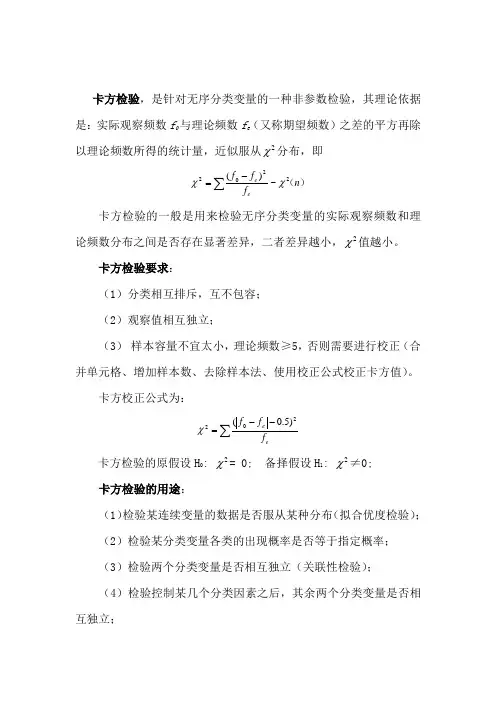

卡方检验,是针对无序分类变量的一种非参数检验,其理论依据是:实际观察频数f 0与理论频数f e (又称期望频数)之差的平方再除以理论频数所得的统计量,近似服从2χ分布,即)(n f f f ee 2202~)(χχ∑-= 卡方检验的一般是用来检验无序分类变量的实际观察频数和理论频数分布之间是否存在显著差异,二者差异越小,2χ值越小。

卡方检验要求:(1)分类相互排斥,互不包容; (2)观察值相互独立;(3) 样本容量不宜太小,理论频数≥5,否则需要进行校正(合并单元格、增加样本数、去除样本法、使用校正公式校正卡方值)。

卡方校正公式为:∑--=ee f f f 202)5.0(χ卡方检验的原假设H 0: 2χ= 0; 备择假设H 1: 2χ≠0; 卡方检验的用途:(1)检验某连续变量的数据是否服从某种分布(拟合优度检验); (2)检验某分类变量各类的出现概率是否等于指定概率; (3)检验两个分类变量是否相互独立(关联性检验); (4)检验控制某几个分类因素之后,其余两个分类变量是否相互独立;(5)检验两种方法的结果是否一致,例如两种方法对同一批人进行诊断,其结果是否一致。

(一)检验单样本某水平概率是否等于某指定概率一、单样本案例例如,检验彩票中奖号码的分布是否服从均匀分布(概率=某常值);检验某产品市场份额是否比以前更大;检验某疾病的发病率是否比以前降低。

有数据文件:检验“性别”的男女比例是否相同(各占1/2)。

1. 【分析】——【非参数检验】——【单样本】,打开“单样本非参数检验”窗口,【目标】界面勾选“自动比较观察数据和假设数据”2.【字段】界面,勾选“使用定制字段分配”,将变量“性别”选入【检验字段】框;注意:变量“性别”的度量标准必须改为“名义”类型。

3. 【设置】界面,选择“自定义检验”,勾选“比较观察可能性和假设可能性(卡方检验)”;4. 点【选项】,打开“卡方检验选项”子窗口,本例要检验男女概率都=,勾选“所有类别概率相等”;注:若有类别概率不等,需要勾选“自定义期望概率”,在其表中设置各类别水平及相应概率。

智慧教室:科技改变教育环境随着科技的不断发展,教育领域也在逐渐发生革命性的变化。

传统的教室已经逐渐演变成了智慧教室,科技的应用让教育环境焕然一新。

智慧教室不仅仅是简单地将电子设备引入教室,更是通过科技手段改变了教学方式、提升了学习效果,为教育注入了新的活力和动力。

一、智慧教室的特点智慧教室是指利用现代信息技术手段,将传统教室与数字化、网络化、智能化技术相结合,实现教学资源共享、互动式教学、个性化学习等目标的教室。

智慧教室的特点主要包括以下几个方面:1. 多媒体教学:智慧教室通过投影仪、电子白板等多媒体设备,实现了教学内容的多样化呈现,让学生在视听上得到更好的体验。

2. 互动式教学:教师和学生可以通过智慧教室的设备进行互动,实现师生之间、生生之间的互动交流,促进学生思维的碰撞和交流。

3. 个性化学习:智慧教室可以根据学生的学习情况和兴趣特点,为每个学生提供个性化的学习内容和学习路径,满足不同学生的学习需求。

4. 教学资源共享:智慧教室可以实现教学资源的共享和整合,教师可以轻松获取各种教学资源,提高教学效率和质量。

二、智慧教室的应用智慧教室的应用已经逐渐渗透到各个教育阶段和各个学科领域。

在小学阶段,智慧教室可以通过生动有趣的教学内容和互动式教学方式,激发学生的学习兴趣,提高学习效果。

在中学阶段,智慧教室可以通过多媒体教学和个性化学习,帮助学生更好地理解知识,提高学习成绩。

在大学阶段,智慧教室可以为学生提供更广阔的学习空间和更丰富的学习资源,培养学生的创新能力和实践能力。

除了在学校教育中的应用,智慧教室还在职业教育、继续教育等领域发挥着重要作用。

通过智慧教室,职业教育可以更好地满足市场需求,培养更符合社会需求的人才;继续教育可以为广大在职人员提供更便捷、高效的学习途径,提升他们的职业素质和竞争力。

三、智慧教室的优势智慧教室相比传统教室具有诸多优势,主要体现在以下几个方面: 1. 提高教学效率:智慧教室可以让教师更好地利用教学资源,设计更生动有趣的教学内容,提高教学效率,激发学生的学习兴趣。

SPSS专用统计术语1、X2/df x2(卡方检验)检验方法和分解融合(DF)方法x2值(Chi-Square)为22.4601,自由度(chi-square df)为4,P值(Pr>Chi-Square)为0.0002 2、RMR LISREL、AMOS等结构方程模型分析软件,为什么我的Amos输出中找不到RMR和GFI这一项内容。

(1)间距参数RSm与混合参数Rmr(c)称为附加参数(2)表示残差均方根,残差是指样本导出的方差协方差矩阵与模型隐含的方差协方差矩阵中对应元素的差值,RMR的值越小,模型拟合越好。

从你的图片看,你的模型拟合度不好。

Amos does not report GFI, PGFI, AGFI and RMR when you estimate means and intercepts. This is because it is not clear how to incorporate means and intercepts into the conventional formulas for these statistics. One possibility is to calculate these statistics based on the observed variances/covariances and the fitted (implied) variances/covariances, leaving the means and intercepts out of the fit measure. That way of computing the statistics could be useful and is certainly defensible. It would make a great deal of sense in those models where means and intercepts are estimated but not constrained. On the other hand, for models thatconstrain means and intercepts it is important to pay attention to how well the model reproduces the means and intercepts, as well as the variances/covariances.Another approach would be to generalize the definitions of those statistics to somehow incorporate failure to fit means and intercepts. So far, a unique, obviously correct, way of doing this has not been proposed.For these reasons, the design decision was made not to report GFI, PGFI, AGFI and RMR when means and intercepts are estimated.回头去看你的“View”里的“Analysis Properties”,“Estimates means and intercepets”是被选中了的,把那个复选框去掉后,报表里就有RMR和GFI等指数啦。

卡方检验查表方法

卡方检验是一种常用的统计方法,用于判断两个分类变量之间是否存在显著关联。

它的原理是通过比较实际观测值和理论预期值之间的差异来判断这种关联是否具有统计学意义。

在进行卡方检验时,我们需要参考卡方检验查表来确定卡方统计量的临界值,从而判断实际观测值与理论预期值之间的差异是否显著。

卡方检验查表是一份用于卡方检验的参考工具,其中记录了不同自由度和显著性水平下的卡方统计量的临界值。

通过查表,我们可以找到适用于我们所研究的问题的临界值,从而进行判断。

在使用卡方检验查表时,我们首先需要确定显著性水平。

显著性水平是一个统计学的概念,它表示我们对拒绝原假设的程度。

通常我们会选择0.05作为显著性水平,也就是5%的风险。

然后,我们需要确定自由度,自由度的计算方法取决于所研究问题的特点。

自由度确定后,我们可以在卡方检验查表中找到对应自由度和显著性水平的卡方统计量的临界值。

通过比较实际观测值和理论预期值与卡方统计量的临界值,我们可以判断两个分类变量之间的关联是否显著。

如果实际观测值与理论预期值之间的差异大于卡方统计量的临界值,那么我们可以认为这种关联是显著的。

反之,如果差异小于临界值,那么我们认为这种关联是不显著的。

卡方检验查表是统计学中一项重要的工具,它能够帮助我们进行卡方检验并确定两个分类变量之间的关联是否显著。

在使用卡方检验查表时,我们需要注意选择适用于我们研究问题的显著性水平和自由度,并准确比较实际观测值与理论预期值与卡方统计量的临界值之间的差异。

只有这样,我们才能得出准确的结论,并对研究问题有更深入的理解。

卡方检验模型验证方法模型参数的验证方法主要使用卡方拟合度检验( Chi-square Goodness-of-fit Test )结合最大似然

估计( Maximum Likelihood Estimation ),并且使用QQ图(Quantile-Quantile Plot)证明验证结果。

具体的说,就是先假定采集的样本数据符合某一分布,通过最大似然估计方法估计出该分布的参数,然后代入并用卡方检验计算相对于该分布的偏差。

实践中我们对于一组样本数据,计算所有常见分布的偏差值,选取偏差最小的分布做为该样本的拟合结果。

另外,从QQ图直观上看,该分布做为拟合结果描绘出的曲线

必须近似为接近参考线的直线(见3.3),否则我们就将数据拆分为多个部分进行分段的拟合(如对终端请求包大小的拟合)。

1.1 卡方拟合度检验卡方检验是一种大样本假设检验法,用于检验随机事件中提出的样本数据是否符合某一给定分布。

它需要较

大量的样本数据及已知的待检验概率分布函数。

1.1.1 卡方检验原理对于一个服从二项分布的随机变量Y服从Binomial( n, p) ,均值为,方差。

由中心极限定理,符合标准正态分布N (0, 1),所以服从自由度为1的卡方分布。

设服从Binomial( n, p1 ), , , 则

有

所以

同理对于k个随机变量,均值分别为

,

在数据拟合时,先对数据分组,每组数据的实际个数即为随机变量

,,,则数据拟合即为判断

是否符合分布,

该卡方分布的自由度为k-1-nep(k为随机变量个数,nep为估计参数的个数)。

1.1.2 卡方检验步骤:假定样本服从某一给定分布。

根据样本数据用最大似然法估计分布的密度函数参数。

设定置信度,对n个样本数据排序。

把排序后的数据分成k组,确定每组的上下限,(上下限确定方法不同对验证能力有影响,

每组数据不少于5个),为了方便起见,本项目中采用平均划分分组间隔,即使为常数,

对于所有的成立。

计算每组数据实际个数,第i组实际个数为。

计算每组数据期望个数,第i组期望个数为:

连续:,其中F(x)为待验证的概率分布函数,

离散:。

计算。

理论上说如果,则数据符合分布函数为F(x)的分布,

其中,nep为估计的参数的个数。

但是由于实际采集的数据并非完全地符合某一分布,

总存在一定的偏差,计算出的值并不满足这个条件,

所以我们使用的拟合标准为采用卡方估计值最小的分布作为验证结果。