概率为0事件的信源熵

- 格式:ppt

- 大小:1.43 MB

- 文档页数:70

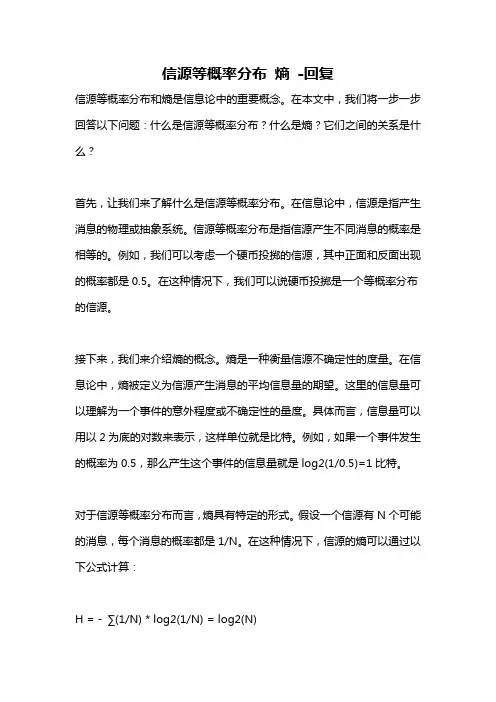

信源等概率分布熵-回复信源等概率分布和熵是信息论中的重要概念。

在本文中,我们将一步一步回答以下问题:什么是信源等概率分布?什么是熵?它们之间的关系是什么?首先,让我们来了解什么是信源等概率分布。

在信息论中,信源是指产生消息的物理或抽象系统。

信源等概率分布是指信源产生不同消息的概率是相等的。

例如,我们可以考虑一个硬币投掷的信源,其中正面和反面出现的概率都是0.5。

在这种情况下,我们可以说硬币投掷是一个等概率分布的信源。

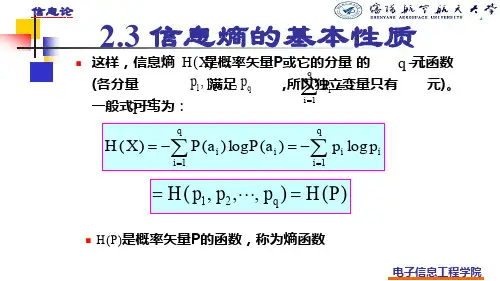

接下来,我们来介绍熵的概念。

熵是一种衡量信源不确定性的度量。

在信息论中,熵被定义为信源产生消息的平均信息量的期望。

这里的信息量可以理解为一个事件的意外程度或不确定性的量度。

具体而言,信息量可以用以2为底的对数来表示,这样单位就是比特。

例如,如果一个事件发生的概率为0.5,那么产生这个事件的信息量就是log2(1/0.5)=1比特。

对于信源等概率分布而言,熵具有特定的形式。

假设一个信源有N个可能的消息,每个消息的概率都是1/N。

在这种情况下,信源的熵可以通过以下公式计算:H = - ∑(1/N) * log2(1/N) = log2(N)这个公式说明了等概率分布信源的熵与可能的消息数量成正比。

换句话说,信源的熵随着消息数量的增加而增加。

那么,信源等概率分布和熵之间有什么关系呢?它们的关系可以通过熵的定义得到解释。

由于等概率分布中的每个消息的概率都相等,因此它们的信息量也是相等的。

因此,在等概率分布下,每个消息的信息量可以等效为一个相同的比特数。

这意味着,等概率分布信源的熵等于每个消息的信息量乘以消息数量。

由于每个消息的信息量是相同的,因此等概率分布信源的熵与消息数量成正比,如上述公式所示。

熵的概念和等概率分布信源的关系对于许多信息论的应用至关重要。

通过熵的度量,我们可以衡量一个信源产生的消息的不确定性程度。

在实际应用中,我们可以利用熵来设计有效的编码方案,以最小化消息的传输量。

总结起来,信源等概率分布是指信源产生不同消息的概率是相等的分布。

⼀⽂详解机器学习中的信息熵概念开篇这篇⽂章主要介绍信息熵(Information Entropy)这个概念,也是为了我的专栏下⼀讲做前期的知识准备。

信息理论是数学的重要分⽀,主要是解决数据在噪⾳通道的传输问题。

其中,信息理论⾥程碑的贡献是量化了⼀个事件或者随机变量所包含的信息,也叫做熵(Entropy)。

熵的计算在机器学习中有着⼴泛的应⽤,如逻辑回归(Logistic Regression),决策树(Decision Tree)等等分类模型。

这些看似深奥的知识,背后的逻辑并不难。

⼤纲1. 信息理论简介2. 信息值和熵的计算信息理论简介熵(Entropy)这个概念在学⼤学物理的时候,有所涉及。

熵可以被看做⼀个系统混乱度的度量。

熵值越⼤,系统越混乱。

也许你听过,宇宙在朝着熵增的⽅向发展着。

信息理论中,最基础的概念就是信息(Information)。

信息值可以将事件、随机变量中所含的信息量化。

问题:六⽉飘雪和六⽉下⾬哪个事件的信息量⼤?六⽉下⾬太正常了,⼀点都不惊讶,这是常识,信息量相对较少。

六⽉飘雪就不正常了,⼩概率事件背后是不是有冤情,信息量满满。

信息理论中:⼀个事件发⽣的概率越⼤,信息量越少,发⽣产⽣的惊喜值较低;⼀个事件发⽣的概率越⼩,信息量越⼤,发⽣产⽣的惊喜值较⾼;信息量的计算也就是说,信息量和概率是负相关的。

概率越⼩,信息量越⼤。

所以,在信息理论中,会⽤到以下的公式将信息量和概率值联系起来:信息值计算从下图中,可以发现公式可以很好的满⾜我们的需求。

当事件发⽣概率为100%的时候,信息值为0。

信息值~概率拿抛硬币为例,正反出现的概率各为50%,P=0.5。

代⼊公式,出现正⾯这个事件的信息值为1。

熵的计算熵这个概念有点类似期望值。

这次拿掷骰⼦为例,骰⼦有1,2,3,4,5,6 六个⾯。

如果有⼈和你赌钱:掷骰⼦掷出1,2,3,4,他就给你1块钱;掷骰⼦掷出5,6,你给他⼀块钱;你觉得公平吗?当然不,为什么呢?这就撤出了期望值的概念。

通信的基本问题,是在通信系统的一端精确地或者近似地复现另一端选择的消息概念消息:由信源发出,具有随机性信息量:消息所包含的不确定性的度量信息的量化1. 在南极大陆,今天的气温为-25°C2. 在南极大陆,今天的气温为38°C在一般情况下,这两条消息哪一条包含的信息量更大呢?一条消息所携带的信息量的大小,和它带给接收者的“surprise”有关。

在数学上,我们可以用事件的发生概率来表示一个事件发生所引起的surprise。

{}r x x x X ,,,21 =Xs s s s x t t ∈=)(10 )()Pr(i i i x P x p =={}r X p p p P ,,,21 =∑==ri ip 11信源符号集合:信源从时刻0开始发出的符号序列为:信源中每个信源符号的发生概率:信源的概率分布为:∑==⎥⎦⎤⎢⎣⎡=⎥⎦⎤⎢⎣⎡n i i n n p where p p p a a a X P X 121211,,,,,,)( 离散信源的概率模型自信息 :当信源发出这个符号时所发出的信息量。

)(log )(1log )(i i i x P x P x I -==单位: 取决于所用的对数的底。

当使用以2为底的对数时,信息量的单位是比特(bit );当使用以10为底的对数时,信息量的单位是哈特莱(Hartley );当使用以e 为底的对数(自然对数)时,信息量的单位是奈特(nat )。

1 nat = 1.44 bit例题某门课程的学生成绩分布如下,求每个成绩等级代表符号A, B, C, D, F所包含的信息量。

A B C D F25%50%12.5%10% 2.5%解:符号概率p自信息 log(1/p)A0.25 2 比特B0.5 1 比特C0.125 3 比特D0.1 3.32 比特F0.025 5.32 比特合计:1例题某门课程的学生成绩分布如下,求每个成绩等级代表符号A, B, C, D, F所包含的信息量。