线性判别函数解读

- 格式:ppt

- 大小:1.16 MB

- 文档页数:58

线性判别分析(LinearDiscriminantAnalysis,LDA)⼀、LDA的基本思想线性判别式分析(Linear Discriminant Analysis, LDA),也叫做Fisher线性判别(Fisher Linear Discriminant ,FLD),是模式识别的经典算法,它是在1996年由Belhumeur引⼊模式识别和⼈⼯智能领域的。

线性鉴别分析的基本思想是将⾼维的模式样本投影到最佳鉴别⽮量空间,以达到抽取分类信息和压缩特征空间维数的效果,投影后保证模式样本在新的⼦空间有最⼤的类间距离和最⼩的类内距离,即模式在该空间中有最佳的可分离性。

如下图所⽰,根据肤⾊和⿐⼦⾼低将⼈分为⽩⼈和⿊⼈,样本中⽩⼈的⿐⼦⾼低和⽪肤颜⾊主要集中A组区域,⿊⼈的⿐⼦⾼低和⽪肤颜⾊主要集中在B组区域,很显然A组合B组在空间上明显分离的,将A组和B组上的点都投影到直线L上,分别落在直线L的不同区域,这样就线性的将⿊⼈和⽩⼈分开了。

⼀旦有未知样本需要区分,只需将⽪肤颜⾊和⿐⼦⾼低代⼊直线L的⽅程,即可判断出未知样本的所属的分类。

因此,LDA的关键步骤是选择合适的投影⽅向,即建⽴合适的线性判别函数(⾮线性不是本⽂的重点)。

⼆、LDA的计算过程1、代数表⽰的计算过程设已知两个总体A和B,在A、B两总体分别提出m个特征,然后从A、B两总体中分别抽取出、个样本,得到A、B两总体的样本数据如下:和假设存在这样的线性函数(投影平⾯),可以将A、B两类样本投影到该平⾯上,使得A、B两样本在该直线上的投影满⾜以下两点:(1)两类样本的中⼼距离最远;(2)同⼀样本内的所有投影距离最近。

我们将该线性函数表达如下:将A总体的第个样本点投影到平⾯上得到投影点,即A总体的样本在平⾯投影的重⼼为其中同理可以得到B在平⾯上的投影点以及B总体样本在平⾯投影的重⼼为其中按照Fisher的思想,不同总体A、B的投影点应尽量分开,⽤数学表达式表⽰为,⽽同⼀总体的投影点的距离应尽可能的⼩,⽤数学表达式表⽰为,,合并得到求从⽽使得得到最⼤值,分别对进⾏求导即可,详细步骤不表。

R语⾔中的线性判别分析_r语⾔线性判别分析在中,线性判别分析(Liner Discriminant Analysis,简称LDA),依靠软件包MASS中有线性判别函数lqa()来实现。

该函数有三种调⽤格式:1)当对象为数据框data.frame时lda(x,grouping,prior = propotions,tol = 1.0e-4,method,CV = FALSE,nu,…)2) 当对象为公式Formula时lda(formula,data,…,subnet,na.action)3) 当对象为矩阵Matrix时lda(x,group,…,subnet,na.action)对于第⼀种情况,grouping表⽰每个观测样本的所属类别;prior表⽰各类别的先验概率,默认取训练集中各样本的⽐例;tol表⽰筛选变量,默认取0.0001对于第⼆种情况,formula表⽰判别公式,⽐如,y~x1 x2 x3,或者y~x1*x1data表⽰数据集subnet表⽰样本na.action表⽰处理缺失值的⽅法,默认为“如果样本中有缺失值,则lda()函数⽆法运⾏”;如果设置为na.omit,则表⽰“⾃动删除样本中的缺失值,然后,进⾏计算”对于第三种情况,x表⽰矩阵data表⽰数据集subnet表⽰样本na.action表⽰处理缺失值的⽅法,默认为“如果样本中有缺失值,则lda()函数⽆法运⾏”;如果设置为na.omit,则表⽰“⾃动删除样本中的缺失值,然后,进⾏计算”下⾯,举⼀个例⼦,来说明线性判别分析。

我们选⽤kknn软件包中的miete数据集进⾏算法演⽰。

miete数据集记录了1994年慕尼⿊的住房佣⾦标准中⼀些有趣变量,⽐如房⼦的⾯积、是否有浴室、是否有中央供暖、是否供应热⽔等等,这些因素都影响着佣⾦的⾼低。

1.数据概况⾸先,简单了解⼀下,miete数据集。

> library(kknn) > data(miete) > head(miete)nm wfl bj bad0 zh ww0 badkach fenster kueche mvdauer bjkat wflkat1 693.29 50 1971.5 0 1 0 0 0 02 4 12 736.60 70 1971.5 0 1 0 0 0 0 26 4 23 732.23 50 1971.5 0 1 0 0 0 0 14 14 1295.14 55 1893.0 0 1 0 0 0 0 0 1 25 394.97 46 1957.0 0 0 1 0 0 0 27 3 16 1285.64 94 1971.5 0 1 0 1 0 0 2 4 3nmqm rooms nmkat adr wohn1 13.865800 1 32 22 10.5228573 3 2 23 14.644600 1 3 2 24 23.548000 35 2 25 8.586304 3 1 2 26 13.677021 4 5 2 2> dim(miete)[1] 1082 17我们看到,该数据集⼀共有1082条样本,和17个变量。

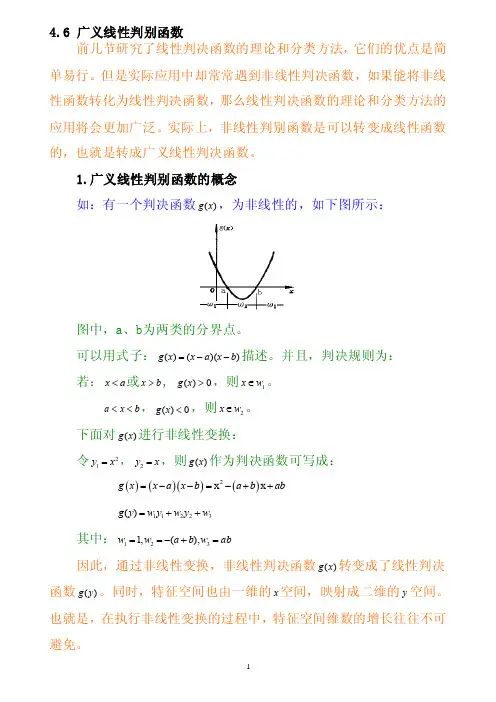

4.6 广义线性判别函数前几节研究了线性判决函数的理论和分类方法,它们的优点是简单易行。

但是实际应用中却常常遇到非线性判决函数,如果能将非线性函数转化为线性判决函数,那么线性判决函数的理论和分类方法的应用将会更加广泛。

实际上,非线性判别函数是可以转变成线性函数的,也就是转成广义线性判决函数。

1.广义线性判别函数的概念如:有一个判决函数)(x g ,为非线性的,如下图所示:图中,a 、b 为两类的分界点。

可以用式子:))(()(b x a x x g --=描述。

并且,判决规则为: 若:a x <或b x >, 0)(>x g ,则1w x ∈。

b x a <<,0)(<x g ,则2w x ∈。

下面对)(x g 进行非线性变换:令21x y =,x y =2,则)(x g 作为判决函数可写成:()g x =()()x a x b --()2x x a b ab =-++32211)(w y w y w y g ++=其中:ab w b a w w =+-==321),(,1因此,通过非线性变换,非线性判决函数)(x g 转变成了线性判决函数)(y g 。

同时,特征空间也由一维的x 空间,映射成二维的y 空间。

也就是,在执行非线性变换的过程中,特征空间维数的增长往往不可避免。

在y 的特征空间里,区分直线为:0)(21=++-ab y b a y ,如下图:区分直线把y 空间线性地划分为两个类型区域1w 和2w ,判决规则为:若0)(>y g ,则1w y ∈,也就是1w x ∈0)(<y g ,则2w y ∈,也就是2w x ∈对样本x 的测量值:① 先进行非线性变换,x y x y ==221, ② 计算)(x g 之值,ab y b a y x g ++-=21)()( ③ 判决类别下面讨论非线性判决函数的一般形式: 把非线性判决函数写成一般形式,就是:12211)(....)()()(+++++=d d d w x f w x f w x f w x g其中,)(x f i (d i ,...,2,1=)是x 的单值实函数,且存在非线性关系,x 是k 维的。

第5章:线性判别函数第一部分:计算与证明1. 有四个来自于两个类别的二维空间中的样本,其中第一类的两个样本为(1,4)T 和(2,3)T ,第二类的两个样本为(4,1)T 和(3,2)T 。

这里,上标T 表示向量转置。

假设初始的权向量a=(0,1)T ,且梯度更新步长ηk 固定为1。

试利用批处理感知器算法求解线性判别函数g(y)=a T y 的权向量。

解:首先对样本进行规范化处理。

将第二类样本更改为(4,1)T 和(3,2)T . 然后计算错分样本集:g(y 1) = (0,1)(1,4)T = 4 > 0 (正确) g(y 2) = (0,1)(2,3)T = 3 > 0 (正确) g(y 3) = (0,1)(-4,-1)T = -1 < 0 (错分) g(y 4) = (0,1)(-3,-2)T = -2 < 0 (错分) 所以错分样本集为Y={(-4,-1)T , (-3,-2)T }.接着,对错分样本集求和:(-4,-1)T +(-3,-2)T = (-7,-3)T第一次修正权向量a ,以完成一次梯度下降更新:a=(0,1)T + (-7,-3)T =(-7,-2)T 再次计算错分样本集:g(y 1) = (-7,-2)(1,4)T = -15 < 0 (错分) g(y 2) = (-7,-2)(2,3)T = -20 < 0 (错分) g(y 3) = (-7,-2)(-4,-1)T = 30 > 0 (正确) g(y 4) = (-7,-2)(-3,-2)T = 25 > 0 (正确) 所以错分样本集为Y={(1,4)T , (2,3)T }.接着,对错分样本集求和:(1,4)T +(2,3)T = (3,7)T第二次修正权向量a ,以完成二次梯度下降更新:a=(-7,-2)T + (3,7)T =(-4,5)T 再次计算错分样本集:g(y 1) = (-4,5)(1,4)T = 16 > 0 (正确) g(y 2) = (-4,5)(2,3)T = 7 > 0 (正确) g(y 3) = (-4,5)(-4,-1)T = 11 > 0 (正确) g(y 4) = (-4,5)(-3,-2)T = 2 > 0 (正确)此时,全部样本均被正确分类,算法结束,所得权向量a=(-4,5)T 。

1. 问题之前我们讨论的PCA、ICA也好,对样本数据来言,可以是没有类别标签y的。

回想我们做回归时,如果特征太多,那么会产生不相关特征引入、过度拟合等问题。

我们可以使用PCA 来降维,但PCA没有将类别标签考虑进去,属于无监督的。

比如回到上次提出的文档中含有“learn”和“study”的问题,使用PCA后,也许可以将这两个特征合并为一个,降了维度。

但假设我们的类别标签y是判断这篇文章的topic是不是有关学习方面的。

那么这两个特征对y几乎没什么影响,完全可以去除。

再举一个例子,假设我们对一张100*100像素的图片做人脸识别,每个像素是一个特征,那么会有10000个特征,而对应的类别标签y仅仅是0/1值,1代表是人脸。

这么多特征不仅训练复杂,而且不必要特征对结果会带来不可预知的影响,但我们想得到降维后的一些最佳特征(与y关系最密切的),怎么办呢?2. 线性判别分析(二类情况)回顾我们之前的logistic回归方法,给定m个n维特征的训练样例(i从1到m),每个对应一个类标签。

我们就是要学习出参数,使得(g 是sigmoid函数)。

现在只考虑二值分类情况,也就是y=1或者y=0。

为了方便表示,我们先换符号重新定义问题,给定特征为d维的N个样例,,其中有个样例属于类别,另外个样例属于类别。

现在我们觉得原始特征数太多,想将d维特征降到只有一维,而又要保证类别能够“清晰”地反映在低维数据上,也就是这一维就能决定每个样例的类别。

我们将这个最佳的向量称为w(d维),那么样例x(d维)到w上的投影可以用下式来计算这里得到的y值不是0/1值,而是x投影到直线上的点到原点的距离。

当x是二维的,我们就是要找一条直线(方向为w)来做投影,然后寻找最能使样本点分离的直线。

如下图:从直观上来看,右图比较好,可以很好地将不同类别的样本点分离。

接下来我们从定量的角度来找到这个最佳的w。

首先我们寻找每类样例的均值(中心点),这里i只有两个由于x到w投影后的样本点均值为由此可知,投影后的的均值也就是样本中心点的投影。

Fisher判别函数,也称为线性判别函数(Linear Discriminant Function),是一种经典的模式识别方法。

它通过将样本投影到一维或低维空间,将不同类别的样本尽可能地区分开来。

一、算法原理:Fisher判别函数基于以下两个假设:1.假设每个类别的样本都服从高斯分布;2.假设不同类别的样本具有相同的协方差矩阵。

Fisher判别函数的目标是找到一个投影方向,使得同一类别的样本在该方向上的投影尽可能紧密,而不同类别的样本在该方向上的投影尽可能分开。

算法步骤如下:(1)计算类内散度矩阵(Within-class Scatter Matrix)Sw,表示每个类别内样本之间的差异。

Sw = Σi=1 to N (Xi - Mi)(Xi - Mi)ᵀ,其中Xi 表示属于类别i 的样本集合,Mi 表示类别i 的样本均值。

(2)计算类间散度矩阵(Between-class Scatter Matrix)Sb,表示不同类别之间样本之间的差异。

Sb = Σi=1 to C Ni(Mi - M)(Mi - M)ᵀ,其中 C 表示类别总数,Ni 表示类别i 中的样本数量,M 表示所有样本的均值。

(3)计算总散度矩阵(Total Scatter Matrix)St,表示所有样本之间的差异。

St =Σi=1 to N (Xi - M)(Xi - M)ᵀ(4)计算投影方向向量w,使得投影后的样本能够最大程度地分开不同类别。

w= arg max(w) (wᵀSb w) / (wᵀSw w),其中w 表示投影方向向量。

(5)根据选择的投影方向向量w,对样本进行投影。

y = wᵀx,其中y 表示投影后的样本,x 表示原始样本。

(6)通过设置一个阈值或使用其他分类算法(如感知机、支持向量机等),将投影后的样本进行分类。

二、优点和局限性:Fisher判别函数具有以下优点:•考虑了类别内和类别间的差异,能够在低维空间中有效地区分不同类别的样本。

判别分析--线性判别分析(LDA)应⽤案例1 线性判别分析执⾏线性判别分析可使⽤lda()函数,且该函数有三种执⾏形式,依次尝试使⽤。

(1)公式formula格式我们使⽤nmkat变量作为待判别变量,其他剩余的变量作为特征变量,根据公式nmkat~使⽤训练集数据来运⾏lda()函数:library(MASS)library("MASS")fitlda1<-lda(nmkat~.,datatrain) #以公式格式执⾏判别分析names(fitlda1) #查看lda输出项名称结果分析:我们看到,可以根据lda()函数得到10项输出结果,分别为执⾏过程中所使⽤的先验概率prior、数据集中各类别的样本量counts、各变量在每⼀类别中的均值 means等。

fitlda1$prior #查看本次执⾏过程中所使⽤的先验概率fitlda1$counts #查看数据集datatrain中各类别的样本量结果分析:由于我们在之前的抽样过程中采⽤的是nmkat各等级的等概率分层抽样⽅式,因此如上各类别的先验概率和样本量在5个等级中都是相等的。

具体的,5类的先验概率都为0.2,之和为1,且训练集中每⼀类都抽出了144个样本。

fitlda1$means结果分析:在如上的均值输出结果中,我们可以看到⼀些很能反映现实情况的数据特征。

⽐如,对于占地⾯积wfl变量,它明显随着租⾦nmkat的升⾼⽽逐步提⾼,我们看到在租⾦为等级1(少于500马克)时,占地⾯积的均值仅为55.53平⽅⽶,⽽对于租⾦等级5(租⾦不低于1150 马克),平均占地⾯积则达到了92.24平⽅⽶。

⾯积越⼤的房屋租⾦越贵,这是⼗分符合常识的。

执⾏fitlda1可直接将判别结果输出。

(2)数据框data.frame及矩阵matrix格式由于这两种函数格式的主体参数都为x与grouping,我们放在⼀起实现,程序代码如下:fitlda2<-lda(datatrain[,-12],datatrain[,12])#设置属性变量(除第12个变量nmkat外)与待判别变量(第12个变量nmkat)的取值fitlda22.判别规则可视化我们⾸先使⽤plot()直接以判别规则fit_ldal为对象输出图形,如下图所⽰:plot(fitlda1)结果分析:从图可以看到,在所有4个线性判别式(Linear Discriminants,即 LD)下1⾄5这5个类别的分布情况,不同类别样本已⽤相应数字标出。