计数型量具分析报告(Excel带计算KAPPA公式)

- 格式:pdf

- 大小:63.81 KB

- 文档页数:2

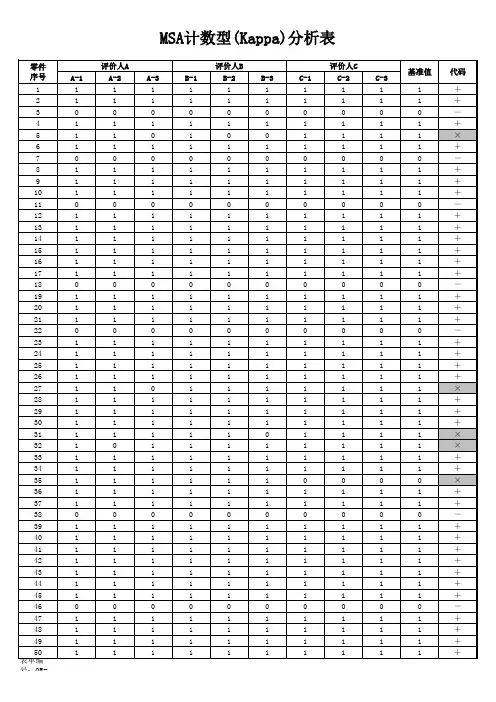

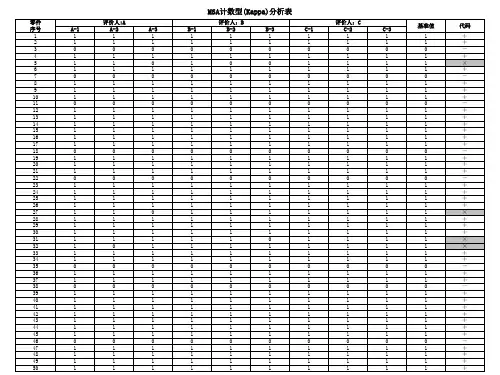

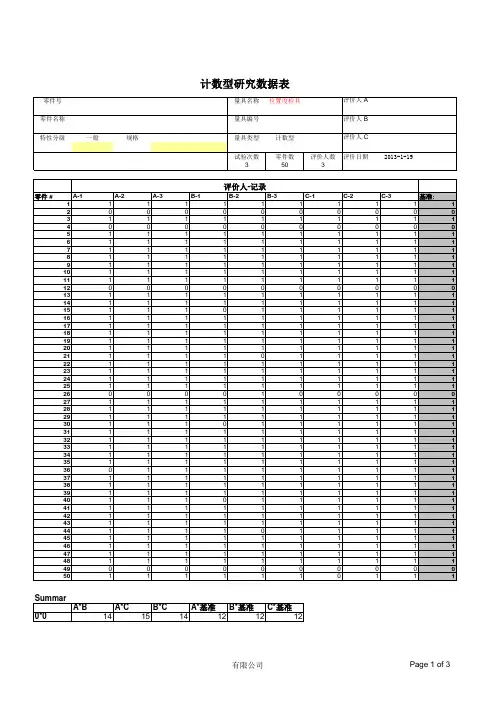

料号量具编号量具名称测量者 A 品名量具类型评价人数测量者 B 特性状态定义重复次数测量者 C 零件数量报告人批准日期产品编号A-1A-2A-3B-1B-2B-3C-1C-2C-3真值(REF)12345678910111213141516171819202122232425262728293031323334353637383940414243444546474849501=合格 0=不合格计数型测量系统分析报告计数型#DIV/0!人员更换定期(校准/年度)修复后新购公差变化DataSummary/A*BA*CB*CA*RefB*RefC*Ref0*00000001*00000000*10000001*1000SelfagreementA B C 00A*B Cross01总计Po:#DIV/0!A0计数000期望值#DIV/0!#DIV/0!#DIV/0!Pe:#DIV/0!1计数000期望值#DIV/0!#DIV/0!#DIV/0!总计计数000期望值#DIV/0!#DIV/0!#DIV/0!B*C01总计Po:#DIV/0!B0计数00期望值#DIV/0!#DIV/0!#DIV/0!Pe:#DIV/0!1计数000期望值#DIV/0!#DIV/0!#DIV/0!总计计数0期望值#DIV/0!#DIV/0!#DIV/0!A*CCrosstabulC 01总计Po:#DIV/0!A0计数0期望值#DIV/0!#DIV/0!#DIV/0!Pe:#DIV/0!1计数0期望值#DIV/0!#DIV/0!#DIV/0!总计计数0期望值#DIV/0!#DIV/0!#DIV/0!Reproduci bilityKappa 判定Kappa=(Po-Pe)/(1-Pe)A*REFCrosstabul1总计Po:#DIV/0!A0计数000期望值#DIV/0!#DIV/0!#DIV/0!Pe:#DIV/0!1计数000期望值#DIV/0!#DIV/0!#DIV/0!总计计数000期望值#DIV/0!#DIV/0!#DIV/0!B*REFCrosstabul1总计Po:#DIV/0!B0计数000期望值#DIV/0!#DIV/0!#DIV/0!Pe:#DIV/0!1计数000期望值#DIV/0!#DIV/0!#DIV/0!总计计数000期望值#DIV/0!#DIV/0!#DIV/0!真值#DIV/0!#DIV/0!#DIV/0!真值B C A*B B*C A*C #DIV/0!#DIV/0!#DIV/0!编制:审核:核准:。

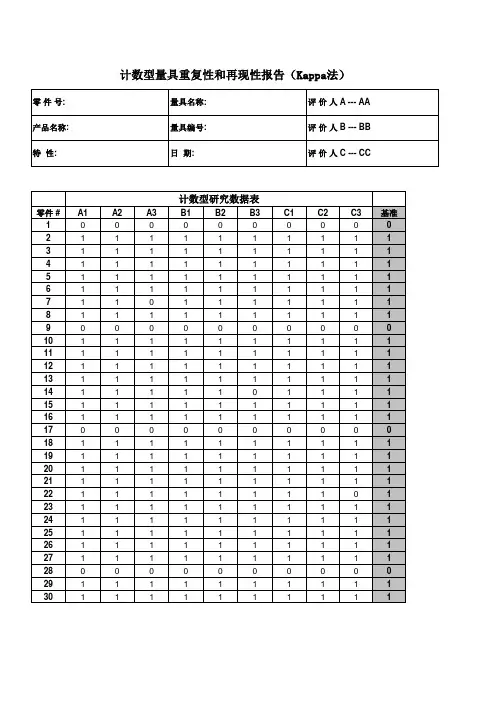

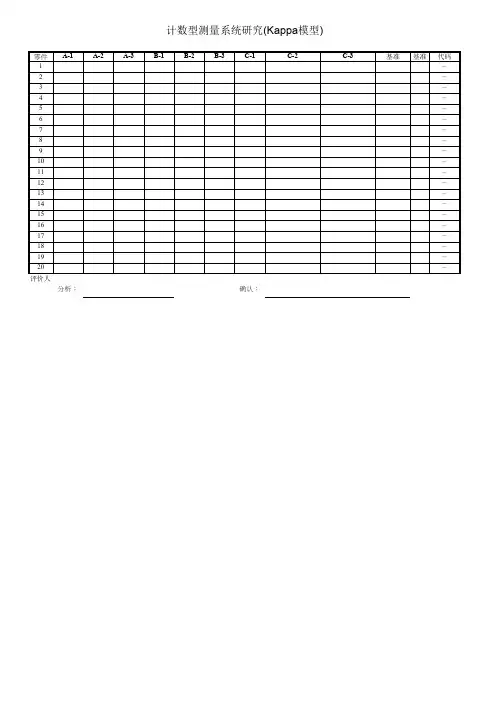

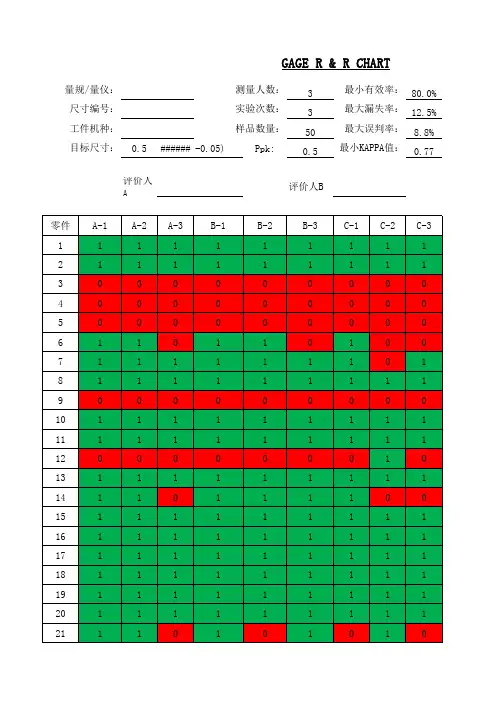

1、2、3、4、5、线性GRR计数型Kappa分析MSA测量系统分析全套表格模板稳定性偏倚Excel原件可在本文档左侧回形针处取出再现性Kappa=(Po-Pe)/(1-Pe)A*参考 交叉表A01总计Po:0.95Pe:0.51B*参考 交叉表B01总计Po:0.97Pe:0.51C*参考 交叉表C01总计Po:0.96Pe:0.5130期望的数量26.4636.5463数量38487期望的数量数量60363一致性好6666Kappa 一致性好判定误发期望的数量638728 4.76%可接受2.30%可接受 4.76%可接受3.45%可接受可接受5.75%可接受01参考总计62063871501C0.90有效性判定重复性检查总数匹配数漏发A A B 评价人评价人%B 93.33%可接受判 定判定0.9383.33%2530 3.17%36.5450.4687数量638715090.00%可接受0.92A C 一致性好150期望的数量B 期望的数量36.9651.0488数量6387150期望的数量26.0435.9662数量38588期望的数量6387数量60248.7284150数量6387150期望的数量35.28数量28284总计01Kappa 判 定A*B 0.89一致性好C 3027A*C 0.93一致性好参考B*C 参考总计可接受期望的数量27.7238.280.90一致性好数量615Page 11 of 11。

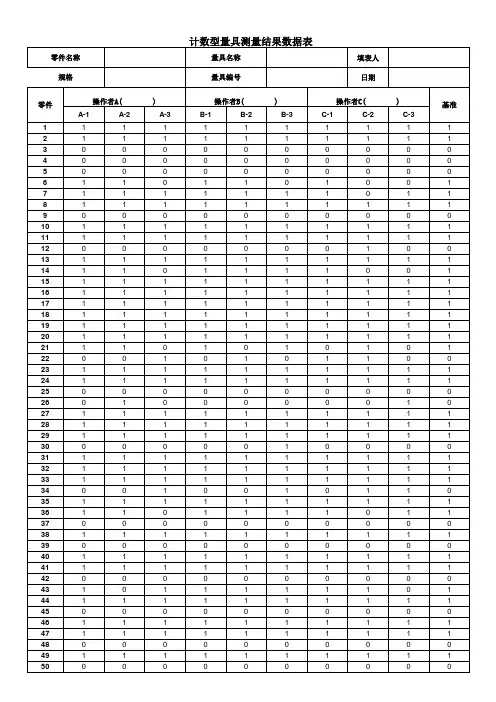

计数型研究数据表Data3503计数型研究数据表1*05120000*12150211*1129133129787677Selfagreeme nt/自评A BC 494449A*B 交叉表0.00 1.00总计Po:0.95A0.00计算14216期望的计 2.014.016Pe:0.791.00计算5129134期望的计17.0117.0134总计计算19131150期望的计19.0131.0150B*C 交叉0.00 1.00总计Po:0.95B0.00计算14519期望的计 2.017.019Pe:0.791.00计算2129131期望的计14.0117.0131总计计算16134150期望的计16.0134.0150A*C 交叉表0.00 1.00总计Po:0.99A0.00计算15116期望的计 1.714.316Pe:0.811.00计算1133134期望的计14.3119.7134总计计算16134150期望的计16.0134.0150Reprodu Kappa结论Kappa=(Po-Pe)/(1-Pe)A*B0.9300.774好好好B C C B*C0.774A*C3503计数型研究数据表A*基准交叉表0.00 1.00总计Po: 1.00A0.00计算12012期望的计 1.610.412.0Pe:0.771.00计算07878期望的计10.467.678.0总计计算127890期望的计12.078.090.0B*基准交叉表0.00 1.00总计Po:0.98B0.00计算12214期望的计 1.912.114.0Pe:0.751.00Count07676Expected 10.165.976.0Total Count 127890Expected12.078.090.0C*基准交叉表0.00 1.00总计Po:0.99C0.00计算12113期望的计 1.711.313.0Pe:0.761.00计算07777期望的计10.366.777.0总计计算127890期望的计12.078.090.0AB C一致性Kappa 1.000.910.95结论好好好重复和再AB C50505049444998%88%98%好差好A 可接受B 可接受C 可接受结论结论总受检数符合的Repeatability 符合率基准0%1%漏发误发0%3%0%0%可接受结论基准基准可接受可接受% 评价人。

01136191.817.219.0113013112.2118.8131.01413615014.0136.0150.001122141.612.414.0513113615.4120.6136.01713315017.0133.0150.001143172.214.817.0512813316.8116.2133.01913115019.0131.0150.0准确总数 估计总数准确总数 估计总数准确总数 估计总数A B C ---76%75%76%---75%AB C ≥0.75 一致性好,可接受< 0.4 一致性差,应改善评价75%C75%75%Kappa76%Kappa75%Kappa有效率A总计00.4<值< 0.75 一致性尚可接受 ≥0.9 有效性好,可接受0.8<值< 0.9 有效性尚可接受评价人与基准的有效性94%92%96%---A与基准交叉表B与基准交叉表B与基准评价人的KappaA BC与基准交叉表C与基准计算总计计算期望的计算0.79C期望的计算P0Pe0.950.80P0Pe A1B与C交叉表期望的计算计算计算期望的计算计算0.811计算总计BCA与B交叉表总计期望的计算总计P0B计算期望的计算0.95期望的计算总计计算期望的计算Pe 0.95C与A交叉表评价< 0.4 有效性差,应改善计算期望的计算1计算A与基准485096.0%计算34794.0%50有效率2有效率计算4465092.0%。

Kappa测试数据分析报告一、引言Kappa 测试是一种用于评估一致性的统计方法,在众多领域都有着广泛的应用。

本次报告旨在对 Kappa 测试数据进行深入分析,以揭示其潜在的规律和趋势,并为相关决策提供有力的支持。

二、数据来源与收集本次分析所使用的数据来源于具体项目名称,通过具体收集方法收集了样本数量个样本。

这些样本涵盖了样本的相关特征和范围,确保了数据的多样性和代表性。

三、Kappa 测试的基本原理Kappa 系数是衡量两个或多个评估者之间一致性的指标,其取值范围在-1 到 1 之间。

当 Kappa 值为 1 时,表示完全一致;当 Kappa 值为0 时,表示一致性与随机猜测相同;当 Kappa 值为负数时,表示一致性比随机猜测还差。

在计算 Kappa 系数时,需要先构建一个列联表,其中行和列分别代表不同评估者的评估结果。

然后,根据列联表中的数据计算预期一致性和实际一致性,最终得出 Kappa 值。

四、数据分析过程1、数据预处理首先,对原始数据进行了清理和筛选,去除了无效和缺失的数据。

同时,对数据进行了编码和标准化处理,以便后续的分析。

2、构建列联表根据预处理后的数据,构建了评估者之间的列联表。

通过列联表,可以直观地看到不同评估者的评估结果分布情况。

3、计算 Kappa 值利用统计软件,计算出了不同评估者之间的 Kappa 值。

结果显示,Kappa 值为具体数值,表明评估者之间的一致性处于具体水平。

4、置信区间估计为了进一步评估 Kappa 值的可靠性,还计算了其置信区间。

通过置信区间,可以了解 Kappa 值的波动范围,以及估计结果的准确性。

五、结果分析与讨论1、一致性水平评估根据计算得到的 Kappa 值,对评估者之间的一致性水平进行了评估。

如果 Kappa 值较高,说明评估者之间的一致性较好;如果 Kappa 值较低,则需要进一步分析原因,可能是评估标准不明确、评估者的经验差异等。

2、影响一致性的因素分析对可能影响一致性的因素进行了分析,如评估者的专业背景、培训程度、评估对象的复杂性等。