基于Hadoop的Web日志挖掘

- 格式:pdf

- 大小:266.08 KB

- 文档页数:3

基于Hadoop 集群的日志分析系统的设计与实现作者:陈森博陈张杰来源:《电脑知识与技术》2013年第34期摘要:当前Internet上存在着海量的日志数据,他们中蕴藏着大量可用的信息。

对海量数据的存储和分析都是一个艰巨而复杂的任务,单一主机已经无法满足要求,使用分布式存储和分布式计算来分析数据已经成为了必然的趋势。

分布式计算框架Hadoop已经日趋成熟,被广泛的应用于很多领域。

该文描述了一个针对大日志分析的分布式集群的构建与实现过程。

介绍了日志分析的现状,使用vmware虚拟机搭建了Hadoop集群和日志分析系统的构建方法,并对实验结果进行了分析。

关键词:分布式计算;日志分析;Hadoop;集群;vmware中图分类号:TP311 文献标识码:A 文章编号:1009-3044(2013)34-7647-041 概述日志文件是由系统或者应用程序产生的,用于记录系统和应用程序的操作事件如各种服务的启动、运行、关闭等信息。

通过对日志文件的分析可以获得很多有价值的数据也能实现对系统安全、性能等方面的监控。

Web日志[1]是由Web服务器产生的,随着社交网络的兴起,Web2.0时代的到来,网站的用户访问量的成级数增长,产生的日志文件大幅增多。

传统的日志文件分析方式已经无法满足大数据量日志分析的需求。

该文将以Web日志文件为例,利用Hadoop集群构建一个分布式计算平台为大数据日志文件的分析提供一个可行的解决方案,以提高了日志分析的效率,为进一步的大数据分析的提供参考。

现今日志文件分析方案是对大的日志文件先进行分割,然后对分割后的日志文件进行分析,分析方法采用文本分析及模式匹配等,最常见的是采用awk、python、perl。

这种分析方式面对大数据的日志文件分析效率低下,耗时长。

王潇博提出了基于挖掘算法的日志分析方式,并设计了TAT系统[1]。

对于Web分析除了对Web日志本身进行分析外还可以主动收集访问信息,然后将信息存于关系型数据库中。

基于交友网站的日志挖掘和分析系统

桑军;李丽

【期刊名称】《数字技术与应用》

【年(卷),期】2010(000)010

【摘要】针对女之海交友广场网站日志挖掘的具体需求,设计和开发了一个用于会员宣传的Web日志挖掘系统.结合自动获取的网站拓扑结构,对站点日志数据进行关联规则挖掘,以便更好地确定宣传的时间、地区、所针对的用户群年龄特征以及相应的会员信息内容等,系统实现了预期的挖掘任务和目的.

【总页数】2页(P142-143)

【作者】桑军;李丽

【作者单位】重庆大学软件学院,四川重庆,400044;重庆大学软件学院,四川重庆,400044

【正文语种】中文

【中图分类】TP321

【相关文献】

1.基于日志挖掘的打印管理系统的分析与设计 [J], 唐维燕

2.基于交友网站的日志挖掘和分析系统 [J], 桑军;李丽

3.基于粗糙集和模糊聚类的网站日志数据挖掘实例分析 [J], 高晓琴;王亨桂

4.基于日志挖掘的计算机取证系统的分析与设计 [J], 国光明;洪晓光

5.基于Hadoop的网站流量日志数据分析系统的设计 [J], 来学伟

因版权原因,仅展示原文概要,查看原文内容请购买。

web数据挖掘的处理流程对web数据的处理可以分为数据获取、数据预处理、数据的转换集成、知识发现和模式分析几个过程,如图6-2所示。

(1) web数据的获取Web数据的来源包括:log日志,记录了用户的访问页面、时间、IP地址等主要信息;web内容,用户所浏览的文字、图片等;用户注册信息,web站点采集的用户输入的自身信息;web结构数据,指web本身在频道、链接上的布局。

Web数据的获取方法有:a) 服务器端信息。

web服务器端产生3种类型的日志文件:Server logs,Error logs,Cookie logs,这些日志记录了用户访问的基本情况,是Web使用挖掘中最重要的数据来源。

服务器日志(Server logs)记录了多个用户对单个站点的用户访问行为。

错误日志(Error log)记录存取请求失败的数据。

Cookie logs用于识别用户和用户会话。

b) 客户端的数据收集。

用户客户端log记录了该用户对各个网站的访问情况,比服务器端Log数据更能准确地反映用户的访问行为,但由于隐私保护,需要用户同意才能获得。

c) 代理服务器端的数据收集。

代理端log数据记载了通过该代理进入Internet 的所有用户对各个网站的访问行为。

但是由于Cache的大量存在,使得代理服务器中的log数据不能准确地确定用户和时间,采集信息也不全面[50]。

(2) web数据的预处理Web数据的预处理包含数据清洗、用户识别、会话识别和事务识别等过程。

a) web数据的清洗数据的清洗,是指删除Web日志中与挖掘任务无关的数据。

将有用的web 日志记录转换为适当的数据格式,同时对用户请求页面时发生错误的记录进行适当处理。

在web日志中,包含许多对挖掘任务毫无意义的数据。

数据清洗的目标是消除冗余数据,方便于数据分析。

常见的数据清洗方法包括:删除日志文件中后缀为gif, jpg, jpeg的自动下载项;删除访问返回错误记录等。

web挖掘的基本任务

Web挖掘的基本任务是指从Web中提取有价值的信息或模式,其主要包括以下几种类型:

1.内容挖掘:指从Web页面中提取出有用的信息。

由于Web页面经常是半

结构化或非结构化的,因此内容挖掘需要处理HTML和XML文档,解析并提取出文本、图片、音频、视频等多媒体内容。

2.结构挖掘:指对Web页面的超链接关系进行挖掘,找出重要的页面,理解

网站的结构和组织方式,以及发现页面之间的关系。

3.使用挖掘:主要通过挖掘服务器日志文件,获取有关用户访问行为的信息,

例如用户访问路径、访问频率、停留时间等,从而理解用户的访问模式和偏好。

4.用户行为挖掘:结合内容挖掘和用户日志挖掘,深入理解用户在Web上的

活动,包括浏览、搜索、点击、购买等行为,用于精准推荐、个性化广告等应用。

5.社区发现:通过分析用户在社交媒体或论坛上的互动,发现用户之间的社

交关系和社区结构。

综上,Web挖掘的基本任务是从Web中提取有价值的信息或模式,这些信息或模式可能是内容、结构、使用情况、用户行为或社区关系。

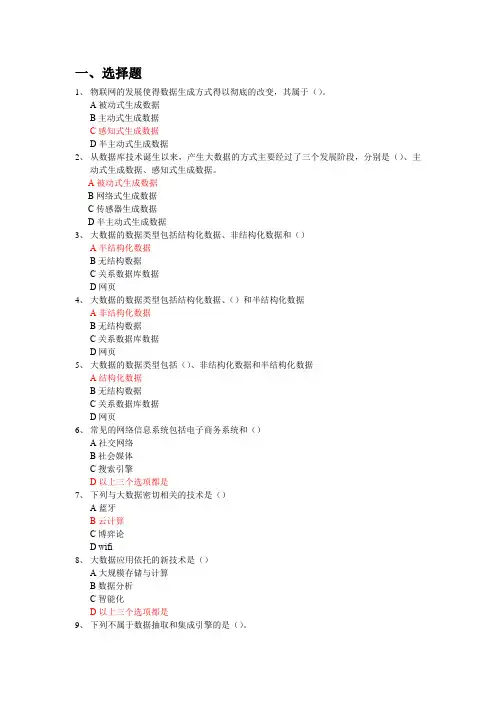

一、选择题1、物联网的发展使得数据生成方式得以彻底的改变,其属于()。

A被动式生成数据B主动式生成数据C感知式生成数据D半主动式生成数据2、从数据库技术诞生以来,产生大数据的方式主要经过了三个发展阶段,分别是()、主动式生成数据、感知式生成数据。

A被动式生成数据B网络式生成数据C传感器生成数据D半主动式生成数据3、大数据的数据类型包括结构化数据、非结构化数据和()A半结构化数据B无结构数据C关系数据库数据D网页4、大数据的数据类型包括结构化数据、()和半结构化数据A非结构化数据B无结构数据C关系数据库数据D网页5、大数据的数据类型包括()、非结构化数据和半结构化数据A结构化数据B无结构数据C关系数据库数据D网页6、常见的网络信息系统包括电子商务系统和()A社交网络B社会媒体C搜索引擎D以上三个选项都是7、下列与大数据密切相关的技术是()A蓝牙B云计算C博弈论D wifi8、大数据应用依托的新技术是()A大规模存储与计算B数据分析C智能化D以上三个选项都是9、下列不属于数据抽取和集成引擎的是()。

A基于物化或ETL方法的引擎B基于中间件的引擎C 基于空间数据的引擎D基于数据流方法的引擎10、大数据呈现出“4V1O”的特征,下列描述正确的是()A V olume、Variety、vacation、V elocity、On-LineB V olume、Variety、Value、Velocity、On-LineC V olume、Variety、Value、vehicle、On-LineD V olume、violence、Value、vehicle、On-Line11、大数据“4V1O”的特征中,表示大数据种类和来源多样化的是()A V olumeB VarietyC ValueD Velocity12、大数据“4V1O”的特征中,表示大数据价值密度相对较低,需要很多的过程才能挖掘出来的是()A V olumeB VarietyC ValueD Velocity13、大数据“4V1O”的特征中,表示时效性要求高的是()A V olumeB VarietyC ValueD Velocity14、大数据“4V1O”的特征中,表示数据量大的是()A V olumeB VarietyC ValueD VelocityD基本研究与人类资源15、美国信息高速公路计划HPCC(高性能计算与通信)中包含的BRHR是指()A高性能计算机系统B国家科研与教育网格C先进软件技术与算法D基本研究与人类资源16、大数据分析的典型工具中,属于实时计算系统的是()A HPCCB RapidMinerC Apache DrillD Storm17、大数据分析的典型工具中,属于数据挖掘解决方案的是()A HPCCB RapidMinerC Apache DrillD Storm18、大数据管理平台所必须考虑的要素是()A自动化和分布式B智能化和开放式C并行化和分布式D并行化和开放式19、大数据采集一般分为()和基础支撑层A基础架构层B智能感知层C数据处理层D数据挖掘层20、Hadoop是一个能够对大量数据进行()处理的软件框架A分布式B一体化C集成化D综合化21、Hadoop是一个能够对大量数据进行分布式处理的()框架A系统B传感C硬件D软件22、EDC系统在临床试验中的应用可以有效解决纸质CRF存在的问题,EDC是一种数据()系统。

面对巨大而复杂的网络系统以及浩如烟海的信息资 源,研究人员将传统的数据挖掘技术和相结合,进行Web 挖掘,从半结构或无结构的页面中,以及使用者的Web Web 活动中,抽取感兴趣的、潜在的模式,分析、研究,并加以利用。

挖掘可分为类:内容挖掘、结构挖掘和Web 3Web Web 日志挖掘。

而日志挖掘作为挖掘的一个重要组Web Web Web 成部分,有其独特的理论和实践意义。

所谓日志,是指在服务器上有关访问的各种日Web Web 志文件,包括访问日志、引用日志、代理日志、错误日志等文件。

这些文件里包含了大量的用户访问信息,如用户的IP 地址、所访问的、访问日期和时间、访问方法或URL (GET 、访问结果功、失败、错误、访问的信息大小等。

POST)()而日志挖掘,就是通过对日志记录的挖掘,发Web Web 现用户访问页面的模式,从而进一步分析和研究日Web Web 志记录中的规律,以期改进站点的性能和组织结构,提Web 高用户查找信息的质量和效率,并通过统计和关联的分析找出特定用户与特定地域、特定时间、特定页面等要素之间的内在联系,这在电子商务等领域是大有作为的。

日志挖掘技术1 Web 目前,日志挖掘技术主要分为两大类:基于事Web Web 务的方法和基于数据立方体的方法。

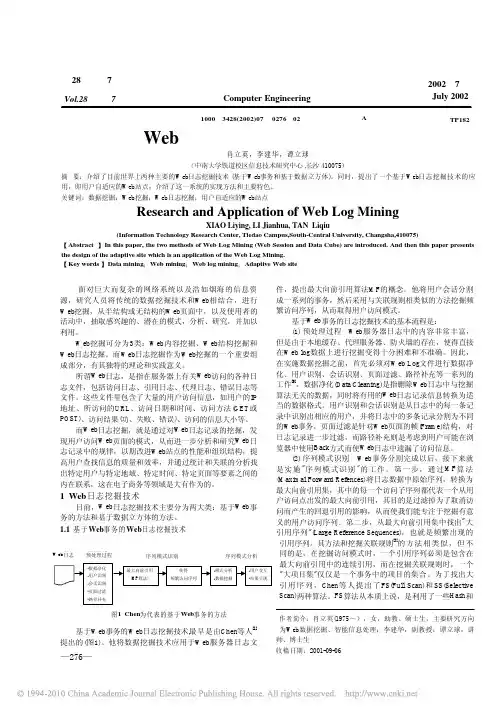

基于事务的日志挖掘技术1.1 Web Web 基于事务的日志挖掘技术最早是由等人Web Web ,Chen [1]提出的图。

他将数据挖掘技术应用于服务器日志文(1)Web 件,提出最大向前引用算法的概念。

他将用户会话分割MF 成一系列的事务,然后采用与关联规则相类似的方法挖掘频繁访问序列,从而取得用户访问模式。

基于事务的日志挖掘技术的基本流程是:Web 预处理过程服务器日志中的内容非常丰富,(1) Web 但是由于本地缓存、代理服务器、防火墙的存在,使得直接在数据上进行挖掘变得十分困难和不准确。

因此,Web log 在实施数据挖掘之前,首先必须对文件进行数据净Web Log 化、用户识别、会话识别、页面过滤、路径补充等一系列的工作[9]。

离线数据分析流程介绍流程介绍数据分析流程介绍离线数据分析3. 离线注:本环节主要感受数据分析系统的宏观概念及处理流程,初步理解hadoop等框架在其中的应⽤环节,不⽤过于关注代码细节⼀个应⽤⼴泛的数据分析系统:“web⽇志数据挖掘”3.1 需求分析3.1.1 案例名称“⽹站或APP点击流⽇志数据挖掘系统”。

3.1.2 案例需求描述“Web点击流⽇志”包含着⽹站运营很重要的信息,通过⽇志分析,我们可以知道⽹站的访问量,哪个⽹页访问⼈数最多,哪个⽹页最有价值,⼴告转化率、访客的来源信息,访客的终端信息等。

3.1.3 数据来源本案例的数据主要由⽤户的点击⾏为记录获取⽅式:在页⾯预埋⼀段js程序,为页⾯上想要监听的标签绑定事件,只要⽤户点击或移动到标签,即可触发ajax请求到后台servlet程序,⽤log4j记录下事件信息,从⽽在web服务器(nginx、tomcat等)上形成不断增长的⽇志⽂件。

形如:58.215.204.118 - - [18/Sep/2013:06:51:35 +0000] "GET /wp-includes/js/jquery/jquery.js?ver=1.10.2 HTTP/1.1" 304 0"http://blog.fens.me/nodejs-socketio-chat/" "Mozilla/5.0 (Windows NT 5.1;rv:23.0) Gecko/20100101 Firefox/23.0"3.2 数据处理流程3.2.1 流程图解析本案例跟典型的BI系统极其类似,整体流程如下:但是,由于本案例的前提是处理海量数据,因⽽,流程中各环节所使⽤的技术则跟传统BI完全不同,后续课程都会⼀⼀讲解:1) 数据采集:定制开发采集程序,或使⽤开源框架FLUME2) 数据预处理:定制开发mapreduce程序运⾏于hadoop集群3) 数据仓库技术:基于hadoop之上的Hive4) 数据导出:基于hadoop的sqoop数据导⼊导出⼯具5) 数据可视化:定制开发web程序或使⽤kettle等产品6) 整个过程的流程调度:hadoop⽣态圈中的oozie⼯具或其他类似开源产品3.2.2 项⽬技术架构图3.2.3 项⽬相关截图(感性认识,欣赏即可)a) Mapreudce程序运⾏b) 在Hive中查询数据c) 将统计结果导⼊mysql./sqoop export --connect jdbc:mysql://localhost:3306/weblogdb --username root --password root --table t_display_xx --export-dir/user/hive/warehouse/uv/dt=2014-08-033.3 项⽬最终效果经过完整的数据处理流程后,会周期性输出各类统计指标的报表,在⽣产实践中,最终需要将这些报表数据以可视化的形式展现出来,本案例采⽤web程序来实现数据可视化效果如下所⽰:。

信18与电16China Computer & Communication 软件打茨与龛用2020年第20期基于Hadoop 的Web 日志分析系统设计褚龙现陈婉冰(平顶山学院软件学院,河南平顶山467000)摘 要:电子商务网站在运行过程中会产生海量的访问日志数据,通过分析Web 日志可以获取有价值的信息,并为 网站运营提供决策支持.针对传统日志分析系统处理大数据能力不足的问题,本文提出基于Hadoop 分布式平台的日志分 析系统,充分利用HDFS 分布式存储能力和MapReduce 并行计算能力实现日志向点击流数据处理,借助Hive 数据仓库实 现日志分析。

关键词:Web 日志;点击流;Hadoop;数据仓库中图分类号:TP391 文献标识码:A 文章编号:1003-9767 (2020) 20-116-03Design of Web Logs Analysis System Based on HadoopChu Longxian, Chen Wanbing(Software College, Pingdingshan University, Pingdingshan Henan 467000, China)Abstract : Massive access logs data is generated during the operation of electronic commerce websites. Valuable information can be obtained by analyzing web logs to provide decision support for website operation. Aiming at the problem that the traditional log analysis system has insufficient ability to process big data, this paper proposes a log analysis system based on Hadoop distributed platform. It makes full use of HDFS distributed storage capacity and MapReduce parallel computing ability to realize log to click stream data processing, and uses hive data warehouse to realize log analysis. The designed system can effectively improve the processing and analysis of massive log data Ability.Key words: Web logs; click stream; Hadoop; data warehouse0引言随着互联网技术和Web 应用的迅猛发展,数以万亿的 Web 网页承载了海量的数据信息E 。

使用Hadoop进行社交媒体数据分析和用户行为挖掘在现代社会中,社交媒体已经成为人们生活中不可或缺的一部分。

无论是个人还是企业,都可以通过社交媒体平台与他人交流、分享信息和建立品牌形象。

然而,随着社交媒体的快速发展和用户数量的不断增加,如何从海量的社交媒体数据中准确提取有价值的信息,成为了一个重要的问题。

为了应对这个问题,许多研究者和企业开始使用Hadoop这一分布式计算框架进行社交媒体数据分析和用户行为挖掘。

Hadoop的分布式特性使得它能够处理大规模的数据,并且具备高可靠性和可扩展性。

下面将介绍一些使用Hadoop进行社交媒体数据分析和用户行为挖掘的方法和技术。

首先,社交媒体数据分析可以帮助企业了解用户的兴趣和需求,以便更好地满足他们的期望。

通过Hadoop,企业可以收集和分析用户在社交媒体平台上的行为数据,如点赞、评论、分享等。

通过对这些数据的分析,企业可以了解用户对不同内容的偏好,从而提供更加个性化和精准的服务。

例如,一家电商平台可以通过分析用户在社交媒体上的购物行为,推荐他们感兴趣的商品,提高销售额。

其次,社交媒体数据分析还可以帮助企业进行品牌监测和声誉管理。

通过Hadoop,企业可以收集和分析用户在社交媒体上对品牌的评论和评价。

通过对这些数据的分析,企业可以了解用户对品牌的态度和看法,及时发现和解决潜在的问题,提升品牌形象。

例如,一家餐饮企业可以通过分析用户在社交媒体上的点评和推荐,了解顾客对菜品口味和服务质量的评价,从而改进菜品和服务,提高用户满意度。

此外,社交媒体数据分析还可以帮助企业进行市场调研和竞争分析。

通过Hadoop,企业可以收集和分析用户在社交媒体上的讨论和观点。

通过对这些数据的分析,企业可以了解用户对不同产品和服务的需求和偏好,以及竞争对手的市场表现。

例如,一家汽车制造商可以通过分析用户在社交媒体上的讨论和推荐,了解用户对不同汽车品牌和型号的评价,从而调整产品定位和市场策略。

基于云计算的Hadoop大数据平台挖掘算法及实现研究作者:张文明来源:《无线互联科技》2021年第19期摘要:在Personal Computer技术的基础上,Hadoop大数据管理平台采用了一种新型的分布式数据集群管理系统,具有网络兼容性好、运行管理效率高、扩展应用能力强等特点,目前已经在很多行业中得到应用。

在此基础上,文章对 Hadoop新型大数据平台的设计基本特征及其实现进行了深入的阐述,并通过实例结合该数据平台的具体工作及设计原理,对 Hadoop大数据服务平台的主要功能及其平台实现应用情况进行了深入的分析研究。

关键词:云计算;Hadoop大数据平台;挖掘算法0 引言Hadoop技术软件是谷歌公司自行研发的一款项目,是现阶段在因特网上较为流行的一种内容编辑和分类工具,它可以很好地解决延展性和扩散性的问题。

例如,对海量文件信息进行字符串搜索和匹配,采用传统方法进行系统处理很可能会花费大量时间,而 Hadoop技术更适合于有效解决与之相关的问题。

它主要包括系统开发功能、数据采集与管理功能、数据存储与管理功能、数据挖掘的可视化及应用,本文重点分析了这些功能在数据挖掘中的实现情况。

1 Hadoop大数据平台设计Hadoop系统结构如图1所示[1]。

此方法在这个软件系统中采用最新的并行计算和数据处理方法,这种新的计算和并行处理方法的速度与对所有数据相关信息的并行处理速度相当,再加上 Hadoop这一技术本身具备高可伸缩性的特点,它还可以对数据信息进行有效的并行处理。

1.1 层级首先,分布式计算处理平台属于管理层,其主要设计目的是实现其在集群处理网络系统中的并行数据存储和综合计算等基本功能,为分布式系统和云系统的并行数据操作提供了一种处理模式,将处理任务从集群网络上顺利地直接传输出来,并将数据发送给集群服务器的各个工作节点。

其次,数据挖掘属于平台架构层,是整个平台架构的重要功能,主要目标是通过数据算法对数据进行并行分析,然后通过编写计算任务,将每项计算任务按实际分配值发送到平台Hadoop,这是数据挖掘平台的一个并行计算层,通过并行计算算法将计算结果发送到平台的任务管理层[2]。

基于Hadoop的电信业务日志分析系统的设计与实现中期报告一、选题背景随着移动互联网的普及和高速网络的发展,电信运营商积累了大量的日志数据。

这些日志数据包含着海量的用户行为信息和网络运营数据,对于电信运营商的业务运营和网络优化至关重要。

因此,如何高效地对这些数据进行分析和利用,成为电信行业亟待解决的问题。

在当前大数据技术的背景下,Hadoop作为分布式大数据处理的核心技术,已经在各行各业得到广泛的应用。

因此,利用Hadoop构建电信业务日志分析系统,具有重要意义和实际价值。

本课题的研究目的是设计和实现一个基于Hadoop的电信业务日志分析系统,为电信运营商的业务决策提供支持。

二、研究内容和计划(一)研究内容1.电信业务日志的采集和格式化通过Hadoop自带的数据采集工具Flume或Logstash实现采集,将采集到的日志转换成Hadoop可处理的格式。

2.电信业务日志数据的存储与检索采用Hadoop分布式文件系统(HDFS)作为存储介质,对海量的日志数据进行高效的存储和检索。

采用HBase或Elasticsearch构建索引,以提高数据检索的效率。

3.日志数据的清洗和预处理通过MapReduce编程和Hive SQL实现对日志数据的清洗和预处理,去除冗余数据、过滤异常数据,提取有用的数据信息。

4.电信业务日志数据的分析与挖掘采用MapReduce编程,通过编写自定义的Map和Reduce函数来实现各种分析指标的计算和统计,包括:用户活跃度、业务流量统计、网络拓扑分析等。

5.数据可视化和分析报告采用数据可视化工具(如Tableau)生成交互式的分析报告,为电信运营商提供直观的分析结果。

(二)研究计划1.选题立项和调研(完成时间:1周)明确系统需求和技术选型,调研相关技术和工具,确定实验环境。

2.系统设计与实现(完成时间:6周)(1)搭建Hadoop分布式集群,包括HDFS和YARN。

(2)设计和实现数据采集和格式化模块,采用Flume或Logstash 作为数据采集工具,将各个节点的日志数据集中到HDFS中。