第八章 多重共线性:解释变量相关会有什么后果1126

- 格式:ppt

- 大小:97.00 KB

- 文档页数:23

计量经济学练习题 一.名词解释1.普通最小二乘法(Ordinary Least Squares,OLS):已知一组样本观测值{}ni Y X i i ,2,1:),(⋯=,普通最小二乘法要求样本回归函数尽可以好地拟合这组值,即样本回归线上的点∧i Y 与真实观测点Yt 的“总体误差”尽可能地小。

普通最小二乘法给出的判断标准是:被解释变量的估计值与实际观测值之差的平方和最小。

2.广义最小二乘法GLS :加权最小二乘法具有比普通最小二乘法更普遍的意义,或者说普通最小二乘法只是加权最小二乘法中权恒取1时的一种特殊情况。

从此意义看,加权最小二乘法也称为广义最小二乘法。

3.加权最小二乘法WLS :加权最小二乘法是对原模型加权,使之变成一个新的不存在异方差性的模型,然后采用普通最小二乘法估计其参数。

4.工具变量法IV :工具变量法是克服解释变量与随机干扰项相关影响的一种参数估计方法。

5.两阶段最小二乘法2SLS, Two Stage Least Squares :两阶段最小二乘法是一种既适用于恰好识别的结构方程,以适用于过度识别的结构方程的单方程估计方法。

6.间接最小二乘法ILS :间接最小二乘法是先对关于内生解释变量的简化式方程采用普通小最二乘法估计简化式参数,得到简化式参数估计量,然后过通参数关系体系,计算得到结构式参数的估计量的一种方法。

7.异方差性Heteroskedasticity :对于不同的样本点,随机干扰项的方差不再是常数,而是互不相同,则认为出现了异方差性。

8.序列相关性Serial Correlation :多元线性回归模型的基本假设之一是模型的随机干扰项相互独立或不相关。

如果模型的随机干扰项违背了相互独立的基本假设,称为存在序列相关性。

9.多重共线性Multicollinearity :对于模型i k i i X X X Y μββββ++⋯+++=i k 22110i ,其基本假设之一是解释变量X 1,X 2,…,Xk 是相互独立的。

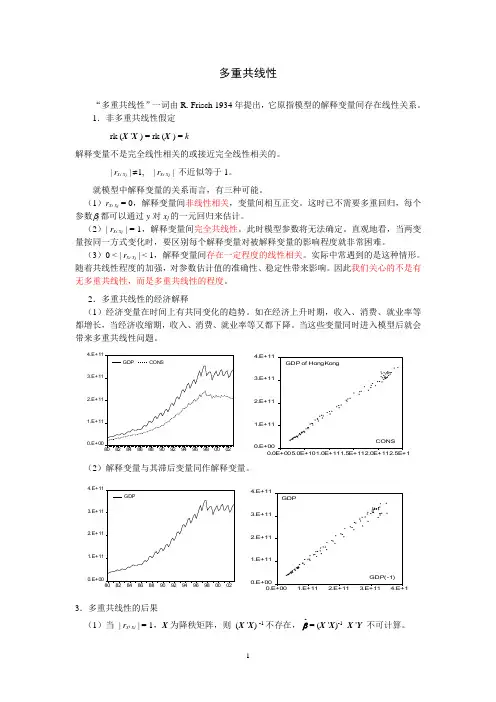

多重共线性“多重共线性”一词由R. Frisch 1934年提出,它原指模型的解释变量间存在线性关系。

1.非多重共线性假定 rk (X 'X ) = rk (X ) = k解释变量不是完全线性相关的或接近完全线性相关的。

| r x i x j | ≠1, | r x i x j | 不近似等于1。

就模型中解释变量的关系而言,有三种可能。

(1)r x i x j = 0,解释变量间非线性相关,变量间相互正交。

这时已不需要多重回归,每个参数βj 都可以通过y 对x j 的一元回归来估计。

(2)| r x i x j | = 1,解释变量间完全共线性。

此时模型参数将无法确定。

直观地看,当两变量按同一方式变化时,要区别每个解释变量对被解释变量的影响程度就非常困难。

(3)0 < | r x i x j | < 1,解释变量间存在一定程度的线性相关。

实际中常遇到的是这种情形。

随着共线性程度的加强,对参数估计值的准确性、稳定性带来影响。

因此我们关心的不是有无多重共线性,而是多重共线性的程度。

2.多重共线性的经济解释(1)经济变量在时间上有共同变化的趋势。

如在经济上升时期,收入、消费、就业率等都增长,当经济收缩期,收入、消费、就业率等又都下降。

当这些变量同时进入模型后就会带来多重共线性问题。

0.E+001.E+112.E+113.E+114.E+11808284868890929496980002GDPCONS0.E +001.E +112.E +113.E +114.E +110.0E +005.0E +101.0E +111.5E +112.0E +112.5E +11C O N SG D P o f H o n g K o n g(2)解释变量与其滞后变量同作解释变量。

0.E+001.E+112.E+113.E+114.E+11808284868890929496980002GDP0.E+001.E+112.E+113.E+114.E+110.E+001.E+112.E+113.E+114.E+11GDP(-1)GDP3.多重共线性的后果(1)当 | r x i x j | = 1,X 为降秩矩阵,则 (X 'X ) -1不存在,βˆ= (X 'X )-1 X 'Y 不可计算。

第8章 多重共线性:解释变量相关会有什么后果本章主要讲授如下内容:8.1 多重共线性的性质8.2 多重共线性产生的原因 8.3 多重共线性的后果8.4 多重共线性的诊断8.5 如何解决多重共线性:补救措施8.1 多重共线性的性质1.完全多重共线性的情形对于变量X 1、X 2……、X k ,如果存在不全为零的数λ1、λ2、……λk ,使得下式成立:02211=+++k k X X X λλλ则称变量X 1、X 2……、X k 之间存在一种完全的共线性。

注意:当解释变量之间存在完全共线性时,不可能获得所有参数的唯一估计值,因而也就不能根据样本进行任何统计推断(即假设检验)。

2.接近或者不完全多重共线性的情形对于变量X 1、X 2……、X k ,如果存在不全为零的数λ1、λ2、……λk ,使得下式成立:02211=++++μλλλk k X X X则称变量X 1、X 2……、X k 之间存在不完全的共线性。

这里,μ为随机误差项。

8.2 多重共线性产生的原因1.经济变量之间往往存在同方向的变化趋势。

2.经济变量之间往往存在着密切的关联度。

3.在模型中采用滞后变量也容易产生多重共线性。

4.在建模过程中由于解释变量选择不当引起了变量之间的多重共线性。

8.3 多重共线性的后果1.增大OLS 估计量的方差和标准差可以证明,参数估计值i b 的方差为:22211)()var(ii iti RX Xb -⋅-=∑σ其中,2i R 是第i 个解释变量对模型中其他解释变量作辅助回归模型),,,,,,(1121k i i i X X X X X f X +-=时的决定系数。

2.可能导致在假设检验中舍去重要的解释变量,检验的可靠性降低。

3.回归模型缺乏稳定性。

4.可能导致回归系数符号的错误。

8.4 多重共线性的诊断多重共线性只是存在的程度而非是否存在的问题,它属于样本特征而非总体特征。

一般可以采取以下方法进行诊断。

1.根据回归结果判断R 2较高但t 值统计显著的不多,这是多重共线性的“典型”特征。

在回归分析中,多重共线性是一个常见的问题。

多重共线性指的是自变量之间存在高度相关性,这会导致回归系数估计不准确,影响模型的解释性和预测能力。

在现实问题中,多重共线性经常出现,因此了解多重共线性的影响和解决方法是非常重要的。

一、多重共线性的影响多重共线性会导致回归系数估计不准确。

在存在多重共线性的情况下,自变量的系数估计可能偏离真实值,而且会出现符号与预期相反的情况。

这会影响对模型的解释,因为我们无法准确地评估每个自变量对因变量的影响程度。

同时,多重共线性也使得模型的预测能力下降,导致对未来数据的预测不准确。

二、多重共线性的检验为了检验模型中是否存在多重共线性,可以使用多种方法。

最常用的方法是计算自变量之间的相关系数。

如果相关系数大于或者,就可以认为存在多重共线性。

此外,还可以使用方差膨胀因子(VIF)来检验多重共线性。

VIF是用来衡量自变量之间相关性的指标,如果VIF的值大于10,就可以认为存在严重的多重共线性。

三、解决多重共线性的方法解决多重共线性问题的方法有很多种,下面介绍几种常用的方法。

1. 剔除相关性较高的自变量当自变量之间存在高度相关性时,可以选择剔除其中一个或几个自变量。

通常选择剔除与因变量相关性较低的自变量,以保留对因变量影响较大的自变量。

2. 使用主成分回归主成分回归是一种常用的解决多重共线性问题的方法。

它通过线性变换将原始的自变量转换为一组不相关的主成分变量,从而减少自变量之间的相关性。

主成分回归可以有效地解决多重共线性问题,并提高模型的解释性和预测能力。

3. 岭回归和套索回归岭回归和套索回归是一种正则化方法,可以在回归模型中加入惩罚项,从而减小自变量的系数估计。

这两种方法都可以有效地解决多重共线性问题,提高模型的鲁棒性和预测能力。

四、结语多重共线性是回归分析中的一个常见问题,会影响模型的解释性和预测能力。

为了解决多重共线性问题,我们可以使用多种方法,如剔除相关性较高的自变量、使用主成分回归、岭回归和套索回归等。