第八章多重共线性:解释变量相关会有什么后果1126案例

- 格式:ppt

- 大小:195.00 KB

- 文档页数:25

多元回归分析中的多重共线性及其解决方法在多元回归分析中,多重共线性是一个常见的问题,特别是在自变量之间存在高度相关性的情况下。

多重共线性指的是自变量之间存在线性相关性,这会造成回归模型的稳定性和可靠性下降,使得解释变量的效果难以准确估计。

本文将介绍多重共线性的原因及其解决方法。

一、多重共线性的原因多重共线性常常发生在自变量之间存在高度相关性的情况下,其主要原因有以下几点:1. 样本数据的问题:样本数据中可能存在过多的冗余信息,或者样本数据的分布不均匀,导致变量之间的相关性增加。

2. 选择自变量的问题:在构建回归模型时,选择了过多具有相似解释作用的自变量,这会增加自变量之间的相关性。

3. 数据采集的问题:数据采集过程中可能存在误差或者不完整数据,导致变量之间的相关性增加。

二、多重共线性的影响多重共线性会对多元回归模型的解释变量产生不良影响,主要表现在以下几个方面:1. 回归系数的不稳定性:多重共线性使得回归系数的估计不稳定,难以准确反映各个自变量对因变量的影响。

2. 系数估计值的无效性:多重共线性会导致回归系数估计偏离其真实值,使得对因变量的解释变得不可靠。

3. 预测的不准确性:多重共线性使得模型的解释能力下降,导致对未知数据的预测不准确。

三、多重共线性的解决方法针对多重共线性问题,我们可以采取以下几种方法来解决:1. 剔除相关变量:通过计算自变量之间的相关系数,发现高度相关的变量,选择其中一个作为代表,将其他相关变量剔除。

2. 主成分分析:主成分分析是一种降维技术,可以通过线性变换将原始自变量转化为一组互不相关的主成分,从而降低多重共线性造成的影响。

3. 岭回归:岭回归是一种改良的最小二乘法估计方法,通过在回归模型中加入一个惩罚项,使得回归系数的估计更加稳定。

4. 方差膨胀因子(VIF):VIF可以用来检测自变量之间的相关性程度,若某个自变量的VIF值大于10,则表明该自变量存在较高的共线性,需要进行处理。

多重共线性案例:变量Y,X1,X2,X3,X4,X5的数据年Y X1X2X3X4X51974 98.45 560.2 153.20 6.53 1.23 1.891975 100.70 603.11 190.00 9.12 1.30 2.031976 102.80 668.05 240.30 8.10 1.80 2.711977 133.95 715.47 301.12 10.10 2.09 3.001978 140.13 724.27 361.00 10.93 2.39 3.291979 143.11 736.13 420.00 11.85 3.90 5.241980 146.15 748.91 491.76 12.28 5.13 6.831981 144.60 760.32 501.00 13.50 5.47 8.361982 148.94 774.92 529.20 15.29 6.09 10.071983 158.55 785.30 552.72 18.10 7.97 12.571984 169.68 795.50 771.16 19.61 10.18 15.121985 162.14 804.80 811.80 17.22 11.79 18.251986 170.09 814.94 988.43 18.60 11.54 20.591987 178.69 828.73 1094.65 23.53 11.68 23.37资料来源:《天津统计年鉴》1988.用1974-1987年数据建立天津市粮食需求模型如下,Y = -3.49 + 0.13 X1 + 0.07 X2 + 2.67 X3 + 3.44 X4– 4.49 X5(-0.11) (2.12) (1.95) (2.13) (1.41) (-2.03)R2 = 0.97, F = 52.59, T = 14, t0.05(8) = 2.31, (1974-1987)其中Y:粮食销售量(万吨/ 年),X1:市常住人口数(万人),X2:人均收入(元/ 年),X3:肉销售量(万吨/ 年),X4:蛋销售量(万吨/ 年),X5:鱼虾销售量(万吨/ 年)。

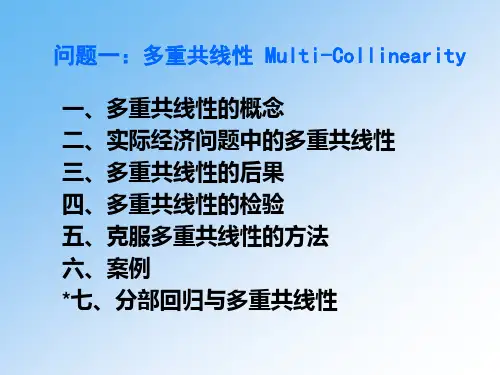

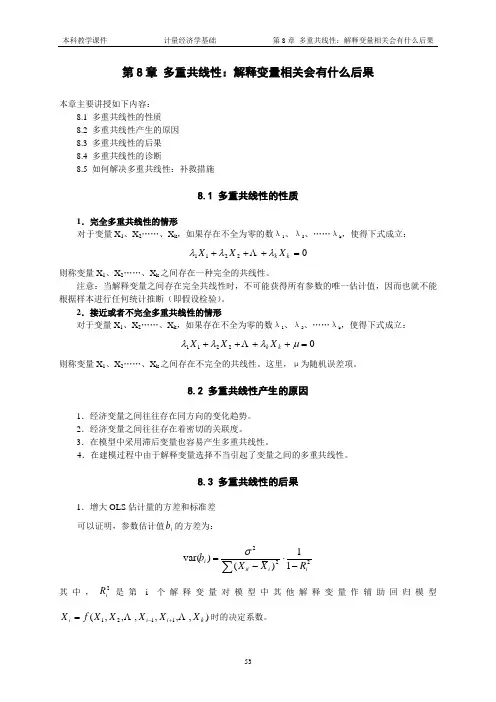

第8章 多重共线性:解释变量相关会有什么后果本章主要讲授如下内容:8.1 多重共线性的性质8.2 多重共线性产生的原因 8.3 多重共线性的后果8.4 多重共线性的诊断8.5 如何解决多重共线性:补救措施8.1 多重共线性的性质1.完全多重共线性的情形对于变量X 1、X 2……、X k ,如果存在不全为零的数λ1、λ2、……λk ,使得下式成立:02211=+++k k X X X λλλ则称变量X 1、X 2……、X k 之间存在一种完全的共线性。

注意:当解释变量之间存在完全共线性时,不可能获得所有参数的唯一估计值,因而也就不能根据样本进行任何统计推断(即假设检验)。

2.接近或者不完全多重共线性的情形对于变量X 1、X 2……、X k ,如果存在不全为零的数λ1、λ2、……λk ,使得下式成立:02211=++++μλλλk k X X X则称变量X 1、X 2……、X k 之间存在不完全的共线性。

这里,μ为随机误差项。

8.2 多重共线性产生的原因1.经济变量之间往往存在同方向的变化趋势。

2.经济变量之间往往存在着密切的关联度。

3.在模型中采用滞后变量也容易产生多重共线性。

4.在建模过程中由于解释变量选择不当引起了变量之间的多重共线性。

8.3 多重共线性的后果1.增大OLS 估计量的方差和标准差可以证明,参数估计值i b 的方差为:22211)()var(ii iti RX Xb -⋅-=∑σ其中,2i R 是第i 个解释变量对模型中其他解释变量作辅助回归模型),,,,,,(1121k i i i X X X X X f X +-=时的决定系数。

2.可能导致在假设检验中舍去重要的解释变量,检验的可靠性降低。

3.回归模型缺乏稳定性。

4.可能导致回归系数符号的错误。

8.4 多重共线性的诊断多重共线性只是存在的程度而非是否存在的问题,它属于样本特征而非总体特征。

一般可以采取以下方法进行诊断。

1.根据回归结果判断R 2较高但t 值统计显著的不多,这是多重共线性的“典型”特征。