matlab四种支持向量机工具箱

- 格式:doc

- 大小:29.00 KB

- 文档页数:3

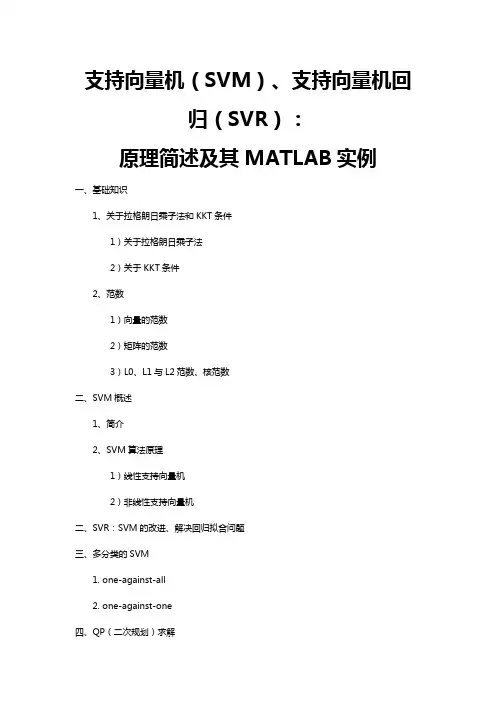

支持向量机(SVM)、支持向量机回归(SVR):原理简述及其MATLAB实例一、基础知识1、关于拉格朗日乘子法和KKT条件1)关于拉格朗日乘子法2)关于KKT条件2、范数1)向量的范数2)矩阵的范数3)L0、L1与L2范数、核范数二、SVM概述1、简介2、SVM算法原理1)线性支持向量机2)非线性支持向量机二、SVR:SVM的改进、解决回归拟合问题三、多分类的SVM1. one-against-all2. one-against-one四、QP(二次规划)求解五、SVM的MATLAB实现:Libsvm1、Libsvm工具箱使用说明2、重要函数:3、示例支持向量机(SVM):原理及其MATLAB实例一、基础知识1、关于拉格朗日乘子法和KKT条件1)关于拉格朗日乘子法首先来了解拉格朗日乘子法,为什么需要拉格朗日乘子法呢?记住,有需要拉格朗日乘子法的地方,必然是一个组合优化问题。

那么带约束的优化问题很好说,就比如说下面这个:这是一个带等式约束的优化问题,有目标值,有约束条件。

那么你可以想想,假设没有约束条件这个问题是怎么求解的呢?是不是直接 f 对各个 x 求导等于 0,解 x 就可以了,可以看到没有约束的话,求导为0,那么各个x均为0吧,这样f=0了,最小。

但是x都为0不满足约束条件呀,那么问题就来了。

有了约束不能直接求导,那么如果把约束去掉不就可以了吗?怎么去掉呢?这才需要拉格朗日方法。

既然是等式约束,那么我们把这个约束乘一个系数加到目标函数中去,这样就相当于既考虑了原目标函数,也考虑了约束条件。

现在这个优化目标函数就没有约束条件了吧,既然如此,求法就简单了,分别对x求导等于0,如下:把它在带到约束条件中去,可以看到,2个变量两个等式,可以求解,最终可以得到,这样再带回去求x就可以了。

那么一个带等式约束的优化问题就通过拉格朗日乘子法完美的解决了。

更高一层的,带有不等式的约束问题怎么办?那么就需要用更一般化的拉格朗日乘子法,即KKT条件,来解决这种问题了。

(整理)matlab部分工具箱.1)通讯工具箱(Communication Toolbox)。

令提供100多个函数和150多个SIMULINK模块用于通讯系统的仿真和分析——信号编码——调制解调——滤波器和均衡器设计——通道模型——同步可由结构图直接生成可应用的C语言源代码。

2)控制系统工具箱(Control System Toolbox)。

鲁连续系统设计和离散系统设计* 状态空间和传递函数* 模型转换* 频域响应:Bode图、Nyquist图、Nichols图* 时域响应:冲击响应、阶跃响应、斜波响应等* 根轨迹、极点配置、LQG3)财政金融工具箱(FinancialTooLbox)。

* 成本、利润分析,市场灵敏度分析* 业务量分析及优化* 偏差分析* 资金流量估算* 财务报表4)频率域系统辨识工具箱(Frequency Domain System ldentification Toolbox* 辨识具有未知延迟的连续和离散系统* 计算幅值/相位、零点/极点的置信区间* 设计周期激励信号、最小峰值、最优能量诺等5)模糊逻辑工具箱(Fuzzy Logic Toolbox)。

* 友好的交互设计界面* 自适应神经—模糊学习、聚类以及Sugeno推理* 支持SIMULINK动态仿真* 可生成C语言源代码用于实时应用(6)高阶谱分析工具箱(Higher—Order SpectralAnalysis Toolbox * 高阶谱估计* 信号中非线性特征的检测和刻画* 延时估计* 幅值和相位重构* 阵列信号处理* 谐波重构(7)图像处理工具箱(Image Processing T oolbox)。

* 二维滤波器设计和滤波* 图像恢复增强* 色彩、集合及形态操作* 二维变换* 图像分析和统计(8)线性矩阵不等式控制工具箱(LMI Control Toolbox)。

* LMI的基本用途* 基于GUI的LMI编辑器* LMI问题的有效解法* LMI问题解决方案(9)模型预测控制工具箱(ModelPredictive Control Toolbox* 建模、辨识及验证* 支持MISO模型和MIMO模型* 阶跃响应和状态空间模型(10)u分析与综合工具箱(u-Analysis and Synthesis Toolbox)* u分析与综合* H2和H无穷大最优综合* 模型降阶* 连续和离散系统* u分析与综合理论(11)神经网络工具箱(Neursl Network T oolbox)。

MATLAB工具箱的使用MATLAB®是一种强大的科学计算软件,广泛应用于各个领域的数学建模、数据分析、仿真和算法开发等工作中。

为了满足不同领域的需求,MATLAB提供了许多不同的工具箱。

这些工具箱包含了各种不同领域的函数和工具,可以帮助用户更加高效地进行数据处理、模拟和算法开发等工作。

下面将介绍几个常用的MATLAB工具箱,以及它们的使用方法:1.信号处理工具箱(Signal Processing Toolbox):这个工具箱提供了一系列处理数字信号的函数和工具。

用户可以使用这些函数和工具进行信号滤波、功率谱估计、频谱分析、时间频率分析等操作。

该工具箱还提供了许多基本信号处理算法,如滤波器设计、卷积和相关等。

例如,用户可以使用`filtfilt(`函数对信号进行零相移滤波,以去除噪声。

2.图像处理工具箱(Image Processing Toolbox):图像处理工具箱提供了一系列处理数字图像的函数和工具。

用户可以使用这些函数和工具进行图像的读取、显示、修改、增强和分析等操作。

该工具箱包含了许多常用的图像处理算法,如图像滤波、边缘检测、形态学处理和图像分割等。

例如,用户可以使用`imread(`函数读取图像,然后使用`imshow(`函数显示图像。

3.控制系统工具箱(Control System Toolbox):这个工具箱提供了一系列用于分析和设计控制系统的函数和工具。

用户可以使用这些函数和工具进行控制系统的建模、稳定性分析、根轨迹设计和频域分析等操作。

该工具箱还提供了许多常用的控制系统设计方法,如PID控制器设计和状态空间控制器设计等。

例如,用户可以使用`tf(`函数创建传递函数模型,然后使用`step(`函数绘制系统的阶跃响应。

4.优化工具箱(Optimization Toolbox):优化工具箱提供了一系列用于求解优化问题的函数和工具。

用户可以使用这些函数和工具进行线性规划、非线性规划和整数规划等操作。

四种支持向量机用于函数拟合与模式识别的Matlab示例程序陆振波点这里下载:四种支持向量机用于函数拟合与模式识别的Matlab示例程序使用要点:应研学论坛《人工智能与模式识别》版主magic_217之约,写一个关于针对初学者的《四种支持向量机工具箱》的详细使用说明。

同时也不断有网友向我反映看不懂我的源代码,以及询问如何将该工具箱应用到实际数据分析等问题,其中有相当一部分网友并不了解模式识别的基本概念,就急于使用这个工具箱。

本文从模式识别的基本概念谈起,过渡到神经网络模式识别,逐步引入到这四种支持向量机工具箱的使用。

本文适合没有模式识别基础,而又急于上手的初学者。

作者水平有限,欢迎同行批评指正![1]模式识别基本概念模式识别的方法有很多,常用有:贝叶斯决策、神经网络、支持向量机等等。

特别说明的是,本文所谈及的模式识别是指“有师分类”,即事先知道训练样本所属的类别,然后设计分类器,再用该分类器对测试样本进行识别,比较测试样本的实际所属类别与分类器输出的类别,进而统计正确识别率。

正确识别率是反映分类器性能的主要指标。

分类器的设计虽然是模式识别重要一环,但是样本的特征提取才是模式识别最关键的环节。

试想如果特征矢量不能有效地描述原样本,那么即使分类设计得再好也无法实现正确分类。

工程中我们所遇到的样本一般是一维矢量,如:语音信号,或者是二维矩阵,如:图片等。

特征提取就是将一维矢量或二维矩阵转化成一个维数比较低的特征矢量,该特征矢量用于分类器的输入。

关于特征提取,在各专业领域中也是一个重要的研究方向,如语音信号的谐振峰特征提取,图片的PCA特征提取等等。

[2]神经网络模式识别神经网络模式识别的基本原理是,神经网络可以任意逼近一个多维输入输出函数。

以三类分类:I、II、III为例,神经网络输入是样本的特征矢量,三类样本的神经网络输出可以是[1;0;0]、[0;1;0]、[0;0;1],也可以是[1;-1;-1]、[-1;1;-1]、[-1;-1;1]。

⽀持向量机的smo算法(MATLABcode)建⽴smo.m% function [alpha,bias] = smo(X, y, C, tol)function model = smo(X, y, C, tol)% SMO: SMO algorithm for SVM%%Implementation of the Sequential Minimal Optimization (SMO)%training algorithm for Vapnik's Support Vector Machine (SVM)%% This is a modified code from Gavin Cawley's MATLAB Support% Vector Machine Toolbox% (c) September 2000.%% Diego Andres Alvarez.%% USAGE: [alpha,bias] = smo(K, y, C, tol)%% INPUT:%% K: n x n kernel matrix% y: 1 x n vector of labels, -1 or 1% C: a regularization parameter such that 0 <= alpha_i <= C/n% tol: tolerance for terminating criterion%% OUTPUT:%% alpha: 1 x n lagrange multiplier coefficient% bias: scalar bias (offset) term% Input/output arguments modified by JooSeuk Kim and Clayton Scott, 2007global SMO;y = y';ntp = size(X,1);%recompute C% C = C/ntp;%initializeii0 = find(y == -1);ii1 = find(y == 1);i0 = ii0(1);i1 = ii1(1);alpha_init = zeros(ntp, 1);alpha_init(i0) = C;alpha_init(i1) = C;bias_init = C*(X(i0,:)*X(i1,:)' -X(i0,:)*X(i1,:)') + 1;%Inicializando las variablesSMO.epsilon = 10^(-6); SMO.tolerance = tol;SMO.y = y'; SMO.C = C;SMO.alpha = alpha_init; SMO.bias = bias_init;SMO.ntp = ntp; %number of training points%CACHES:SMO.Kcache = X*X'; %kernel evaluationsSMO.error = zeros(SMO.ntp,1); %errornumChanged = 0; examineAll = 1;%When all data were examined and no changes done the loop reachs its%end. Otherwise, loops with all data and likely support vector are%alternated until all support vector be found.while ((numChanged > 0) || examineAll)numChanged = 0;if examineAll%Loop sobre todos los puntosfor i = 1:ntpnumChanged = numChanged + examineExample(i);end;else%Loop sobre KKT pointsfor i = 1:ntp%Solo los puntos que violan las condiciones KKTnumChanged = numChanged + examineExample(i);end;end;end;if (examineAll == 1)examineAll = 0;elseif (numChanged == 0)examineAll = 1;end;end;alpha = SMO.alpha';alpha(alpha < SMO.epsilon) = 0;alpha(alpha > C-SMO.epsilon) = C;bias = -SMO.bias;model.w = (y.*alpha)* X; %%%%%%%%%%%%%%%%%%%%%%model.b = bias;return;function RESULT = fwd(n)global SMO;LN = length(n);RESULT = -SMO.bias + sum(repmat(SMO.y,1,LN) .* repmat(SMO.alpha,1,LN) .* SMO.Kcache(:,n))'; return;function RESULT = examineExample(i2)%First heuristic selects i2 and asks to examineExample to find a%second point (i1) in order to do an optimization step with two%Lagrange multipliersglobal SMO;alpha2 = SMO.alpha(i2); y2 = SMO.y(i2);if ((alpha2 > SMO.epsilon) && (alpha2 < (SMO.C-SMO.epsilon)))e2 = SMO.error(i2);elsee2 = fwd(i2) - y2;end;% r2 < 0 if point i2 is placed between margin (-1)-(+1)% Otherwise r2 is > 0. r2 = f2*y2-1r2 = e2*y2;%KKT conditions:% r2>0 and alpha2==0 (well classified)% r2==0 and 0% r2<0 and alpha2==C (support vectors between margins)%% Test the KKT conditions for the current i2 point.%% If a point is well classified its alpha must be 0 or if% it is out of its margin its alpha must be C. If it is at margin% its alpha must be between 0%take action only if i2 violates Karush-Kuhn-Tucker conditionsif ((r2 < -SMO.tolerance) && (alpha2 < (SMO.C-SMO.epsilon))) || ...((r2 > SMO.tolerance) && (alpha2 > SMO.epsilon))% If it doens't violate KKT conditions then exit, otherwise continue.%Try i2 by three ways; if successful, then immediately return 1;RESULT = 1;% First the routine tries to find an i1 lagrange multiplier that% maximizes the measure |E1-E2|. As large this value is as bigger% the dual objective function becames.% In this first test, only support vectors will be tested.POS = find((SMO.alpha > SMO.epsilon) & (SMO.alpha < (SMO.C-SMO.epsilon)));[MAX,i1] = max(abs(e2 - SMO.error(POS)));if ~isempty(i1)if takeStep(i1, i2, e2), return;end;end;%The second heuristic choose any Lagrange Multiplier that is a SV and tries to optimizefor i1 = randperm(SMO.ntp)if (SMO.alpha(i1) > SMO.epsilon) & (SMO.alpha(i1) < (SMO.C-SMO.epsilon))%if a good i1 is found, optimiseif takeStep(i1, i2, e2), return;end;endend%if both heuristc above fail, iterate over all data setfor i1 = randperm(SMO.ntp)if takeStep(i1, i2, e2), return;end;endend;end;%no progress possibleRESULT = 0;return;function RESULT = takeStep(i1, i2, e2)% for a pair of alpha indexes, verify if it is possible to execute% the optimisation described by Platt.global SMO;RESULT = 0;if (i1 == i2), return;end;% compute upper and lower constraints, L and H, on multiplier a2alpha1 = SMO.alpha(i1); alpha2 = SMO.alpha(i2);y1 = SMO.y(i1); y2 = SMO.y(i2);C = SMO.C; K = SMO.Kcache;s = y1*y2;if (y1 ~= y2)L = max(0, alpha2-alpha1); H = min(C, alpha2-alpha1+C);elseL = max(0, alpha1+alpha2-C); H = min(C, alpha1+alpha2);end;if (L == H), return;end;if (alpha1 > SMO.epsilon) & (alpha1 < (C-SMO.epsilon))e1 = SMO.error(i1);elsee1 = fwd(i1) - y1;end;%if (alpha2 > SMO.epsilon) & (alpha2 < (C-SMO.epsilon))% e2 = SMO.error(i2);%else% e2 = fwd(i2) - y2;%end;%compute etak11 = K(i1,i1); k12 = K(i1,i2); k22 = K(i2,i2);eta = 2.0*k12-k11-k22;%recompute Lagrange multiplier for pattern i2if (eta < 0.0)a2 = alpha2 - y2*(e1 - e2)/eta;%constrain a2 to lie between L and Hif (a2 < L)a2 = L;elseif (a2 > H)a2 = H;end;else%When eta is not negative, the objective function W should be%evaluated at each end of the line segment. Only those terms in the%objective function that depend on alpha2 need be evaluated...ind = find(SMO.alpha>0);aa2 = L; aa1 = alpha1 + s*(alpha2-aa2);Lobj = aa1 + aa2 + sum((-y1*aa1/2).*SMO.y(ind).*K(ind,i1) + (-y2*aa2/2).*SMO.y(ind).*K(ind,i2)); aa2 = H; aa1 = alpha1 + s*(alpha2-aa2);Hobj = aa1 + aa2 + sum((-y1*aa1/2).*SMO.y(ind).*K(ind,i1) + (-y2*aa2/2).*SMO.y(ind).*K(ind,i2)); if (Lobj>Hobj+SMO.epsilon)a2 = H;elseif (Lobj<Hobj-SMO.epsilon)a2 = L;elsea2 = alpha2;end;if (abs(a2-alpha2) < SMO.epsilon*(a2+alpha2+SMO.epsilon))return;end;% recompute Lagrange multiplier for pattern i1a1 = alpha1 + s*(alpha2-a2);w1 = y1*(a1 - alpha1); w2 = y2*(a2 - alpha2);%update threshold to reflect change in Lagrange multipliersb1 = SMO.bias + e1 + w1*k11 + w2*k12;bold = SMO.bias;if (a1>SMO.epsilon) & (a1<(C-SMO.epsilon))SMO.bias = b1;elseb2 = SMO.bias + e2 + w1*k12 + w2*k22;if (a2>SMO.epsilon) & (a2<(C-SMO.epsilon))SMO.bias = b2;elseSMO.bias = (b1 + b2)/2;end;end;% update error cache using new Lagrange multipliersSMO.error = SMO.error + w1*K(:,i1) + w2*K(:,i2) + bold - SMO.bias;SMO.error(i1) = 0.0; SMO.error(i2) = 0.0;% update vector of Lagrange multipliersSMO.alpha(i1) = a1; SMO.alpha(i2) = a2;%report progress madeRESULT = 1;return;画图⽂件:start_SMOforSVM.m(点击⾃动⽣成⼆维两类数据,画图,这⾥只是线性的,⾮线性的可以对应修改) clearX = []; Y=[];figure;% Initialize training data to empty; will get points from user% Obtain points froom the user:trainPoints=X;trainLabels=Y;clf;axis([-5 5 -5 5]);if isempty(trainPoints)% Define the symbols and colors we'll use in the plots latersymbols = {'o','x'};classvals = [-1 1];trainLabels=[];hold on; % Allow for overwriting existing plotsxlim([-5 5]); ylim([-5 5]);for c = 1:2title(sprintf('Click to create points from class %d. Press enter when finished.', c));[x, y] = getpts;plot(x,y,symbols{c},'LineWidth', 2, 'Color', 'black');% Grow the data and label matricestrainPoints = vertcat(trainPoints, [x y]);trainLabels = vertcat(trainLabels, repmat(classvals(c), numel(x), 1));endend% C = 10;tol = 0.001;% par = SMOforSVM(trainPoints, trainLabels , C, tol );% p=length(par.b); m=size(trainPoints,2);% if m==2% % for i=1:p% % plot(X(lc(i)-l(i)+1:lc(i),1),X(lc(i)-l(i)+1:lc(i),2),'bo')% % hold on% % end% k = -par.w(1)/par.w(2);% b0 = - par.b/par.w(2);% bdown=(-par.b-1)/par.w(2);% bup=(-par.b+1)/par.w(2);% for i=1:p% hold on% h = refline(k,b0(i));% set(hdown, 'Color', 'b')% hup=refline(k,bup(i));% set(hup, 'Color', 'b')% end% end% xlim([-5 5]); ylim([-5 5]);%% pauseC = 10;tol = 0.001;par = smo(trainPoints, trainLabels, C, tol);p=length(par.b); m=size(trainPoints,2);if m==2% for i=1:p% plot(X(lc(i)-l(i)+1:lc(i),1),X(lc(i)-l(i)+1:lc(i),2),'bo') % hold on% endk = -par.w(1)/par.w(2);b0 = - par.b/par.w(2);bdown=(-par.b-1)/par.w(2);bup=(-par.b+1)/par.w(2);for i=1:phold onh = refline(k,b0(i));set(h, 'Color', 'r')hdown=refline(k,bdown(i));set(hdown, 'Color', 'b')hup=refline(k,bup(i));set(hup, 'Color', 'b')endendxlim([-5 5]); ylim([-5 5]);。

MATLAB_智能算法30个案例分析1.线性回归:使用MATLAB的回归工具箱,对给定的数据集进行线性回归分析,获取拟合的直线方程。

2.逻辑回归:使用MATLAB的分类工具箱,对给定的数据集进行逻辑回归分析,建立分类模型。

3.K均值聚类:使用MATLAB的聚类工具箱,对给定的数据集进行K 均值聚类算法,将数据集分为多个簇。

4.支持向量机:使用MATLAB的SVM工具箱,对给定的数据集进行支持向量机算法,建立分类或回归模型。

5.决策树:使用MATLAB的分类工具箱,对给定的数据集进行决策树分析,建立决策模型。

6.随机森林:使用MATLAB的分类和回归工具箱,对给定的数据集进行随机森林算法,集成多个决策树模型。

7. AdaBoost:使用MATLAB的分类工具箱,对给定的数据集进行AdaBoost算法,提升分类性能。

8.遗传算法:使用MATLAB的全局优化工具箱,利用遗传算法进行优化问题的求解。

9.粒子群优化:使用MATLAB的全局优化工具箱,利用粒子群优化算法进行优化问题的求解。

10.模拟退火算法:使用MATLAB的全局优化工具箱,利用模拟退火算法进行优化问题的求解。

11.神经网络:使用MATLAB的神经网络工具箱,构建和训练多层感知机模型。

12.卷积神经网络:使用MATLAB的深度学习工具箱,构建和训练卷积神经网络模型。

13.循环神经网络:使用MATLAB的深度学习工具箱,构建和训练循环神经网络模型。

14.长短期记忆网络:使用MATLAB的深度学习工具箱,构建和训练长短期记忆网络模型。

15.GAN(生成对抗网络):使用MATLAB的深度学习工具箱,构建和训练生成对抗网络模型。

16.自编码器:使用MATLAB的深度学习工具箱,构建和训练自编码器模型。

17.强化学习:使用MATLAB的强化学习工具箱,构建和训练强化学习模型。

18.关联规则挖掘:使用MATLAB的数据挖掘工具箱,发现数据中的关联规则。

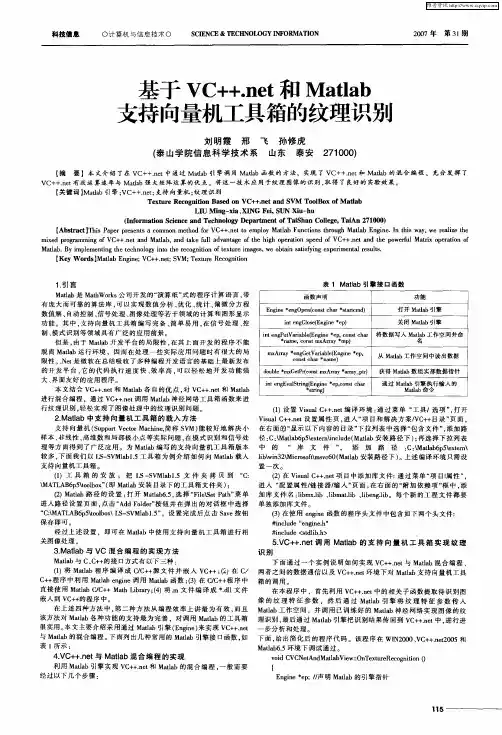

第24卷第12期 计算机应用与软件Vol 124No .122007年12月 Computer App licati ons and Soft w are Dec .2007收稿日期:2006-01-20。

江苏省自然科学基金项目(BK2003026)。

郭小荟,讲师,主研领域:软件工程,故障诊断,人工智能应用等。

基于M a tl ab 的支持向量机工具箱郭小荟1,2 马小平11(中国矿业大学信息与电气工程学院 江苏徐州221008)2(徐州师范大学计算机科学与技术学院 江苏徐州221116)摘 要 介绍了基于MAT LAB 的支持向量机工具箱,详细说明了工具箱中用于支持向量分类和支持向量回归的函数。

并通过两个具体的实例来说明利用S VM 工具箱进行分类和回归方面的方法。

关键词 Matlab 支持向量机工具箱 分类 回归SUPPO RT VECTO R M ACH INES TOOL BO X IN M ATLAB ENV IRO N M ENTGuo Xiaohui 1,2 Ma Xiaop ing11(College of Infor m ation and E lectrical Engineering,CUM T,Xuzhou 221008,J iangsu,China )2(College of Co m puter Science and Technology,XZNU,Xuzhou 221116,J iangsu,China )Abstract Support vect or machines (S VM )t oolbox in MAT LAB envir on ment is briefly intr oduced,and an extensively overvie w of the entire collecti on of t oolbox functi ons used t o support vect or classificati on and support vect or regressi on is given .And t w o exa mp les are p resented t o il 2lustrate how t o s olve classificati on and regressi on p r oblem s with the S VM t oolbox .Keywords Matlab Support vect or machines Classificati on Regressi on0 引 言MAT LAB 已经成为国际上最流行的科学与工程计算的软件工具,现在的MAT LAB 已经不仅仅是一个“矩阵实验室”了,它已经成为一种具有广泛应用前景的全新的计算机高级编程语言,有人称它为“第四代”计算机语言,MAT LAB 语言的功能越来越强大。

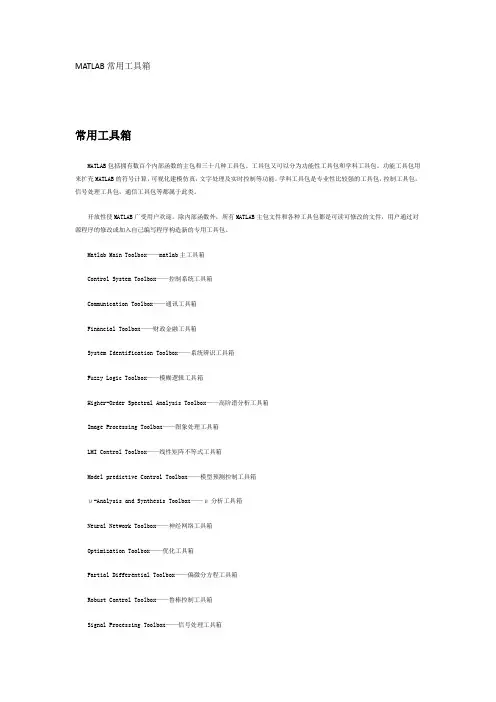

MATLAB常用工具箱常用工具箱MATLAB包括拥有数百个内部函数的主包和三十几种工具包。

工具包又可以分为功能性工具包和学科工具包。

功能工具包用来扩充MATLAB的符号计算,可视化建模仿真,文字处理及实时控制等功能。

学科工具包是专业性比较强的工具包,控制工具包,信号处理工具包,通信工具包等都属于此类。

开放性使MATLAB广受用户欢迎。

除内部函数外,所有MATLAB主包文件和各种工具包都是可读可修改的文件,用户通过对源程序的修改或加入自己编写程序构造新的专用工具包。

Matlab Main Toolbox——matlab主工具箱Control System Toolbox——控制系统工具箱Communication Toolbox——通讯工具箱Financial Toolbox——财政金融工具箱System Identification Toolbox——系统辨识工具箱Fuzzy Logic Toolbox——模糊逻辑工具箱Higher-Order Spectral Analysis Toolbox——高阶谱分析工具箱Image Processing Toolbox——图象处理工具箱LMI Control Toolbox——线性矩阵不等式工具箱Model predictive Control Toolbox——模型预测控制工具箱μ-Analysis and Synthesis Toolbox——μ分析工具箱Neural Network Toolbox——神经网络工具箱Optimization Toolbox——优化工具箱Partial Differential Toolbox——偏微分方程工具箱Robust Control Toolbox——鲁棒控制工具箱Signal Processing Toolbox——信号处理工具箱Spline Toolbox——样条工具箱Statistics Toolbox——统计工具箱Symbolic Math Toolbox——符号数学工具箱Simulink Toolbox——动态仿真工具箱Wavele Toolbox——小波工具箱常用函数Matlab内部常数[3]eps:浮点相对精度exp:自然对数的底数ei 或 j:基本虚数单位inf 或 Inf:无限大,例如1/0nan或NaN:非数值(Not a number),例如0/0 pi:圆周率 p(= 3.1415926...)realmax:系统所能表示的最大数值realmin:系统所能表示的最小数值nargin: 函数的输入引数个数nargout: 函数的输出引数个数lasterr:存放最新的错误信息lastwarn:存放最新的警告信息MATLAB常用基本数学函数abs(x):纯量的绝对值或向量的长度angle(z):复数z的相角(Phase angle)sqrt(x):开平方real(z):复数z的实部imag(z):复数z的虚部conj(z):复数z的共轭复数round(x):四舍五入至最近整数fix(x):无论正负,舍去小数至最近整数floor(x):下取整,即舍去正小数至最近整数ceil(x):上取整,即加入正小数至最近整数rat(x):将实数x化为多项分数展开rats(x):将实数x化为分数表示sign(x):符号函数 (Signum function)。

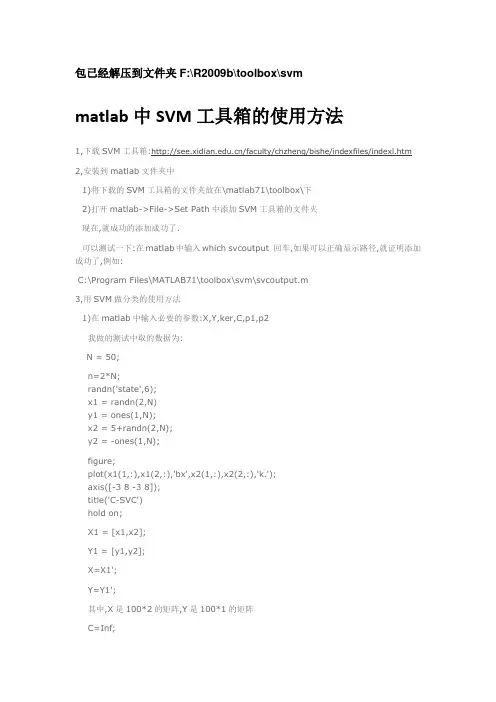

包已经解压到文件夹F:\R2009b\toolbox\svmmatlab中SVM工具箱的使用方法1,下载SVM工具箱:/faculty/chzheng/bishe/indexfiles/indexl.htm 2,安装到matlab文件夹中1)将下载的SVM工具箱的文件夹放在\matlab71\toolbox\下2)打开matlab->File->Set Path中添加SVM工具箱的文件夹现在,就成功的添加成功了.可以测试一下:在matlab中输入which svcoutput 回车,如果可以正确显示路径,就证明添加成功了,例如:C:\Program Files\MATLAB71\toolbox\svm\svcoutput.m3,用SVM做分类的使用方法1)在matlab中输入必要的参数:X,Y,ker,C,p1,p2我做的测试中取的数据为:N = 50;n=2*N;randn('state',6);x1 = randn(2,N)y1 = ones(1,N);x2 = 5+randn(2,N);y2 = -ones(1,N);figure;plot(x1(1,:),x1(2,:),'bx',x2(1,:),x2(2,:),'k.');axis([-3 8 -3 8]);title('C-SVC')hold on;X1 = [x1,x2];Y1 = [y1,y2];X=X1';Y=Y1';其中,X是100*2的矩阵,Y是100*1的矩阵C=Inf;ker='linear';global p1 p2p1=3;p2=1;然后,在matlab中输入:[nsv alpha bias] = svc(X,Y,ker,C),回车之后,会显示:Support Vector Classification_____________________________Constructing ...Optimising ...Execution time: 1.9 secondsStatus : OPTIMAL_SOLUTION|w0|^2 : 0.418414Margin : 3.091912Sum alpha : 0.418414Support Vectors : 3 (3.0%)nsv =3alpha =0.00000.00000.00000.00000.00002)输入预测函数,可以得到与预想的分类结果进行比较.输入:predictedY = svcoutput(X,Y,X,ker,alpha,bias),回车后得到:predictedY =1111111113)画图输入:svcplot(X,Y,ker,alpha,bias),回车补充:X和Y为数据,m*n:m为样本数,n为特征向量数比如:取20组训练数据X,10组有故障,10组无故障的,每个训练数据有13个特征参数,则m=20,n=13Y为20*1的矩阵,其中,10组为1,10组为-1.对于测试数据中,如果取6组测试数据,3组有故障,3组无故障的,则m=6,n=13Y中,m=6,n=1/SV M_soft.htmlSVM - Support Vector MachinesSoftwareTrain support vector machine classifier/access/helpdesk/help/toolbox/bioinfo/ref/svmtrain.html一些问题???????1.今天我在使用SVM通用工具箱对眼电的信号数据进行分类时出现如下错误:Support Vector Classification_____________________________Constructing ...Optimising ...??? Dimension error (arg 3 and later).Error in ==> svc at 60[alpha lambda how] = qp(H, c, A, b, vlb, vub, x0, neqcstr);不知道是什么原因?答:今天上午终于找到出现这一错误的原因:它并不是SVM程序的问题,是我在整理样本时,把参数需要的样本行列颠倒所致。

支持向量机支持向量机回归原理简述及其MATLAB实例支持向量机 (Support Vector Machine, SVM) 是一种在监督学习中应用广泛的机器学习算法。

它既可以用于分类问题(SVM),又可以用于回归问题(SVR)。

本文将分别简要介绍 SVM 和 SVR 的原理,并提供MATLAB 实例来展示其应用。

SVM的核心思想是找到一个最优的超平面,使得正样本和负样本之间的间隔最大化,同时保证误分类的样本最少。

这个最优化问题可以转化为一个凸二次规划问题进行求解。

具体的求解方法是通过拉格朗日乘子法,将约束优化问题转化为一个拉格朗日函数的无约束极小化问题,并使用庞加莱对偶性将原问题转化为对偶问题,最终求解出法向量和偏差项。

SVR的目标是找到一个回归函数f(x),使得预测值f(x)和实际值y之间的损失函数最小化。

常用的损失函数包括平方损失函数、绝对损失函数等。

与SVM类似,SVR也可以使用核函数将问题转化为非线性回归问题。

MATLAB实例:下面以一个简单的数据集为例,展示如何使用MATLAB实现SVM和SVR。

1.SVM实例:假设我们有一个二分类问题,数据集包含两个特征和两类样本。

首先加载数据集,划分数据集为训练集和测试集。

```matlabload fisheririsX = meas(51:end, 1:2);Y=(1:100)';Y(1:50)=-1;Y(51:100)=1;randn('seed', 1);I = randperm(100);X=X(I,:);Y=Y(I);X_train = X(1:80, :);Y_train = Y(1:80, :);X_test = X(81:end, :);Y_test = Y(81:end, :);```然后,使用 fitcsvm 函数来训练 SVM 模型,并用 predict 函数来进行预测。

```matlabSVMModel = fitcsvm(X_train, Y_train);Y_predict = predict(SVMModel, X_test);```最后,可以计算分类准确度来评估模型的性能。

文章标题:深度探究Matlab中LS-SVMLab工具箱的使用案例在本文中,我将以深度和广度的方式来探讨Matlab中LS-SVMLab工具箱的使用案例。

LS-SVMLab是一个用于支持向量机(SVM)的Matlab工具箱,它具有灵活性、高性能和易用性。

在本文中,我们将通过具体的案例来展示LS-SVMLab的功能和优势,以及其在实际应用中的价值。

一、LS-SVMLab工具箱简介LS-SVMLab是一个用于实现线性支持向量机(LS-SVM)和核支持向量机(KS-SVM)的Matlab工具箱。

它由比利时根特大学的Bart De Moor教授团队开发,提供了一系列的函数和工具,用于支持向量机的建模、训练和预测。

LS-SVMLab具有数学严谨性和代码优化性,适用于各种复杂的数据分析和模式识别任务。

二、LS-SVMLab的使用案例在这个部分,我们将通过一个实际的案例来展示LS-SVMLab的使用。

假设我们有一个包含多个特征和标签的数据集,我们希望利用支持向量机来进行分类和预测。

我们需要加载数据集,并将其分割为训练集和测试集。

接下来,我们可以使用LS-SVMLab提供的函数来构建支持向量机模型,并进行参数优化。

我们可以利用训练好的模型来对测试集进行预测,并评估模型的性能。

具体地,我们可以使用LS-SVMLab中的`svm`函数来构建支持向量机模型,`gridsearch`函数来进行参数优化,以及`svmpredict`函数来进行预测。

在实际操作中,我们可以根据数据集的特点和任务的要求,灵活地调整模型的参数和优化方法。

通过这个案例,我们可以清晰地看到LS-SVMLab在支持向量机建模和应用方面的优势和价值。

三、个人观点和总结在本文中,我们深入探讨了Matlab中LS-SVMLab工具箱的使用案例。

通过具体的案例,我们展示了LS-SVMLab在支持向量机建模和应用中的灵活性和高性能。

在实际应用中,LS-SVMLab可以帮助我们快速、准确地构建支持向量机模型,解决各种复杂的数据分析和模式识别问题。

matlab信号特征提取与分类Matlab信号特征提取与分类信号特征提取与分类是信号处理领域的重要研究方向之一。

在许多应用领域,如生物医学信号分析、语音识别和图像处理等,我们常常需要从原始信号中提取关键的特征,并将其用于分类、识别或其他应用。

Matlab作为一种强大的计算工具,在信号处理和机器学习方面具有丰富的工具箱,使得信号特征提取和分类变得更加方便和高效。

本文将以Matlab为工具,介绍信号特征提取与分类的主要步骤和方法。

第一步:导入信号数据在Matlab中,我们可以使用`load`函数或者`xlsread`函数来导入信号数据。

一般来说,信号通常是一个时间序列或者多维数组,我们需要将其转换为Matlab处理的数据格式。

例如,我们导入一组心电图(ECG)信号数据:matlabload('ecg_data.mat');第二步:可视化信号数据在进行信号特征提取之前,我们通常需要先对信号数据进行可视化,以便了解其特点和结构。

Matlab提供了众多的绘图函数,如`plot`、`spectrogram`等,用于绘制信号的时域图、频域图等。

例如,我们可以使用`plot`函数绘制心电图信号:matlabplot(ecg_data);第三步:预处理信号数据在进行信号特征提取之前,我们通常需要对原始信号进行预处理,以消除噪声、平滑信号等。

Matlab提供了多种信号预处理的函数和工具箱,如滤波、去噪等。

例如,我们可以使用`sgolayfilt`函数对信号进行平滑处理:matlabsmoothed_data = sgolayfilt(ecg_data, 3, 15);第四步:提取信号特征信号特征提取是信号处理中的关键步骤,它可以帮助我们从原始信号中提取出与分类任务相关的有用信息。

Matlab提供了许多用于信号特征提取的函数和工具箱,如时域特征提取、频域特征提取等。

例如,我们可以使用`spectrogram`函数计算心电图信号的频谱图:matlab[s, f, t] = spectrogram(ecg_data, window, noverlap, nfft, fs);其中,`window`表示窗函数,`noverlap`表示重叠样本数,`nfft`表示FFT 点数,`fs`表示采样率。

matlab工具箱介绍MATLAB有三十多个工具箱大致可分为两类:功能型工具箱和领域型工具箱.功能型工具箱主要用来扩充MATLAB的符号计算功能、图形建模仿真功能、文字处理功能以及与硬件实时交互功能,能用于多种学科。

而领域型工具箱是专业性很强的。

如控制系统工具箱(Control System Toolbox)、信号处理工具箱(Signal Processing Toolbox)、财政金融工具箱(Financial Toolbox)等。

下面,将MATLAB工具箱内所包含的主要内容做简要介绍:1)通讯工具箱(Communication Toolbox)。

令提供100多个函数和150多个SIMULINK模块用于通讯系统的仿真和分析——信号编码——调制解调——滤波器和均衡器设计——通道模型——同步可由结构图直接生成可应用的C语言源代码。

2)控制系统工具箱(Control System Toolbox)。

鲁连续系统设计和离散系统设计* 状态空间和传递函数* 模型转换* 频域响应:Bode图、Nyquist图、Nichols图* 时域响应:冲击响应、阶跃响应、斜波响应等* 根轨迹、极点配置、LQG3)财政金融工具箱(FinancialTooLbox)。

* 成本、利润分析,市场灵敏度分析* 业务量分析及优化* 偏差分析* 资金流量估算* 财务报表4)频率域系统辨识工具箱(Frequency Domain System ldentification Toolbox* 辨识具有未知延迟的连续和离散系统* 计算幅值/相位、零点/极点的置信区间* 设计周期激励信号、最小峰值、最优能量诺等5)模糊逻辑工具箱(Fuzzy Logic Toolbox)。

* 友好的交互设计界面* 自适应神经—模糊学习、聚类以及Sugeno推理* 支持SIMULINK动态仿真* 可生成C语言源代码用于实时应用(6)高阶谱分析工具箱(Higher—Order SpectralAnalysis Toolbox* 高阶谱估计* 信号中非线性特征的检测和刻画* 延时估计* 幅值和相位重构* 阵列信号处理* 谐波重构(7)图像处理工具箱(Image Processing Toolbox)。

Matlab的第三⽅⼯具箱⼤全(强烈推荐)Matlab ToolboxesADCPtools - acoustic doppler current profiler dataprocessingAFDesign - designing analog and digital filtersAIRES - automatic integration of reusable embedded softwareAir-Sea - air-sea flux estimates in oceanographyAnimation - developing scientific animationsARfit - estimation of parameters and eigenmodes of multivariate autoregressive methodsARMASA - power spectrum estimationAR-Toolkit - computer vision trackingAuditory - auditory modelsb4m - interval arithmeticBayes Net - inference and learning for directed graphical modelsBinaural Modeling - calculating binaural cross-correlograms of soundBode Step - design of control systems with maximized feedbackBootstrap - for resampling, hypothesis testing and confidence interval estimationBrainStorm - MEG and EEG data visualization and processingBSTEX - equation viewerCALFEM - interactive program for teaching the finite element methodCalibr - for calibrating CCD camerasCamera CalibrationCaptain - non-stationary time series analysis and forecastingCHMMBOX - for coupled hidden Markov modeling using maximum likelihood EMClassification - supervised and unsupervised classification algorithmsCLOSIDCluster - for analysis of Gaussian mixture models for data set clusteringClustering - cluster analysisClusterPack - cluster analysisCOLEA - speech analysisCompEcon - solving problems in economics and finance Complex - for estimating temporal and spatial signal complexitiesComputational StatisticsCoral - seismic waveform analysisDACE - kriging approximations to computer modelsDAIHM - data assimilation in hydrological and hydrodynamic modelsData VisualizationDBT - radar array processingDDE-BIFTOOL - bifurcation analysis of delay differential equationsDenoise - for removing noise from signalsDiffMan - solving differential equations on manifoldsDimensional Analysis -DIPimage - scientific image processingDirect - Laplace transform inversion via the direct integration methodDirectSD - analysis and design of computer controlled systems with process-oriented modelsDMsuite - differentiation matrix suiteDMTTEQ - design and test time domain equalizer design methodsDrawFilt - drawing digital and analog filtersDSFWAV - spline interpolation with Dean wave solutions DWT - discrete wavelet transformsEasyKrigEconometricsEEGLABEigTool - graphical tool for nonsymmetric eigenproblems EMSC - separating light scattering and absorbance by extended multiplicative signal correctionEngineering VibrationFastICA - fixed-point algorithm for ICA and projection pursuitFDC - flight dynamics and controlFDtools - fractional delay filter designFlexICA - for independent components analysisFMBPC - fuzzy model-based predictive controlForWaRD - Fourier-wavelet regularized deconvolutionFracLab - fractal analysis for signal processingFSBOX - stepwise forward and backward selection of features using linear regressionGABLE - geometric algebra tutorialGAOT - genetic algorithm optimizationGarch - estimating and diagnosing heteroskedasticity in time series modelsGCE Data - managing, analyzing and displaying data and metadata stored using the GCE data structure specification GCSV - growing cell structure visualizationGEMANOVA - fitting multilinear ANOVA modelsGenetic AlgorithmGeodetic - geodetic calculations#1助理⼯程师精华 0积分 49帖⼦ 76⽔位 164技术分 0 Kalman - Bayesian Kalman filter Kalman Filter - filtering, smoothing and parameter estimation (using EM) for linear dynamical systems KALMTOOL - state estimation of nonlinear systems Kautz - Kautz filter design Kriging LDestimate -estimation of scaling exponents LDPC - low density parity check codes LISQ - wavelet lifting scheme on quincunx grids LKER - Laguerre kernel estimation toolLMAM-OLMAM - Levenberg Marquardt with Adaptive Momentum algorithm for training feedforward neural networksLow-Field NMR - for exponential fitting, phase correction of quadrature data and slicingLPSVM - Newton method for LP support vector machine for machine learning problemsLSDPTOOL - robust control system design using the loop shaping design procedureLS-SVMlabLSVM - Lagrangian support vector machine for machine learning problemsLyngby - functional neuroimagingMARBOX - for multivariate autogressive modeling and cross-spectral estimationMatArray - analysis of microarray dataMatrix Computation - constructing test matrices, computing matrix factorizations, visualizing matrices, and direct search optimization MCAT - Monte Carlo analysisMDP - Markov decision processesMESHPART - graph and mesh partioning methodsMILES - maximum likelihood fitting using ordinary least squares algorithmsMIMO - multidimensional code synthesisMissing - functions for handling missing data valuesM_Map - geographic mapping toolsMODCONS - multi-objective control system designMOEA - multi-objective evolutionary algorithmsMS - estimation of multiscaling exponentsMultiblock - analysis and regression on several data blockssimultaneouslyMultiscale Shape AnalysisMusic Analysis - feature extraction from raw audio signals forcontent-based music retrievalMWM - multifractal wavelet modelNetCDFNetlab - neural network algorithmsNiDAQ - data acquisition using the NiDAQ libraryNEDM - nonlinear economic dynamic modelsNMM - numerical methods in Matlab textNNCTRL - design and simulation of control systems based on neural networksNNSYSID - neural net based identification of nonlinear dynamic systems NSVM - newton support vector machine for solving machine learning problemsNURBS - non-uniform rational B-splinesN-way - analysis of multiway data with multilinear models OpenFEM - finite element developmentPCNN - pulse coupled neural networksPeruna - signal processing and analysisPhiVis - probabilistic hierarchical interactive visualization, i.e. functions for visual analysis of multivariate continuous data Planar Manipulator - simulation of n-DOF planar manipulators PRTools - pattern recognitionpsignifit - testing hyptheses about psychometric functionsPSVM - proximal support vector machine for solving machine learning problemsPsychophysics - vision researchPyrTools - multi-scale image processingRBF - radial basis function neural networksRBN - simulation of synchronous and asynchronous random boolean networksReBEL - sigma-point Kalman filtersRegression - basic multivariate data analysis and regression Regularization ToolsRegularization Tools XPRestore ToolsRobot - robotics functions, e.g. kinematics, dynamics and trajectory generationRobust Calibration - robust calibration in statsRRMT - rainfall-runoff modellingSAM - structure and motionSchwarz-Christoffel - computation of conformal maps to polygonally bounded regionsSDH - smoothed data histogramSeaGrid - orthogonal grid makerSEA-MAT - oceanographic analysisSLS - sparse least squaresSolvOpt - solver for local optimization problemsSOM - self-organizing mapSOSTOOLS - solving sums of squares (SOS) optimization problems Spatial and Geometric AnalysisSpatial RegressionSpatial StatisticsSpectral MethodsSPM - statistical parametric mappingSSVM - smooth support vector machine for solving machine learning problemsSTATBAG - for linear regression, feature selection, generation of data, and significance testingStatBox - statistical routinesStatistical Pattern Recognition - pattern recognition methodsStixbox - statisticsSVM - implements support vector machinesSVM ClassifierSymbolic Robot DynamicsTEMPLAR - wavelet-based template learning and pattern classification TextClust - model-based document clustering TextureSynth - analyzing and synthesizing visual texturesTfMin - continous 3-D minimum time orbit transfer around EarthTime-Frequency - analyzing non-stationary signals using time-frequency distributionsTree-Ring - tasks in tree-ring analysisTSA - uni- and multivariate, stationary and non-stationary time series analysisTSTOOL - nonlinear time series analysisT_Tide - harmonic analysis of tidesUTVtools - computing and modifying rank-revealing URV and UTV decompositionsUvi_Wave - wavelet analysisvarimax - orthogonal rotation of EOFsVBHMM - variation Bayesian hidden Markov modelsVBMFA - variational Bayesian mixtures of factor analyzersVMT - VRML Molecule Toolbox, for animating results from molecular dynamics experimentsVOICEBOXVRMLplot - generates interactive VRML 2.0 graphs and animations VSVtools - computing and modifying symmetric rank-revealing decompositionsWAFO - wave analysis for fatique and oceanographyWarpTB - frequency-warped signal processingWAVEKIT - wavelet analysisWaveLab - wavelet analysis。

支持向量机的matlab代码如果是7.0以上版本>>edit svmtrain>>edit svmclassify>>edit svmpredictfunction [svm_struct, svIndex] = svmtrain(training, groupnames, varargin)%SVMTRAIN trains a support vector machine classifier%% SVMStruct = SVMTRAIN(TRAINING,GROUP) trains a support vector machine% classifier using data TRAINING taken from two groups given by GROUP. % SVMStruct contains information about the trained classifier that is% used by SVMCLASSIFY for classification. GROUP is a column vector of % values of the same length as TRAINING that defines two groups. Each % element of GROUP specifies the group the corresponding row of TRAINING% belongs to. GROUP can be a numeric vector, a string array, or a cell% array of strings. SVMTRAIN treats NaNs or empty strings in GROUP as % missing values and ignores the corresponding rows of TRAINING.%% SVMTRAIN(...,'KERNEL_FUNCTION',KFUN) allows you to specify the kernel% function KFUN used to map the training data into kernel space. The% default kernel function is the dot product. KFUN can be one of the% following strings or a function handle:%% 'linear' Linear kernel or dot product% 'quadratic' Quadratic kernel% 'polynomial' Polynomial kernel (default order 3)% 'rbf' Gaussian Radial Basis Function kernel% 'mlp' Multilayer Perceptron kernel (default scale 1)% function A kernel function specified using @,% for example @KFUN, or an anonymous function%% A kernel function must be of the form%% function K = KFUN(U, V)%% The returned value, K, is a matrix of size M-by-N, where U and V have M % and N rows respectively. If KFUN is parameterized, you can use% anonymous functions to capture the problem-dependent parameters. For% example, suppose that your kernel function is%% function k = kfun(u,v,p1,p2)% k = tanh(p1*(u*v')+p2);%% You can set values for p1 and p2 and then use an anonymous function: % @(u,v) kfun(u,v,p1,p2).%% SVMTRAIN(...,'POLYORDER',ORDER) allows you to specify the order of a% polynomial kernel. The default order is 3.%% SVMTRAIN(...,'MLP_PARAMS',[P1 P2]) allows you to specify the% parameters of the Multilayer Perceptron (mlp) kernel. The mlp kernel% requires two parameters, P1 and P2, where K = tanh(P1*U*V' + P2) and P1% > 0 and P2 < 0. Default values are P1 = 1 and P2 = -1.%% SVMTRAIN(...,'METHOD',METHOD) allows you to specify the method used% to find the separating hyperplane. Options are%% 'QP' Use quadratic programming (requires the Optimization Toolbox) % 'LS' Use least-squares method%% If you have the Optimization Toolbox, then the QP method is the default % method. If not, the only available method is LS.%% SVMTRAIN(...,'QUADPROG_OPTS',OPTIONS) allows you to pass an OPTIONS% structure created using OPTIMSET to the QUADPROG function when using% the 'QP' method. See help optimset for more details.%% SVMTRAIN(...,'SHOWPLOT',true), when used with two-dimensional data,% creates a plot of the grouped data and plots the separating line for% the classifier.%% Example:% % Load the data and select features for classification% load fisheriris% data = [meas(:,1), meas(:,2)];% % Extract the Setosa class% groups = ismember(species,'setosa');% % Randomly select training and test sets% [train, test] = crossvalind('holdOut',groups);% cp = classperf(groups);% % Use a linear support vector machine classifier% svmStruct = svmtrain(data(train,:),groups(train),'showplot',true); % classes = svmclassify(svmStruct,data(test,:),'showplot',true);% % See how well the classifier performed% classperf(cp,classes,test);% cp.CorrectRate%% See also CLASSIFY, KNNCLASSIFY, QUADPROG, SVMCLASSIFY.% Copyright 2004 The MathWorks, Inc.% $Revision: 1.1.12.1 $ $Date: 2004/12/24 20:43:35 $% References:% [1] Kecman, V, Learning and Soft Computing,% MIT Press, Cambridge, MA. 2001.% [2] Suykens, J.A.K., Van Gestel, T., De Brabanter, J., De Moor, B., % Vandewalle, J., Least Squares Support Vector Machines,% World Scientific, Singapore, 2002.% [3] Scholkopf, B., Smola, A.J., Learning with Kernels,% MIT Press, Cambridge, MA. 2002.%% SVMTRAIN(...,'KFUNARGS',ARGS) allows you to pass additional% arguments to kernel functions.% set defaultsplotflag = false;qp_opts = [];kfunargs = {};setPoly = false; usePoly = false;setMLP = false; useMLP = false;if ~isempty(which('quadprog'))useQuadprog = true;elseuseQuadprog = false;end% set default kernel functionkfun = @linear_kernel;% check inputsif nargin < 2error(nargchk(2,Inf,nargin))endnumoptargs = nargin -2;optargs = varargin;% grp2idx sorts a numeric grouping var ascending, and a string grouping% var by order of first occurrence[g,groupString] = grp2idx(groupnames);% check group is a vector -- though char input is special...if ~isvector(groupnames) && ~ischar(groupnames)error('Bioinfo:svmtrain:GroupNotVector',...'Group must be a vector.');end% make sure that the data is correctly oriented.if size(groupnames,1) == 1groupnames = groupnames';end% make sure data is the right sizen = length(groupnames);if size(training,1) ~= nif size(training,2) == ntraining = training';elseerror('Bioinfo:svmtrain:DataGroupSizeMismatch',...'GROUP and TRAINING must have the same number of rows.') endend% NaNs are treated as unknown classes and are removed from the training % datanans = find(isnan(g));if length(nans) > 0training(nans,:) = [];g(nans) = [];endngroups = length(groupString);if ngroups > 2error('Bioinfo:svmtrain:TooManyGroups',...'SVMTRAIN only supports classification into two groups.\nGROUP contains %d different groups.',ngroups)end% convert to 1, -1.g = 1 - (2* (g-1));% handle optional argumentsif numoptargs >= 1if rem(numoptargs,2)== 1error('Bioinfo:svmtrain:IncorrectNumberOfArguments',...'Incorrect number of arguments to %s.',mfilename);endokargs ={'kernel_function','method','showplot','kfunargs','quadprog_opts','polyorder','ml p_params'};for j=1:2:numoptargspname = optargs{j};pval = optargs{j+1};k = strmatch(lower(pname), okargs);%#okif isempty(k)error('Bioinfo:svmtrain:UnknownParameterName',...'Unknown parameter name: %s.',pname);elseif length(k)>1error('Bioinfo:svmtrain:AmbiguousParameterName',...'Ambiguous parameter name: %s.',pname);elseswitch(k)case 1 % kernel_functionif ischar(pval)okfuns = {'linear','quadratic',...'radial','rbf','polynomial','mlp'};funNum = strmatch(lower(pval), okfuns);%#okif isempty(funNum)funNum = 0;endswitch funNum %maybe make this less strict in the futurecase 1kfun = @linear_kernel;case 2kfun = @quadratic_kernel;case {3,4}kfun = @rbf_kernel;case 5kfun = @poly_kernel;usePoly = true;case 6kfun = @mlp_kernel;useMLP = true;otherwiseerror('Bioinfo:svmtrain:UnknownKernelFunction',...'Unknown Kernel Function %s.',kfun);endelseif isa (pval, 'function_handle')kfun = pval;elseerror('Bioinfo:svmtrain:BadKernelFunction',...'The kernel function input does not appear to be a function handle\nor valid function name.')endcase 2 % methodif strncmpi(pval,'qp',2)useQuadprog = true;if isempty(which('quadprog'))warning('Bioinfo:svmtrain:NoOptim',...'The Optimization Toolbox is required to use the quadratic programming method.')useQuadprog = false;endelseif strncmpi(pval,'ls',2)useQuadprog = false;elseerror('Bioinfo:svmtrain:UnknownMethod',...'Unknown method option %s. Valid methods are ''QP'' and ''LS''',pval);endcase 3 % displayif pval ~= 0if size(training,2) == 2plotflag = true;elsewarning('Bioinfo:svmtrain:OnlyPlot2D',...'The display option can only plot 2D training data.')endendcase 4 % kfunargsif iscell(pval)kfunargs = pval;elsekfunargs = {pval};endcase 5 % quadprog_optsif isstruct(pval)qp_opts = pval;elseif iscell(pval)qp_opts = optimset(pval{:});elseerror('Bioinfo:svmtrain:BadQuadprogOpts',...'QUADPROG_OPTS must be an opts structure.');endcase 6 % polyorderif ~isscalar(pval) || ~isnumeric(pval)error('Bioinfo:svmtrain:BadPolyOrder',...'POLYORDER must be a scalar value.');endif pval ~=floor(pval) || pval < 1error('Bioinfo:svmtrain:PolyOrderNotInt',...'The order of the polynomial kernel must be a positive integer.')endkfunargs = {pval};setPoly = true;case 7 % mlpparamsif numel(pval)~=2error('Bioinfo:svmtrain:BadMLPParams',...'MLP_PARAMS must be a two element array.');endif ~isscalar(pval(1)) || ~isscalar(pval(2))error('Bioinfo:svmtrain:MLPParamsNotScalar',...'The parameters of the multi-layer perceptron kernel must be scalar.');endkfunargs = {pval(1),pval(2)};setMLP = true;endendendendif setPoly && ~usePolywarning('Bioinfo:svmtrain:PolyOrderNotPolyKernel',...'You specified a polynomial order but not a polynomial kernel');endif setMLP && ~useMLPwarning('Bioinfo:svmtrain:MLPParamNotMLPKernel',...'You specified MLP parameters but not an MLP kernel');end% plot the data if requestedif plotflag[hAxis,hLines] = svmplotdata(training,g);legend(hLines,cellstr(groupString));end% calculate kernel functiontrykx = feval(kfun,training,training,kfunargs{:});% ensure function is symmetrickx = (kx+kx')/2;catcherror('Bioinfo:svmtrain:UnknownKernelFunction',...'Error calculating the kernel function:\n%s\n', lasterr);end% create Hessian% add small constant eye to force stabilityH =((g*g').*kx) + sqrt(eps(class(training)))*eye(n);if useQuadprog% The large scale solver cannot handle this type of problem, so turn it % off.qp_opts = optimset(qp_opts,'LargeScale','Off');% X=QUADPROG(H,f,A,b,Aeq,beq,LB,UB,X0,opts)alpha = quadprog(H,-ones(n,1),[],[],...g',0,zeros(n,1),inf *ones(n,1),zeros(n,1),qp_opts);% The support vectors are the non-zeros of alphasvIndex = find(alpha > sqrt(eps));sv = training(svIndex,:);% calculate the parameters of the separating line from the support% vectors.alphaHat = g(svIndex).*alpha(svIndex);% Calculate the bias by applying the indicator function to the support% vector with largest alpha.[maxAlpha,maxPos] = max(alpha); %#okbias = g(maxPos) - sum(alphaHat.*kx(svIndex,maxPos));% an alternative method is to average the values over all support vectors % bias = mean(g(sv)' - sum(alphaHat(:,ones(1,numSVs)).*kx(sv,sv)));% An alternative way to calculate support vectors is to look for zeros of % the Lagrangians (fifth output from QUADPROG).%% [alpha,fval,output,exitflag,t] = quadprog(H,-ones(n,1),[],[],...% g',0,zeros(n,1),inf *ones(n,1),zeros(n,1),opts);%% sv = t.lower < sqrt(eps) & t.upper < sqrt(eps);else % Least-Squares% now build up compound matrix for solverA = [0 g';g,H];b = [0;ones(size(g))];x = A\b;% calculate the parameters of the separating line from the support% vectors.sv = training;bias = x(1);alphaHat = g.*x(2:end);endsvm_struct.SupportVectors = sv;svm_struct.Alpha = alphaHat;svm_struct.Bias = bias;svm_struct.KernelFunction = kfun;svm_struct.KernelFunctionArgs = kfunargs;svm_struct.GroupNames = groupnames;svm_struct.FigureHandles = [];if plotflaghSV = svmplotsvs(hAxis,svm_struct);svm_struct.FigureHandles = {hAxis,hLines,hSV}; end41|评论(6)。