最小二乘支持向量机的自编代码和安装SVM工具箱方法

- 格式:doc

- 大小:36.50 KB

- 文档页数:5

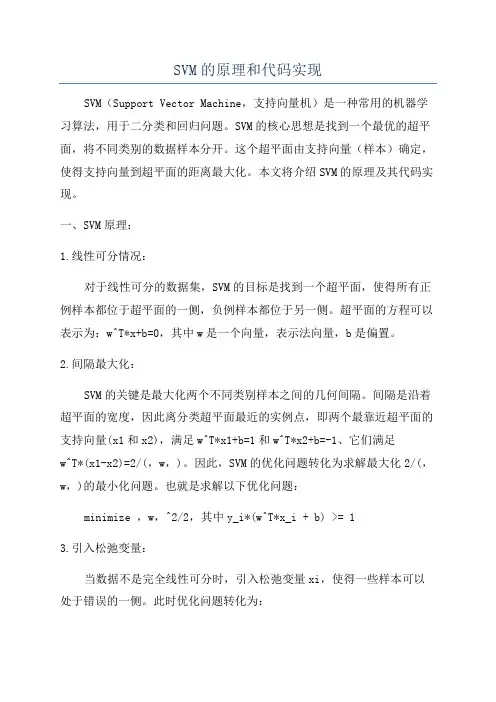

SVM的原理和代码实现SVM(Support Vector Machine,支持向量机)是一种常用的机器学习算法,用于二分类和回归问题。

SVM的核心思想是找到一个最优的超平面,将不同类别的数据样本分开。

这个超平面由支持向量(样本)确定,使得支持向量到超平面的距离最大化。

本文将介绍SVM的原理及其代码实现。

一、SVM原理:1.线性可分情况:对于线性可分的数据集,SVM的目标是找到一个超平面,使得所有正例样本都位于超平面的一侧,负例样本都位于另一侧。

超平面的方程可以表示为:w^T*x+b=0,其中w是一个向量,表示法向量,b是偏置。

2.间隔最大化:SVM的关键是最大化两个不同类别样本之间的几何间隔。

间隔是沿着超平面的宽度,因此离分类超平面最近的实例点,即两个最靠近超平面的支持向量(x1和x2),满足w^T*x1+b=1和w^T*x2+b=-1、它们满足w^T*(x1-x2)=2/(,w,)。

因此,SVM的优化问题转化为求解最大化2/(,w,)的最小化问题。

也就是求解以下优化问题:minimize ,w,^2/2,其中y_i*(w^T*x_i + b) >= 13.引入松弛变量:当数据不是完全线性可分时,引入松弛变量xi,使得一些样本可以处于错误的一侧。

此时优化问题转化为:minimize ,w,^2/2 + C*Σξ_i,其中y_i*(w^T*x_i + b) >= 1 - ξ_i,ξ_i >= 0。

C是一个超参数,用于控制错误样本的惩罚程度。

当C越大,对错误样本的惩罚越重;C越小,则对错误样本的惩罚越轻。

4.对偶问题:为了方便求解SVM的优化问题,引入拉格朗日乘子,将SVM的原始问题转化为对偶问题。

通过求解对偶问题,可以得到最优解。

对偶问题如下:maximize Σα_i - 1/2*ΣΣ α_i*α_j*y_i*y_j*x_i*x_j,其中Σα_i*y_i = 0,0 <= α_i <= C。

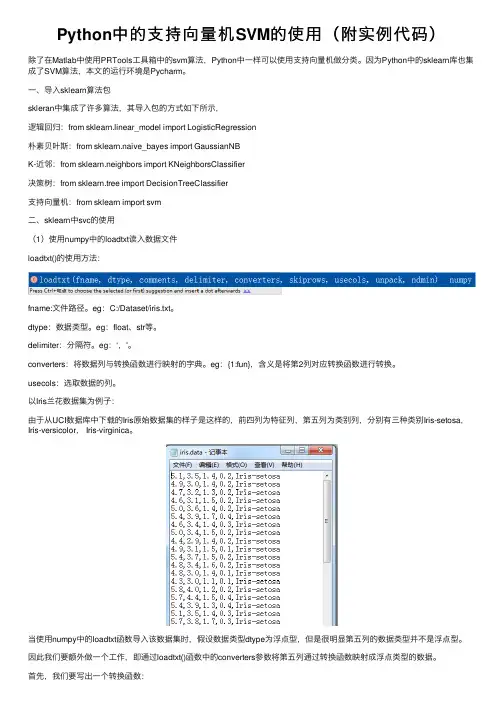

Python中的⽀持向量机SVM的使⽤(附实例代码)除了在Matlab中使⽤PRTools⼯具箱中的svm算法,Python中⼀样可以使⽤⽀持向量机做分类。

因为Python中的sklearn库也集成了SVM算法,本⽂的运⾏环境是Pycharm。

⼀、导⼊sklearn算法包skleran中集成了许多算法,其导⼊包的⽅式如下所⽰,逻辑回归:from sklearn.linear_model import LogisticRegression朴素贝叶斯:from sklearn.naive_bayes import GaussianNBK-近邻:from sklearn.neighbors import KNeighborsClassifier决策树:from sklearn.tree import DecisionTreeClassifier⽀持向量机:from sklearn import svm⼆、sklearn中svc的使⽤(1)使⽤numpy中的loadtxt读⼊数据⽂件loadtxt()的使⽤⽅法:fname:⽂件路径。

eg:C:/Dataset/iris.txt。

dtype:数据类型。

eg:float、str等。

delimiter:分隔符。

eg:‘,'。

converters:将数据列与转换函数进⾏映射的字典。

eg:{1:fun},含义是将第2列对应转换函数进⾏转换。

usecols:选取数据的列。

以Iris兰花数据集为例⼦:由于从UCI数据库中下载的Iris原始数据集的样⼦是这样的,前四列为特征列,第五列为类别列,分别有三种类别Iris-setosa,Iris-versicolor, Iris-virginica。

当使⽤numpy中的loadtxt函数导⼊该数据集时,假设数据类型dtype为浮点型,但是很明显第五列的数据类型并不是浮点型。

因此我们要额外做⼀个⼯作,即通过loadtxt()函数中的converters参数将第五列通过转换函数映射成浮点类型的数据。

最小二乘支持向量机:用于分类和回归问题的机器学习算法随着计算机技术的不断发展,机器学习(Machine Learning)已经成为当前人工智能领域的重要应用之一。

(Least Squares Support Vector Machines,LSSVM)是一种用于分类和回归问题的机器学习算法。

它利用最小二乘法,将样本数据分为不同的类别或预测目标。

LSSVM有着广泛的应用领域,例如语音识别、图像处理、生物医学工程等,具有较好的效果。

SVM的发展背景SVM(Support Vector Machine)是由Vapnik等人在1980年代发明的。

它是一种二分类模型,通过构建一个最优的超平面来分离数据。

SVM在许多问题中取得了出色的解决方案。

然而,它们只设计了处理训练样本是线性可分的情况。

在实际问题中,许多数据集是线性不可分的。

因此,LSSVM是SVM的发展方向之一,它可以用于处理过度拟合或线性不可分的数据集。

支持向量机的数学模型支持向量机(SVM)是一种基于概率的监督学习算法,在分类和回归问题中广泛应用。

在二分类问题中,SVM的目标是找到一个最优的超平面,将样本数据分为两个类别。

其中,这个超平面的特点是离两个类别最近的样本点最远。

这两个样本点被称为“支持向量”。

SVM的数学模型可以表示为:$ \min \limits_{\alpha, b} \frac{1}{2} \alpha^T H \alpha - \alpha^T e $其中, $H$是Gram矩阵, $e$是所有样本的标签向量,$ \alpha $是拉格朗日乘子。

LSSVM是一种推广了SVM算法的机器学习算法。

它通过最小化重建误差,把训练样本映射到高维空间,从而实现非线性分类和回归。

LSSVM和SVM都是在特征空间中构造一个超平面,但LSSVM选择使用最小二乘法来解决优化问题。

LSSVM的数学模型为:$ \min \limits_{w, b, e} \frac{1}{2} w^T w +\frac{C}{2}\sum_{i=1}^{n} e_i^2 $$ y_i = w^T\phi(x_i) + b = \sum_{j=1}^n \alpha_j \phi(x_j) \phi(x_i) +b $其中w是一个权重向量, $b$是常数项, $e$是松弛变量。

最小二乘支持向量机算法及应用研究最小二乘支持向量机算法及应用研究引言:在机器学习领域中,支持向量机(Support Vector Machines, SVM)算法是一种广泛应用于分类和回归分析的监督学习方法。

而最小二乘支持向量机算法(Least Square Support Vector Machines, LS-SVM)则是支持向量机算法的一种变种。

本文将首先简要介绍支持向量机算法的原理,然后重点探讨最小二乘支持向量机算法的基本原理及应用研究。

一、支持向量机算法原理支持向量机是一种有效的非线性分类方法,其基本思想是找到一个超平面,使得将不同类别的样本点最大程度地分开。

支持向量是指离分类超平面最近的正负样本样本点,它们对于分类的决策起着至关重要的作用。

支持向量机算法的核心是通过优化求解问题,将原始样本空间映射到更高维的特征空间中,从而实现在非线性可分的数据集上进行线性分类的目的。

在支持向量机算法中,线性可分的数据集可以通过构建线性判别函数来实现分类。

但是,在实际应用中,往往存在非线性可分的情况。

为了克服这一问题,引入了核技巧(Kernel Trick)将样本映射到更高维的特征空间中。

通过在高维空间中进行线性判别,可以有效地解决非线性可分问题。

二、最小二乘支持向量机算法基本原理最小二乘支持向量机算法是一种通过最小化目标函数进行求解的线性分类方法。

与传统的支持向量机算法不同之处在于,最小二乘支持向量机算法将线性判别函数的参数表示为样本点与分类超平面的最小误差之和的线性组合。

具体而言,最小二乘支持向量机算法的目标函数包括一个平滑项和一个约束条件项,通过求解目标函数的最小值,得到最优解。

最小二乘支持向量机算法的求解过程可以分为以下几个步骤:1. 数据预处理:对原始数据进行标准化或归一化处理,以确保算法的稳定性和准确性。

2. 求解核矩阵:通过选取适当的核函数,将样本点映射到特征空间中,并计算核矩阵。

3. 构建目标函数:将目标函数表示为一个凸二次规划问题,包括平滑项和约束条件项。

svm matlab 代码如何使用SVM(支持向量机)进行二分类任务的MATLAB代码。

支持向量机(Support Vector Machine,SVM)是一种机器学习算法,可用于二分类问题。

在MATLAB中,我们可以使用SVM工具箱来实现这一算法。

下面我将逐步引导你使用MATLAB编写SVM的代码进行二分类任务。

第一步:导入数据集首先,我们需要准备一个用于训练分类器的数据集。

数据集应包括输入特征和对应的类别标签。

MATLAB提供了一种方便的方式来加载和处理数据,我们可以使用load函数从文件中导入数据。

例如,假设你的数据集保存在一个名为data.csv的文件中,你可以使用以下代码导入数据集:matlabdata = load('data.csv');X = data(:, 1:end-1); 输入特征y = data(:, end); 类别标签这样,数据集中的输入特征将存储在X矩阵中,而类别标签将存储在y向量中。

第二步:拆分数据集在训练SVM分类器之前,我们需要将数据集拆分为训练集和测试集。

训练集将用于训练分类器,而测试集将用于评估分类器的性能。

MATLAB提供了一个方便的函数cvpartition,可以帮助我们实现这一步骤。

以下是一个示例代码:matlabcv = cvpartition(y, 'HoldOut', 0.2); 将数据集按照20的比例划分为测试集X_train = X(training(cv), :); 训练集输入特征y_train = y(training(cv), :); 训练集类别标签X_test = X(test(cv), :); 测试集输入特征y_test = y(test(cv), :); 测试集类别标签现在,我们已经准备好了训练和测试集。

第三步:训练SVM分类器使用MATLAB的SVM工具箱,我们可以轻松地训练一个SVM分类器。

以下是一个使用线性核函数(linear kernel)的示例代码:matlabSVMModel = fitcsvm(X_train, y_train, 'KernelFunction', 'linear');上述代码中,fitcsvm函数用于训练SVM分类器。

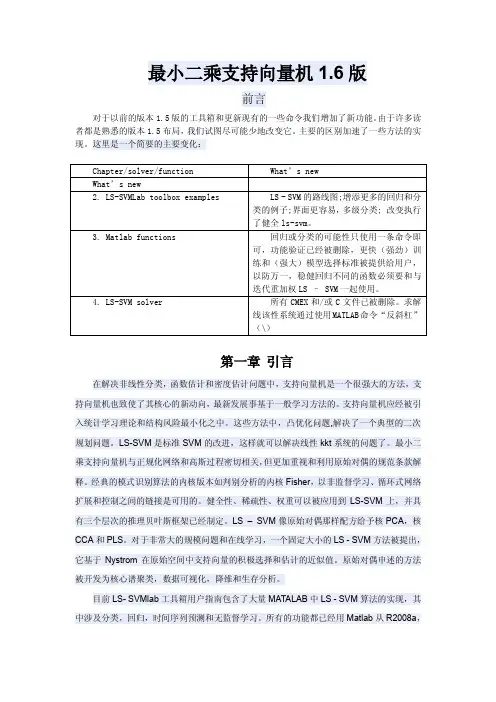

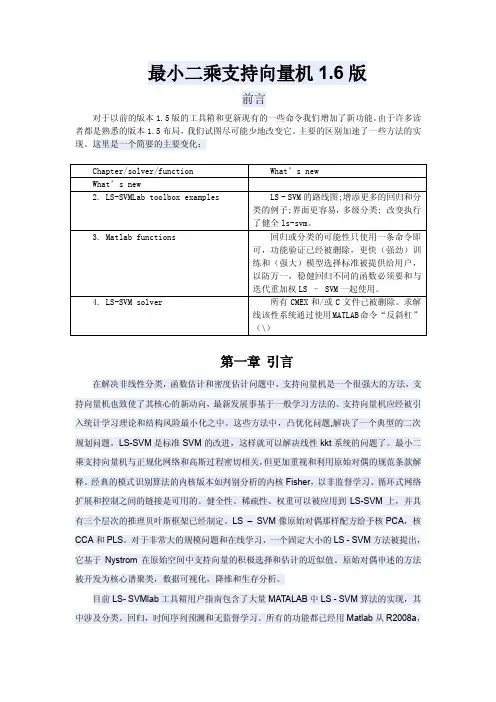

最小二乘支持向量机1.6版前言对于以前的版本1.5版的工具箱和更新现有的一些命令我们增加了新功能。

由于许多读者都是熟悉的版本1.5布局,我们试图尽可能少地改变它。

主要的区别加速了一些方法的实现。

这里是一个简要的主要变化:Chapter/solver/function What’s newWhat’s new2. LS-SVMLab toolbox examples LS - SVM的路线图;增添更多的回归和分类的例子;界面更容易,多级分类; 改变执行了健全ls-svm。

3. Matlab functions 回归或分类的可能性只使用一条命令即可,功能验证已经被删除,更快(强劲)训练和(强大)模型选择标准被提供给用户,以防万一,稳健回归不同的函数必须要和与迭代重加权LS – SVM一起使用。

4. LS-SVM solver 所有CMEX和/或C文件已被删除。

求解线该性系统通过使用MATLAB命令“反斜杠”(\)第一章 引言在解决非线性分类,函数估计和密度估计问题中,支持向量机是一个很强大的方法,支持向量机也致使了其核心的新动向,最新发展事基于一般学习方法的。

支持向量机应经被引入统计学习理论和结构风险最小化之中。

这些方法中,凸优化问题,解决了一个典型的二次规划问题。

LS-SVM是标准SVM的改进,这样就可以解决线性kkt系统的问题了。

最小二乘支持向量机与正规化网络和高斯过程密切相关,但更加重视和利用原始对偶的规范条款解释。

经典的模式识别算法的内核版本如判别分析的内核Fisher,以非监督学习、循环式网络扩展和控制之间的链接是可用的。

健全性、稀疏性、权重可以被应用到LS-SVM上,并具有三个层次的推理贝叶斯框架已经制定。

LS – SVM像原始对偶那样配方给予核PCA,核CCA和PLS。

对于非常大的规模问题和在线学习,一个固定大小的LS - SVM方法被提出,它基于Nystrom在原始空间中支持向量的积极选择和估计的近似值。

机器学习代码实战——SVM(支持向量机)(使用不同核函数)支持向量机(Support Vector Machine, SVM)是一种常用的机器学习方法,它可以应用于分类和回归问题。

SVM通过构建一个超平面或决策边界来在不同类别之间进行分类,从而找到最佳的分类结果。

在SVM中,我们可以使用不同的核函数来改变超平面的形状和效果。

下面将介绍SVM 的基本原理以及如何使用不同核函数来解决分类问题。

SVM的基本原理是找到一个超平面来将不同类别的样本分割开来,最大化边界的宽度。

这个超平面的选择要求离它最近的训练点与该超平面的距离最大化,这些训练点被称为支持向量。

SVM的目标是找到一个最优的决策边界,使得其能够正确分类训练样本,并且对未知数据具有较好的泛化能力。

SVM可以使用不同的核函数来改变超平面的形状。

核函数是一种将输入空间映射到高维特征空间的函数,它可以将线性可分的样本在低维特征空间中转化为非线性可分的样本,从而提高分类的准确性。

常用的核函数有线性核函数、多项式核函数和高斯核函数。

线性核函数是最简单的核函数,它在原始特征空间上直接进行线性分割。

当数据集是线性可分的时候,使用线性核函数可以获得较好的分类效果。

线性核函数可以通过设置kernel参数为'linear'来使用。

多项式核函数可以在原始特征空间中引入高阶项,从而实现非线性分割。

多项式核函数可以通过设置kernel参数为'poly'来使用,并且可以通过degree参数来控制多项式的阶数。

高斯核函数(也称为径向基函数)将数据从原始特征空间映射到无穷维的特征空间中。

高斯核函数可以通过设置kernel参数为'rbf'来使用,并且可以通过gamma参数来控制高斯核函数的宽度。

除了上述三种常用的核函数之外,SVM还支持其他核函数,如sigmoid核函数和核对角线核函数等。

每种核函数都有不同的特点和适用场景,选择合适的核函数是SVM应用中的一项重要任务。

clcclearclose all%---------------------------------------------------% 产生训练样本与测试样本,每一列为一个样本k=125;m=10;n1=ones(5,125);n2=ones(5,10);n3=[120,150,218,247.7,56,181,0,57,4.32,23.51,24.16,93.5,96,93,910,20,24,26.7,220,33.9,46.9,70 .2,72,128,139,144,159.8,230,679,15.21,20.37,22.1,16,35,73,86,336,82,87,94,121,170,172.9,180, 26.6,70.4,164,25.1,274,3,14,45,60,72,304,22.3,35.1,56,63,68,68,207,236,37,80,82,293,42,220,76 6,10,36.2,105,117,240,851,4072,4.6875,0.962,2,20.443,18.614,4.0787,17.187,17.314,11.299,11. 31,3.7648,2587.2,1565,87.266,85.865,84.333,61.394,57.983,59,57,673.6,32.2,255,707,50.11,56, 121,130.4,300.44,685,174,111,410,574,127,200,1678,162,334,48.155,49.77,45.703,39.216,56.98 2,32.597,26.859,43.737,20.385;120,60,120.7,148.7,78,262,434,77,193,61.33,261.05,36.7,41,58,1592,41.9,27.8,90.6,230,36.5,16 1.6,70.2,442,419,714,754,438.7,572.4,4992,61.25,59.79,64.1,237,30,520,110,419,81,87,195,69,3 20,334,97,22.7,69.5,244,411.91,376,198,221,168,139,160.3,443.5,7.8,50.6,99.9,149.6,99.2,99.2, 416,410.2,130,243,161,134,98,340,990,4,12.6,169.4,257,676,2802,15850,10.826,15.787,16.667, 17.036,17.972,20.83,21.432,21.731,21.834,21.835,26.818,7.882,98,6.5004,7.0013,8.0593,10.822 ,18.866,28,13,423.5,5.5,48,115,15.97,13,14,2.39,42.14,102,24,58,120,256,107,48,652.9,35,39.9, 1.4272,8.4485,9.1405,9.4118,10.479,15.47,16.887,17.018,17.175;33,40,126.6,78.7,18,41,226,19,118,45.21,196.13,11.2,12.8,43,801,20.2,24.4,49.2,57,31.5,94.1,17 1.5,221,269.4,351,250,312.4,343,1823,45.94,45.24,44.3,92,10,140,18,105,33,26,14,32,53,172,34 ,22.5,28.9,103,320.9,55,191,199,82,21,63.1,110.9,12.4,16.1,51.4,57.5,35.9,35.9,347,159,91,274. 2,79,52,156,42,115,3,4.4,59.1,92,200,772,9057,17.522,12.299,3.8667,5.6786,6.6865,6.992,5.370 8,5.8304,11.299,11.244,7.2202,4.704,35,5.1647,4.4914,7.2211,4.1623,4.6218,9,0.1,77.6,1.4,8.3, 11,4.66,2.4,3,7.22,3.25,9,9.3,0,18,22,11,14,80.7,5.6,47.8,4.0354,2.1505,2.4557,2.7451,1.2837,4. 9724,3.0902,2.1034,1.7657;84,70,142.1,192.7,21,28,387,21,125,98.03,201.4,69.5,82.5,37,932,44.2,30,95,110,39.3,193.3,371 .6,461,614.1,634,502,644.6,768.9,3671,81.83,80.49,81.4,470,93,1200,92,1074,224,218,153,268, 520,812.5,271,109,241.2,497,1832.8,1002,701,804,330,430,303.7,946,95.7,93,24.8,276,202.9,20 2.9,1345,817.3,430,1347.7,406,239,610,480,660,33,15.5,347.6,468,818,3521,22621,66.964,70.2 46,76.533,52.811,55.363,67.589,54.936,52.297,53.089,53.146,61.888,1.4,48,1.0686,2.642,0.386 85,10.406,8.6555,70,11,988.9,12.6,33,55,45.37,22,29,1.8,43.18,170,29.3,105,71,503,154,117,10 05.9,30,5.35,22.539,19.355,19.509,22.941,13.571,38.674,39.431,26.219,24.719;0.55,1,0.9,0.9,0,0,0,0,0,1.01,0.87,1.1,0.6,0,0,0.38,0,0.5,7,0,0.56,0,0.7,0.35,0,1,0.38,0.51,0,0,0,0,0 ,7.1,6,7.4,21,5.4,7.5,15,8,3.2,37.7,8,0,10.4,8.3,18.4,17,0,0,3.1,4.6,0.1,56.1,1.4,1.1,2.3,0,0,0,20,3. 5,2.9,8.4,8.9,2.9,0,14,0,6,0,1.8,4,4,10,535,0,0.7052,0.93333,4.0318,1.3644,0.50983,1.0742,2.826 9,2.4692,2.4646,0.30944,0,0,0,0,0,13.215,9.8739,15,12,344.5,13.2,29.8,81,12.3,22.13,74,4.38,64 .71,367,64.4,201,250,382,224,131,419.1,44,247.6,23.843,20.276,23.192,25.686,17.684,8.2873,1 3.733,10.924,35.955];for t=1:kn1(:,t)=(n3(:,t)-min(n3(:,t)))/(max(n3(:,t))-min(n3(:,t)));endx1 = [1*ones(1,6),2*ones(1,26),3*ones(1,56),4*ones(1,1),5*ones(1,6),6*ones(1,30)];n4 = [160,97,27,56,78,92,980,83.714,23,42;130,229,90,27,161,62,73,8.067,12,62;33,136,42,20,86,35,58,5.175,12,5;96,227,63,108,353,280,12,3.0441,10,63;0,1,0.2,6,10,11,0,0,61,73];for n=1:mn2(:,n)=(n4(:,n)-min(n4(:,n)))/(max(n4(:,n))-min(n4(:,n)));endx2 = [1*ones(1,1),2*ones(1,2),3*ones(1,3),4*ones(1,1),5*ones(1,1),6*ones(1,2)];xn_train = n1; % 训练样本dn_train = x1; % 训练目标xn_test = n2; % 测试样本dn_test = x2; % 测试样本%---------------------------------------------------% 参数设置X = xn_train';% 训练样本Y = dn_train';Xt = xn_test';Yt = dn_test';type = 'c'; %'type has to be ''function (estimation)'', ''classification'', ''timeserie'' or ''NARX'''] kernel_type = 'RBF_kernel';L_fold = 7;preprocess = 'preprocess'; %是否归一化'preprocess'是'original'否codefct = 'code_OneVsOne';% 将“多类”转换成“两类”的编码方案% 1. Minimum Output Coding (code_MOC)% 2. Error Correcting Output Code (code_ECOC)% 3. One versus All Coding (code_OneVsAll)% 4. One Versus One Coding (code_OneVsOne)%---------------------------------------------------% 编码[Yc,codebook,old_codebook]=code(Y,codefct);%---------------------------------------------------% 交叉验证优化参数[gam,sig2] = tunelssvm({X,Y,type,[],[],kernel_type,preprocess},...'gridsearch','crossvalidatelssvm',{L_fold,'misclass'},codefct);%---------------------------------------------------% 训练与测试model = initlssvm(X,Y,type,[],[],kernel_type,preprocess);model = changelssvm(model,'codetype',codefct);model = tunelssvm(model,'gridsearch','crossvalidatelssvm',{L_fold,'misclass'});model = trainlssvm(model);plotlssvm(model,[],125);Yd = simlssvm(model, Xt);Result =1-abs(Yd-Yt) % 正确分类显示为1 Percent = sum(Result)/length(Result) % 正确分类率。

基于Matlab的最小二乘支持向量机的工具箱及其应用李方方,赵英凯,颜昕1最小二乘支持向量机的原理最小二乘支持向量机[2]是支持向量机的一种改进,它是将传统支持向量机中的不等式约束改为等式约束,且将误差平方和(Sum SquaresError)损失函数作为训练集的经验损失,这样就把解二次规划问题转化为求解线性方程组问题,提高求解问题的速度和收敛精度。

设样本为n维向量,某区域的l个样本及其表示为: (x1,y1),…, (xl,yl)∈Rn×R,首先用一非线性映射ψ(·)把样本从原空间Rn映射到特征空间φ(xi),在这个高维特征空间中构造最优决策函数:y(x) =ω·φ(x) +b(1)这样非线性估计函数转化为高维特征空间的线性估计函数。

利用结构风险最小化原则,寻找ω, b就是最小化:其中‖ω‖2控制模型的复杂度, c是正规化参数,控制对超出误差样本的惩罚程度。

Remp为误差控制函数,也即ε不敏感损失函数。

常用的损失函数有线性ε损失函数,二次ε损失函数,Huber损失函数。

选取了不同的损失函数,可构造不同形式的支持向量机。

最小二乘支持向量机在优化目标失函数为误差ξi的二次项。

故优化问题为:式中,ξi为松弛因子。

用拉格朗日法求解这个优化问题:其中:αi(i =1,…, l)是拉格朗日乘子。

根据优化条件可得到:其中:αi= c·ξi,ω·φ(xi) +b +ξi-yi=0。

定义核函数K(xi,yi) =φ(xi)·φ(xj)是满足条件的对称函数。

根据文献[6],优化问题转化为求解线性方程:最后用最小二乘法求出a与b,最小二乘支持向量机也由此得名,并且得到非线性预测模型:K(xi,x) =Φ(xi)·Φ(x)称为核函数,它是满足Mercer条件的任何对称的核函数对应于特征空间的点积。

核函数的种类较多,常用的有:(1)多项式函数:(2)RBF函数:(3)Sigmoid函数:k(xi,x) =tanh(v(x·xi) +c)(4)B样条函数:K(x,y) =B2n(x-y)2LS-SVMlab工具箱基于Matlab的LS-SVMlab工具箱[3]主要包括分类、回归、时间序列预测和无监督学习。

最小二乘支持向量机的自编代码

clear all;

clc;

N=35; %样本个数

NN1=4; %预测样本数

%********************随机选择初始训练样本及确定预测样本

*******************************

x=[];

y=[];

index=randperm(N); %随机排序N个序列

index=sort(index);

gama=23.411; %正则化参数

deita=0.0698; %核参数值

%thita=; %核参数值

%*********构造感知机核函数*************************************

%for i=1:N

% x1=x(:,index(i));

% for j=1:N

% x2=x(:,index(j));

% K(i,j)=tanh(deita*(x1'*x2)+thita);

% end

%end

%*********构造径向基核函数************************************** for i=1:N

x1=x(:,index(i));

for j=1:N

x2=x(:,index(j));

x12=x1-x2;

K(i,j)=exp(-(x12'*x12)/2/(deita*deita));

end

end

%*********构造多项式核函数**************************************** %for i=1:N

% x1=x(:,index(i));

% for j=1:N

% x2=x(:,index(j));

% K(i,j)=(1+x1'*x2)^(deita);

% end

%end

%*********构造核矩阵************************************

for i=1:N-NN1

for j=1:N-NN1

omeiga1(i,j)=K(i,j);

end

end

omeiga2=omeiga1';

omeiga=omeiga2+(1/gama)*eye(N-NN1);

A12=ones(1,N-NN1);

A21=A12';

A=[0 A12;A21 omeiga];

%**************************************

for i=1:N-NN1

B21(i,:)=y(index(i));

end

B=[0;B21];

%********LS-SVM模型的解******************************

C=A\B;

%******

b=C(1); %模型参数

for i=1:N-NN1

aipha(i)=C(i+1); %模型参数,行向量

end

%*******************************************

for i=1:N %预测模型

aifx(i)=b+(aipha)*K(1:N-NN1,i);

end

%*******************************************

aifx

index

从网上搜到,还没试,不知那个可以成功,先收藏下

方法一:

Matlab大部分函数都放在了toolbox这个文件夹下面。

可以试着把需要的函数和工具箱放进去看看能不能用。

象matlab升级以后功能会更强大,包含的工具箱也越多,所占用的硬盘空间也变得很大。

建议你安装的时候选择自定义安装,只装自己需要的几个工具箱,看你需要是用在什么专业,它里面有很多比如财务工具箱,航空工具箱,生物技术工具箱对与我专业就没有用,就可以不安装。

这样就省了空间了。

结一下matlab添加工具箱的方法:第一种:如果是安装光盘上的工具箱,重新执行安装程序,选中即可。

如果是单独下载的工具箱,一般情况下仅需要把新的工具箱解压到某个目录,然后用pathtool添加工具箱的路径。

在命令窗口中敲入pathtool,会出现一个setpath的窗口,点add folder或者add with subfolders 按钮,选中你的工具箱。

保存既可。

任选工具箱中的一个命令,然后help一下看看是否好使。

举例:

我下载了支持向量基工具箱,解压后,里边有一个目录svm

我的matlab安装在D:\MATLAB6p5

将svm目录拷贝至D:\MATLAB6p5\toolbox

然后运行matlab,在命令窗口输入addpath D:\MATLAB6p5\toolbox\svm回车,来添加路径。

然后在svm目录下,任意找一个m文件,以svcinfo.m为例

在命令窗口中输入which svcinfo.m

如果显示出该文件路径,如 D:\MATLAB6p5\toolbox\svm\svcinfo.m

则安装成功

方法二:

在libsvm的网站上下载libsvm-mat-2.83-1.zip文件,解压后放在任意目录下(比如c:\libsvm-mat-2.83-1下)

打开matlab,切换到c:\libsvm-mat-2.83-1目录下,键入以下命令:

mex -setup

Matlab会询问你是否需要locate installed compiler,选择y,然后根据需要选择一个编译器即可。

确认时选择y即可。

然后键入

make

就会生成svmtrain.dll,svmpredict.dll和read_sparse.dll这三个文件(对于Matlab 7.1及以上版本,生成的对应文件为svmtrain.mexw32,svmpredict.mexw32和read_sparse.mexw32)

然后可以在matlab的菜单File->Set Path->Add Folder里,把c:\libsvm-mat-2.83-1目录添加进去,这样以后在任何目录下都可以调用libsvm的函数了。

为了检验libsvm和matlab之间的接口是否已经配置完成,可以在matlab下执行以下命令:

load heart_scale.mat

model = svmtrain(heart_scale_label, heart_scale_inst, '-c 1 -g 2');

如果运行正常并生成了model这个结构体(其中保存了所有的支持向量及其系数),那么说明libsvm和matlab之间的接口已经完全配置成功。

附:SVM的历史

基于数据的机器学习是现代智能技术中的重要方面, 研究从观测数据(样本) 出发寻找规律, 利用这些规律对未来数据或无法观测的数据进

行预测. 包括模式识别、神经网络等在内, 现有机器学习方法共同的重要理论基础之一是统计学.传统统计学研究的是样本数目趋于无穷大时的渐近理论, 现有学习方法也多是基于此假设. 但在实际问题

中, 样本数往往是有限的, 因此一些理论上很优秀的学习方法实际中表现却可能不尽人意.

与传统统计学相比, 统计学习理论

(Statistical Learning Theory 或SLT ) 是一种专门研究小样本情况下机器学习规律的理论. V. Vapnik等人从六、七十年代开始致力于此方面研究 , 到九十年代中期, 随着其理论的不断发展和成熟, 也由于神经网络等学习方法在理论上缺乏实质性进展, 统计学习理论开始受到越来越广泛的重视.

统计学习理论是建立在一套较坚实的理论基础之上的, 为解决有限样本学习问题提供了一个统一的框架. 它能将很多现有方法纳入其中, 有望帮助解决许多原来难以解决的问题(比如神经网络结构选择问题、局部极小点问题等) ; 同时, 在这一理论基础上发展了一种新的通用学习方法——支持向量机(Support Vector Machine 或

SVM ) , 它已初步表现出很多优于已有方法的性能. 一些学者认

为,SVM 正在成为继神经网络研究之后新的研究热点, 并将有力地推动机器学习理论和技术的发展。

我国早在八十年代末就有学者注意到支持向量机的基础成果,但之后较少研究,目前只有少部分学者认识到这个重要的研究方向.。