支持向量机(SVM)简明学习教程

- 格式:doc

- 大小:397.00 KB

- 文档页数:8

SVM学习之五——支持向量机的原理名词解释1——支持向量机:“机(machine,机器)”实际上是一个算法。

在机器学习领域,常把一些算法看作是一个机器(又叫学习机器,或预测函数,或学习函数)。

“支持向量”则是指训练集中的某些训练点的输入xi 。

它是一种有监督(有导师)学习方法,即已知训练点的类别,求训练点和类别之间的对应关系,以便将训练集按照类别分开,或者是预测新的训练点所对应的类别。

名词解释2——符号函数:sgn(a) = 1, a >= 0;sgn(a) = -1, a < 0.一般地,考虑 n 维空间上的分类问题,它包含 n 个指标和 l 个样本点。

记这 l 个样本点的集合为 T = {(x1,y1),...,(xl,yl)},其中 xi 是输入指标向量,或称输入,或称模式,其分量称为特征,或属性,或输入指标;yi 是输出指标向量,或称输出,i = 1,...,l。

这 l 个样本点组成的集合称为训练集,所以我们也称样本点位训练点。

对于训练集来说,有线性可分、近似线性可分和线性不可分等三种情况,这就是分类问题的三种类型。

其实,无论是哪类问题,都有对应的分类机,这将在以下的内容中进行详细阐述。

那么,有人可能会问,什么叫线性可分?通俗地讲,就是可以用一条或几条直线把属于不同类别的样本点分开。

实际上,求解分类问题,就是要求出这条或这几条直线!那么,问题是:怎么求?这里先以二维两类线性可分的分类问题为例,做个详细的说明,然后再过渡到多类分类问题。

首先,回忆一下平面(二维)坐标系中某条直线的方程。

还记得直线的一般方程Ax + By + C = 0 (公式一)吧,我们引入向量的概念,则该方程可以写成{x,y}与{A,B}的内积加上C等于0,即{A,B}·{x,y} + C = 0你还记得法向量和方向向量的概念吗?其实{A,B}就是法向量,而{B,-A}就是方向向量了。

那么我们可以把直线的一般方程简化成为w·x + b = 0 (公式二)的形式(因为这个式子是大家最常用的嘛)。

⽀持向量机(SVM)原理详解SVM简介 ⽀持向量机(support vector machines, SVM)是⼀种⼆分类模型,它的基本模型是定义在特征空间上的间隔最⼤的线性分类器,间隔最⼤使它有别于感知机;SVM还包括核技巧,这使它成为实质上的⾮线性分类器。

SVM的的学习策略就是间隔最⼤化,可形式化为⼀个求解凸⼆次规划的问题,也等价于正则化的合页损失函数的最⼩化问题。

SVM的的学习算法就是求解凸⼆次规划的最优化算法。

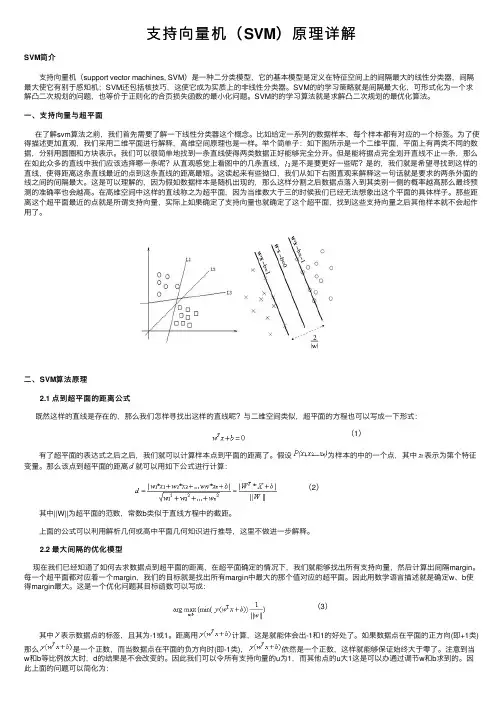

⼀、⽀持向量与超平⾯在了解svm算法之前,我们⾸先需要了解⼀下线性分类器这个概念。

⽐如给定⼀系列的数据样本,每个样本都有对应的⼀个标签。

为了使得描述更加直观,我们采⽤⼆维平⾯进⾏解释,⾼维空间原理也是⼀样。

举个简单⼦:如下图所⽰是⼀个⼆维平⾯,平⾯上有两类不同的数据,分别⽤圆圈和⽅块表⽰。

我们可以很简单地找到⼀条直线使得两类数据正好能够完全分开。

但是能将据点完全划开直线不⽌⼀条,那么在如此众多的直线中我们应该选择哪⼀条呢?从直观感觉上看图中的⼏条直线,是不是要更好⼀些呢?是的,我们就是希望寻找到这样的直线,使得距离这条直线最近的点到这条直线的距离最短。

这读起来有些拗⼝,我们从如下右图直观来解释这⼀句话就是要求的两条外⾯的线之间的间隔最⼤。

这是可以理解的,因为假如数据样本是随机出现的,那么这样分割之后数据点落⼊到其类别⼀侧的概率越⾼那么最终预测的准确率也会越⾼。

在⾼维空间中这样的直线称之为超平⾯,因为当维数⼤于三的时候我们已经⽆法想象出这个平⾯的具体样⼦。

那些距离这个超平⾯最近的点就是所谓⽀持向量,实际上如果确定了⽀持向量也就确定了这个超平⾯,找到这些⽀持向量之后其他样本就不会起作⽤了。

⼆、SVM算法原理 2.1 点到超平⾯的距离公式既然这样的直线是存在的,那么我们怎样寻找出这样的直线呢?与⼆维空间类似,超平⾯的⽅程也可以写成⼀下形式:(1) 有了超平⾯的表达式之后之后,我们就可以计算样本点到平⾯的距离了。

超详细SVM(支持向量机)知识点一. 简单概括一下SVM:SVM 是一种二类分类模型。

它的基本思想是在特征空间中寻找间隔最大的分离超平面使数据得到高效的二分类,具体来讲,有三种情况(不加核函数的话就是个线性模型,加了之后才会升级为一个非线性模型):•当训练样本线性可分时,通过硬间隔最大化,学习一个线性分类器,即线性可分支持向量机;•当训练数据近似线性可分时,引入松弛变量,通过软间隔最大化,学习一个线性分类器,即线性支持向量机;•当训练数据线性不可分时,通过使用核技巧及软间隔最大化,学习非线性支持向量机。

二. SVM 为什么采用间隔最大化(与感知机的区别):当训练数据线性可分时,存在无穷个分离超平面可以将两类数据正确分开。

感知机利用误分类最小策略,求得分离超平面,不过此时的解有无穷多个。

线性可分支持向量机利用间隔最大化求得最优分离超平面,这时,解是唯一的。

另一方面,此时的分隔超平面所产生的分类结果是最鲁棒的,对未知实例的泛化能力最强。

三. SVM的目标(硬间隔):有两个目标:第一个是使间隔最大化,第二个是使样本正确分类,由此推出目标函数:稍微解释一下,w是超平面参数,目标一是从点到面的距离公式化简来的,具体不展开,目标二就相当于感知机,只是把大于等于0进行缩放变成了大于等于1,为了后面的推导方便。

有了两个目标,写在一起,就变成了svm的终极目标:四. 求解目标(硬间隔):从上面的公式看出,这是一个有约束条件的最优化问题,用拉格朗日函数来解决。

上式的拉格朗日函数为:在满足Slater定理的时候,且过程满足KKT条件的时候,原问题转换成对偶问题:先求内部最小值,对和 b 求偏导数=0可得将其带入到上式中可以得到此时需要求解α ,利用SMO(序列最小优化)算法:五. 软间隔:不管直接在原特征空间,还是在映射的高维空间,我们都假设样本是线性可分的。

虽然理论上我们总能找到一个高维映射使数据线性可分,但在实际任务中,寻找一个合适的核函数核很困难。

支持向量机(SVM)原理详解支持向量机(Support Vector Machine, SVM)是一种机器学习算法,用于二分类和多分类问题。

它的基本思想是寻找一个超平面,能够将不同类别的数据分隔开来,并且与最近的数据点之间的间隔最大。

一、原理概述:SVM的基本原理是将原始数据映射到高维空间中,使得在该空间中的数据能够线性可分,然后在高维空间中找到一个最优的超平面。

对于线性可分的情况,SVM通过最大化分类边界与最近数据点之间的距离,并将该距离定义为间隔,从而使分类边界具有更好的泛化能力。

二、如何确定最优超平面:1.线性可分的情况下:SVM寻找一个能够将不同类别的数据分开的最优超平面。

其中,最优超平面定义为具有最大间隔(margin)的超平面。

间隔被定义为超平面到最近数据点的距离。

SVM的目标是找到一个最大化间隔的超平面,并且这个超平面能够满足所有数据点的约束条件。

这可以通过求解一个凸二次规划问题来实现。

2.线性不可分的情况下:对于线性不可分的情况,可以使用一些技巧来将数据映射到高维空间中,使其线性可分。

这种方法被称为核技巧(kernel trick)。

核技巧允许在低维空间中计算高维空间的内积,从而避免了直接在高维空间中的计算复杂性。

核函数定义了两个向量之间的相似度。

使用核函数,SVM可以在高维空间中找到最优的超平面。

三、参数的选择:SVM中的参数有两个主要的方面:正则化参数C和核函数的选择。

1.正则化参数C控制了分类边界与数据点之间的权衡。

较大的C值将导致更少的间隔违规,增加将数据点分类正确的权重,可能会导致过拟合;而较小的C值将产生更宽松的分类边界,可能导致欠拟合。

2.核函数选择是SVM中重要的一步。

根据问题的特点选择合适的核函数能够更好地处理数据,常用的核函数有线性核函数、多项式核函数和高斯核函数等。

四、优缺点:SVM有以下几个优点:1.在灵活性和高扩展性方面表现出色,尤其是在高维数据集上。

2.具有良好的泛化能力,能够很好地处理样本数量较少的情况。

支持向量机的构建方法支持向量机(Support Vector Machine,SVM)是一种非常强大的机器学习算法,常用于分类和回归问题。

它的构建方法主要包括数据预处理、选择核函数、确定超参数和模型训练四个步骤。

第一步,数据预处理。

在构建支持向量机模型之前,我们需要对数据进行预处理。

这包括数据清洗、特征选择和数据标准化。

数据清洗是指处理缺失值、异常值和重复值等数据质量问题。

特征选择是从所有特征中选择最相关的特征,以提高模型的准确性和泛化能力。

数据标准化是将不同尺度的特征转化为相同的尺度,以避免特征之间的差异对模型的影响。

第二步,选择核函数。

在支持向量机中,核函数是一个非常重要的概念,它用于将数据从原始空间映射到一个高维特征空间,以便在特征空间中进行线性分类。

常用的核函数有线性核、多项式核和高斯核等。

选择合适的核函数对于支持向量机的性能至关重要,需要根据数据的特点和分类问题的复杂度进行选择。

第三步,确定超参数。

超参数是在模型训练之前需要确定的参数,它们不是通过模型的训练数据来学习得到的。

常见的超参数有正则化参数C和核函数参数gamma。

正则化参数C控制着对误分类样本的惩罚程度,过大的C会导致过拟合,过小的C会导致欠拟合。

核函数参数gamma决定了样本点映射到特征空间后的影响范围,过大的gamma会导致模型过于复杂,过小的gamma会导致模型过于简单。

通过交叉验证等方法,可以选择合适的超参数。

第四步,模型训练。

在进行模型训练之前,需要先将数据分为训练集和测试集。

训练集用于模型的参数估计和调整,而测试集用于模型的性能评估。

通过优化目标函数,支持向量机的模型可以得到最优的超平面,以实现对样本的分类。

训练过程可以使用优化算法(如序列最小最优化算法)来求解。

总结起来,支持向量机的构建方法包括数据预处理、选择核函数、确定超参数和模型训练。

这些步骤的合理选择和操作对于构建一个高效的支持向量机模型至关重要。

在实际应用中,我们需要根据数据的特点和问题的复杂度来选择适当的方法,并通过交叉验证等技术进行调优,以达到最佳的分类效果。

机器学习中支持向量机算法的使用教程及实战案例分析支持向量机(Support Vector Machine,SVM)是一种重要的机器学习算法,被广泛应用于分类和回归问题。

它在许多实际应用中显示出了出色的性能和鲁棒性。

本文将详细介绍支持向量机算法的原理、使用方法和实战案例分析。

一、支持向量机算法的原理支持向量机算法的基本原理是基于最大间隔分类的思想,通过在特征空间中找到一个最优超平面,将不同类别的数据样本完全分开。

该超平面由支持向量确定,支持向量是距离超平面最近的样本点。

支持向量机算法的目标是最大化间隔。

间隔指的是超平面到最近的样本点的距离,最大化间隔可以提高模型的鲁棒性。

支持向量机算法可以处理线性可分和线性不可分的问题。

对于线性可分问题,可以使用硬间隔支持向量机;对于线性不可分问题,可以使用软间隔支持向量机,通过引入松弛变量来容忍一定的错分类。

二、支持向量机算法的使用方法1. 数据预处理在应用支持向量机算法之前,需要对数据进行预处理。

首先,对数据进行清洗,处理缺失值和异常值。

然后,对数据进行标准化或归一化,以便不同特征之间的数值范围一致。

2. 特征选择选择合适的特征对支持向量机算法的性能至关重要。

可以通过统计方法、相关性分析或专业知识等方式选择最具区分度的特征。

3. 模型训练将数据集分为训练集和测试集,使用训练集对支持向量机模型进行训练。

在模型训练过程中,需要选择合适的核函数和参数,并进行交叉验证来确定最优的模型。

4. 模型评估使用测试集对训练好的支持向量机模型进行评估。

常用的评估指标包括准确率、精确率、召回率和F1值等。

通过评估结果可以判断模型的性能。

三、支持向量机算法的实战案例分析为了更好地理解支持向量机算法的应用,下面将介绍一个实战案例:乳腺癌分类。

乳腺癌是女性常见的恶性肿瘤之一,及早发现和诊断对于治疗和预后非常重要。

在这个案例中,我们将使用支持向量机算法对乳腺癌进行分类。

首先,我们收集了乳腺癌相关的临床特征数据,包括肿块的厚度、大小、形状等。

支持向量机(SVM)、支持向量机回归(SVR):原理简述及其MATLAB实例一、基础知识1、关于拉格朗日乘子法和KKT条件1)关于拉格朗日乘子法2)关于KKT条件2、范数1)向量的范数2)矩阵的范数3)L0、L1与L2范数、核范数二、SVM概述1、简介2、SVM算法原理1)线性支持向量机2)非线性支持向量机二、SVR:SVM的改进、解决回归拟合问题三、多分类的SVM1. one-against-all2. one-against-one四、QP(二次规划)求解五、SVM的MATLAB实现:Libsvm1、Libsvm工具箱使用说明2、重要函数:3、示例支持向量机(SVM):原理及其MATLAB实例一、基础知识1、关于拉格朗日乘子法和KKT条件1)关于拉格朗日乘子法首先来了解拉格朗日乘子法,为什么需要拉格朗日乘子法呢?记住,有需要拉格朗日乘子法的地方,必然是一个组合优化问题。

那么带约束的优化问题很好说,就比如说下面这个:这是一个带等式约束的优化问题,有目标值,有约束条件。

那么你可以想想,假设没有约束条件这个问题是怎么求解的呢?是不是直接 f 对各个 x 求导等于 0,解 x 就可以了,可以看到没有约束的话,求导为0,那么各个x均为0吧,这样f=0了,最小。

但是x都为0不满足约束条件呀,那么问题就来了。

有了约束不能直接求导,那么如果把约束去掉不就可以了吗?怎么去掉呢?这才需要拉格朗日方法。

既然是等式约束,那么我们把这个约束乘一个系数加到目标函数中去,这样就相当于既考虑了原目标函数,也考虑了约束条件。

现在这个优化目标函数就没有约束条件了吧,既然如此,求法就简单了,分别对x求导等于0,如下:把它在带到约束条件中去,可以看到,2个变量两个等式,可以求解,最终可以得到,这样再带回去求x就可以了。

那么一个带等式约束的优化问题就通过拉格朗日乘子法完美的解决了。

更高一层的,带有不等式的约束问题怎么办?那么就需要用更一般化的拉格朗日乘子法,即KKT条件,来解决这种问题了。

SVM入门SVM入门(一)SVM的八股简介支持向量机(Support Vector Machine)是Cortes和Vapnik于1995年首先提出的,它在解决小样本、非线性及高维模式识别中表现出许多特有的优势,并能够推广应用到函数拟合等其他机器学习问题中[10]。

支持向量机方法是建立在统计学习理论的VC 维理论和结构风险最小原理基础上的,根据有限的样本信息在模型的复杂性(即对特定训练样本的学习精度,Accuracy)和学习能力(即无错误地识别任意样本的能力)之间寻求最佳折衷,以期获得最好的推广能力[14](或称泛化能力)。

以上是经常被有关SVM 的学术文献引用的介绍,有点八股,我来逐一分解并解释一下。

Vapnik是统计机器学习的大牛,这想必都不用说,他出版的《Statistical Learning Theory》是一本完整阐述统计机器学习思想的名著。

在该书中详细的论证了统计机器学习之所以区别于传统机器学习的本质,就在于统计机器学习能够精确的给出学习效果,能够解答需要的样本数等等一系列问题。

与统计机器学习的精密思维相比,传统的机器学习基本上属于摸着石头过河,用传统的机器学习方法构造分类系统完全成了一种技巧,一个人做的结果可能很好,另一个人差不多的方法做出来却很差,缺乏指导和原则。

所谓VC维是对函数类的一种度量,可以简单的理解为问题的复杂程度,VC维越高,一个问题就越复杂。

正是因为SVM关注的是VC维,后面我们可以看到,SVM解决问题的时候,和样本的维数是无关的(甚至样本是上万维的都可以,这使得SVM很适合用来解决文本分类的问题,当然,有这样的能力也因为引入了核函数)。

结构风险最小听上去文绉绉,其实说的也无非是下面这回事。

机器学习本质上就是一种对问题真实模型的逼近(我们选择一个我们认为比较好的近似模型,这个近似模型就叫做一个假设),但毫无疑问,真实模型一定是不知道的(如果知道了,我们干吗还要机器学习?直接用真实模型解决问题不就可以了?对吧,哈哈)既然真实模型不知道,那么我们选择的假设与问题真实解之间究竟有多大差距,我们就没法得知。

支持向量机(Support Vector Machine,SVM)是一种常用的机器学习算法,在分类问题上表现出色。

然而,SVM也可以用于回归分析,即根据已知数据来预测一个连续值。

本文将介绍如何使用支持向量机进行回归分析,并探讨其优缺点及应用场景。

一、支持向量机回归分析的原理支持向量机回归分析的核心思想是寻找一个超平面,使得训练数据点到这个超平面的距离尽可能小,并且在距离之外有尽可能多的点。

这个超平面实际上就是预测模型,而距离则是模型的误差。

在SVM中,距离的计算采用的是间隔(margin)的概念,而不是传统回归分析中的误差平方和。

具体而言,支持向量机回归分析的目标是最小化间隔的同时最大化预测误差的容忍度。

这个过程可以通过求解一个凸优化问题来实现,通常采用的是拉格朗日对偶性及其相关的算法。

这种方法的优点是可以避免局部最优解的问题,而且对于高维数据也有较好的表现。

二、支持向量机回归分析的优点与传统的线性回归模型相比,支持向量机回归分析有几个明显的优点。

首先,SVM可以处理非线性关系,因为支持向量机在寻找超平面时可以通过核函数将数据映射到高维空间,从而更容易找到一个合适的超平面。

其次,SVM对异常值和噪声的鲁棒性较好,因为SVM在训练模型时只使用了支持向量,而对于非支持向量的数据点,其影响较小。

最后,SVM具有较好的泛化能力,即在面对新数据时能够给出较准确的预测结果。

三、支持向量机回归分析的缺点然而,支持向量机回归分析也存在一些缺点。

首先,SVM模型的训练时间较长,尤其在处理大规模数据时会变得非常耗时。

其次,SVM模型的解释性较差,即很难从模型本身得到一些直观的结论。

最后,SVM模型对参数的选择较为敏感,需要进行大量的调参工作才能得到较好的结果。

四、支持向量机回归分析的应用场景支持向量机回归分析在很多领域都有着广泛的应用。

例如,在金融领域,可以利用支持向量机模型来预测股票价格的变化趋势;在医学领域,可以利用支持向量机模型来预测病人的生存时间或疾病的发展情况;在工程领域,可以利用支持向量机模型来预测材料的强度或者产品的寿命等。

支持向量机(SVM )简明学习教程一、最优分类超平面给定训练数据),(,),,(11l l y x y x ,其中n i R x ∈,}1,1{-∈i y 。

若1=i y ,称i x 为第一类的,I ∈i x ;若1-=i y ,称i x 为第二类的,II ∈i x 。

若存在向量ϕ和常数b ,使得⎪⎩⎪⎨⎧II∈<-I∈>-i i T i i T x if b x x if b x ,0,0ϕϕ (1),则该训练集可被超平面0=-b x T ϕ分开。

(一)、平分最近点法求两个凸包集中的最近点d c ,',做d c ,'的垂直平分面x ,即为所求。

02)(2222=---⇒-=-dc xd c x d xc T,则d c -=ϕ,2)()(d c d c b T +-=。

求d c ,,⎪⎩⎪⎨⎧≥==≥==∑∑∑∑-=-===.0,1,.0,1,1111i y iy i i i y iy i i i i i i x d x c αααααα所以2112∑∑-==-=-i i y iiy ii xx dc αα,只需求出最小的T l ),,(1ααα =。

算法:1)求解.0,1,1..2121min 1121211≥===-∑∑∑∑∑-===-==i y i y i li i i i y i i y i i i i i i t s x y x x αααααα;2)求最优超平面0=-b x T ϕ。

(二)、最大间隔法附加条件1=ϕ,加上(1)式。

记C x C i T x i >=I∈ϕϕmin )(1,C x C i T x i <=I I∈ϕϕmax )(2。

使⎪⎩⎪⎨⎧II∈<-I∈>-=-=i i Ti i Tx if b x x if b x t s C C ,0,0,1..2)()()(max 21ϕϕϕϕϕϕρ (2) 可以说明在(2)下可以得到一个最优超平面,且该超平面是唯一的。

如何快速生成一个最优超平面??? 考虑等价问题:求权向量w 和b ,使⎪⎩⎪⎨⎧II∈-<-I∈>-i i T i i T x if b x w x if b x w ,1,1,且ϕ最小。

这种写法已经包含最大间隔。

事实上b C C C x if C b x w x if C b x w i i T i i T=+=⇒⎪⎩⎪⎨⎧II∈=+-<I∈=+>))()((21),(1),(121021ϕϕϕϕ中心,而w w =ϕ,故w b C =,wC C 12)()()(21=-=ϕϕϕρ。

所以(2)式可以转化为求解:1)(..min≥-b x w y t s wi Ti (3)总结,求最优超平面,只需求解:1)(..21)(min ≥-=Φb x w y t s w w w i T i T (QP1)对(QP1)构造lagrange 函数:令∑=---=li i T i i b x w y w b w L 12]1)([21),,(αα,其中0),,(1≥=T l ααα 为lagrange 乘子。

下求L 的鞍点:1=i =i 1将2)代入L 中,且目标改为)(αW 。

则∑∑∑===+-=li i l i l j j Ti j i j i x x y y W 11121)(αααα所以,(QP1)的对偶问题为:,0..)(max =≥∑iiyt s W ααα (DQP1)由KKT 条件,0]1)([=--b x w y i T i i α。

若存在0*>j α时,有01)(=--b x w y j Tj ,此时,SV j ∈,则∑+-=+-=ij T i i i j j T j x x y y x w y b α*几何意义:i x ,SV i ∈是与超平面距离最近的向量,称其为支持向量。

他在构造超平面中起到及其重要的作用。

SVM 算法1(线性可分SVM 分类机) 1)、求解规划问题(DQP1)2)、求∑==li i i i x y w 1*α和∑+-=ij T i i i j x x y y b α*,得到分类超平面0**=-b x w T 。

3)、分类器:)()(**b x w sign x f T -=。

(三)、软间隔分类超平面针对样本数据线性不可分的情况。

此时02)()()(21<-=ϕϕϕρC C 。

解决方案:软化约束(通过添加松弛因子)。

i j T j b x w y ξ-≥-1)(,其中,0≥i ξ。

显然,当i ξ充分大时,软约束总是成立的,但i ξ不应该取太大。

所以将i ξ加入到目标中,得到(QP2):.0,1)(..21)(min ≥-≥-+=Φ∑i i i T i ii Tb x w y t s C w w w ξξξ (QP2)其中,C 为正的惩罚参数。

显然,QP2包含了QP1的,(取∞→C )。

另外,QP2的鲁棒性好(稳定性好) 同样,对(QP2)构造lagrange 函数:令∑∑∑----+==i i li i T i i i b x w y C w b w L ξβαξβαξ12]1)([21),,,,(。

1=i =i 13)、C C C L i i i i ≤-=≤⇒=--⇒=∇βαβαξ000。

代入L 中,得∑∑---+-)(212i i i i i i C w ξβξαξα。

所以,(QP2)的对偶问题为:0,0..21min 111=≥≥-∑∑∑∑===iili i l i l j j Ti j i j i yC t s x x y y ααααα (DQP2) 对于b ,由KKT 条件⎩⎨⎧=-=+--0)(0]1)([C b x w y i i i i T i i αξξα。

当0*>>j C α时,0=j ξ,则∑+-=+-=ij T i i i j j T j x x y y x w y b α*。

(四)、支持向量机对于本质线性不可分问题,有两种方法:(1)构造非线性分类器;(2)将样本点射到高维特征空间,再用线性分类器。

例1:)}1,3(),1,1(),1,1{(--=T 不可分映射:T x x x ),(2→,则)}1,93(),1,11(),1,11{(~⎪⎪⎭⎫ ⎝⎛-⎪⎪⎭⎫ ⎝⎛⎪⎪⎭⎫ ⎝⎛-=T 可分。

基本思想:Z x x x x T m ==→))(,),(()(1ϕϕϕ ,),(),(i i i i y Z y x → 例2:对于圆0)()(21222122221=++++⇒=-+-E Dx Cx Bx Ax r b x a x ,故Z x x x x x x x x T ==→=)1,,,,()(),(21222121ϕ。

但复杂性增大,如n R x ∈,则二次特征空间n n n N ++=2/)1(。

(问题:推广性如何评价,技术上如何处理高维数据???)1)、核函数设Z X Z →:,n R X x ⊂∈∀,N N T N R z z x Z x Z x Z ∈==),,())(,),(()(11 。

(注N 可为无穷)考虑在Hilbert 空间中内积的一个一般表达式:),()(i i x x K z z =•。

根据Hilbert-Schmidt 理论,),(i x x K 可以是满足下面一般条件的任意对称函数(Courant andHilbert,1953)定理(Mercer )要保证2l 中的对称连续函数),(v u K 能以正的系数0>k a 展开成),()()(),(1v u K v u a v u K k k k k ⇔⋅⋅=∑∞=ϕϕ正定。

(⎰⎰>⋅⋅⇔0)()(),(v g u g v u K K 正定)2)支持向量机 训练样本)},(,),,{(11l l y x y x T =,Nn R x z R x ∈=→∈)(ϕ,则)}),((,),),({(~11l l y x y x T ϕϕ =。

求Z ~上的超平面将T ~分开(若可分),则最大间隔超平面: 1))((..21)(min ≥-=Φb x w y t s w w w i T i Tϕ (QP3)其对偶问题为:,0..),(21min 111=≥-∑∑∑∑===iili i l i lj j i j i j i yt s x x K y y ααααα (DQP3) 设(DQP3)有解*α,则∑==li i i i x y w 1**)(ϕα,∑+-=+-=ij i i i j j T j x x K y y x w y b ),()(*αϕ,(}0|{*>∈i i j α)。

从而,决策函数为))()(())(()(*1***b x x y sign b x w sign x f li T i i i T-=-=∑=ϕϕαϕ)),((*1*b x x K y sign li i i i -=∑=α。

算法(可分的SVM )(1)、选样本)},(,),,{(11l l y x y x T =; (2)、选核函数,用Mercer 定理判断; (3)、计算*α,由(DQP3); (4)、代入决策函数应用。

(错误率高可转(2)重来)同样,对特征映射后的样本点T ~线性可分难于判断,可引人松弛变量:.0,1)(..21)(min ≥-≥-+=Φ∑i i i T i ii Tb x w y t s C w w w ξξξ (QP4)其对偶问题为:0,0..),(21min 111=≥≥-∑∑∑∑===iili i l i lj j i j i j i yC t s x x K y y ααααα (DQP4) 则∑+-=+-=ij i i i j j T j x x K y y x w y b ),()(*αϕ,(}0|{*>>∈i C i j α)。

决策函数为)(x f )),((*1*b x x K y sign li i i i -=∑=α。

(存在问题:1、C 的选择;2、K 的选择????)3)常用的核函数d 阶多项式核:d T y x y x K )1(),(+=;Gauss 核:}exp{)(),(2y x r y x K y x K r --=-=;))((),(c y x v S y x K T +=,其中)(u S 为Sigmoid 函数,但他不满足Mercer 定理。

二、估计实值函数的支持向量机 (一)、回归分析已知)},(,),,{(11l l y x y x T =,R y R x i n i ∈∈,,最小二乘:εα+=),(x f y ,),0(2σεN ∈。

其定义损失函数为:2)),(()),(,(ααx f y x f y L -=,使得经验风险最小:∑-ii ix f y2)),((minα。