- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

p( xi | yi ) I ( xi ; yi ) log2 p( xi )

xi 的自信息:

1 I ( xi ) log2 p( xi )

平均互信息:( X ; Y ) p( xi , y j ) log2 I

i 1 j 1

n

m

p( xi , y j ) p( xi ) p( y j )

x(t )

n

x(

n ) 2W

sin[2W (t

利用抽样定理可把模拟信源的输出转换成等效的 离散时间信源。

n )] 2W n 2W (t ) 2W

二. 信息的量度——熵及其性质

1. 熵 离散随机变量 xi

事件X

yi 事件Y 事件Y yi 的出现提供事件X xi 的信息量 xi 和 yi 间的互信息:

源符号平均所需的最小的r元码位数就是原 始信源的熵值 H r (s) 。 (2)通过增加扩展信源的次数N,可使编码 平均码长 LN N 达到下限值。 (3)逆定理:若平均编码码长小于信源的熵 值,则惟一可译码不存在,在译码时必然要 引起失真。

2. 香农第二定理 — 噪声信道编码定理

信道编码——第七章 最大似然译码准则:MLD (Maximum Likelihood Decoding) 香农第二定理:(存在性定理) 设某信道有r个输入符号,s个输出符号,信道 容量为C,只要码长n足够长,总可以在输入的 r n 个符号集中找到M个码字组成一个码,并存在相应 的译码规则,使信道输出的错误概率 PE 任意小。 M 2n (C ) , 为 其中M个等可能的消息,且 任意小的正数。

n H ( x) p( xi ) log p( xi ) i 1 0 p( x ) 1 H ( x) 0 i

当 x i为确定时 p( xi ) 1 ,则 H ( x) 0 确定性越大,H (x) 越小。

信源的熵 H (x)反映的是信源的总体不确定性。

H (s) LN H ( s) 1 log2 r N log2 r N

LN H ( s) N 时有: lim 且当 H r ( s) N N log2 r

若以二元码表示编码,则

LN 1 H ( s) H ( s) N N

说明:(1)要实现无失真的信源编码,变换每个信

1. 香农第一定理 —— 无失真可变长信源编码 定理

(1)信源编码器 a. 信源编码的实质:是对信源的原始符号按一定规 则进行变换,以新的编码符号代替原始信源符号, 从而降低原始信源的冗余度。 b. 编码的过程:是按照一定的规则,将信源的各个 原始符号 i 表示成码字 Wi 输出,而 Wi 是由若干个 码元 xi j组成的序列。

(3)只要信道编码后,输入信道的信息传输率不超 过信道容量C,则总存在最佳编码,使传输达到任 意高的可靠性。

3. 香农第三定理 —— 保真度准则下的信源 编码定理

(1)失真度与信息失真函数 失真度:对于每一对输入、输出符号 (u , v ) 定义单符号失真度: d (ui , v j ) 0 i 1,2,, r; j 1,2, , s

一种码字个数为 M 2 K [ R ( D ) ] 的信源编码,使 编码后码的平均失真度 D D 。

) 组成的 a. 对于长度为K的M个码字 (M 2 码C,编码后每个符号的信息传输率为:

log 2 M R R( D) K 即 R不小于率失真函数 R(D) 。

k [ R ( D ) ]

d (ui , v j ) (ui v j ) P ( P 2)

平均失真度定义:

D [d (ui , v j )] E[d (u, v)]

(2)信息率失真函数 a. R(D) min{p(v j | ui ), D D} {I (U ;V )} (比特 / 符号) 信息传输率 I (U ;V ) b. 无记忆高斯信源的率失真函数(香农,1959年)

说明:

M 2n(C ),由于对M个等概率消息进行 (1)码字数 编码,则编码后每符号的信息传输率为: log 2 M R C R可以无限逼近信息容量C。 n (2)只要码长n足够长,则总可以找到一种码,使 编码后的信道信息传输率R达到信道容量,且在相 应的译码规则下使错误概率最小,从而实现极高的 传输可靠性。

平均自信息: H ( x) p( xi ) I ( xi )

i 1

n

p( xi ) log2 p( xi )

i 1

n

H X 表示信源可能的输出字符集, (X ) 表示每个信 源字符的平均自信息。

H (x)称为信源的熵

2. 熵的基本性质 (1)非负性 H ( x) 0 (2)确定性

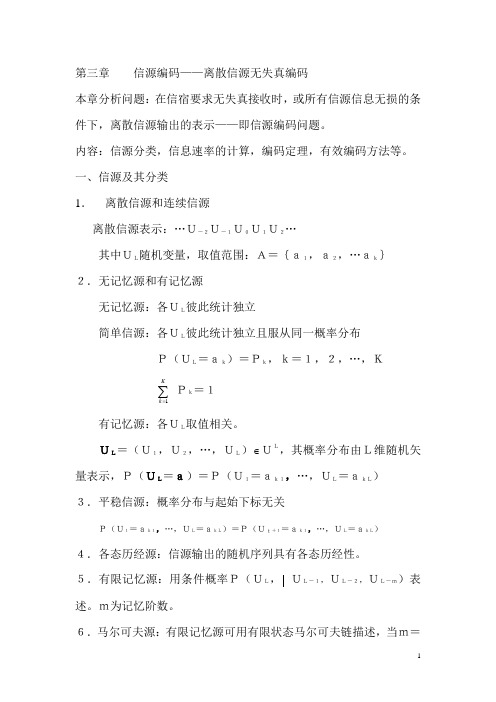

第三章 信源编码

主要内容:

1. 信源的数学模型和量度

2. 离散信源的编码 —— 离散无记忆信源的编码 及其相关算法 (1)最优量化技术 (2)编码技术(时间波形编码,频谱波形编码, 模型基信息编码)

基本概念:

信源——离散、模拟 DMS——离散无记忆信源 对数量度 平均互信息 熵及其基本性质 信源编码定理Ⅰ,Ⅱ 霍夫曼编码算法 率失真函数及香农定理 量化(矢量量化)(K均值算法) PCM DPCM 适应PCM和DPCM DM(增量调制) 自适应变换编码 LPC——线性预测编码

H 为该码的编码效率。式中, (s ) 代表信息量,N为 扩展信源次数,即N次扩展信源的无失真编码。

LN H ( s) log r N

(2)香农第一定理——可变长无失真信源编码定理 设 S N {1,2 ,,q }N 为q元离散无记忆信源S 的N次扩展信源,若对 S N 进行编码,码符号集 {x1 , x2 ,.xr } X , 则总可以找到一种编码方法 构成惟一可译码,使信源S中每个符号所需的 平均码长度 LN / N 满足:

(3)对称性 H (P , P2 ,, Pq ) H (Pi , P ,, Pi ) 1 i

1 2 q

即当 P , P ,, P 的顺序互换时,熵函数的值不变 1 2 q

熵函数只与随机变量的总体结构有关

(4)扩展性 lim H ( P , P2 ,, Pq , , ) H ( P , P2 , , Pq ) 1 1 0 当信源中增加小概率事件后,对信源总的平均 不确定性几乎没有影响。 熵的总体平均性 (5)可加性 对于两个统计独立信源X和Y,有 H ( XY ) H ( X ) H (Y ) 1 1 1 (6)极值性 H ( P1 , P2 ,, Pq ) H ( , ,, ) log q

Rg (D)

1 2 2 log2 ( x / D) (0 D x ) 2 2 0 (D x )

x2 为高斯信源输出的方差。

(3)香农第三定理(存在性定理)

设 R(D)为一离散无记忆信源的信息率失真

函数,并且有有限的失真测度D,则对于任意

D 0, 0 ,以及任意长的码长K,一定存在

b. 只要码长K足够长,总可以找到一种信源编码, 使编码后的信息传输率略大于率失真函数 R(D) , 而D D 。

c. 如果编码后的信息传输率 R R(D),则保真度准 则 D D 不再满足。

四. 信源编码技术

1. 离散信源编码

2. 模拟信源编码

一. 信源的数学模型

信源:随机信号(能量信号,功率信号)<非确知信号> 信源输出序列统计独立 —— DMS(离散无记忆信源) 信源的输出统计相关 ——(平稳) 模拟信源具有输出波形 x(t ),是平稳随机过程 X (t ) 的一个样本函数,其自相关函数xx ( ) ,功率密度谱xx ( f ) 当 X (t )是带限的随机过程,即 | f | W 时,满足条 件 xx ( f ) 0 ,可以用抽样定理来表示 x(t )

q q q

信源中各事件的出现概率趋于均等时,信源具 有最大熵。 等概率事件平均不确定性最大 证明:用到凸函数和詹森不等式

E[logY ] log[E (Y )]

p

i 1

q

i

logyi log pi yi

i 1

q

三. 香农三大定理

通信的根本问题是如何高效、可靠地实现信息 的传输。

编码就是从信源符号到码符号组成的码字之

间的一种映射。

S : s {1 ,, q }

C : c {W1 ,,Wq }

X : x {x1 ,, xr }

Wi ( xi1 , xi2 ,, xil )

c. 定义1. 若某一种码的任意一串有限长的符号序列 只能被惟一地译成所对应的信源符号,则该码称 为惟一可译码。 定义2. 若用r元码对信源 S N 进行编码,设S中每个 符号所需的平均码长为 LN / N ,则定义

需要解决两个问题: (1)在不失真或允许一定失真的条件下,如何用尽 可能少的编码符号来传送信源信息,以便提高信息 传输率; (2)在信道受到干扰的情况下,如何增强信息的抗 干扰能力,同时又不过多地降低信息传输率。 对于数字通信系统,解决这两个问题的基本方 法是采用信源编码和信道编码,而研究的理论依据 就是著名的香农三大定理。