005 信息论与编码 第5章 信源编码

- 格式:ppt

- 大小:278.50 KB

- 文档页数:15

信息论与编码原理信源编码

信息论是一门涉及了信息处理的学科,它研究信息生成、传输、接收、存储、利用等过程的一般性理论。

它探讨涉及信息的一切问题,强调掌握

信息所必需的体系性的体系知识,其主要内容有:信息的定义、信息测度,信息的熵,信息编码,信息的可计量性,信息传输,信息和随机性,信息

编译,信息安全,信息认证,解码准确性,信息的保密,校验,系统复杂性,信息的加密等。

信源编码是一种在信息论中常用的编码技术,其目的是用最少的信息

量表示最多的信息内容,以提高信息发送效率。

它主要包括概率信息源编

码和确定性信息源编码两种。

概率信息源编码是根据一个信息源的发生概率来编码,是根据发出信

息的概率来决定编码方式的。

它根据一个消息源中发出的不同信息的概率

来决定信息的编码,并确定每种信息的编码长度。

在这种情况下,越高概

率的信息,编码长度越短。

确定性信息息源编码,是根据一个消息源中出现特定信息的概率确定

编码方式的。

在这种情况下,编码长度取决于消息源的熵,也就是期望的

信息量。

信源编码的基本思想是以最小的编码来传输最多的信息量。

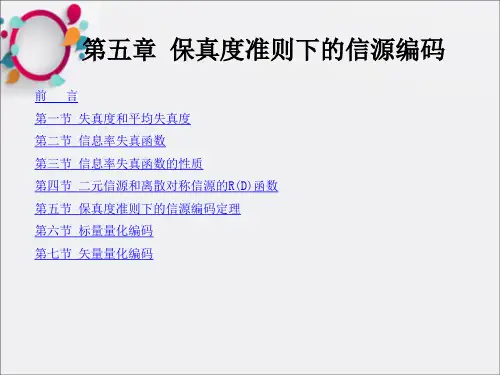

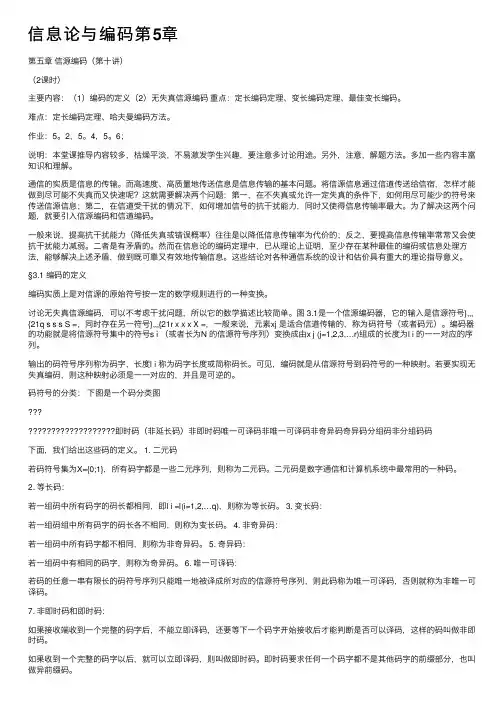

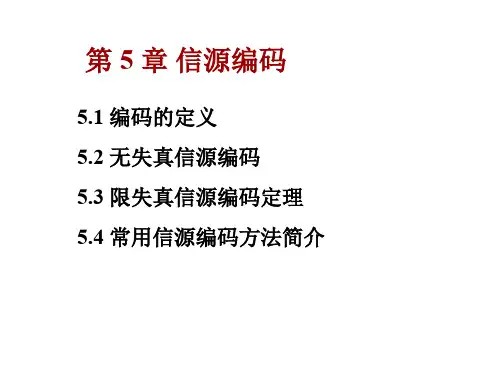

信息论与编码第5章第五章信源编码(第⼗讲)(2课时)主要内容:(1)编码的定义(2)⽆失真信源编码重点:定长编码定理、变长编码定理、最佳变长编码。

难点:定长编码定理、哈夫曼编码⽅法。

作业:5。

2,5。

4,5。

6;说明:本堂课推导内容较多,枯燥平淡,不易激发学⽣兴趣,要注意多讨论⽤途。

另外,注意,解题⽅法。

多加⼀些内容丰富知识和理解。

通信的实质是信息的传输。

⽽⾼速度、⾼质量地传送信息是信息传输的基本问题。

将信源信息通过信道传送给信宿,怎样才能做到尽可能不失真⽽⼜快速呢?这就需要解决两个问题:第⼀,在不失真或允许⼀定失真的条件下,如何⽤尽可能少的符号来传送信源信息;第⼆,在信道受⼲扰的情况下,如何增加信号的抗⼲扰能⼒,同时⼜使得信息传输率最⼤。

为了解决这两个问题,就要引⼊信源编码和信道编码。

⼀般来说,提⾼抗⼲扰能⼒(降低失真或错误概率)往往是以降低信息传输率为代价的;反之,要提⾼信息传输率常常⼜会使抗⼲扰能⼒减弱。

⼆者是有⽭盾的。

然⽽在信息论的编码定理中,已从理论上证明,⾄少存在某种最佳的编码或信息处理⽅法,能够解决上述⽭盾,做到既可靠⼜有效地传输信息。

这些结论对各种通信系统的设计和估价具有重⼤的理论指导意义。

§3.1 编码的定义编码实质上是对信源的原始符号按⼀定的数学规则进⾏的⼀种变换。

讨论⽆失真信源编码,可以不考虑⼲扰问题,所以它的数学描述⽐较简单。

图 3.1是⼀个信源编码器,它的输⼊是信源符号},,, {21q s s s S =,同时存在另⼀符号},,,{21r x x x X =,⼀般来说,元素xj 是适合信道传输的,称为码符号(或者码元)。

编码器的功能就是将信源符号集中的符号s i (或者长为N 的信源符号序列)变换成由x j (j=1,2,3,…r)组成的长度为l i 的⼀⼀对应的序列。

输出的码符号序列称为码字,长度l i 称为码字长度或简称码长。

可见,编码就是从信源符号到码符号的⼀种映射。

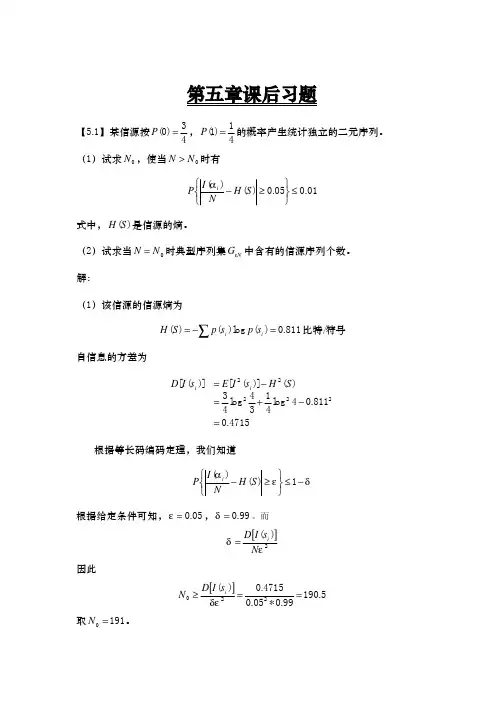

第五章课后习题【5.1】某信源按43)0(=P ,41)1(=P 的概率产生统计独立的二元序列。

(1)试求0N ,使当0N N >时有01.005.0)()(≤≥−S H N I P i α 式中,)(S H 是信源的熵。

(2)试求当0N N =时典型序列集N G ε中含有的信源序列个数。

解:(1)该信源的信源熵为811.0)(log )()(=−=∑i i s p s p S H 比特/符号自信息的方差为4715.0811.04log 4134log 43)()]([)]([22222=−+=−=S H s I E s I D i i 根据等长码编码定理,我们知道δεα−≤≥−1)()(S H N I P i 根据给定条件可知,05.0=ε,99.0=δ。

而[]2)(εδN s I D i =因此[]5.19099.0*05.04715.0)(220==≥δεi s I D N 取1910=N 。

(2)ε典型序列中信源序列个数取值范围为:])([])([22)1(εεεδ+−<<−S H N N S H N G代入上述数值得451.164351.1452201.0<<×N G ε【5.2】有一信源,它有六个可能的输出,其概率分布如下表所示,表中给出了对应的码A 、B 、C 、D 、E 和F 。

表5.2消息 )(i a P A B C D E F 1a 1/2 000 0 0 0 0 0 2a 1/4 001 01 10 10 10 100 3a 1/16 010 011 110 110 1100 101 4a 1/16 011 0111 1110 1110 1101 110 5a 1/16 100 01111 11110 1011 1110 111 6a1/1610101111111111011011111011(1) 求这些码中哪些是惟一可译码; (2) 求哪些码是非延长码(即时码); (3) 求对所有惟一可译码求出其平均码长L 。

5.1某离散无记忆信源的概率空间为采用香农码和费诺码对该信源进行二进制变长编码,写出编码输出码字,并且求出平均码长和编码效率。

解:计算相应的自信息量1)()(11=-=a lbp a I 比特 2)()(22=-=a lbp a I 比特 3)()(313=-=a lbp a I 比特 4)()(44=-=a lbp a I 比特 5)()(55=-=a lbp a I 比特 6)()(66=-=a lbp a I 比特 7)()(77=-=a lbp a I 比特 7)()(77=-=a lbp a I 比特根据香农码编码方法确定码长1)()(+<≤i i i a I l a I平均码长984375.164/6317128/17128/1664/1532/1416/138/124/112/1L 1=+=⨯+⨯+⨯+⨯+⨯+⨯+⨯+⨯=由于每个符号的码长等于自信息量,所以编码效率为1。

费罗马编码过程5.2某离散无记忆信源的概率空间为使用费罗码对该信源的扩展信源进行二进制变长编码,(1) 扩展信源长度,写出编码码字,计算平均码长和编码效率。

(2) 扩展信源长度,写出编码码字,计算平均码长和编码效率。

(3) 扩展信源长度,写出编码码字,计算平均码长和编码效率,并且与(1)的结果进行比较。

解:信息熵811.025.025.075.075.0)(=--=lb lb X H 比特/符号 (1)平均码长11=L 比特/符号编码效率为%1.81X)(H 11==L η(2)平均码长为84375.0)3161316321631169(212=⨯+⨯+⨯+⨯=L 比特/符号 编码效率%9684375.0811.0X)(H 22===L η(3)当N=4时,序列码长309.3725617256362563352569442569242562732562732256814=⨯+⨯+⨯⨯+⨯⨯+⨯⨯+⨯+⨯⨯+⨯=L平均码长827.04309.34==L %1.98827.0811.0X)(H 43===L η可见,随着信源扩展长度的增加,平均码长逐渐逼近熵,编码效率也逐渐提高。

信息论基础与编码(第五章)5-1 有一信源,它有六种可能的输出,其概率分布如下表所示,表中给出了对应的六种编码12345C C C C C 、、、、和6C 。

(1) 求这些码中哪些是唯一可译码; (2) 求哪些是非延长码(即时码); (3) 对所有唯一可译码求出其平均码长。

001111解:(1)1,2,3,6是唯一可译码; (2)1,3,6是即时码。

5-2证明若存在一个码长为12,,,ql l l ⋅⋅⋅的唯一可译码,则一定存在具有相同码长的即时码。

证明:由定理可知若存在一个码长为的唯一可译码,则必定满足kraft 不等式1。

由定理4可知若码长满足kraft 不等式,则一定存在这样码长的即时码。

所以若存在码长的唯一可译码,则一定存在具有相同码长P (y=0)的即时码。

5-3设信源126126()s s s S p p p P s ⋅⋅⋅⎡⎤⎡⎤=⎢⎥⎢⎥⋅⋅⋅⎣⎦⎣⎦,611i i p ==∑。

将此信源编码成为r 元唯一可译变长码(即码符号集12{,,,}r X x x x =⋅⋅⋅),其对应的码长为(126,,,l l l ⋅⋅⋅)=(1,1,2,3,2,3),求r 值的最小下限。

解:要将此信源编码成为 r 元唯一可译变长码,其码字对应的码长(l 1 ,l 2 ,l 3, l 4,l 5, l 6)=(1,1,2,3,2,3) 必须满足克拉夫特不等式,即LqL L ,,2,1 ∑=-qi l ir1≤4⋅LqL L ,,2,1132321161≤+++++=------=-∑r r r r r r ri li所以要满足 122232≤++rr r ,其中 r 是大于或等于1的正整数。

可见,当r=1时,不能满足Kraft 不等式。

当r=2, 1824222>++,不能满足Kraft 。

当r=3, 127262729232<=++,满足Kraft 。

所以,求得r 的最大值下限值等于3。