最大似然估计及三大检验(Wald LM LR)

- 格式:doc

- 大小:1.25 MB

- 文档页数:25

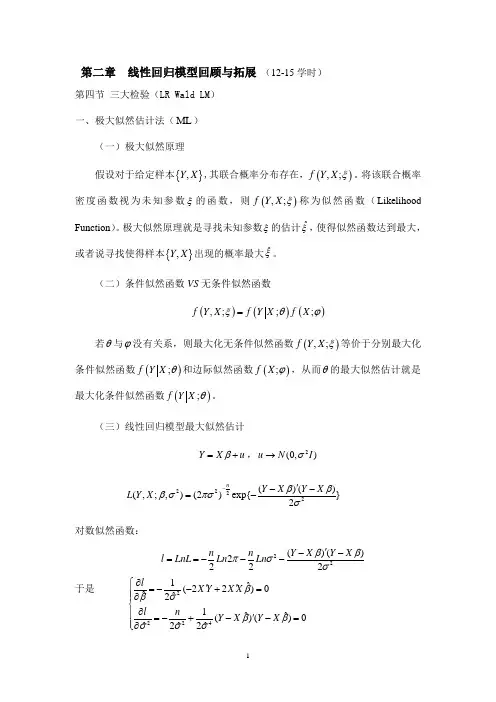

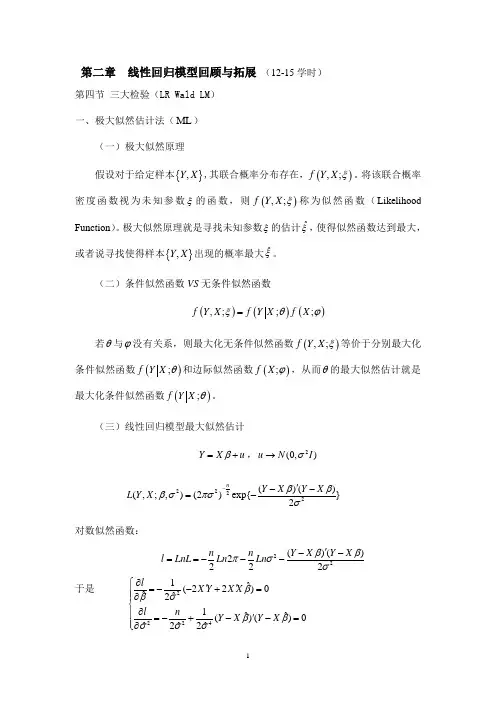

第二章 线性回归模型回顾与拓展 (12-15学时)第四节 三大检验(LR Wald LM ) 一、极大似然估计法(ML )(一)极大似然原理假设对于给定样本{},Y X ,其联合概率分布存在,(),;f Y X ξ。

将该联合概率密度函数视为未知参数ξ的函数,则(),;f Y X ξ称为似然函数(Likelihood Function )。

极大似然原理就是寻找未知参数ξ的估计ˆξ,使得似然函数达到最大,或者说寻找使得样本{},Y X 出现的概率最大ˆξ。

(二)条件似然函数VS 无条件似然函数()()(),;;;f Y X f Y X f X ξθϕ=若θ与ϕ没有关系,则最大化无条件似然函数(),;f Y X ξ等价于分别最大化条件似然函数();f Y X θ和边际似然函数();f X ϕ,从而θ的最大似然估计就是最大化条件似然函数();f Y X θ。

(三)线性回归模型最大似然估计Y X u β=+,2(0,)u N I σ→2222()()(,;,)(2)exp{}2nY X Y X L Y X βββσπσσ-'--=-对数似然函数:22()()2222n n Y X Y X l LnL Ln Ln ββπσσ'--==---于是 22241ˆ(22)0ˆˆ21ˆˆ()()0ˆˆˆ22l X Y X X l n Y X Y X βσβββσσσ∂⎧''=--+=⎪⎪∂⎨∂⎪'=-+--=⎪∂⎩得到 12ˆ()1ˆMLML X X X Y e e n βσ-⎧''=⎪⎨'=⎪⎩(三)得分(Score )和信息矩阵(Information Matrix )(;,)lf Y X θθ∂=∂称为得分; 12...k l l l l θθθθ∂⎡⎤⎢⎥∂⎢⎥∂⎢⎥⎢⎥∂⎢⎥∂⎢⎥=∂⎢⎥⎢⎥⎢⎥⎢⎥∂⎢⎥⎢⎥∂⎣⎦得分向量;(Gradient ) 海瑟矩阵(Hessian Matrix ):2l H θθ∂='∂∂信息矩阵:三*、带约束条件的最小二乘估计(拉格朗日估计)在计量经济分析中,通常是通过样本信息对未知参数进行估计。

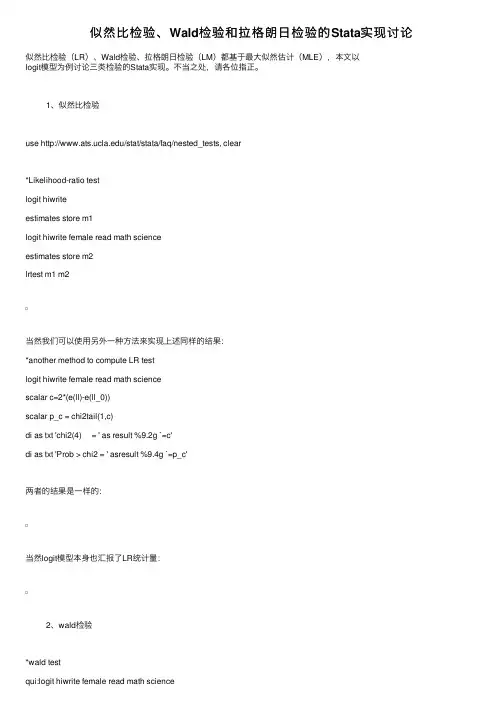

似然⽐检验、Wald检验和拉格朗⽇检验的Stata实现讨论似然⽐检验(LR)、Wald检验、拉格朗⽇检验(LM)都基于最⼤似然估计(MLE),本⽂以logit模型为例讨论三类检验的Stata实现。

不当之处,请各位指正。

1、似然⽐检验use /stat/stata/faq/nested_tests, clear*Likelihood-ratio testlogit hiwriteestimates store m1logit hiwrite female read math scienceestimates store m2lrtest m1 m2当然我们可以使⽤另外⼀种⽅法来实现上述同样的结果:*another method to compute LR testlogit hiwrite female read math sciencescalar c=2*(e(ll)-e(ll_0))scalar p_c = chi2tail(1,c)di as txt 'chi2(4) = ' as result %9.2g `=c'di as txt 'Prob > chi2 = ' asresult %9.4g `=p_c'两者的结果是⼀样的:当然logit模型本⾝也汇报了LR统计量:2、wald检验*wald testqui:logit hiwrite female read math sciencetest female read math science3、拉格朗⽇检验本来Stata⾥有⼀个user-written的命令叫做testomit,但是这个命令当前在Stata⾥并不能被找到。

可能是作者移除了⽹页。

如果您有这个命令的源程序,⿇烦您联系我。

Statalist⾥很多⼈都在讨论如何进⾏LM检验,来⾃Universityof Konstanz的Maarten L. Buis给出的答案如下:* Lagrange multiplier testqui:logit hiwrite female read math science// use the resulting gradient and var-covmatrix to compute the test statisticsmatrix S = e(gradient)*e(V)*e(gradient)'scalar a = el(S,1,1)scalar p_s = chi2tail(1,a)// display the resultdi as txt 'chi2(1) = ' as result %9.2g `=a'di as txt 'Prob > chi2 = ' asresult %9.4g `=p_s'但是由于这种⽅法得到的结果和前述两种检验得到的结果差别真的太⼤,我对这个⽅法持谨慎态度。

第二章 线性回归模型回顾与拓展 (12-15学时)第四节 三大检验(LR Wald LM ) 一、极大似然估计法(ML )(一)极大似然原理假设对于给定样本{},Y X ,其联合概率分布存在,(),;f Y X ξ。

将该联合概率密度函数视为未知参数ξ的函数,则(),;f Y X ξ称为似然函数(Likelihood Function )。

极大似然原理就是寻找未知参数ξ的估计ˆξ,使得似然函数达到最大,或者说寻找使得样本{},Y X 出现的概率最大ˆξ。

(二)条件似然函数VS 无条件似然函数()()(),;;;f Y X f Y X f X ξθϕ=若θ与ϕ没有关系,则最大化无条件似然函数(),;f Y X ξ等价于分别最大化条件似然函数();f Y X θ和边际似然函数();f X ϕ,从而θ的最大似然估计就是最大化条件似然函数();f Y X θ。

(三)线性回归模型最大似然估计Y X u β=+,2(0,)u N I σ→2222()()(,;,)(2)exp{}2nY X Y X L Y X βββσπσσ-'--=-对数似然函数:22()()2222n n Y X Y X l LnL Ln Ln ββπσσ'--==---于是 22241ˆ(22)0ˆˆ21ˆˆ()()0ˆˆˆ22l X Y X X l n Y X Y X βσβββσσσ∂⎧''=--+=⎪⎪∂⎨∂⎪'=-+--=⎪∂⎩得到 12ˆ()1ˆMLML X X X Y e e n βσ-⎧''=⎪⎨'=⎪⎩(三)得分(Score )和信息矩阵(Information Matrix )(;,)lf Y X θθ∂=∂称为得分; 12...k l l l l θθθθ∂⎡⎤⎢⎥∂⎢⎥∂⎢⎥⎢⎥∂⎢⎥∂⎢⎥=∂⎢⎥⎢⎥⎢⎥⎢⎥∂⎢⎥⎢⎥∂⎣⎦得分向量;(Gradient ) 海瑟矩阵(Hessian Matrix ):2l H θθ∂='∂∂信息矩阵:三*、带约束条件的最小二乘估计(拉格朗日估计)在计量经济分析中,通常是通过样本信息对未知参数进行估计。

conditional条件法、lr偏似然估计法、wald瓦尔德法-回复中括号内的内容,即"conditional条件法、LR偏似然估计法、Wald瓦尔德法"是统计学中常用的三种方法,用于估计参数的方法。

在下文中,我将针对这三种方法逐一进行解释和分析。

首先,我们来看conditional条件法。

在概率论中,条件概率指的是在已知某个事件发生的前提下,另一个事件发生的概率。

在统计学中,conditional条件法是一种通过已知条件来估计未知参数的方法。

这种方法通常用于在给定某些先验知识的情况下,通过对数据进行推断来计算参数的取值。

这种方法可以用于估计各种分布的参数,例如正态分布、泊松分布等。

接下来,我们来看LR偏似然估计法。

LR是"Likelihood Ratio"的缩写,意为似然比。

偏似然估计法是一种通过最大化似然函数来估计参数的方法。

在概率论中,似然函数是一种用于描述未知参数的函数。

通过最大化似然函数,我们可以找到最可能的参数取值。

然而,在实际应用中,由于似然函数的计算往往比较复杂,因此我们往往使用对数似然函数来简化计算。

LR偏似然估计法通过最大化对数似然函数来估计参数的取值。

这种方法通常用于估计回归模型中的参数,例如Logistic回归模型、Cox比例风险模型等。

最后,我们来看Wald瓦尔德法。

瓦尔德法是一种通过计算参数估计量的标准差来估计参数的方法。

在统计学中,标准差是一种衡量数据的离散程度的指标。

通过计算参数估计量的标准差,我们可以得到参数估计的置信区间。

瓦尔德法通过计算参数估计量的标准差,来进行参数的估计。

这种方法通常用于估计线性回归模型、广义线性模型等中的参数。

综上所述,conditional条件法、LR偏似然估计法和Wald瓦尔德法是统计学中常用的三种方法,用于估计参数的方法。

conditional条件法通过已知条件来估计未知参数的取值,LR偏似然估计法通过最大化似然函数来估计参数的取值,而Wald瓦尔德法通过计算参数估计量的标准差来估计参数的取值。

conditional条件法、lr偏似然估计法、wald瓦尔德法-回复什么是条件法、偏似然估计法和瓦尔德法?条件法(Conditional Method)是一种用于在概率论和数理统计中进行参数估计的方法。

它基于已知的条件概率分布和相关统计量,通过最大化似然函数或调整算法来寻找最优解。

偏似然估计法(Likelihood Ratio Estimation,LR法)是一种常用的参数估计方法。

它首先计算目标函数的二阶导数矩阵,通过牛顿法求解极值,然后利用似然比检验来估计未知参数。

瓦尔德法(Wald Method)是一种用于计算参数置信区间和假设检验的统计方法。

它基于大样本离散估计法,在极大似然估计下,利用正态分布近似推导参数的标准估计误差和置信区间。

下面将详细介绍这三种方法,并比较它们的优缺点和适用范围。

一、条件法条件法是一种基于条件概率分布的参数估计方法。

它根据给定的条件,从条件概率分布中选取最大化似然函数的参数值。

通常情况下,条件法需要明确指定条件概率分布的形式,才能进行参数估计。

条件法的优点是可以充分利用已知的条件信息,从而提高参数估计的准确性。

但它的缺点是对条件概率分布的选择较为敏感,如果选择不当,可能导致估计结果不准确。

二、偏似然估计法偏似然估计法是一种通过求解目标函数的极值来估计参数的方法。

它首先计算目标函数的二阶导数矩阵,然后利用牛顿法迭代求解参数的极值。

偏似然估计法的核心思想是最大化似然函数,在参数估计的过程中,通过调整算法来寻找最优解。

偏似然估计法的优点是在满足一定条件下,估计结果具有较高的准确性。

它可以利用样本的更多信息来估计参数,相对于最大似然估计法,偏似然估计法更偏向于正态分布,适用于样本量较大、数据近似正态分布的情况。

然而,偏似然估计法也有一些缺点。

首先,它对目标函数的二阶导数矩阵的计算和牛顿法的迭代求解要求较高,计算量较大;其次,偏似然估计法对初值的选择很敏感,初值选择不当可能导致不收敛或陷入局部最优解。

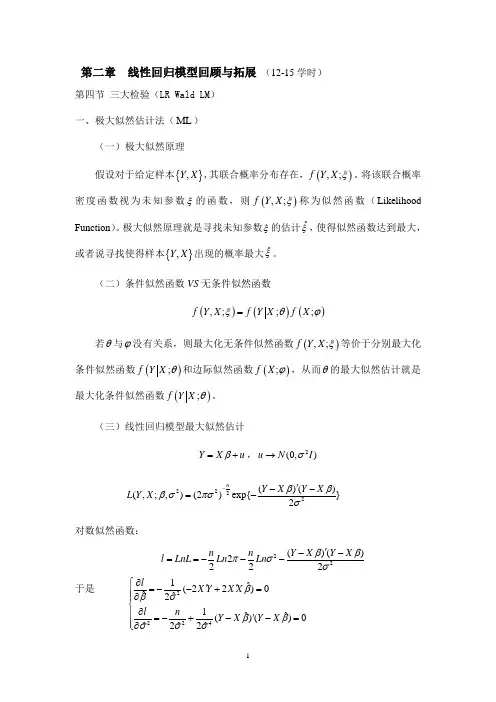

第二章 线性回归模型回顾与拓展 (12-15学时)第四节 三大检验(LR Wald LM ) 一、极大似然估计法(ML )(一)极大似然原理假设对于给定样本{},Y X ,其联合概率分布存在,(),;f Y X ξ。

将该联合概率密度函数视为未知参数ξ的函数,则(),;f Y X ξ称为似然函数(Likelihood Function )。

极大似然原理就是寻找未知参数ξ的估计ˆξ,使得似然函数达到最大,或者说寻找使得样本{},Y X 出现的概率最大ˆξ。

(二)条件似然函数VS 无条件似然函数()()(),;;;f Y X f Y X f X ξθϕ=若θ与ϕ没有关系,则最大化无条件似然函数(),;f Y X ξ等价于分别最大化条件似然函数();f Y X θ和边际似然函数();f X ϕ,从而θ的最大似然估计就是最大化条件似然函数();f Y X θ。

(三)线性回归模型最大似然估计Y X u β=+,2(0,)u N I σ→2222()()(,;,)(2)exp{}2nY X Y X L Y X βββσπσσ-'--=-对数似然函数:22()()2222n n Y X Y X l LnL Ln Ln ββπσσ'--==---于是 22241ˆ(22)0ˆˆ21ˆˆ()()0ˆˆˆ22l X Y X X l n Y X Y X βσβββσσσ∂⎧''=--+=⎪⎪∂⎨∂⎪'=-+--=⎪∂⎩得到 12ˆ()1ˆMLML X X X Y e e n βσ-⎧''=⎪⎨'=⎪⎩(三)得分(Score )和信息矩阵(Information Matrix )(;,)lf Y X θθ∂=∂称为得分; 12...k l l l l θθθθ∂⎡⎤⎢⎥∂⎢⎥∂⎢⎥⎢⎥∂⎢⎥∂⎢⎥=∂⎢⎥⎢⎥⎢⎥⎢⎥∂⎢⎥⎢⎥∂⎣⎦得分向量;(Gradient ) 海瑟矩阵(Hessian Matrix ):2l H θθ∂='∂∂信息矩阵:三*、带约束条件的最小二乘估计(拉格朗日估计)在计量经济分析中,通常是通过样本信息对未知参数进行估计。

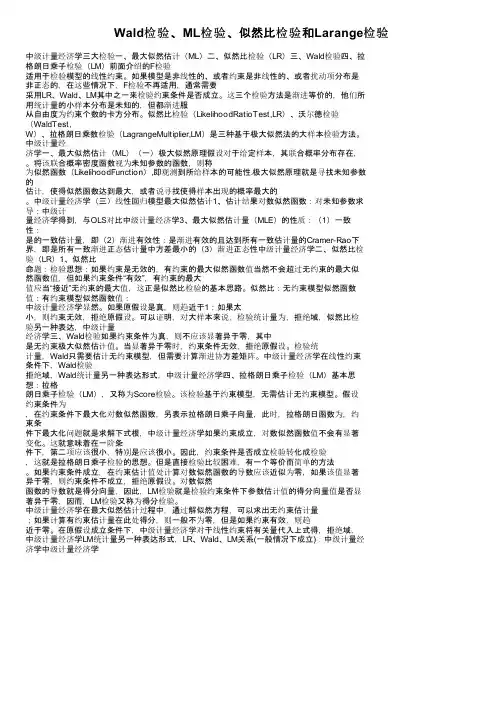

Wald检验、ML检验、似然比检验和Larange检验中级计量经济学三大检验一、最大似然估计(ML)二、似然比检验(LR)三、Wald检验四、拉格朗日乘子检验(LM)前面介绍的F检验适用于检验模型的线性约束。

如果模型是非线性的、或者约束是非线性的、或者扰动项分布是非正态的,在这些情况下,F检验不再适用,通常需要采用LR、Wald、LM其中之一来检验约束条件是否成立。

这三个检验方法是渐进等价的,他们所用统计量的小样本分布是未知的,但都渐进服从自由度为约束个数的卡方分布。

似然比检验(LikelihoodRatioTest,LR)、沃尔德检验(WaldTest,W)、拉格朗日乘数检验(LagrangeMultiplier,LM)是三种基于极大似然法的大样本检验方法。

中级计量经济学一、最大似然估计(ML)(一)极大似然原理假设对于给定样本,其联合概率分布存在,。

将该联合概率密度函数视为未知参数的函数,则称为似然函数(LikelihoodFunction),即观测到所给样本的可能性.极大似然原理就是寻找未知参数的估计,使得似然函数达到最大,或者说寻找使得样本出现的概率最大的。

中级计量经济学(三)线性回归模型最大似然估计1、估计结果对数似然函数:对未知参数求导:中级计量经济学得到,与OLS对比中级计量经济学3、最大似然估计量(MLE)的性质:(1)一致性:是的一致估计量,即(2)渐进有效性:是渐进有效的且达到所有一致估计量的Cramer-Rao下界,即是所有一致渐进正态估计量中方差最小的(3)渐进正态性中级计量经济学二、似然比检验(LR)1、似然比命题:检验思想:如果约束是无效的,有约束的最大似然函数值当然不会超过无约束的最大似然函数值,但如果约束条件“有效”,有约束的最大值应当“接近”无约束的最大值,这正是似然比检验的基本思路。

似然比:无约束模型似然函数值:有约束模型似然函数值:中级计量经济学显然。

如果原假设是真,则趋近于1;如果太小,则约束无效,拒绝原假设。

第二章 线性回归模型回顾与拓展 (12-15学时)第四节 三大检验(LR Wald LM ) 一、极大似然估计法(ML )(一)极大似然原理假设对于给定样本{},Y X ,其联合概率分布存在,(),;f Y X ξ。

将该联合概率密度函数视为未知参数ξ的函数,则(),;f Y X ξ称为似然函数(Likelihood Function )。

极大似然原理就是寻找未知参数ξ的估计ˆξ,使得似然函数达到最大,或者说寻找使得样本{},Y X 出现的概率最大ˆξ。

(二)条件似然函数VS 无条件似然函数()()(),;;;f Y X f Y X f X ξθϕ=若θ与ϕ没有关系,则最大化无条件似然函数(),;f Y X ξ等价于分别最大化条件似然函数();f Y X θ和边际似然函数();f X ϕ,从而θ的最大似然估计就是最大化条件似然函数();f Y X θ。

(三)线性回归模型最大似然估计Y X u β=+,2(0,)u N I σ→2222()()(,;,)(2)exp{}2nY X Y X L Y X βββσπσσ-'--=-对数似然函数:22()()2222n n Y X Y X l LnL Ln Ln ββπσσ'--==---于是 22241ˆ(22)0ˆˆ21ˆˆ()()0ˆˆˆ22l X Y X X l n Y X Y X βσβββσσσ∂⎧''=--+=⎪⎪∂⎨∂⎪'=-+--=⎪∂⎩得到 12ˆ()1ˆMLML X X X Y e e n βσ-⎧''=⎪⎨'=⎪⎩(三)得分(Score )和信息矩阵(Information Matrix )(;,)lf Y X θθ∂=∂称为得分; 12...k l l l l θθθθ∂⎡⎤⎢⎥∂⎢⎥∂⎢⎥⎢⎥∂⎢⎥∂⎢⎥=∂⎢⎥⎢⎥⎢⎥⎢⎥∂⎢⎥⎢⎥∂⎣⎦得分向量;(Gradient ) 海瑟矩阵(Hessian Matrix ):2l H θθ∂='∂∂信息矩阵:三*、带约束条件的最小二乘估计(拉格朗日估计)在计量经济分析中,通常是通过样本信息对未知参数进行估计。

但有些时候可能会遇到非样本信息——对未知参数的约束限制(如生产函数中的规模报酬不变等)。

在这种情况下,我们就可以采用拉格朗日估计法。

对于线性模型(1),若其参数β具有某种线性等式约束: 0H β= (6)其中H 是m k ⨯矩阵(m k <,()rank H m =)。

β可视为除分量0β以外的1k ⨯矩阵。

上式表明未知参数12,,,k βββ之间的某些线性关系的信息。

现在的问题是寻求满足上式又使()()Y X Y X ββ'--达到最小的估计量0ˆH β。

为此,构造拉格朗日函数。

(λ是1m ⨯的向量)()()L Y X Y X H ββλβ''=--+ (7)于是ˆˆ220ˆH HHL X Y X X H βλβ∂'''=-++=∂ (8)ˆ0ˆH HL H βλ∂==∂ (9) 由(8)可得11ˆˆˆ()2H HX X H ββλ-''=- (10) (10)式的ˆβ是OLS 的估计量。

两边再左乘H ,并结合(9)式有 11ˆˆˆ0()2H HH H H X X H ββλ-''==- 所以,11ˆˆ2[()]H H X X H H λβ--''= 代入(10)式,我们便得到估计量:111ˆˆˆ()[()]HX X H H X X H H βββ---''''=- (11) 这就是拉格朗日估计,或称为带约束的最小二乘估计。

它既利用了样本信息,也利用了非样本信息。

另外,ˆHβ也是带约束的极大似然估计量(证明从略)。

四、广义最小二乘估计(GLS ) 1、数理过程在实际经济问题的分析过程中,常常遇到古典假定中2的不满足,即随机扰动项存在异方差或自相关。

比如利用截面数据进行分析时,随机因素的方差会随着解释变量的增大而增大(即所谓的递增异方差——如在研究消费收入的关系时,随着收入的增加,随机因素的变化会增大)。

而利用时间序列数据进行分析时,由于经济变量的惯性作用,随机扰动项之间也会有联系,较为普遍的现象是扰动项的一阶自相关。

(即1t t t u u ρε-=+)当存在异方差或自相关的情况下,传统的OLS 不再是有效估计,这时,我们应采用广义最小二乘法来解决这类问题。

具体地,2'Euu σ=Ω (12)其中212122n n w w σσσσ⎛⎫ ⎪⎛⎫ ⎪⎪Ω== ⎪⎪ ⎪ ⎪⎝⎭⎪⎝⎭时t u 存在异方差, 1221211111n n n n ρρρρρρρ----⎛⎫⎪ ⎪Ω=⎪- ⎪ ⎪⎝⎭时t u 存在一阶自相关。

需要说明的是,无论是异方差还是自相关,矩阵Ω是正定矩阵。

于是,存在非奇异矩阵P ,使得PP 'Ω= 或 1()P P I -''Ω=在模型 Y X u β=+ 两边同时左乘1P -,得 111P Y P X P u β---=+或写成***Y X u β=+ (13) 此时,**111212'['()]()Eu u E P uu P P P I σσ----''==Ω= 即*u 已无异方差和自相关。

那么,对(13)式运用OLS 可以得到**1**11111111ˆ()(())()()X X X Y X P P X X P P Y X X X Y β'---------''''''===ΩΩ (14)这就是未知参数β的广义最小二乘估计量GLS 。

它同样具有良好的统计性质。

即它是无偏的、一致的、渐近正态211ˆˆ(,())E Var X X βββσ--'==Ω的估计量。

换句话说,GLS 估计量是广义模型中的最小方差线性无偏估计。

这就是所谓的Aitken 定理,当I Ω=时高斯—马尔科夫定理为其特例。

2、WLS 和广义差分法广义最小二乘法是处理异方差和自相关问题的一般良好估计方法。

当Ω已知时,比如异方差时,各个22i i w σσ=已知,此时,矩阵PP ⎫⎪=⎪ ⎝,1P -⎫⎪⎪= ⎪ ⎝*1Y P Y -⎛ == ⎪,*1X P X -⎛⎫ ⎪ ⎪== ⎪ ⎝,*1u P u -⎛ == ⎪。

这时由(13)式估计出来的β,其实同加权最小二乘估计(WLS )是相同的。

换句话说,加权最小二乘实际上是广义最小二乘的特例。

再比如随机扰动项有一阶自相关且ρ已知,此时1221211111n n n n PP ρρρρρρρ----⎛⎫⎪ ⎪'Ω==⎪- ⎪ ⎪⎝⎭,可以算得100001000010001P ρρρ-⎫⎪- ⎪ ⎪=- ⎪ ⎪ ⎪-⎝⎭那么(13)式中的1*1211n n Y Y Y P Y Y Y ρρ--⎫⎪- ⎪== ⎪ ⎪ ⎪-⎝⎭,1*1211nn X X X P X X X ρρ--⎛⎫⎪- ⎪== ⎪⎪ ⎪-⎝⎭ 此时估计(13)式得出的ˆβ,其实就是所谓的广义差分法。

也就是说广义差分法也是GLS 的特例。

所以,GLS 是一个普遍适用的方法。

3、Ω未知时的GLS当然,上述情形只是Ω已知的情况。

而在现实应用时,Ω往往是未知的。

于是我们面临一个问题——Ω如何确定?回答当然是对Ω中的未知量进行估计(比如自相关中的ρ,异方差中的i W )。

那么又该如何估计呢?在回答这个问题之前,我们先考察一下GLS 与最大似然估计的关系(可对照OLS 与ML 的关系)一般来说,当2(0,)N μσΩ或2(,)YN X βσΩ时,Y 的对数似然函数为221112()()()222n InL In In Y X Y X πσβσβ-'=--Ω--Ω-或者考虑到PP 'Ω=,而1*P Y Y -=、1*P X X -=,又有(经过适当的运算)2****21ln ln 2ln ln ||()()222n n L P Y X Y X πσββσ=--+---最大化上式,对β求导令其为0,可得到β的极大似然估计量(它其实就是GLS )。

对Ω或P 中的未知量求导令其为0,可得到Ω中未知量(比如ρ)的估计。

这是一种理论上可行的方法,但实际操作可能会遇到障碍,尤其是在有异方差存在时。

为此,我们介绍另一种方法——可行广义最小二乘法FGLS 4、可行广义最小二乘法(FGLS )异方差的具体形式是复杂多样的,但总的来说都是与解释变量有关的,随解释变量的变化而变化。

以下三种假设情况基本上涵盖了文献中讨论过的大多数情形。

(i )2011i i p ip Z Z σααα=+++ (ii )011i i p ip Z Z σααα=+++(iii )2011i i p ip ln Z Z σααα=+++ (或2011exp()i i p ip Z Z σααα=+++)我们称这些方程为扰动项方差的辅助方程。

式中的Z 是原模型中部分或全部的X 或X 的函数(比如21121312Z =X ,Z =X ,Z X X =等等)。

可行广义最小二乘法的基本思想就是,先利用辅助函数求得参数估计值ˆi α,然后得出估计值ˆi σ从而得到ˆΩ及最终的GLS 结果。

FGLS 的步骤如下: (1)Y 对常数项和12,,,K X X X 回归,求得β的OLS 估计值;(2)计算残差011ˆˆˆi i i k kie Y X X βββ=---- (3)选择上述方程的适当形式 (3i )2i e 对常数项及1,,P Z Z 回归,求得α的估计值。

这是针对上述(i )的情况。

式中的Z 为原来X 的平方或交叉乘积。

然后把这些α的估计值代回(i )便得到2i σ的估计值2ˆi σ。

再使用GLS 或WLS 得出最终结果。

需要指出的是,这种方式并不能保证所有的2ˆi σ都为正,如果其中出现了0或负数,那么我们就只能使用原来的2i e 代替2ˆi σ了。

(3ii )对应于上述方程(ii ),让i e 对常数项及1,,P Z Z 回归,求得α的OLS估计值,代入(ii )得到ˆi σ,然后使用GLS 或WLS (此时选择权数为1ˆi σ,如ˆi σ为负,那么权数为1ie )。

(3iii )对应于方程(iii ),让2i lne 对常数项及1,,P Z Z 回归,求出α的OLS 估计值,再代回(iii )求得2ˆi ln σ或2ˆi σ。

然后利用GLS 或WLS 得出结果。

这里值得一提的是,此时的2ˆi σ只会产生正值,不存在0或负的情况,这也是此种方法很有吸引力的地方。