计量经济学数据库

- 格式:xls

- 大小:71.50 KB

- 文档页数:25

经济学数据大全|经济学免费数据库大全1.SEC EDGAR数据库美国国会两院记录、商务部经济数据、伯克莱圆桌会议、斯坦福法律经济词典/radio/JEC2.高校财经数据库收录12个在线数据库,超过三百万篇商业报告和文章。

/3.国际股票市场数据库包括国际股票市场的价格图表、交易量、共同基金图、上市公司简介等/4.华通数据中心宏观经济信息、行业(产业)发展报告、企业(公司)信息、产品市场分析/5.经济数据和链接(美国加州大学Fresno分校)Econ Data & Links (CAL State Fresno) 由美国加州大学Fresno分校建立。

该站点提供了大量表格和统计数据,以及很多相关站点的链接,内容从收入、财富到贫困问题都有。

/Economics/econ_EDL.htm6.经济学数据Economics Data是WebEc的一部分。

以良好的编排方式将数据和经济学站点排列出来。

可参见经济学与计算网页,上面提供了很多软件链接。

http://www.helsinki.fi/WebEc/webecc8d.html7.经济学网络这是一个内容非常丰富的资源中心,有大量美国和世界经济与金融市场的在线图表、经济指南、每周经济分析与简评,以及指向其它资源的链接。

所有文件都是PDF格式。

由德国驻纽约Morgan Grenfell的首席经济学家Ed Yardeni博士提供。

/8.联储经济数据Federal Reserve Economic Data (FRED)是美国联邦储备银行圣路易斯分行提供的一种很出色的服务。

再该站点上,除了有经济研究方面的研究论文和工作论文以外,还提供了有价值的关于美国经济各方面的当前和历史数据。

/fred/9.联合国统计年鉴Statistics Yearbook (UN)主要包括统计数据和指标(如月度统计公报)、统计方法、统计源与参考工具等内容。

注册后可以在一段时间以内免费使用统计数据和指标,其它资源不需注册。

计量经济学数据类型

“计量经济学”是指利用经济学理论和数学统计方法来研究实际的经济问题。

数据是计量经济学研究的重要基础,计量经济学中常见的数据类型如下:

1. 时间序列数据:时间序列数据是按时间顺序排列的数据,例如经济指标、股票价格、汇率等。

应用:基于时间序列数据进行趋势预测和时间序列分析,例如预测未来的经济增长率、通货膨胀率、利率等。

2. 横截面数据:横截面数据是在相同时间点上针对不同个体所收集的数据,例如收入、教育程度、职业等。

应用:基于横截面数据进行个体变量的比较分析,例如探讨收入水平与教育程度的关系、职业类型与收入的关系等。

3. 面板数据:面板数据是同时包含时间序列和横截面数据的数据,例如企业的经济数据、家庭调查数据等。

应用:基于面板数据进行个体和时间变量的研究,例如探讨企业投资和利润的关系、家庭收支变化的影响因素等。

4. 实验数据:实验数据是通过对特定因素进行控制来获取的数据,例如经济政策的实验数据、招聘决策的实验数据等。

应用:基于实验数据进行因果关系的分析,例如探讨各种政策对实体经济的影响、探讨招聘流程中不同因素对应聘者选择和工作表现的影响等。

以上数据类型及其应用是计量经济学研究中常见的基础。

在实际应用中,根据实际问题和数据可用性,研究者可以将不同类型的数据进行组合分析,以获取更深入的结论。

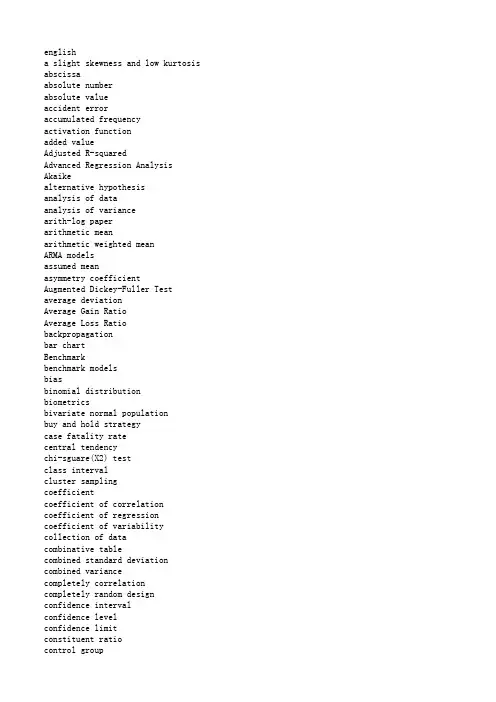

englisha slight skewness and low kurtosis abscissaabsolute numberabsolute valueaccident erroraccumulated frequencyactivation functionadded valueAdjusted R-squaredAdvanced Regression Analysis Akaikealternative hypothesisanalysis of dataanalysis of variancearith-log paperarithmetic meanarithmetic weighted meanARMA modelsassumed meanasymmetry coefficientAugmented Dickey-Fuller Test average deviationAverage Gain RatioAverage Loss Ratio backpropagationbar chartBenchmarkbenchmark modelsbiasbinomial distributionbiometricsbivariate normal populationbuy and hold strategycase fatality ratecentral tendencychi-sguare(X2) testclass intervalcluster samplingcoefficientcoefficient of correlation coefficient of regression coefficient of variability collection of datacombinative tablecombined standard deviation combined variancecompletely correlationcompletely random design confidence intervalconfidence levelconfidence limitconstituent ratioCorrect Directional Changecorrection for continuitycorrection for groupingcorrection numbercorrection valuecorrelation coefficientcritical valuecritical valuecumulative frequencydata setdegree of confidencedegree of dispersiondegree of freedomdegree of variationdependent variabledependent variabledesign of experimentdeviation from meandeviation from the meandiagnose accordance ratedifference with significancedifference with significancediscrete variabledispersion tendencyDurbin-Watson stat.econometricseffective rateefficient market hypothesiseigenvalueempiricalenumeration dataequation of linear regressionequitieserror of replicationestimate valueEVexchange rateexplained varianceExplanatory Variablesextreme valuefatality ratefield surveyfixed exchange ratesfloating exchange ratesforecasting accuracy measuresfourfold tablefreguency distributionFX time seriesGaussian curvegeneralisation abilityGeneralized Autoregressive Conditional Heteroskedasticity geometric meangrouped datahidden nodeshistogramhomogeneity of variance homogeneity test of variances hypothesis testhypothetical universeincidence rateincomplete surveyindepindent variableindivedual differenceInequality Coefficientinfection rateinferior limitinitial datainput valuesinspection of datainterceptinterceptinterpolation methodinterval estimationinverse correlationkurtosis coefficientlatin sguare designleast significant differenceleast square methodleast Squaresleptokurtic distribution leptokurtosislikelihoodlinear chartlinear correlationlinear cross-correlation analysis linear regressionlinear regression eguationlink relativeLog likelihoodlogarithmic normal distribution logarithmic scalelogistic functionlognormal distributionLondon daily closing priceslower limitMackinnonmarket inefficienciesmatched pair designmathematical statisticsmaximum valuemeanMean Absolute ErrorMean Absolute Percentage Error mean of populationmean squaremean variancemedianmedianmedical statisticsmesokurtosismethod of groupingmethod of least squaresmethod of percentilesmid-value of classmodemodellingmomentmomentum parametermorbiditymortalitynatalitynatural logarithmnegative correlationnegative skewnessnetwork selectionnetwork weightsneural network modellingNeural Network Regression models non-linear correlationnonlinear patternsnonlinearitynon-parametric modelsnon-parametric statisticsnormal curvenormal deviatenormal distributionnormal kurtosisnormal populationnormal probability curvenormal rangenormal valuenormality testnosometrynull hypothesisobserved unitobserved valueOccam's Razorone-sided testone-tailed testoptimal weightoptimization criteriaoption pricingorder statisticordinal numberordinateoverfittingovertrainedpairing dataparameterparsimonious modelpartitionpercentage bar chartpercentilePhillips-Perron testpie diagramplanning of surveypoint estimationpopulation meanpopulation ratepopulation varianceportfoliopositive correlationpositive skewnesspower of a testprevalence rateprobability errorprospective studyprospective surveypublic health statisticsquality eontrolquartilequasi-randomrandom numbers tablerandom samplerandom samplingrandom variablerandom walk modelrandomizationrandomized blocksrandomized blocks analysis of variance randomized blocks designrangerange of normal valuesrank correlationrank correlation coefficentranked datarank-sum testrecognition abilityRegression Analysisregression analysisRegression Analysisregression coefficientregression eguationrelative numberrelative ratiorelative ratio with fixed base remainder errorretrospective surveyRidit analysisRidit valueroot-mean squared errorsRoot-Mean-Squared Errorsample averagesample sizesampling errorsampling statisticssampling survaysaturation zonesscaller diagramschedule of surveySchwarz criterionsemi-guartile rangesemi-logarithmic chartsemi-measursement datasensitivitySharp Ratiosign testsignificancesignificance levelsignificance testsignificant differencesimple random samplingsimple tablesingle-step predictionsize of sampleskewnessslopesorting datasorting tablesources of variationspeculative dealingspot dealsspot foreign exchangespot marketsquare deviationstandard deviationstandard error of estimate standard error of the mean standardizationstandardized normal distribution standardized ratestatisticstatistical inductionstatistical inferencestatistical mapstatistical methodstatistical methodstatistical surveystatistical tablestatistical teststatistical treatmentstatisticsStd.errorstochastic variablestratified samplingsum of rankssum of sguares of deviation from mean superior limitsurvival ratesystematic errorsystematic samplingtabulation methodt-distributiontest of normalitytest of one-sidedtest of one-tailedtest of significancetest of two-sidedtest of two-tailedtest setthe Bretton Woods systemthe root-mean-squared errorTheil's Inequality Coefficient theoretical frequencytheoretical numbertime seriesTraining settreatment factortreatment of datetrend following strateget-testtwo-factor analysis of variancetwo-sided testtwo-tailed testungrouped dataunit rootvalidation setvariance analysisvariance ratiovariation coefficientvectorvelocity of developmentvelocity of increasevolatility spilloverweightweight matrixweighted meanyield curvezero correlationenglish chinese轻微的偏态和较低的峰态横坐标绝对数绝对值偶然误差累积频数激活函数附加值判定系数高等回归分析赤池备择假设分析资料ANOVA方差分析算术对数纸算术均数加权算术均数自回归滑动平均模型假定均数偏度系数迪基-福勒检验平均差平均增益比平均损失比反向传播算法直条图基准点基准模型偏性二项分布生物统计学双变量正态总体买入并持有策略case mortality病死率集中趋势卡方检验组距整群抽样系数相关系数回归系数coefficieut of variation变异系数收集资料组合表合并标准差poolled variance合并方差完全相关完全随机设计可信区间可信水平可信限结构相对数正确方向的变化连续性校正归组校正校正数校正值相关系数临界值临界值累积频率数据集可信度离散程度自由度变异度应变量因变量实验设计离均差积和离均差诊断符合率差别不显著差别显著离散变量离中趋势德宾-沃森检验计量经济学有效率有效市场假说特征值经验计数资料线性回归方程普通股重复误差估计值可解释方差汇率可释方差解释变数极值病死率现场调查固定汇率机制浮动汇率机制预测精度测量四格表频数分布外汇时间序列高斯曲线泛化能力广义自回归条件异方差几何均数分组资料隐层节点直方图方差齐性方差齐性检验假设检验假设总体发病率非全面调检自变量个体差异不等式系数感染率下限原始数据输入值检查资料截距截距内插法区间估计负相关峰度系数拉丁方设计最小显著差数最小平方法最小方差法尖峭态分布峰态可能性线图直线相关线性相关分析直线回归直线回归方程环比对数似然值对数正态分布对数尺度逻辑函数对数正态分布伦敦每日收盘价下限麦金龙市场无效论配对设计数理统计极大值均值平均绝对误差平均绝对百分差总体均数均方均方正态峰分组法最小平方法百分位数法组中值众数模化动差动力参数患病率死亡率出生率自然对数负相关负偏志网络选型网络权值神经网络模型NNR models神经网络回归模型非线性相关非线性模型非线性非参数模型非参数统计正态曲线正态离差正态分布正态峰正态总体正态概率曲线正常范围正常值正态性检验患病率无效假设观察单位观察值奥卡姆剃刀原理单测检验单尾检验最优加权优化衡准期权定价顺序统计量秩号纵坐标过适过分操作配对资料参数百分位数PP test pp检验园图调查计划点估计总体均数总体率总体方差投资组合正相关正偏态把握度患病率偶然误差前瞻研究前瞻调查卫生统计学质量控制四分位数拟随机随机数目表随机样本随机抽样随机变量随机游走模型随机化随机区组随机单位组方差分析随机单位组设计极差正常值范围等级相关等级相关系数等级资料秩和检验识别能力回归分析回归分析回归分析回归系数回归方程相对数比较相对数定基比剩余误差回顾调查参照单位分析参照单位值均方根误差根均方误差样本含量抽样误差样本统计量抽样调查电子饱和区散点图调查表SC施瓦兹准则四分位数间距半对数线图半计量资料灵敏度夏普比率符号检验显著性,意义显著性水平显著性检验差别显著单纯随机抽样简单表单步线性预测样本含量偏态斜率整理资料整理表变异来源投机交易现货交易即期外汇现货市场方差Std.Dev标准差标准估计误差均数的标准误标准化标准正态分布标化率统计量统计图统计归纳统计推断统计地图统计法统计方法统计调查统计表统计检验统计学标准误差分层抽样统计处理秩和离均差平方和上限生存率系统误差机械抽样划记法t分布正态性检验单侧检验单尾检验显著性检验双侧检验双尾检验测试集布雷顿森林体系均方误差希尔不等系数理论频数理论数时间序列训练集处理因素数据处理趋势跟踪策略t检验双因素方差分析双侧检验双尾检验未分组资料单位根验证集方差分析方差比变异系数向量发展速度增长速度波动溢出权数权矩阵加权均数收益曲线零相关。

计量经济学导论伍德里奇数据集全文共四篇示例,供读者参考第一篇示例:计量经济学导论伍德里奇数据集是一个广泛使用的经济学数据集,它收集了来自不同国家和地区的大量经济数据,包括国内生产总值(GDP)、人口、失业率、通货膨胀率等指标。

这些数据被广泛用于经济学研究和实证分析,帮助经济学家们了解和预测经济现象。

伍德里奇数据集由经济学家Robert S. Pindyck和Daniel L. Rubinfeld于1991年编撰而成,现已成为许多大学和研究机构的经济学教学和研究工具。

该数据集包含了大量的时间序列和横截面数据,涵盖了从1960年至今的多个国家和地区。

在伍德里奇数据集中,经济指标按照国家和地区进行分类,每个国家或地区都有各种经济指标的时间序列数据。

这些数据不仅涵盖了宏观经济指标,如GDP、人口、通货膨胀率等,还包括了一些特定领域的数据,如能源消耗、就业情况、教育水平等。

研究人员可以使用伍德里奇数据集进行各种经济学研究,例如分析不同国家和地区的经济增长趋势、比较不同国家之间的经济表现、评估各种经济政策的效果等。

通过对数据集的分析,经济学家们可以更好地理解和解释经济现象,为政策制定和经济预测提供依据。

除了为经济学研究提供数据支持外,伍德里奇数据集还可以帮助经济学教学。

许多经济学课程都会使用这个数据集进行案例分析和实证研究,让学生们更直观地理解经济理论,并将理论应用到实际问题中去。

通过实际数据的分析,学生们可以培养独立思考和解决问题的能力,提高他们的经济学研究水平。

要正确使用伍德里奇数据集进行经济学研究和教学,研究人员和教师们需要对数据集的结构和特点有深入的了解。

他们需要了解数据集中各个变量的定义和计量单位,以确保数据分析的准确性。

他们需要熟悉数据集的时间跨度和覆盖范围,以便选择合适的时间段和国家样本进行研究。

他们还需要掌握数据处理和分析的方法,如时间序列分析、横截面分析等,以确保研究结论的可靠性和科学性。

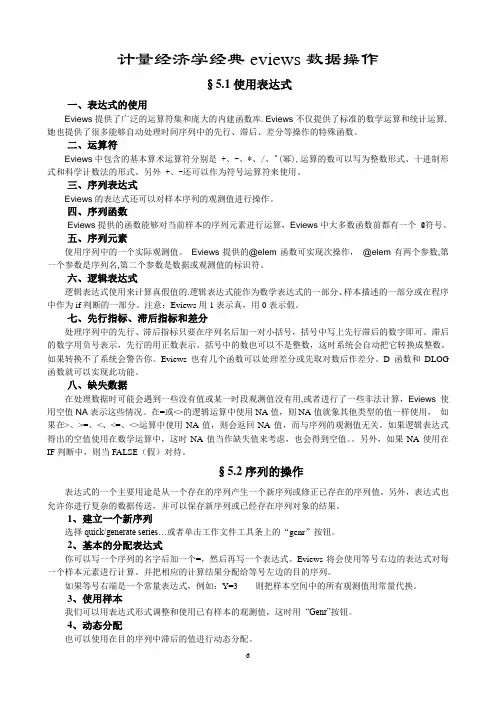

计量经济学经典eviews数据操作§5.1使用表达式一、表达式的使用Eviews提供了广泛的运算符集和庞大的内建函数库.Eviews不仅提供了标准的数学运算和统计运算,她也提供了很多能够自动处理时间序列中的先行、滞后、差分等操作的特殊函数。

二、运算符Eviews中包含的基本算术运算符分别是 +、-、*、/、^(幂),运算的数可以写为整数形式、十进制形式和科学计数法的形式。

另外 +、-还可以作为符号运算符来使用。

三、序列表达式Eviews的表达式还可以对样本序列的观测值进行操作。

四、序列函数Eviews提供的函数能够对当前样本的序列元素进行运算,Eviews中大多数函数前都有一个 @符号。

五、序列元素使用序列中的一个实际观测值。

Eviews提供的@elem函数可实现次操作,@elem有两个参数,第一个参数是序列名,第二个参数是数据或观测值的标识符。

六、逻辑表达式逻辑表达式使用来计算真假值的.逻辑表达式能作为数学表达式的一部分、样本描述的一部分或在程序中作为if判断的一部分。

注意:Eviews用1表示真,用0表示假。

七、先行指标、滞后指标和差分处理序列中的先行、滞后指标只要在序列名后加一对小括号,括号中写上先行滞后的数字即可。

滞后的数字用负号表示,先行的用正数表示。

括号中的数也可以不是整数,这时系统会自动把它转换成整数。

如果转换不了系统会警告你。

Eviews也有几个函数可以处理差分或先取对数后作差分。

D函数和DLOG 函数就可以实现此功能。

八、缺失数据在处理数据时可能会遇到一些没有值或某一时段观测值没有用,或者进行了一些非法计算,Eviews使用空值NA表示这些情况。

在=或<>的逻辑运算中使用NA值,则NA值就象其他类型的值一样使用,如果在>、>=、<、<=、<>运算中使用NA值,则会返回NA值,而与序列的观测值无关。

如果逻辑表达式得出的空值使用在数学运算中,这时NA值当作缺失值来考虑,也会得到空值。

计量经济学数据引言概述:计量经济学是经济学中一门重要的学科,它研究的是经济现象和经济政策的定量分析方法。

在计量经济学中,数据是不可或者缺的重要组成部份。

本文将从数据的来源、类型、质量、处理和分析等五个大点进行阐述,以期匡助读者更好地理解计量经济学数据的重要性和应用。

正文内容:1. 数据的来源1.1. 实验数据:通过实验设计和实施,获得的数据具有较高的控制性和可重复性。

1.2. 调查数据:通过问卷调查、访谈等方式获取的数据,能够反映实际情况和个体行为。

1.3. 历史数据:通过统计局、政府部门等机构采集的历史数据,具有一定的时序性和代表性。

1.4. 金融市场数据:通过金融市场交易数据获得的数据,反映了市场行为和价格波动等情况。

1.5. 大数据:通过互联网、社交媒体等渠道获取的大规模数据,能够提供更全面和深入的信息。

2. 数据的类型2.1. 定量数据:以数字形式表达的数据,如收入、价格等,可以进行数学和统计分析。

2.2. 定性数据:以非数字形式表达的数据,如性别、职业等,不能直接进行数学和统计分析,但可以进行分类和描述。

2.3. 时间序列数据:按照时间顺序罗列的数据,如股票价格、GDP等,可以进行趋势和周期性分析。

2.4. 截面数据:在某一特定时间点上采集的数据,如个体的年龄、收入等,可以进行横截面分析。

2.5. 面板数据:同时包含时间序列和截面数据的数据,可以进行动态面板数据分析。

3. 数据的质量3.1. 可靠性:数据的来源和采集方法是否可信,数据是否经过核实和验证。

3.2. 完整性:数据是否包含了所需的全部信息,是否存在缺失或者错误的情况。

3.3. 一致性:数据是否在不同来源和时间点上保持一致,是否存在矛盾或者冲突的情况。

3.4. 精确性:数据的度量是否准确,是否存在测量误差或者估计误差。

3.5. 可用性:数据是否易于获取和使用,是否存在访问限制或者使用限制。

4. 数据的处理4.1. 数据清洗:对原始数据进行去重、去噪、填补缺失值等处理,以保证数据的准确性和完整性。

计量经济学数据计量经济学是经济学中的一个重要分支,它通过运用数理统计方法和经济理论,对经济现象进行量化分析和预测。

在计量经济学的研究过程中,数据的收集、整理和分析是至关重要的环节。

本文将围绕计量经济学数据展开讨论,包括数据的来源、类型、质量评估和处理方法等。

一、数据的来源计量经济学的数据来源多样,主要包括以下几种:1. 宏观经济数据:如国内生产总值(GDP)、物价指数、失业率等,这些数据通常由政府部门或国际组织发布。

2. 微观经济数据:如个体企业的销售额、利润、劳动力成本等,这些数据通常由企业自行收集或通过市场调研机构获得。

3. 社会调查数据:如家庭收入、教育水平、健康状况等,这些数据通常通过问卷调查、面访等方式获得。

4. 金融市场数据:如股票价格、汇率、利率等,这些数据通常由金融机构提供。

二、数据的类型根据数据的性质和测量方式,计量经济学数据可分为以下几种类型:1. 时间序列数据:按时间顺序排列的数据,如某一经济指标在不同时间点上的观测值。

2. 截面数据:在某一特定时间点上收集的数据,如某一经济指标在不同地区或不同个体上的观测值。

3. 面板数据:同时包含时间序列和截面的数据,如某一经济指标在不同地区或不同个体上的观测值,并且这些观测值在一段时间内持续收集。

三、数据的质量评估在使用计量经济学数据进行分析之前,需要对数据的质量进行评估,以确保数据的可靠性和准确性。

常用的数据质量评估方法包括以下几个方面:1. 完整性:数据是否完整,是否存在缺失值或异常值。

2. 一致性:数据是否一致,是否存在逻辑错误或矛盾。

3. 可信度:数据的来源是否可信,是否有可能存在操纵或误报。

4. 精度:数据的测量误差是否可接受,是否能够满足研究的要求。

5. 可比性:数据是否具有可比性,是否可以进行跨时间、跨地区或跨个体的比较。

四、数据的处理方法在计量经济学研究中,常常需要对原始数据进行处理和转换,以满足研究的需要。

常用的数据处理方法包括以下几种:1. 数据清洗:对原始数据进行筛选、去除异常值和缺失值,以保证数据的质量。

计量经济学数据计量经济学是经济学中的一个重要分支,它研究经济现象和经济理论之间的数学和统计关系。

在计量经济学的研究过程中,数据的采集、整理和分析是至关重要的环节。

本文将详细介绍计量经济学数据的标准格式以及数据的来源和应用。

一、计量经济学数据的标准格式计量经济学数据的标准格式通常包括以下几个方面的内容:1. 变量名称:对于每一个数据变量,需要给出一个明确的名称,以便于后续分析和解释。

例如,对于GDP(国内生产总值)这个变量,可以使用“GDP”作为变量的名称。

2. 变量定义:对于每一个变量,需要给出一个准确的定义,以确保数据的一致性和可比性。

例如,对于GDP这个变量,可以定义为某个国家或者地区在一定时间内生产的全部最终产品和服务的市场价值。

3. 数据来源:对于每一个数据变量,需要注明数据的来源,以确保数据的可靠性和可验证性。

数据来源可以是政府统计机构、国际组织、学术研究机构等。

例如,GDP数据可以来源于国家统计局或者国际货币基金组织。

4. 数据单位:对于每一个数据变量,需要注明数据的单位,以确保数据的一致性和可比性。

例如,GDP数据可以使用货币单位(如美元)或者百分比单位(如GDP增长率)。

5. 数据频率:对于时间序列数据,需要注明数据的频率,以确保数据的时效性和可比性。

常见的数据频率包括年度数据、季度数据、月度数据等。

6. 数据格式:对于数值型数据,需要注明数据的格式,例如小数位数、千位分隔符等。

对于文本型数据,需要注明数据的编码方式和字符集。

二、计量经济学数据的来源和应用计量经济学数据的来源多种多样,常见的数据来源包括政府统计机构、国际组织、学术研究机构、企业调查等。

这些数据来源提供了大量的经济数据,包括国民经济核算数据、劳动力市场数据、价格指数数据、贸易数据等。

这些数据在计量经济学研究中有着广泛的应用。

首先,这些数据可以用于描述和分析经济现象和经济行为。

例如,通过分析GDP数据,可以了解一个国家或者地区的经济总量和经济增长趋势。

计量经济学数据计量经济学是研究经济现象的数量关系的一门学科,通过收集、整理和分析数据来揭示经济现象的规律。

在计量经济学中,数据是至关重要的,它们是研究的基础和支撑。

数据的来源可以是调查、实验、统计机构、政府部门等。

在进行计量经济学研究时,我们需要采用标准格式的文本来描述和呈现数据,以确保数据的准确性和可读性。

标准格式的文本包括以下几个要素:1. 数据来源:首先,我们需要明确数据的来源,例如调查机构、统计局、研究机构等。

这有助于读者了解数据的可信度和可靠性。

2. 数据样本:接下来,我们需要描述数据的样本。

样本是指从总体中选取的一部分观察对象,它代表了总体的特征。

描述样本时,需要包括样本的大小、抽样方法和抽样时期等信息。

3. 数据变量:然后,我们需要介绍数据所涉及的变量。

变量是用来度量经济现象的属性或特征,例如收入、价格、就业率等。

对于每个变量,我们需要明确其定义、度量单位和测量方法。

4. 数据类型:在计量经济学中,数据可以分为两种类型:定量数据和定性数据。

定量数据是用数字表示的,可以进行数学运算和统计分析;定性数据是用文字或符号表示的,通常用于描述性分析。

我们需要明确数据的类型,以便正确选择适当的分析方法。

5. 数据处理:在研究过程中,我们可能需要对数据进行处理和转换,以满足研究需求。

数据处理可以包括数据清洗、数据转换、数据合并等操作。

我们需要详细描述数据处理的方法和步骤,以确保结果的可重复性和可验证性。

6. 数据分析:最后,我们需要进行数据分析,以揭示经济现象的规律和关系。

数据分析可以使用各种统计方法和模型,例如回归分析、时间序列分析、面板数据分析等。

我们需要详细描述所使用的分析方法和模型,以及得出的结论和推断。

总之,计量经济学数据的标准格式的文本应包括数据来源、样本描述、变量定义、数据类型、数据处理和数据分析等要素。

通过准确描述这些要素,我们可以确保数据的可信度和可靠性,从而进行有效的计量经济学研究。

计量经济学数据计量经济学是经济学领域中的一个重要分支,它运用数理统计学和经济学的理论和方法,对经济现象进行量化分析和预测。

在计量经济学研究中,数据是不可或缺的重要组成部分,它为研究人员提供了对经济现象进行实证分析的基础。

在进行计量经济学研究时,需要收集和处理各种类型的数据。

这些数据可以是时间序列数据,即按照时间顺序排列的数据,例如某个国家的GDP数据;也可以是截面数据,即在某一个时间点上收集的数据,例如某个城市的人口数据;还可以是面板数据,即同时包含时间序列和截面的数据,例如不同城市的房价数据。

为了保证计量经济学研究的可靠性和有效性,需要遵循一定的数据处理和分析的标准。

下面是一些常用的标准格式和步骤:1. 数据收集:首先,确定研究的目标和问题,明确需要收集的数据类型和范围。

然后,通过各种渠道获取数据,例如政府统计局、调查问卷、互联网数据等。

在收集数据时,要注意数据的来源和可靠性,尽量选择公开和权威的数据。

2. 数据清洗:在收集到数据后,需要对数据进行清洗和整理,以确保数据的准确性和一致性。

数据清洗包括去除重复数据、处理缺失数据、处理异常值等。

同时,还需要对数据进行标准化,使得不同变量之间具有可比性。

3. 数据描述:在进行计量经济学分析之前,需要对数据进行描述性统计分析。

可以计算数据的均值、标准差、最大值、最小值等统计指标,以了解数据的分布和变化情况。

此外,还可以绘制直方图、散点图等图表,直观地展示数据的特征。

4. 数据建模:在进行计量经济学研究时,通常会使用一定的经济理论模型进行分析。

根据研究问题的不同,可以选择不同的模型,例如线性回归模型、时间序列模型等。

在建立模型时,需要选择适当的自变量和因变量,并进行变量的转换和调整,以确保模型的可靠性和有效性。

5. 数据分析:在建立模型之后,需要对数据进行进一步的分析。

可以使用各种统计方法和技术,例如假设检验、方差分析、回归分析等,对模型进行参数估计和显著性检验。

计量经济学数据计量经济学是一门研究经济现象的定量方法和技术的学科,它运用统计学和数学工具来分析经济数据,从而揭示经济规律和进行经济政策的评估。

在计量经济学研究中,数据的选择、处理和分析是非常关键的环节。

一、数据的选择在进行计量经济学研究时,首先需要选择适当的数据。

数据的选择应该基于研究的目的和问题,以及数据的可得性和质量。

常用的数据来源包括官方统计数据、调查数据、公司财务报表等。

此外,还可以利用计量经济学中的时间序列数据和面板数据等特殊类型数据进行研究。

二、数据的处理数据的处理是为了使原始数据更加适合进行计量经济学分析。

数据处理的主要任务包括数据清洗、变量构建和数据转换等。

数据清洗是指对原始数据进行筛选、删除异常值和缺失值等处理,以保证数据的准确性和完整性。

变量构建是指根据研究的需要,通过对原始数据进行加工和计算,构建出新的变量。

数据转换是指对原始数据进行变换,使其满足计量经济学模型的假设条件。

三、数据的分析数据的分析是计量经济学研究的核心环节,它通过运用统计学和数学工具,对数据进行描述和推断。

常用的数据分析方法包括描述统计分析、回归分析、时间序列分析和面板数据分析等。

描述统计分析主要用于对数据进行总体特征的描述,如均值、方差、频数分布等。

回归分析是计量经济学中最常用的方法,它通过建立经济模型,对变量之间的关系进行定量分析。

时间序列分析和面板数据分析则用于研究数据随时间变化和跨个体之间的关系。

四、数据的解释数据的解释是对计量经济学分析结果进行解读和说明。

在数据解释过程中,需要注意结果的统计显著性和经济意义。

统计显著性是指分析结果的假设检验是否通过,表明变量之间的关系是否存在。

经济意义是指对分析结果进行经济解释,揭示变量之间的经济关系和影响机制。

数据解释的目的是为了回答研究问题,提供经济政策的决策依据。

总之,计量经济学数据的选择、处理、分析和解释是进行计量经济学研究的基本步骤。

合理选择数据、正确处理数据、准确分析数据和恰当解释数据,将有助于揭示经济现象的规律和提供经济政策的科学依据。

一、概述计量经济学是经济学中的一门重要分支,它利用数学和统计工具来解释经济现象和预测经济变量。

在计量经济学中,使用Python语言建立模型已经成为一种普遍的趋势。

Python具有简洁的语法和丰富的库,可以帮助经济学家更高效地进行数据处理和建模分析。

本文将介绍计量经济学中使用Python建立模型的方法和技巧。

二、数据处理1. 数据收集:在建立计量经济学模型之前,首先需要收集相关的经济数据。

这些数据可以来自于冠方统计机构、学术研究机构或者自行采集。

Python提供了各种库和工具,如pandas和BeautifulSoup,可以帮助我们高效地抓取和处理经济数据。

2. 数据清洗:经济数据往往存在缺失值、异常值等问题,因此在建立模型前需要对数据进行清洗。

Python的pandas库提供了丰富的数据处理函数,可以帮助我们快速识别和处理数据中的问题。

3. 数据可视化:在数据处理的过程中,我们还可以利用Python的matplotlib和seaborn库进行数据可视化,帮助我们更直观地了解数据的分布和变化趋势。

三、建立模型1. 线性回归模型:在计量经济学中,线性回归模型是最常用的模型之一。

我们可以使用Python的statsmodels库来建立线性回归模型,进行参数估计和显著性检验。

statsmodels还提供了丰富的模型诊断函数,帮助我们检验模型的拟合效果和稳健性。

2. 时间序列模型:经济数据往往具有时间序列特性,因此在计量经济学中,时间序列模型也是非常重要的。

Python的statsmodels库和其他专门的时间序列分析库,如pmdarima和prophet,可以帮助我们建立各类时间序列模型,进行趋势分析和预测。

3. 面板数据模型:对于面板数据,我们可以使用Python的linearmodels库来建立面板数据模型,进行固定效应或随机效应估计,并进行异方差和自相关的检验和修正。

四、模型评价1. 拟合优度和显著性检验:在建立模型后,我们需要对模型进行评价。

例 1.3序列T 和H 分别表示某地区1997 年 1 月至2000 年12 月的气温和绝对湿度的月平均值序列,数据见表 1.2。

要求绘制序列H 的经验累计分布函数图和它与序列T 的QQ图。

表 1.2(0102)某地区气温和绝对湿度月平均值例 2.1 表 2.1 是 1950— 1987 年间美国机动车汽油消费量和影响消费量的变量数值。

其 中各变量表示: qmg —机动车汽油消费量(单位:千加仑) ; car —汽车保有量; pmg —机动 汽油零售价格; pop —人口数; rgnp —按 1982 年美圆计算的 gnp (单位:十亿美圆) ; pgnp — gnp 指数(以 1982 年为 100) 。

以汽油量为因变量,其他变量为自变量,建立一个回归模 型。

表 2.1( 0201 ) 1950— 1987 年间美国机动车汽油消费量数据例 2.1 表 2.1 是 1950— 1987 年间美国机动车汽油消费量和影响消费量的变量数值。

其101515260 161017926 1.157 234799 3279.1 103.9102603690 163432944 1.129237001 3489.9 107.9104719230 1687438171.1152392793585.2111.5ls car c pmg pop rgnp pgnp ls qmg c car pmg pop rgnp pgnp ls car c pmg pop rgnp pgnp scalar vifcar=1/(1-eqcar.@r2) eq01.testdrop carLs qmg-qmg(-1) car-car(-1) pmg-pmg(-1) pop-pop(-1) rgnp-rgnp(-1) pgnp-pgnp(-1)Ls qmg-qmg(-1) car-car(-1)Ls qmg c qmg(-1) car car(-1) pmg pmg(-1) pop pop(-1) rgnp rgnp(-1) pgnp pgnp(-1) pmg pmg(-1) pop pop(-1) rgnp rgnp(-1)pgnpEq01.testdrop pgnppgnp(-2)Ls qmg c qmg(-1) car Ls qmg c qmg(-1) car pmg pmg(-1) pop pop(-1) rgnp(-1) pgnp Ls qmg c qmg(-1) carpmg pmg(-1) pop pop(-1)rgnp(-1)Ls qmg c qmg(-1) carpmg pmg(-1) pop pop(-1) rgnp(-1)Ls cScalar beta0=eq04.@Dependent Variable: QMGMethod: Least SquaresDate: 10/16/12 Time: 19:02Sample: 1950 1987Included observations: 38Variable Coefficient Std. Error t-Statistic Prob.C 68497350 13416155 5.105587 0.0000CAR 1.587677 0.137742 11.52646 0.0000PMG -10375410 3346338. -3.100526 0.0040POP -462.2931 108.0825 -4.277224 0.0002RGNP -12666.47 5248.346 -2.413421 0.0217PGNP -579453.0 59259.84 -9.778173 0.0000R-squared 0.991878 Mean dependent var 80901846Adjusted R-squared 0.990608 S.D. dependent var 22972717S.E. of regression 2226295. Akaike info criterion 32.21351Sum squared resid 1.59E+14 Schwarz criterion 32.47208Log likelihood -606.0568 Hannan-Quinn criter. 32.30551F-statistic 781.5361 Durbin-Watson stat 0.869418Prob(F-statistic) 0.000000例 2.2为研究采取某项保险革新措施的速度y与保险公司的规模x1 和保险公司类型的关系,选取下列数据:y—一个公司提出该项革新直至革新被采纳间隔的月数,x1 —公司的资产总额(单位:百万元),x2—定性变量,表示公司类型:其中 1 表示股份制公司,0 表示互助公司。

计量经济学数据计量经济学是经济学的一个重要分支,旨在通过运用数理统计和经济理论来分析经济现象。

在计量经济学研究中,数据的选择和使用是至关重要的。

本文将介绍计量经济学数据的标准格式,并提供一些例子来说明。

一、数据来源计量经济学数据可以来自多种渠道,包括政府统计机构、国际组织、学术研究机构以及企业等。

数据的来源应该是权威可靠的,有良好的数据质量保证。

二、数据类型1. 时间序列数据:时间序列数据是按照一定时间间隔收集的数据,通常用于分析经济变量随时间的变化趋势。

例如,GDP、通货膨胀率、失业率等。

2. 截面数据:截面数据是在某一特定时间点上收集的数据,通常用于分析不同个体之间的差异。

例如,个人收入、教育水平、就业情况等。

3. 面板数据:面板数据是时间序列数据和截面数据的结合,既包含了个体之间的差异,又包含了随时间的变化。

例如,企业的销售额、利润率等。

三、数据格式1. 数据表格:数据表格是最常见的数据格式,通常使用Excel、CSV等文件格式进行存储和处理。

数据表格应该包含清晰的表头和行列标签,以便于数据的理解和分析。

2. 数据变量:每一列代表一个变量,每一行代表一个观测值。

变量应该有明确的名称和单位,以便于数据的解释和比较。

例如,变量名称可以是“GDP”,单位可以是“亿元”。

3. 缺失值处理:在数据收集过程中,可能会出现部分数据缺失的情况。

对于缺失值,可以使用特定的符号(如“NA”)或者进行插补处理。

在使用数据时,应该注意缺失值对结果的影响。

四、数据清洗数据清洗是指对原始数据进行处理,以确保数据的质量和可用性。

数据清洗可能包括以下几个步骤:1. 数据去重:去除重复的数据观测值,以避免重复计算和分析。

2. 数据筛选:根据研究的需要,选择符合条件的数据进行分析。

例如,根据时间范围、地区等筛选条件进行数据选择。

3. 数据转换:对数据进行转换,以满足研究的需求。

例如,将货币单位转换为统一的标准,或者对数据进行对数变换等。