第二章回归分析概述

- 格式:doc

- 大小:331.03 KB

- 文档页数:11

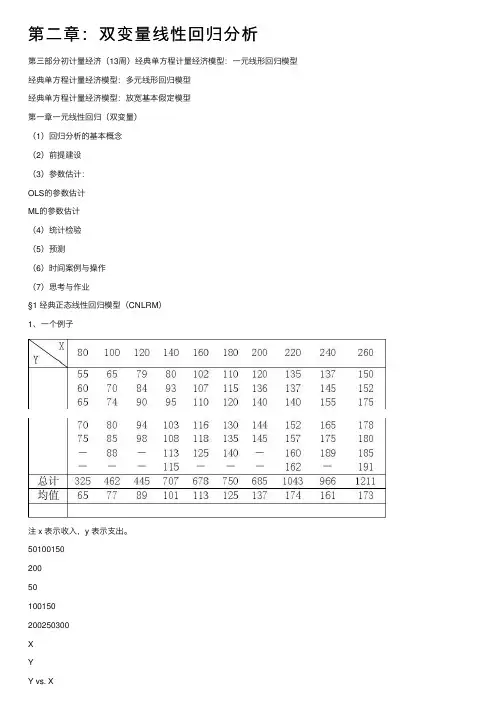

第⼆章:双变量线性回归分析第三部分初计量经济(13周)经典单⽅程计量经济模型:⼀元线形回归模型经典单⽅程计量经济模型:多元线形回归模型经典单⽅程计量经济模型:放宽基本假定模型第⼀章⼀元线性回归(双变量)(1)回归分析的基本概念(2)前提建设(3)参数估计:OLS的参数估计ML的参数估计(4)统计检验(5)预测(6)时间案例与操作(7)思考与作业§1 经典正态线性回归模型(CNLRM)1、⼀个例⼦注 x 表⽰收⼊,y 表⽰⽀出。

5010015020050100150200250300XYY vs. X5010015020050100150200250300XY 1Y1 vs. X条件分布:以X 取定值为条件的Y 的条件分布条件概率:给定X 的Y 的概率,记为P(Y|X)。

例如,P(Y=55|X=80)=1/5;P (Y=150|X=260)=1/7。

条件期望(conditional Expectation ):给定X 的Y 的期望值,记为E(Y|X)。

例如,E(Y|X=80)=55×1/5+60×1/5+65×1/5+70×1/5+75×1/5=65总体回归曲线(Popular Regression Curve )(总体回归曲线的⼏何意义):当解释变量给定值时因变量的条件期望值的轨迹。

总结总体:总体函数:总体⽅程:样本:样本函数:样本⽅程:2、总体回归函数(PRF)E(Y|X i)=f(X i)当PRF的函数形式为线性函数,则有,E(Y|X i)=β1+β2X i其中β1和β2为未知⽽固定的参数,称为回归系数。

β1和β2也分别称为截距和斜率系数。

上述⽅程也称为线性总体回归函数。

3、PRF的随机设定将个别的Y I围绕其期望值的离差(Deviation)表述如下:u i=Y i-E(Y|X i)或Y i=E(Y|X i)+u i其中u i是⼀个不可观测的可正可负的随机变量,称为随机扰动项或随机误差项。

第二章多元线性回归§2.1 基本概述一、回归的任务多元线性回归(MLR)(multiple linear regression)是分析一个随机变量与多个变量之间线性关系的统计方法。

回归(Regression)起源于19世纪生物学家F·高尔顿进行的遗传学研究。

其核心是“普通最小平方法”(Ordinary Least Squares)OLS。

多元回归将所研究的变量分为:确定自变量和因变量的关系是回归分析的主要任务:(1)根据实测数据求解某一模型的各个参数;(2)评价回归模型是否较好地拟合实例数据;(3)利用模型进行预测。

需要注意的是:(1) 因变量必须是间距测度等级以上的变量(有时也包含定性变量。

见《应用回归分析》)(也称为连续变量)。

自变量可以是任意等级的变量。

(2)既使模型正确通过检验,也不能确定X、Y之间的因果关系,而只能确认存在着统计关系。

[例] 不同地区的人均食品支出与人均收入的关系(图2–1);汽车重量与每加仑燃料行驶英里值的关系;(图2–2)。

图2–1图2–2二、一元线性回归的回顾1. 模型i i i x Y εββ++=10 (2.1)当获得n 组样本观测值(x 1 , y 1),(x 2 , y 2),…(x n ,y n )的数据时,如果符合2.1式,则有n i X Y iii,,2,11=++=εββ (2.2)2.1式称为理论回归模型;2.2式称为样本回归模型。

有时不加以区分地将两者称为一元线性回归模型。

通过n 组观测值,用OLS 法对10,ββ进行估计,得10ˆ,ˆββ,则称为Y 关于X 的一元线性方程。

其中: 1β 回归系数,说明X 与Y 之间的变化关系。

2.普通最小二乘法估计的统计性质(OLSE Estimation ) (1)残差:ii iY Y e ˆ-=,用来说明拟合效果,可以看作误差项εi 的估计值。

⎪⎩⎪⎨⎧==∑∑00ii i e x e 因为 )(ˆˆX X Y Y-+=β,所以 0)(ˆ)()ˆ(=---=-=∑∑∑∑X X Y Y Y Y e β 但∑=ni i e 1||很麻烦,经常用∑2i e 来说明。

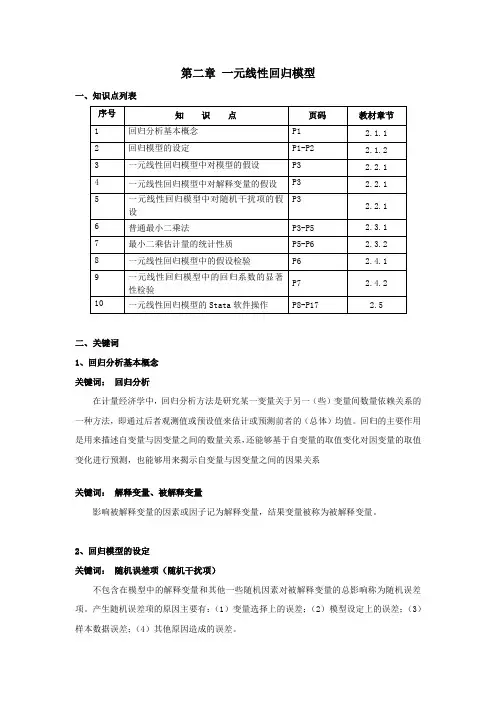

第二章一元线性回归模型一、知识点列表二、关键词1、回归分析基本概念关键词:回归分析在计量经济学中,回归分析方法是研究某一变量关于另一(些)变量间数量依赖关系的一种方法,即通过后者观测值或预设值来估计或预测前者的(总体)均值。

回归的主要作用是用来描述自变量与因变量之间的数量关系,还能够基于自变量的取值变化对因变量的取值变化进行预测,也能够用来揭示自变量与因变量之间的因果关系关键词:解释变量、被解释变量影响被解释变量的因素或因子记为解释变量,结果变量被称为被解释变量。

2、回归模型的设定关键词:随机误差项(随机干扰项)不包含在模型中的解释变量和其他一些随机因素对被解释变量的总影响称为随机误差项。

产生随机误差项的原因主要有:(1)变量选择上的误差;(2)模型设定上的误差;(3)样本数据误差;(4)其他原因造成的误差。

关键词:残差项(residual )通过样本数据对回归模型中参数估计后,得到样本回归模型。

通过样本回归模型计算得到的样本估计值与样本实际值之差,称为残差项。

也可以认为残差项是随机误差项的估计值。

3、一元线性回归模型中对随机干扰项的假设 关键词:线性回归模型经典假设线性回归模型经典假设有5个,分别为:(1)回归模型的正确设立;(2)解释变量是确定性变量,并能够从样本中重复抽样取得;(3)解释变量的抽取随着样本容量的无限增加,其样本方差趋于非零有限常数;(4)给定被解释变量,随机误差项具有零均值,同方差和无序列相关性。

(5)随机误差项服从零均值、同方差的正态分布。

前四个假设也称为高斯马尔科夫假设。

4、最小二乘估计量的统计性质关键词:普通最小二乘法(Ordinary Least Squares ,OLS )普通最小二乘法是通过构造合适的样本回归函数,从而使得样本回归线上的点与真实的样本观测值点的“总体误差”最小,即:被解释变量的估计值与实际观测值之差的平方和最小。

ββ==---∑∑∑nn n222i i 01ii=111ˆˆmin =min ()=min ()i i i i u y y y x关键词:无偏性由于未知参数的估计量是一个随机变量,对于不同的样本有不同的估计量。

第二章回归分析中的几个基本概念第一节回归的含义“回归”(Regression)一词最初是由英国生物学家兼统计学家F.Galton(F·高尔顿)在一篇著名的遗传学论文中引入的(1877年)。

他在研究中发现,具有较高身躯的双亲,或具有较矮身躯的双亲尔,其子女的身高表现为退回(即回归)到人的平均身高趋势。

这一回归定律后来被统计学家K·Pearson通过上千个家庭成员身高的实际调查数据进一步得到证实,从而产生了“回归”这一名称。

然而,现代意义上的“回归”比其原始含义要广得多。

一般来说,现代意义上的回归分析是研究一个变量(也称为explained variable或因变量dependent variable)对另一个或多个变量(也称为解释变量explanatory variable或自变量independent variable )的依赖关系,其目的在于通过解释变量的给定值来预测被解释变量的平均值或某个特定值。

具体而言,回归分析所要解决的问题主要有:(1)确定因变量与自变量之间的回归模型,并依据样本观测值对回归模型中的参数进行估计,给出回归方程。

(2)对回归方程中的参数和方程本身进行显著性检验。

(3)评价自变量对因变量的贡献并对其重要性进行判别。

(4)利用所求得的回归方程,并根据自变量的给定值对因变量进行预测,对自变量进行控制。

第二节统计关系与回归分析一、变量之间的统计关系现象之间的相互联系一般可以分为两种不同的类型:一类为变量间的关系是确定的,称为函数关系;而另一类变量之间的关系是不确定的,称为统计关系。

变量之间的函数关系表达的是变量之间在数量上的确定性关系,即一个或几个变量在数量上的变动就会引起另一个变量在数量上的确定性变动,它们之间的关系可以用函数关系y f x=准确地加以描述,这里x可以是一个向量。

当知道了变量x的值,就可以计算出一()个确切的y值来。

变量之间统计关系,是指一个或几个变量在数量上的变动会引起另一个变量数量上发生变动,但变动的结果不是惟一确定的,亦即变量之间的关系不是一一对应的,因而不能用函数关系进行表达。

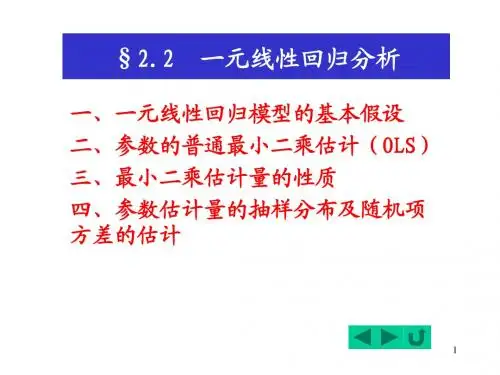

计量经济学第二章一元线性回归模型第二章一元线性回归模型第一节一元线性回归模型及其古典假定第二节参数估计第三节最小二乘估计量的统计特性第四节统计显著性检验第五节预测与控制第一节回归模型的一般描述(1)确定性关系或函数关系:变量之间有唯一确定性的函数关系。

其一般表现形式为:一、回归模型的一般形式变量间的关系经济变量之间的关系,大体可分为两类:(2.1)(2)统计关系或相关关系:变量之间为非确定性依赖关系。

其一般表现形式为:(2.2)例如:函数关系:圆面积S =统计依赖关系/统计相关关系:若x和y之间确有因果关系,则称(2.2)为总体回归模型,x(一个或几个)为自变量(或解释变量或外生变量),y为因变量(或被解释变量或内生变量),u为随机项,是没有包含在模型中的自变量和其他一些随机因素对y的总影响。

一般说来,随机项来自以下几个方面:1、变量的省略。

由于人们认识的局限不能穷尽所有的影响因素或由于受时间、费用、数据质量等制约而没有引入模型之中的对被解释变量有一定影响的自变量。

2、统计误差。

数据搜集中由于计量、计算、记录等导致的登记误差;或由样本信息推断总体信息时产生的代表性误差。

3、模型的设定误差。

如在模型构造时,非线性关系用线性模型描述了;复杂关系用简单模型描述了;此非线性关系用彼非线性模型描述了等等。

4、随机误差。

被解释变量还受一些不可控制的众多的、细小的偶然因素的影响。

若相互依赖的变量间没有因果关系,则称其有相关关系。

对变量间统计关系的分析主要是通过相关分析、方差分析或回归分析(regression analysis)来完成的。

他们各有特点、职责和分析范围。

相关分析和方差分析本身虽然可以独立的进行某些方面的数量分析,但在大多数情况下,则是和回归分析结合在一起,进行综合分析,作为回归分析方法的补充。

回归分析(regression analysis)是研究一个变量关于另一个(些)变量的具体依赖关系的计算方法和理论。

第⼆章回归分析中的⼏个基本概念第四章⼀、练习题(⼀)简答题1、多元线性回归模型的基本假设是什么?试说明在证明最⼩⼆乘估计量的⽆偏性和有效性的过程中,哪些基本假设起了作⽤?2、多元线性回归模型与⼀元线性回归模型有哪些区别?3、某地区通过⼀个样本容量为722的调查数据得到劳动⼒受教育的⼀个回归⽅程为fedu medu sibs edu 210.0131.0094.036.10++-=R 2=0.214式中,edu 为劳动⼒受教育年数,sibs 为该劳动⼒家庭中兄弟姐妹的个数,medu 与fedu 分别为母亲与⽗亲受到教育的年数。

问(1)若medu 与fedu 保持不变,为了使预测的受教育⽔平减少⼀年,需要sibs 增加多少?(2)请对medu 的系数给予适当的解释。

(3)如果两个劳动⼒都没有兄弟姐妹,但其中⼀个的⽗母受教育的年数为12年,另⼀个的⽗母受教育的年数为16年,则两⼈受教育的年数预期相差多少? 4、以企业研发⽀出(R&D )占销售额的⽐重为被解释变量(Y ),以企业销售额(X1)与利润占销售额的⽐重(X2)为解释变量,⼀个有32容量的样本企业的估计结果如下:099.0)046.0()22.0()37.1(05.0)log(32.0472.0221=++=R X X Y其中括号中为系数估计值的标准差。

(1)解释log(X1)的系数。

如果X1增加10%,估计Y 会变化多少个百分点?这在经济上是⼀个很⼤的影响吗?(2)针对R&D 强度随销售额的增加⽽提⾼这⼀备择假设,检验它不虽X1⽽变化的假设。

分别在5%和10%的显著性⽔平上进⾏这个检验。

(3)利润占销售额的⽐重X2对R&D 强度Y 是否在统计上有显著的影响? 5、什么是正规⽅程组?分别⽤⾮矩阵形式和矩阵形式写出模型:i ki k i i i u x x x y +++++=ββββΛ22110,n i ,,2,1Λ=的正规⽅程组,及其推导过程。

第二章回归分析中的几个基本概念1. 回归模型(Regression Model):回归模型是回归分析的基础,用来描述两个或多个变量之间的关系。

回归模型通常包括一个或多个自变量和一个或多个因变量。

常用的回归模型有线性回归模型和非线性回归模型。

线性回归模型是最简单的回归模型,其中自变量和因变量之间的关系可以用一条直线来表示。

线性回归模型的表达式为:Y=β0+β1*X1+β2*X2+...+βn*Xn+ε其中,Y表示因变量,X1、X2、…、Xn表示自变量,β0、β1、β2、…、βn表示回归系数,ε表示误差项。

2. 回归系数(Regression Coefficients):回归系数是回归模型中自变量的系数,用来描述自变量对因变量的影响程度。

回归系数可以通过最小二乘法估计得到,最小二乘法试图找到一组系数,使得模型的预测值和实际观测值的误差平方和最小。

回归系数的符号表示了自变量与因变量之间的方向关系。

如果回归系数为正,表示自变量的增加会使因变量增加,即存在正向关系;如果回归系数为负,表示自变量的增加会使因变量减少,即存在负向关系。

3. 拟合优度(Goodness-of-fit):拟合优度是用来评估回归模型对样本数据的拟合程度。

通常使用R方(R-squared)来度量拟合优度。

R 方的取值范围在0到1之间,越接近1表示模型对数据的拟合程度越好。

R方的解释是,回归模型中自变量的变异能够解释因变量的变异的比例。

例如,如果R方为0.8,表示模型中自变量解释了因变量80%的变异,剩下的20%可能由其他未考虑的因素引起。

4. 显著性检验(Significance Test):显著性检验用于判断回归模型中自变量的系数是否显著不为零,即自变量是否对因变量有显著影响。

常用的方法是计算t值和p值进行检验。

t值是回归系数除以其标准误得到的统计量。

p值是t值对应的双侧检验的概率。

如果p值小于给定的显著性水平(通常是0.05),则可以拒绝原假设,即认为回归系数显著不为零,即自变量对因变量有显著影响。

第二章回归分析的基本思想第一节回归分析的含义回归分析的基本思想根据经济理论建立计量经济学模型时,计量经济学家会大量地用到回归分析(Regression Analysis)技术,这一节我们将根据最简单的线性回归模型--双变量模型介绍回归分析的基本思想。

回归分析的含义回归分析是研究一个变量与另一个(或一些)变量依赖关系的计算方法和理论。

其中,前一个变量称为被解释变量(Explained Variable)或因变量(Dependent Variable),后一个变量称为解释变量(Explanatory Variable)或自变量(Independent Variable)。

在本书中,为统一符号,统一用y表示因变量,x代表自变量,如果有多个自变量,则用适当的下标表示各个不同的自变量,如有n个自变量,则用x1,x2,…,xn表示。

例如,我们可能对某种商品的需求量与该商品的价格、消费者的收入以及其他竞争性商品的价格之间的关系感兴趣;可能对失业率变动与产出增长之间的关系感兴趣;可能对股票价格指数与利率、GDP增长率等因素之间的关系感兴趣;可能对职工工资与受教育年限之间的关系感兴趣;也可能对购买书报支出金额与收入之间的关系感兴趣。

在这些例子中,有的有理论基础,如需求定理就提供了这样的一个理论基础,即某种产品的需求量依赖于该产品的价格、消费者的收入以及竞争性产品的价格等因素;而奥肯定律则表明失业率的降低依赖于实际产出的增长。

一、回归分析与因果关系要特别注意的是,变量之间的因果关系是回归分析的前提,在被解释变量与解释变量之间存在因果关系的基础上,才能进行回归分析,否则,回归分析没有任何意义。

例如,某段时间内,河水与股市都上涨,显然,如果进行回归分析,则也能建立起回归模型,但得到的结果没有什么意义,因为,河水的上涨与股市的上涨之间并没有什么依赖关系。

二、回归分析与相关分析相关分析是讨论变量之间相关程度的一种统计分析方法。

第二章回归分析概述回归分析是寻求隐藏在随机现象中的统计规律的理论和方法,是经济计量学的最基本的方法论基础。

讨论回归模型在经典假设条件下的参数估计、假设检验和估计量的统计性质,以及经典假设不完全满足条件下,有关问题的处理是理论经济计量学的任务。

为了对回归分析理论和方法有一个全面深入的理解,本章先对回归分析的基本概念和性质予以介绍,在以后各章顺次展开以上问题的讨论。

第一节回归分析的性质一、“回归”一词的现代含义回归一词最早是生物统计学家高尔顿(Francis Galton)引入的。

高尔顿在对人类身高之类的遗传特性的研究中,发现了他称之为“向平均回归”的现象。

虽然客观上存在一种趋势,即父母高,子女也高;父母矮,子女也矮,但是给定父母的身高,子女的平均身高却有“回归”到全体人口的平均身高的倾向。

也就是说,尽管父母双亲都异常高或异常矮,而子女的身高却有趋向人口总体平均身高的趋势。

高尔顿的普通回归定律也被另一位统计学家皮尔逊(Karl Pearson)证实。

高尔顿的兴趣在于发现人口的身高为什么有一种稳定性。

这是“回归”一词的初始含义。

然而,对“回归”一词的现代解释却与初始含义有很大不同,其现代含义是回归分析研究一个被解释变量对另一个或多个解释变量的变量依存关系,其用意在于通过后者(在重复抽样中)的已知或设定值,去估计或预测前者的(总体)均值。

比如,对于父母身高与子女身高的关系研究,人们会发现,对于设定的每一个父辈的身高,都有一个儿辈的假想人口总体的身高分布与之对应,随着父辈身高的增加,儿辈的平均身高也增加。

若把这种父辈身高与儿辈平均身高的一一对应关系绘制在平面坐标图上,可以得到一条直线,这条直线就叫做回归线,它表明儿辈的平均身高如何随父辈的身高变化。

从现代回归的观点出发,人们关心的是给定父辈的身高情况下,如何发现儿辈平均身高的变化。

也就是说,人们关心的是一旦知道了父辈的身高,如何估计预测儿辈的平均身高。

经济学家可以利用回归分析研究个人消费支出对其实际可支配收入的依从关系。

通过回归分析可估计边际消费倾向(MPC),而边际消费倾向说明人们每增加一个单位的实际可支配收入而引起的消费支出的平均变化。

农业经济学家可利用回归分析研究农作物收成对施肥量,降雨量,气温等的依赖关系。

这种分析能使他用给定的解释变量的信息预测或预报农作物的平均收成。

劳动经济学家利用回归分析研究货币工资变化率对失业率的依存关系,著名的菲利普斯曲线就是研究这一依存关系的成果,劳动经济学家经常利用这一曲线预测在给定的某个失业率下货币工资的平均变化。

由于工资的增长会引起物价的上涨,因此通过这一曲线还可以研究通货膨胀、关于经济扩张过程方面的问题。

由货币银行学的知识可知,若其它条件不变,通货膨胀率愈高,人们愿意以货币形式保存的收入比例越低。

对这种关系作回归分析,使金融学家能够预测在各种通货膨胀率下人们愿意以货币形式保存的平均收入比例。

公司的经理想了解人们对公司产品的需求与广告费开支的关系。

对其进行回归分析在很大程度上有助于计算相对于广告费支出的需求弹性,这有助于公司经理制定“最优”的广告费预算。

我们能提供关于一个变量依赖于另一个或多个变量的大量事例。

现代回归分析的主要任务,就是用来研究这种变量之间的依从关系的。

二、统计关系与确定关系在经典物理学中研究的变量之间的关系是函数关系或确定性依赖关系。

从上述例子可以看出,回归分析中研究的变量之间的关系都不是函数关系或确定性依赖关系,而是一种所谓的统计依从关系。

在变量之间的统计关系中,人们主要处理的是随机变量,也就是具有概率分布的变量。

但是在函数或确定性依赖关系中,人们处理的变量是非随机的。

统计关系虽然没有函数关系准确,但是它的存在比后者更为广泛,而且非常有用。

因为客观社会经济现象中存在的大量统计关系可表示成确定性部分和随机性部分之和,这种统计关系的表示是回归分析的基础。

例如农作物收成对施肥量、降雨量、气温的依赖关系是统计性质的。

其意义在于:这些解释变量固然重要,但并不能使农业经济学家准确预测作物的收成。

一方面,除了上述解释变量外,还有其他影响收成的因素(变量)存在,由于种种原因难于一一识别和测量;另一方面,对这些已考虑的解释变量的测量存在误差。

因此,无论我们考虑多少个解释变量,都无法完全解释农作物收成这个应变量。

它的一些“内生的”或随机的变异是注定存在的。

但是在确定性现象中,人们利用函数的形式研究表示这样一类变量的依赖关系。

比如,牛顿的引力定律可表示为212(/)F k m m r ,其中F 为引力,1m 和2m 为两个粒子的质量,r 为距离,而k 为比例常数。

其物理意义说明:宇宙间的每个粒子吸引着另一个粒子,其引力与它们的质量乘积成正比,而与它们之间的距离的平方成反比。

在物理学中,这类确定性现象的例子很多。

如欧姆定律、波依耳的气体定律、克奇霍夫的电流定律和牛顿的运动定律等等。

统计关系与确定性关系有区别,但也有联系。

比方说,在牛顿的引力定律中,若k 的测量有误差,则原来的确定性关系就变成了一个统计关系。

这时,引力只能按给定的k (还有1m 、2m 和r )近似地加以预测,于是变量之间的关系由函数关系变为统计关系,变量F 变成了一个随机变量。

三、回归与因果关系回归分析研究大量的一个变量对一个或一些变量的依赖关系,但是它本身并不揭示和说明这些变量之间是否存在因果关系。

对于这些变量代表的事物之间是否存在因果关系,要由研究这些事物的实质性科学来揭示,因果关系的理念,必须来自统计学之外。

回归分析可对实质性科学揭示的因果关系给予实证。

比如父辈身高与儿辈身高一例中,我们没有任何统计上的理由可以认为父辈身高不依赖于儿辈身高,人们之所以把儿辈身高作为依赖于父辈身高的被解释变量,是出于非统计上的考虑,常识告诉我们不能把这种关系颠倒过来。

若从统计的角度,把儿辈身高作为解释变量而把父辈身高作为被解释变量进行回归,可能得到一个很强的统计关系式,但不能由此得到一个合乎逻辑的解释,更不能得出儿辈的高矮是父辈高矮的原因的荒谬结论。

也就是说,从逻辑上看,统计关系式本身不说明任何因果关系。

事物之间的因果关系,必须依赖先验的或理论上的思考或揭示。

四、回归分析与相关分析以测度两个变量之间的线性关联程度为其主要目的的相关分析,虽然与回归分析具有密切的关联,然而在概念上却迥然不同。

第3章中我们将要讨论的相关系数就是用来测度变量(线性)相关程度的指标。

在现实中,也许我们对家庭的消费支出与家庭的可支配收入,农作物的收获率与降雨量,产品的产出量与劳动和资本的投入量,人的身高与体重,学生的统计学成绩与数学成绩,吸烟的时间与肺癌的发病率等等之间的相关性感兴趣,计算它们的相关系数,进行相关分析。

但在回归分析中,我们对这种度量并无太大的兴趣,感兴趣的是根据其它变量的设定值来估计或预测某一变量的平均值。

比如,也许人们想知道是否能依据一个家庭的可支配收入去预测具有相同可支配收入家庭的平均消费支出。

回归分析和相关分析之间存在一些基本的区别。

在回归分析中,被解释变量与解释变量的处理方法上存在不对称性。

被解释变量是随机变量,具有概率分布,而解释变量则是非随机的,在重复抽样中取固定值。

但在相关分析中,我们对称地对待任何(两个)变量;两个变量都被看作是随机的,没有被解释变量与解释变量的区分,大部分相关理论都建立在变量的随机性假定上。

而回归理论大部分都以下述假定为条件:即被解释变量是随机的,而解释变量是非随机的。

所以,同样两个变量,根据理论分析,可以拟合两个意义不同的回归方程,但只能计算一个相关系数。

比如我们可以拟合以人的身高为被解释变量,以人的体重为解释变量的回归模型;也可以反过来以人的体重作为被解释变量,而以人的身高作为解释变量的回归模型,但人的身高和体重之间只可计算一个相关系数。

相关分析与回归分析之间也存在一些基本的联系。

一般在回归分析之前,要对涉及的变量进行相关分析(定性的、定量的分析),确定有相关关系时,才进一步作回归分析。

因此可以说相关分析是回归分析的前提,回归分析是相关分析的深化。

第二节回归分析的基本概念一、总体回归线上一节指出,回归分析就是要根据解释变量的已知或给定值,去估计或预测被解释变量的(总体)均值。

为了弄清楚其实质含义,考虑下面的例子。

例2.2.1 假想一个人口总体由100户家庭组成。

若我们要研究家庭人均月消费支出Y与人均月可支配收入X之间的关系,也就是说,知道了家庭的人均月可支配收入,预测其人均月消费支出的(总体)平均水平。

表2.1给出了人为的数据,将100户家庭按照其人均可支配收入大小从小到大划分为10个组,每组只给出人均可支配收入的组中值。

表2.1 假想总体月家庭人均可支配收入和消费支出 单位:元表2.1应做如下的解释:对应于每个纵列的给定组中值收入水平X ,都有一个消费支出Y 的总体分布,也就是说,它给出了以X 的给定值为条件的Y 的总体条件分布。

比如,对应于每月1000元的人均可支配收入,具有9户家庭的月人均消费支出(590元,657元,,989元)构成的总体条件分布。

同时我们也容易算出给定X 的Y 的条件概率(|)P Y X 。

例如,当X =1000,得到这些消费支出中任一个的条件概率均为1/9。

用符号表示为(590|1000)1/9P Y X ===等等。

同理,(1564|3000)1/12P Y X ===,等等。

对于Y 的每一条件概率分布,我们都能算出它们的条件均值或条件期望值(conditional expected values ) ,记做(|)i E Y X X =。

例如(|2000)E Y X =1468,=(|3000)E Y X = 2128=,等等。

实际上我们根据表2.1的数据可绘制图2.1的散点图,观察此散点图可以发现,虽然每个个别家庭的人均消费支出都有变异,但图2.1依然清楚地表明随着收入的增加,消费支出平均说来也在增加,也就是说Y 的条件均值随X 的增加而增加。

若将图中粗圆点代表的Y 的各个条件均值连起来,可以看出,这些条件均值落在一条有正斜率的直线上。

这条直线称为总体回归曲线(population regression curve ),简称为总体回归线(population regression line, PRL )。

它表示Y 对X 的回归。

图2.1 不同收入水平下消费支出的条件分布及其总体回归线在几何意义上,总体回归曲线就是当解释变量取给定值时被解释变量的条件均值或期望值的轨迹。

它表明对每一i X 值都有Y 值的一个总体(假定服从正态分布)和一个相应的条件均值。

而总体回归曲线(或直线)就是通过这些条件均值的连线。

二、总体回归函数由图2.1可以清楚地看出,每一条件均值(|)i E Y X X =都是i X 的一个函数,即有: (|)(|)()i i i E Y X X E Y X f X === (2.2.1) 其中()i f X 表示解释变量i X 的某个函数(在我们的人为例子中,(|)i E Y X 是i X 的一个线性函数)。