深度学习-卷积神经网络应用

- 格式:docx

- 大小:212.99 KB

- 文档页数:8

大数据分析中的卷积神经网络算法应用随着物联网技术不断进步和智能化浪潮的兴起,数据量在不断膨胀。

如何更好地处理、分析这些庞大的数据量,将其中有价值的信息提取出来,成为了当前亟待解决的问题。

而大数据分析技术就是解决这个问题的重要手段之一。

在大数据分析技术中,卷积神经网络算法的应用越来越受到重视。

一、卷积神经网络算法介绍卷积神经网络是一个可以自动学习和提取特征的神经网络模型。

它结构复杂、理论丰富,广泛应用于图像、语音等信号处理领域,具有良好的分类、识别能力。

相比传统方法,它能够更好地模拟人类视觉和听觉系统的工作过程。

卷积神经网络的核心是卷积层、池化层和全连接层。

其中卷积层和池化层可以有效地减少模型复杂度和参数量,全连接层是整个网络的输出层,可以输出分类或回归结果。

二、卷积神经网络在大数据分析中的应用1. 图像识别卷积神经网络在图像识别领域的应用比较广泛。

在大数据分析中,通过使用卷积神经网络,可以训练模型进行图片分类、定位和检测等任务。

卷积神经网络的局部连接和共享参数的特点,使得对于图像中位置的变化,可以具有一定的不变性,能够更好地学习图像的特征,提高识别的准确性。

2. 自然语言处理卷积神经网络在自然语言处理中的应用也比较广泛。

在大数据分析中,卷积神经网络可以用于文本分类、情感分析、问答系统等任务。

卷积神经网络的卷积层可以提取文本中的n-gram特征,对于文本中的局部结构特征有很好的捕获能力。

而卷积神经网络的全连接层则可以输出文本的分类结果。

3. 信号处理信号处理是大数据分析的一个重要领域,而卷积神经网络在这个领域的应用也是不可或缺的。

卷积神经网络可以用于音频分类、音频分割、语音识别等任务。

卷积神经网络的卷积层可以对音频信号的时域和频域进行特征提取和抽象,对于音频数据的局部信息和全局信息都能够较好地进行处理。

三、卷积神经网络算法的优缺点1. 优点(1) 卷积神经网络具有良好的特征提取能力,能够从庞大的数据中自动识别,提取有效的特征进行分类等任务。

深度学习在医学影像研究中的应用摘要:随着深度学习技术的发展,医学影像技术也发生了重大变革,从基于图像分割的医学影像处理到基于目标检测与分割的医学影像处理,再到基于深度学习的医学影像分析,其应用范围越来越广泛。

深度学习在医学影像领域的应用主要有:①医学影像数据自动标注,可用于临床科研和培训;②高质量、多模态、多层次医学影像数据自动生成;③医疗影像深度学习临床应用,包括临床疾病诊断、病理分型及鉴别诊断、预测治疗效果等。

随着深度学习技术的发展,近年来,医疗影像深度学习在医学影像处理与分析方面取得了长足进步。

本文将介绍深度学习技术在医学影像数据标注与分析方面的最新进展,以及该技术在医疗领域的应用。

关键词:深度学习;医学影像;研究1医学影像数据自动标注医学影像数据的自动标注是指对医学影像数据进行自动标注,生成高质量、多模态、多层次的医疗影像数据。

其中,高质量指生成的图像或标注数据集要符合临床诊断要求,标注数据集应包含多种类型、多种成像方式和多种参数设置。

多模态指生成的医学影像数据应具有多种模态特征,如不同组织器官和疾病特征、不同成像方式、不同参数设置等。

多层次指生成的医学影像数据应包含高层次结构信息,如解剖层次、器官层次、组织层次等。

此外,医疗影像数据还应满足临床需求。

目前,基于深度学习技术的医学影像标注系统主要由训练集和测试集组成。

训练集用于训练模型,测试集用于验证模型,通过这种方式不断优化模型性能。

在医学影像标注中,训练集指用于训练模型的全部样本数;测试集指用于验证模型性能的所有样本数。

在实际应用中,通常将训练集设为100个样本,将测试集设为10个样本。

其中训练集和测试集的比例为1:1或1:10。

这是因为在医学影像分析中,通常只有20%的数据是标注数据,而80%的数据都是非标注数据。

2高质量、多模态、多层次医学影像数据自动生成近年来,随着人工智能技术的发展,医学影像数据生成正朝着高质量、多模态、多层次方向发展。

【深度学习】SchNet:模拟量子相互作用的连续滤波卷积神经网络2017年,来自德国柏林工业大学的K.-R. Müller机器学习研究组在Advances in NIPS上发表了题为“SchNet: Acontinuous-filter convolutional neural network for modeling quantum interactions”的研究,首次提出用于预测分子能量和原子受力的SchNet神经网络架构。

——简介——深度学习非常适合学习结构化数据的表示,因此可能彻底改变量子化学计算,并加速化学空间的探索。

尽管卷积神经网络已被证明是图像、音频和视频数据的首选,但分子中的原子并不局限于网格中,它们的精确位置包含重要的物理信息,如果离散化,这些信息就会丢失。

Schütt等人建议使用连续滤波卷积层来建模局部关联,从而避开将数据置于网格上;并且随后这些层被应用于一种新型的深度学习架构SchNet以模拟分子中的量子相互作用。

SchNet是一个总能量和原子间力的联合模型,它遵循基本的量子化学原理,且在平衡分子和分子动力学轨迹的基准上达到了最先进的性能。

最后,此项工作引入了更具挑战性的化学和结构变化的基准,为进一步的工作提供了线索。

这项工作的目标是学习遵循基本物理原理的分子表示,并准确预测分子的能量和作用在原子上的力。

主要贡献:·使用连续滤波卷积(cfconv)层作为建模不受网格约束的数据的一种手段。

·提出SchNet:一种使用了cfconv层来学习分子中任意位置原子的相互作用的神经网络。

·设计了一个新的具有挑战性的基准数据集ISO17,其中包括了化学和构象变化。

——连续滤波卷积——在深度学习中,卷积层对图像像素、视频帧或数字音频数据等离散信号进行操作。

虽然这些情况下在网格上定义滤波器就足够了,但对于非均匀间隔的输入,如分子中的原子位置,这是不可能的(见图1)。

深度学习模型在情感分析中的应用方法情感分析是一种通过自然语言处理技术和机器学习算法,对文本或者语音数据进行分析,从中提取出其中所表达的情感倾向或者情感极性的过程。

近年来,随着深度学习技术的发展,它在情感分析领域的应用越来越广泛。

深度学习模型在情感分析中的应用方法主要包括以下几个方面:1. 基于卷积神经网络(CNN)的情感分析模型:卷积神经网络是一种常用的深度学习模型,其在图像处理领域表现出色。

然而,它也可以应用于自然语言处理任务,如情感分析。

通过将文本数据转化为矩阵形式,将卷积层和池化层应用于文本数据,提取出特征信息,并将这些特征送入全连接层进行情感分类。

2. 基于长短时记忆网络(LSTM)的情感分析模型:长短时记忆网络是一种适用于序列数据处理的深度学习模型。

在情感分析中,可以将文本数据视为一个序列,通过LSTM模型来学习文本中的时序信息,并将其映射到情感类别上。

LSTM模型通过遗忘门、输入门和输出门的控制机制,能够有效地处理长期依赖的信息。

3. 基于注意力机制的情感分析模型:注意力机制在深度学习模型中起到了重要的作用。

在情感分析中,为了提取文本中重要的特征信息,可以引入注意力机制。

通过计算文本中每个单词或者每个句子的注意力权重,将其与文本的其他部分进行加权相加,从而获得更加准确的情感分类结果。

4. 结合词嵌入和深度学习模型的情感分析方法:词嵌入是一种将单词映射为连续向量表示的技术,它能够更好地捕捉单词的语义信息。

在情感分析中,可以使用预训练的词嵌入模型,将文本中的每个单词转化为固定维度的向量表示,并将其作为深度学习模型的输入。

这种结合词嵌入和深度学习模型的方法可以提高情感分析的准确性。

5. 基于迁移学习的情感分析方法:迁移学习是一种通过利用源领域的知识来改善目标领域任务性能的方法。

在情感分析中,可以使用在大规模语料库上预训练的深度学习模型,将其迁移到情感分析任务中。

通过迁移学习,可以提高情感分析模型在小规模数据集上的性能。

深度学习的原理与应用深度学习是一种模拟人脑神经网络结构进行数据处理和模式识别的人工智能技术。

它在图像识别、语音识别、自然语言处理等领域取得了巨大的成功。

本文将介绍深度学习的原理、常用的神经网络结构以及其在不同领域的应用。

1. 深度学习的原理深度学习的核心思想是模拟人脑神经网络,通过多层次的神经元组成的网络来学习和处理信息。

它可以自动从大量的数据中学习特征和规律,并进行模式识别。

2. 神经网络结构深度学习的核心是神经网络结构,下面将介绍几种常用的神经网络结构。

(1)多层感知机(Multilayer Perceptron, MLP)多层感知机是最基础的神经网络结构,由输入层、隐藏层和输出层组成。

每个神经元都与前一层的所有神经元相连,通过激活函数进行信号传递和计算。

(2)卷积神经网络(Convolutional Neural Network, CNN)卷积神经网络主要应用于图像处理领域。

它通过卷积层、池化层和全连接层来提取图像的特征。

卷积层可以有效地减少模型参数,池化层可以缩小特征图的尺寸,全连接层可以进行分类。

(3)循环神经网络(Recurrent Neural Network, RNN)循环神经网络主要应用于序列数据的处理,如语音识别和自然语言处理。

它通过循环层和隐藏层的记忆单元来处理具有时间序列性质的数据。

3. 深度学习的应用深度学习在各个领域都有广泛的应用,下面将介绍几个具体的应用案例。

(1)图像识别深度学习在图像识别领域取得了突破性的成果。

例如,通过训练卷积神经网络,可以实现对物体、人脸等图像内容的准确识别。

(2)语音识别深度学习在语音识别方面也有广泛应用。

通过训练循环神经网络,可以实现对语音信号的准确识别和转录。

(3)自然语言处理深度学习在自然语言处理方面也有很多成功的应用。

例如,通过训练神经网络,可以实现机器翻译、情感分析等任务。

4. 深度学习的挑战和发展尽管深度学习在各个领域取得了巨大成功,但仍面临一些挑战。

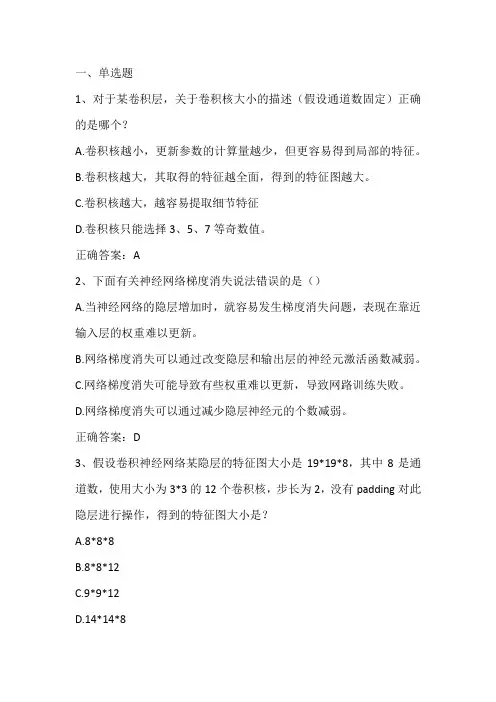

一、单选题1、对于某卷积层,关于卷积核大小的描述(假设通道数固定)正确的是哪个?A.卷积核越小,更新参数的计算量越少,但更容易得到局部的特征。

B.卷积核越大,其取得的特征越全面,得到的特征图越大。

C.卷积核越大,越容易提取细节特征D.卷积核只能选择3、5、7等奇数值。

正确答案:A2、下面有关神经网络梯度消失说法错误的是()A.当神经网络的隐层增加时,就容易发生梯度消失问题,表现在靠近输入层的权重难以更新。

B.网络梯度消失可以通过改变隐层和输出层的神经元激活函数减弱。

C.网络梯度消失可能导致有些权重难以更新,导致网路训练失败。

D.网络梯度消失可以通过减少隐层神经元的个数减弱。

正确答案:D3、假设卷积神经网络某隐层的特征图大小是19*19*8,其中8是通道数,使用大小为3*3的12个卷积核,步长为2,没有padding对此隐层进行操作,得到的特征图大小是?A.8*8*8B.8*8*12C.9*9*12D.14*14*8正确答案:C4、卷积神经网络隐层神经元的数量与下面哪些因素无关?A.输入图像大小B.卷积核大小C.步长D.激活函数正确答案:D5、以下哪个有关卷积神经网络的说法是错误的?A.输入一个300*300的彩色图,经过10个5*5的卷积核,隐层的参数量是260(含偏置)B.使用激活函数Relu的收敛速度比Sigmoid要快一些C.隐层的神经元输入输出可以看成一个相关权重和偏置的复合非线性多元函数。

D.在网络规模相同的情况下,增加网络深度比增加宽度能带来更强的网络特征获取能力正确答案:A6、以下哪个关于卷积神经网络的说法是错误的?A.卷积神经网络训练时值学习每层神经元的阈值B.AlexNet是一个8层的卷积神经网络C.目标检测网络Yolo网络结构中包含卷积层D.典型的卷积神经网络是由卷积层、池化层和全连接层等组成正确答案:A7、下列对于生成式对抗网络的叙述,哪个是错误的?A.训练可能不稳定B.可以产生清晰且真实的样本C.仅由一个生成网络与一个判别网络组成D.属于无监督学习正确答案:C8、假设卷积神经网络某卷积层的输入和输出特征图大小分别为63*63*16和33*33*64,卷积核大小是3*3,步长为2,那么Padding 值为多少?A.0B.3C.2D.1正确答案:C9、有关一般卷积神经网络的组成,下面哪种说法是正确的?A.卷积神经网络的层次结构依次是由输入层、卷积层、池化层、激活层和全连接层组成B.卷积神经网络的层次结构依次是由输入层、池化层、卷积层、激活层和全连接层组成C.卷积神经网络的层次结构依次是由输入层、卷积层、激活层、池化层和全连接层组成D.卷积神经网络的层次结构依次是由输入层、激活层、卷积层、池化层和全连接层组成正确答案:C10、有关卷积神经网络的说法哪个是正确的?A.在卷积层后面使用池化操作,可以减少网络可以训练的参数量B.1*1的卷积没有改变特征图的大小,因此没有获得新的特征C.不同卷积层或同一卷积层只能用一种大小的卷积核D.类似AlexNet网络使用的分组卷积可以增加卷积层的参数量,降低网络训练速度正确答案:A11、有关循环神经网络激活函数的说法,以下哪个是错误的?A.ReLU可以减少循环神经网络的梯度消失问题B.Sigmoid函数相对于Tanh函数来说更容易导致梯度消失C.取Tanh或Sigmoid函数作为激活函数,做梯度下降时,偏导数是一堆小数在做乘法,容易导致网络梯度消失。

深度学习技术原理及应用案例深度学习技术是人工智能领域的一个重要分支,其基于神经网络的理论和算法,可以模仿人脑的神经系统处理信息的能力,实现对大量数据的自动分类、识别、预测等任务。

本文将介绍深度学习技术的原理,并着重阐述其在图像识别、自然语言处理、游戏智能等方面的应用案例。

一、深度学习技术原理深度学习技术基于神经网络的思想,其核心是通过一系列的神经元模拟信息的传递和转化,进行数据的高效处理。

在神经网络中,输入数据被送入输入层,经过一系列的隐层,最终输出结果在输出层给出。

神经元在这个过程中扮演着重要的角色,其将输入数据通过激活函数转化为输出信号,输出信号又传递给下一层神经元进行处理。

深度学习技术的名称来源于神经网络中多层的隐层,这些隐层可以对输入数据进行多次的映射和转换,提高对数据的处理效率和准确性。

深度学习技术的训练也是基于神经网络的反向传播算法,该算法通过计算神经网络输出结果与实际结果之间的差异,并根据误差对神经元的权重进行调整,从而实现损失函数下降,模型的优化。

深度学习技术的训练需要大量的数据和计算资源,因此其较为依赖于高性能的计算设备和数据集资源。

二、深度学习技术在图像识别中的应用案例深度学习技术在图像识别领域有着广泛的应用,其中最具有代表性的案例是物体识别。

物体识别是指将图像中的物体进行分类和识别,例如将图片中的猫、狗、汽车等物体进行标识。

相对于传统的识别算法,深度学习技术在物体识别中具有更高的准确性和鲁棒性。

其中,卷积神经网络(CNN)是实现图像识别任务的最经典模型之一。

CNN通过多层卷积处理、池化操作和全连接层等进行图像特征的提取和分类。

通过卷积操作,CNN可以有效地捕捉图像中的局部特征。

同时,池化操作则可以对输入数据进行下采样,减小计算量同时提高模型的鲁棒性。

三、深度学习技术在自然语言处理中的应用案例深度学习技术在自然语言处理(NLP)领域的应用也逐渐成熟。

NLP是指对自然语言进行识别、理解、生成和应用的技术。

基于深度学习的图像处理技术研究应用近年来,随着计算机技术的不断发展,基于深度学习的图像处理技术也得到了越来越广泛的应用。

无论是在医疗、安防还是娱乐等领域,深度学习技术的应用都在不断地拓展着。

本文将会从两个方面,分别是基础技术和实际应用,来介绍当前深度学习图像处理技术的研究和应用现状。

一、基础技术1. 卷积神经网络卷积神经网络(Convolutional Neural Network,CNN)是深度学习技术中一种基于多层神经元来处理特征的算法模型。

在图像处理领域中,CNN采用以像素为基础的数据分析和组织来完成对数据的识别和分析。

2. 支持向量机支持向量机(Support Vector Machine,SVM)是一种常用的监督学习算法模型。

在图像处理领域中,SVM主要用于数据分类。

通过构建分隔超平面,SVM可以对输入图像进行分类,从而实现对数据的处理和分析。

3. 生成式对抗网络生成式对抗网络(Generative Adversarial Network,GAN)是一种可以用于生成合成图像的深度学习技术。

GAN主要由两个互相对抗的神经网络组成,一个负责生成图像,另一个则负责判别哪些是真实图像,哪些是生成的图像。

二、实际应用1. 人脸识别人脸识别是现代图像处理技术中的一项重要挑战,其应用范围广泛。

近年来,基于深度学习技术的人脸识别技术得到了快速发展。

例如,FaceNet就是一种基于卷积神经网络的人脸识别技术,它可以在进行人脸识别的时候,准确性能够极大地提高。

2. 自然图像处理另一个深度学习技术的应用例子是在自然图像处理(Image Processing)中。

通过采用基于CNN的技术,可以对自然图像的特征进行分析和处理,从而得到更加精确的处理结果。

例如,基于CNN的图像超分辨率技术,可以使得在低分辨率下拍摄的图像能够得到更加精确的处理和增强。

3. 视频分析与处理视频分析和处理是一种通过对图像序列进行处理和分析来实现的技术。

深度学习技术在图像识别中的应用随着科技的不断发展,人工智能技术的应用正越来越广泛。

其中,深度学习技术作为一种基于人工神经网络的机器学习方法,广泛应用于图像识别领域,如人脸识别、图像分类、目标检测以及图像自动生成等方面。

本文将探讨深度学习技术在图像识别中的应用,包括其在实际应用中的优势和挑战。

1.深度学习技术简介深度学习技术是一种基于神经网络的机器学习方法,其主要通过多层神经元计算来实现对数据的自主分类和识别。

这种方法的主要特点是能够针对海量数据进行有效处理,提高数据处理的准确性和效率。

目前,深度学习技术在图像分类、目标检测、人脸识别等领域的应用已经得到广泛关注。

2.深度学习在图像分类中的应用图像分类是指对图像进行标注,根据不同的特征将图像分为不同的类别。

在图像分类中,深度学习技术通常采用卷积神经网络(Convolutional Neural Networks, CNN)进行图像特征的提取和学习。

通常,卷积神经网络由若干个卷积层、池化层和全连接层组成。

通过卷积层对图像进行特征提取,通过池化层对特征进行压缩,最终通过全连接层进行分类。

这种方法可以有效地减少参数量,提高计算效率和准确性。

目前,CNN已被广泛应用于各种图像识别任务,如物体识别、图像分类、手写数字识别等。

3.深度学习在目标检测中的应用目标检测是指在图像中自动搜索并标记出感兴趣的目标。

与图像分类不同的是,目标检测还需要识别出目标所在的位置。

在目标检测中,深度学习技术通常采用区域卷积神经网络(Regional Convolutional Neural Networks, R-CNN)和快速区域卷积神经网络(Fast R-CNN)等方法进行处理。

R-CNN方法先利用Selective Search等方法来产生候选框,然后在每个候选框中提取特征,最后通过已训练好的分类器进行目标识别。

Fast R-CNN则是在R-CNN的基础上进行了优化,将特征提取和分类器训练合并为一个过程进行,从而提高了检测速度。

深度学习模型的常见结构深度学习已经在各个领域展现出了巨大的潜力,并且成为了人工智能领域的热门话题。

在深度学习中,模型的结构是至关重要的,它决定了模型的性能和效果。

本文将介绍深度学习模型中常见的结构,包括卷积神经网络(CNN)、循环神经网络(RNN)和生成对抗网络(GAN)。

一、卷积神经网络(CNN)卷积神经网络是一种特殊的神经网络结构,广泛应用于图像识别和计算机视觉任务中。

它模拟了人类对视觉信息的处理方式,通过卷积层、池化层和全连接层构成。

其中,卷积层负责提取图像的特征,池化层用于降采样和减小计算量,全连接层则将提取的特征进行分类。

二、循环神经网络(RNN)循环神经网络是一种适用于序列数据处理的模型,广泛应用于自然语言处理和语音识别等领域。

与传统的前馈神经网络不同,RNN 具有循环连接的结构,使其能够捕捉到序列数据中的上下文信息。

RNN 中的隐藏状态可以储存前面时间步的信息,并传递到后面的时间步中,以此实现对序列数据的有效建模。

三、生成对抗网络(GAN)生成对抗网络是一种包含生成器和判别器的模型结构,用于生成逼真的合成数据。

生成器负责生成伪造数据,而判别器则负责判断生成的数据和真实数据的区别。

GAN 通过两个网络相互对抗的方式进行训练,逐渐提高生成器生成真实数据的能力。

四、注意力机制(Attention)注意力机制是一种用于强化模型重点关注区域的结构。

它在自然语言处理和计算机视觉任务中被广泛应用。

通过引入注意力机制,模型能够更加准确地聚焦于输入数据中的关键信息,从而提高模型的性能。

五、残差连接(Residual Connection)残差连接是一种用于解决深度神经网络中梯度消失和梯度爆炸的问题的结构。

在残差连接中,模型的前向传播不仅仅包括正常的组件,还包括一个跳跃连接,将前一层的输出直接与当前层的输入相加。

通过这种方式,残差连接可以使信息更好地从一个层传递到另一个层,加快训练速度并提高模型性能。

什么是深度学习?深度学习是如何应用的?深度学习是一类人工智能的算法,它基于深层神经网络,通过多层网络结构来模拟人类大脑的处理机制,来完成复杂的计算任务。

深度学习算法通过对大量数据进行训练,来学习模型权重,从而实现高效的学习和预测。

深度学习主要应用在计算机视觉、自然语言处理、语音识别、自动驾驶等领域。

在计算机视觉中,深度学习算法可以用来识别图像中的物体,识别手写字符等。

在自然语言处理中,深度学习算法可以用来处理自然语言文本,实现机器翻译等功能。

在语音识别中,深度学习算法可以用来识别语音输入,并转化为文本输出。

这些算法可以学习语音的特征,并识别语音中的单词和句子,从而实现语音转文本的功能。

这类语音识别算法通常基于深度神经网络构建,如音频-语音识别深度神经网络(ASR-DNN),这些算法能够在训练大量语音数据后识别语音输入,并转化为文本输出。

目前,深度学习技术在语音识别领域有着广泛应用,已经成为了语音识别领域的主流技术。

深度学习算法主要有三类,分别是卷积神经网络(Convolutional Neural Networks, CNNs)、循环神经网络(Recurrent Neural Networks, RNNs)和生成对抗网络(Generative Adversarial Networks, GANs)。

卷积神经网络是一类用于处理图像和视频数据的算法,它可以学习图像中的特征并识别图像中的物体。

循环神经网络用于处理序列数据,如语音和文本,它可以学习序列中的关系并生成新的序列。

生成对抗网络用于生成图像、音频、文本等数据,它可以通过学习数据的特征来生成新的数据。

深度学习算法的应用也在不断拓展,在许多新的领域都有可能有新的应用,如虚拟现实、机器人等.。

深度学习知识:卷积神经网络与循环神经网络的比较深度学习(Deep Learning)是一种机器学习的方法,它旨在通过彼此之间有关的多层神经网络相互作用来解决复杂的模式识别问题。

在深度学习领域中,卷积神经网络(Convolutional Neural Network,CNN)和循环神经网络(Recurrent Neural Network,RNN)是两种最常用的神经网络架构。

它们分别适用于不同类型的任务,且各有优劣。

本文将对卷积神经网络和循环神经网络进行较为全面的比较。

我们将首先分别介绍这两种网络的基本原理和结构,然后从不同的角度对它们进行比较,包括适用领域、处理长期依赖性、参数共享、计算效率等方面。

1.卷积神经网络卷积神经网络是一种专门用于处理图像、语音识别、自然语言处理等高维数据的神经网络。

其核心思想是局部感知(local perception)和参数共享(parameter sharing)。

卷积层通过滤波器(filter)来提取数据的特征,池化层(pooling layer)通过降采样(down-sampling)来减少数据维度,全连接层(fully connected layer)则用于输出分类结果。

1.1卷积层:卷积层通过一系列的滤波器对输入数据进行卷积运算,从而提取数据的空间信息。

卷积运算的优势在于参数共享,使得网络对于输入的平移、旋转、尺度变化具有一定的不变性。

1.2池化层:池化层用于减少数据维度,提高模型的鲁棒性。

常用的池化操作包括最大池化(max pooling)、平均池化(average pooling)等。

1.3全连接层:全连接层将卷积层和池化层提取的特征映射到具体的分类结果上。

2.循环神经网络循环神经网络是一种适用于处理序列数据的神经网络结构。

其核心特点是具有循环连接(recurrent connection),能够在网络内部建立记忆,从而处理不定长的输入序列。

为了解决长期依赖性(long-term dependency)的问题,循环神经网络引入了门控机制,其中最典型的模型是长短期记忆网络(Long Short-Term Memory,LSTM)和门控循环单元(Gated Recurrent Unit,GRU)。

卷积神经网络在模式识别中的应用概述摘要:卷积神经网络(convolutional neural network,CNN)强大的建模和表征能力很好地解决了特征表达能力不足和维数灾难等模式识别方面的关键问题,受到学者们的广泛关注。

因此,本文首先介绍了卷积神经网络的发展历程及其理论模型,然后重点对卷积神经网络在文字语音识别、图像识别和人脸表情识别等中的应用作了总结。

最后对卷积神经网络未来在模式识别领域的发展潜力和应用前景进行了展望。

关键词:卷积神经网络;模式识别;文字语音识别;图像识别;人脸表情识别1引言模式识别(Pattern Recognition)是人类的一项基本智能,在日常生活中,人们经常在进行“模式识别”。

随着20世纪40年代计算机的出现以及50年代人工智能的兴起,人们当然也希望能用计算机来代替或扩展人类的部分脑力劳动。

(计算机)模式识别在20世纪60年代初迅速发展并成为一门新学科,是指对表征事物或现象的各种形式的(数值的、文字的和逻辑关系的)信息进行处理和分析,以对事物或现象进行描述、辨认、分类和解释的过程,是信息科学和人工智能的重要组成部分。

模式识别又常称作模式分类,从处理问题的性质和解决问题的方法等角度,模式识别分为有监督的分类(Supervised Classification)和无监督的分类(Unsupervised Classification)两种。

模式还可分成抽象的和具体的两种形式[1]。

前者如意识、思想、议论等,属于概念识别研究的范畴,是人工智能的另一研究分支。

我们所指的模式识别主要是对语音波形、地震波、心电图、脑电图、图片、照片、文字、符号、生物的传感器等对象进行测量的具体模式进行分类和辨识。

模式识别方法主要可分为四种,分别为:模板匹配法、统计模式识别法、语法模式识别法以及神经网络。

其中模板匹配法是出现较早的一种方法,实现起来较简单,匹配是个通用的操作,用于定义两个实体间的相似性程度,一般是采用二维模板,匹配的要素一般采用像素、曲线及形状信息,当然在定义模板及相似性函数时要考虑到实体的姿态及比例问题,这种方法一般不需要训练,实际上模板就是由训练集建立起来的,它的缺点是适应性差。

深度学习在信号处理中的应用教程深度学习作为一种机器学习技术,已经在多个领域展现出了强大的应用能力。

其中,信号处理领域也不例外。

本文将介绍深度学习在信号处理中的应用,包括语音信号处理、图像信号处理和时序信号处理等方面。

一、语音信号处理语音信号处理是深度学习中一个重要的应用方向。

传统的语音信号处理中,通常使用基于特征提取的方法,如MFCC(Mel-Frequency Cepstral Coefficients)等。

然而,这些方法需要手动选择特征,并且对于复杂的语音信号很难提取到有效的特征。

深度学习在语音信号处理中的应用主要有两个方面:语音识别和语音合成。

语音识别是将语音信号转化成文字的过程,而语音合成则是将文字转化成语音信号的过程。

深度学习可以通过构建适合语音信号的神经网络模型,实现更加准确的语音识别和语音合成。

二、图像信号处理深度学习在图像信号处理中的应用也非常广泛。

图像信号处理主要包括图像分类、目标检测、图像分割等任务。

传统的图像信号处理方法通常通过手工设计特征,并使用一些机器学习算法进行分类或者检测。

然而,这些方法需要大量的人力和时间,且很难达到较高的准确率。

深度学习可以通过卷积神经网络(Convolutional Neural Network,CNN)来自动学习图像的特征。

通过深度卷积层和池化层等结构,网络能够从原始图像中提取出高层次的特征,并通过全连接层进行分类或者检测任务。

深度学习在图像信号处理中的应用已经取得了很多重要的突破,如物体识别、人脸识别、图像分割等。

三、时序信号处理时序信号处理是指对于一系列按时间顺序排列的信号进行处理和分析的过程。

深度学习在时序信号处理中的应用非常广泛,如时间序列预测、信号分类、异常检测等。

对于时间序列预测任务,可以使用循环神经网络(Recurrent Neural Network,RNN)来处理。

RNN具有记忆功能,能够处理具有时序关系的数据,并且可以对未来的数据进行预测。

深度学习神经网络原理与应用分析深度学习神经网络是当今最热门的领域之一,其在人工智能、计算机视觉、语音识别和自然语言处理等方面都有广泛的应用。

深度学习的基础是神经网络,本文将对深度学习神经网络的原理与应用进行分析。

一、神经网络的基本结构与原理神经网络是由多个神经元组合而成的网络结构,每个神经元都具有多个输入和一个输出。

神经元接收到多个输入,并将这些输入送入激活函数中进行处理,最终输出一个结果。

多个神经元组成的网络就可以实现更加复杂的功能。

神经网络通常由输入层、中间层和输出层组成。

输入层是神经网络的接口,将外部信息输入到神经网络中;中间层是神经网络的核心,通过多个中间层的组合,可以实现非常复杂的功能;输出层是神经网络的输出接口,将神经网络的输出结果输出到外部。

神经网络的训练过程通常采用反向传播算法,该算法是求解网络的最优权值的一种方法。

在训练过程中,首先对神经网络进行正向传播,得到神经网络的输出结果;然后,将输出结果与期望输出结果进行比较,计算误差;最后,将误差通过反向传播算法传回网络,调整神经元之间的权值,使得误差最小化。

二、深度学习神经网络的应用1.计算机视觉深度学习在计算机视觉领域有着广泛的应用,如图像分类、目标识别和人脸识别等。

目前,卷积神经网络(CNN)已成为计算机视觉领域最常用的深度学习模型。

CNN的特点是可以自动提取图像的特征,并可以逐层提取信息,逐渐深入到图像的各个层次。

通过CNN,可以实现图像分类、目标检测、图像分割等多种计算机视觉任务。

2.语音识别深度学习在语音识别领域的应用也非常广泛。

传统的语音识别方法通常是通过Gaussian混合模型(GMM)和隐马尔可夫模型(HMM)来实现的。

然而,这些方法需要手动提取语音的特征,容易受到噪声和变化的影响。

深度学习神经网络可以自动提取语音的特征,并且对于噪声和变化具有很好的鲁棒性。

目前,深度学习神经网络已经成为语音识别领域最常用的模型之一。

了解深度学习中的卷积神经网络的优化方法一、卷积神经网络简介深度学习中的卷积神经网络(Convolutional Neural Network, CNN)是一种常用于图像分析与处理的人工神经网络模型。

它采用了一种称为卷积的特殊运算方式,将输入数据通过多个卷积层和池化层进行逐步抽象和压缩,最后通过全连接层实现特征识别和分类。

然而,随着网络参数数量的增加,CNN模型对于训练数据的拟合能力增强,但同时也带来了过拟合等问题。

为了解决这些问题,研究者们开发了各种优化方法。

二、梯度下降法1. 梯度下降法原理梯度下降法(Gradient Descent)是深度学习中最常用的优化方法之一。

其基本思想是通过迭代更新参数值以减小目标函数(损失函数)的值。

具体而言,在每次迭代中,根据目标函数对每个参数的偏导数(梯度),沿着梯度方向更新参数值,并重复该过程直至达到收敛条件。

2. 随机梯度下降法随机梯度下降法(Stochastic Gradient Descent, SGD)是梯度下降法的改进版本,通过随机选择部分样本进行参数更新,避免了使用全部训练数据的计算开销,提高了训练速度。

然而,SGD也存在参数更新不稳定性和收敛速度慢等问题。

三、卷积神经网络的优化方法1. 动量法动量法(Momentum)是一种加速随机梯度下降法的优化方法。

它引入了一个动量项,用于惯性更新参数值,并使得收敛过程更加平稳。

具体而言,在每次迭代中,动量法将当前梯度与上一次更新的方向相结合,计算出新的移动方向和步幅,并更新参数值。

2. 学习率衰减学习率衰减(Learning Rate Decay)是一种控制学习率逐渐减小的优化方法。

在训练初始阶段使用较大的学习率可以使模型快速收敛,而在后期采用小学习率可以增强模型的泛化能力和稳定性。

3. 批标准化批标准化(Batch Normalization)是一种通过规范化输入数据分布来加速模型收敛的方法。

它在每个卷积层或全连接层之前,对输入数据进行均值和方差的归一化,使得模型对参数初始值和学习率变化不敏感,并减轻了梯度消失和爆炸等问题。

手写数字识别实验报告 实验目的 利用python和深度学习框架搭建手写数字识别的神经网络,并进行相关的仿真实验,尽可能的提高识别的准确度。

实验环境 python3.6、Pytorch1.4.0、torchvision、MNIST数据库。 环境介绍 Python Python是一个高层次的结合了解释性、编译性、互动性和面向对象的脚本语言。Python的设计具有很强的可读性,相比其他语言经常使用英文关键字,其他语言的一些标点符号,它具有比其他语言更有特色语法结构。Python具有简单易学、明确优雅、开发速度快等特点,在人工智能、数据分析、云计算、网络爬虫等方面有着广泛的应用。 Pytorch Pytorch是torch的python版本,是由Facebook开源的神经网络框架,专门针对 GPU 加速的深度神经网络(DNN)编程。Torch是一个经典的对多维矩阵数据进行操作的张量(tensor)库,在机器学习和其他数学密集型应用有广泛应用。与TensorFlow的静态计算图不同,Pytorch的计算图是动态的,可以根据计算需要实时改变计算图。Pytorch的设计追求最少的封装,尽量避免重复造轮子。Pytorch的源码只有TensorFlow的十分之一左右,更少的抽象、更直观的设计使得Pytorch的源码十分易于阅读。同时Pytorch的灵活性不以速度为代价,在许多评测中,Pytorch的速度表现胜过TensorFlow和Keras等框架。Pytorch提供了完整的文档,循序渐进的指南。 MNIST数据库 MNIST是一个入门级的计算机视觉数据集,它包括6万张28x28的训练样本,1万张测试样本,可以说是CV里的“Hello Word”。它也包含每一张图片对应的标签,告诉我们这个是数字几。比如,图1的标签分别是5,0,4,1。 图1 MNIST图像图片 MNIST的每一张图片包含28×28个像素点。我们可以用一个数组来表示这张图片。如图2所示。

图2 MNIST的数组表示 我们把这个数组展开成一个向量,长度是28× 287884。如何展开这个数组(数字间的顺序)不重要,只要保持各个图片采用相同的方式展开。从这个角度来看,MNIST数据集的图片就是在884维向量空间里面的点。

实验内容 实验方案 拟采用RNN网络的变体LSTM、以及全连接层来实现对手写体数字的识别。使用MNIST数据集的训练集对搭建的网络进行训练,损失函数则采用交叉熵函数,采用Adam优化算法对权值进行更新。完成之后使用MNIST数据集的测试集进行测试,查看正确率。 实验准备 数据准备 我们直接使用torchvision中自带的datasets,并使用Pytorch中的DataLoader 函数对训练数据和测试数据分别进行读取。代码如图3所示。 图3 数据准备代码 当然,如果下载过数据集,可以将datasets.MNIST的download参数设置为False即可。 网络构建 接下来对网络进行定义,只要在继承nn.Module的基础上,对相关网络进行构建即可。网络的构建代码如图4所示。其中def __init__()函数,定义了网络的初始化。def forward()函数,则定义了前向传播,后向传播则不需要用户进一步的定义。这也是选择Pytorch作为深度学习框架的原因。

图4 网络构建代码 图中涉及到两个函数,其中一个为torch.nn.LSTM(*args, **kwargs)。函数的各个参数以及意义如表一所示。

表一 函数参数及意义 参数 意义 input_size 输入序列中每一个组成成员的数据大小 hidden_size LSTM输出的隐藏层的数据大小 num_layers LSTM的叠加层数 bias 是否偏置 batch_first 设为True,则输入输出格式发生改变,batch_size提前 dropout 叠加LSTM时,除了最后一层,其他层的输出进行dropout操作 bidirectional 是否是双向LSTM

函数的输入参数为:input,h_0,c_0。输出参数为output,h_n,c_n。 其中input的格式为(seq_len, batch, input_size),h_0和c_0的格式为(num_layers * num_directions, batch, hidden_size),其中num_directions的值和bidirectional有关。output的格式为(seq_len, batch, num_directions * hidden_size),代表着h_t,h_ n和c_n的格式为(num_layers * num_directions, batch, hidden_size)。 另一个函数为nn.Linear(in_features, out_features, bias7True),Pytorch的nn.Linear()是用于设置网络中的全连接层的,需要注意的是全连接层的输入与输出都是二维张量,一般形状为[batch_size, size],不同于卷积层要求输入输出是四维张量。in_features指的是输入的二维张量的大小,即输入的[batch_size, size]中的size。out_features指的是输出的二维张量的大小,即输出的二维张量的形状为[batch_size,output_size],当然,它也代表了该全连接层的神经元个数。从输入输出的张量的shape角度来理解,相当于一个输入为[batch_size, in_features]的张量变换成了[batch_size, out_features]的输出张量。 损失函数、优化 网络的反向传播主要取决于损失函数以及网络的优化策略,损失函数使用的是交叉熵函数,而优化策略则使用的是Adam优化算法。交叉熵损失函数如式1-1所示。 𝐿=−[𝑦𝑙𝑜𝑔𝑦̂+(1−𝑦)𝑙𝑜𝑔(1−𝑦̂)] (1-1) Adam优化算法的步骤基本如下: (1)计算目标函数关于当前参数的梯度,可以记为𝑔𝑡。 (2)根据历史的梯度计算一阶动量和二阶动量,分别记为𝑚𝑡、𝑉𝑡。 其中,一阶动量即为,每个时刻梯度方向的指数移动平均值。二阶动量即为,迄今为止所有梯度值的平方和。而在Adam优化算法中有: 𝑚𝑡=𝛽1∗𝑚𝑡−1+(1−𝛽1)∗𝑔𝑡

𝑉𝑡=𝛽2∗𝑉𝑡−1+(1−𝛽2)∗𝑔𝑡2

(3)计算当前时刻的下降梯度,记为𝛿𝑡。计算公式为:𝛿𝑡=𝛼∗𝑚𝑡/√𝑉𝑡 (4)根据下降梯度对梯度进行更新。𝜔𝑡+1=𝜔𝑡−𝛿𝑡 以上操作的代码实现如图5所示。

图5 损失函数、优化器代码 其中,torch.nn.CrossEntropyLoss()函数的参数,和参数意义如表二所示。 表二 函数参数与参数意义 参数 意义 weight 输入为C的张量,表示权重 ignore_index 指定一个目标值,该目标值将被忽略 reduction 'mean'和'none'和'sum'三种模式

实验过程 在准备好相关数据之后,实例化网络,并进行训练,设置epoch为20,即使用训练集训练网络20次,batch的大小为100,学习率为1e-3,每训练完一次网络之后,使用网络对测试集进行测试,确定网络的分类能力情况。具体代码如下所示。 model 7 Rnn(28, 128, 2, 10) # 图片大小是28x28 model 7 model.cuda() criterion 7 nn.CrossEntropyLoss() optimizer 7 optim.Adam(model.parameters(), lr7learning_rate) # 开始训练 for epoch in range(num_epoches): model.train() print('-' * 15, 'Epoch %d' % (epoch+1), '-' * 15) running_loss 7 0.0 running_acc 7 0.0 for i, (img, label) in enumerate(train_loader): b, c, h, w 7 img.size() assert c 77 1, 'channel must be 1' img 7 img.squeeze(1).cuda() label 7 label.cuda()

# 向前传播 out 7 model(img) loss 7 criterion(out, label) running_loss +7 loss.item() * label.size(0) _, pred 7 torch.max(out, 1) num_correct 7 (pred 77 label).sum() running_acc +7 num_correct.item()

# 向后传播 optimizer.zero_grad() loss.backward() optimizer.step()

if (i+1) % 300 77 0: print('[{}/{}] Loss: {:.6f}, Acc: {:.6f}'.format( epoch + 1, num_epoches, running_loss / (batch_size * i), running_acc / (batch_size * i))) print('Finish {} epoch, Loss: {:.6f}, Acc: {:.6f}'.format(