基于感知哈希的视频去重

- 格式:pdf

- 大小:945.75 KB

- 文档页数:11

9个视频去重方法

一、掐头去尾

用剪映等软件,剪掉视频的开头和结尾的1-2秒

二、镜像反转+变速

将视频进行镜像反转,对视频进行加速或降速处理

三、画面放大或缩小

将视频画面比例进行放大或缩小

四、抽桢并删除

在不影响视频内容连贯性的情况下,把视频多余部分剪掉并删除

五、视频添加转场

画面与画面之间剪开,在其中间加入转场特效

六、给视频添加滤镜

选择舒服的滤镜特效,并调节滤镜程度

七、给视频添加画中画

选中「解说画面」,点击「添加画中画」,加入视频,视频最好为自己原创拍摄

八、添加字幕

可以用「识别字幕」功能直接通过AI获取视频文字,就不用自己一句一句打字了

九、给视频添加音乐

音乐在抖音,对于氛围感很重要,一定要选择合适的音乐呀。

视频哈希算法的设计与实现随着互联网技术的发展和普及,人们的生活方式也随之发生了很大的变化。

在现如今的数字化时代,视频成为了人们随时随地学习、娱乐、交流的重要手段之一。

然而,随之而来的是海量的视频数据需要储存、管理和处理。

这时引入哈希算法成为一个有利的工具,能够对视频数据进行高效的处理与管理。

这里将介绍视频哈希算法的设计与实现。

1.哈希算法简介哈希算法是一类将数据压缩成指定位数摘要信息的算法,它的应用十分广泛,如常见的md5、sha1等就是哈希算法的代表。

哈希函数将任意长度的消息映射为固定长度的消息摘要,这个摘要通常是一个较小的固定大小的字符串,也就是哈希值。

哈希函数的设计应尽量满足两个条件:首先,哈希值的计算无法逆推出原数据,其次任何一点微小的数据变化都会使哈希值发生不可忽略的变化。

2.视频哈希算法的作用视频哈希算法的作用是对视频数据进行快速度查找、去重、识别等。

对于大规模的视频数据,如何进行去重是一个十分重要的问题。

这时可以通过将视频进行哈希值的计算,将哈希值作为查找索引进行去重。

通过视频哈希,可以极大地提高去重的效率。

此外,在视频资源使用中,哈希算法可以对视频进行识别,找出相似视频。

3.视频哈希算法的流程视频哈希算法的流程通常包括以下几个步骤:(1)将视频分解为连续的图像帧序列(2)通过图像的特征提取算法,计算得到每张图像的哈希值(如graycode哈希)(3)将图像哈希值序列组成一个哈希特征序列(4)通过哈希特征序列进行查重、相似性识别等操作4.视频哈希算法的实现在实现视频哈希算法的过程中,通常要先对视频进行格式转换,使其能够被Python等编程语言所识别。

其次,我们需要用到一些第三方库,如Python中的OpenCV库等,来完成图像特征的计算。

在完成图像特征的计算后,我们便可以进行哈希特征的提取和组成了。

最后我们可以选择不同的算法,来进行相似度的计算和哈希值的查找。

例如,可以选择cosine similarity算法、hamming distance算法等。

数据处理中的数据去重方法数据去重是数据处理的一个重要步骤,它用于剔除重复的数据,保证数据的准确性和完整性。

在现如今数据爆炸的时代,如何高效地去重成为了一个亟待解决的问题。

本文将介绍几种常见的数据去重方法,帮助读者更好地进行数据处理。

一、基于哈希算法的去重方法哈希算法是一种非常高效的数据去重方法。

它通过将数据映射成唯一的哈希值,利用哈希值来进行去重操作。

具体步骤如下:1. 首先,将待处理的数据集拆分成小块,每个小块包含若干条数据。

2. 对每个小块中的数据使用哈希函数进行计算,得到其对应的哈希值。

3. 将哈希值存储在一个哈希表中,如果表中已经存在该哈希值,则表明该数据已经存在,可以将其剔除。

哈希算法的优点是对大规模数据处理效率高,但是由于哈希冲突的存在,可能会出现误判的情况。

二、基于排序算法的去重方法排序算法是另一种常见的数据去重方法。

它通过对数据进行排序,将相邻的相同数据进行合并,达到去重的目的。

具体步骤如下:1. 将待处理的数据集进行排序,可以使用快速排序或归并排序等算法。

2. 遍历排序后的数据集,将相邻的相同数据合并成一条,其余数据保留。

排序算法需要占用较多的计算资源和时间,对于大规模数据处理可能会存在一定的困难。

三、基于集合操作的去重方法集合操作是数据处理中一种常用的去重方法。

它利用集合的性质,将重复出现的数据剔除,保留唯一的数据。

具体步骤如下:1. 将待处理的数据集转化为集合。

2. 遍历集合,将其中的重复数据剔除。

3. 将去重后的集合转化为列表或其他形式的数据存储。

基于集合操作的去重方法简单、高效,适用于中小规模的数据处理。

四、基于高级算法的去重方法除了上述常见的去重方法外,还有一些基于高级算法的去重方法值得一提。

例如布隆过滤器算法、最小哈希算法等。

这些算法使用了更复杂的数据结构和计算模型,可以处理规模更大的数据集。

布隆过滤器算法通过使用多个哈希函数和位数组来判断数据是否存在,适用于海量数据的去重操作。

基于智能算法的数据去重技术研究数据去重是数据处理领域中非常重要的一项技术,它可以帮助我们去除重复的数据,减少数据存储的空间和计算资源的消耗。

在大数据时代,数据量的增长速度越来越快,因此数据去重技术变得愈发重要。

传统的数据去重方法主要基于哈希算法,但随着人工智能和机器学习技术的发展,越来越多的基于智能算法的数据去重技术被提出。

智能算法,如神经网络、遗传算法、模拟退火等,可以应用于数据挖掘、分类、聚类等领域。

它的主要特点是自适应、非线性和高度并行,能够发现数据中的隐藏规律和特征。

因此,利用智能算法去重处理重复数据,具有更高的准确度和更好的效率,同时还可以自适应地调整去重算法的参数,适应数据量的不断增长。

其中,基于神经网络的去重方法是比较常见的,它主要通过识别重复数据之间的相似度,将相似的数据归为一类。

这种方法需要预先训练神经网络模型,得出模型的参数,然后通过测试数据进行验证,进行数据去重处理。

与此同时,该算法还可以对数据的相似度进行分级处理,若相似度高的数据被分到同一类中,那么它们在进行去重处理时的效果更好。

另外一种基于智能算法的数据去重方法是遗传算法,它能够对较大规模的数据进行去重。

遗传算法通过主观判断分三类数据,即:重复数据、未重复数据、需进一步检测的数据。

然后利用交叉、变异等遗传算法进行迭代处理,直到找到最优解。

由于遗传算法可以自适应、高度并行处理数据,可以在较短时间内进行大规模数据的去重,因此被广泛应用于互联网公司、金融公司等行业。

总体来看,基于智能算法的数据去重技术,尤其是神经网络和遗传算法,可以有效减少数据存储的空间和计算资源的消耗,同时还可提高数据的去重准确度。

但这种方法也存在一定问题,例如当数据量非常庞大时,去重处理需要耗费大量时间和计算资源,因此需要更加高效、优化的算法来应对这种情况。

因此,目前的研究重点是探索更加完善、高效的算法,例如增强学习、深度学习等,以应对大规模数据的处理。

video duplicate finder原理视频重复查找是一种应用程序,用于检测计算机系统中的重复视频文件。

这种技术主要用于媒体管理、版权保护、数据整理和存储优化等领域。

视频重复查找的原理通常基于视频特征提取和相似度比较算法。

首先,视频重复查找需要从视频文件中提取特征。

视频特征是用来描述视频内容的数字表示,旨在捕捉视频中的关键信息。

常用的视频特征提取方法包括直方图、颜色矩、边缘特征、纹理特征、形状特征等。

通过这些特征,可以将视频转换成数字表达形式,便于后续的相似度比较。

接下来,视频重复查找使用相似度比较算法来计算不同视频之间的相似度。

常见的相似度比较算法包括余弦相似度、欧氏距离、汉明距离等。

这些算法通过比较视频特征之间的差异,来判断两个视频之间的相似程度。

一般来说,相似度越高,则两个视频越相似。

在实际应用中,视频重复查找通常采用哈希索引和高效算法来提高查找速度。

哈希索引是一种数据结构,能够将大量数据按照一定规则进行分组,以加快查找效率。

视频重复查找中,哈希索引通常用于存储视频特征的哈希值,通过哈希值的快速比较,可以筛选出具有潜在重复关系的视频。

此外,视频重复查找还需要面对一些挑战和限制。

首先,视频文件往往具有大量的数据和复杂的格式,需要高效的算法和计算能力来处理。

其次,视频内容的变化、裁剪、缩放、旋转等操作会导致视频特征的变化,增加了查找的难度。

另外,大规模视频库管理、视频版权保护等问题也是需要考虑的因素。

总结起来,视频重复查找通过提取视频特征和进行相似度比较,可以有效地检测和管理计算机系统中的重复视频文件。

这项技术在现代媒体管理和版权保护中起着重要作用,为用户提供了更加高效和便捷的视频资源管理方式。

随着计算机技术的不断发展,视频重复查找算法和应用将会越来越完善,为用户提供更好的使用体验。

哈希表在数据去重中的应用在数据处理过程中,数据去重是一项常见而重要的任务。

当我们处理大量数据时,可能会遇到数据中存在重复项的情况,这会导致数据的冗余和不必要的计算消耗。

为了解决这个问题,哈希表被广泛应用于数据去重的场景中。

哈希表是一种基于哈希函数实现的数据结构,它将每个数据元素映射到一个唯一的索引值。

通过将数据元素与其索引值一一对应,哈希表可以快速地判断数据是否已存在。

因此,在进行数据去重时,我们可以借助哈希表来高效地处理数据。

首先,我们需要创建一个空的哈希表。

接下来,我们逐一遍历待处理的数据集合。

以每个数据元素作为输入,通过哈希函数计算得到对应的索引值。

然后,我们检查该索引值在哈希表中是否已经存在。

如果该索引值在哈希表中不存在,我们将该索引值添加到哈希表中,并将该数据元素加入到去重后的数据集合中。

这样,我们可以通过不断地更新哈希表和去重后的数据集合,来实现数据去重的目标。

另一方面,如果该索引值在哈希表中已经存在,说明该数据元素已经出现过,可以将其视为重复数据,并进行相应的处理。

例如,我们可以忽略该数据元素,或者记录下重复的数据信息以供后续分析。

哈希表在数据去重中的应用不仅可以提高去重的效率,而且可以减少不必要的计算和存储开销。

由于哈希表的特性,其查找操作的时间复杂度为常数级别,即O(1)。

这使得我们可以快速地判断数据是否已存在,实现高效的去重功能。

此外,哈希表还可以适应不同规模的数据集合。

无论是处理小规模数据还是大规模数据,哈希表都能够保持较高的查找效率。

这使得哈希表在实际应用中广泛被使用,例如数据库去重、日志分析、网页爬取等领域。

总结而言,哈希表在数据去重中扮演着重要的角色。

通过利用其快速查找的特性,我们可以高效地判断数据是否已存在,并将不重复的数据整理出来。

这不仅提高了数据的质量和可用性,还加快了数据处理的速度。

因此,在面对需要处理大量数据的情况下,我们可以考虑使用哈希表来进行数据去重操作。

去重流程

素材准备

类似的点状网格图片。

动态干扰视频。

视频扫光

流程

1.

把准备的素材添加到轨道里,混合模式统一调为柔光,不透明度改为10%以内看具体效果调节

2.

将短剧素材添加到最底层轨道 镜像,画面裁剪,变速,平均每分钟减少六秒左右,识别字幕。

复制短剧素材添加至上一层轨道放大10%左右混合模式调为柔光,不透明度5-10%,轨道静音(放大虚化重影)。

再次复制底层素材到重影素材上层 右上方功能栏 画面 — 蒙版 选择矩形 裁剪大小至挡住素材原字幕,左上方功能栏选择 特效 搜索 模糊 拖拽至蒙版轨道上 轨道静音。

将识别的字幕拖到蒙版遮挡处 更改字体 更改字体颜色,调整合适大小。

3.

音频,添加两首音乐到下方不同轨道上调整音量至-30左右

也可以将主轨道素材视频进行人声分离,然后选择素材短剧视频同风格的音乐添加 注意音量调节。

现在短视频内卷严重,平台的审核越来越严格,“重复度过高,推荐受影响”应该是做视频的人遇到过的最多的问题了。

很多人说如今只能原创了,先不说大家是否都有这个精力,为什么别人就能顺利的搬运呢?这里还是存在技术因素的。

没有原创、也不愿意真人出境,只是单纯地想通过下载网络上的素材剪辑成自己的作品,那就一定要重视去重这个步骤。

去重做得越彻底,原创度越高,视频就不会被检测出重复度过高。

首先说明一点,短视频搬运去重,不是改个MD5,加个滤镜就可以的,现在平台对视频的重复检测都是多个维度的,光是改MD5没用,你对视频做任何的操作,MD5都会发生改变,根本没必要单拎出来说。

而滤镜无非就是修改色值,效果跟MD5差不多,如果抽帧检测加不加滤镜效果是一样的。

作为一名合格的搬运工,视频该经过哪些处理后才能不被各大平台检测出来呢,下面分享一些短视频去重的技巧和处理方法,有需要的朋友可以看看~平台的查重机制先跟大家说说平台的查重机制,知道了平台是怎么检测视频重复的,我们才能知道怎么做到去重。

平台应该会先检查MD5, 因为这个检查是最快的。

然后从视频的标题,描述,标签,封面,时长,分辨率,bgm等信息进行检查,筛选出一些可能重复的视频,然后重点检测。

这些属性的重复检测都是很简单的。

要知道,以目前的技术,视频没法直接对比是否一样或者很像,除非是人工检查,但是可以对比图片的相似度,而且简单快速,所以比较两个视频的相似度其实就是图片的对比。

平台会把视频的片头几秒抽出几帧,然后片尾几秒抽出几帧,然后中间抽出若干帧进行对比。

如果画面改动很小,那么图片的对比基本也是一致的。

(这里只是大概说一下原理,实际的检测肯定更为复杂。

)知道检测的原理,想要达到去重也就比较简单了,下面详细说一说如何去重,然后举几个例子,不同类型的视频去重方式也略有不同。

12种去重方法1、剪裁:通过剪裁改变原视频的大小和比例2、水印:消除原视频的水印,然后加上自己账号的专属水印3、片头片尾:不要跟原视频一样,先掐头去尾,再用后期剪辑软件制作片头与片尾,不需要太长,几秒钟就好4、镜像:利用镜像功能,改变画面5、特效:添加多一些转场和特效6、变速:利用变速功能,慢放或者快进,更改素材的整体速度7、字幕:拉大字幕,穿过背景和画面,从而改变画面效果8、换背景:通过智能抠像功能直接换画面背景9、分辨率:比如原视频是1920x1080的蓝光分辨率,你把它改成720x128010、帧率:改帧率最大的作用是有些平台需要指定60fps, 如果低于这个数就没法发布,那么就需要修改帧率(修改帧率和分辨率的软件很多,比如“格式工厂”)11、BGM:对音量进行调整,调高或者调低,如果能自己配音解说最好12、超轻画质:选择高质量导出,可以利用快影百宝箱的超清画质功能,把视频加工至4k例子:改变画面最常用的方法就是通过插入背景颜色、背景图片、模糊拓边或者画面叠加的效果,实现横竖屏的切换。

一种重复视频的快速检测算法

随着互联网的快速发展,视频的数量和使用率正在不断增加。

不可避免的,一些人可能会将视频复制多次,或者使用不同的格式进行转换。

这些相似或重复的视频会占用存储空间并增加带宽负担,因此需要进行快速检测。

在本文中,我们将介绍一种用于检测重复视频的快速算法。

首先,在图像相似度方面,我们可以使用感知哈希算法来快速比较图像相似度。

该算法可以通过对图像进行缩小,离散余弦变换和比较哈希值来计算图像之间的相似度。

然而,这种算法在视频中的应用比较复杂,需要考虑到视频中多个帧之间的比较,并且需要考虑到视频中的流畅性和时间相关性。

因此,我们可以使用视频帧聚类来处理视频,以便快速检测重复内容。

该算法首先将视频分成一系列离散的帧,然后通过对每个帧进行转换和哈希处理,生成相似度哈希值。

然后,我们将这些哈希值与先前生成的所有哈希值进行比较。

如果两个哈希值非常相似,则该帧被归类为相似。

最后,我们可以通过在相邻帧之间设置一定的比较窗口来优化算法以考虑视频的流畅性和时间相关性。

这种聚类算法可以快速处理大量的视频和帧,并且可以通过参数调整来平衡算法的灵敏度和准确性。

此外,该算法可以并行化处理,以加快处理速度和适应不同硬件平台。

在总结中,这种视频帧聚类算法可以快速检测重复视频内容,

并且可以根据需要进行调整。

在处理大量视频或需要快速检测视频内容的应用中,该算法具有广泛的应用前景。

数据处理中的数据去重方法引言在现代社会中,数据已经深入到我们生活的方方面面。

我们通过不同的渠道收集和获取数据,这些数据以不同的形式出现在我们的日常工作和生活中。

然而,数据的质量和准确性对于我们能否从中获取有用信息至关重要。

数据去重作为数据清洗的一项重要工作,可以帮助我们消除重复和冗余的数据,提高数据的质量和可信度。

本文将介绍一些常用的数据去重方法,帮助读者更好地处理数据。

一、基于规则的去重方法基于规则的去重方法是一种简单且常见的数据去重方式。

它通过设定一些规则或约束条件,来判断是否为重复数据。

这种方法适用于数据中存在明确规则的情况,例如电话号码、邮件地址等。

通过对这些字段进行规范化处理,可以轻松去重。

二、基于相似度的去重方法基于相似度的去重方法是一种比较灵活的方式。

它通过计算数据之间的相似度来判断是否为重复数据。

相似度计算可以使用多种算法,例如余弦相似度、编辑距离等。

这种方法适用于文本、图像等非结构化数据的去重,也可以用于一些特定领域的数据去重,例如音频指纹、人脸识别等。

三、基于哈希算法的去重方法基于哈希算法的去重方法是一种高效且可靠的方式。

它通过计算数据的哈希值来判断是否为重复数据。

哈希算法能够将数据映射为固定长度的哈希值,且哈希值的计算速度非常快。

常用的哈希算法有MD5、SHA等。

通过比较数据的哈希值,可以快速识别出重复数据,提高处理效率。

四、基于机器学习的去重方法随着机器学习的发展,基于机器学习的去重方法也逐渐应用于数据处理中。

这种方法通过训练模型来学习数据的特征,从而判断是否为重复数据。

机器学习算法包括决策树、支持向量机、神经网络等。

通过对大量已知数据进行训练,模型可以识别出隐含在数据中的规律,有效去重。

五、综合应用在实际应用中,我们可以综合运用不同的去重方法来处理数据。

通过先利用基于规则的方法处理一些明确存在规则的字段,然后再使用基于相似度或哈希算法的方法对剩余字段进行去重,最后再借助机器学习手段进行进一步筛选,可以获得更准确、高质量的数据。

图集去重最好的方法图集去重是指在一个图集中去掉重复的图片。

当我们在整理图片时,会发现有些图片可能会出现重复,占用不必要的存储空间。

图集去重的目的就是为了优化存储空间和提高效率。

下面我将介绍几种常见的图集去重方法。

1. 基于哈希算法的去重方法:这是一种常见的图集去重方法。

它的基本原理是通过计算图片的哈希值,将其作为图像的唯一标识。

当两个图片的哈希值相同时,它们被认为是相同的图片。

根据这个原理,我们可以遍历图集中的所有图片,计算其哈希值,并将其放入一个集合中。

如果集合中已经存在相同的哈希值,说明这是一张重复的图片,我们可以将其删除或标记。

这种方法的优点是效率高,速度快,适用于大规模的图集去重。

但是也存在缺点,就是可能会存在哈希冲突,即不同的图片计算出的哈希值相同,误判为重复图片的情况。

2. 基于相似度匹配的去重方法:这种方法的基本原理是通过比较图片之间的相似度来判断是否是重复图片。

常见的相似度匹配算法有均值哈希算法、感知哈希算法、结构相似度算法等。

通过计算图片之间的相似度,我们可以设置一个阈值,当两张图片的相似度超过阈值时,认为它们是重复图片。

这种方法的优点是精度较高,可以识别出相似度较高的图片,并进行去重。

但是也存在缺点,就是该方法计算量较大,需要遍历图集中的所有图片进行相似度计算。

3. 基于特征提取的去重方法:这种方法的基本原理是通过提取图片的特征来判断是否是重复图片。

常见的特征提取算法有局部二值模式(LBP)、灰度共生矩阵(GLCM)、尺度不变特征变换(SIFT)等。

我们可以通过将特征向量进行比较,来判断图片是否是重复图片。

这种方法的优点是可以提取出图片的特征信息,并进行比较判断,适用于不同风格和尺度的图片。

但是也存在缺点,就是特征提取的过程可能会存在一定的误差,造成误判或漏判。

以上是几种常见的图集去重方法。

选择何种方法取决于具体的应用场景和需求。

如果对于去重的准确性要求较高,可以采用基于相似度匹配或特征提取的方法;如果对准确性要求不是特别高,但对处理速度有要求,可以选择基于哈希算法的方法。

第四范式的数据去重与数据冗余处理技巧在当今信息爆炸的时代,数据的重复和冗余问题成为了亟待解决的难题。

第四范式作为一家专注于数据处理和人工智能技术的公司,致力于提供高效的数据去重和冗余处理方案。

本文将介绍第四范式的数据去重技巧和冗余处理策略。

一、数据去重技巧数据去重是指在数据集中去除重复的数据,以减少存储空间和提高数据处理效率。

第四范式通过以下技巧实现数据去重:1. 基于哈希算法的去重:第四范式利用哈希算法对数据进行哈希运算,将数据映射为唯一的哈希值,并通过比较哈希值来判断数据是否重复。

这种方法具有高效、快速的特点,能够在大规模数据集中高效地去重。

2. 基于相似度的去重:第四范式采用相似度计算的方法,通过计算数据之间的相似度来判断数据是否重复。

相似度计算可以使用编辑距离、余弦相似度等算法,根据具体需求选择合适的相似度计算方法。

3. 基于机器学习的去重:第四范式还结合了机器学习的方法,通过训练模型来判断数据是否重复。

这种方法可以根据数据的特征和模式进行分类,从而实现高效的数据去重。

二、数据冗余处理策略数据冗余是指在数据集中存在重复、无效或冗余的数据,对数据处理和分析造成不必要的负担。

第四范式提供以下策略来处理数据冗余:1. 数据清洗:第四范式通过数据清洗的方式去除无效和冗余的数据。

数据清洗可以包括去除空值、去除重复数据、去除异常值等操作,从而提高数据的质量和准确性。

2. 数据规范化:第四范式通过数据规范化的方式将冗余的数据转化为标准化的格式。

数据规范化可以包括统一日期格式、统一单位、统一命名规范等操作,从而减少数据的冗余和混乱。

3. 数据压缩:第四范式利用数据压缩技术来减少数据的存储空间和传输成本。

数据压缩可以通过压缩算法、编码算法等方式实现,从而减少数据冗余和浪费。

三、第四范式的应用案例第四范式的数据去重和冗余处理技巧在多个领域得到了广泛应用。

以下是一些应用案例:1. 金融领域:第四范式的数据去重和冗余处理技巧可以应用于金融数据的清洗和分析,提高金融数据的质量和准确性。

感知哈希算法感知哈希算法(PerceptualHashing,简称PHash)是一种用于检测非结构化数据(如图像、视频、音频)相似性的技术。

PHash具有抗硬件失真(如调整图像大小或者位深度,调整播放速度等)、抗加密、快速运算等优点,目前已经在多个领域应用。

PHash的原理是利用频谱特征来描述一个图像,然后用一定的数学方法计算出一个哈希码(Hash String),以此来表示这个图像的特征。

例如,如果一张图片的频谱特征有一定的变化,它的Hash String 也会发生变化。

因此,PHash可以用于判断两张图片的相似度,具体流程是:1.算图像的频谱特征,如傅里叶变换、低频滤波等;2.过某种数学方式,把频谱特征编码成一组字符串,也就是 Hash string;3.过比较两个图像的 Hash string计算它们的相似度。

由于PHash具有优秀的抗加密性,通过简单操作(如调整图像大小或者位深度,调整播放速度等)并不会改变图像本身的特征,因此,PHash可以用于发现抗加密图像。

例如,复制加密图像和原始图像的Hash String可能不一样,但它们之间的相似度还是可以计算出来的,因此,PHash可以用来发现受到加密影响的图片。

此外,PHash还可以应用在音频和视频中,其基本思路是在处理过程中,将音视频文件转换成图片,然后对图片应用PHash算法,最后计算出音视频文件之间的相似度。

总之,感知哈希算法是一种非常成熟且有效的技术,它可以用来检测非结构化数据的相似性,具有抗硬件失真、抗加密、快速运算等优点。

除此之外,在安全领域,PHash还可以用于发现受到加密影响的图片。

未来,随着算法的进一步研发与完善,PHash将会发挥更大的作用,为社会的信息安全做出更大的贡献。

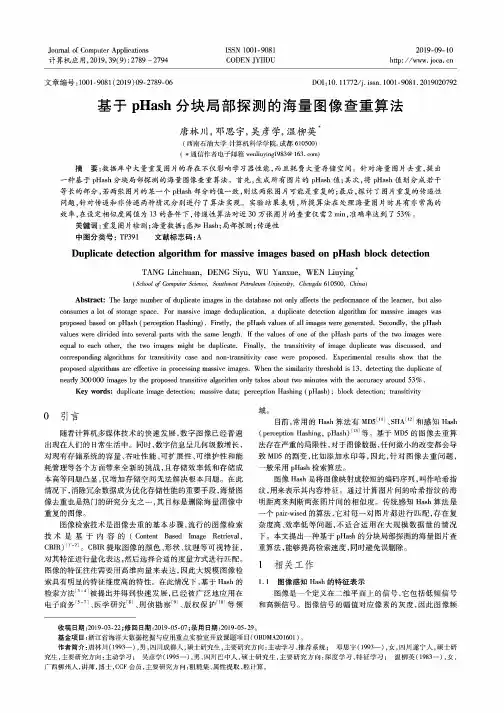

基于pHash分块局部探测的海量图像查重算法唐林川; 邓思宇; 吴彦学; 温柳英【期刊名称】《《计算机应用》》【年(卷),期】2019(039)009【总页数】6页(P2789-2794)【关键词】重复图片检测; 海量数据; 感知Hash; 局部探测; 传递性【作者】唐林川; 邓思宇; 吴彦学; 温柳英【作者单位】西南石油大学计算机科学学院成都610500【正文语种】中文【中图分类】TP3910 引言随着计算机多媒体技术的快速发展,数字图像已经普遍出现在人们的日常生活中。

同时,数字信息呈几何级数增长,对现有存储系统的容量、吞吐性能、可扩展性、可维护性和能耗管理等各个方面带来全新的挑战,且存储效率低和存储成本高等问题凸显,仅增加存储空间无法解决根本问题。

在此情况下,消除冗余数据成为优化存储性能的重要手段,海量图像去重也是热门的研究分支之一,其目标是删除海量图像中重复的图像。

图像检索技术是图像去重的基本步骤,流行的图像检索技术是基于内容的(Content Based Image Retrieval, CBIR)[1-2]。

CBIR提取图像的颜色、形状、纹理等可视特征,对其特征进行量化表达,然后选择合适的度量方式进行匹配。

图像的特征往往需要用高维向量来表达,因此大规模图像检索具有明显的特征维度高的特性。

在此情况下,基于Hash的检索方法[3-4]被提出并得到快速发展,已经被广泛地应用在电子商务[5-7]、医学研究[8]、刑侦勘察[9]、版权保护[10]等领域。

目前,常用的Hash算法有MD5[11]、SHA[12]和感知Hash(perception Hashing, pHash)[13]等。

基于MD5的图像去重算法存在严重的局限性,对于图像数据,任何微小的改变都会导致MD5的剧变,比如添加水印等,因此,针对图像去重问题,一般采用pHash检索算法。

图像Hash是将图像映射成较短的编码序列,叫作哈希指纹,用来表示其内容特征。

数据去重方法数据去重是在数据处理过程中常见的一个任务,目的是从一组数据中删除重复的元素,以提高数据质量和处理效率。

本文将介绍几种常见的数据去重方法。

一、基于哈希的方法基于哈希的方法是一种常用的数据去重技术。

它通过将数据元素转化为哈希值,并利用哈希函数将这些元素映射到一个哈希表中。

如果两个元素的哈希值相同,则认为它们可能相同,需要进一步比较确认。

这种方法的优点是速度快,适用于大规模数据的处理。

常见的基于哈希的去重算法有Bloom Filter、Hash Set等。

二、排序去重方法排序去重方法是通过先对数据进行排序,然后再顺序扫描删除重复元素的方法。

这种方法的基本思想是相同的元素在排序后会相邻,通过一次扫描就可以完成去重操作。

由于排序需要消耗额外的时间和空间,适用于数据规模较小的场景。

三、位图法位图法是一种适用于处理大规模数据的高效去重方法。

它利用位图的特性,将数据映射到一系列位上,并设置相应的标记来表示元素是否存在。

通过位运算等操作可以快速判断元素的去重情况。

这种方法的优点是占用内存小、查询速度快,适用于处理大规模数据集合。

四、采样法采样法是一种通过随机抽样来进行数据去重的方法。

它基于概率统计的原理,通过从原始数据中抽取部分样本,并对样本进行去重操作来推断整个数据集合的去重结果。

采样法可以在保证较高准确率的同时,减少数据处理的开销。

五、机器学习方法机器学习方法在数据去重中也有一定的应用。

通过训练模型,可以识别重复数据并进行去重操作。

常用的机器学习算法有支持向量机(SVM)、决策树等。

机器学习方法一般适用于复杂的数据去重场景,需要有一定的训练数据和模型构建过程。

六、基于去重库的方法除了自行实现去重算法,还可以使用现有的去重库或工具来完成数据去重任务。

例如,Python中的pandas库提供了drop_duplicates()函数可以方便地去除DataFrame或Series中的重复值;在关系型数据库中,可以使用SQL语句的DISTINCT关键字来实现数据去重。